关键词:LLM-JEPA, Apple Manzano, 联发科天玑9500, GPT-5, DeepSeek-V3.1-Terminus, Qwen3-Omni, 百度Qianfan-VL, 嵌入空间训练框架, 混合视觉分词器, 双NPU架构, SWE-BENCH PRO基准测试, 多模态音频输入

🔥 聚焦

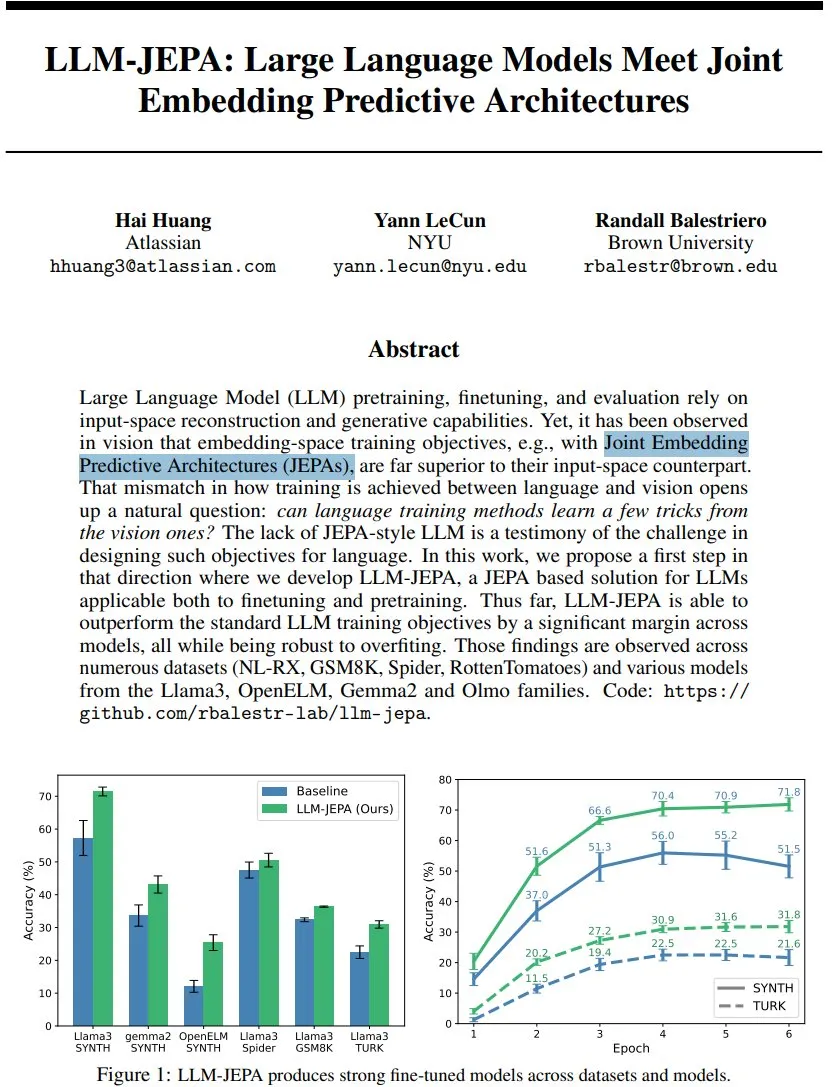

LLM-JEPA:语言模型训练框架新突破 : 耶利昆(Yann LeCun)等人提出了LLM-JEPA,这是首个将视觉领域嵌入空间目标与自然语言处理生成目标相结合的JEPA风格语言模型训练框架。该框架在NL-RX、GSM8K、Spider等多个基准测试中超越了标准LLM目标,并在Llama3、OpenELM等模型上表现良好,对过拟合更具鲁棒性,预训练和微调均有效,预示着嵌入空间训练可能成为LLM的下一个重大飞跃。(来源:ylecun, ylecun)

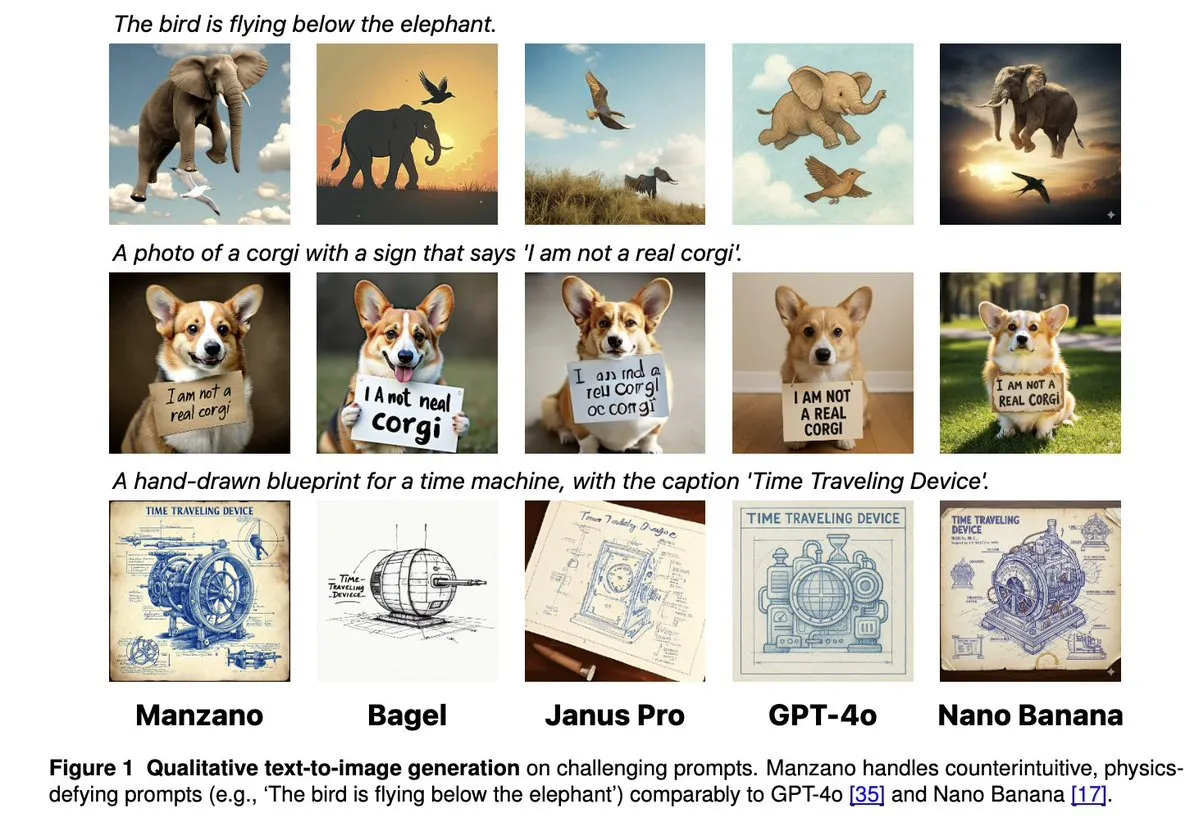

Apple Manzano:统一多模态LLM的简洁可扩展方案 : Apple发布Manzano,一个简单且可扩展的统一多模态大语言模型。该模型采用混合视觉分词器,有效减少了图像理解与生成任务之间的冲突。Manzano在文本密集型基准测试(如ChartQA、DocVQA)中达到SOTA水平,并在生成能力上与GPT-4o/Nano Banana等竞争,支持通过条件图像进行编辑,展现了多模态AI的强大潜力。(来源:arankomatsuzaki, charles_irl, vikhyatk, QuixiAI, kylebrussell)

联发科天玑9500发布双NPU架构,强化主动式AI体验 : 联发科推出天玑9500芯片,首创超性能+超能效双NPU架构,旨在实现AI“Always on”的常驻智能体验。该芯片在ETHZ移动SoC AI榜单中蝉联榜首,推理效率相比上一代提升56%,并支持端侧4K超高画质生图和128K上下文窗口,为手机AI的实时响应和个性化服务奠定硬件基础,推动AI从“可调用”走向“默认在线”。(来源:量子位)

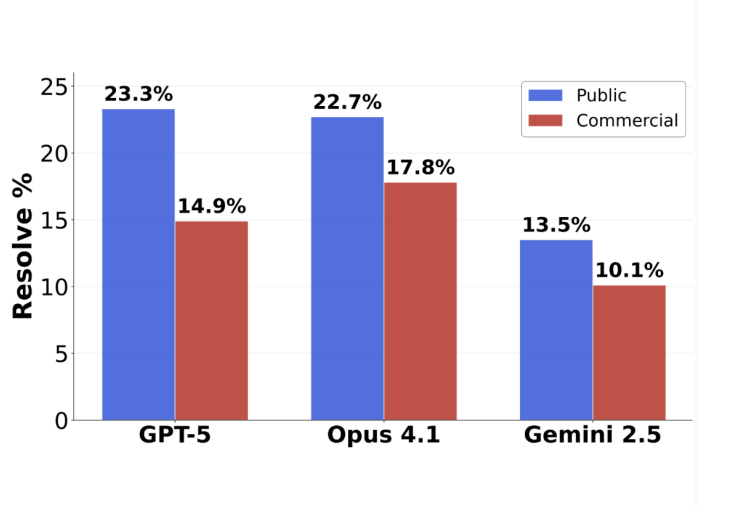

GPT-5编程测评反转:实际提交任务准确率达63.1% : Scale AI发布的新软件工程基准SWE-BENCH PRO显示,GPT-5在已提交任务上的准确率达到63.1%,远超Claude Opus 4.1的31%,表明其在擅长领域的表现依旧强劲。新基准采用全新题目和复杂多文件修改场景,更真实地考验模型实际编程能力,揭示了当前顶级模型在工业级软件工程任务中仍面临挑战,但GPT-5在“会就会,不会就不提交”的策略下,实际能力被低估。(来源:36氪)

🎯 动向

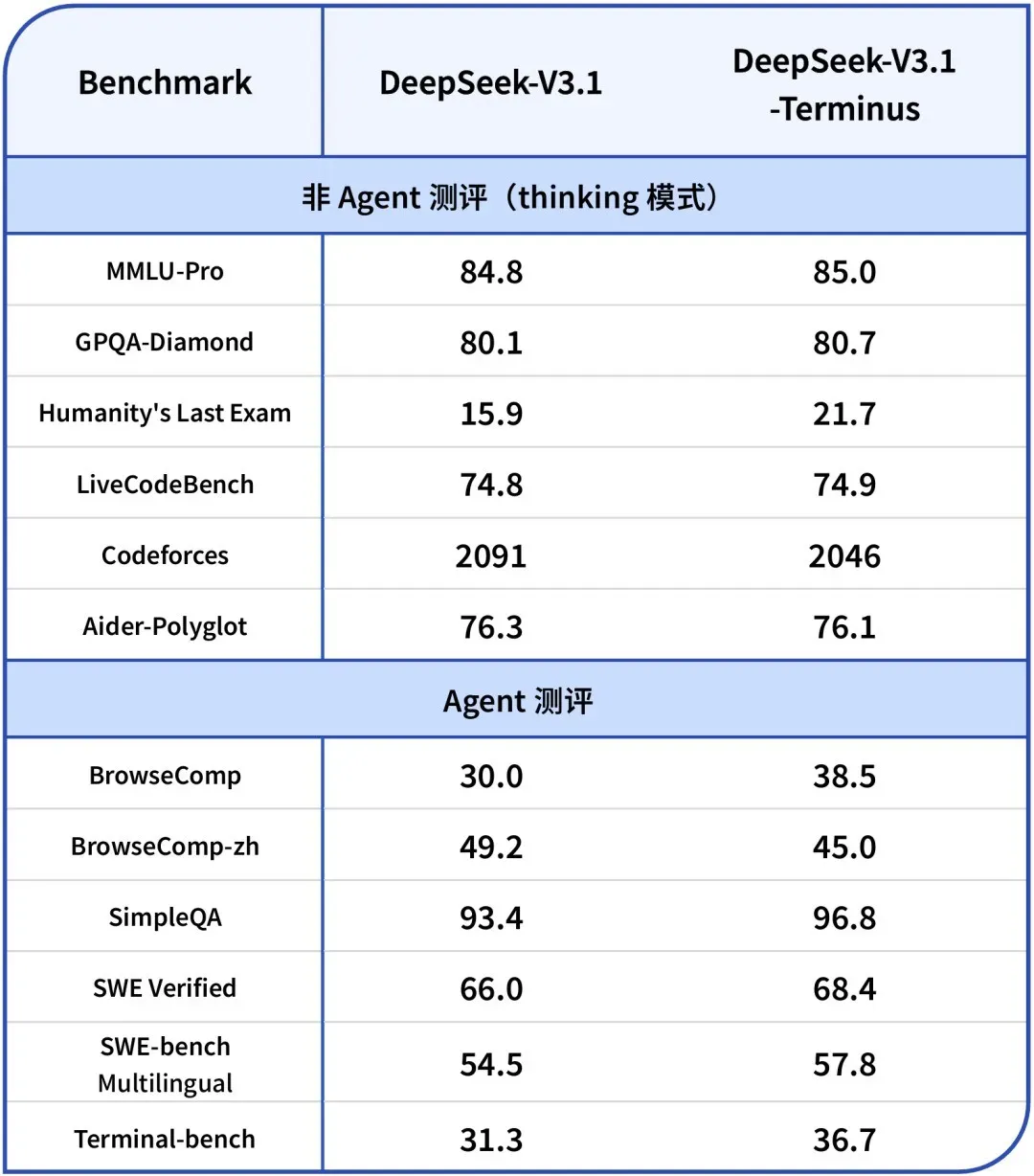

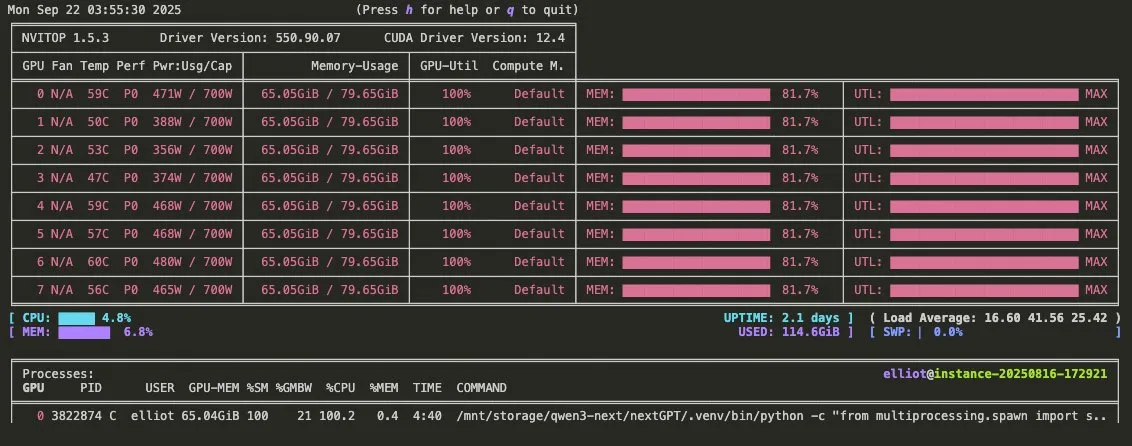

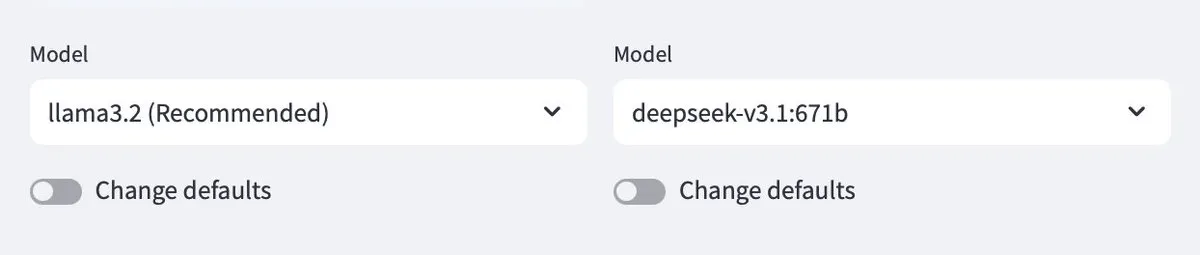

DeepSeek-V3.1-Terminus发布:优化语言一致性和Agent能力 : DeepSeek发布V3.1-Terminus版本,主要改进语言一致性(减少中英文混杂和异常字符)并优化Code Agent和Search Agent性能。新模型在多领域测评中输出更稳定可靠,开源权重已在Hugging Face和ModelScope上线,预示着DeepSeek在V3系列架构上的最终完善。(来源:DeepSeek Blog, Reddit r/LocalLLaMA, scaling01, karminski3, ben_burtenshaw, dotey)

Qwen3-Omni宣传视频发布:支持多模态音频与工具调用 : Qwen发布Qwen3-Omni宣传视频,预告其将支持多模态音频输入和输出,并具备原生工具调用能力。该模型有望成为Gemini 2.5 Flash Native Audio的直接竞争对手,提供思考和非思考模式,显著提升语音Agent的构建潜力,其权重即将发布。(来源:Reddit r/LocalLLaMA, scaling01, Alibaba_Qwen, huybery)

百度开源Qianfan-VL系列多模态大语言模型 : 百度AI Cloud开源Qianfan-VL系列多模态大语言模型(3B, 8B, 70B),专为企业级应用优化。模型结合InternViT视觉编码器和增强的多语言语料库,提供32K上下文长度,在OCR、文档理解、图表分析和数学问题解决方面表现出色,并支持链式思考推理,旨在提供强大的通用能力和行业高频场景的深度优化。(来源:huggingface, Reddit r/LocalLLaMA)

xAI发布Grok 4 Fast模型:2M上下文窗口,高成本效益 : xAI推出Grok 4 Fast模型,一个具备2M上下文窗口的多模态推理模型,旨在以高成本效益树立新标准。此版本可能通过FP8量化等技术实现快速推理,并优化了Agentic编程能力,使其在处理复杂任务时兼顾性能与经济性。(来源:TheRundownAI, Yuhu_ai_)

GPT-5-Codex:OpenAI推出针对Agentic编程优化的GPT-5版本 : OpenAI发布GPT-5-Codex,这是GPT-5的一个优化版本,专门用于Agentic编程。该模型旨在提升AI在代码生成和软件工程任务中的表现,与Agentic工作流和多模态LLM的发展趋势相符,通过增强其编程能力,进一步推动AI在开发领域的应用。(来源:TheRundownAI, Reddit r/artificial)

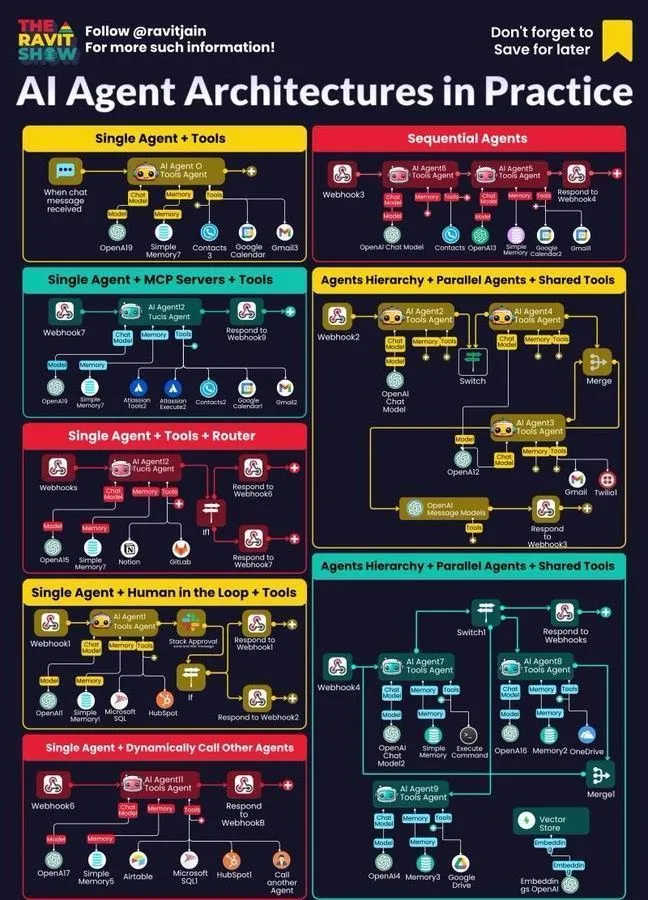

腾讯智能体开发平台3.0全球上线,优图实验室关键技术持续开源 : 腾讯云智能体开发平台3.0(ADP3.0)面向全球上线,在RAG、Multi-Agent协同、Workflow、应用评测及插件生态方面全面升级。腾讯优图实验室将持续开源关键智能体技术,包括Youtu-Agent框架和Youtu-GraphRAG知识图谱框架,旨在推动技术普惠和智能体生态的开放共建,让企业低门槛构建、集成、运营自己的AI智能体。(来源:量子位)

百度文库再获国家工信安全中心认证,领跑智能PPT行业 : 百度文库在国家工信安全中心的大模型赋能智慧办公评测中排名第一,在生成质量、意图理解、排版美化等六项指标上均位列第一。其智能PPT功能提供全流程解决方案,AI月活用户超9700万,月访问量超3400万,持续巩固在智能PPT领域的领先地位,为用户提供专业、准确且美观的PPT创作体验。(来源:量子位)

Google DeepMind推出Frontier Safety Framework,应对新兴AI风险 : Google DeepMind发布其最新的“前沿安全框架”,这是迄今为止最全面的方法,旨在识别并领先于新兴的AI风险。该框架强调负责任的AI模型开发,致力于确保随着AI能力增强,安全措施也能同步升级,以应对未来可能出现的复杂挑战。(来源:GoogleDeepMind)

人形机器人与自动化系统发展:提升交互与稳定性 : 机器人技术持续进步,包括RoboForce推出工业人形机器人Titan,WIROBOTICS的ALLEX平台实现触觉、自然运动和内置平衡的类人交互,以及Unitree G1机器人展示“反重力”模式以提升稳定性。此外,Hitbot机器人农场展示自动化采摘系统,自主移动运输机器人也强调人机协作设计,共同推动机器人从计算到感知世界的转变。(来源:Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Unitree)

AI Agent成为企业工作流核心:架构、地图、实践应用 : AI Agent正迅速成为企业工作流的核心,其架构设计、生态系统地图和实际应用受到广泛关注。神经符号AI被视为解决LLM幻觉的潜在方案,而Anthropic的模拟研究则指出AI模型可能构成内部威胁,凸显了Agentic AI在企业部署中的机遇与挑战,并促使企业探索更安全的实践方法。(来源:Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

🧰 工具

Ollama支持云端模型,实现本地与云端模型互动 : Ollama现在支持在云端部署模型,允许用户在本地Ollama模型与云端托管的模型之间进行互动。这一功能通过Minions应用实现,使用户能够更灵活地管理和利用其LLM资源,无论是本地运行还是通过云服务访问,都提供了无缝的体验。(来源:ollama)

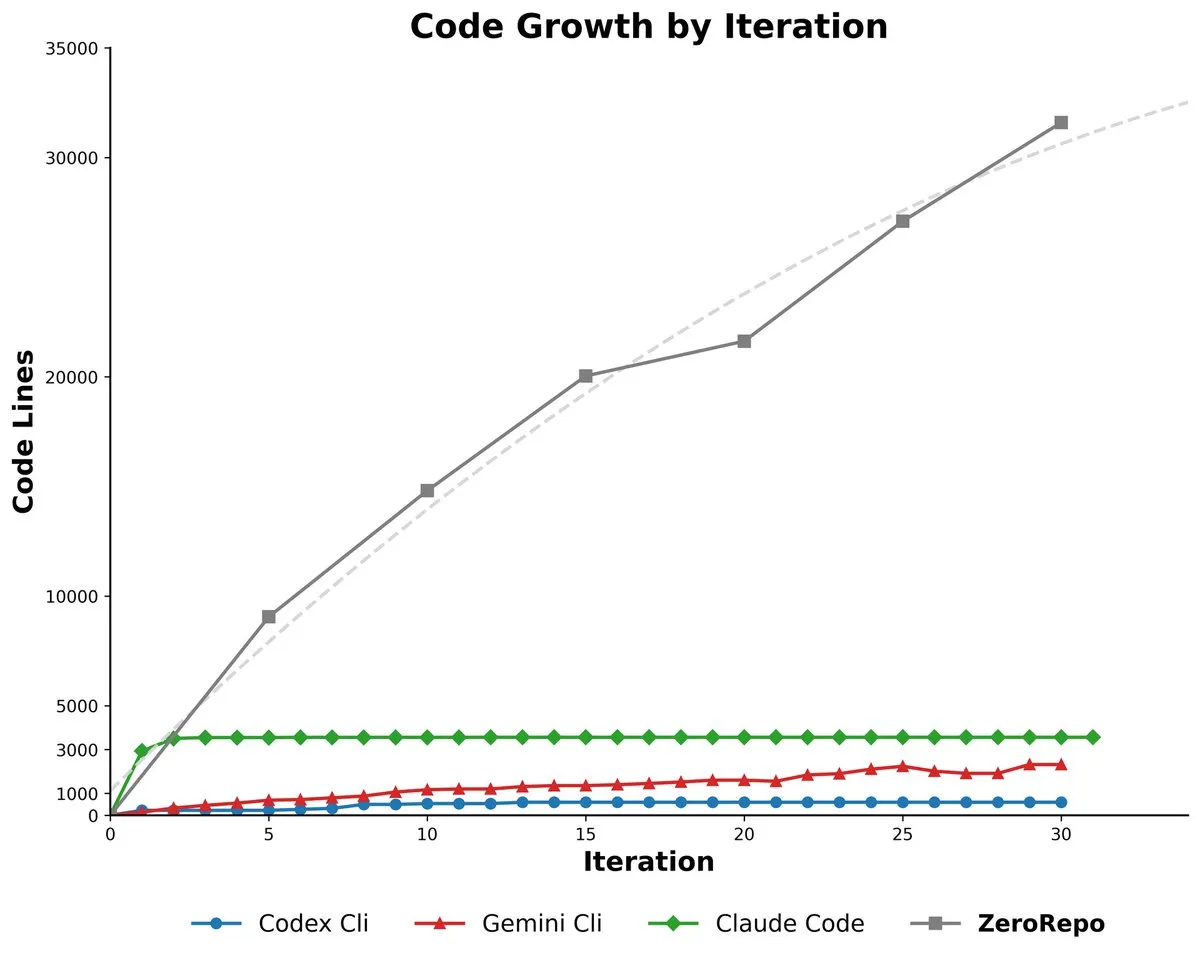

微软ZeroRepo:基于图驱动框架生成完整代码库 : 微软推出ZeroRepo,一个基于图驱动框架(Repository Planning Graph, RPG)的工具,能够从零开始构建完整的软件项目。该工具生成代码量比现有基线高3.9倍,并通过率达69.7%,解决了自然语言不适合软件结构的问题,实现可靠的长期规划和可扩展的代码库生成。(来源:_akhaliq, TheTuringPost, paul_cal)

DSPy UI:构建Agent的可视化界面 : DSPy正在开发一个可视化用户界面(UI),旨在简化Agent的构建过程,使其像Figma或Framer一样,通过拖拽组件来组合Agent。该UI将帮助用户更好地概念化复杂的Agent管道,并简化生成的代码语法,最终目标是实现DSPy各种语言版本的生成和GEPA的运行。(来源:lateinteraction)

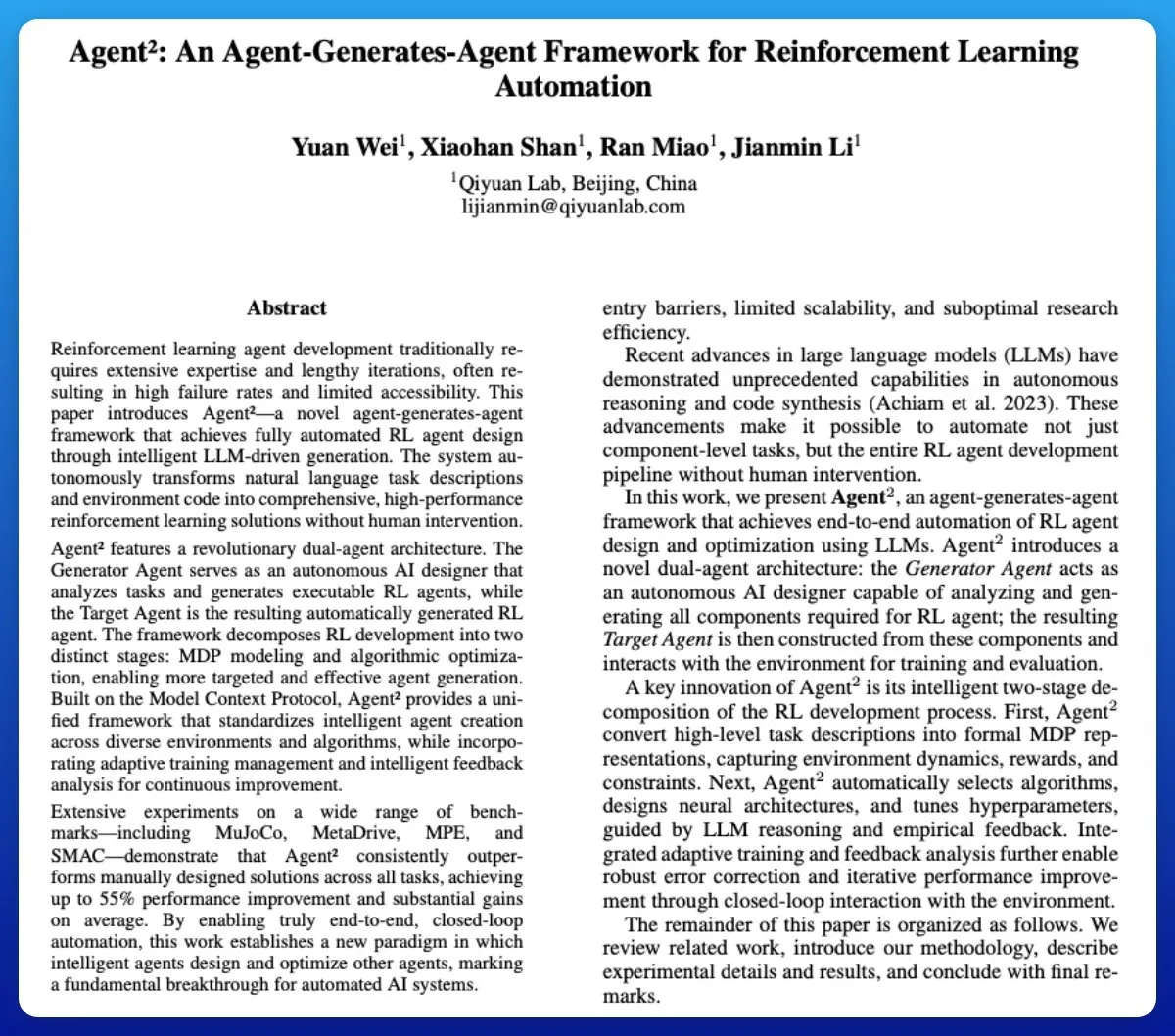

Agent²:LLM生成端到端强化学习Agent : Agent²是一个利用大型语言模型(LLM)自动生成端到端强化学习(RL)Agent的工具。该工具通过自然语言和环境代码,无需人工干预即可自动生成有效的RL解决方案,可视为RL领域的AutoML工具,极大地简化了RL Agent的开发过程。(来源:omarsar0)

Weaviate发布Query Agent,支持AI系统中的引用、模式内省和多集合路由 : Weaviate正式发布其Query Agent,该Agent在为期六个月的开发后达到通用可用性。它支持AI系统中的引用生成、模式内省和多集合路由,并通过Compound Retrieval System增强搜索模式。Query Agent旨在简化与Weaviate的交互,并提供Python和TypeScript客户端,提升开发者体验。(来源:bobvanluijt, Reddit r/deeplearning)

Claude Code CLI:SDK思维管理微型员工,强调外部状态和过程工程 : 将Claude Code CLI视为SDK而非简单工具,开发者需要像管理微型员工一样,强调外部状态管理(如JSON文件、数据库条目)以实现会话连续性,并将提示工程视为过程工程。这种方法揭示了当前LLM在上下文过载和UI臃肿等方面的局限性,但同时也突显了超特异性内部自动化工具的巨大价值。(来源:Reddit r/ClaudeAI)

Synapse-system:基于知识图谱、向量搜索和专业Agent的大型代码库AI辅助系统 : Synapse-system是一个旨在提升大型代码库AI辅助能力的系统,它结合了知识图谱(Neo4j)存储代码关系、向量搜索(BGE-M3)查找语义相似代码、专业Agent(Rust、TypeScript、Go、Python专家)提供上下文,以及智能缓存(Redis)快速访问常用模式。该系统通过模块化设计,避免了单一巨型模型,并针对不同语言的特性进行优化。(来源:Reddit r/ClaudeAI)

Claude Opus 4.0+:AI导游App,实时生成个性化城市导览 : 一位开发者利用Claude Opus 4.0及Claude Code实现了15年的梦想,开发出一款AI导游App。该应用能为任何城市、任何主题(如“威尼斯观光”或“佛罗伦萨刺客信条之旅”)实时生成个性化导览,并由AI导游提供多语言讲解、故事和互动问答。这款App以远低于人工导游的价格,提供灵活的、可暂停和恢复的沉浸式体验。(来源:Reddit r/ClaudeAI)

Mindcraft:Minecraft AI与LLM结合,通过Mineflayer实现游戏内智能体控制 : Mindcraft项目结合大型语言模型(LLM)和Mineflayer库,为Minecraft游戏创建AI智能体。该项目允许LLM在游戏中编写和执行代码,以完成获取物品或建造建筑等任务。它支持多种LLM API(如OpenAI、Gemini、Anthropic等),并提供沙盒环境,但警告用户注意潜在的注入攻击风险。(来源:GitHub Trending)

AI Agents for Continuous Inventory Management with Drones : 结合AI Agent和无人机技术,实现无需信标或照明的持续库存管理。该创新利用自主飞行无人机,通过AI算法进行实时库存盘点和管理,有望大幅提升物流和仓储效率,减少人力成本,并在复杂环境中提供更精准的数据。(来源:Ronald_vanLoon)

LLM评估指南:可靠性、安全性、性能的最佳实践 : 一份全面的LLM评估指南被发布,详细介绍了评估大型语言模型(LLM)的关键指标、方法和最佳实践。该指南旨在帮助确保AI驱动应用的可靠性、安全性与性能,为开发者和研究人员提供一套系统化的评估框架,以应对LLM部署中的挑战。(来源:dl_weekly)

📚 学习

OpenAI科学家 Lukasz Kaiser谈大模型第一性思考 : OpenAI科学家Lukasz Kaiser(Transformer八子之一)分享了他对大模型发展的“第一性原理”思考。他认为AI的下一个阶段关键在于教会模型“思考”,通过生成更多中间步骤进行深度推理,而非直接输出答案。他预言未来计算力将从大规模预训练转向少量高质量数据上的海量推理计算,这是一种更接近人类智慧的模式。(来源:36氪)

AI编程时代的生存原则:吴恩达强调快速行动、承担责任 : 吴恩达在Buildathon演讲中指出,AI辅助编程将独立原型开发加速10倍,促使开发者以“快速行动,承担责任”的原则,在沙盒环境中大胆试错。他强调代码价值正在贬值,开发者需转型为系统设计者和AI指挥者,掌握最新AI编程工具、AI构建模块(提示工程/评估技术/MCP)和快速原型能力,反驳“AI时代无需学编程”的观点。(来源:36氪)

《深度学习与Python》第三版免费在线发布 : 弗朗索瓦·肖莱(François Chollet)宣布其著作《深度学习与Python》第三版已出版,并同时提供完整的免费在线版本。这一举措旨在降低深度学习的学习门槛,让更多对人工智能感兴趣的人能够接触到高质量的学习资源,推动知识的普及。(来源:fchollet, fchollet)

《Kaggle Grandmasters Playbook》:表格建模的7种实战技术 : Kaggle Grandmasters团队Gilberto Titericz Jr等人,在多年竞赛和实践经验的基础上,发布了《Kaggle Grandmasters Playbook》。该手册汇集了7种经过实战检验的表格数据建模技术,旨在帮助数据科学家和机器学习工程师提升在表格数据处理和模型构建方面的能力,尤其适用于Kaggle竞赛和真实世界的数据挑战。(来源:HamelHusain)

AI工程师奇缺,大学课程严重脱节 : 吴恩达指出,尽管计算机科学专业毕业生失业率上升,但企业仍面临AI工程师严重短缺。核心矛盾在于大学课程未能及时覆盖AI辅助编程、大语言模型调用、RAG/Agentic工作流构建、规范错误分析流程等关键技能。他呼吁教育体系加速课程更新,培养具备最新AI构建模块和快速原型能力的工程师。(来源:36氪)

LLM评估指南:可靠性、安全性、性能的最佳实践 : 一份全面的LLM评估指南被发布,详细介绍了评估大型语言模型(LLM)的关键指标、方法和最佳实践。该指南旨在帮助确保AI驱动应用的可靠性、安全性与性能,为开发者和研究人员提供一套系统化的评估框架,以应对LLM部署中的挑战,确保AI产品的质量和用户信任。(来源:dl_weekly)

💼 商业

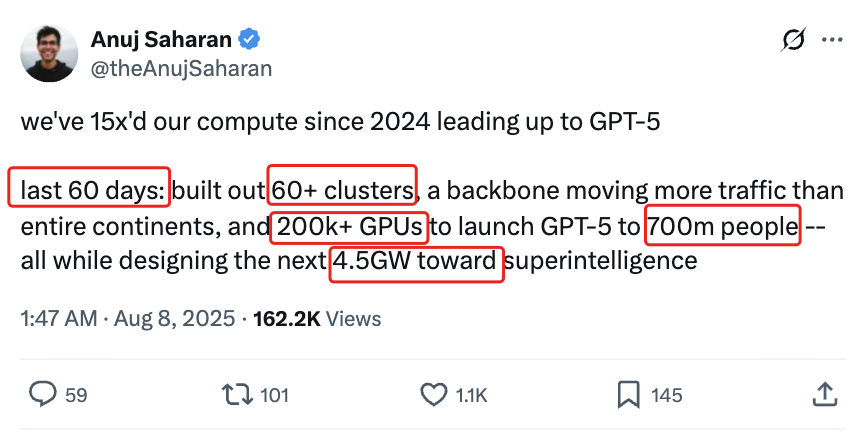

AI基础设施投资狂潮:2025年美国AI数据中心支出或达5200亿美元 : 据《华尔街日报》和《经济学人》报道,美国正经历AI数据中心支出狂潮,2025年预计达5200亿美元,规模超过互联网时代电信支出峰值。这短期内提振了美国GDP,但长期可能导致其他领域资金匮乏、大规模裁员,并因AI硬件迭代快而带来高贬值风险,引发结构性经济隐忧,对美国经济的长期健康构成挑战。(来源:36氪)

OpenAI预告新功能将收费:Pro用户需额外付费,成本密集 : OpenAI首席执行官Sam Altman预告,未来几周将推出多项计算密集型新功能。由于高昂的成本,这些功能最初仅对每月200美元的Pro订阅用户开放,甚至可能需要额外付费。Altman表示团队正努力降低成本,但这一举措预示着AI服务商业模式可能转向按小时雇佣员工的模式,对用户和行业带来新的挑战。(来源:The Verge, op7418, amasad)

初创公司获得巨额OpenAI积分,寻求变现途径 : 一家科技初创公司获得了12万美元的Azure OpenAI积分,远超其需求,正在寻求将其变现的方法。这反映出AI资源在市场上的潜在供需不平衡,以及企业对如何有效利用和货币化过剩AI算力资源的探索,同时也可能催生新的AI资源交易模式。(来源:Reddit r/deeplearning)

🌟 社区

AI对批判性思维的负面影响:过度依赖导致能力退化 : 社交媒体上热议,AI的广泛使用正在导致人类批判性思维能力的退化。有观点认为,当人们不再使用“思维肌肉”时,这些能力就会萎缩。AI虽然能提高效率,但也可能使人们在关键领域失去深度思考的能力,引发对人类认知能力长期影响的担忧。(来源:mmitchell_ai)

AI在医疗健康领域的伦理困境:Delphi-2M预测疾病的利弊 : 新型AI模型Delphi-2M能够分析健康数据,预测用户未来20年罹患千余种疾病的风险。社区讨论指出,提前知晓疾病风险可能带来积极的预防干预,但也可能导致长期的焦虑,并引发保险公司或雇主获取此类数据的隐私和歧视风险。在AI工具尚未成熟之际,其潜在的社会伦理影响已成为焦点。(来源:Reddit r/ArtificialInteligence)

AI日常使用引发的“脑残”现象:过度依赖AI导致思考能力下降 : 社交讨论中,许多用户抱怨AI在日常生活中被过度使用,导致人们思考能力下降。从简单的决策(看什么电影、吃什么饭)到复杂的问题(大学组织问题),AI都被频繁咨询,即使答案错误或唾手可得。这种“AI脑残”现象不仅降低了个人参与度,还助长了虚假信息传播,引发对AI使用边界的深刻反思。(来源:Reddit r/ArtificialInteligence)

AI编程工具使用疲劳:开发者感觉精神参与度降低 : 许多开发者反映,日常使用AI编程工具(如Claude Code)虽然提高了生产力,但却导致精神疲劳和参与度下降。他们发现自己更多处于“审查模式”而非主动解决问题,等待AI生成输出的过程让人感到被动。社区正在探讨如何平衡AI辅助与保持思维活跃度,以避免认知负荷和创造力减退。(来源:Reddit r/artificial, Reddit r/ClaudeAI)

1/4的年轻人与AI进行浪漫和性目的交流 : 一项研究显示,1/4的年轻成年人出于浪漫和性目的与AI进行交流。这一现象引发了社区对孤独感、人际互动缺失以及AI在情感陪伴中角色的讨论。尽管AI在某些方面提供慰藉,但许多人仍质疑其能否替代真正有意义的人际关系,并担忧其对社会互动模式的长期影响。(来源:Reddit r/ArtificialInteligence)

AI安全威胁:大模型漏洞众测揭示新型风险,提示注入普遍 : 国内首次针对AI大模型的实网众测发现281个安全漏洞,其中177个为大模型特有,占比超六成。典型风险包括不当输出、信息泄露、提示注入(最普遍)和无限制消耗攻击。腾讯混元、百度文心一言等国产主流模型表现较好。社区警示,用户对AI的无防备信任可能导致隐私泄露,尤其在咨询私密问题时。(来源:36氪)

AI Agent的伦理困境:城市AI监控系统10%误报率的决策与责任 : 社区讨论了一个关于AI Agent伦理困境的假想情景:城市AI监控系统存在10%的误报率,将无辜者标记为潜在威胁。讨论聚焦于如何在部署压力和道德原则(如布莱克斯通原则)之间权衡。提出的解决方案包括:组建人机协作团队修复问题、将误报成本转嫁给管理层、彻底删除被错误标记者的记录并道歉,以及在“公共信任完全丧失和管理层贪婪无视”的情况下考虑辞职。(来源:Reddit r/artificial)

AI意识与AGI的定义:吴恩达认为AGI已成炒作术语,意识是哲学问题 : 吴恩达在演讲中指出,通用人工智能(AGI)已从技术术语变为炒作术语,其定义模糊,导致行业对“实现AGI”的宣称缺乏统一标准。他认为,意识是一个重要的哲学问题,而非科学问题,目前缺乏衡量标准,工程师和科学家应专注于构建实际有用的AI系统,而非纠结于意识的哲学辩论。(来源:36氪)

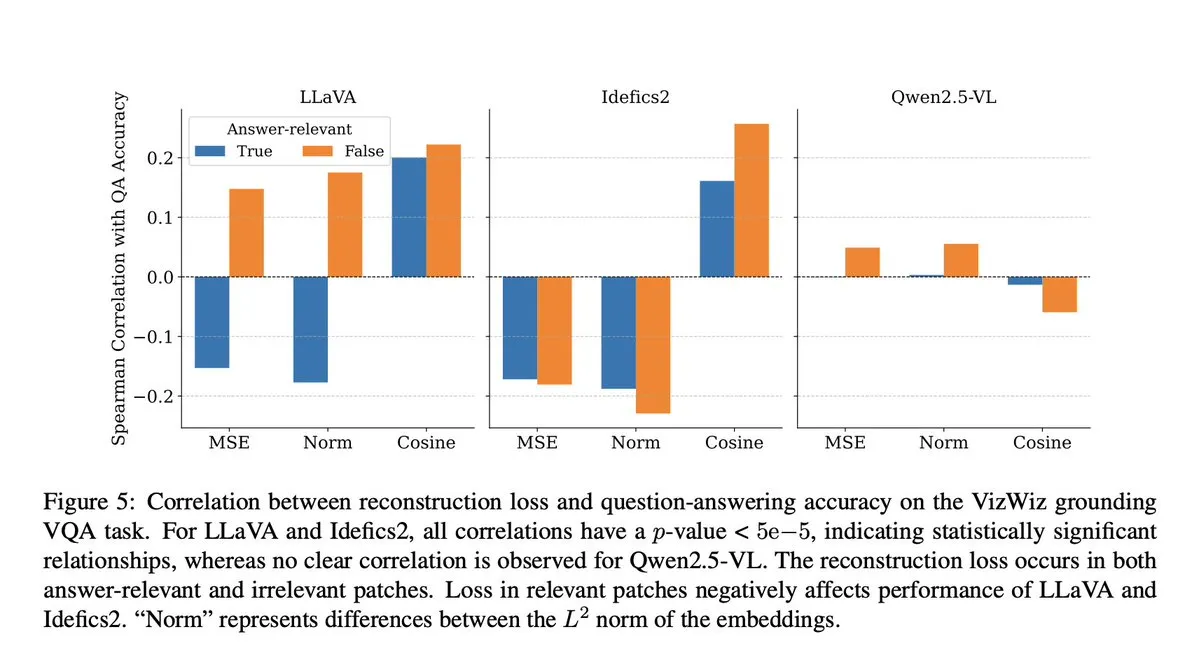

AI模型作弊:VLM研究揭示投影步骤导致语义上下文损失 : 社区讨论了微软的一项研究,该研究揭示视觉-语言模型(VLM)在投影步骤中会损失40-60%的语义上下文,从而扭曲视觉表示并影响下游任务。这一发现引发了对VLM评估准确性和数据污染的担忧,尤其是在DocVQA等基准测试中,高分可能并非完全反映模型真实能力。(来源:vikhyatk)

AI与机器人伦理:呼吁停止对机器人进行暴力测试 : 社交媒体上,多位AI研究者和社区成员呼吁停止对机器人进行暴力测试,例如反复击打Unitree G1机器人以展示其稳定性。他们认为这种测试方式不仅引发伦理担忧,也可能强化对机器人的负面认知,并质疑其科学必要性,倡导以更人道和科学的方式评估机器人性能。(来源:vikhyatk, dejavucoder, Ar_Douillard)

AI的“伪智能”:呼吁将“人工智能”改为“伪智能”以减少公众误解 : 有观点提出,应将“人工智能”(Artificial Intelligence)的称谓改为“伪智能”(Pseudo Intelligence),以减少公众对AI能力的过度夸大和误解。这一提议源于对AI目前局限性的清醒认识,旨在避免因“终结者式”的宏大叙事而误导公众,促进行业内外对AI真实能力的理性认知。(来源:clefourrier)

阿尔巴尼亚AI聊天机器人Diella被任命为内阁成员,引发争议 : 阿尔巴尼亚政府任命AI聊天机器人Diella为内阁成员,旨在打击腐败。这一举动引发了广泛争议,被批评为廉价的噱头,类似于2017年沙特阿拉伯授予机器人索菲亚“公民身份”的事件。评论认为,此举可能过度宣传AI能力,并模糊了技术与治理的界限。(来源:The Verge)

ChatGPT“幻觉”现象:模型陷入循环,自我纠正但无法跳出 : 社区用户分享了ChatGPT陷入“幻觉”循环的案例,模型在回答问题时反复生成错误信息,即使“意识到”自己的错误,也无法跳出这种循环。这种现象引发了对LLM深层技术缺陷的讨论,表明模型在某些情况下理解自身逻辑错误的能力与纠正能力之间存在脱节。(来源:Reddit r/ChatGPT, Reddit r/ChatGPT)

💡 其他

Transformer到GPT-5:OpenAI科学家Lukasz Kaiser的大模型第一性思考 : OpenAI科学家Lukasz Kaiser(Transformer八子之一)分享了他从逻辑学背景出发,参与Transformer架构发明,到深度参与GPT-4/5研发的历程。他强调从第一性原理构建系统的重要性,并预言AI的下一个阶段将是教会模型“思考”,通过生成更多中间步骤进行深度推理,而非直接输出答案,计算力将转向少量高质量数据上的海量推理。(来源:36氪)

语义图像合成:卫星河流照片骨架生成技术 : 机器学习社区正在探讨语义图像合成领域的最新进展,特别关注如何从河流图像的骨架生成黑白卫星河流照片。这一任务涉及使用生成器从新的、未见的骨架数据中进行卫星图像生成,并可能引入额外的条件变量。讨论旨在寻找最先进的方法和相关研究论文,以指导此类计算机视觉项目。(来源:Reddit r/MachineLearning)

AI时代的智能鸿沟:邱泽奇教授探讨AI对人类思维和认知的深远影响 : 北京大学邱泽奇教授指出,AI的使用并非简单导致“降智”,而更像是一种思维锻炼,取决于人的主动性和质疑态度。他强调人类对思维的认知仍处早期,AI虽强大但仍基于人类知识,无法完全模拟人类五官感知和跳跃性思维。AI的“讨好”倾向要求用户挑战它,并警惕其价值观。他认为AI时代基础能力培养和多样性社会发展更为重要,避免以高位视角观察“智能鸿沟”。(来源:36氪)