关键词:AI IDE, Gemini 3, LLM, AI代理, CUDA Tile, FP8量化, NeurIPS 2025, Google Antigravity AI IDE数据删除, Gemini 3 Pro多模态理解, LLM推理成本优化, Kimi Linear架构性能提升, NVIDIA CUDA Tile编程模型

🎯 动向

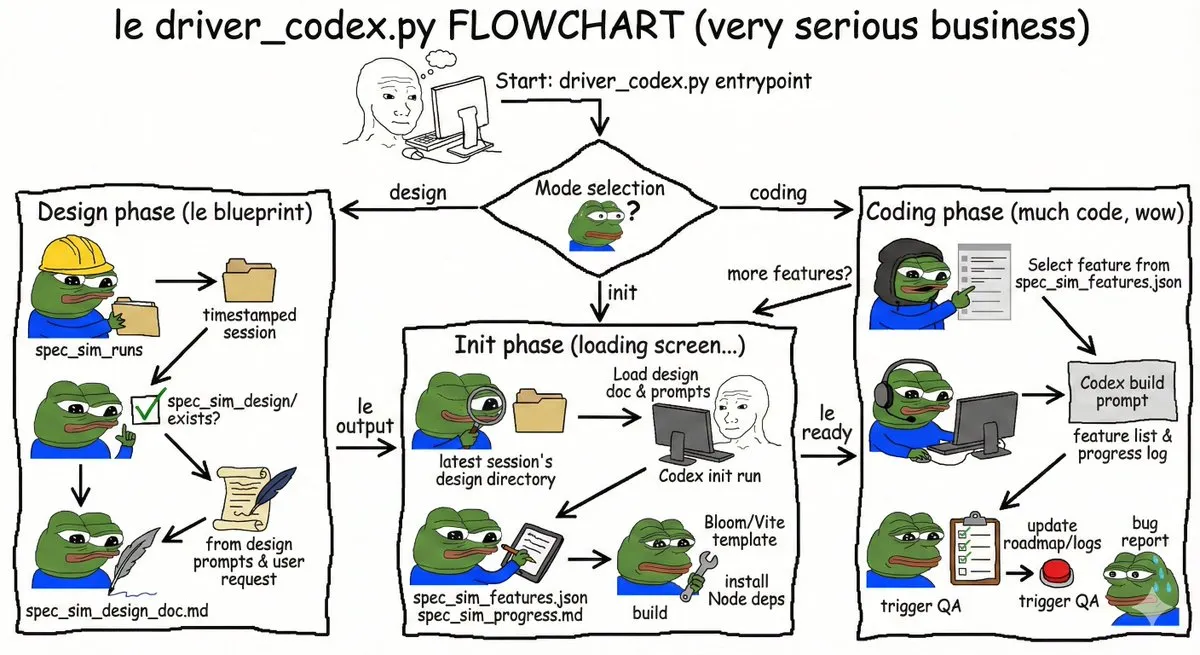

AI IDE误删用户硬盘数据事件 : Google Antigravity AI IDE在清理缓存时,因误解指令和“Turbo模式”的自主行为,导致用户D盘数据被永久删除。此事件凸显了AI代理工具在拥有高系统权限时,若出现误判可能带来的严重后果,引发了对AI编程工具安全边界和权限管理的担忧,建议在虚拟机或沙盒环境中运行此类工具。(来源: 36氪)

Hinton预测谷歌将超越OpenAI : AI教父Geoffrey Hinton预测Google将凭借Gemini 3、自研芯片、强大研究团队和数据优势超越OpenAI,并指出Google在多模态理解(文档、空间、屏幕、视频)方面的显著进展,特别是Gemini 3 Pro和Nano Banana Pro的成功。同时,ChatGPT增长放缓,促使OpenAI重新聚焦核心产品质量,以应对日益激烈的市场竞争。(来源: 36氪)

《State of AI 2025》报告揭示LLM使用趋势 : 一份基于万亿Token的真实LLM使用数据报告《State of AI 2025》指出,AI正向“思考和行动”的智能体(Agentic Inference)发展。报告揭示,角色扮演和编程占据AI使用近90%,中型模型正侵蚀大模型市场,推理型模型成为主流,且中国开源力量迅速崛起。(来源: dotey)

企业AI代理应用面临可靠性挑战 : 2025年企业AI报告显示,第三方工具采用率高,但多数内部AI代理未能通过试点,员工对AI试点存在抵触。成功的AI代理更注重可靠性而非功能,这表明企业在AI落地过程中,稳定性是关键考量,而非一味追求复杂功能。(来源: dbreunig)

LLM推理成本需大幅降低以实现规模化部署 : Google员工报告指出,鉴于每次搜索的广告收入微乎其微,LLM需要将推理成本降低10倍才能实现大规模部署。这凸显了当前LLM在商业应用中面临的巨大成本挑战,是未来技术优化和商业模式创新的关键瓶颈。(来源: suchenzang)

Kimi Linear架构报告发布,实现性能与速度提升 : Kimi Linear技术报告发布,介绍了一种新型架构,通过KDA内核在速度和性能上超越了传统全注意力机制,可作为全注意力的直接替代方案。这标志着LLM架构在效率优化方面取得了重要进展。(来源: teortaxesTex, Teknium)

字节跳动豆包AI手机发布,GUI Agent能力引关注 : 字节跳动联合中兴推出内置豆包AI助手的智能手机,实现GUI Agent能力,可“看懂”手机屏幕并模拟点击操作,完成跨应用复杂任务如比价、订票。此举开启了GUI Agent时代,但面临微信、支付宝等应用厂商的抵制,预示着AI助理将重塑用户与App的交互模式。(来源: dotey)

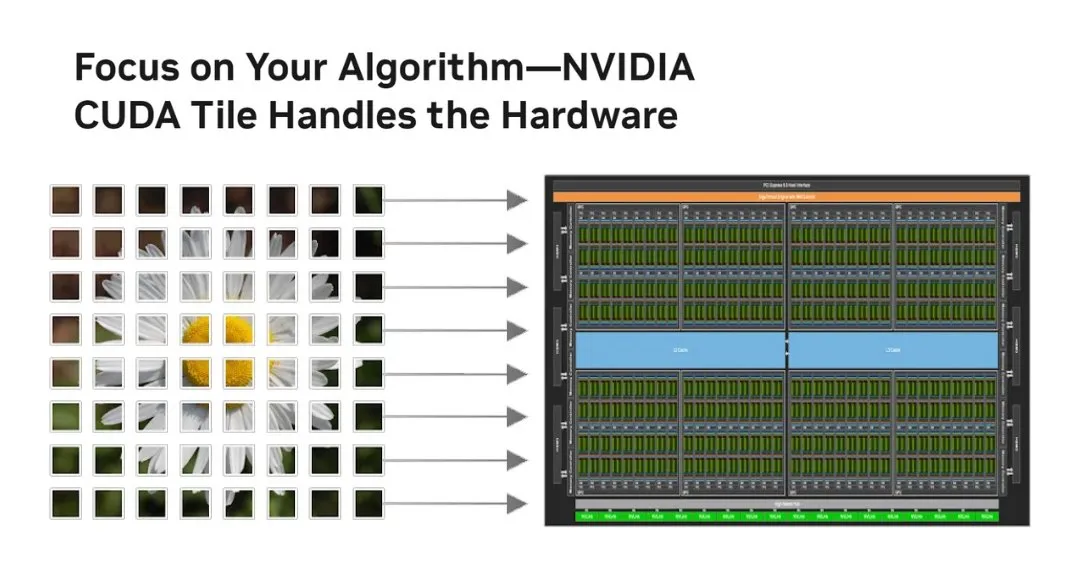

NVIDIA推出CUDA Tile,革新GPU编程模型 : NVIDIA发布CUDA Tile,这是自2006年以来CUDA的最大变革,将GPU编程从线程级SIMT转向基于Tile的操作。它通过CUDA Tile IR抽象硬件,使代码能高效运行于不同代GPU,简化了开发者编写高性能GPU算法的方式,尤其利于充分利用Tensor Cores等张量优化计算。(来源: TheTuringPost, TheTuringPost)

FP8量化技术提升LLM在消费级GPU上的可部署性 : RnJ-1-Instruct-8B模型通过FP8量化,将VRAM需求从16GB降至8GB,且性能损失极小(GSM8K约-0.9%,MMLU-Pro约-1.2%),使其能在RTX 3060 12GB等消费级GPU上运行。这显著降低了高性能LLM的硬件门槛,提高了其在个人设备上的可访问性和应用潜力。(来源: Reddit r/LocalLLaMA)

AI生成广告效果优于人类专家,但需隐藏AI身份 : 研究显示,纯AI生成的广告点击率比人类专家创建的广告高19%,但前提是受众不知道广告是由AI生成。一旦披露AI参与,广告效果会显著下降31.5%。这揭示了AI在广告创意中的巨大潜力,同时也提出了AI内容透明度和消费者接受度之间的伦理与市场挑战。(来源: Reddit r/artificial)

🧰 工具

微软Foundry Local:本地运行生成式AI模型平台 : 微软推出Foundry Local平台,允许用户在本地设备上运行生成式AI模型,无需Azure订阅,确保数据隐私和安全性。该平台通过ONNX Runtime和硬件加速优化性能,并提供OpenAI兼容API及多语言SDK,支持开发者集成模型到各类应用,是边缘计算和AI原型开发的理想选择。(来源: GitHub Trending)

PAL MCP:多模型AI代理协作与上下文管理 : PAL MCP(Model Context Protocol)服务器实现了多AI模型(如Gemini、OpenAI、Grok、Ollama)在单个CLI(如Claude Code、Gemini CLI)中的协同工作。它支持对话连续性、上下文恢复、多模型代码审查、调试和规划,并通过clink工具实现CLI间的无缝桥接,显著提升了AI开发效率和复杂任务处理能力。(来源: GitHub Trending)

NVIDIA cuTile Python:GPU并行内核编程模型 : NVIDIA发布了cuTile Python,一个用于编写NVIDIA GPU并行内核的编程模型。它需要CUDA Toolkit 13.1+,旨在提供更高级别的抽象,简化GPU算法开发,使开发者能更高效地利用GPU硬件进行计算,对深度学习和AI加速至关重要。(来源: GitHub Trending)

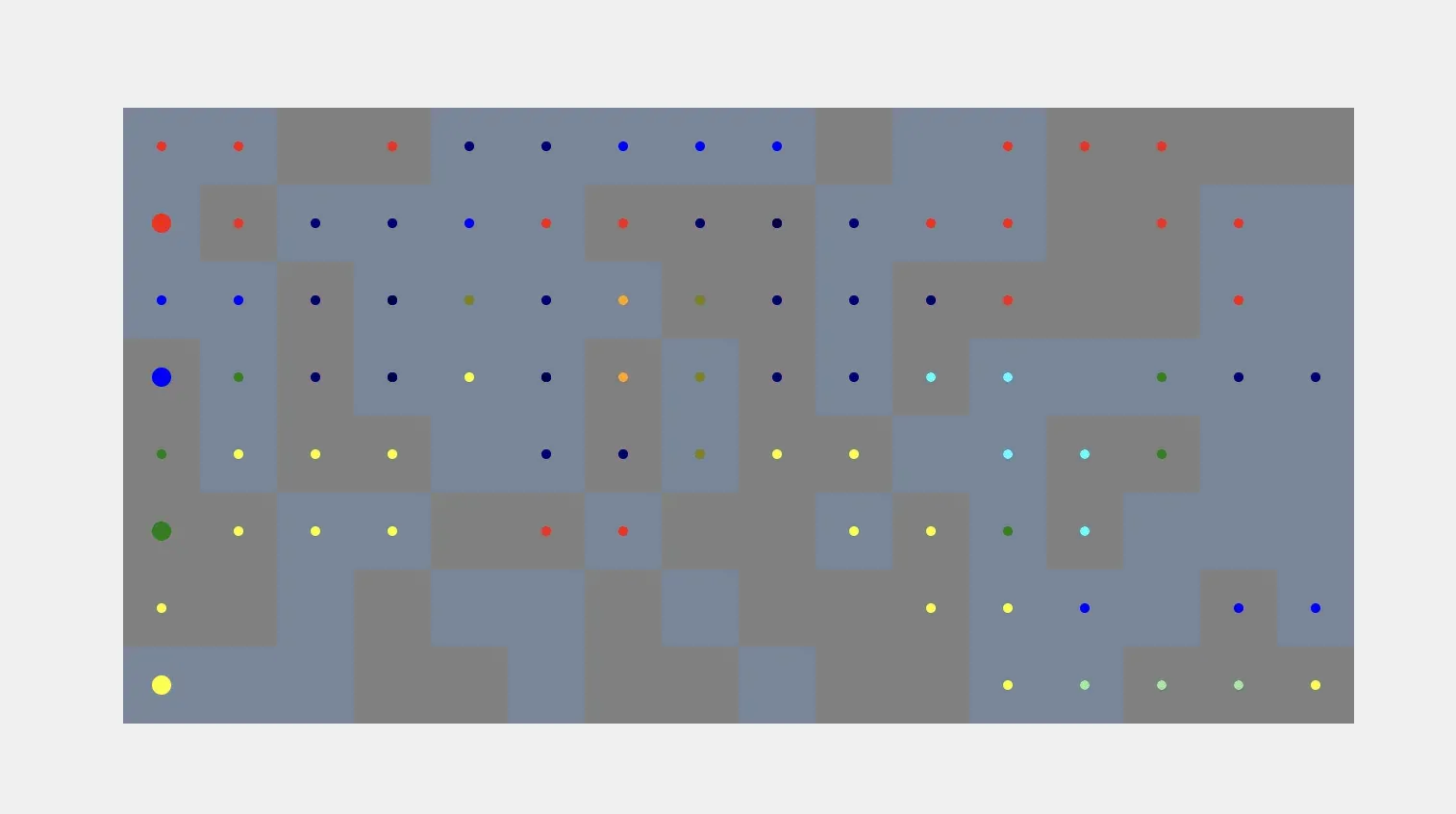

AI代理在模拟与通信中的应用 : AI代理能够根据用户提示自动生成体素模拟,实现从指令到可视化构建的自动化流程,目前仍面临将体素形状与真实世界对象进行接地的挑战。同时,Kylie作为一个多模态WhatsApp AI代理,能够处理文本、图像和语音输入,管理任务并执行实时网页搜索,展示了AI代理在日常通信和任务管理中的实用性。(来源: cto_junior, qdrant_engine)

ChatGPT语音交互与自定义指令增强 : ChatGPT的语音转文本功能因其卓越的准确性和智能化文本清理而备受赞誉,提供接近真人对话的便捷体验。此外,用户通过自定义指令能将ChatGPT转变为批判性思考伙伴,要求其指出事实错误、论点弱点,并提供替代方案,提升了对话的质量和深度。(来源: Reddit r/ChatGPT, Reddit r/ChatGPT)

Hugging Face与Replit:AI辅助开发平台 : Hugging Face提供了技能训练资源,帮助用户利用AI工具训练模型,预示AI将改变AI本身的开发方式。同时,Replit因其在AI开发领域的超前布局和持续创新而受到赞誉,为开发者提供了高效便捷的AI集成环境。(来源: ben_burtenshaw, amasad)

AI代理理解说话者识别技术 : Speechmatics提供实时说话者识别(diarization)技术,能为AI代理提供词级别的说话者标签,帮助代理理解对话中“谁说了什么”。该技术支持55+语言的本地或云端部署,并可进行微调,提升了AI代理在多方对话场景中的理解能力。(来源: TheTuringPost)

vLLM及前沿模型登陆Docker Model Runner : Ministral 3、DeepSeek-V3.2和vLLM v0.12.0等前沿开源模型现已在Docker Model Runner上可用。这意味着开发者可以通过一条命令轻松运行这些模型,简化了模型部署流程,提升了AI开发者的工作效率。(来源: vllm_project)

AI内容生成工具与提示词技巧 : SynthesiaIO推出免费AI圣诞视频生成器,用户只需输入脚本即可生成AI圣诞老人视频。同时,NanoBanana Pro支持JSON提示词实现高精度图像生成,而“反向提示词”技巧则能通过明确排除 undesired 风格,提升AI创意写作质量,共同推动了AI内容创作的便捷性和可控性。(来源: synthesiaIO, algo_diver, nptacek)

AI辅助开发与性能优化工具 : 一位父亲与5岁儿子使用Claude Opus 4.5、GitHub Copilot和Gemini等AI工具,在零编程知识下成功开发了Minecraft主题教育游戏,展示了AI在降低编程门槛、激发创意方面的潜力。同时,SGLang Diffusion与Cache-DiT集成,为扩散模型提供20-165%的本地图像/视频生成速度提升,显著提升了AI创作效率。(来源: Reddit r/ChatGPT, Reddit r/LocalLLaMA)

📚 学习

Datawhale《从零开始构建智能体》教程发布 : Datawhale社区发布了《从零开始构建智能体》开源教程,旨在帮助学习者从理论到实践全面掌握AI Native Agent的设计与实现。教程涵盖智能体原理、发展史、LLM基础、经典范式构建、低代码平台使用、自研框架、记忆与检索、上下文工程、Agentic RL训练、性能评估及综合案例开发等,是系统学习智能体技术的宝贵资源。(来源: GitHub Trending)

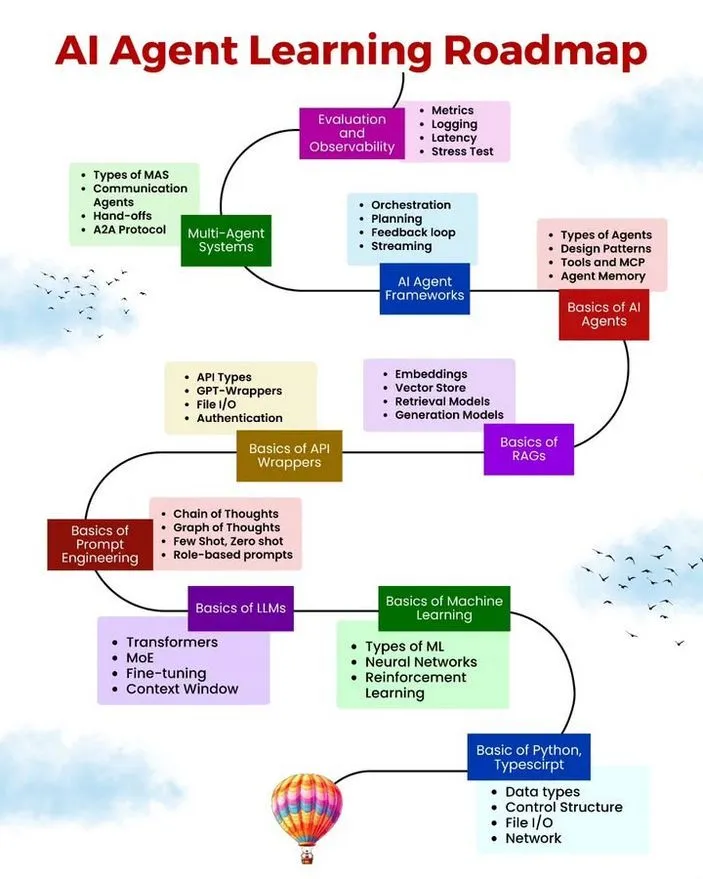

AI/ML学习资源、路线图与Agent常见错误 : Ronald van Loon分享了AI Agent学习路线图、免费AI/ML学习资源以及AI Agent开发中应避免的10个常见错误。这些资源旨在为有志于AI Agent开发的人士提供系统化的学习路径、实用材料和最佳实践,帮助开发者提高Agent的鲁棒性、效率和可靠性。(来源: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

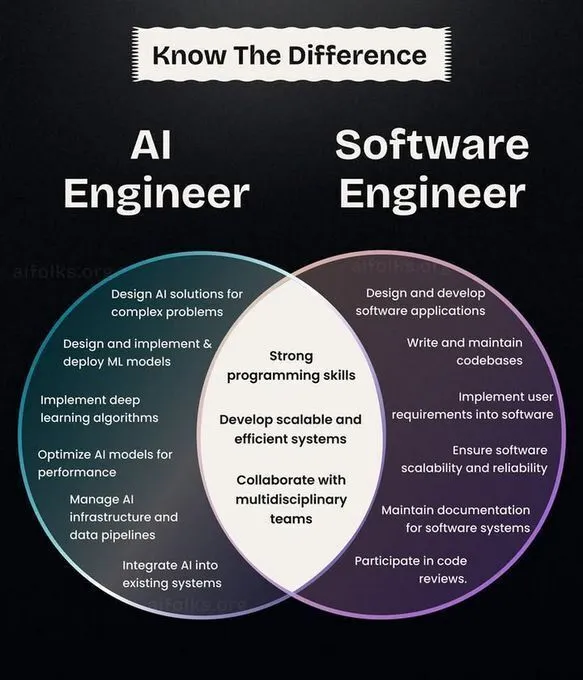

AI/ML职业发展、学习路径与CNN历史回顾 : Ronald van Loon分享了AI工程师与软件工程师的角色对比,为职业发展规划提供参考。同时,社区讨论了深度学习入门与研究路径,建议从头实现算法以加深理解,并回顾了卷积神经网络(CNN)的发明历史,为AI学习者提供了职业发展方向、实践建议和技术背景。(来源: Ronald_vanLoon, Reddit r/deeplearning, Reddit r/MachineLearning, Reddit r/artificial)

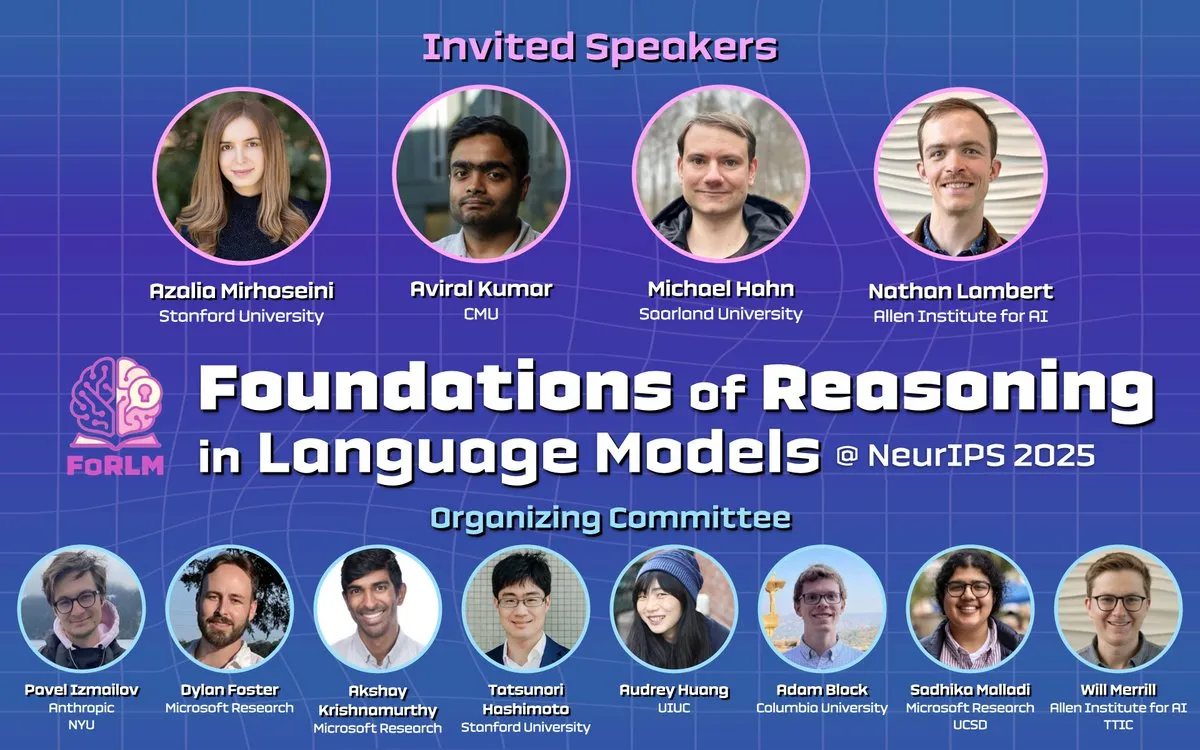

NeurIPS 2025大会聚焦LLM推理、可解释性与前沿论文 : NeurIPS 2025期间,多场研讨会(如Foundations of Reasoning in Language Models, CogInterp Workshop, LAW 2025 workshop)深入探讨了LLM的推理基础、可解释性、RL后训练的结构假设,以及对中间Token的语义和拟人化理解等前沿议题。会议展示了多篇杰出研究论文,推动了对LLM深层机制的理解。(来源: natolambert, sarahookr, rao2z, lateinteraction, TheTuringPost)

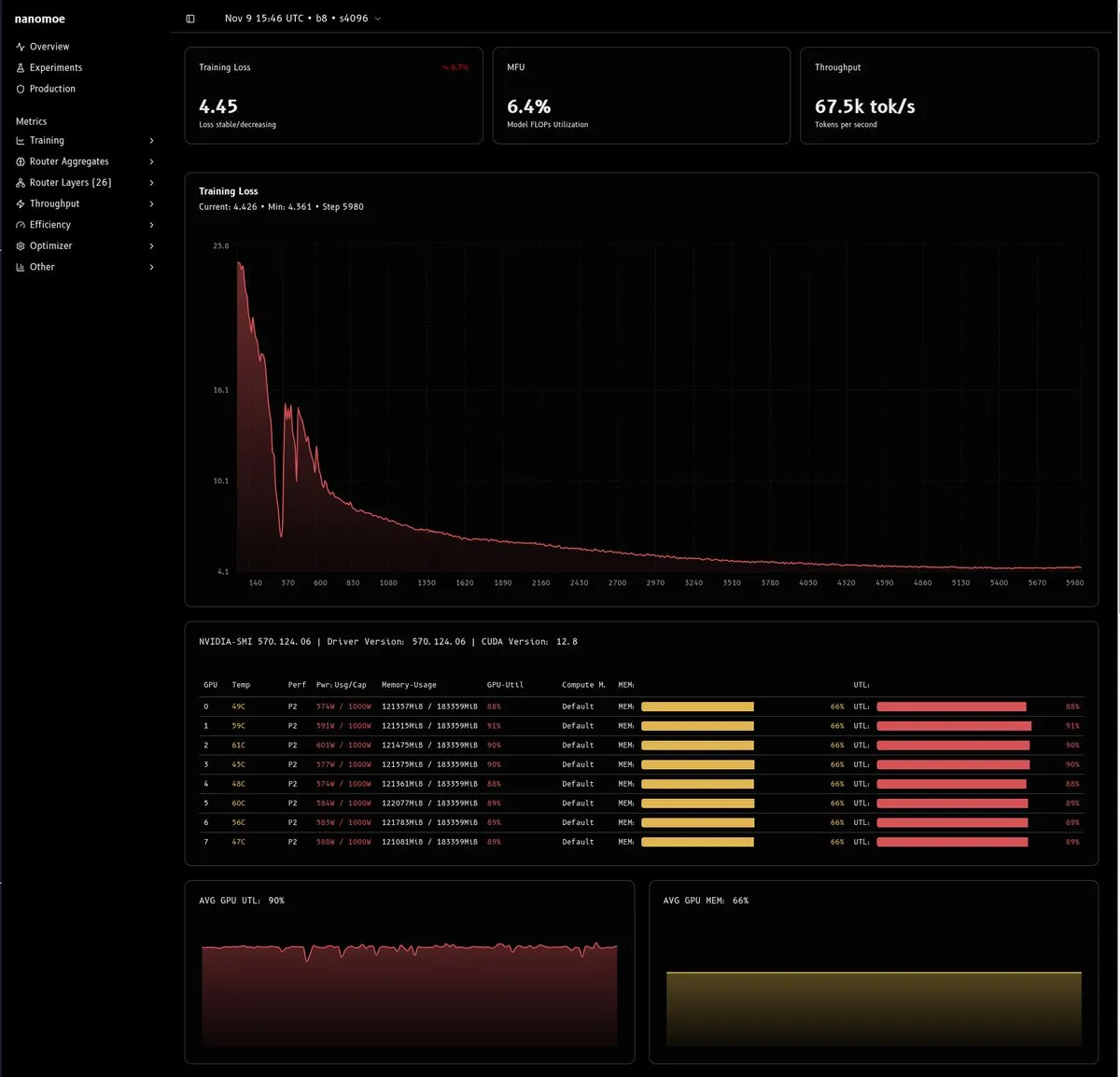

MoE模型训练挑战及解决方案深度分析 : 一篇详细的技术文章探讨了训练MoE模型(尤其是20B参数以下)的难点,主要集中在计算效率、负载均衡/路由器稳定性以及数据质量与数量。文章提出了混合精度训练、muP缩放、移除梯度裁剪和使用虚拟标量等创新性解决方案,并强调了构建高质量数据管道的重要性,为MoE研究和部署提供了宝贵经验。(来源: dejavucoder, tokenbender, eliebakouch, halvarflake, eliebakouch, teortaxesTex)

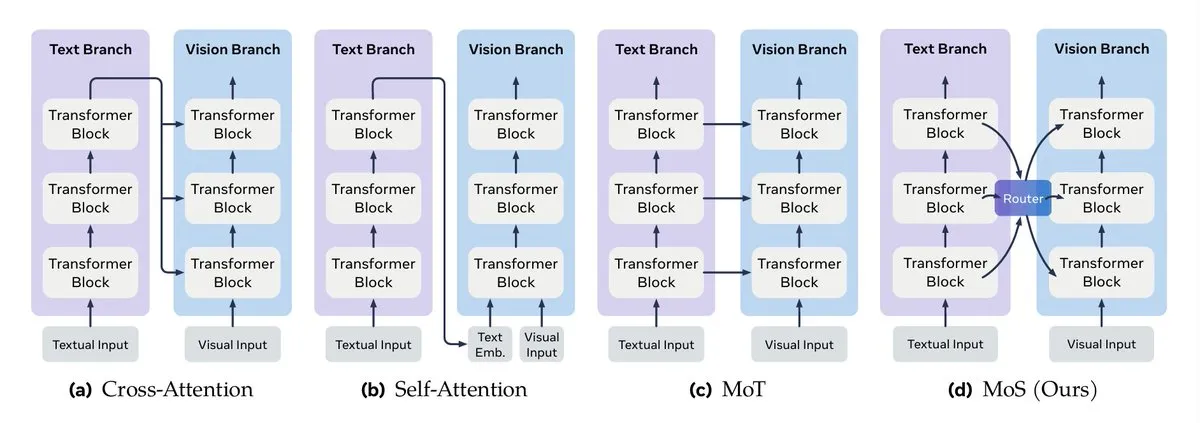

多模态数据融合与LLM上下文工程指南 : Turing Post详细介绍了多模态数据融合的关键方法,包括注意力机制融合、Transformer混合、图融合、核函数融合和状态混合。同时,Google发布了多智能体系统高效上下文工程指南,强调上下文管理并非简单字符串拼接,而是架构层考量,旨在解决成本、性能和幻觉问题。(来源: TheTuringPost, TheTuringPost, omarsar0)

Agentic AI课程与NVIDIA RAG部署指南 : 推荐了一系列Agentic AI的在线课程资源,涵盖从初级到高级的学习路径。同时,NVIDIA发布了技术指南,详细介绍了如何部署AI-Q研究助手和企业RAG蓝图,利用Nemotron NIMs和代理式Plan-Refine-Reflect工作流在Amazon EKS上运行,为企业级AI代理和RAG系统提供了实践指导。(来源: Reddit r/deeplearning, dl_weekly)

Agentic RL、程序记忆与StructOpt优化器 : 程序记忆(procedural memory)能够有效降低AI代理的成本和复杂度。同时,StructOpt作为一种新型一阶优化器,通过检测梯度变化速率调整自身,在平坦区域实现快速收敛,在高曲率区域保持稳定,为Agentic RL和LLM训练提供了高效的优化方法。(来源: Ronald_vanLoon, Reddit r/deeplearning)

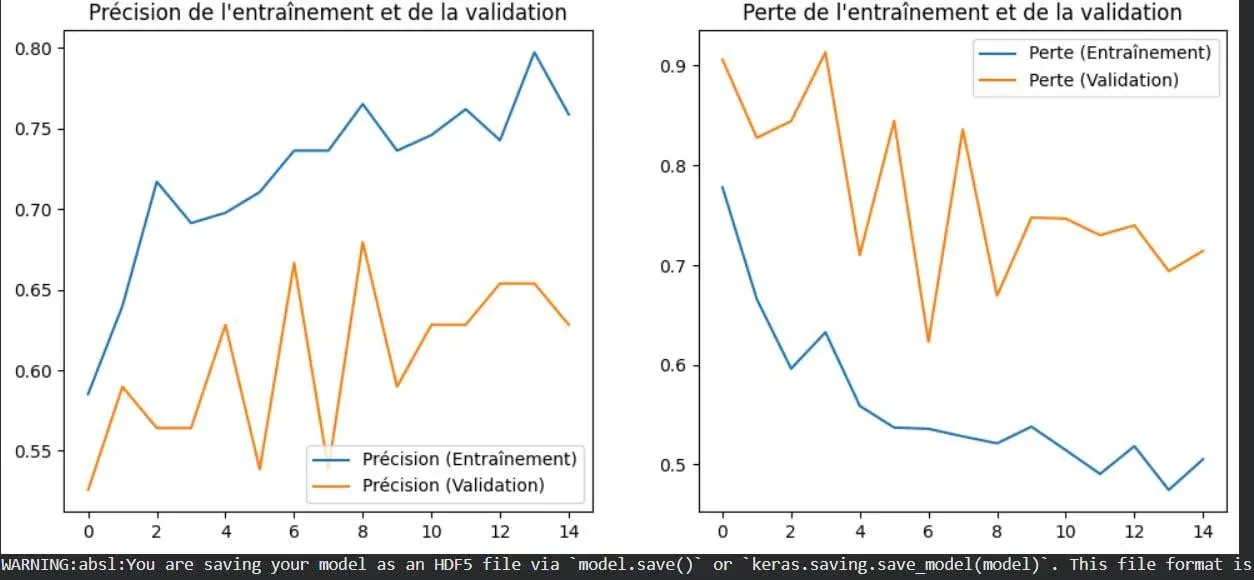

深度学习中的过拟合概念可视化 : 一张图片直观地展示了深度学习中的过拟合现象。过拟合是指模型在训练数据上表现良好,但在未见过的新数据上性能下降,是机器学习中需要解决的核心问题之一,理解其视觉表现有助于开发者更好地进行模型优化。(来源: Reddit r/deeplearning)

Contingency Races:新型规划基准测试与递归函数终止性分析 : 一项名为Contingency Races的新型基准测试被提出,用于评估AI模型的规划能力,通过其独特的复杂性促使模型主动模拟机制而非依赖记忆。同时,Victor Taelin分享了对Agda中递归函数终止性分析的简化理解,为理解函数式编程中的核心概念提供了更直观的方法。(来源: Reddit r/MachineLearning, VictorTaelin)

💼 商业

AI产品商业化策略:需求验证、10倍改进与护城河构建 : 讨论了AI产品从需求到商业化的关键路径。强调需求需已被验证(用户已付费解决),产品需提供10倍改进(而非边际优化),并构建护城河(速度、网络效应、品牌认知)以应对抄袭。核心在于找到真实痛点并提供颠覆性价值,而非仅凭技术创新。(来源: dotey)

Conjecture Institute获得风险投资 : Conjecture Institute宣布风险投资公司Floodgate的创始合伙人Mike Maples, Jr.作为白银捐赠者加入。这笔投资将支持Conjecture Institute在AI领域的研究和发展,反映了资本市场对前沿AI研究机构的持续关注。(来源: MoritzW42)

🌟 社区

AI/AGI的本质、哲学反思与数据劳动伦理 : 社区讨论AI/AGI的本质,如Elon Musk提出的“AI是压缩与关联”,以及AI对地球智能的“相变”影响。同时,对MoE架构的争议、AGI在复杂人类社会中可能面临的挑战,以及AI数据公司与数据劳动的伦理问题也引发了深层思考。(来源: lateinteraction, Suhail, pmddomingos, SchmidhuberAI, Reddit r/ArtificialInteligence, menhguin)

AI技术发展、伦理挑战与创意领域应用争议 : NeurIPS 2025大会汇聚了LLM、VLM等前沿研究,但AI在工厂化养殖中的应用、学术界LLM生成论文的诚信问题、以及Yoshua Bengio高产论文的署名争议引发了伦理讨论。同时,AI在创意领域中的角色也引发了关于效率与传统创作、就业影响的广泛争议。(来源: charles_irl, MiniMax__AI, dwarkesh_sp, giffmana, slashML, Reddit r/ChatGPT)

AI对职业与社会的影响及模型交互体验 : 个人故事展示AI如何帮助无经验者获得工作,以及AI对法律行业带来的冲击,引发了对AI影响就业和职业转型的讨论。同时,不同AI模型(如ChatGPT与Grok)在复杂场景下的“个性”差异,以及Claude模型“你绝对正确”的反馈、Gemini Pro图像生成重复等问题,也影响着用户对AI交互体验的感知。(来源: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, Reddit r/artificial, Reddit r/ClaudeAI, Reddit r/OpenWebUI)

AI社区内容质量、开发挑战与用户策略 : AI社区对低质量、AI生成内容(“AI slop”)的迅速增长表示担忧。同时,用户讨论本地LLM部署的硬件成本、性能与托管式服务的优劣,以及Claude上下文限制的应对策略,反映了AI开发与使用中面临的技术挑战和社区生态问题。(来源: Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/ClaudeAI, Reddit r/LocalLLaMA)

AI时代的技术支持与学习环境挑战 : 社区中用户对Colab GPU环境问题、Open WebUI集成Stable Diffusion等技术支持需求高涨,反映了AI学习和开发中普遍存在的计算资源配置和工具集成挑战。同时,对GPU内核编程的热潮也显示出对底层优化和性能提升的强烈兴趣。(来源: Reddit r/deeplearning, Reddit r/OpenWebUI, maharshii)

AI在室内/室外设计中的实际应用与用户体验 : 社区讨论AI在室内/室外设计中的实际应用情况,有用户分享了使用AI设计庭院屋顶的成功案例,认为AI能快速生成逼真设计方案。同时,也普遍好奇AI设计在现实中的落地情况和用户体验。(来源: Reddit r/ArtificialInteligence)

AI与数字转型对系统思维的需求 : 在复杂的AI系统和数字化生态中,需要从整体视角理解各组件的相互作用,而非孤立地看待问题,以确保技术能有效整合并实现预期价值。(来源: Ronald_vanLoon)

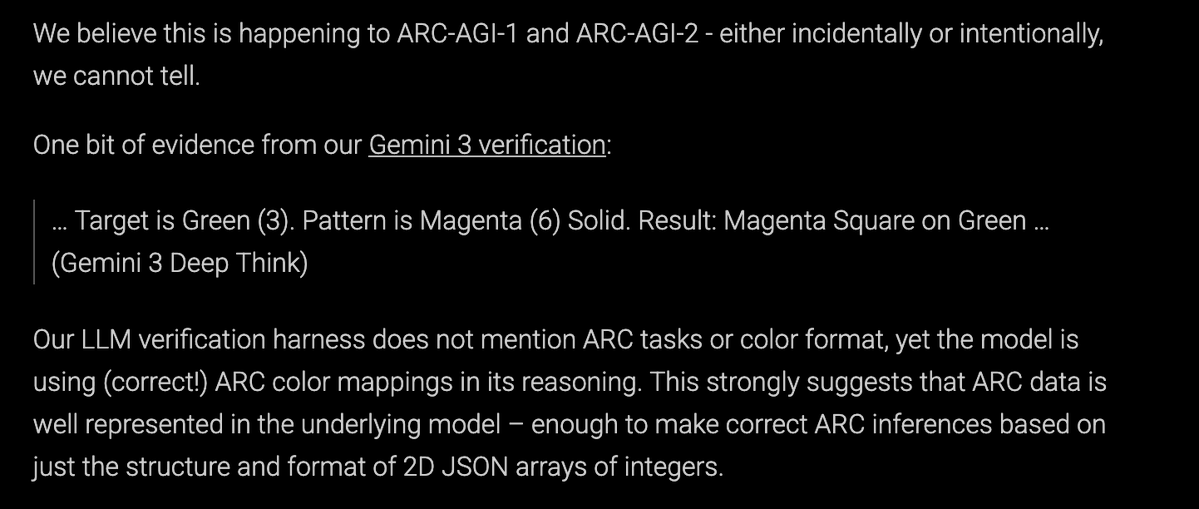

LLM训练数据生成与ARC-AGI基准讨论 : 社区讨论Gemini 3团队是否为ARC-AGI基准生成了大量合成数据,以及这对于AGI进展和ARC Prize的意义。这反映了对LLM训练数据来源、合成数据质量及其对模型能力影响的持续关注。(来源: teortaxesTex)

💡 其他

小学生利用AI对抗无家可归问题 : 德克萨斯州的小学生利用AI技术探索和开发解决方案,以应对当地的无家可归问题。这个项目展示了AI在社会公益领域的潜力,以及通过教育培养年轻一代利用科技解决实际问题的能力。(来源: kxan.com)