关键词:人形机器人, AI大模型, 强化学习, 多模态AI, AI Agent, Figure 03数据瓶颈, GPT-5 Pro数学证明, EmbeddingGemma设备端RAG, GraphQA图分析对话, NVIDIA Blackwell推理性能

🔥 聚焦

Figure 03登上《时代》最佳发明榜封面,CEO称“现阶段就差数据了” : Figure公司CEO Brett Adcock表示,人形机器人Figure 03目前最大的瓶颈在于“数据”,而非架构或算力,认为数据能解决几乎所有问题,推动机器人实现大规模应用。Figure 03登上《时代》杂志2025年最佳发明榜封面,引发了关于数据、算力与架构在机器人发展中重要性的讨论。Brett Adcock强调,Figure的目标是让机器人在家庭和商业场景中完成人类任务,并高度重视机器人安全,预言未来人形机器人数量可能超越人类。(来源: 量子位)

陶哲轩用GPT5-Pro跨界挑战!3年无解的难题,11分钟出完整证明 : 著名数学家陶哲轩与GPT-5 Pro合作,在11分钟内解决了微分几何领域一个3年无解的难题。GPT-5 Pro不仅完成了复杂计算,还直接给出了完整证明,甚至帮助陶哲轩修正了最初的直觉。陶哲轩总结AI在“小尺度”问题上表现出色,在“大尺度”理解问题上也有帮助,但在“中等尺度”策略上可能强化错误直觉。他强调AI应作为数学家的“副驾驶”,提升实验效率,而非完全替代人类在创造性、直觉性上的工作。(来源: 量子位)

🎯 动向

云澎科技发布AI+健康新品 : 云澎科技与帅康、创维合作发布AI+健康新品,包括“数智化未来厨房实验室”和搭载AI健康大模型的智能冰箱。AI健康大模型优化厨房设计与运营,智能冰箱通过“健康助手小云”提供个性化健康管理。这标志着AI在日常健康管理领域的突破,通过智能设备实现个性化健康服务,有望推动家庭健康科技发展,提升居民生活质量。(来源: 36氪)

人形机器人与具身智能进展:从家务到工业应用 : 多个社交讨论展示了人形机器人和具身智能的最新进展。Reachy Mini被《时代》杂志评为2025年最佳发明之一,体现了开源协作在机器人领域的潜力。AI驱动的仿生假肢让17岁少年实现意念控制,人形机器人能轻松完成家务。工业领域,Yondu AI发布了轮式人形机器人仓库拣选方案,AgiBot推出具备近人移动能力的Lingxi X2,中国也发布了高速球形警用机器人。Boston Dynamics的机器人则演变为多功能摄像师,LocoTouch四足机器人通过触觉实现智能运输。(来源: Ronald_vanLoon, Ronald_vanLoon, ClementDelangue, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, johnohallman, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

大模型能力突破与代码基准测试新进展 : GPT-5 Pro和Gemini 2.5 Pro在国际天文学与天体物理学奥林匹克竞赛(IOAA)中获得金牌表现,显示出AI在尖端物理学领域的强大能力。GPT-5 Pro还展现出超强的科学文献搜索和验证能力,解决了Erdos问题#339,并能有效识别已发表论文中的重大漏洞。在代码领域,KAT-Dev-72B-Exp成为SWE-Bench Verified榜首的开源模型,达到74.6%的修复率。SWE-Rebench项目通过测试大模型发布后新提出的GitHub issue来避免数据污染。Sam Altman对Codex的未来充满期待。关于AGI是否能通过纯LLM实现,AI研究界普遍认为仅靠LLM核心难以达到。(来源: gdb, karminski3, gdb, SebastienBubeck, karminski3, teortaxesTex, QuixiAI, sama, OfirPress, Reddit r/LocalLLaMA, Reddit r/ArtificialInteligence)

AI硬件与基础设施的性能革新与挑战 : NVIDIA Blackwell平台在SemiAnalysis InferenceMAX基准测试中展现出无与伦比的推理性能和效率,Together AI已提供NVIDIA GB200 NVL72和HGX B200系统。Groq通过其ASIC和垂直整合策略,以更低的延迟和有竞争力的价格重塑开源LLM基础设施经济。社区讨论了Python GIL移除对AI/ML工程的影响,认为其移除有望提升多线程性能。此外,LLM爱好者分享了各自的硬件配置,并探讨了大型量化模型与小型非量化模型在不同量化级别下的性能权衡,指出2-bit量化可能适用于对话,但编码任务至少需要Q5。(来源: togethercompute, arankomatsuzaki, code_star, MostafaRohani, jeremyphoward, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

AI模型与应用前沿动态:从通用模型到垂直领域 : AI领域新模型和功能持续涌现。土耳其语大模型Kumru-2B在Hugging Face上崭露头角,Replit本周发布了多项更新。Sora 2已移除水印,预示着视频生成技术将带来更广泛的应用。有传言称Gemini 3.0将于10月22日发布。AI在医疗健康领域持续深化,数字病理学正通过AI辅助癌症诊断,无标记显微镜结合AI有望带来新的诊断工具。增强现实(AR)模型在Imagenet FID榜单上取得SOTA。Qwen Code命令行编码Agent更新支持Qwen-VL模型识别图片。斯坦福大学提出Agentic Context Engineering (ACE)方法,使模型无需微调即可变得更智能。DeepSeek V3系列模型也在持续迭代,AI Agent的部署类型和AI对专业服务领域的重塑也成为行业关注焦点。(来源: mervenoyann, amasad, scaling01, npew, kaifulee, Ronald_vanLoon, scaling01, TheTuringPost, TomLikesRobots, iScienceLuvr, NerdyRodent, shxf0072, gabriberton, Ronald_vanLoon, karminski3, Ronald_vanLoon, teortaxesTex, demishassabis, Dorialexander, yoheinakajima, 36氪)

🧰 工具

GraphQA:将图分析转化为自然语言对话 : LangChainAI推出了GraphQA框架,该框架结合NetworkX和LangChain,能将复杂的图分析转化为自然语言对话。用户可以用普通英语提问,GraphQA会自动选择并执行合适的算法,处理节点数超过10万的图。这极大地简化了图数据分析的门槛,使其更易于非专业用户使用,是LLM领域的一项重要工具创新。(来源: LangChainAI)

VS Code顶级Agentic AI工具 : Visual Studio Magazine将某款工具评为VS Code顶级Agentic AI工具之一,标志着开发范式正从“助手”转向能与开发者共同思考、行动和构建的“真正Agent”。这反映了AI工具在软件开发领域从辅助性功能向更深层次智能协作的演进,提升了开发者的效率和体验。(来源: cline)

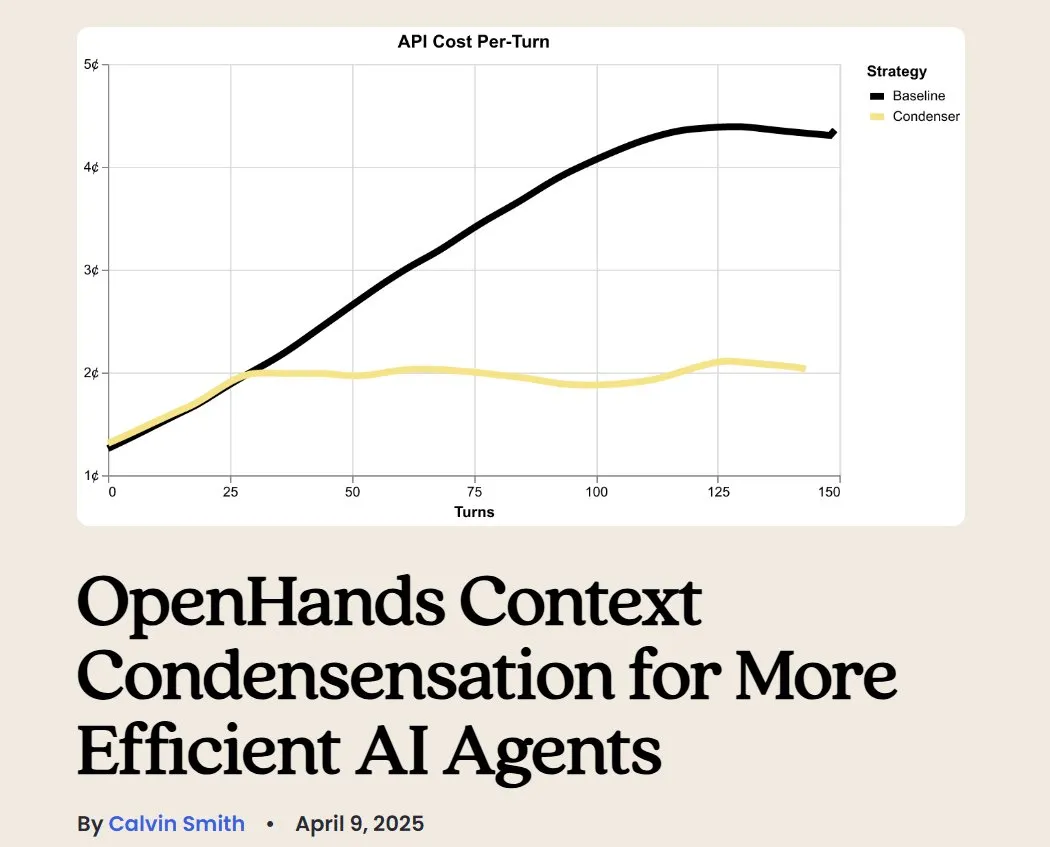

OpenHands:LLM上下文管理开源工具 : OpenHands作为一个开源工具,提供了多种上下文压缩器来管理LLM在Agentic应用中的上下文,包括基本的历史修剪、提取“最重要事件”以及浏览器输出压缩等。这对于调试、评估和监控LLM应用、RAG系统和Agentic工作流至关重要,有助于提高LLM在复杂任务中的效率和一致性。(来源: gneubig)

BLAST:AI网络浏览器引擎 : LangChainAI发布了BLAST,一个高性能的AI网络浏览器引擎,旨在为AI应用提供网页浏览能力。BLAST提供OpenAI兼容接口,支持自动并行化、智能缓存和实时流媒体,能够高效地将网页信息集成到AI工作流中,极大地扩展了AI Agent获取和处理实时网络数据的能力。(来源: LangChainAI)

Opik:开源LLM评估工具 : Opik是一款开源的LLM评估工具,用于调试、评估和监控LLM应用、RAG系统和Agentic工作流。它提供全面的追踪、自动化评估和生产就绪的仪表板,帮助开发者更好地理解模型行为、优化性能并确保应用在实际场景中的可靠性。(来源: dl_weekly)

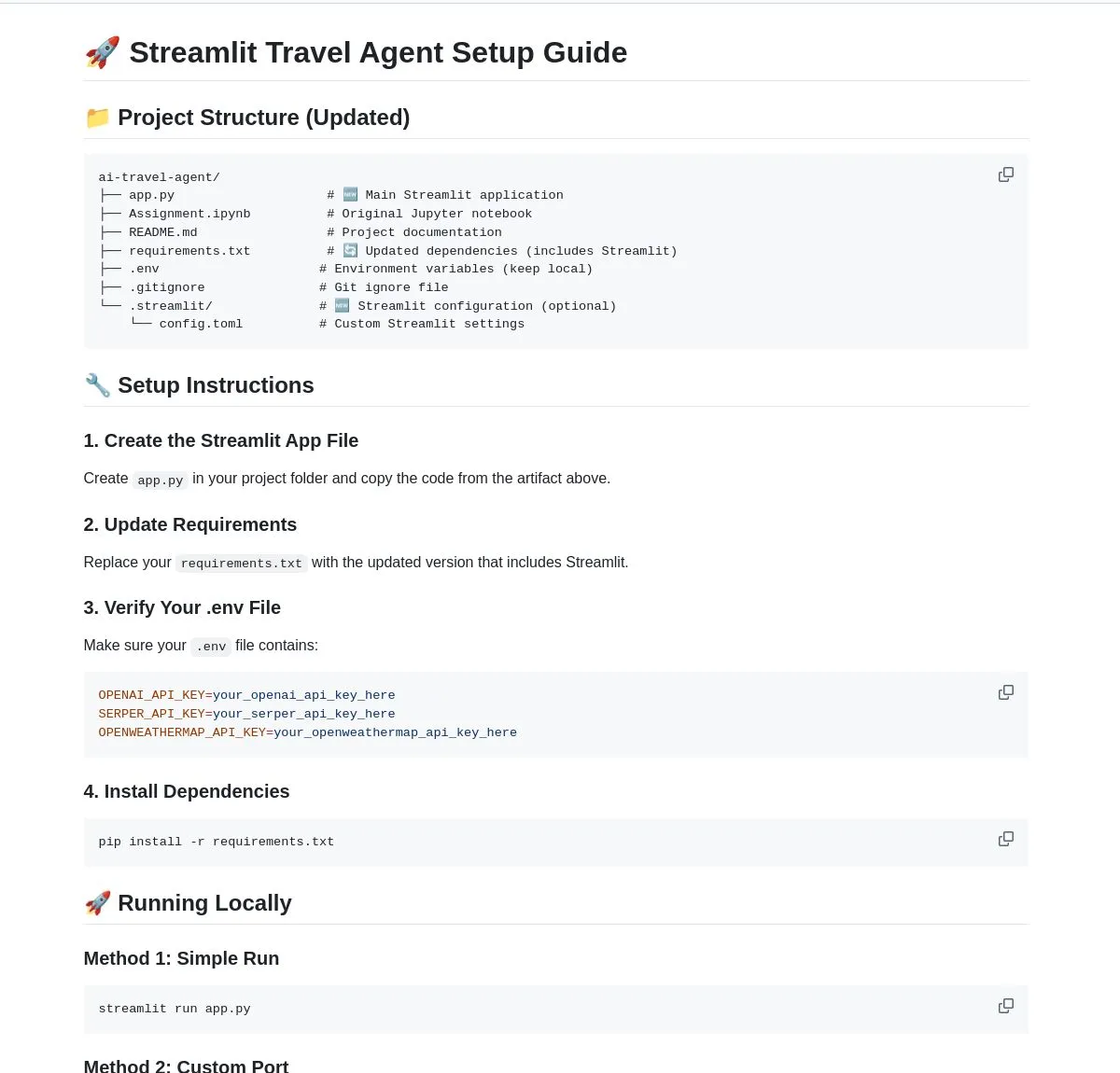

AI旅行Agent:智能规划助手 : LangChainAI展示了一个智能AI旅行Agent,它集成了实时天气、搜索和旅行信息,并利用多个API简化了从天气更新到货币兑换的整个流程。该Agent旨在提供一站式旅行规划和协助,提升用户旅行体验,是LLM在垂直应用场景中赋能Agent的典型案例。(来源: LangChainAI)

AI广告主提示词构建工具设想 : 有观点提出,市场急需一款帮助营销人员构建“广告主提示词”的AI工具。该工具应能协助建立评估体系(涵盖品牌安全、提示词遵循度等),并对主流模型进行测试。随着OpenAI推出多种自然广告单元,营销提示词的重要性日益凸显,这类工具将成为广告创意和分发流程中的关键环节。(来源: dbreunig)

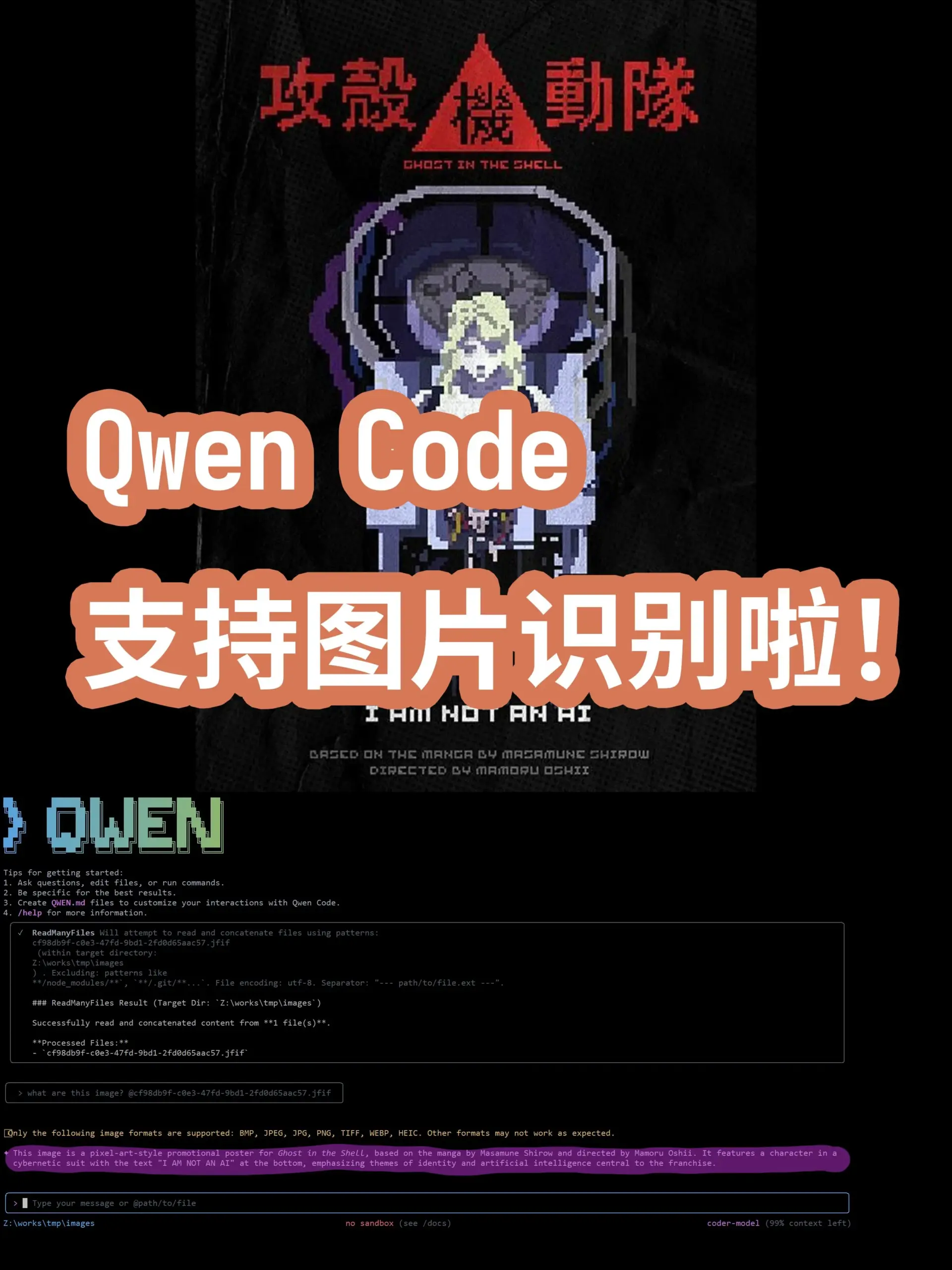

Qwen Code更新:支持Qwen-VL模型图片识别 : Qwen Code命令行编码Agent近期更新,新增支持切换到Qwen-VL模型进行图片识别。用户测试显示效果良好,且目前可免费使用。这一更新极大地扩展了Qwen Code的能力,使其不仅能处理代码任务,还能进行多模态交互,提升了编码Agent在处理包含视觉信息任务时的效率和准确性。(来源: karminski3)

利用LibreChat托管个人聊天机器人服务器 : 一篇博客文章提供了使用LibreChat托管个人聊天机器人服务器并连接到多个模型控制面板(MCPs)的指南。这使得用户能够灵活地管理和切换不同的LLM后端,实现自定义的聊天机器人体验,强调了开源解决方案在AI应用部署中的灵活性和可控性。(来源: Reddit r/artificial)

AI生成器:将虚拟形象带入生活 : 一位用户寻求最佳AI生成器,希望将自己的品牌形象(包括真人视频和虚拟形象)“带入生活”,用于YouTube频道,以减少拍摄和录制时间,专注于剪辑。用户希望AI能让虚拟形象进行对话、玩游戏、跳舞等。这反映了内容创作者对AI工具在虚拟形象动画和视频生成方面的高度需求,以提高生产效率和内容多样性。(来源: Reddit r/artificial)

本地LLM对抗邮件垃圾:私密解决方案 : 一篇博客文章分享了如何利用本地LLM在自己的邮件服务器上私密地识别和对抗垃圾邮件的实践。该方案结合Mailcow、Rspamd、Ollama和自定义Python代理,为自托管邮件服务器的用户提供了一种基于AI的垃圾邮件过滤方法,强调了本地LLM在保护隐私和定制化应用方面的潜力。(来源: Reddit r/LocalLLaMA)

📚 学习

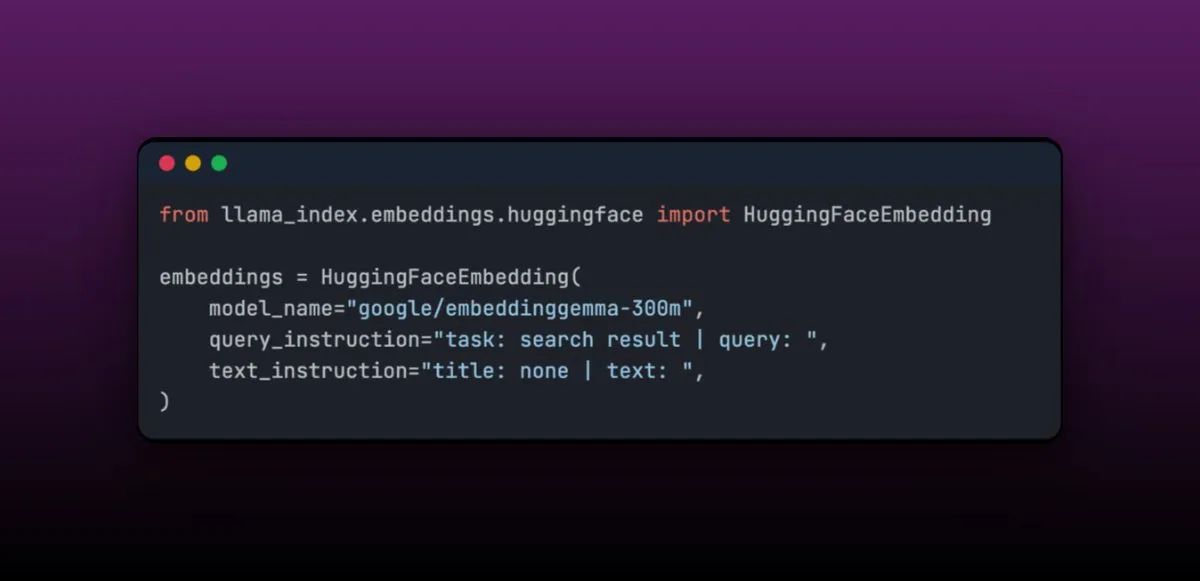

EmbeddingGemma:设备端RAG应用的多语言嵌入模型 : EmbeddingGemma是一个紧凑的多语言嵌入模型,参数量仅308M,非常适合设备端RAG应用,且易于与LlamaIndex集成。该模型在Massive Text Embedding Benchmark上排名靠前,同时体积小巧,适合移动设备。其易于微调的特性,使得在特定领域(如医疗数据)进行微调后,性能可超越更大的模型。(来源: jerryjliu0)

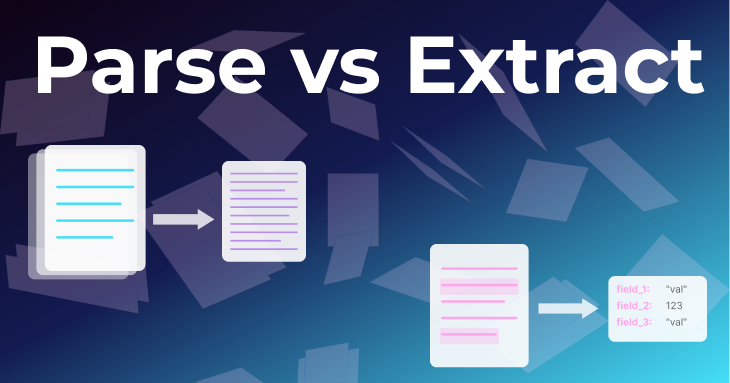

文档处理的两种基本方法:解析与提取 : LlamaIndex团队的一篇文章深入探讨了文档处理中的“解析”与“提取”两种基本方法。解析是将整个文档转换为结构化Markdown或JSON,保留所有信息,适用于RAG、深度研究和总结。提取是从LLM获取结构化输出,将文档标准化为通用模式,适用于数据库ETL、自动化Agent工作流和元数据提取。理解两者区别对于构建高效的文档Agent至关重要。(来源: jerryjliu0)

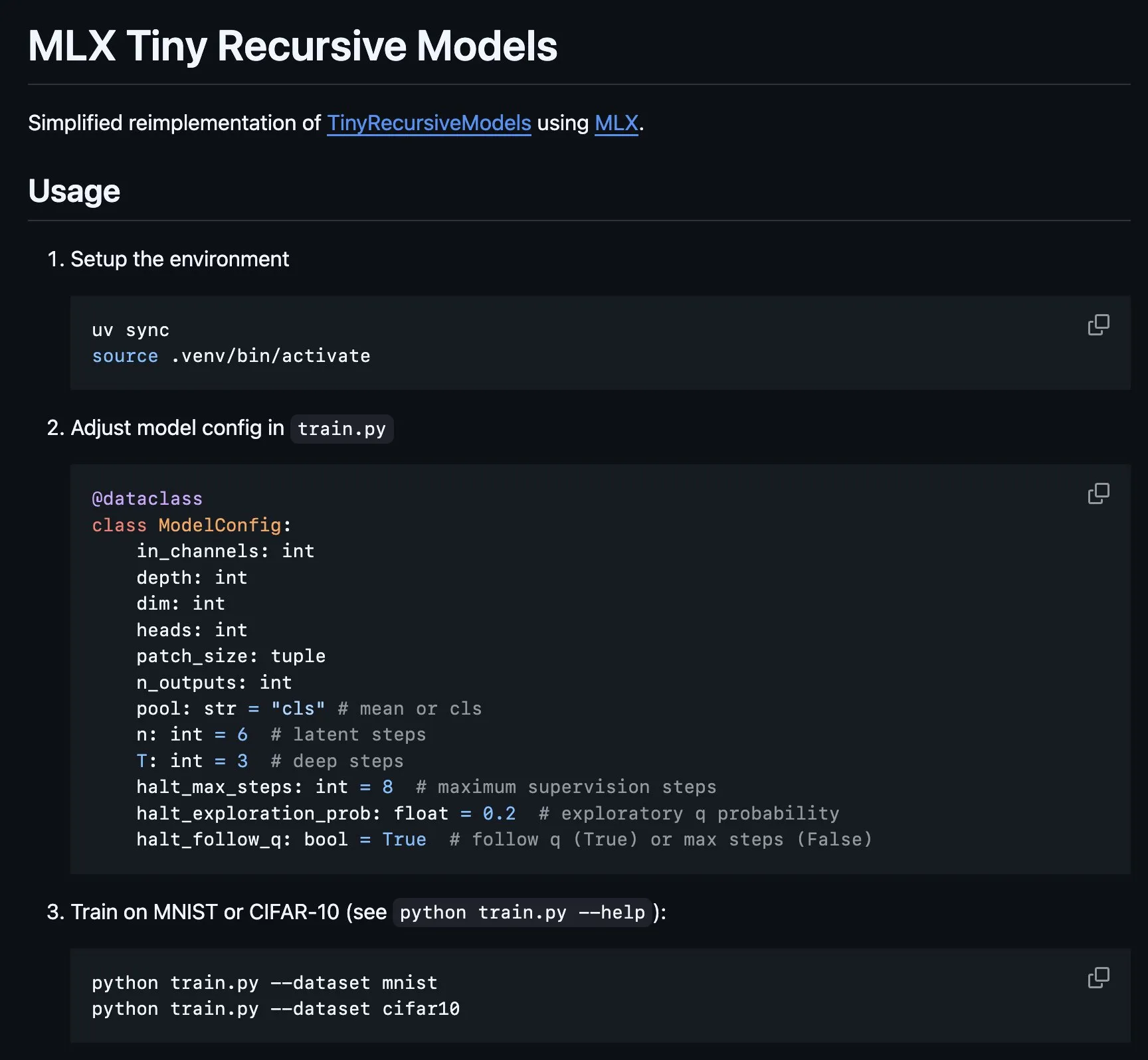

Tiny Recursive Model (TRM)在MLX上的实现 : MLX平台实现Tiny Recursive Model (TRM)的核心部分,该模型由Alexia Jolicoeur-Martineau提出,旨在以7M参数的微小神经网络通过递归推理获得高性能。这一MLX实现使得在Apple Silicon笔记本上进行本地实验成为可能,降低了复杂性,涵盖了深度监督、递归推理步骤、EMA等特性,为小型高效模型的开发和研究提供了便利。(来源: awnihannun, ImazAngel)

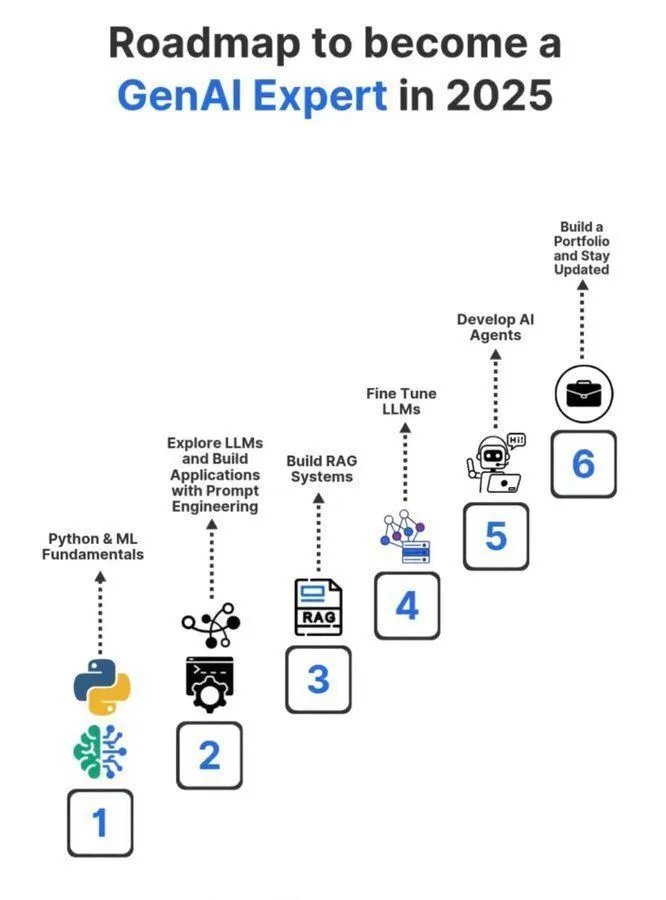

2025年生成式AI专家学习路线图 : 一份详细的2025年生成式AI专家学习路线图在社交媒体上被分享,涵盖了成为生成式AI领域专业人士所需的关键知识和技能。该路线图旨在指导有志者系统学习人工智能、机器学习和深度学习等核心概念,以适应快速发展的GenAI技术趋势。(来源: Ronald_vanLoon)

机器学习博士学习经验分享 : 一位用户重新分享了关于在机器学习领域攻读博士的系列推文,旨在为对ML博士学习感兴趣的人提供指导和经验。这些推文可能涵盖了申请流程、研究方向、职业发展以及个人经历等内容,是社区中宝贵的AI学习资源。(来源: arohan)

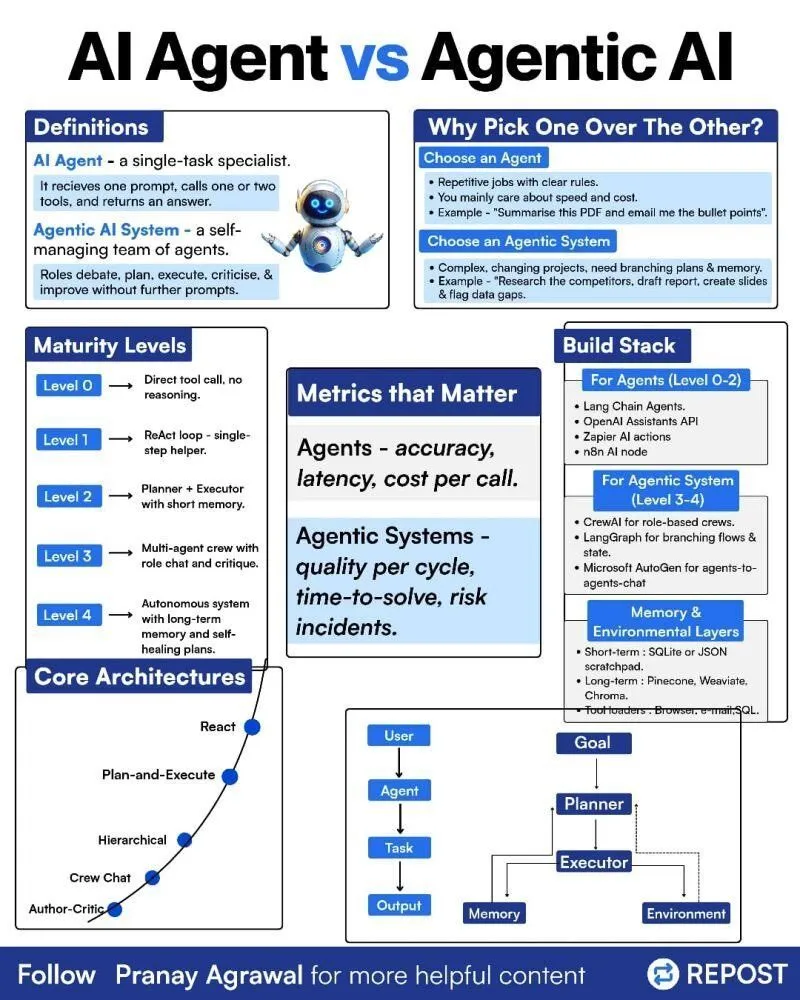

AI Agents与Agentic AI的区别 : 社交媒体上有人分享了关于“AI Agents”和“Agentic AI”之间区别的图解,旨在澄清这两个相关但不同的概念。这有助于社区更好地理解AI Agent的部署类型、其自主性水平以及Agentic AI在更广泛的人工智能系统中的作用,推动对Agent技术更精确的讨论。(来源: Ronald_vanLoon)

LLM训练中的强化学习与权重衰减 : 社交媒体讨论了在LLM强化学习(RL)训练中,权重衰减(Weight Decay)可能不是一个好主意。有观点认为,权重衰减会导致网络忘记大量预训练信息,尤其是在优势为零的GRPO更新中,权重会趋向于零。这提示研究者在设计LLM的RL训练策略时,需谨慎考虑权重衰减的影响,以避免模型性能下降。(来源: lateinteraction)

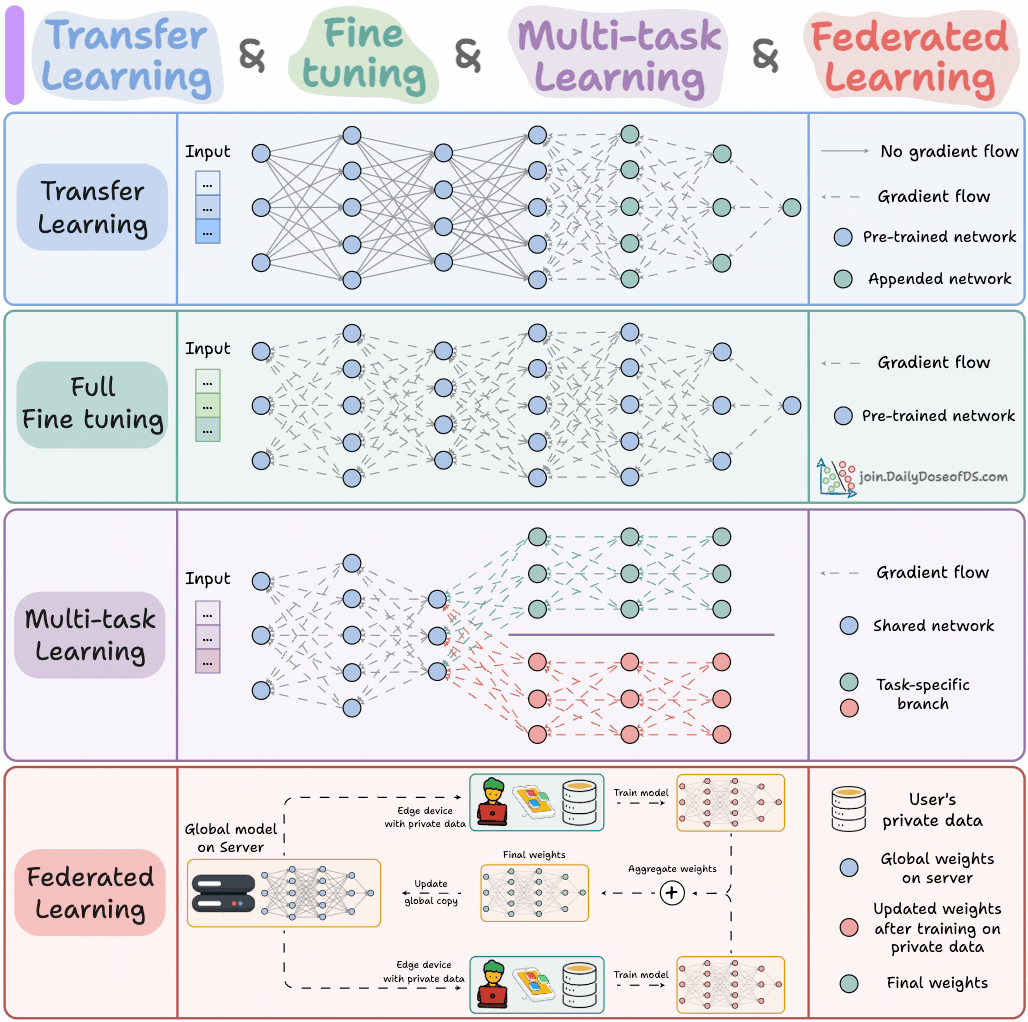

AI模型训练范式 : 一位专家分享了ML工程师必须了解的四种模型训练范式,旨在为机器学习工程师提供关键的理论指导和实践框架。这些范式可能涵盖了监督学习、无监督学习、强化学习和自监督学习等,帮助工程师更好地理解和应用不同的模型训练方法。(来源: _avichawla)

基于课程学习的强化学习提升LLM能力 : 一项研究发现,结合课程学习的强化学习(RL)能够教授LLM新的能力,这是其他方法难以实现的。这表明课程学习在提升LLM长期推理能力方面的潜力,预示着RL与课程学习的结合可能成为解锁AI新技能的关键途径。(来源: sytelus)

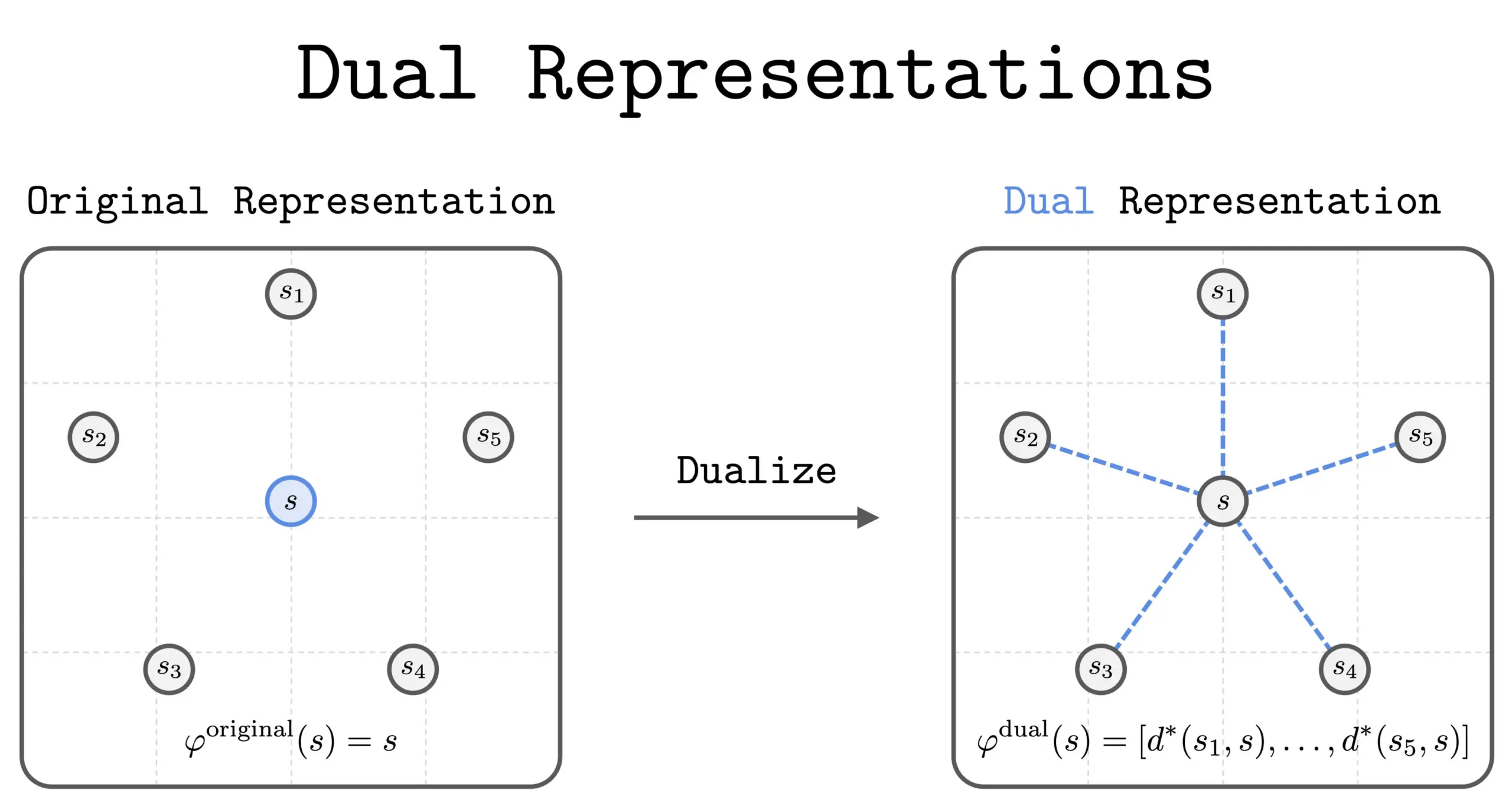

RL中的双重表示新方法 : 一项新的研究引入了强化学习(RL)中的“双重表示”方法。该方法通过将状态表示为与所有其他状态的“相似性集合”,提供了新的视角。这种双重表示具有良好的理论特性和实际效益,有望提升RL的性能和理解能力。(来源: dilipkay)

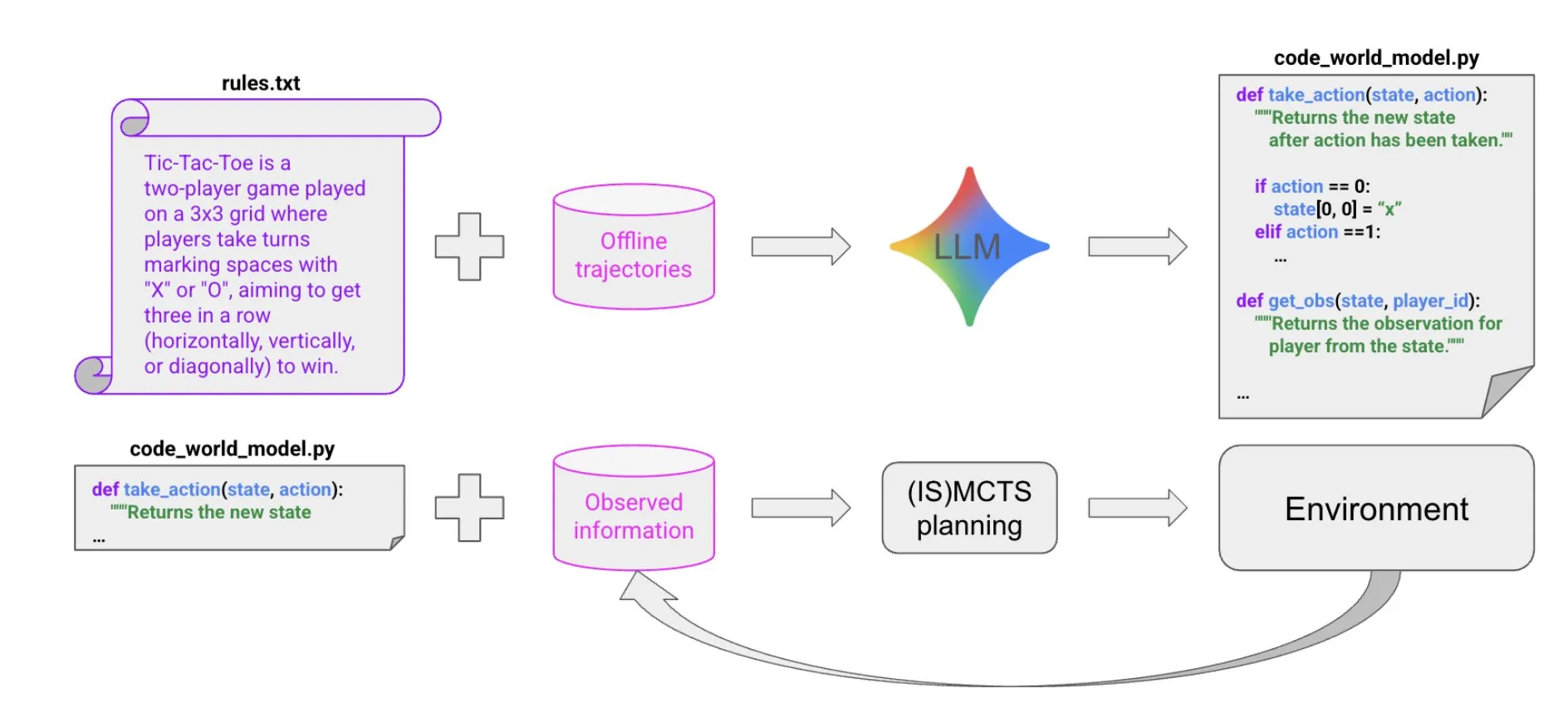

LLM驱动的代码合成构建世界模型 : 一篇新论文提出了一种极其样本高效的方法,通过LLM驱动的代码合成来创建能够在多Agent、部分可观察的符号环境中表现良好的Agent。该方法从少量轨迹数据和背景信息中学习代码世界模型,然后将其传递给现有求解器(如MCTS)选择下一步行动,为构建复杂Agent提供了新思路。(来源: BlackHC)

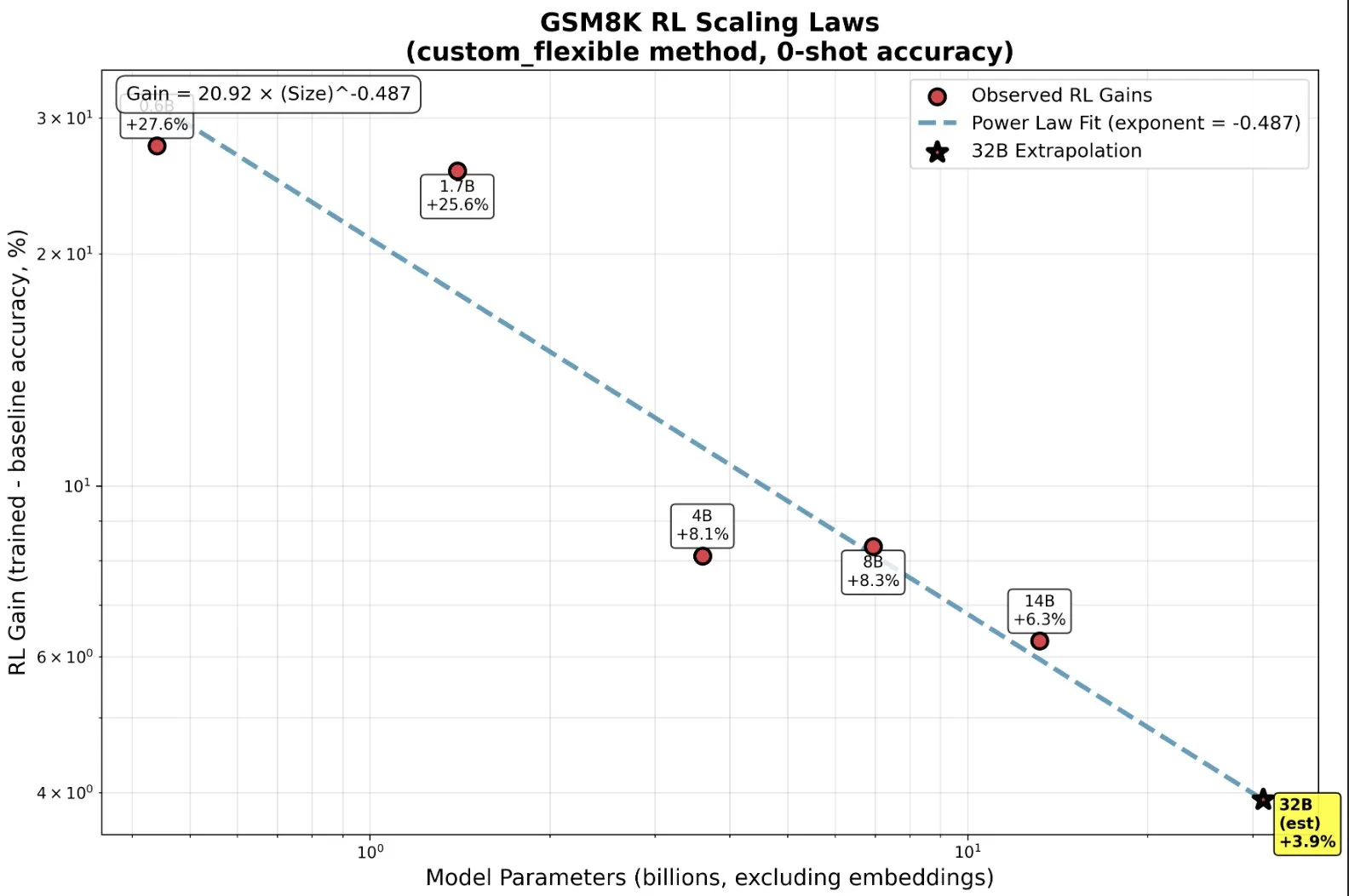

RL训练小模型:超越预训练的涌现能力 : 研究发现,在强化学习(RL)中,小模型能不成比例地受益,甚至出现“涌现”能力,这颠覆了“越大越好”的传统直觉。在小规模模型上,RL可能比更多的预训练更具计算效率。这一发现对AI实验室在扩展RL时何时停止预训练、何时开始RL的决策具有重要意义,揭示了RL在模型规模和性能提升之间的新缩放规律。(来源: ClementDelangue, ClementDelangue)

AI vs. 机器学习 vs. 深度学习:简单解释 : 一个视频资源以简单易懂的方式解释了人工智能(AI)、机器学习(ML)和深度学习(DL)之间的区别。该视频旨在帮助初学者快速理解这些核心概念,为进一步深入学习AI领域打下基础。

深度学习模型实验中的提示模板管理 : 深度学习社区讨论了如何在模型实验中管理和复用提示模板。在大型项目中,尤其是在修改架构或数据集时,追踪不同提示词变体的效果变得复杂。用户分享了使用Empromptu AI等工具进行提示词版本控制和分类的经验,强调提示词版本化和数据集与提示词对齐的重要性,以优化模型产品。(来源: Reddit r/deeplearning)

代码补全(FIM)模型选择指南 : 社区讨论了选择代码补全(FIM)模型的关键因素。速度被认为是绝对优先,建议选择参数少且仅使用GPU运行的模型(目标>70 t/s)。此外,“基础”模型与指令模型在FIM任务中表现相似。讨论还列举了Qwen3-Coder、KwaiCoder等近期和稍旧的FIM模型,并探讨了nvim.llm等工具如何支持非代码特定模型。(来源: Reddit r/LocalLLaMA)

量化模型性能权衡:大模型与低精度 : 社区讨论了大型量化模型与小型非量化模型之间的性能权衡,以及量化级别对模型表现的影响。普遍认为2-bit量化可能适用于写作或对话,但对于编码等任务,至少需要Q5级别。有用户指出,Gemma3-27B在低量化下性能下降严重,而一些新模型在FP4精度下训练,无需更高精度。这表明量化效果因模型和任务而异,需要具体测试。(来源: Reddit r/LocalLLaMA)

R语言MissForest在预测任务中失败的原因 : 一篇分析文章探讨了R语言的MissForest算法在预测任务中失败的原因,指出其在归因时悄然打破了训练集和测试集分离的关键原则。文章解释了MissForest在此类情况下的局限性,并介绍了MissForestPredict等新方法如何通过保持学习和应用之间的一致性来解决这一问题。这对于机器学习实践者在处理缺失值和构建预测模型时具有重要指导意义。(来源: Reddit r/MachineLearning)

多模态机器学习资源寻求 : 社区用户寻求多模态机器学习的学习资源,特别是关于如何结合不同数据类型(文本、图像、信号等)以及理解融合、对齐和跨模态注意力等概念的理论与实践材料。这反映了对多模态AI技术日益增长的学习需求。(来源: Reddit r/deeplearning)

强化学习训练推理模型视频资源寻求 : 机器学习社区寻求关于使用强化学习(RL)训练推理模型的最佳科学讲座视频资源,包括概述性视频和特定方法的深入讲解。用户希望获取高质量的学术内容,而非肤浅的网红视频,以快速了解相关文献并决定进一步研究方向。(来源: Reddit r/MachineLearning)

11个月AI编码旅程:工具、技术栈与最佳实践 : 一位开发者分享了长达11个月的AI编码旅程,详细介绍了使用Claude Code等工具的经验、失败和最佳实践。他强调了在AI编码中,前期规划和上下文管理的重要性远超编写代码本身。尽管AI降低了实现代码的门槛,但它不替代架构设计和商业洞察力。该经验分享涵盖了从前端到后端、移动应用开发等多个项目,并推荐了Context7、SpecDrafter等辅助工具。(来源: Reddit r/ClaudeAI)

💼 商业

摩根大通:一年20亿美元投入,转型“全AI银行” : 摩根大通CEO Jamie Dimon宣布每年投入20亿美元用于AI,旨在将公司转型为“全AI银行”。AI已深度融入风控、交易、客服、合规、投行等核心业务,不仅节省成本,更重要的是加速了工作节奏,改变了岗位本质。摩根大通通过自研LLM Suite平台和大规模部署AI Agent,将AI视为公司运行的底层操作系统,并强调数据整合和网络安全是其AI战略的最大挑战。Dimon认为AI是真实的长期价值,而非短期泡沫,将重塑银行的定义。(来源: 36氪)

**苹果从马斯