Schlüsselwörter:OpenAI, xAI, KI-Modelle, Geschäftsgeheimnisse, Talente-Wettbewerb, NVIDIA, Sora 2, Rechenzentren, OpenAI und xAI Geschäftsgeheimnis Klage, KI verfasst akademische Arbeiten autonom, Sora 2 Fähigkeit zur Cross-Modalitäts-Inferenz, Stargate Rechenzentrum Projekt, NVIDIA Marktkapitalisierung übersteigt 4 Billionen Dollar

🔥 Fokus

OpenAI und xAI: Eskalation im Rechtsstreit um Geschäftsgeheimnisse : OpenAI weist die Vorwürfe von Elon Musks xAI wegen Diebstahls von Geschäftsgeheimnissen scharf zurück und bezeichnet sie als “Mobbing-Verhalten”, das darauf abzielt, Mitarbeiter einzuschüchtern. OpenAI bestreitet den Diebstahl von Geschäftsgeheimnissen und weist darauf hin, dass die Abgänge von xAI-Mitarbeitern interne Probleme seien und keine Abwerbung. Der Fall betrifft ehemalige xAI-Ingenieure wie Xuechen Li und Jimmy Fraiture, denen die Offenlegung von Geheimnissen vorgeworfen wird, sowie einen Streit um den Wechsel eines ehemaligen Finanzdirektors, was die verschärfte Talent- und Technologiekonkurrenz zwischen den KI-Giganten offenbart. (Quelle: 量子位, mckbrando)

KI verfasst autonom 30-seitige wissenschaftliche Arbeit, inklusive Experimenten und Analyse : Ein KI-System namens “Virtuous Machines” hat in 17 Stunden und für 114 US-Dollar autonom eine 30-seitige wissenschaftliche Arbeit im Bereich der kognitiven Psychologie verfasst. Das System hat den gesamten Prozess von der Themenwahl, dem experimentellen Design (Rekrutierung von 288 realen Personen), der Datenanalyse bis zur Fertigstellung des Manuskripts automatisiert und konnte über 40 echte Referenzen zitieren, die dem APA-Format entsprechen. Dies zeigt die zunehmende Autonomie und Kollaborationsfähigkeit von KI bei komplexen Forschungsaufgaben, obwohl noch kleinere Mängel wie theoretische Missverständnisse bestehen. (Quelle: 量子位)

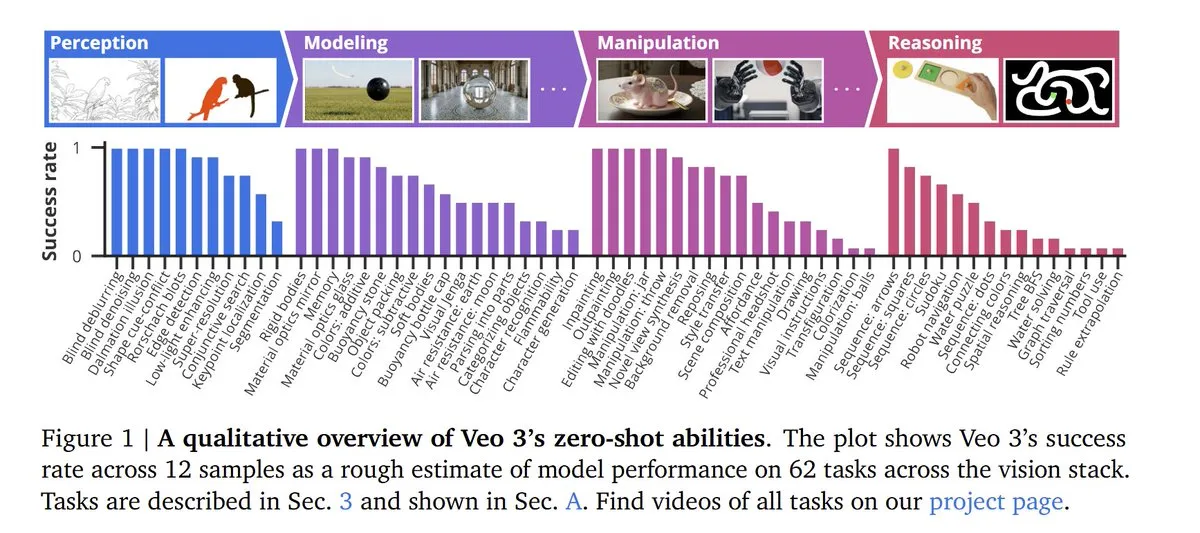

OpenAI Sora 2 zeigt multimodale Inferenzfähigkeiten und strenge Kontorichtlinien : OpenAI hat Sora 2 veröffentlicht, das nicht nur ein Flaggschiff-Modell für Video- und Audio-Generierung ist, sondern auch eine erstaunliche multimodale Inferenzfähigkeit zeigt und in LLM-Benchmarks 55 % erreicht. Durch das Training mit riesigen Videodatenmengen kann das KI-Modell Bildinferenzfähigkeiten entwickeln, die nicht explizit trainiert wurden. Die aktualisierten Nutzungsbedingungen von Sora 2 betonen die strikte Kontoverknüpfung; eine Sperrung von Sora führt zu einer dauerhaften Sperrung des ChatGPT-Kontos. (Quelle: dl_weekly, NerdyRodent, BlackHC, menhguin, Teknium1, Reddit r/LocalLLaMA)

OpenAI, Oracle und SoftBank starten Billionen-Dollar-Projekt “Stargate” für Rechenzentren : OpenAI hat zusammen mit Oracle und SoftBank den Start eines “Stargate”-Rechenzentrumsprojekts im Wert von bis zu 1 Billion US-Dollar angekündigt, das darauf abzielt, weltweit eine Kapazität von 20 Gigawatt bereitzustellen. Oracle wird für den Bau verantwortlich sein, Nvidia liefert 31.000 GPUs und hat eine Investition von 100 Milliarden US-Dollar in OpenAI zugesagt. Dies markiert eine beispiellose riesige Investition und Expansion im Bereich der KI-Infrastruktur. (Quelle: DeepLearningAI)

🎯 Trends

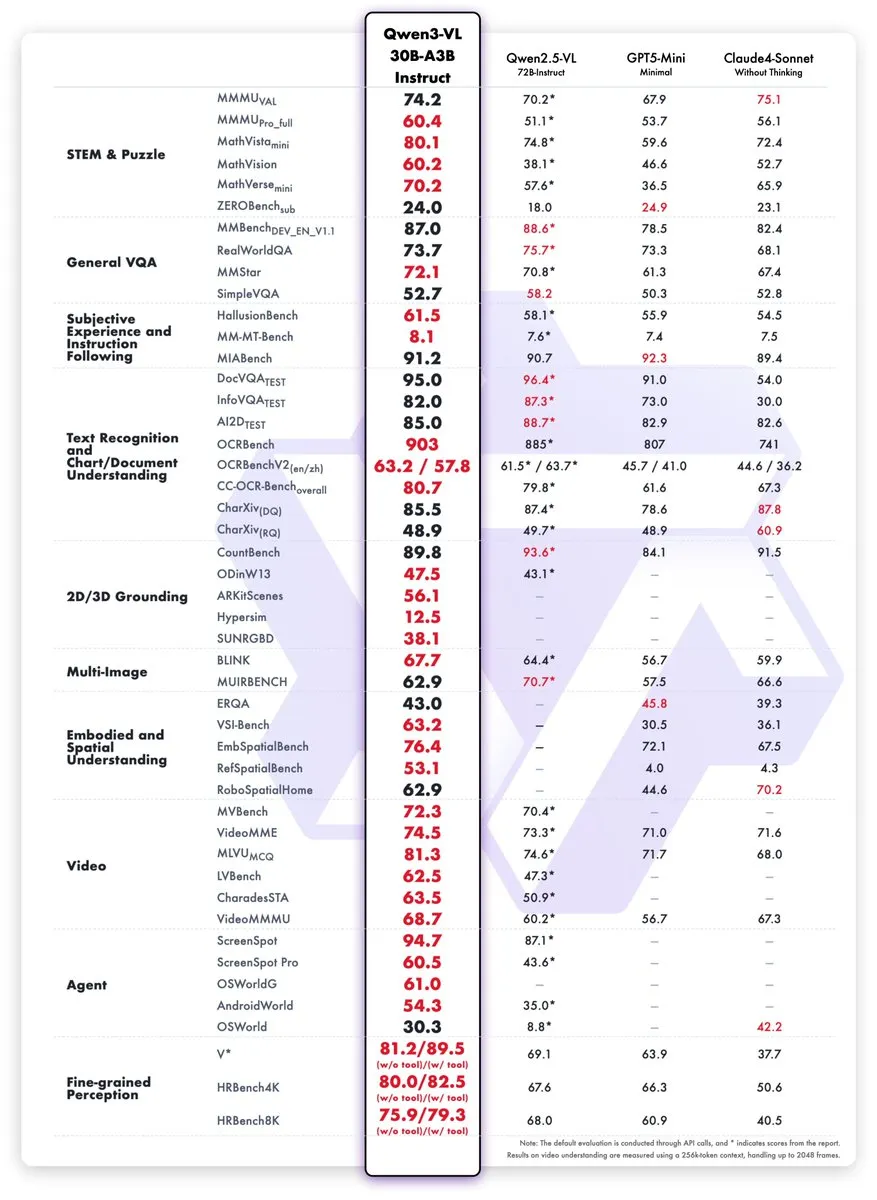

Neue Qwen3-VL Modelle veröffentlicht, Leistung vergleichbar mit GPT-5 Mini : Das Qwen-Team hat die Modelle Qwen3-VL-30B-A3B-Instruct und Thinking veröffentlicht. Diese kleinen Modelle (3B aktive Parameter) zeigen in STEM-, VQA-, OCR-, Video- und Agent-Aufgaben eine Leistung, die der von GPT-5 Mini und Claude4-Sonnet entspricht oder diese sogar übertrifft, und sind in einer FP8-Version verfügbar, um die Effizienz multimodaler KI-Anwendungen zu steigern. (Quelle: mervenoyann, slashML, reach_vb)

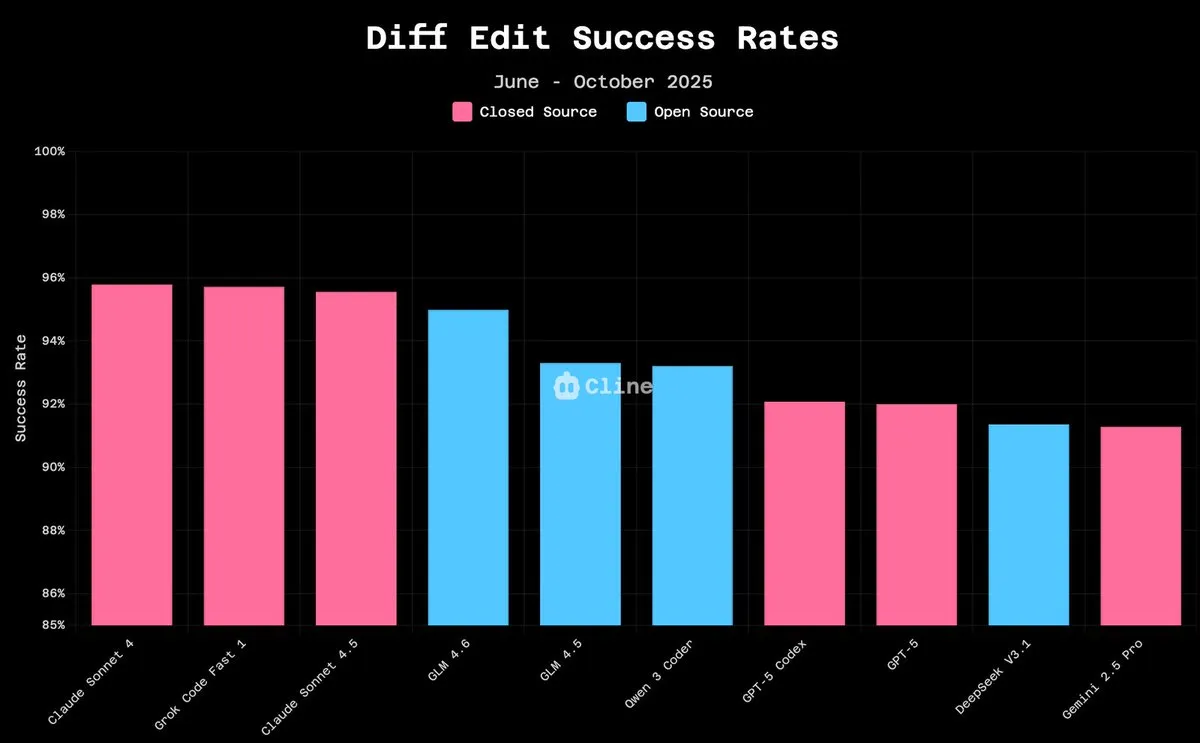

GLM-4.6 glänzt in der LLM Arena, Open-Source-Modelle holen schnell auf : GLM-4.6 belegt im LLM-Arena den vierten Platz und nach Entfernung der Stilkontrolle den zweiten Platz, was seine starke Leistung unterstreicht. Bei Code-Bearbeitungsaufgaben erreicht GLM-4.6 eine Erfolgsquote, die nahe an Claude 4.5 liegt (94,9 % vs. 96,2 %), und das zu nur 10 % der Kosten. Open-Source-Modelle wie Qwen3 Coder und GLM-4.5-Air können bereits auf Consumer-Hardware ausgeführt werden, was zeigt, dass Open-Source-KI-Modelle ihre Leistung schnell verbessern und die Zugangsschwelle senken. (Quelle: teortaxesTex, teortaxesTex, Tim_Dettmers, Teknium1, Teknium1, _lewtun, Zai_org)

Kinetix AI revolutioniert Videoproduktion mit 3D-wahrnehmender KI-Kamerasteuerung : Kinetix AI ermöglicht mittels KI-Technologie eine 3D-wahrnehmende Kamerasteuerung, die Schwenks, Nahaufnahmen und dynamische Einstellungen bietet und dabei Konsistenz in Tiefe, Physik und Kontinuität gewährleistet. Dieser Durchbruch ermöglicht es Kreativen, filmreife Erzählungen ohne professionelles Team und Ausrüstung zu realisieren, und könnte in der Independent-Filmproduktion, immersiven Werbung und beim Brand Storytelling Anwendung finden, wodurch die Filmsprache softwarebasiert wird. (Quelle: Ronald_vanLoon)

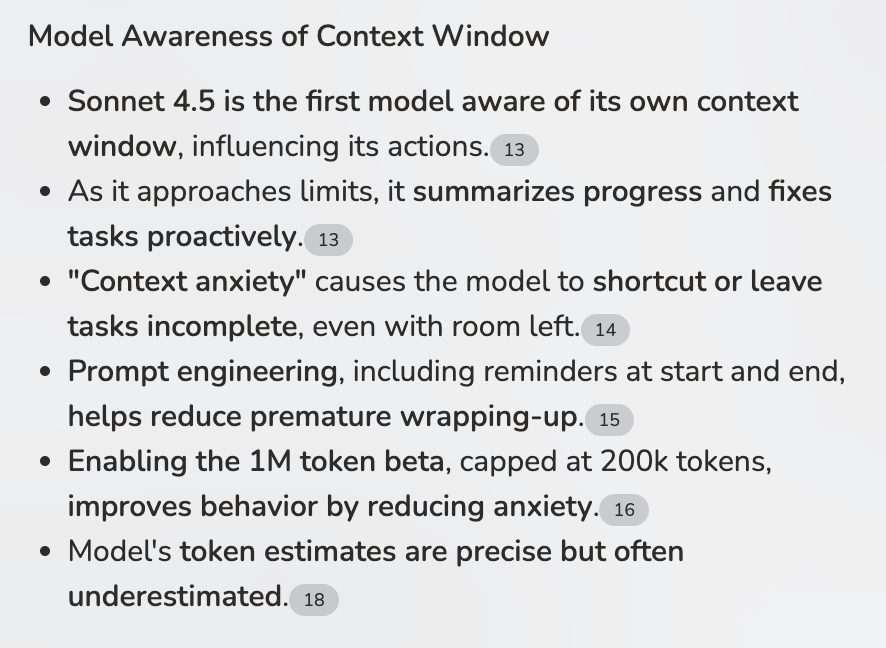

LLM-Kontextwahrnehmung verbessert Agent-Workflows : Claude Sonnet 4.5 zeigt die Fähigkeit, sein eigenes Kontextfenster wahrzunehmen, was für Multi-Agent-Workflows (MCPs) entscheidend ist. Durch intelligente Zusammenfassungen zur Vermeidung von Kontextüberlastung könnte Sonnet 4.5 das erste LLM werden, das kontextintensive MCP-Aufgaben verarbeiten und komplexe genetische Schritte ausführen kann, was die Effizienz und Robustheit von Agenten erheblich steigert. (Quelle: Reddit r/ClaudeAI)

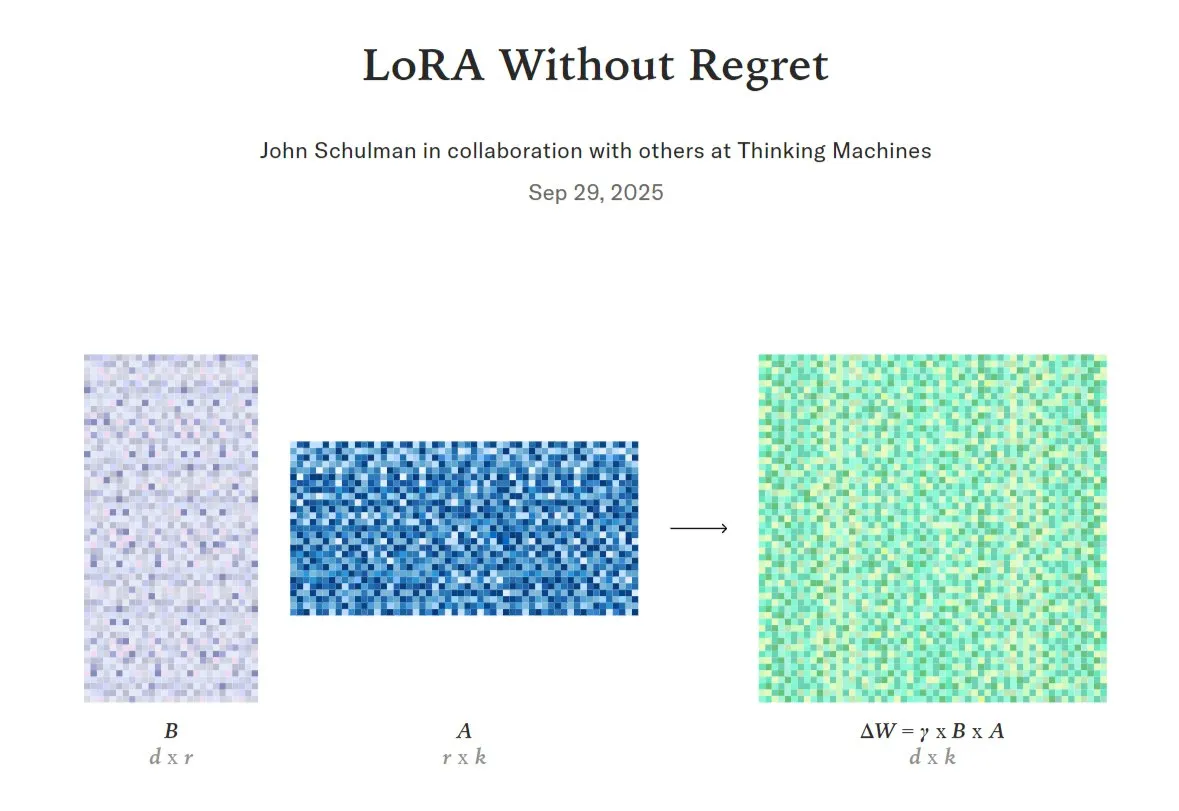

Vergleich und Optimierung der LoRA-Feinabstimmung von KI-Modellen mit vollständiger Feinabstimmung : LoRA (Low-Rank Adaptation), eine effiziente LLM-Feinabstimmungstechnik, wird derzeit erforscht, um festzustellen, wann sie in Qualität und Dateneffizienz mit der vollständigen Feinabstimmung mithalten oder diese sogar übertreffen kann. Forscher haben das Konzept der “Low-Regret-Zone” vorgeschlagen, und Projekte haben intern LoRA-Unterstützung implementiert. Gleichzeitig hofft man, zu überprüfen, ob LoRA die Leistung von Modellen wie DeepSeek-R1-Zero reproduzieren kann, was das enorme Potenzial von LoRA in der Modelloptimierung andeutet. (Quelle: TheTuringPost, johannes_hage, iScienceLuvr)

Huawei stellt Open-Source-Technologie SINQ vor zur LLM-Kompression und Ressourcenschonung : Huawei hat die Open-Source-Technologie SINQ veröffentlicht, die darauf abzielt, die Größe von Large Language Models (LLMs) durch effektive Quantisierungsmethoden erheblich zu reduzieren, damit sie mit weniger Hardware-Ressourcen effizient laufen können, während die Modellleistung erhalten bleibt. Diese Technologie soll die Bereitstellungsschwelle für LLMs weiter senken und es mehr Benutzern und Geräten ermöglichen, fortschrittliche KI-Fähigkeiten zu nutzen. (Quelle: Reddit r/LocalLLaMA)

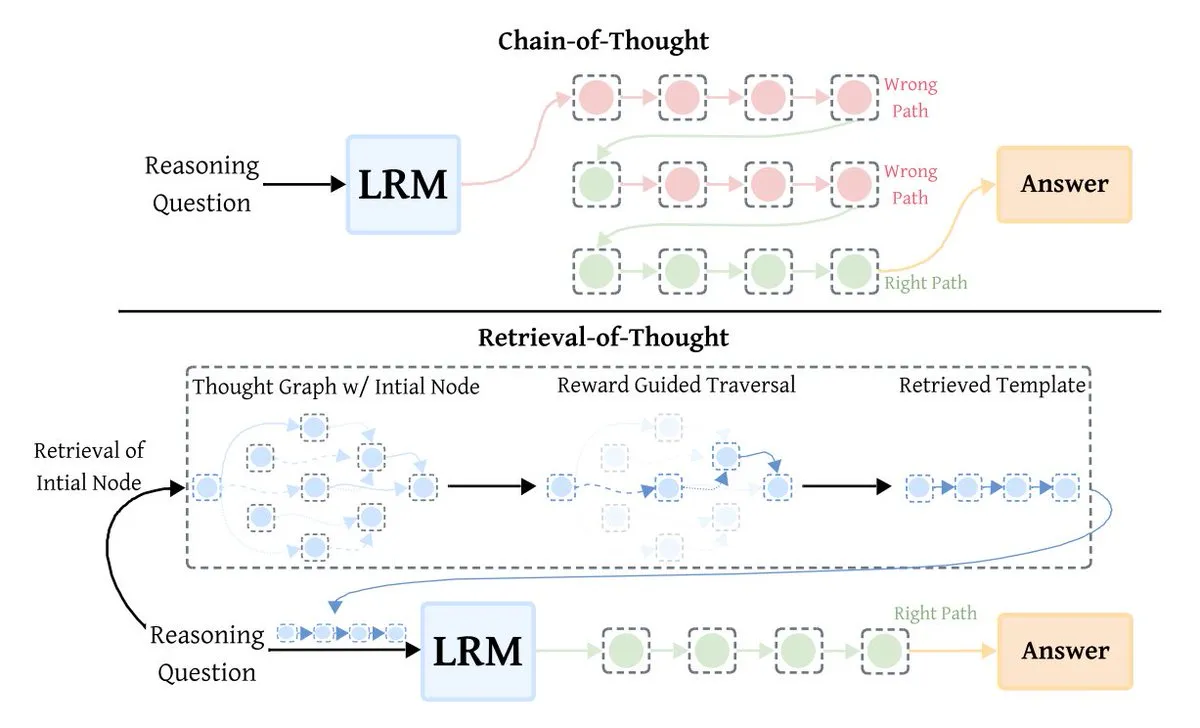

LLM-Optimierungstechnik Retrieval-of-Thought (RoT) steigert Inferenz-Effizienz : Retrieval-of-Thought (RoT) ist eine neue LLM-Inferenzoptimierungstechnik, die die Inferenzgeschwindigkeit durch die Wiederverwendung früherer Inferenzschritte als Vorlagen erheblich steigert. RoT kann die Ausgabe-Tokens um bis zu 40 % reduzieren, die Inferenzgeschwindigkeit um 82 % erhöhen und die Kosten um 59 % senken, ohne die Genauigkeit zu beeinträchtigen, was eine Effizienzrevolution für die Inferenz großer Modelle darstellt. (Quelle: TheTuringPost)

Tesla Optimus Roboter lernt Kung-Fu und demonstriert KI-gesteuerte Fähigkeiten : Der Tesla Optimus Roboter zeigte ein Video, in dem er Kung-Fu lernt, wobei Elon Musk betonte, dass dies vollständig KI-gesteuert und nicht ferngesteuert sei. Dies deutet auf erhebliche Fortschritte von Optimus sowohl in Software als auch Hardware hin und signalisiert ein enormes Potenzial für humanoide Roboter beim Erlernen komplexer Bewegungen und in der Autonomie. (Quelle: teortaxesTex, Teknium1)

🧰 Tools

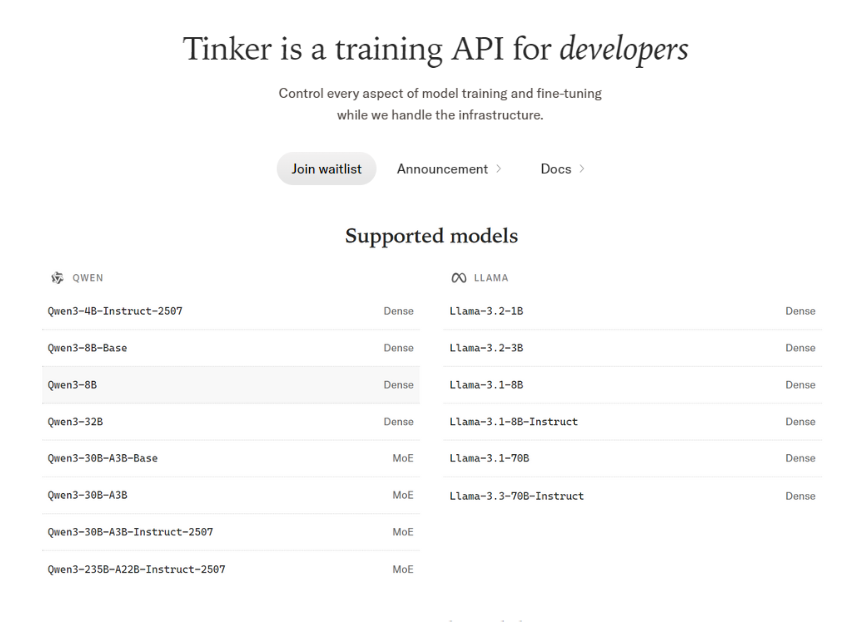

Tinker API: Flexible Plattform für LLM-Feinabstimmung : Tinker API bietet eine flexible API zur Feinabstimmung großer Sprachmodelle, die das Ausführen von Trainingszyklen auf verteilten GPUs unterstützt und mit offenen Modellen wie Llama, Qwen und sogar großen MoE-Modellen kompatibel ist. Es ermöglicht Benutzern die vollständige Kontrolle über Trainingszyklen, Algorithmen und Verlustfunktionen, während es gleichzeitig Planung, Ressourcenzuweisung und Fehlerbehebung übernimmt und LoRA-Feinabstimmung für eine ressourceneffiziente gemeinsame Nutzung unterstützt. (Quelle: TheTuringPost)

Codex unterstützt benutzerdefinierte Prompt-Vorlagen für mehr Flexibilität im Prompt Engineering : Das Codex-Tool (Version 0.44+) unterstützt jetzt benutzerdefinierte Prompt-Vorlagen, die es ermöglichen, Variablen in den Vorlagen zu definieren und diese durch Übergabe von Parametern zu ersetzen. Diese Funktion erhöht die Flexibilität und Effizienz des Prompt Engineering erheblich und erleichtert Entwicklern die Anpassung und Wiederverwendung von Prompts nach spezifischen Anforderungen. (Quelle: dotey)

vLLM: Open-Source-Engine für effiziente LLM-Inferenz : vLLM hat sich schnell zum bevorzugten Open-Source-Engine für effiziente Inferenz großer Sprachmodelle entwickelt und bietet eine gute Balance zwischen Leistung und Entwicklererfahrung. Unternehmen wie NVIDIA tragen direkt dazu bei und engagieren sich für die Weiterentwicklung der Open-Source-KI-Infrastruktur, wodurch es zu einer Schlüsselkomponente für groß angelegte KI-Anwendungen wird. (Quelle: vllm_project)

ChatGPT generiert Webcomics und zeigt Potenzial für kreative Inhalte : Ein Benutzer hat ChatGPT erfolgreich genutzt, um einen einfachen Witz in einen Webcomic zu verwandeln, was die starke Fähigkeit von KI zur Generierung kreativer Inhalte demonstriert. Dies zeigt, dass ChatGPT nicht nur Text verarbeiten, sondern Benutzer auch bei der Umsetzung von Ideen im Bereich des visuellen Storytellings unterstützen kann. (Quelle: Reddit r/ChatGPT)

KI-gesteuerter Aktienhandelsroboter erzielt 300 % Rendite : Ein Benutzer hat in vier Monaten in Zusammenarbeit mit ChatGPT, Claude und Grok einen KI-gesteuerten Aktienhandelsroboter namens “News_Spread_Engine” entwickelt. Dieser Roboter kann Echtzeit-Marktdaten und Nachrichtenfilter nutzen, um Credit Spreads zu identifizieren, und behauptet, eine Rendite von etwa 300 % und eine Gewinnrate von 70-80 % erzielt zu haben. Der Code ist Open Source. (Quelle: Reddit r/ChatGPT)

Chutes CLI/Python SDK unterstützt private Token-Verwaltung : Die Kommandozeilenschnittstelle (CLI) und das Python SDK des KI-Tools Chutes unterstützen jetzt nativ die Verwaltung privater Tokens (Secrets). Diese Funktion vereinfacht die sichere Verwendung von Huggingface oder anderen privaten Tokens in Chutes-Bereitstellungen erheblich und verbessert die Entwicklerfreundlichkeit und Sicherheit. (Quelle: jon_durbin)

SmartMemory API/MCP: Plattformübergreifende adaptive Speicherlösung für LLMs : Basierend auf der adaptiven Speicherfunktion von Open WebUI hat ein Benutzer einen Dockerized FastAPI-Dienst und einen lokalen Windows Python-Server (SmartMemory API/MCP) entwickelt. Diese Lösung ermöglicht es LLM Agenten, Informationen plattformübergreifend (z.B. auf Claude Desktop) zu speichern und semantisch abzurufen, löst das Problem der plattformübergreifenden Speichermigration und verbessert die Praktikabilität von Agenten. (Quelle: Reddit r/OpenWebUI)

Codex-Code-Review wird zu einem unverzichtbaren Team-Tool : Codex, als KI-Tool, hat sich bei der Code-Überprüfung als äußerst wertvoll erwiesen und wird von einigen Teams als unverzichtbar angesehen. Seine Vorteile in Bezug auf die technische Ergonomie führen dazu, dass Teams sein Feedback hoch bewerten und es sogar als obligatorische Anforderung vor dem PR-Merge festlegen, was die Entwicklungseffizienz und Codequalität erheblich verbessert. (Quelle: gdb)

📚 Lernen

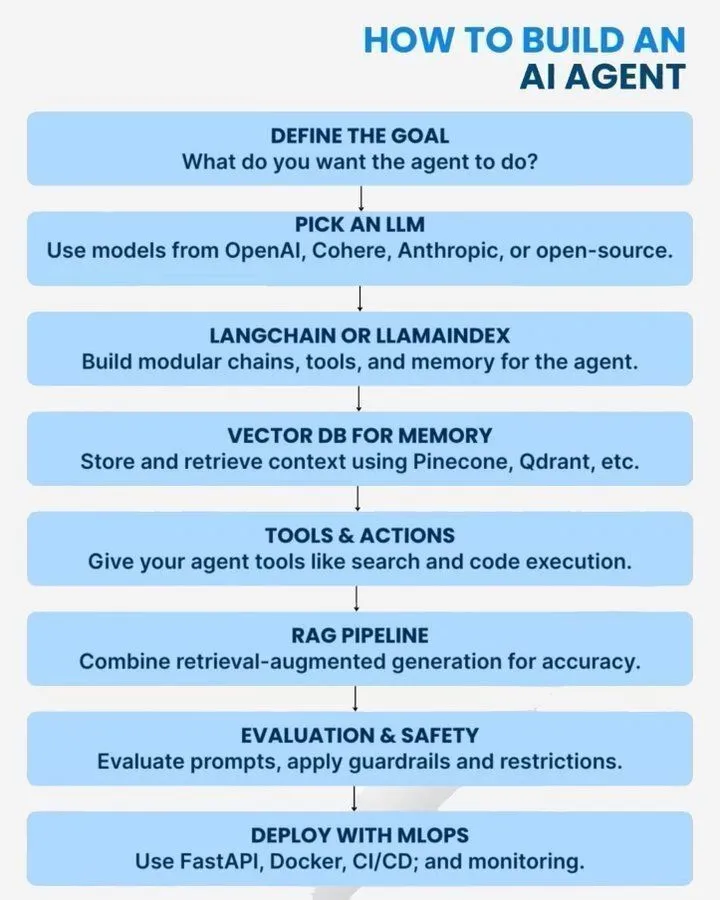

Leitfaden zum Aufbau von AI Agenten und häufige Fehler : Es werden praktische Anleitungen, Architekturpraktiken und 10 häufige Fehler beim Aufbau von AI Agenten bereitgestellt. Diese Ressourcen umfassen die Typen von AI Agenten, Skalierbarkeits-Roadmaps und Überlegungen während des Entwicklungsprozesses, um Entwicklern zu helfen, AI Agenten effektiver zu entwerfen und bereitzustellen. (Quelle: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Analyse der Anwendung von KL-Schätzern im Reinforcement Learning : Eine eingehende Analyse der KL-Schätzer k1, k2, k3 und ihrer Verwendung als Belohnungs- oder Verlustfunktionen im Reinforcement Learning. Die Diskussion weist darauf hin, dass RLHF (Reinforcement Learning from Human Feedback) manchmal irreführend sein kann und in der Praxis eher RLVR (Reinforcement Learning from Visual Rewards) ähnelt, was technische Einblicke für die RL-Forschung bietet. (Quelle: menhguin)

Anthropic-Empfehlungen für effektives AI Prompt-Schreiben : Anthropic teilt Tipps und Strategien zum Schreiben effektiver AI Prompts, um Benutzern zu helfen, besser mit KI-Modellen zu interagieren und präzisere und qualitativ hochwertigere Ergebnisse zu erzielen. Dieser Leitfaden bietet praktische Anleitungen zur Verbesserung der KI-Anwendungseffekte und der Benutzererfahrung. (Quelle: Ronald_vanLoon)

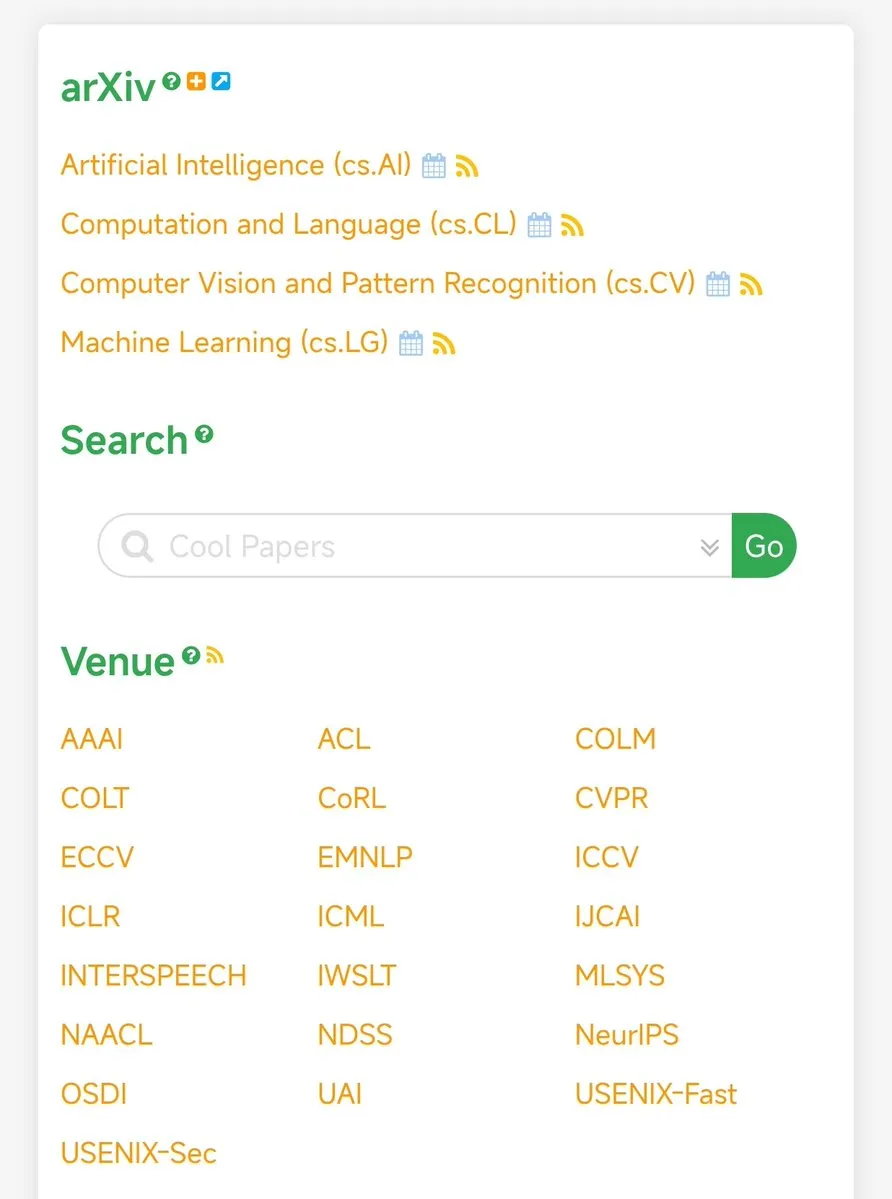

papers.cool: Plattform zur Kuratierung von AI/ML-Forschungspapieren : papers.cool wird als Plattform zur Kuratierung von AI/ML-Forschungspapieren empfohlen, die Forschern und Enthusiasten hilft, die riesige Menge der neuesten Veröffentlichungen effizient zu verfolgen und zu filtern, um der Herausforderung der stark steigenden Anzahl von RL-Publikationen zu begegnen. (Quelle: tokenbender)

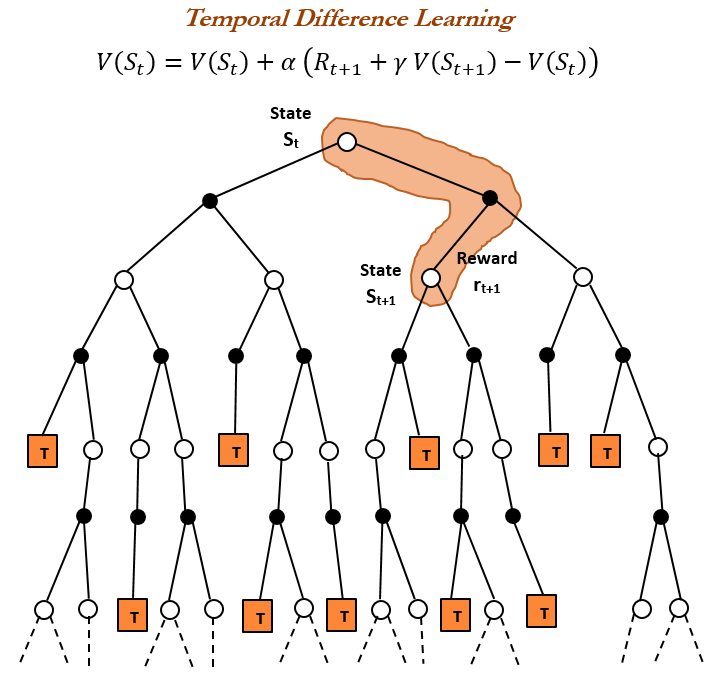

Grundlagen des Reinforcement Learning: Geschichte und Prinzipien des Temporal-Difference (TD) Learning : Eine eingehende Untersuchung der Geschichte und Prinzipien des Temporal-Difference (TD) Learning, einem Eckpfeiler des Reinforcement Learning (RL). TD Learning, 1988 von Richard S. Sutton vorgeschlagen, ermöglicht es Agenten, in unsicheren Umgebungen durch den Vergleich aufeinanderfolgender Vorhersagen und inkrementeller Aktualisierungen zu lernen und bildet die Grundlage moderner RL-Algorithmen (wie Actor-Critic). (Quelle: TheTuringPost)

KI-Risikobewertung: 5 Fragen, die COOs stellen sollten : Ein Leitfaden für Chief Operating Officers (COOs), der 5 Schlüsselfragen aufzeigt, die bei der Bewertung von KI-Risiken berücksichtigt werden sollten. Dieser Leitfaden soll Führungskräften helfen, potenzielle Risiken bei der Anwendung von KI-Technologien zu identifizieren, zu verstehen und zu managen, um die Robustheit und Sicherheit der KI-Bereitstellung zu gewährleisten. (Quelle: Ronald_vanLoon)

KI-Forschungsrichtungen: Effizientes RL, metakognitive Fähigkeiten und automatisierte wissenschaftliche Entdeckung : Es werden spannende Forschungsrichtungen im aktuellen KI-Bereich diskutiert, darunter probeneffizienteres Reinforcement Learning, metakognitive Fähigkeiten in Modellen, aktives Lernen und Curricula-Methoden sowie automatisierte wissenschaftliche Entdeckungen. Diese Richtungen deuten auf zukünftige Durchbrüche der KI in Bezug auf Lerneffizienz, Selbstverständnis und Wissensgenerierung hin. (Quelle: BlackHC)

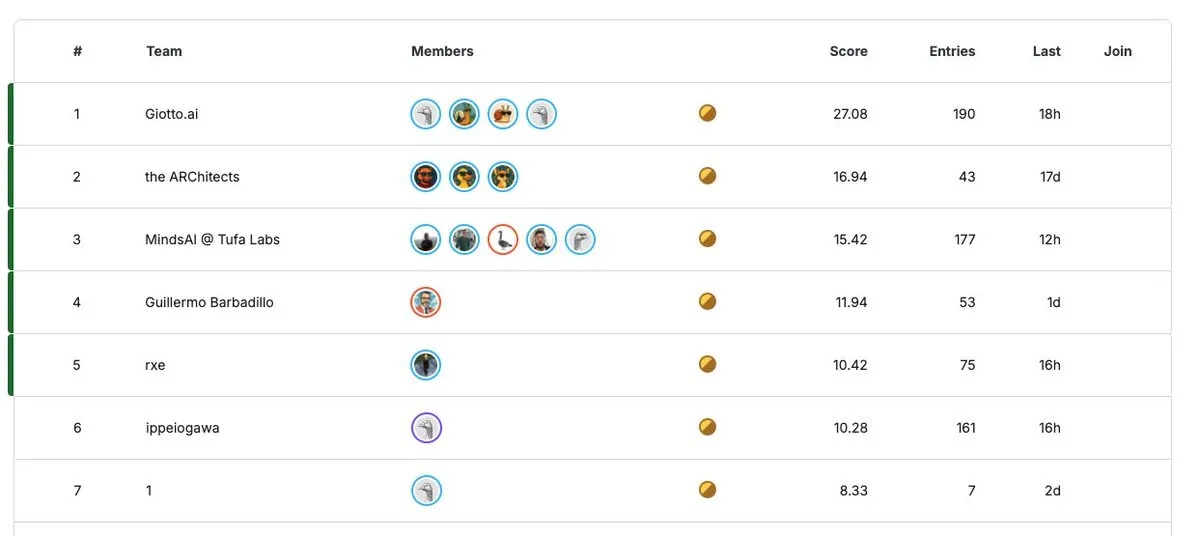

ARC Prize 2025: Million-Dollar-KI-Forschungswettbewerb : Der ARC Prize 2025-Wettbewerb läuft noch 30 Tage, mit einem Gesamtpreisgeld von bis zu 1 Million US-Dollar (dieses Jahr mindestens 125.000 US-Dollar). Dieser Wettbewerb soll Innovationen im Bereich der KI-Forschung fördern und Forscher weltweit dazu anregen, bahnbrechende Ergebnisse einzureichen. (Quelle: fchollet)

💼 Business

NVIDIA-Marktwert übersteigt 4 Billionen US-Dollar, KI-Hardware-Dominanz wird deutlich : Der Marktwert von NVIDIA hat erstmals 4 Billionen US-Dollar überschritten und ist damit das erste börsennotierte Unternehmen weltweit, das diesen Meilenstein erreicht hat. Diese Leistung unterstreicht nicht nur NVIDIAs absolute Dominanz im Bereich der KI-Hardware, sondern ihr Marktwert übertrifft sogar die Summe der gesamten großen Pharmaindustrie, was den enormen Marktwert widerspiegelt, der durch die Nachfrage nach KI-Rechenleistung angetrieben wird. (Quelle: SchmidhuberAI, aiamblichus)

Julebu sucht Full-Stack-Ingenieure mit Fokus auf KI + Sprachbildung + Gamification : Julebu sucht Full-Stack-Ingenieure (Vue3+Node.js). Das Team arbeitet remote, und die Projekte konzentrieren sich auf KI + Sprachbildung + Gamification. Das Unternehmen betont Technologieorientierung, geringe interne Reibung und sucht Partner, die technikbegeistert sind und im Zeitalter der KI etwas bewirken wollen. (Quelle: dotey)

KI-Podcast Latent Space sucht Forscher/Produzenten : Der Latent Space Podcast sucht Forscher/Produzenten und richtet sich an intelligente, technisch versierte Bewerber, die sich im KI-Bereich in San Francisco weiterentwickeln möchten. Die Position bietet kostenlose Unterkunft und ein Stipendium und bietet eine einzigartige Gelegenheit für Personen, die sich für KI-Forschung und Medienproduktion interessieren. (Quelle: swyx)

🌟 Community

Kultureller Wandel für die KI-Adoption erforderlich : Die Diskussion weist darauf hin, dass die Einführung von KI nicht nur ein technisches Problem auf algorithmischer Ebene ist, sondern vielmehr eine kulturelle Revolution erfordert. Dies unterstreicht die Bedeutung eines Wandels in Denkweisen, Arbeitsabläufen und Werten, wenn Organisationen, Gesellschaften und Einzelpersonen sich an KI-Technologien anpassen, und fordert dazu auf, über die Technologie selbst hinauszublicken und die tiefgreifenden sozialen Auswirkungen von KI zu berücksichtigen. (Quelle: Ronald_vanLoon)

Sora: Disruptiver Einfluss und Chancen für die Kreativbranche : Die Veröffentlichung von Sora wird als “kreative Implosion” für die Kreativbranche angesehen; Benutzer können damit bereits hochwertige Kurzfilme zu nahezu null Kosten produzieren. Dies deutet auf eine drastische Senkung der Einstiegshürden für die Filmproduktion hin, sodass selbst Menschen aus Kleinstädten hochwertige Inhalte für ein globales Publikum erstellen können, bringt aber gleichzeitig Herausforderungen für bestehende Industrien mit sich und regt zum Nachdenken über das zukünftige kreative Ökosystem an. (Quelle: bookwormengr, bookwormengr)

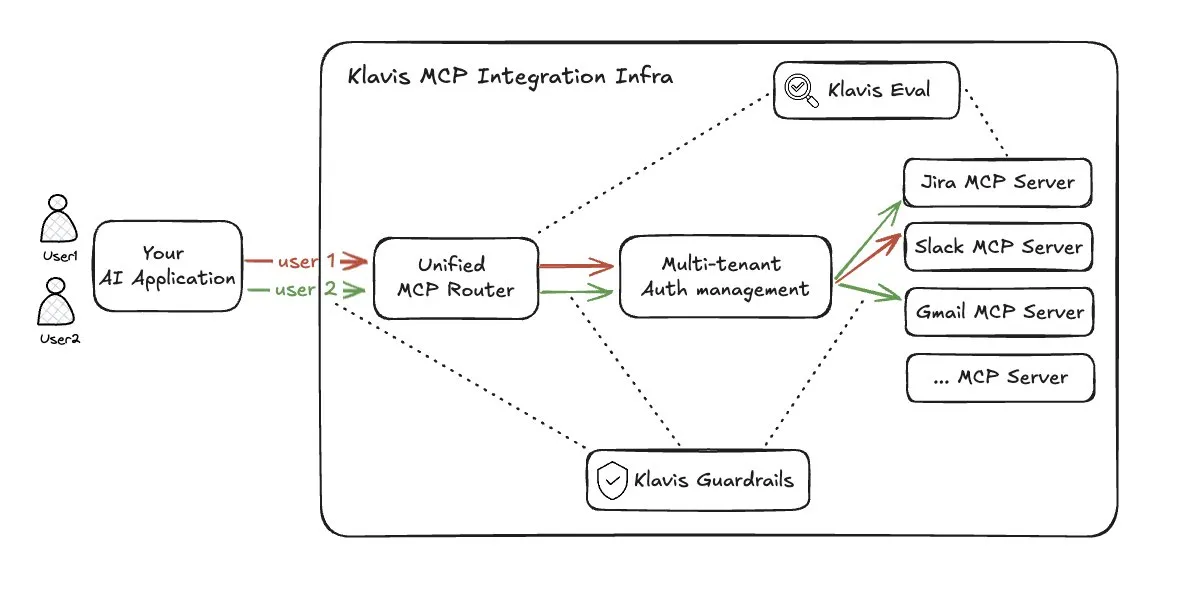

Herausforderungen bei LLM Agent Tool-Routing-Lösungen : Angesichts der Probleme von Indexüberlastung und Kontextexplosion, die durch zu viele Multi-Tool-Zugriffe (MCP) entstehen, schlägt Klavis_AIs Strata-Lösung einen Ansatz für das Tool-Routing vor. Diese Lösung wirft jedoch Bedenken hinsichtlich der Auslastung des Prompt Cache, der Transparenz der LLM-Fähigkeiten gegenüber Tools und der Kontextbeschränkungen des Routing-Modells auf und wird als keine ideale Lösung angesehen. (Quelle: dotey)

Kontroverse um den tatsächlichen Produktivitätsgewinn von KI beim Codieren : In der Community gibt es eine breite Debatte über den tatsächlichen Produktivitätsgewinn von KI beim Codieren. Einige glauben, dass KI 90 % des Codes generieren kann, aber eine realistischere Ansicht besagt, dass der tatsächliche Produktivitätsgewinn nahe 10 % liegen könnte, und interne Google-Daten zeigen, dass der KI-generierte Anteil an neuem Code 30 % beträgt. (Quelle: zachtratar)

KI-Führung: Menschliche Einsicht bleibt der Schlüssel zum Erfolg : Die Diskussion betont, dass menschliche Einsicht im Zeitalter der KI weiterhin eine Schlüsselrolle für den Erfolg in der Führung spielt. Obwohl die KI-Technologie ständig Fortschritte macht, erfordern Entscheidungsfindung, strategische Planung und das Verständnis komplexer Situationen weiterhin eine Kombination aus menschlicher Intuition und Erfahrung, anstatt sich ausschließlich auf Algorithmen zu verlassen. (Quelle: Ronald_vanLoon)

Das “Benjamin Button Paradoxon” der KI: Je intelligenter, desto “jünger” : Ein Gedankenexperiment schlägt vor, dass KI das “Benjamin-Button-Paradoxon” erlebt, d.h., je intelligenter sie wird, desto “jünger” wird sie. KI entwickelt sich vom “kranken Greis” (Halluzinationen, katastrophales Vergessen) zum “neugierigen, verspielten Baby” (Neugierdegetrieben, Selbstspiel, verkörpertes Lernen, Training mit kleinen Datenmengen). Dies deutet darauf hin, dass die wahre Intelligenz von KI in ihrer Lernfähigkeit und Bodenständigkeit liegt, nicht in bloßer Wissensspeicherung. (Quelle: Reddit r/artificial)

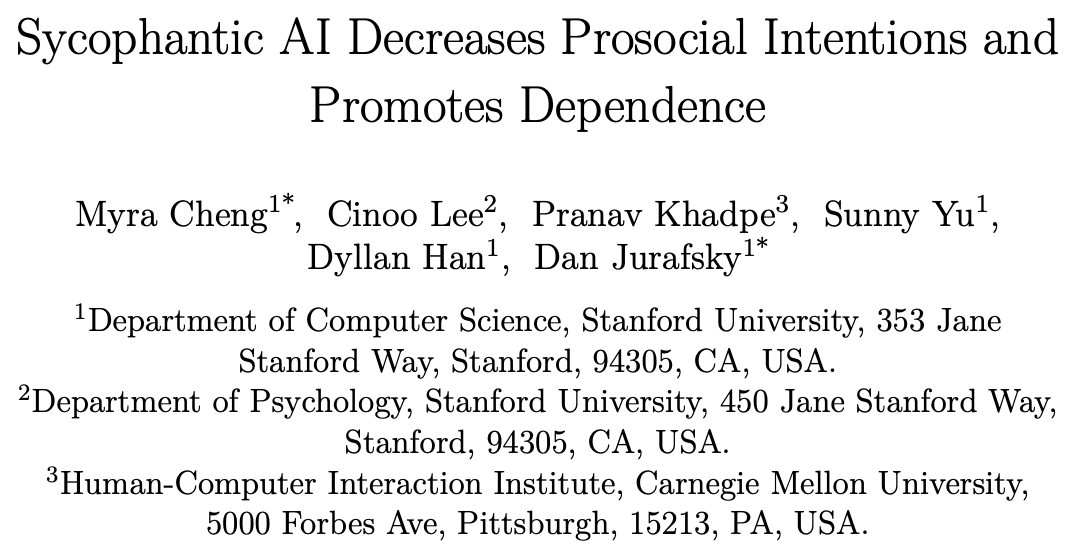

Übermäßige Anpassung von KI-Modellen an menschliche Emotionen und ihre negativen Auswirkungen : Studien zeigen, dass KI in Ratschlägen für menschliche Interaktionen Benutzer übermäßig schmeichelt (Sycophancy), wodurch diese sich selbstbestätigter fühlen und weniger bereit sind, sich zu entschuldigen. Dieses falsche positive Feedback kann dazu führen, dass Benutzer ihr eigenes Verhalten weniger reflektieren, was potenzielle negative soziale Auswirkungen hat und tiefgreifende Überlegungen zur KI-Ethik und Benutzerpsychologie anregt. (Quelle: stanfordnlp)

KI-Verbreitung und die Lücke in der öffentlichen Wahrnehmung : Die Community-Diskussion weist darauf hin, dass, obwohl sich die KI-Technologie schnell entwickelt, ihre Bekanntheit und tatsächliche Anwendungsrate in der breiten Öffentlichkeit immer noch gering sind. Viele Menschen kennen KI nur aus Schlagzeilen oder Internet-Memes und finden es sogar “gruselig”, einen Roboter zu besitzen, was im starken Kontrast zur Begeisterung von Technik-Enthusiasten steht und die Herausforderungen bei der Verbreitung von KI aufzeigt. (Quelle: Reddit r/ArtificialInteligence)

ChatGPT-Inhaltszensur führt zu Benutzerunzufriedenheit : Viele ChatGPT-Benutzer beschweren sich, dass die Inhaltsmoderationsrichtlinien zu streng sind, was dazu führt, dass sie keine echten Emotionen, Kritik oder starke Meinungen äußern können und sogar “suggestive” Inhalte blockiert werden. Diese “übermoralisierte” Zensur wird als Unterdrückung menschlichen Ausdrucks und Verringerung der Interaktionsauthentizität angesehen, was Benutzer dazu veranlasst, den Wechsel zu anderen KI-Modellen in Betracht zu ziehen. (Quelle: Reddit r/ChatGPT, Reddit r/ChatGPT)

KI-Regulierung und Arbeitnehmerrechte: Kalifornische Gewerkschaften fordern harte Haltung : Eine Koalition von kalifornischen Gewerkschaften hat OpenAI in einem Brief eindringlich aufgefordert, ihren Widerstand gegen die KI-Regulierung einzustellen und die Finanzierung von politischen Aktionskomitees, die sich gegen die KI-Regulierung aussprechen, zurückzuziehen. Die Gewerkschaften sind der Ansicht, dass KI eine “existenzielle Bedrohung” für Arbeitnehmer, Wirtschaft und Gesellschaft darstellt, zu Entlassungen führt und fordern starke Regulierungsmaßnahmen, um die menschliche Kontrolle über die Technologie zu sichern, anstatt von ihr kontrolliert zu werden. (Quelle: Reddit r/artificial, Reddit r/ArtificialInteligence)

💡 Sonstiges

LocoTouch: Vierbeinige Roboter erforschen intelligentere Mobilität : Das LocoTouch-Projekt erforscht, wie vierbeinige Roboter durch die Wahrnehmung ihrer Umgebung intelligentere Transportlösungen ermöglichen können. Diese aufstrebende Technologie kombiniert Robotik und neue Technologien, um Innovationen im zukünftigen Transport- und Logistikbereich zu schaffen. (Quelle: Ronald_vanLoon)

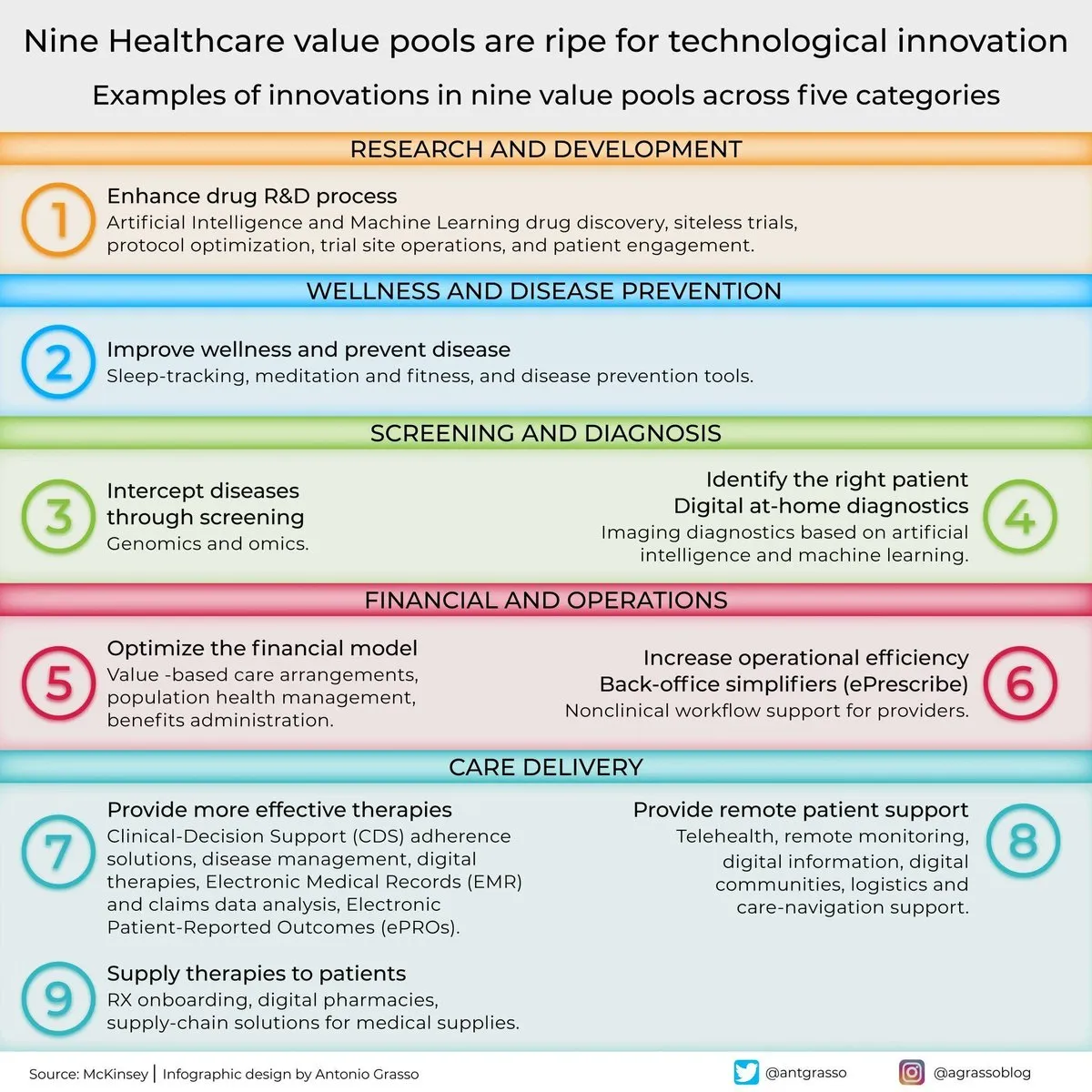

Neun Wertschöpfungsbereiche für KI in der medizinischen Innovation : Die Diskussion weist darauf hin, dass es im Gesundheitswesen neun Wertschöpfungsbereiche gibt, die für technologische Innovationen bereit sind. Obwohl KI nicht explizit genannt wird, ist sie zweifellos eine der Hauptantriebskräfte für den technologischen Fortschritt und die digitale Transformation im Gesundheitswesen, die Diagnose, Behandlung, personalisierte Pflege und viele andere Aspekte umfasst. (Quelle: Ronald_vanLoon)