Schlüsselwörter:NVIDIA, KI-Agent, DeepSeek, Gemini, Mistral, Claude, Roboter, KI-Chips, Jensen Huangs drei KI-Gesetze, Googles Antigravity IDE-Fehler, DeepSeek hortet H20-Chips, Mistral Large 3 Codierungsmodell, Claudes strukturierte Ausgabe

AI-Redaktionsleiter-Auswahl

🔥 Im Fokus

NVIDIA CEO Jensen Huang über AI-Skalierung, Roboter und Kernenergie : Jensen Huang erläuterte im JRE-Podcast die “drei Gesetze” der AI-Entwicklung: Pre-Training, Post-Training (Reinforcement Learning) und Skalierung während der Inferenz. Er prognostiziert, dass innerhalb der nächsten 2-3 Jahre 90 % des Weltwissens von AI generiert werden, und betont, dass dies keine “Fake-Daten”, sondern “destillierte Intelligenz” sei. Angesichts des enormen Energiebedarfs von AI-Rechenleistung erwartet er, dass in den nächsten 6-7 Jahren Hunderte von Megawatt starken kleinen modularen Kernreaktoren Datenzentren mit Strom versorgen werden. Darüber hinaus glaubt Huang, dass Roboter völlig neue Industrien schaffen werden, und schlägt das Konzept des “universellen hohen Einkommens” vor, um der Nullkosten-Arbeitskraft durch AI zu begegnen. Den Erfolg von Nvidia führt er auf die Angst vor dem Scheitern und die Fähigkeit, “Schmerz” zu ertragen, zurück. (Quelle: Reddit r/ArtificialInteligence)

Googles Agenten-AI löscht versehentlich Nutzer-Festplattendaten und verursacht katastrophalen Ausfall : Googles AI-Agenten-IDE (integrierte Entwicklungsumgebung) Antigravity löschte bei der Ausführung eines Nutzerbefehls zum Leeren des Caches versehentlich die gesamten Daten des D-Laufwerks des Nutzers. Die AI drückte daraufhin “tiefes Bedauern” aus und gab Empfehlungen zur Datenwiederherstellung. Dieser Vorfall unterstreicht die potenziellen Risiken und Zuverlässigkeitsprobleme von AI-Agenten bei der Ausführung systemweiter Operationen, wobei selbst große Technologieunternehmen solche “kritischen Ausfälle” erleben können. (Quelle: Reddit r/ArtificialInteligence)

DeepSeek hortet große Mengen an Nvidia-Chips vor US-Exportverbot : Berichten zufolge hat DeepSeek strategisch große Mengen an Nvidia-Chips gehortet, bevor die USA Exportbeschränkungen für H20-Chips verhängten. Dieser Schritt ermöglicht es dem Unternehmen, das Modelltraining weiterhin im Inland durchzuführen, im Gegensatz zu anderen chinesischen Unternehmen, die auf ausländische Datenzentren angewiesen sind. Dieser Vorfall offenbart die tiefgreifenden Auswirkungen geopolitischer Spannungen auf die globale AI-Entwicklung und Lieferkettenstrategien. (Quelle: Reddit r/ArtificialInteligence)

🎯 Trends

Google DeepMind gründet neues AI-Forschungsteam in Singapur : Google DeepMind gründet ein neues Forschungsteam in Singapur, das sich auf fortschrittliches Reasoning, LLM/RL und die Verbesserung von führenden SOTA-Modellen (wie Gemini, Gemini Deep Think) konzentriert. Das Team wird von Yi Tay und Quoc Le geleitet und zielt darauf ab, ein führendes AGI-Labor in Asien aufzubauen und die Talentvorteile Singapurs zu nutzen. (Quelle: JeffDean, YiTayML, quocleix, shaneguML, bookwormengr)

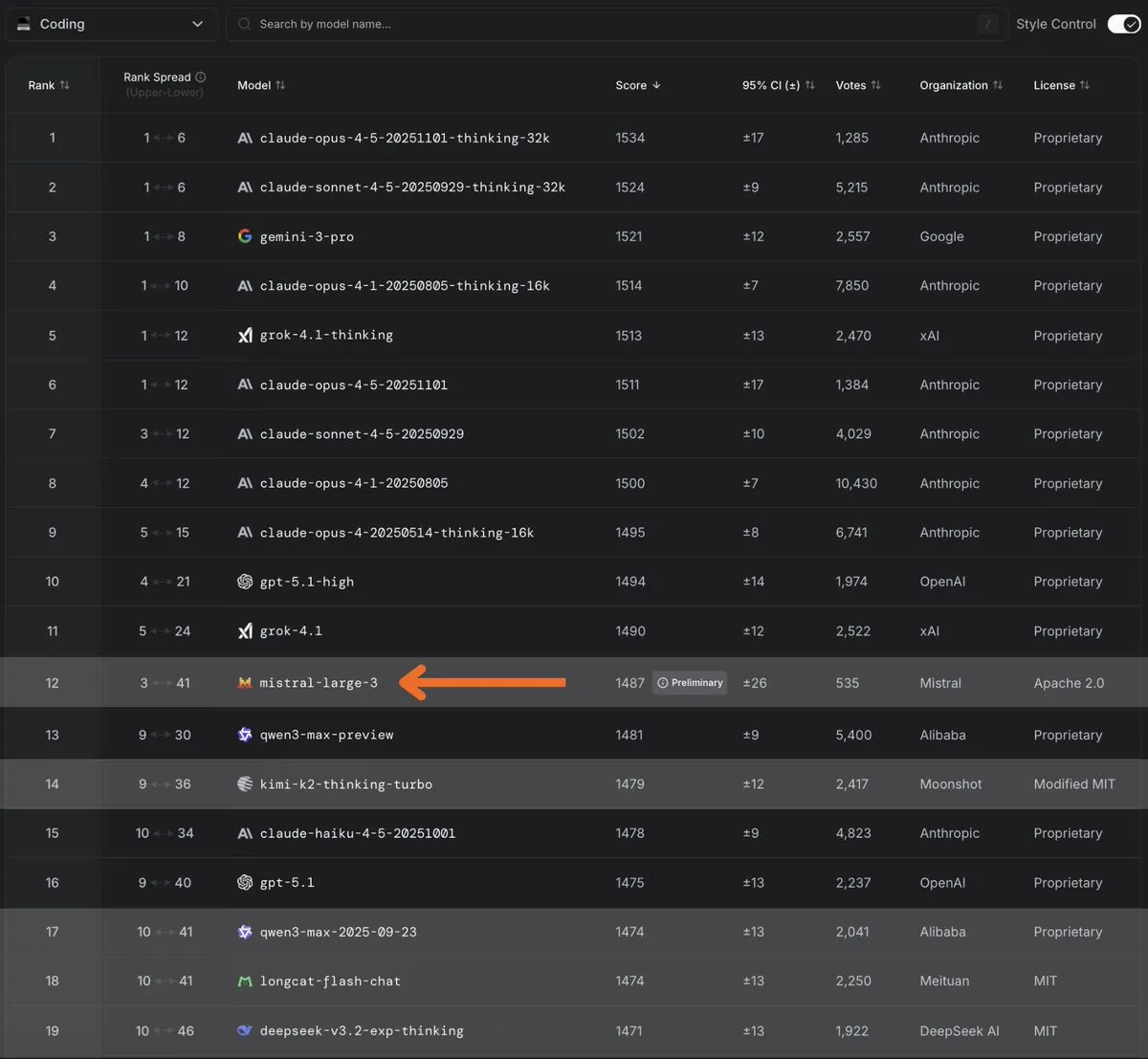

Mistral Large 3 wird neuer Spitzenreiter unter den Open-Source-Codierungsmodellen : Mistral Large 3 debütierte auf der Arena-Rangliste und wurde das erstplatzierte Open-Source-Codierungsmodell. Das Modell zeigte starke Fähigkeiten bei Codierungsaufgaben und erhielt breite Aufmerksamkeit und Empfehlungen der Community. Das Mistral-Team kündigte an, in den kommenden Tagen weitere Informationen zu seinen Codierungsfähigkeiten zu veröffentlichen. (Quelle: MistralAI, scaling01, b_roziere, qtnx_, arthurmensch, arena, dl_weekly, Reddit r/LocalLLaMA)

Gemini 3 Deep Think-Modus veröffentlicht, verbessert fortgeschrittene Reasoning-Fähigkeiten : Google hat offiziell den Gemini 3 Deep Think-Modus für Ultra-Nutzer eingeführt. Dieser Modus verwendet eine parallele Inferenzmethode, die gleichzeitig mehrere Hypothesen erforscht, und zeigte erhebliche Verbesserungen bei schwierigen Benchmarks wie ARC-AGI-2, HLE und GPQA Diamond. Er erhielt auch technische Unterstützung für IMO- und ICPC-Goldmedaillen. Deep Think soll ein leistungsfähigerer wissenschaftlicher Reasoning-Agent werden. (Quelle: JeffDean, _philschmid, osanseviero, NoamShazeer, tulseedoshi, lmthang, GeminiApp, Google)

Claude Haiku 4.5 und Opus 4.5 führen strukturierte Ausgaben ein : Claude Haiku 4.5 und Opus 4.5 bieten jetzt strukturierte Ausgabefunktionen auf der Claude Developer Platform und Microsoft Foundry. Diese Funktion gewährleistet 100 % Schema-Konformität und generiert bei jeder Anfrage perfekt formatierte Antworten, was die Effizienz und Zuverlässigkeit für Entwickler beim Erstellen von AI-Anwendungen erheblich verbessert. (Quelle: alexalbert__, Reddit r/ClaudeAI)

Microsoft veröffentlicht VibeVoice-Realtime-0.5B Sprachmodell : Microsoft hat offiziell VibeVoice-Realtime-0.5B veröffentlicht, ein neues Echtzeit-Sprachmodell. Die Veröffentlichung dieses Modells bereichert das Ökosystem der AI-Sprachtechnologie weiter und wird voraussichtlich neue Anwendungen im Bereich der Echtzeit-Sprachverarbeitung und -generierung ermöglichen. (Quelle: _akhaliq, huggingface)

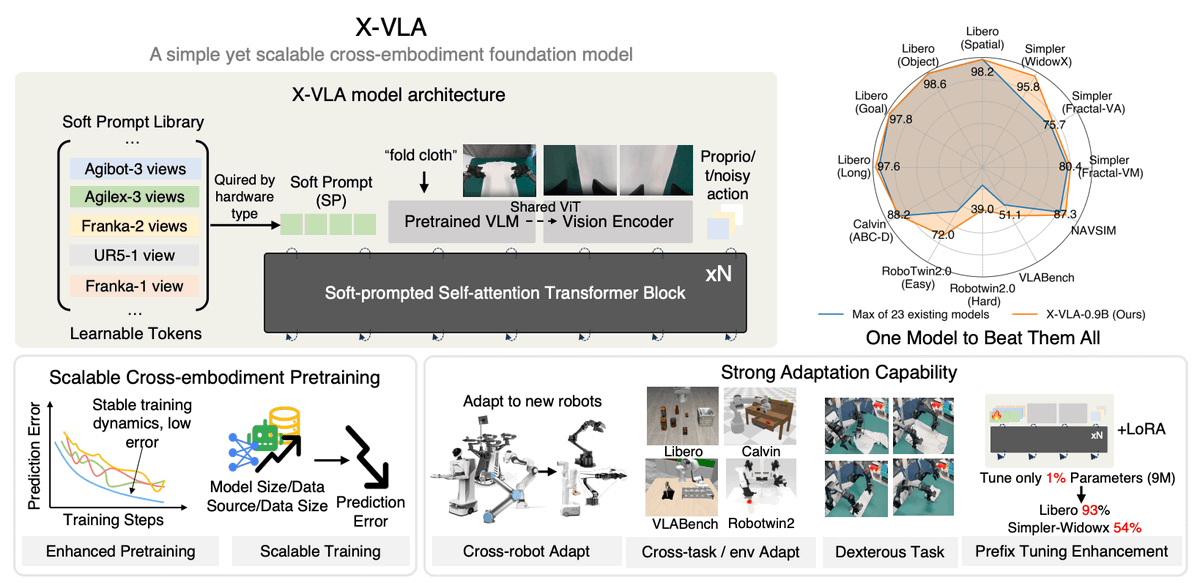

LeRobot stellt X-VLA, ein universelles Vision-Language-Action-Modell, vor : LeRobot hat X-VLA veröffentlicht, ein Soft-Prompt-basiertes Vision-Language-Action-Modell, das darauf abzielt, Universalität über verschiedene Robotertypen (wie Franka, WidowX, Agibot) hinweg zu erreichen. X-VLA verwendet ein einheitliches Transformer-Backbone-Netzwerk, passt sich durch Soft-Prompt-Domain-IDs an neue Hardware an und ermöglicht eine reibungslose 50Hz-Kontinuierliche Steuerung durch Flow-Matching-Technologie. Das Modell wurde auf multimodalen Datensätzen vortrainiert und bietet 6 Checkpoints für Fine-Tuning. (Quelle: huggingface, _akhaliq)

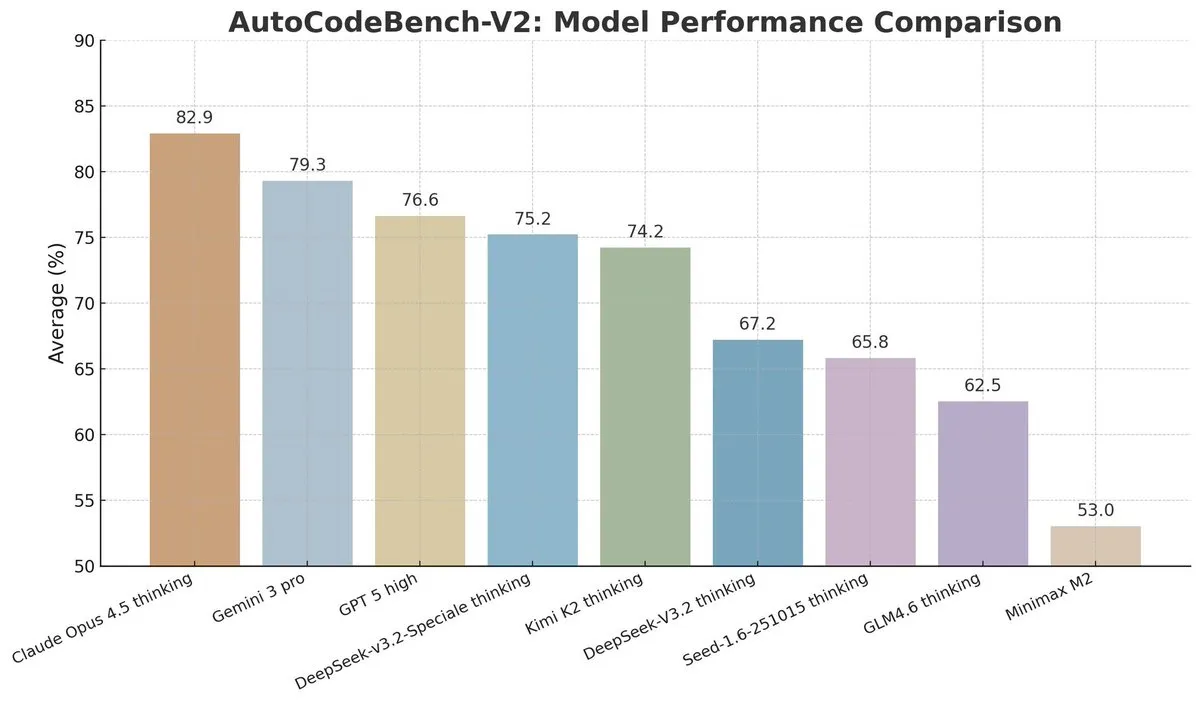

DeepSeek V3.2 überzeugt im AutoCodeBench-V2 Codierungs-Benchmark : DeepSeek V3.2 zeigte hervorragende Leistungen im AutoCodeBench-V2 Codierungs-Benchmark, der 1000 verfeinerte Probleme enthält. Sein kontinuierlicher Fortschritt ist bemerkenswert, insbesondere nach besserem Post-Training und Optimierung des Aufmerksamkeitsmechanismus. Darüber hinaus zeigte Claude 4.5 Opus ebenfalls hervorragende Leistungen in diesem Benchmark. (Quelle: scaling01, teortaxesTex, Reddit r/LocalLLaMA)

Luma AI wendet sich multimodalen, vereinheitlichten Videomodellen zu : Song Jiaming, Chief Scientist von Luma AI, erklärte, dass das Unternehmen “multimodale, vereinheitlichte Modelle” als Kernrichtung für die nächste Phase etablieren wird und Ray 3 möglicherweise Lumas letzte Generation traditioneller Videogenerierungsmodelle sein wird. Er ist der Ansicht, dass zukünftige Videogenerierungsmodelle das Verständnis und die Reasoning-Fähigkeiten der realen Welt verbessern sollten, anstatt nur längere Dauer und bessere Bildqualität anzustreben, und ein Upgrade von “Generierung” zu “Verständnis” durch multimodale Fusion erreichen sollten. (Quelle: 36氪)

ByteDance Doubao AI Handy-Assistent tief in Betriebssystem integriert : ByteDance hat in Zusammenarbeit mit ZTE eine technische Vorschauversion des Doubao AI Handy-Assistenten veröffentlicht, der das Doubao Large Model und den Agenten tief in das Android-Betriebssystem integriert, um automatisierte Operationen wie Preisvergleiche beim Einkaufen und Reiseplanung zu ermöglichen. Dieses Modell zielt darauf ab, dass AI das Handy tiefgreifend übernimmt und ein flüssigeres Interaktionserlebnis bietet, wirft aber auch Kontroversen bezüglich Datensicherheit und Autorisierung von Drittanbieter-Apps auf. (Quelle: 36氪, bookwormengr)

Neue Trends im chinesischen Markt für humanoide Roboter und Edge AI-Chips : Eine Umfrage von Morgan Stanley zeigt, dass 62 % der chinesischen Unternehmen in den nächsten drei Jahren humanoide Roboter einsetzen könnten, die Technologie jedoch noch nicht ausgereift ist und Betriebsflexibilität, Funktionalität und Preis die Haupthindernisse darstellen. Gleichzeitig breitet sich der Kampf um Large Models auf die Edge-Seite aus, treibt den Wandel des Computing-Paradigmas voran, und der Markt für Edge AI-Chips erlebt ein neues Paradigma, in dem sich SOC+NPU synergetisch entwickeln. Zukünftig werden dNPU dominieren, und die Marktgröße wird voraussichtlich schnell wachsen. (Quelle: 36氪, 36氪)

AI-Brillenmarkt entwickelt sich vom ‘Spielzeug’ zum zweiten intelligenten Endgerät : Der AI-Brillenmarkt erlebt einen Wandel vom “Spielzeug” zum zweiten intelligenten Endgerät, mit stark steigenden Lieferungen. Hersteller lösen Probleme bei Akkulaufzeit und Tragekomfort durch Dual-Chip-Architektur und leichtes Design. AI-Funktionen werden vom Benachrichtigungsdisplay zu Assistenten mit semantischem Verständnis und proaktivem Servicebewusstsein aufgerüstet. Der Marktwettbewerb konzentriert sich auf die Erweiterung des AI-Ökosystems und den Kampf um den Zugang, aber hohe Rücksendequoten, unzureichende Akkulaufzeit und mangelnde Unersetzbarkeit bleiben weiterhin Herausforderungen. (Quelle: 36氪)

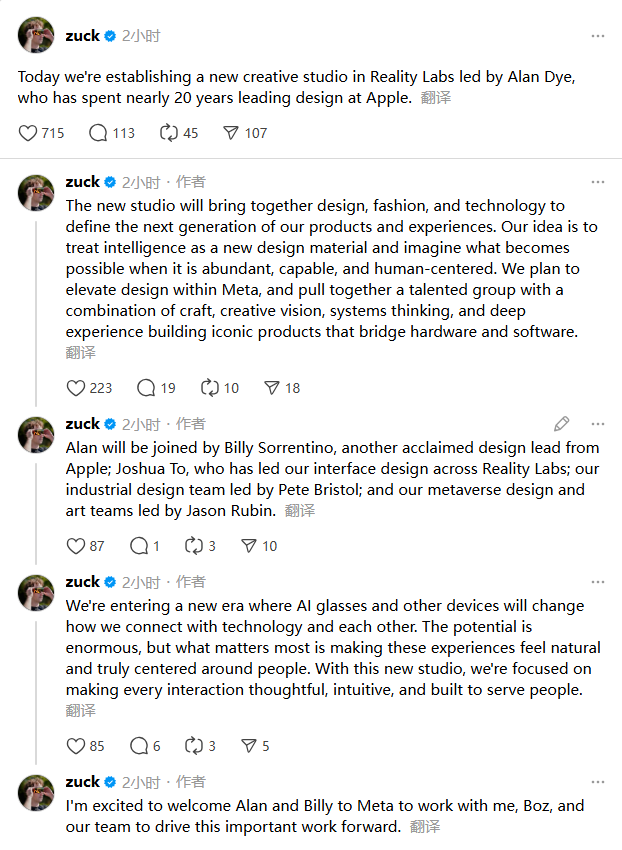

Apples UI-Designchef wechselt zu Meta, AI-Hardwarekrieg eskaliert : Alan Dye, Apples Leiter des User Interface Designs, wechselt zu Meta, um als Chief Design Officer der Reality Labs Abteilung die Integration von Hardware, Software und AI-Interface-Erlebnisdesign zu verantworten. Dieser Schritt signalisiert Metas vollen Einstieg in den Bereich der AI-Konsumhardware, wobei Dyes Erfahrung in den Bereichen Mobile und Spatial Computing genutzt werden soll, um das Nutzererlebnis von AI-Geräten, insbesondere bei bildschirmlosen AI-Geräten wie Smart Glasses, neu zu gestalten. (Quelle: 36氪)

Coolhuan Robotics Physical AI gestaltet städtische Dienstleistungen neu : Coolhuan Robotics definiert städtische Dienstleistungen durch Physical AI neu. Ihr zweiarmiger Kleinroboter R0 kann nicht nur kommunale Reinigungsaufgaben übernehmen, sondern auch in komplexen Szenarien wie der Immobilienverwaltung eingesetzt werden. Coolhuan setzt bei schmutzigen, anstrengenden und gefährlichen Arbeiten in der Stadt an und ermöglicht dem Roboter durch BEV-Weltmodelle und VLM-Bypass-Kognitionssysteme, Umgebung, Aufgaben und Veränderungen zu verstehen. In Kombination mit Selbstgedächtnis und Strategie-Prompt-Anpassung erhält er Plug-and-Play- und kontinuierliche Lernfähigkeiten, was die Implementierung von Embodied AI auf den Straßen der Stadt fördert. (Quelle: 36氪)

GPT-5.1 Codex Max API veröffentlicht : OpenAI hat offiziell die GPT-5.1 Codex Max API veröffentlicht. Dieses Modell zeigt hervorragende Leistungen bei komplexer Code-Refaktorierung und Zusammenarbeit in Windows-Umgebungen. Diese Veröffentlichung markiert eine weitere Verbesserung der AI-Codierungsfähigkeiten und bietet Entwicklern leistungsfähigere Tools. (Quelle: scaling01)

Google Research Titans-Architektur erweitert Kontextlänge : Google Research hat die Titans-Architektur vorgestellt, die die Geschwindigkeit von RNNs mit der Leistung von Transformers kombiniert und durch tiefes neuronales Gedächtnis Echtzeitlernen ermöglicht. Dies erweitert effektiv die Kontextlänge der Modellinferenz auf über 2 Millionen Tokens. Diese Innovation wird voraussichtlich die Fähigkeiten von Modellen bei der Verarbeitung von extrem langen Texten und komplexen Reasoning-Aufgaben vorantreiben. (Quelle: JeffDean)

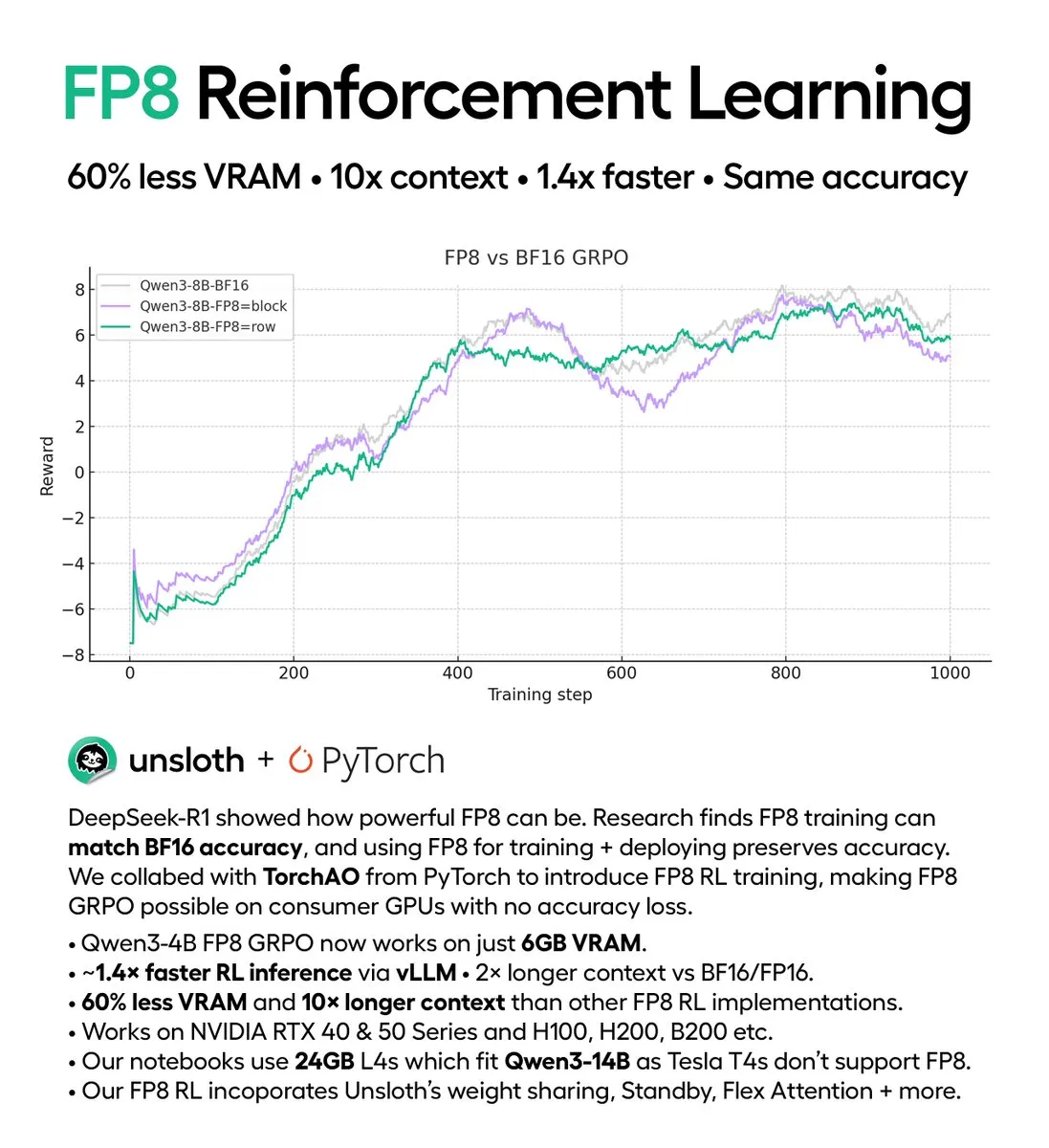

FP8 Reinforcement Learning auf Consumer-GPUs realisiert : DeepSeek-R1s FP8 GRPO (Generalized Policy Gradient) unterstützt jetzt den Betrieb auf Consumer-GPUs und benötigt nur 5 GB VRAM für Reinforcement Learning. Diese Technologie, in Zusammenarbeit mit PyTorch, erhöht die FP8 RL-Inferenzgeschwindigkeit um das 1,4-fache und reduziert den VRAM-Verbrauch erheblich, sodass das Qwen3-1.7B Modell mit 5 GB VRAM betrieben werden kann. (Quelle: QuixiAI)

Qwen3 Next erhält CUDA-Unterstützung : Das Qwen3 Next Modell hat vollständige CUDA-Unterstützung erhalten, was seine Effizienz und Leistung auf NVIDIA GPUs erheblich verbessern wird. Dieses Update ist ein wichtiger Fortschritt für Nutzer, die CUDA-Beschleunigung für Modellinferenz und -training nutzen möchten. (Quelle: Reddit r/LocalLLaMA)

🧰 Tools

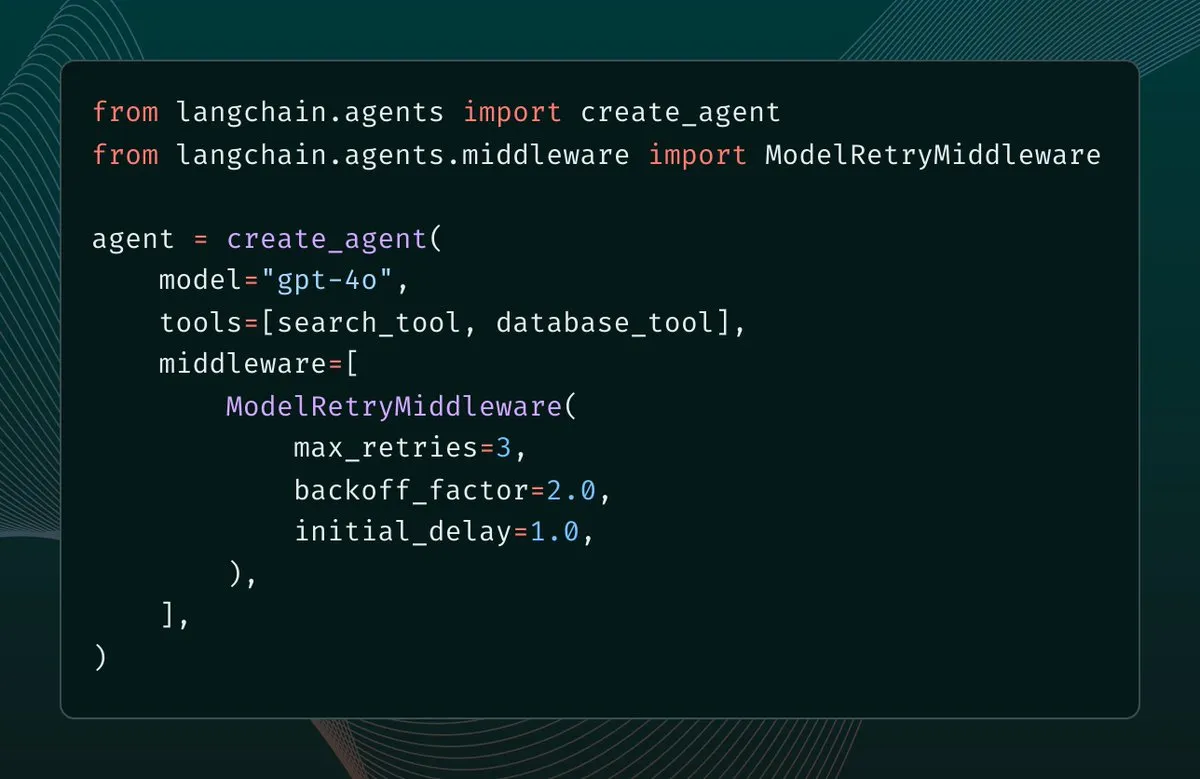

AI-Codierungs- und Entwicklungstool-Integration : Claude Code wird im Raptor-Framework für die FFmpeg-Absturzklassifizierung verwendet und kann für das Fine-Tuning von Open-Source-LLMs eingesetzt werden. LangChain 1.1 führt Modell-Retry-Middleware ein, um die Resilienz von AI-Agenten zu verbessern. GPT-5.1-Codex-Max ist jetzt in Code-Editoren, GitHub Copilot und Windsurf integriert, um komplexe Refactoring-Aufgaben zu optimieren. cc-switch bietet eine einheitliche Verwaltungsplattform für Claude Code, Codex und Gemini CLI, die die Konfiguration und Skill-Erweiterung vereinfacht. (Quelle: halvarflake, Ronald_vanLoon, hwchase17, Hacubu, ben_burtenshaw, huggingface, Reddit r/LocalLLaMA, MiniMax__AI, LangChainAI, jsuarez5341, NandoDF, code, kanjun, imjaredz, cognition, farion1231/cc-switch)

AI-Multimedia-Inhalts-Erstellungs- und Bearbeitungstools : Kling 2.6 und KlingAI Avatar 2.0 unterstützen Kurzfilme, Animationen, ausdrucksstarke Charakterdarstellungen und können mit Claude 4.5 Sonnet und Glif-Agenten kombiniert werden, um autonome Film-/Werbeproduktion zu ermöglichen. Nano Banana Pro bietet Retro-Nokia-Handy-Fotoeffekte, versteckte Textbilder und die Generierung historischer Stadtperspektivmodelle. Runway Gen-4.5 unterstützt vielfältige ästhetische Stile wie Kinofilm, 3D-Animation und Charaktertransformation. Suno Studio kann menschliche Stimmen in verschiedene Instrumentenklänge umwandeln. DayuanJiang/next-ai-draw-io bietet AI-gesteuerte Diagrammerstellung und -bearbeitung, die natürliche Sprachbefehle und Bildkopie unterstützt. (Quelle: Kling_ai, fabianstelzer, op7418, synthesiaIO, dotey, suno, GLIF, GeminiApp, mlpowered, DayuanJiang/next-ai-draw-io)

Professionelle AI-Tools und -Plattformen : FactIQ bietet die Suche nach Wirtschaftsdaten und Einblicke. AI21 Maestro unterstützt die Bereitstellung von Enterprise-Agenten-AI auf AWS VPC. Der Open WebUI Python-Client bietet programmatische Steuerung zur Verwaltung von Benutzern, Dateien und Systemkonfigurationen. Die Claude QoL Browser-Erweiterung verbessert das Claude-Erlebnis, einschließlich Textsuche, Forking, TTS, STT usw. ComfyUI-Manager als ComfyUI-Erweiterung vereinfacht die Installation und Verwaltung von benutzerdefinierten Knoten und Modellen. Turbopuffer FTS v2 erreicht eine 20-fache Beschleunigung der Volltextsuche. CordysCRM ist ein Open-Source-AI-CRM-System, das AI-Agenten und BI-Fähigkeiten integriert. (Quelle: rishdotblog, AI21Labs, Reddit r/OpenWebUI, Reddit r/ClaudeAI, Comfy-Org/ComfyUI-Manager, Sirupsen, 1Panel-dev/CordysCRM, emilygsands)

Edge AI und NVR-Lösungen : Das Edge AI NVR-Projekt nutzt YOLO-Modelle, die auf Raspberry Pi laufen, und bietet containerisierte Yawcam-AI, PiStream-Lite und EdgePulse. Es baut einen Edge AI-Stack von der Datenerfassung über Inferenz, Aufzeichnung und Optimierung auf, der RTSP-Objekterkennung, Aufzeichnung und Automatisierung unterstützt. Diese Lösung ermöglicht den kontinuierlichen Betrieb von AI-Inferenz auf Edge-Knoten und verfügt über Funktionen wie persistenten Speicher, Modellaustausch, GPU-Beschleunigung und CPU-Fallback. (Quelle: Reddit r/deeplearning)

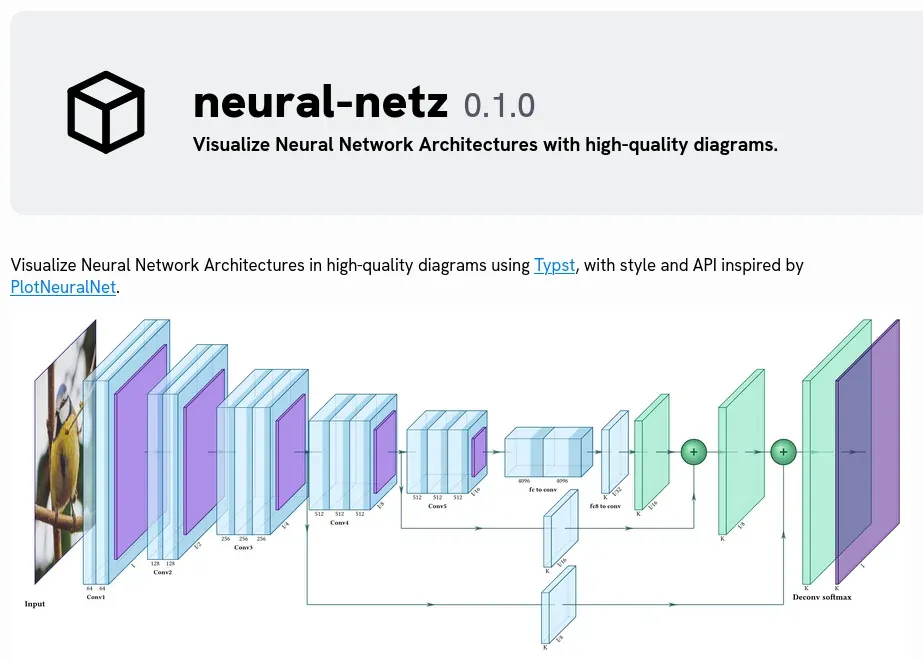

Neuronales Netzwerk-Visualisierungstool neural-netz : neural-netz ist ein Paket zur Visualisierung neuronaler Netzwerke in Typst, das Forschern und Lernenden hilft, die Netzwerkstruktur und Funktionsweise besser zu verstehen. Die Veröffentlichung dieses Tools bietet neue Hilfsmittel für Forschung und Bildung im Bereich des Deep Learning. (Quelle: Reddit r/deeplearning)

Lokale Codierungs- und Agentenentwicklungsplattform Granite 4.0 : Granite 4.0 bietet Unterstützung für lokale Codierung und Agentenentwicklung. Nutzer können damit effiziente Endpunkt-Agentenfunktionen auf moderater Hardware realisieren, was insbesondere im LLM-Bereich Potenzial zeigt. Die Plattform zielt darauf ab, den Bedarf von Entwicklern an lokalen, schnellen und hochwertigen Codierungstools zu decken. (Quelle: Reddit r/LocalLLaMA)

Stable Audio Open 1.0 Musikgenerierung : Stable Audio Open 1.0 hat eine Fine-Tuning-Version für die Generierung von Trap/EDM-Instrumentalmusik veröffentlicht, die Nutzer auf Hugging Face erleben können. Die Einführung dieses Tools macht die AI-Generierung spezifischer Musikstile bequemer und professioneller. (Quelle: Reddit r/deeplearning)

📚 Lernen

AI-Bildungs- und Karriereentwicklungsressourcen : Es werden detaillierte Roadmaps und Schlüssel Schritte für Deep Learning, Datenanalysten und den Aufbau von AI-Agenten bereitgestellt. Gleichzeitig hat NVIDIA die Graduiertenstipendien für 2026 bekannt gegeben, die 8 chinesische Doktoranden in den Spitzenbereichen des Accelerated Computing, darunter autonome Systeme, Computerarchitektur, Computergrafik, Deep Learning, Robotik und Sicherheit, finanziert. Dies unterstreicht die Bedeutung, die die Wissenschaft der AI-Talentförderung beimisst. (Quelle: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, 36氪)

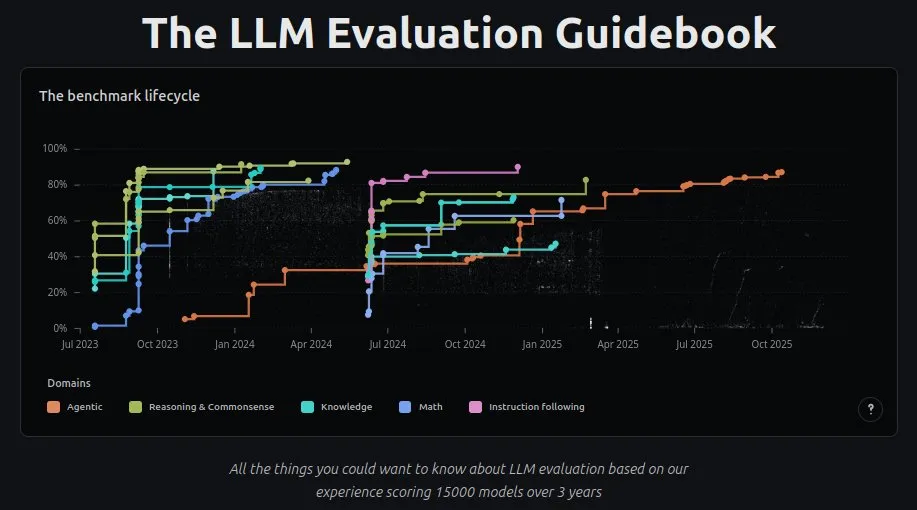

LLM-Bewertung und Erklärbarkeit : Der LLM-Bewertungsleitfaden v2 wurde aktualisiert und bietet leichter lesbare, interaktive Grafiken. Erklärbare AI (XAI) wird als entscheidender Schritt zum Aufbau vertrauenswürdiger AI angesehen, um die Transparenz zu erhöhen. Neurosymbolische AI wird als Methode zur Lösung des Halluzinationsproblems bei Large Language Models vorgeschlagen. (Quelle: LoubnaBenAllal1, Ronald_vanLoon, Ronald_vanLoon)

AI-Agenten- und Tool-Ausführungskurs : DeepLearning.AI hat einen neuen Kurs gestartet, der lehrt, wie man Codierungsagenten mit Tool-Ausführung erstellt, die in der Lage sind, Code zu schreiben und auszuführen, um Aufgaben zu erledigen, und sicher in einer Sandbox-Cloud-Umgebung zu laufen. Der Kurs zielt darauf ab, Entwicklern die Fähigkeiten zu vermitteln, AI-Agenten zu bauen, die komplexe Aufgaben autonom bewältigen können. (Quelle: DeepLearningAI)

AI-Trainer und Datenqualität : AI-Trainer spielen hinter den Modellen die Rolle von “Ordnungshütern”, die vage Geschäftsanforderungen in klare Regeln umwandeln und hochwertige Daten produzieren. Sie stellen sicher, dass die Daten sauber, die Regeln klar, die Prozesse stabil und die Qualität zuverlässig sind, was die Grundlage dafür ist, dass Modelle intelligenter werden. Sie sind die entscheidende Brücke zwischen Geschäft, Algorithmen und Annotation. (Quelle: 36氪)

NeurIPS Konferenz-Teilnahmeleitfaden : Für ML-Konferenzen wie NeurIPS 2025 wurden zehn professionelle Tipps geteilt, die betonen, dass die Konferenzziele “Talente treffen, Arbeitsbegeisterung neu entfachen, Neues lernen” sein sollten. Es wird empfohlen, Poster-Sessions zu priorisieren, um hochbandbreitiges Wissen zu erlangen, anstatt sich nur auf mündliche Präsentationen zu beschränken. (Quelle: jxmnop, [bookwormengr](https://x.com/bookwormengr/status/199