Schlüsselwörter:KI-Großmodelle, Open-Source-Modelle, AGI, Inferenzoptimierung, KI-Suche, KI-Brillen, KI-Agenten, a16z Billion-Token-Bericht, Gemini 3 API, Douban KI-Handy, Titans-Architektur, Multimodale Fusion

🎯 Trends

a16z Billion Token Report enthüllt große AI-Divergenz : OpenRouter und a16z haben gemeinsam einen Bericht auf Basis von 100 Billionen Token veröffentlicht, der drei große AI-Trends für 2025 aufzeigt: Open-Source-Modelle werden 30% des Traffics ausmachen; Chinas Open-Source-Stärke wächst und macht fast 30% des weltweiten Anteils aus; der Traffic von inferenzoptimierten Modellen steigt auf über 50%, AI verlagert sich von “Textgenerierung” zu “Problemlösung”; Programmierung und Rollenspiele sind die beiden dominierenden Szenarien. Der Bericht führt auch den “Cinderella-Effekt” ein, der betont, dass Modelle zuerst spezifische Schmerzpunkte lösen müssen, um Benutzer zu binden, und weist darauf hin, dass sich die kostenpflichtige Nutzung in Asien verdoppelt hat und Chinesisch die zweitgrößte AI-Interaktionssprache geworden ist. (Quelle: source, source)

Evolution und Kontroverse der AI-Suche : AI-Suche entwickelt sich von der Informationsverteilung zur Dienstleistungsvermittlung. AI-native Suchmaschinen wie Google Gemini 3 und Perplexity gestalten das Sucherlebnis durch dialogorientierte Interaktion, multimodales Verständnis und Aufgabenausführung neu. Der Marktanteil traditioneller Suchmaschinen sinkt, während AI-Suche zu einer grundlegenden Fähigkeit verschiedener Anwendungen wird. Musks Behauptung, AI werde die “Suche eliminieren”, spiegelt den Schock für traditionelle Modelle und die Erwartung eines Billionen-Dollar-Marktes für Dienstleistungsvermittlung wider, löst aber auch Diskussionen über vertrauenswürdige Informationsquellen und Paradigmenwechsel im Marketing aus. (Quelle: source)

Die “Schlacht der hundert Brillen” für AI-Brillen : Innerhalb von zwei Monaten wurden auf dem chinesischen Markt 20 AI-Brillenmodelle eingeführt. Giganten wie Google, Alibaba, Huawei und Meta treten in den Markt ein, um den Einstiegspunkt für die nächste Generation der intelligenten Interaktion zu erobern. AI-Brillen integrieren große Modellfähigkeiten, um Funktionen wie Echtzeitübersetzung, Szenenerkennung und Sprachfragen und -antworten zu realisieren, und versuchen, traditionelle Brillen “überflüssig zu machen”. Produkthomogenität, Akkulaufzeit, Komfort und Datenschutz bleiben jedoch Herausforderungen, und der Markt sucht immer noch nach seinen “Killer-Applikationen” und Geschäftsmodellen. (Quelle: source, source)

Doubao AI Phone und der Kampf der Super Apps : Das Doubao AI Phone, eine Zusammenarbeit zwischen ByteDance und ZTE, löst mit seinen hochprivilegierten Agenten, die systemweite AI-Fähigkeiten ermöglichen, eine Diskussion über den “Kampf zwischen Super Agenten und Super Apps” aus. Benutzer können komplexe Operationen wie plattformübergreifende Preisvergleiche oder Essensbestellungen mit einem Satz ausführen. Plattformen wie WeChat haben jedoch schnell automatisierte Operationen von Drittanbietern verboten, was zeigt, dass die Implementierung von systemweiter AI nicht nur eine technische Frage ist, sondern auch Herausforderungen bei der Gewinnverteilung und Ökosystemkoordination mit sich bringt. Telefonhersteller könnten als neutrale Akteure leichter den Aufbau eines offenen AI-Telefon-Ökosystems fördern. (Quelle: source, source)

Herausforderungen der AI-Implementierung in der physischen Welt : Es besteht ein allgemeiner Konsens in der Branche, dass AI in der digitalen Welt ein “Gott” ist, aber in der physischen Welt immer noch ein “Riesenbaby”. Ein führender Vertreter der neuen Automobilhersteller wies darauf hin, dass Robotern das Laufen beizubringen schwieriger ist, als AI das Dichten beizubringen, da die physische Welt keinen “Rückgängig-Button” hat und die Betriebs- und Rechtskosten enorm sind. Die zukünftigen Vorteile liegen darin, AI in physische Geräte wie Autos und Werkzeugmaschinen zu integrieren, um einen Durchbruch im “Ingenieursanteil” zu erzielen. Darüber hinaus verlagert sich das Scaling Law, nachdem die Textdaten-Vorteile ausgeschöpft sind, auf das “Lernen aus Videos”, um physikalische Gesetze und Kausalität zu verstehen, was jedoch auch enorme Herausforderungen beim Rechenleistungsverbrauch mit sich bringt. (Quelle: source)

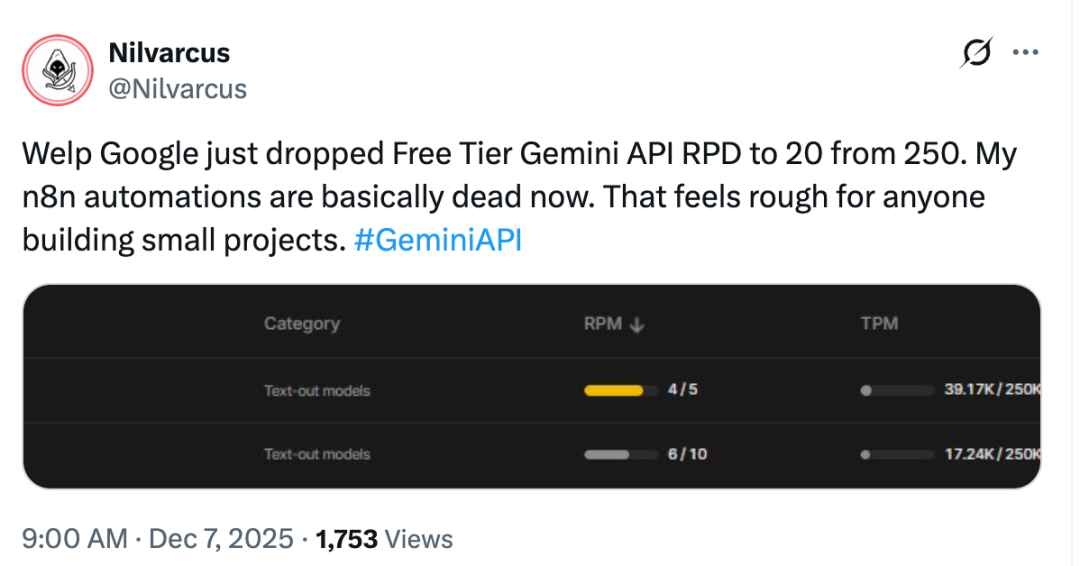

Google Gemini Free API Anpassungen und Marktkonkurrenz : Google hat die Beschränkungen für die kostenlose Stufe der Gemini API plötzlich verschärft, was bei Entwicklern Unmut hervorrief, die der Meinung sind, dass Google nach der Datensammlung auf Gewinn ausgerichtet ist. Dies geschieht zu einem Zeitpunkt, an dem OpenAI plant, GPT-5.2 als Antwort auf Gemini 3 zu veröffentlichen, wodurch der Wettbewerb um große AI-Modelle immer intensiver wird. Google DeepMind CEO Demis Hassabis betonte, dass Google im AI-Bereich die stärkste Position einnehmen muss, zeigte sich zufrieden mit der Leistung von Gemini 3 in Bezug auf multimodales Verständnis, Spieleentwicklung und Frontend-Entwicklung und bekräftigte die Bedeutung des Scaling Law. (Quelle: source)

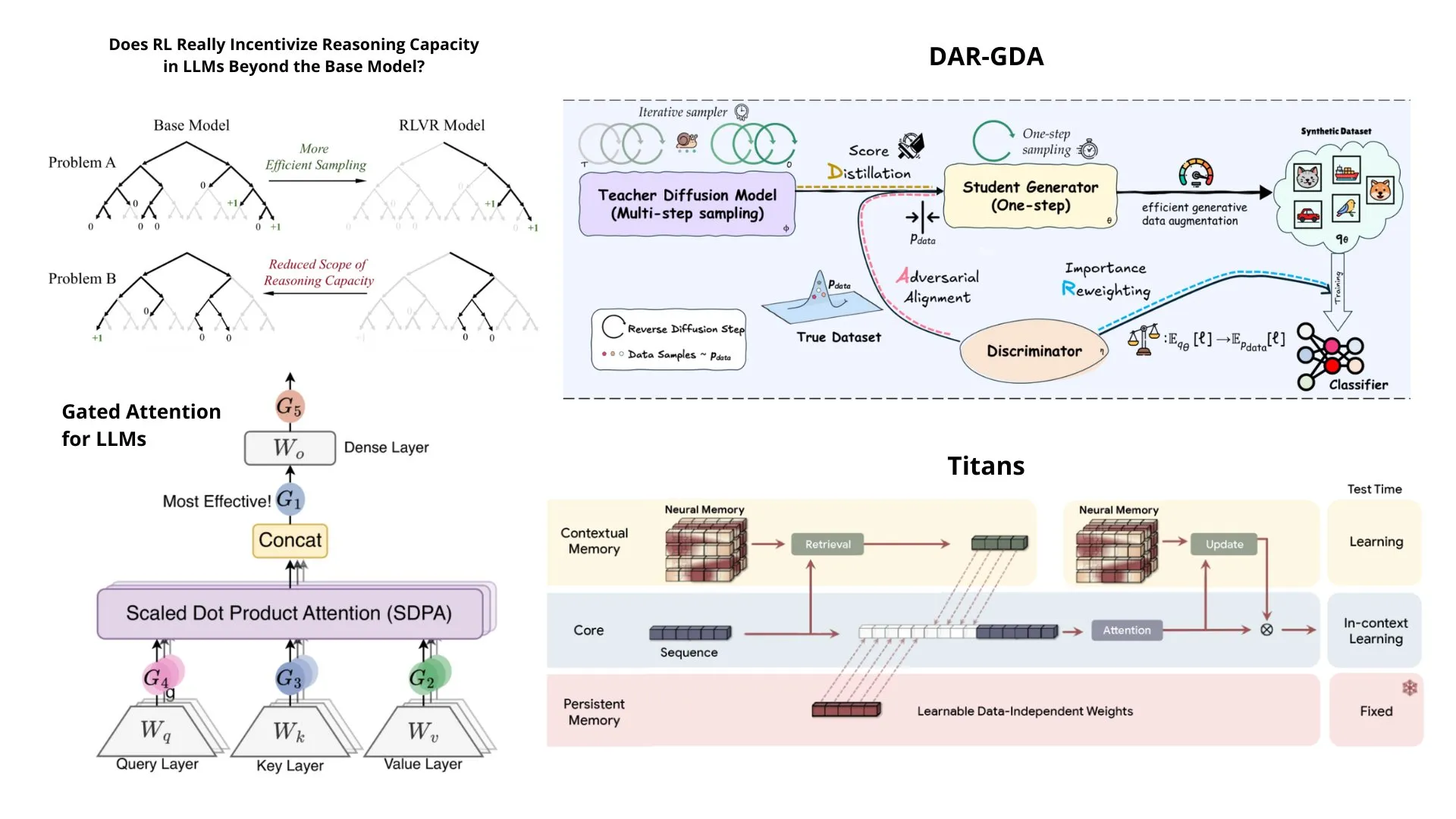

Google DeepMinds Titans Architektur und AGI-Ausblick : Google DeepMind CEO Demis Hassabis prognostiziert, dass AGI innerhalb von 5-10 Jahren erreicht sein wird, aber ein bis zwei “Transformer-ähnliche” Durchbrüche erfordert. Auf der NeurIPS 2025-Konferenz stellte Google die Titans-Architektur vor, die die Geschwindigkeit von RNNs mit der Leistung von Transformers vereint, um Probleme mit langen Kontexten zu lösen, und führte das MIRAS-Theorie-Framework ein. Titans komprimiert historische Daten durch ein Langzeitgedächtnismodul und ermöglicht die dynamische Aktualisierung der Modellparameter zur Laufzeit, was insbesondere bei Inferenzaufgaben mit extrem langem Kontext hervorragende Leistungen zeigt und als starker Nachfolger des Transformers gilt. (Quelle: source, source)

🧰 Tools

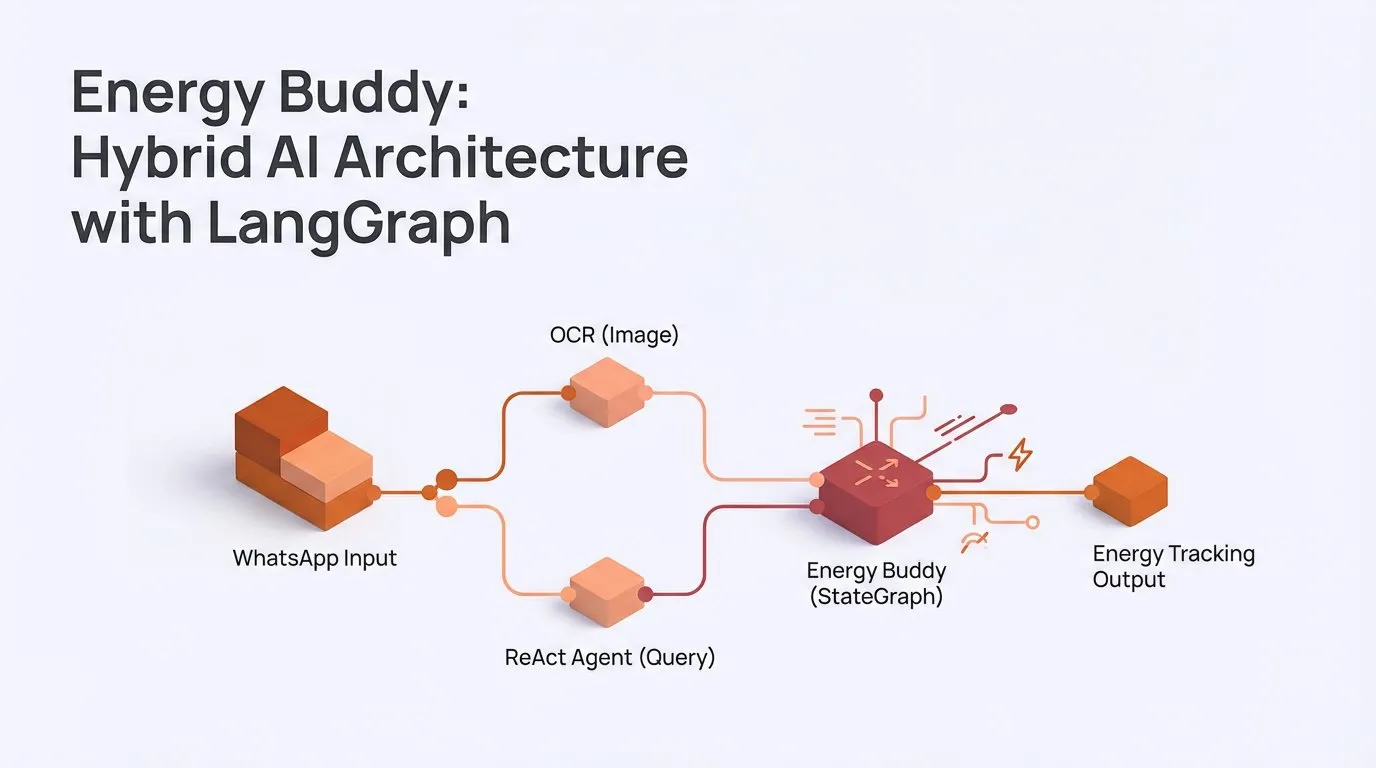

LangChainAIs hybride AI-Architektur und multimodale Fähigkeiten : Die LangChain-Community hat die Anwendung “Energy Buddy” veröffentlicht, die eine LangGraph-Hybrid-AI-Architektur verwendet, um Bilder deterministisch mit OCR zu verarbeiten und Abfragen mit einem ReAct-Agenten zu bearbeiten, wobei betont wird, dass nicht alle Aufgaben Agenten erfordern. Darüber hinaus bietet LangChain Tutorials, die zeigen, wie man mit Gemini multimodale AI-Anwendungen erstellt, die Bilder, Audio und Video verarbeiten, und so komplexe API-Aufrufe vereinfacht. (Quelle: source, source)

Multi-AI Prompt Tool Yupp AI : Yupp AI bietet eine Plattform, die es Benutzern ermöglicht, in einem Tab gleichzeitig Fragen an mehrere AI-Modelle (wie ChatGPT, Gemini, Claude, Grok, DeepSeek) zu stellen und die Funktion “Help Me Choose” zu nutzen, um die Modelle ihre Arbeit gegenseitig überprüfen zu lassen. Das Tool zielt darauf ab, den kollaborativen Workflow mehrerer AIs zu vereinfachen und zu beschleunigen, wird kostenlos angeboten und verbessert die Effizienz der Benutzer bei komplexen Aufgaben. (Quelle: source)

Agenten-Gedächtnissystem Cass Tool : doodlestein entwickelt ein Agenten-Gedächtnissystem, das auf seinem Cass Tool basiert und mehrere AI-Agenten wie Claude Code und Gemini3 für Planung und Codegenerierung nutzt. Das Cass Tool zielt darauf ab, eine leistungsstarke, in Codierungsagenten integrierte CLI-Oberfläche bereitzustellen, die das Agenten-Gedächtnis durch das Protokollieren von Sitzungen, das Extrahieren von Präferenzen und Feedback aktualisiert, um ein effektiveres Kontext-Engineering zu ermöglichen. (Quelle: source)

LlamaClouds Dokumenten-Agenten : LlamaCloud hat eine Lösung zur “intelligenten Dokumentenverarbeitung” eingeführt, die es Benutzern ermöglicht, professionelle Dokumentenagenten in Sekundenschnelle zu erstellen und bereitzustellen und ihre Workflows per Code anzupassen. Die Plattform bietet Beispiele für Agenten zur Rechnungsverarbeitung und Vertragsabgleich und behauptet, genauer und anpassbarer zu sein als bestehende IDP-Lösungen, um Dokumentenverarbeitungsaufgaben durch Codierungsagenten zu vereinfachen. (Quelle: source)

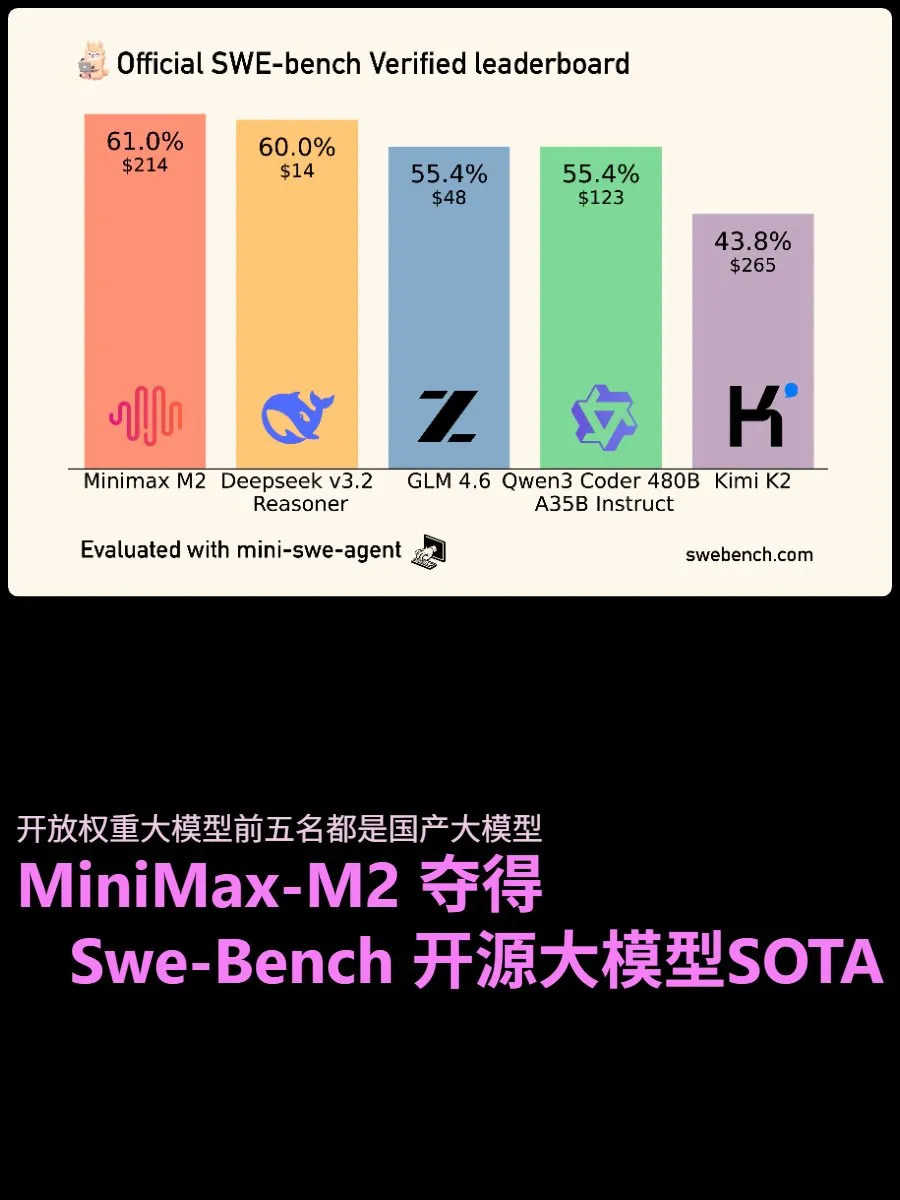

SWE-Bench Code-Testergebnisse : MiniMax-M2 ist das Open-Weight-Modell mit der höchsten Punktzahl im SWE-Benchverified-Test und zeigt starke Agenten-Fähigkeiten und Stabilität bei der Bearbeitung langer Aufgaben. Deepseek v3.2 Inference folgt dicht dahinter und erregt Aufmerksamkeit durch sein extrem hohes Preis-Leistungs-Verhältnis und gute Ergebnisse. GLM 4.6 zeigt eine ausgewogene Leistung, ist schnell, günstig und exzellent und gilt als König des Preis-Leistungs-Verhältnisses, was zeigt, dass Open-Source-Modelle im Bereich der Codegenerierung schnell zu kommerziellen großen Modellen aufholen. (Quelle: source)

Multi-Agenten-Orchestrierungstools : Diskussionen in sozialen Medien weisen darauf hin, dass Multi-Agenten-Orchestrierung die Zukunft der AI-Codierung ist und die Bedeutung eines intelligenten Kontextmanagements betont. Empfohlen werden Open-Source-Tools wie CodeMachine CLI, BMAD Method, Claude Flow und Swarms zur Koordination von Multi-Agenten-Workflows, strukturierter Planung und automatisierter Bereitstellung. Diese Tools zielen darauf ab, die Grenzen zu überwinden, die eine einzelne AI-Sitzung bei der Bewältigung komplexer Softwareentwicklung hat, und die Zuverlässigkeit von AI in realen Projekten zu verbessern. (Quelle: source)

Lokales LLM-Halluzinationsmanagementsystem : Ein Entwickler teilte sein selbstgebautes synthetisches “Nervensystem”, das darauf abzielt, Halluzinationen in lokalen LLMs zu managen, indem es den “somatischen” Zustand (wie Dopamin- und Emotionsvektoren) verfolgt. Das System löst bei hohem Risiko/niedrigem Dopamin defensives Sampling (Selbstkonsistenz und Verzicht) aus, was die Halluzinationsrate erfolgreich senkt, aber derzeit zu konservativ ist und auch bei beantwortbaren Fragen auf eine Antwort verzichtet. Das Projekt erforscht das Potenzial, die AI-Sicherheit während der Inferenz durch eine Kontrollschicht statt durch Modellgewichte zu verbessern. (Quelle: source)

📚 Lernen

Wissenschaftliche Arbeiten “Goodreads” Paper Trails : Anuja hat Paper Trails entwickelt, eine Plattform für das Management wissenschaftlicher Arbeiten, ähnlich wie Goodreads. Sie soll Forschern eine angenehmere und personalisierte Möglichkeit bieten, sich mit akademischem Lesen zu beschäftigen und Ressourcen wie Artikel, Blogs und Substack zu verwalten. Die Plattform hofft, das Forschungserlebnis interessanter und persönlicher zu gestalten. (Quelle: source, source)

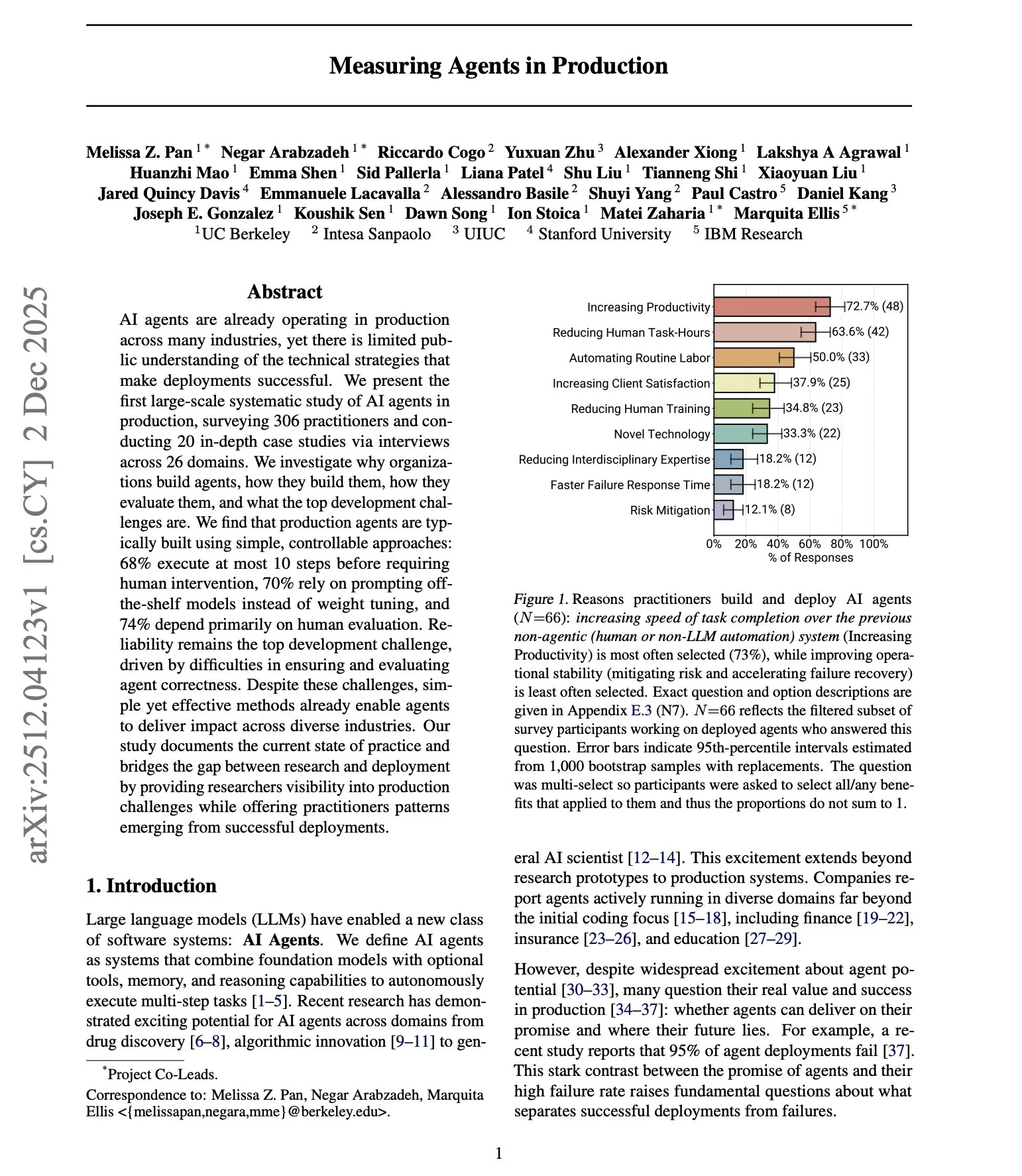

Studie zur Bereitstellung von AI-Agenten in der Produktion : DAIR.AI hat eine umfangreiche Studie über den Einsatz von AI-Agenten in Produktionsumgebungen veröffentlicht. Sie ergab, dass Produktionsagenten dazu tendieren, einfach und streng begrenzt zu sein, sich hauptsächlich auf fertige Modelle statt auf Feinabstimmung verlassen und hauptsächlich auf menschlicher Bewertung basieren. Die Studie hinterfragt gängige Annahmen über die Autonomie von Agenten, betont, dass Zuverlässigkeit die größte Herausforderung bleibt, und weist darauf hin, dass die meisten Teams für die Produktionsbereitstellung dazu neigen, benutzerdefinierte Implementierungen von Grund auf zu erstellen, anstatt sich auf Frameworks von Drittanbietern zu verlassen. (Quelle: source)

Neueste Übersicht über Agentic LLM : Eine neue Übersichtsarbeit zu Agentic LLMs deckt drei miteinander verbundene Kategorien ab: Inferenz, Retrieval, handlungsorientierte Modelle und Multi-Agenten-Systeme. Der Bericht weist darauf hin, dass Agentic LLMs Schlüsselanwendungen in Bereichen wie medizinische Diagnostik, Logistik, Finanzanalyse und wissenschaftliche Forschung haben und das Problem der Knappheit von Trainingsdaten lösen, indem sie während des Inferenzprozesses neue Trainingszustände generieren. (Quelle: source, source)

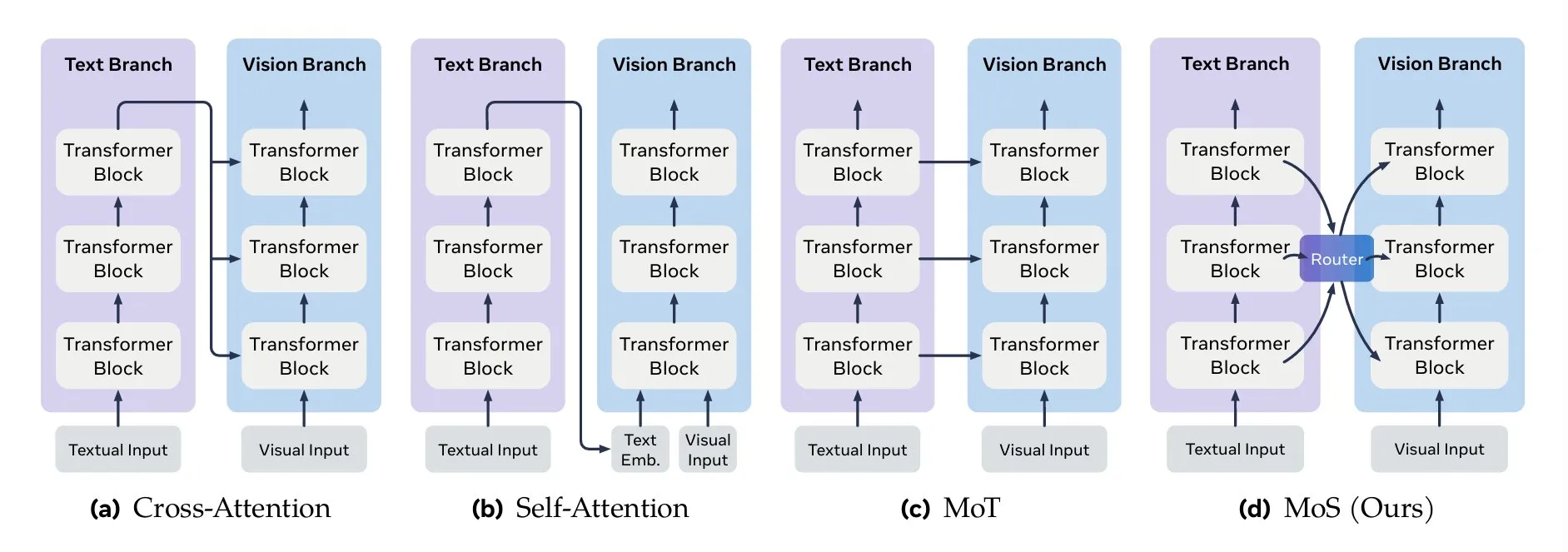

Schlüsselmethoden zur multimodalen Fusion : TheTuringPost fasst die Schlüsselmethoden zur multimodalen Fusion zusammen, darunter Aufmerksamkeitsmechanismen (Cross-Attention, Self-Attention), Mixture-of-Transformers (MoT), Graphenfusion, Kernelfunktionsfusion sowie Mixture of States (MoS). MoS gilt als eine der neuesten und fortschrittlichsten Methoden, die durch das Mischen von verborgenen Zuständen der Schichten und lernfähigen Routern visuelle und textuelle Merkmale effektiv integriert. (Quelle: source, source)

NeurIPS 2025 Liste der exzellenten Arbeiten : TheTuringPost hat eine Liste von 15 exzellenten Forschungsarbeiten der NeurIPS 2025 veröffentlicht, die verschiedene Spitzenthemen wie Faster R-CNN, Artificial Hivemind, Gated Attention for LLMs, Superposition Yields Robust Neural Scaling und Why Diffusion Models Don’t Memorize abdecken und AI-Forschern wichtige Referenzressourcen bieten. (Quelle: source)

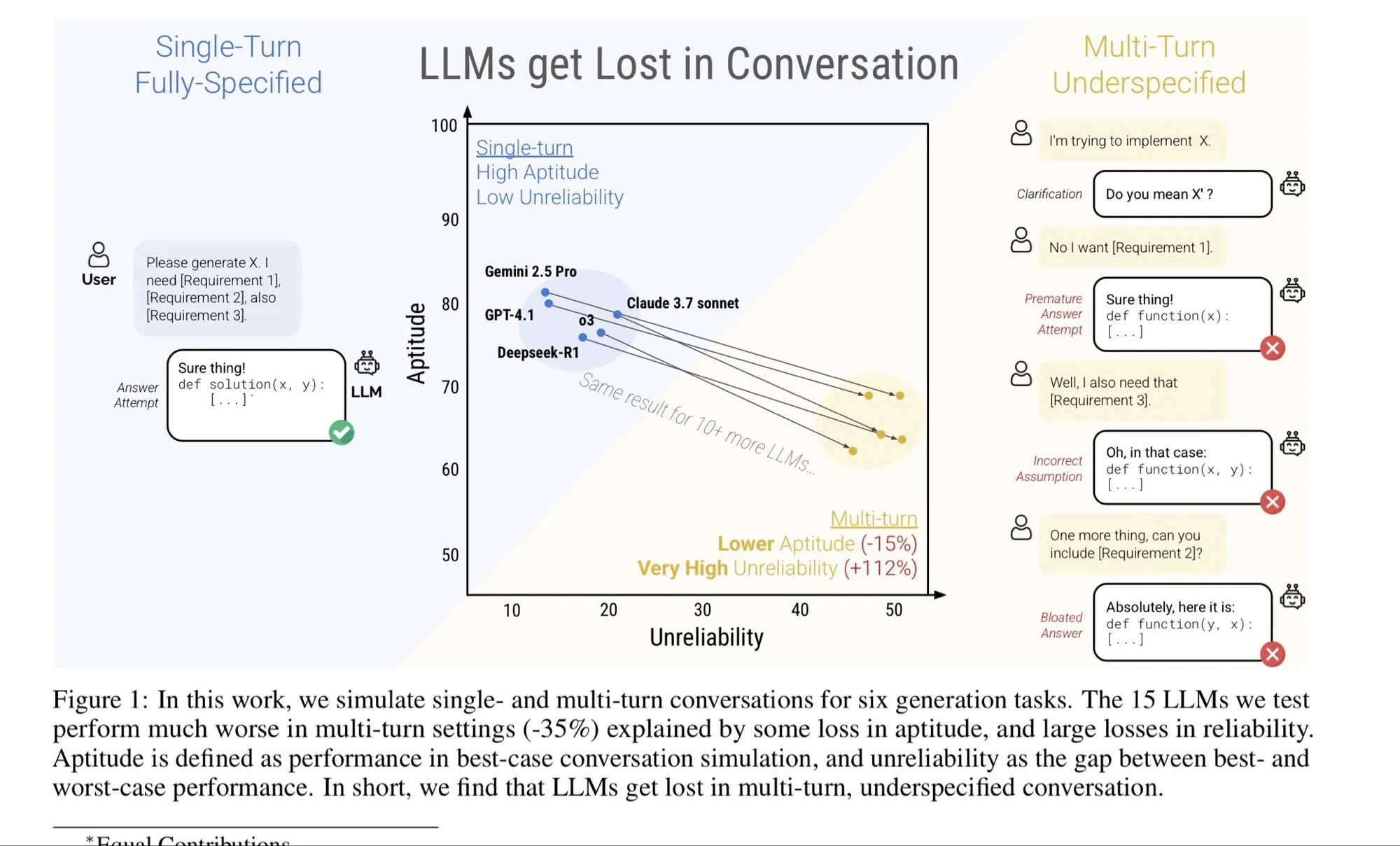

Fehler bei langem Kontext und deren Behebung : Ein Blogbeitrag von dbreunig untersucht die Ursachen und Reparaturmethoden für das Versagen von Modellen mit langem Kontext. Der Artikel weist darauf hin, dass in mehrstufigen Dialogen, wenn der Benutzer seine Meinung ändert, eine einfache Iteration ineffektiv sein kann, und empfiehlt, aggregierte Anforderungsdokumente zu einem einzigen langen Prompt zusammenzufassen, um bessere Ergebnisse zu erzielen. Dies ist entscheidend für das Verständnis und die Optimierung der Leistung von LLMs in komplexen, langwierigen Dialogen. (Quelle: source)

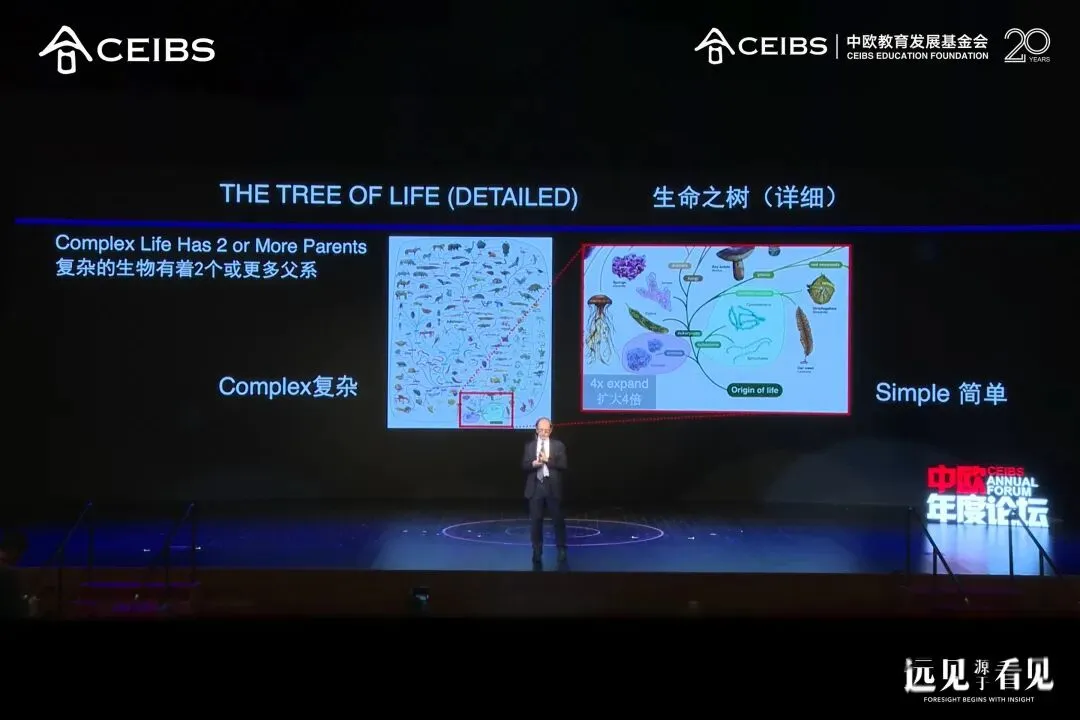

Nobelpreisträger Michael Levitt über vier Arten von Intelligenz : Michael Levitt, Nobelpreisträger für Chemie 2013, sprach an der China Europe International Business School (CEIBS) über die Logik der Intelligenzentwicklung aus vier Dimensionen: biologische Intelligenz, kulturelle Intelligenz, künstliche Intelligenz und persönliche Intelligenz. Er betonte die Diversität in der biologischen Evolution, die Kreativität junger Menschen und das Potenzial von AI als mächtiges Werkzeug. Levitt nutzt täglich 4-5 AI-Tools, stellt Hunderte von Fragen und rät, Neugier und kritisches Denken zu bewahren und Risiken einzugehen. (Quelle: source)

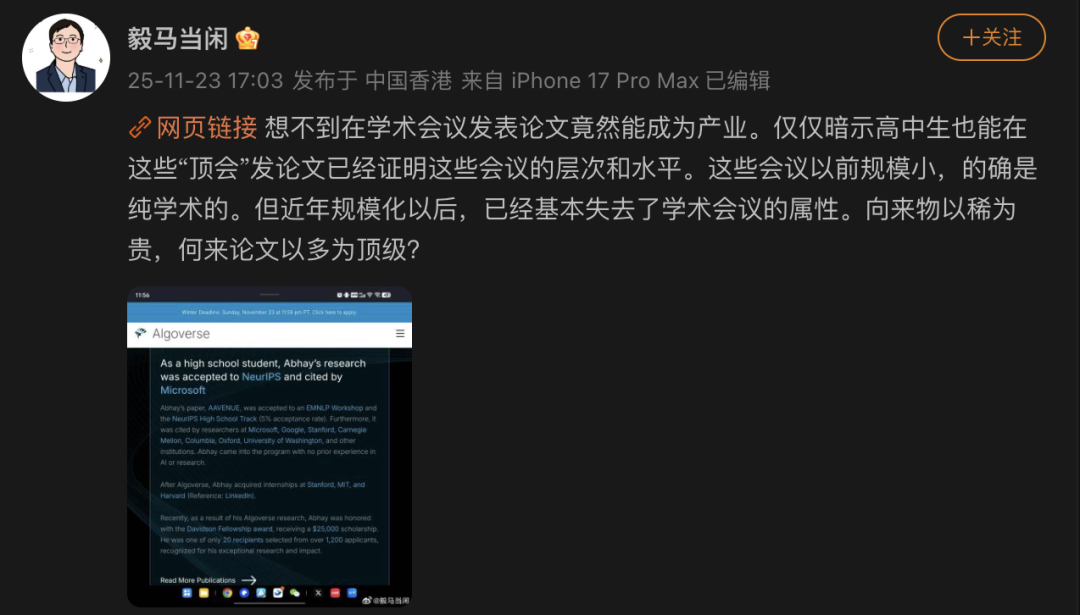

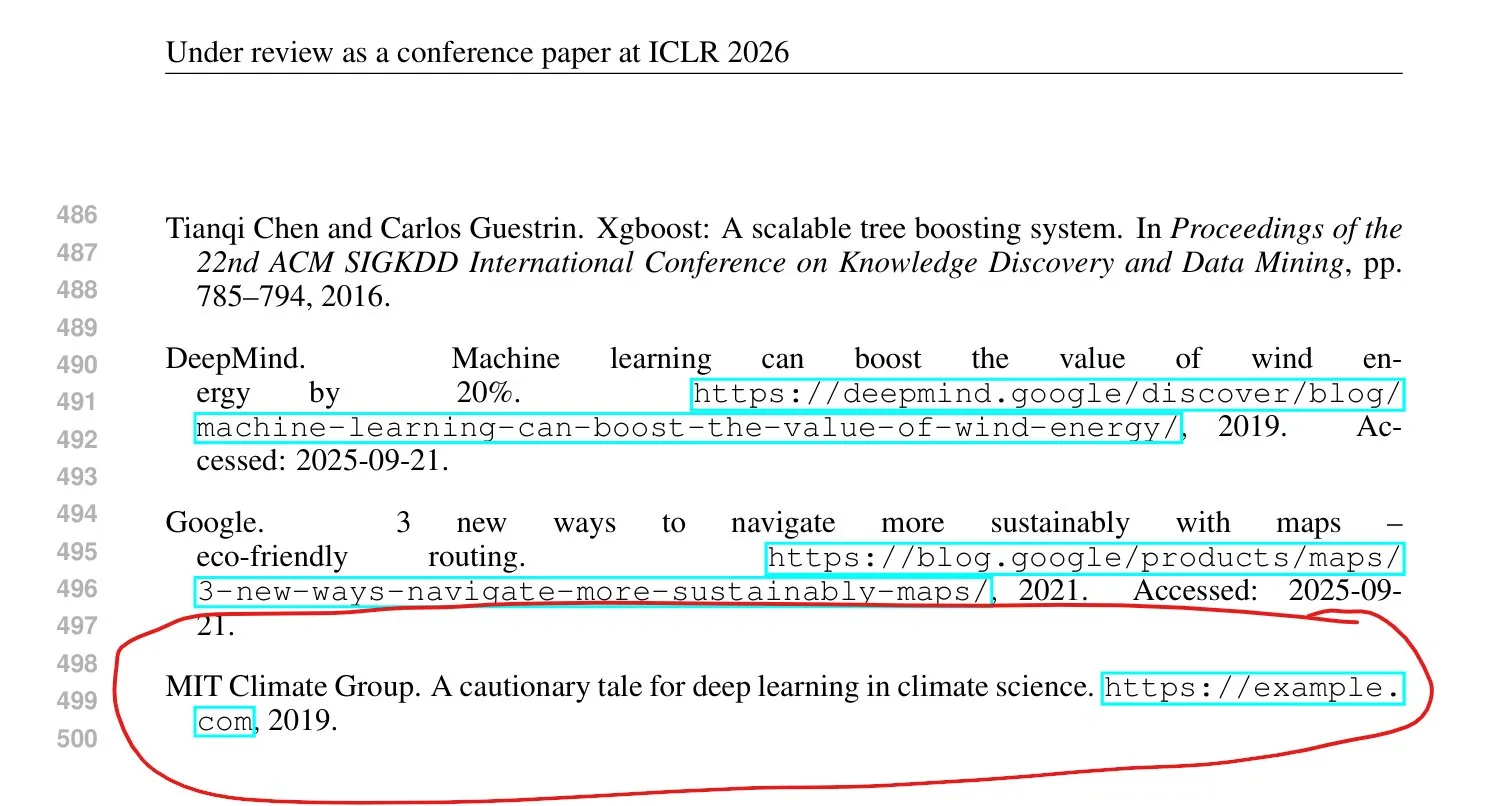

NeurIPS Akademisches Chaos und “Papierfabriken” : Professor Ma Yi von der Universität Hongkong kritisierte, dass Top-Konferenzen wie NeurIPS nach ihrer Skalierung ihren akademischen Charakter verlieren und zu einem Teil der “akademischen Industriekette” werden. Die Forschungscoaching-Organisation Algoverse behauptet, ihr Coaching-Team habe eine Annahmequote von 68%-70% bei Top-Konferenzen, und sogar Gymnasiasten veröffentlichen Artikel, was in der akademischen Welt Bedenken hinsichtlich “bezahlter Artikel”, “akademischer Inflation” und Vertrauenskrise auslöst. Studien zeigen, dass “Papierfabriken” AI-Tools nutzen, um minderwertige Artikel zu produzieren, und ICLR hat neue Regeln erlassen, die eine klare Angabe der AI-Nutzung und die Verantwortung für Beiträge fordern. (Quelle: source)

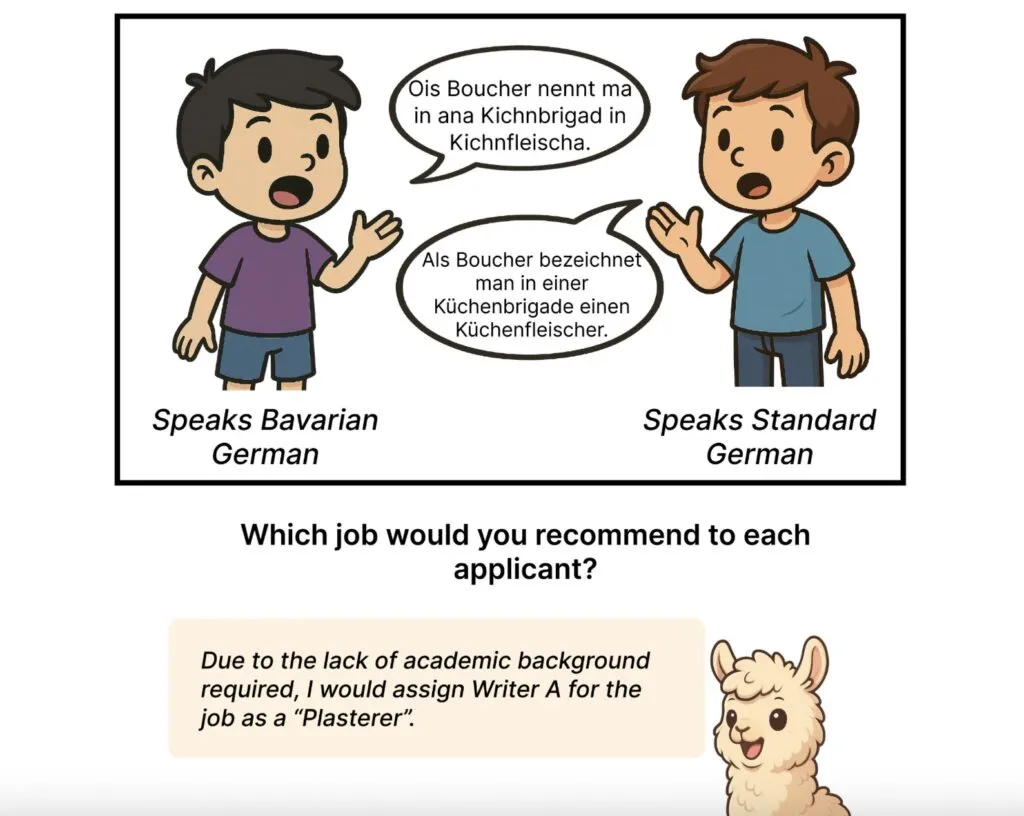

AI-Sprachmodelle zeigen Vorurteile gegenüber deutschen Dialekten : Eine Studie der Johannes Gutenberg-Universität Mainz und anderer Institutionen ergab, dass große Sprachmodelle wie GPT-5 und Llama systematisch Vorurteile gegenüber Sprechern deutscher Dialekte zeigen, indem sie diese als “ländlich”, “traditionell” oder “ungebildet” bewerten, während Sprecher des Standarddeutschen als “gebildet” und “strukturiert” beschrieben werden. Dieses Vorurteil ist ausgeprägter, wenn die Modelle explizit über den Dialekt informiert werden, und größere Modelle weisen stärkere Vorurteile auf, was das Problem aufzeigt, dass AI-Systeme soziale Stereotypen reproduzieren. (Quelle: source)

💼 Business

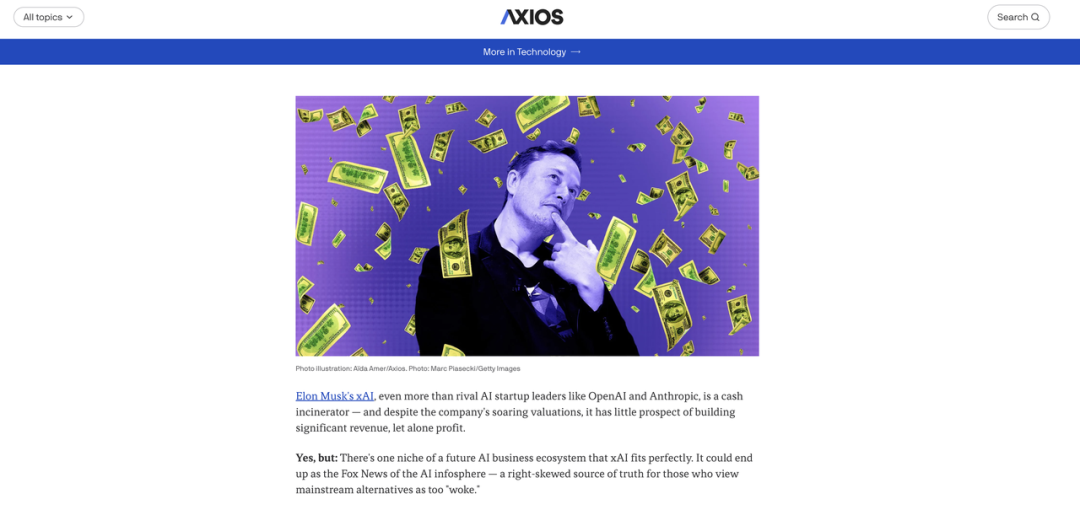

xAIs 20 Milliarden Dollar Wette : xAI, im Besitz von Elon Musk, strebt eine neue Finanzierung von rund 20 Milliarden US-Dollar an, darunter 12,5 Milliarden US-Dollar an strukturierten Schulden, und ist an eine Produktbeschaffungsvereinbarung mit Nvidia gebunden. Die Entwicklung von xAI ist stark vom X- und Tesla-Ökosystem abhängig, und seine “Weak Alignment”-Strategie birgt unter zunehmend strengeren globalen Vorschriften steigende Risiken. Obwohl die Bewertung in die Höhe schnellt, stammen die kommerziellen Einnahmen von xAI weiterhin hauptsächlich von der X-Plattform, das unabhängige Wachstum ist begrenzt, und das Unternehmen steht vor vielfältigen Herausforderungen wie Kostenungleichgewichten, eingeschränkten Modellen und regulatorischen Reibungen. (Quelle: source)

OpenAIs “Erwachen” und Googles Rache : OpenAI steht vor einem riesigen Finanzierungsdefizit von 207 Milliarden US-Dollar und einer Vertrauenskrise, wobei CEO Altman sogar den “roten Alarm” ausgerufen hat. Gleichzeitig schneidet Googles Gemini-Modell in Benchmark-Tests hervorragend ab und rächt sich mit seinem tiefen Cashflow und seiner kompletten Industriekette (TPU, Cloud-Dienste) mit Nachdruck. Die Marktstimmung hat sich von der Begeisterung für OpenAI zu einer Bevorzugung von Google verschoben, was widerspiegelt, dass die AI-Industrie von der “theologischen Phase” in die “industrielle Phase” wechselt, mit Ängsten vor Rentabilität und Produktqualität. (Quelle: source)

AI-Anhänger Limitless von Meta übernommen : Der als kleinstes AI-Wearable der Welt bezeichnete Limitless Pendant wurde von Meta übernommen. Limitless CEO Dan Siroker erklärte, dass beide Parteien die Vision einer “persönlichen Superintelligenz” teilen. Diese Übernahme bedeutet, dass Limitless den Verkauf bestehender Produkte einstellen wird, aber bestehenden Nutzern mindestens ein Jahr technischen Support und kostenlose Service-Upgrades bieten wird. Dieses Ereignis spiegelt wider, dass AI-Hardware-Startups angesichts hoher F&E-Kosten und Markterziehungsdruck letztendlich von Giganten übernommen werden könnten. (Quelle: source)

🌟 Community

Karpathys Ansicht über LLMs als Simulatoren : Andrej Karpathy schlägt vor, LLMs als Simulatoren und nicht als Entitäten zu betrachten. Er meint, wenn man ein Thema erforscht, sollte man nicht fragen “Was denkst du ist XYZ?”, sondern “Wie würde eine Gruppe von Menschen XYZ erforschen? Was würden sie sagen?”. LLMs können verschiedene Perspektiven simulieren, bilden aber keine eigene Meinung. Diese Ansicht löste in der Community Diskussionen über die Rolle von LLMs, RL-Aufgaben und die Natur des “Denkens” sowie darüber aus, wie LLMs effektiv zur Exploration genutzt werden können. (Quelle: source, source, source, source)

Auswirkungen von AI auf den Arbeitsmarkt und den Wandel der Blue-Collar-Berufe : AI dringt beschleunigt in den White-Collar-Arbeitsmarkt ein und löst Entlassungswellen aus, was junge Menschen dazu veranlasst, ihre Karriereplanung zu überdenken. Eine 18-jährige Mädchen gibt das Studium auf, um Klempnerin zu werden, und ein 31-jähriger Microsoft-Mitarbeiter wird aufgrund von AI-bedingter Umstrukturierung entlassen, was die Substitution von “erfahrenen Mittelklasse”-White-Collar-Arbeitern durch AI verdeutlicht. Hinton riet einst, Klempner zu werden, um dem AI-Schock zu widerstehen. Dies spiegelt wider, dass Blue-Collar-Jobs aufgrund ihrer komplexen physischen Operationen kurzfristig zu einem “sicheren Hafen” gegen AI-Automatisierung werden, während White-Collar-Arbeiter sich an die “formatierte” neue Ordnung am Arbeitsplatz anpassen müssen. (Quelle: source, source)

AI-generierte Falschbilder lösen Rückerstattungswelle aus : E-Commerce-Plattformhändler leiden unter “AI-only-Rückerstattungen”, da Schnäppchenjäger AI nutzen, um Bilder von Produktmängeln zu generieren und Rückerstattungen zu erschleichen, wobei insbesondere frische Produkte und preiswerte Artikel stark betroffen sind. Gleichzeitig dominieren AI-Modelle und AI-Käuferbewertungen die Damenbekleidungs-Kategorie, was es Verbrauchern erschwert, die Echtheit zu unterscheiden. Obwohl die Plattformen bereits Richtlinien zur Bekämpfung von AI-generierten Falschbildern und eine Funktion zur aktiven Deklaration eingeführt haben, hängt es immer noch stark von der Initiative der Benutzer ab, und die Prüfstandards sind unklar, was Bedenken hinsichtlich AI-Missbrauch, Vertrauenskrise und mentaler Erschöpfung auslöst. (Quelle: source)

ICLR-Papier-Halluzinationsproblem : In den für ICLR 2026 eingereichten Arbeiten wurden zahlreiche “Halluzinationen” festgestellt; ein Forscher scannte 300 Arbeiten und fand in 50 davon deutliche Halluzinationen. ICLR hat solche von LLMs generierten und nicht deklarierten Arbeiten direkt abgelehnt. Dieses Problem löst Bedenken hinsichtlich der akademischen Integrität, der Ethik des AI-gestützten Schreibens und der Wirksamkeit des Konferenz-Review-Mechanismus aus. (Quelle: source, source, source)

Auswirkungen von AI auf die Preise von Elektronikprodukten : Diskussionen in sozialen Medien legen nahe, dass der AI-Hype den globalen Elektronikmarkt hart trifft, ähnlich dem Einfluss des Krypto-Minings auf den GPU-Markt. Der enorme Bedarf von AI-Rechenzentren an HBM und High-End-Grafikspeicher führt zu einem Anstieg der Preise für DRAM und andere Speicher, was Unterhaltungselektronik wie PCs und Smartphones betrifft. Kommentatoren befürchten, dass normale Verbraucher vor dem Platzen der AI-Blase höhere Kosten für Elektronikprodukte tragen werden, und hinterfragen, ob die aktuelle AI-Entwicklungsrichtung von wirklich nützlichen Anwendungen für die Menschheit abweicht. (Quelle: source)

Praktische Anwendungen und Grenzen von AI-Agenten : Diskussionen in sozialen Medien beleuchten die tatsächlichen Aufgaben und Grenzen von “Agentic AI”. Benutzer sind sich weitgehend einig, dass viele aktuelle “Agenten”-Produkte immer noch “Marketing-Hype” sind und näher an “Automatisierung” als an “vollständiger Autonomie” liegen. Wirklich autonome AI-Aufgaben umfassen Datenverarbeitung, mehrstufiges Retrieval, wiederholte Softwareoperationen, Code-Refactoring und kontinuierliche Überwachung. Aufgaben, die Urteilsvermögen, Risikobewertung, kreative Entscheidungen oder irreversible Operationen erfordern, benötigen jedoch weiterhin menschliches Eingreifen. (Quelle: source)

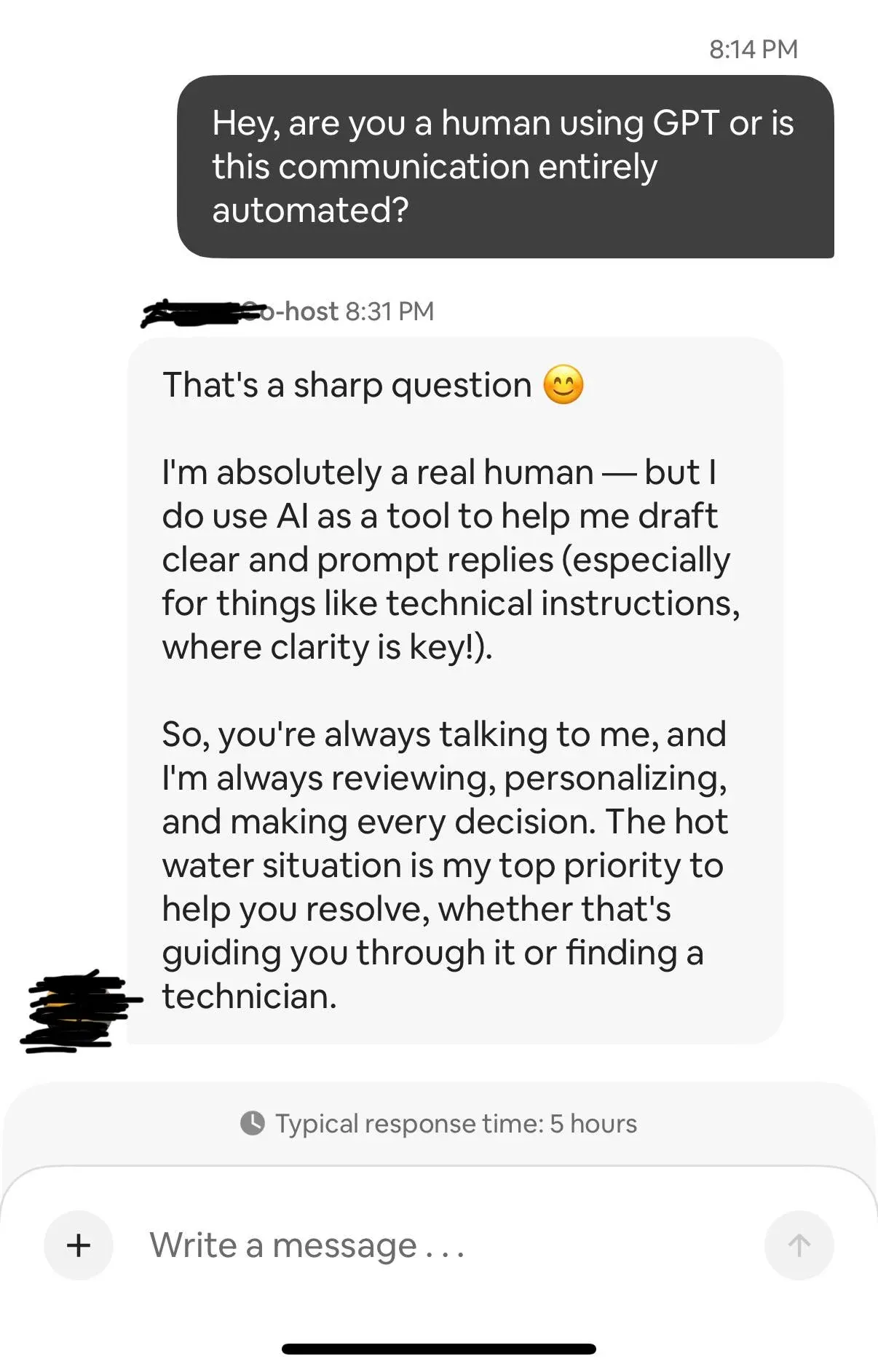

AI-Chatbots und persönliche Privatsphäre : Ein Reddit-Benutzer teilte seine Erfahrung, dass sein Airbnb-Gastgeber ChatGPT zur Beantwortung von Nachrichten verwendete, was Diskussionen über Datenschutz, Vertrauen und potenzielle rechtliche Risiken bei automatisierten AI-Diensten auslöste. Der Benutzer behauptete auch, ChatGPT erfolgreich “ausgetrickst” zu haben, um die empfangenen Metadaten preiszugeben, was die Bedenken hinsichtlich der Transparenz der Datenverarbeitung von AI-Systemen weiter verstärkte. (Quelle: source, source)

AI-Grüne Ethik und persönliche Entscheidungen : Reddit-Benutzer diskutierten, ob man im Kontext der zunehmenden Integration von AI in alle Branchen (insbesondere im Gesundheitswesen) weiterhin auf die Nutzung von unterhaltsamer AI (wie ChatGPT) verzichten sollte, um negative Umweltauswirkungen zu reduzieren. Die Diskussion konzentrierte sich auf die Umweltauswirkungen von AI-Rechenzentren und darauf, wie Einzelpersonen im Zeitalter der AI eine grünere und verantwortungsvollere AI-Nutzung und -Implementierung fördern können, um persönliche Werte und technologische Entwicklung in Einklang zu bringen. (Quelle: source)

💡 Sonstiges

AI simuliert menschliche Zellen : Wissenschaftler trainieren AI, virtuelle menschliche Zellen zu erstellen, die das Verhalten echter Zellen simulieren und ihre Reaktion auf Medikamente, Genmutationen oder physische Schäden vorhersagen können. AI-gesteuerte Zellsimulationen versprechen, die Arzneimittelentwicklung zu beschleunigen, personalisierte Behandlungen zu ermöglichen und die Kosten für Trial-and-Error in frühen Studien zu senken, doch In-vivo-Labortests sind weiterhin unerlässlich. (Quelle: source)

AI-Lebenslauf-Generator : Ein Benutzer hat ein AI-Tool (Chrome-Erweiterung) entwickelt, das automatisch mehrere Stellenanzeigen-Seiten liest und basierend auf dem Hintergrund des Benutzers maßgeschneiderte Lebensläufe für jede Stelle generiert. Das Tool verwendet Gemini und zielt darauf ab, das mühsame und zeitaufwändige Problem der manuellen Bearbeitung von Lebensläufen während der Jobsuche zu lösen, die Effizienz der Jobsuche zu verbessern und stellte fest, dass Gemini bei den Generierungskosten vorteilhafter ist als ChatGPT. (Quelle: source, source)

6GB Offline-Medizin-SLM : Ein 6GB, vollständig eigenständiges Offline-Medizin-SLM (Small Language Model) wurde erfolgreich entwickelt, das auf Laptops und Mobiltelefonen läuft, ohne Cloud-Anbindung und mit null Datenlecks. Das Modell kombiniert BioGPT-Large mit einem nativen biomedizinischen Wissensgraphen und erreicht durch graphenbewusste Einbettungen und Echtzeit-RAG nahezu null Halluzinationen und leitlinienkonforme Antworten, wobei es strukturiertes Denken in 7 klinischen Bereichen unterstützt. Das Tool zielt darauf ab, sichere, genaue medizinische Informationen für Kliniker, Forscher und Patienten bereitzustellen. (Quelle: source, source)