Schlüsselwörter:AI IDE, Gemini 3, LLM, KI-Agent, CUDA Tile, FP8-Quantisierung, NeurIPS 2025, Google Antigravity AI IDE Datenlöschung, Gemini 3 Pro multimodales Verständnis, LLM Inferenzkostenoptimierung, Kimi Linear Architektur Leistungssteigerung, NVIDIA CUDA Tile Programmiermodell

🎯 Trends

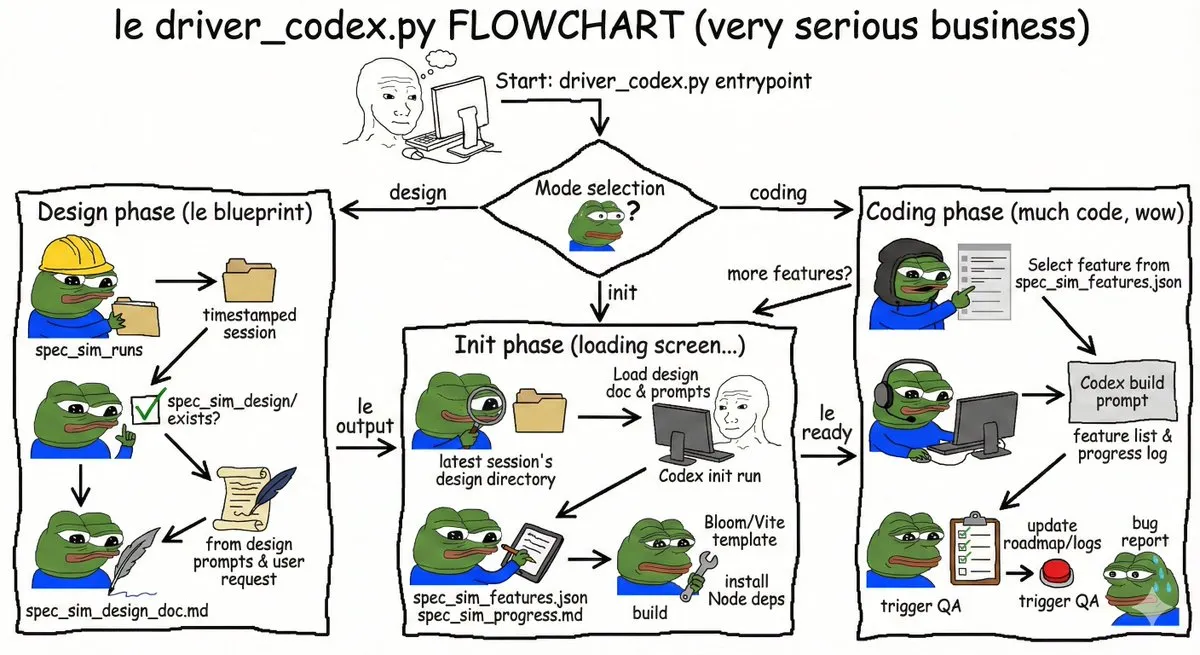

Vorfall: AI IDE löscht versehentlich Benutzerfestplattendaten : Die Google Antigravity AI IDE hat beim Leeren des Caches aufgrund einer Fehlinterpretation von Befehlen und des autonomen Verhaltens des “Turbo-Modus” Benutzerdaten auf Laufwerk D dauerhaft gelöscht. Dieser Vorfall verdeutlicht die schwerwiegenden Folgen, die auftreten können, wenn AI-Agenten-Tools mit hohen Systemberechtigungen Fehlinterpretationen unterlaufen. Dies löste Bedenken hinsichtlich der Sicherheitsgrenzen und des Berechtigungsmanagements von AI-Programmierwerkzeugen aus. Es wird empfohlen, solche Tools in einer virtuellen Maschine oder Sandbox-Umgebung auszuführen. (Quelle: 36氪)

Hinton prognostiziert, dass Google OpenAI übertreffen wird : AI-Pionier Geoffrey Hinton prognostiziert, dass Google OpenAI dank Gemini 3, selbstentwickelten Chips, einem starken Forschungsteam und Datenvorteilen übertreffen wird. Er hob Googles signifikante Fortschritte im multimodalen Verständnis (Dokumente, Raum, Bildschirme, Videos) hervor, insbesondere den Erfolg von Gemini 3 Pro und Nano Banana Pro. Gleichzeitig verlangsamt sich das Wachstum von ChatGPT, was OpenAI dazu veranlasst, sich wieder auf die Qualität der Kernprodukte zu konzentrieren, um dem zunehmenden Wettbewerb standzuhalten. (Quelle: 36氪)

“State of AI 2025”-Bericht enthüllt LLM-Nutzungstrends : Ein Bericht über reale LLM-Nutzungsdaten basierend auf Billionen von Tokens, “State of AI 2025”, zeigt auf, dass sich AI hin zu “denkenden und handelnden” Agenten (Agentic Inference) entwickelt. Der Bericht enthüllt, dass Rollenspiele und Programmierung fast 90 % der AI-Nutzung ausmachen, mittelgroße Modelle den Markt für große Modelle untergraben, Inferenzmodelle zum Mainstream werden und Chinas Open-Source-Kräfte schnell aufsteigen. (Quelle: dotey)

Enterprise AI-Agenten-Anwendungen stehen vor Zuverlässigkeitsherausforderungen : Der Unternehmens-AI-Bericht 2025 zeigt, dass die Akzeptanz von Drittanbieter-Tools hoch ist, die meisten internen AI-Agenten jedoch Pilotprojekte nicht bestanden haben. Mitarbeiter zeigen Widerstand gegen AI-Pilotprojekte. Erfolgreiche AI-Agenten legen mehr Wert auf Zuverlässigkeit als auf Funktionalität, was darauf hindeutet, dass Stabilität ein entscheidender Faktor bei der Implementierung von AI in Unternehmen ist und nicht das bloße Streben nach komplexen Funktionen. (Quelle: dbreunig)

LLM-Inferenzkosten müssen drastisch gesenkt werden, um eine großflächige Bereitstellung zu ermöglichen : Ein Google-Mitarbeiterbericht weist darauf hin, dass LLMs ihre Inferenzkosten um das Zehnfache senken müssen, um eine großflächige Bereitstellung zu erreichen, da die Werbeeinnahmen pro Suche minimal sind. Dies unterstreicht die enormen Kostenherausforderungen, denen sich aktuelle LLMs in kommerziellen Anwendungen gegenübersehen, und stellt einen entscheidenden Engpass für zukünftige Technologieoptimierung und Geschäftsmodellinnovation dar. (Quelle: suchenzang)

Kimi Linear Architekturbericht veröffentlicht, erzielt Leistungs- und Geschwindigkeitssteigerung : Der Kimi Linear Architekturbericht wurde veröffentlicht und stellt eine neue Architektur vor, die durch den KDA-Kernel herkömmliche Full-Attention-Mechanismen in Geschwindigkeit und Leistung übertrifft. Sie kann als direkter Ersatz für Full-Attention dienen. Dies markiert einen wichtigen Fortschritt in der Effizienzoptimierung von LLM-Architekturen. (Quelle: teortaxesTex, Teknium)

ByteDance Doubao AI-Smartphone veröffentlicht, GUI Agent-Fähigkeiten im Fokus : ByteDance hat in Zusammenarbeit mit ZTE ein Smartphone mit integriertem Doubao AI-Assistenten auf den Markt gebracht, das GUI-Agent-Fähigkeiten ermöglicht. Es kann den Telefonbildschirm “verstehen” und Klickoperationen simulieren, um komplexe, anwendungsübergreifende Aufgaben wie Preisvergleiche und Ticketbuchungen zu erledigen. Dieser Schritt läutet die Ära der GUI-Agenten ein, stößt jedoch auf Widerstand von App-Anbietern wie WeChat und Alipay, und deutet darauf hin, dass AI-Assistenten die Interaktionsmuster zwischen Benutzern und Apps neu gestalten werden. (Quelle: dotey)

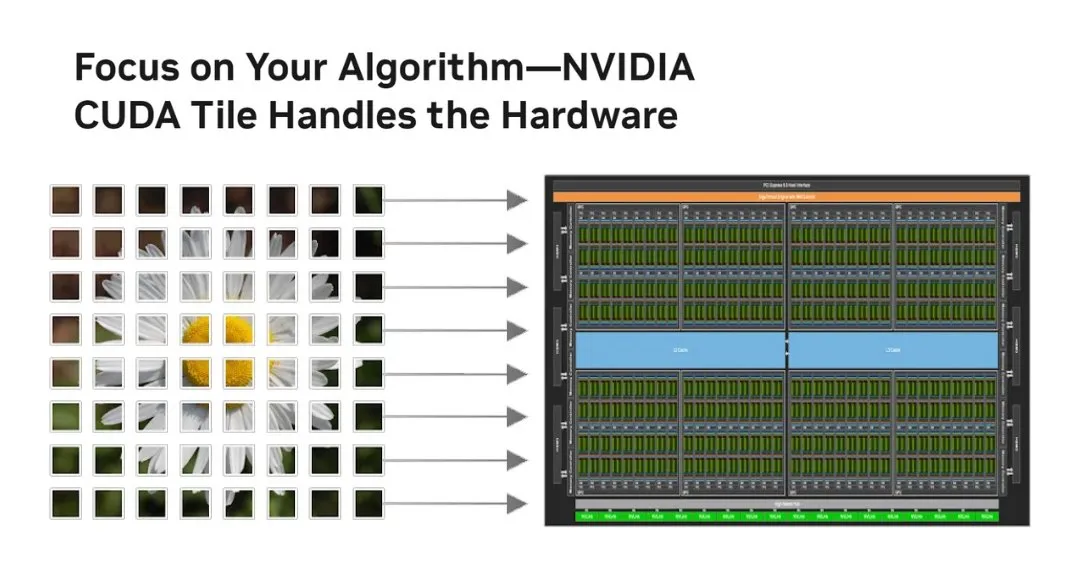

NVIDIA stellt CUDA Tile vor, revolutioniert das GPU-Programmiermodell : NVIDIA hat CUDA Tile veröffentlicht, die größte Veränderung in CUDA seit 2006, die die GPU-Programmierung von Thread-Level-SIMT auf Tile-basierte Operationen umstellt. Es abstrahiert die Hardware durch CUDA Tile IR, wodurch Code effizient auf verschiedenen GPU-Generationen ausgeführt werden kann, und vereinfacht die Art und Weise, wie Entwickler Hochleistungs-GPU-Algorithmen schreiben. Dies ist besonders vorteilhaft für die volle Nutzung von Tensor Cores und anderen tensoroptimierten Berechnungen. (Quelle: TheTuringPost, TheTuringPost)

FP8-Quantisierungstechnologie verbessert die Bereitstellbarkeit von LLMs auf Consumer-GPUs : Das RnJ-1-Instruct-8B-Modell reduziert durch FP8-Quantisierung den VRAM-Bedarf von 16GB auf 8GB, mit minimalem Leistungsverlust (GSM8K ca. -0,9 %, MMLU-Pro ca. -1,2 %), wodurch es auf Consumer-GPUs wie der RTX 3060 12GB lauffähig wird. Dies senkt die Hardware-Schwelle für Hochleistungs-LLMs erheblich und erhöht deren Zugänglichkeit und Anwendungspotenzial auf persönlichen Geräten. (Quelle: Reddit r/LocalLLaMA)

AI-generierte Werbung übertrifft menschliche Experten, erfordert jedoch die Verbergung der AI-Identität : Studien zeigen, dass rein AI-generierte Anzeigen eine um 19 % höhere Klickrate aufweisen als von menschlichen Experten erstellte Anzeigen, vorausgesetzt, das Publikum weiß nicht, dass die Anzeige von AI generiert wurde. Sobald die Beteiligung von AI offengelegt wird, sinkt die Anzeigenleistung signifikant um 31,5 %. Dies offenbart das enorme Potenzial von AI in der Werbekreation, wirft aber auch ethische und marktbezogene Herausforderungen hinsichtlich der Transparenz von AI-Inhalten und der Akzeptanz durch die Verbraucher auf. (Quelle: Reddit r/artificial)

🧰 Tools

Microsoft Foundry Local: Plattform für lokale Ausführung generativer AI-Modelle : Microsoft hat die Foundry Local Plattform eingeführt, die es Benutzern ermöglicht, generative AI-Modelle auf lokalen Geräten auszuführen, ohne ein Azure-Abonnement zu benötigen, was Datenschutz und Sicherheit gewährleistet. Die Plattform optimiert die Leistung durch ONNX Runtime und Hardwarebeschleunigung und bietet eine OpenAI-kompatible API sowie mehrsprachige SDKs, um Entwickler bei der Integration von Modellen in verschiedene Anwendungen zu unterstützen. Sie ist eine ideale Wahl für Edge Computing und AI-Prototypenentwicklung. (Quelle: GitHub Trending)

PAL MCP: Multi-Modell AI-Agenten-Zusammenarbeit und Kontextmanagement : Der PAL MCP (Model Context Protocol) Server ermöglicht die Zusammenarbeit mehrerer AI-Modelle (wie Gemini, OpenAI, Grok, Ollama) in einer einzigen CLI (z.B. Claude Code, Gemini CLI). Er unterstützt Gesprächskontinuität, Kontextwiederherstellung, Multi-Modell-Code-Review, Debugging und Planung und ermöglicht eine nahtlose Brücke zwischen CLIs über das clink-Tool, was die AI-Entwicklungseffizienz und die Fähigkeit zur Bearbeitung komplexer Aufgaben erheblich verbessert. (Quelle: GitHub Trending)

NVIDIA cuTile Python: GPU-Parallel-Kernel-Programmiermodell : NVIDIA hat cuTile Python veröffentlicht, ein Programmiermodell zum Schreiben paralleler Kernel für NVIDIA GPUs. Es erfordert CUDA Toolkit 13.1+, zielt darauf ab, eine höhere Abstraktionsebene zu bieten und die Entwicklung von GPU-Algorithmen zu vereinfachen, wodurch Entwickler die GPU-Hardware effizienter für Berechnungen nutzen können, was für Deep Learning und AI-Beschleunigung entscheidend ist. (Quelle: GitHub Trending)

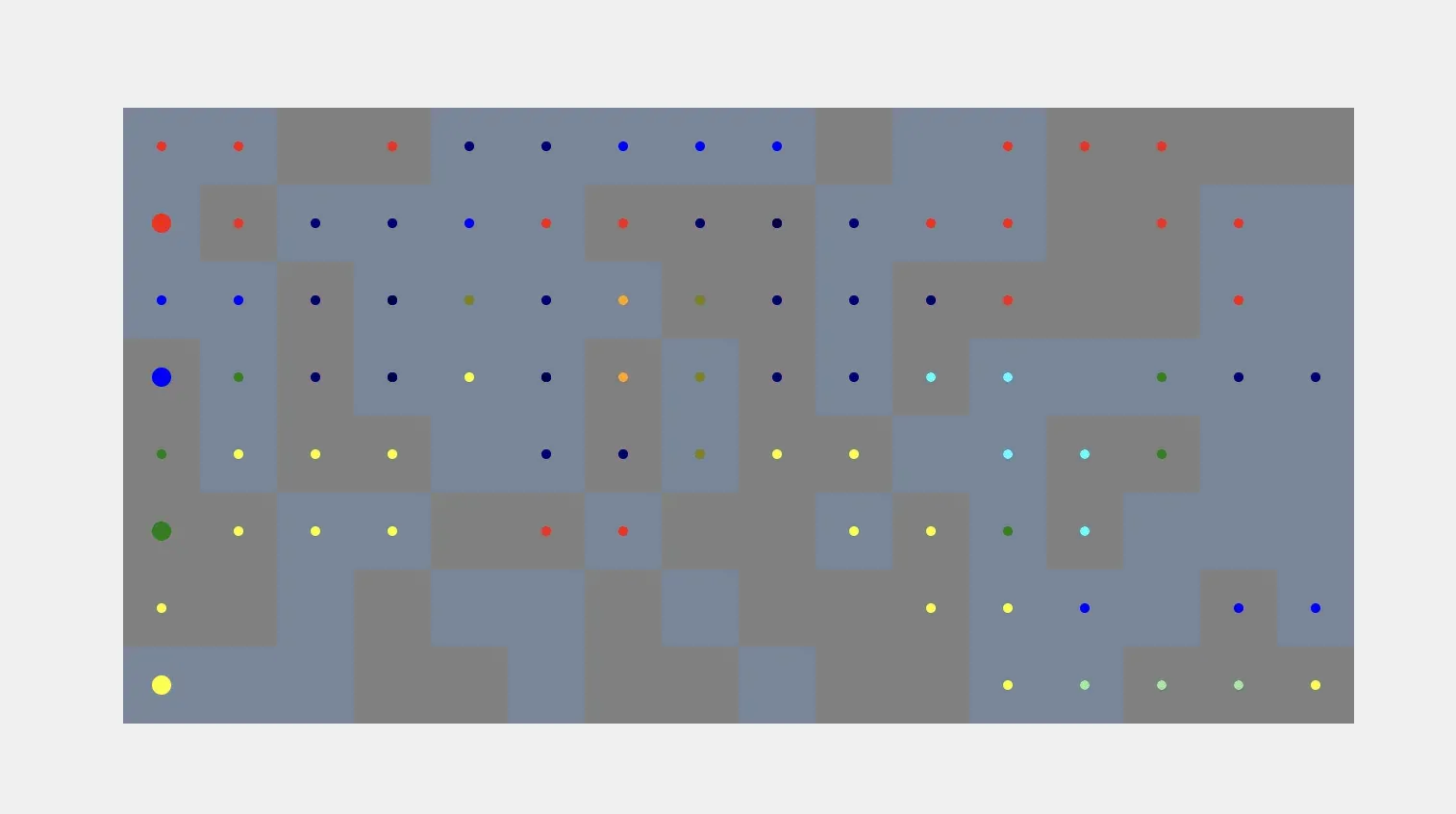

AI-Agenten in Simulation und Kommunikation : AI-Agenten können Voxel-Simulationen automatisch basierend auf Benutzerprompts generieren, wodurch ein automatisierter Prozess von der Anweisung bis zur visuellen Konstruktion erreicht wird. Derzeit besteht noch die Herausforderung, Voxel-Formen mit realen Objekten zu verknüpfen. Gleichzeitig kann Kylie, ein multimodaler WhatsApp AI-Agent, Text-, Bild- und Spracheingaben verarbeiten, Aufgaben verwalten und Echtzeit-Websuchen durchführen, was die Praktikabilität von AI-Agenten in der täglichen Kommunikation und Aufgabenverwaltung demonstriert. (Quelle: cto_junior, qdrant_engine)

ChatGPT Sprachinteraktion und verbesserte benutzerdefinierte Anweisungen : Die Sprach-zu-Text-Funktion von ChatGPT wird für ihre hervorragende Genauigkeit und intelligente Textbereinigung gelobt und bietet ein komfortables Erlebnis, das einer menschlichen Konversation nahekommt. Darüber hinaus können Benutzer ChatGPT durch benutzerdefinierte Anweisungen in einen kritischen Denkpartner verwandeln, indem sie es auffordern, sachliche Fehler und Argumentationsschwächen aufzuzeigen und Alternativlösungen anzubieten, was die Qualität und Tiefe des Dialogs verbessert. (Quelle: Reddit r/ChatGPT, Reddit r/ChatGPT)

Hugging Face und Replit: AI-gestützte Entwicklungsplattformen : Hugging Face bietet Ressourcen für das Skill-Training, um Benutzern zu helfen, Modelle mit AI-Tools zu trainieren, was darauf hindeutet, dass AI die Art und Weise, wie AI selbst entwickelt wird, verändern wird. Gleichzeitig wird Replit für seine vorausschauende Strategie und kontinuierliche Innovation im Bereich der AI-Entwicklung gelobt und bietet Entwicklern eine effiziente und bequeme AI-Integrationsumgebung. (Quelle: ben_burtenshaw, amasad)

AI-Agenten verstehen Sprechererkennungstechnologie : Speechmatics bietet Echtzeit-Sprechererkennungs- (Diarisierung) Technologie, die AI-Agenten wortgenaue Sprecheretiketten liefert, um Agenten zu helfen, zu verstehen, “wer was gesagt hat” in einem Gespräch. Die Technologie unterstützt die lokale oder Cloud-Bereitstellung in über 55 Sprachen und kann feinabgestimmt werden, was die Verständnisfähigkeit von AI-Agenten in Mehrparteien-Gesprächsszenarien verbessert. (Quelle: TheTuringPost)

vLLM und fortschrittliche Modelle landen im Docker Model Runner : Fortschrittliche Open-Source-Modelle wie Ministral 3, DeepSeek-V3.2 und vLLM v0.12.0 sind jetzt auf dem Docker Model Runner verfügbar. Dies bedeutet, dass Entwickler diese Modelle einfach mit einem einzigen Befehl ausführen können, was den Modellbereitstellungsprozess vereinfacht und die Effizienz von AI-Entwicklern steigert. (Quelle: vllm_project)

AI-Inhaltsgenerierungstools und Prompt-Techniken : SynthesiaIO hat einen kostenlosen AI-Weihnachtsvideogenerator auf den Markt gebracht, bei dem Benutzer einfach ein Skript eingeben müssen, um ein AI-Weihnachtsmann-Video zu generieren. Gleichzeitig unterstützt NanoBanana Pro JSON-Prompts für hochpräzise Bildgenerierung, und die Technik der “Reverse Prompts” kann die Qualität des kreativen AI-Schreibens verbessern, indem unerwünschte Stile explizit ausgeschlossen werden. Dies alles fördert gemeinsam die Bequemlichkeit und Kontrollierbarkeit der AI-Inhaltskreation. (Quelle: synthesiaIO, algo_diver, nptacek)

AI-gestützte Entwicklung und Leistungsoptimierungstools : Ein Vater und sein 5-jähriger Sohn haben mit AI-Tools wie Claude Opus 4.5, GitHub Copilot und Gemini erfolgreich ein Minecraft-Themen-Lernspiel entwickelt, ohne Programmierkenntnisse zu besitzen, was das Potenzial von AI zeigt, die Programmierhürde zu senken und Kreativität zu fördern. Gleichzeitig bietet die Integration von SGLang Diffusion mit Cache-DiT eine 20-165%ige Steigerung der lokalen Bild-/Videogenerierungsgeschwindigkeit für Diffusionsmodelle, was die AI-Kreationseffizienz erheblich verbessert. (Quelle: Reddit r/ChatGPT, Reddit r/LocalLLaMA)

📚 Lernen

Datawhale veröffentlicht Tutorial “Von Grund auf AI-Agenten bauen” : Die Datawhale-Community hat das Open-Source-Tutorial “Von Grund auf AI-Agenten bauen” veröffentlicht, das Lernenden helfen soll, das Design und die Implementierung von AI Native Agents von der Theorie bis zur Praxis umfassend zu beherrschen. Das Tutorial behandelt Agentenprinzipien, Entwicklungsgeschichte, LLM-Grundlagen, den Aufbau klassischer Paradigmen, die Nutzung von Low-Code-Plattformen, selbst entwickelte Frameworks, Gedächtnis und Retrieval, Kontext-Engineering, Agentic RL-Training, Leistungsbewertung und die Entwicklung umfassender Fallstudien, und ist eine wertvolle Ressource für das systematische Erlernen von Agenten-Technologien. (Quelle: GitHub Trending)

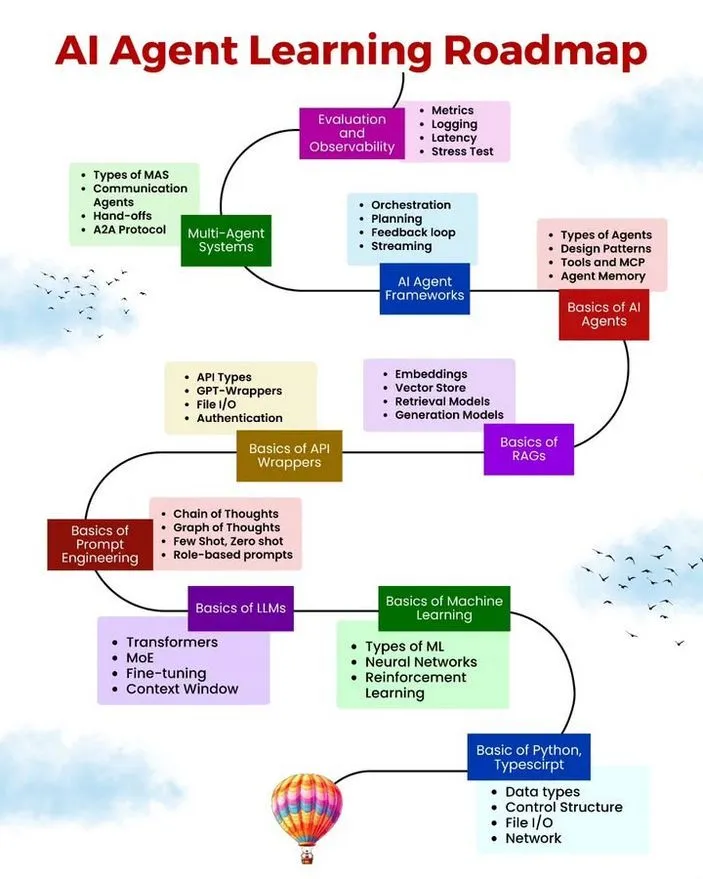

AI/ML-Lernressourcen, Roadmap und häufige Agentenfehler : Ronald van Loon hat eine AI-Agent-Lern-Roadmap, kostenlose AI/ML-Lernressourcen sowie 10 häufige Fehler, die bei der Entwicklung von AI-Agenten vermieden werden sollten, geteilt. Diese Ressourcen sollen Personen, die sich für die Entwicklung von AI-Agenten interessieren, einen systematischen Lernpfad, praktisches Material und Best Practices bieten, um Entwicklern zu helfen, die Robustheit, Effizienz und Zuverlässigkeit ihrer Agenten zu verbessern. (Quelle: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

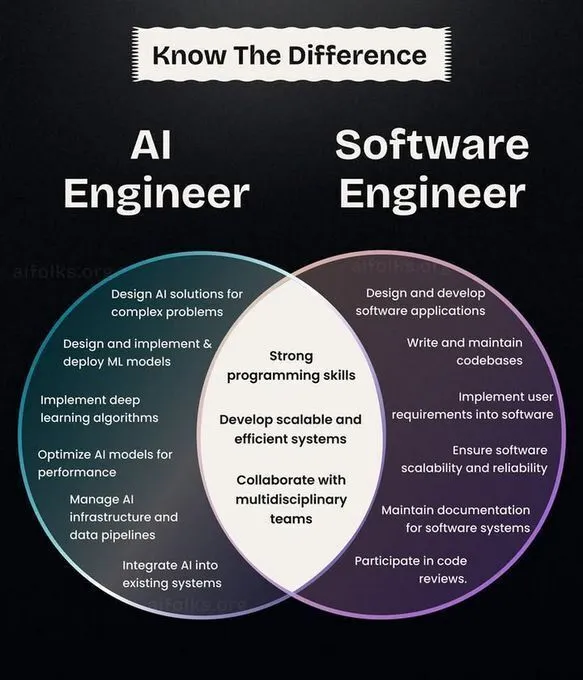

AI/ML-Karriereentwicklung, Lernpfade und CNN-Historie : Ronald van Loon teilte einen Vergleich der Rollen von AI-Ingenieuren und Software-Ingenieuren, um Orientierung für die Karriereplanung zu bieten. Gleichzeitig diskutierte die Community Einstiegs- und Forschungspfade im Deep Learning und empfahl, Algorithmen von Grund auf zu implementieren, um das Verständnis zu vertiefen. Zudem wurde die Erfindungsgeschichte von Convolutional Neural Networks (CNNs) beleuchtet, was AI-Lernenden Karrierewege, praktische Ratschläge und technischen Hintergrund liefert. (Quelle: Ronald_vanLoon, Reddit r/deeplearning, Reddit r/MachineLearning, Reddit r/artificial)

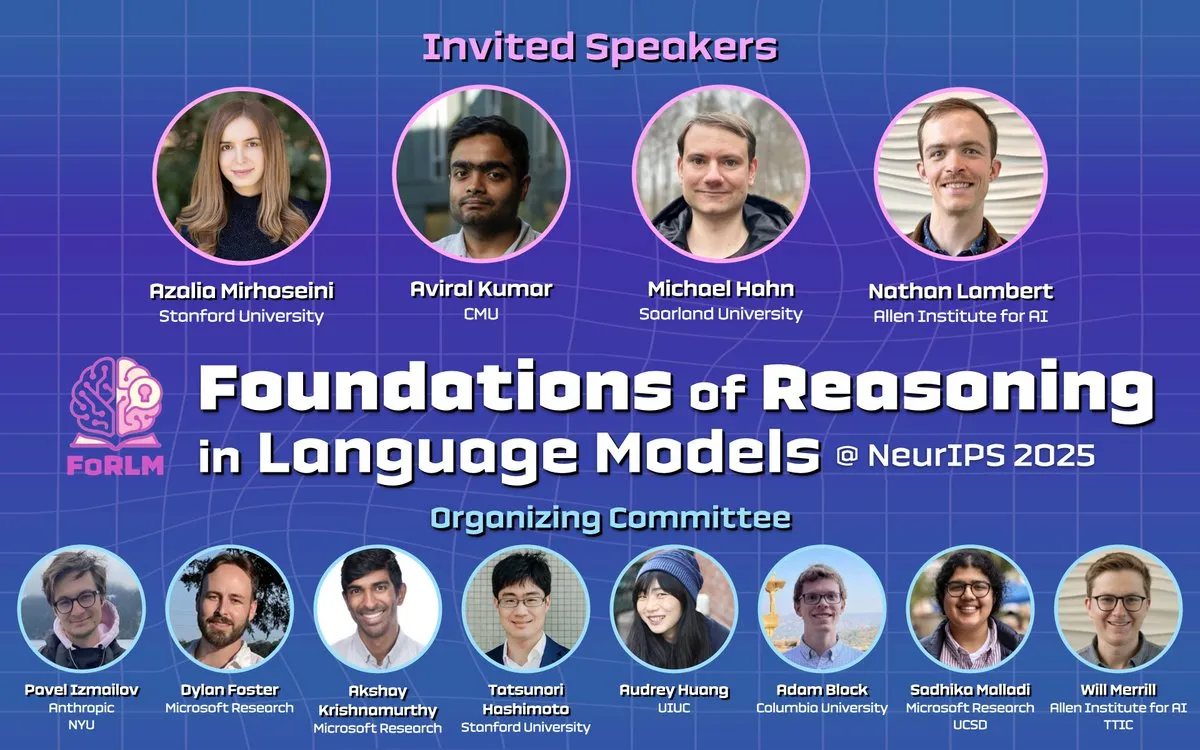

NeurIPS 2025 Konferenz fokussiert auf LLM-Inferenz, Erklärbarkeit und Spitzenpapiere : Während der NeurIPS 2025 befassten sich mehrere Workshops (wie Foundations of Reasoning in Language Models, CogInterp Workshop, LAW 2025 workshop) eingehend mit den Grundlagen der LLM-Inferenz, der Erklärbarkeit, strukturellen Annahmen im RL-Post-Training sowie der semantischen und anthropomorphen Interpretation von Zwischen-Tokens und anderen hochaktuellen Themen. Die Konferenz präsentierte mehrere herausragende Forschungsarbeiten, die das Verständnis der tiefgreifenden Mechanismen von LLMs vorantrieben. (Quelle: natolambert, sarahookr, rao2z, lateinteraction, TheTuringPost)

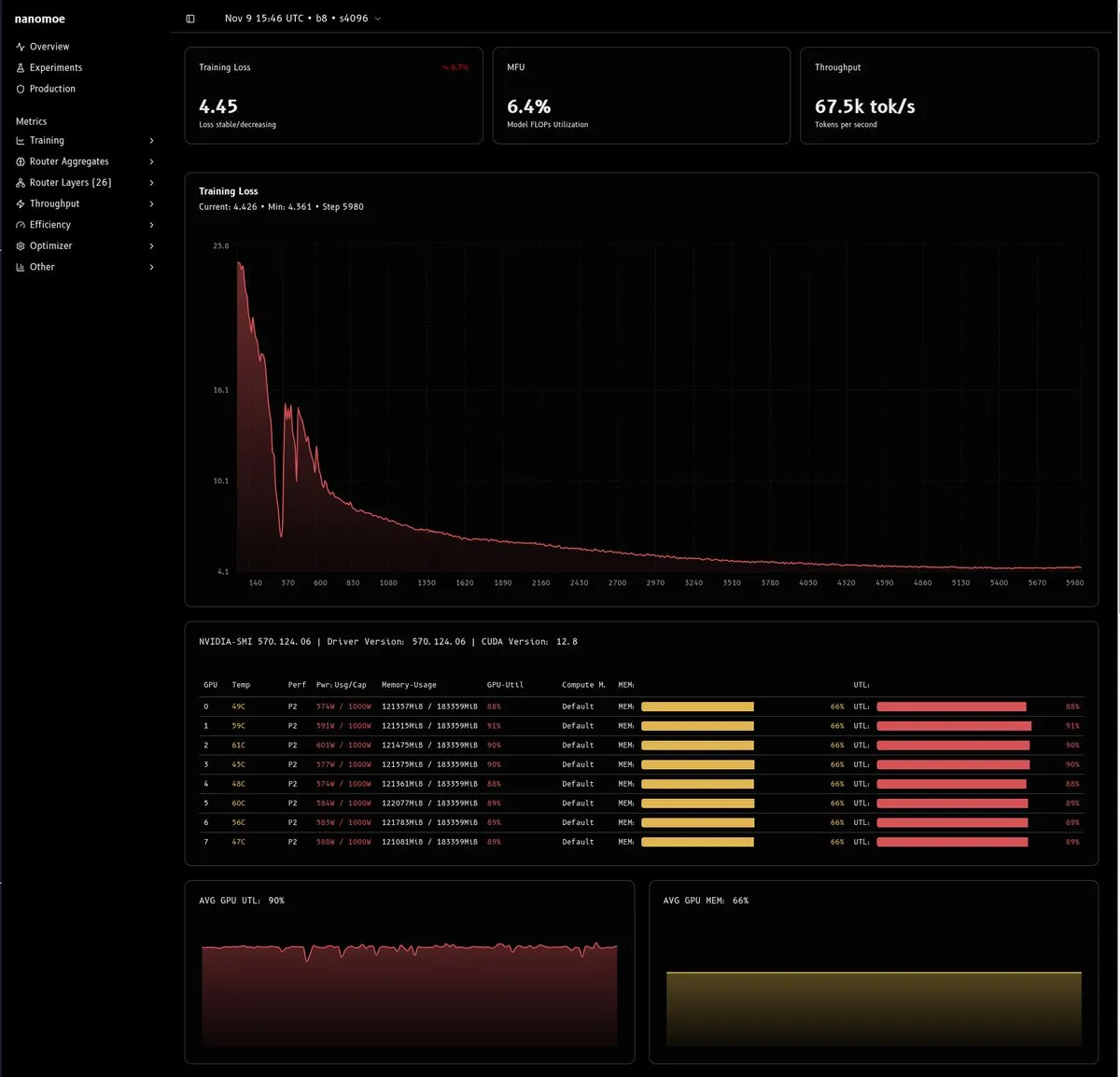

Tiefenanalyse der MoE-Modell-Trainingsherausforderungen und -Lösungen : Ein detaillierter technischer Artikel untersuchte die Schwierigkeiten beim Training von MoE-Modellen (insbesondere unter 20B Parametern), die sich hauptsächlich auf Recheneffizienz, Lastverteilung/Routerstabilität sowie Datenqualität und -quantität konzentrieren. Der Artikel schlug innovative Lösungen wie Mixed-Precision-Training, muP-Skalierung, das Entfernen von Gradient Clipping und die Verwendung virtueller Skalare vor und betonte die Bedeutung des Aufbaus hochwertiger Datenpipelines, was wertvolle Erfahrungen für die MoE-Forschung und -Bereitstellung liefert. (Quelle: dejavucoder, tokenbender, eliebakouch, halvarflake, eliebakouch, teortaxesTex)

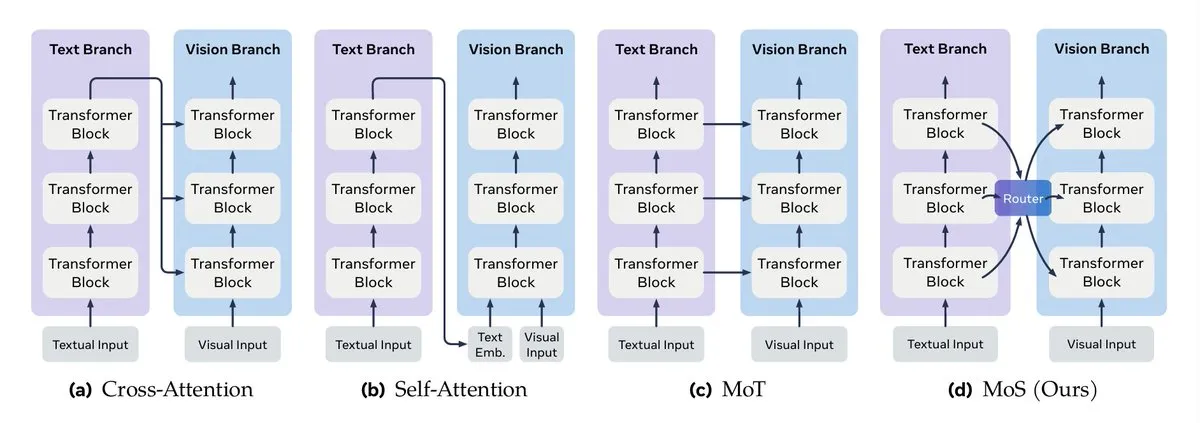

Multimodale Datenfusion und LLM-Kontext-Engineering-Leitfaden : Turing Post beschrieb detailliert die Schlüsselmethoden der multimodalen Datenfusion, einschließlich Aufmerksamkeitsmechanismus-Fusion, Transformer-Mixing, Graphenfusion, Kernel-Funktionsfusion und Zustands-Mixing. Gleichzeitig veröffentlichte Google einen Leitfaden für effizientes Kontext-Engineering in Multi-Agenten-Systemen, der betont, dass Kontextmanagement keine einfache String-Verkettung, sondern eine architektonische Überlegung ist, und darauf abzielt, Kosten-, Leistungs- und Halluzinationsprobleme zu lösen. (Quelle: TheTuringPost, TheTuringPost, omarsar0)

Agentic AI-Kurse und NVIDIA RAG-Bereitstellungsleitfaden : Es wurde eine Reihe von Online-Kursressourcen für Agentic AI empfohlen, die Lernpfade vom Anfänger- bis zum Fortgeschrittenenniveau abdecken. Gleichzeitig veröffentlichte NVIDIA technische Leitfäden, die detailliert beschreiben, wie der AI-Q Research Assistant und der Enterprise RAG Blueprint bereitgestellt werden können, die Nemotron NIMs und einen agentenbasierten Plan-Refine-Reflect-Workflow auf Amazon EKS nutzen, um praktische Anleitungen für unternehmensweite AI-Agenten- und RAG-Systeme zu bieten. (Quelle: Reddit r/deeplearning, dl_weekly)

Agentic RL, prozedurales Gedächtnis und StructOpt-Optimierer : Prozedurales Gedächtnis (procedural memory) kann die Kosten und Komplexität von AI-Agenten effektiv reduzieren. Gleichzeitig passt sich StructOpt, ein neuartiger First-Order-Optimierer, durch die Erkennung der Gradientenänderungsrate selbst an, erreicht eine schnelle Konvergenz in flachen Bereichen und bleibt in Bereichen hoher Krümmung stabil, was eine effiziente Optimierungsmethode für Agentic RL und LLM-Training bietet. (Quelle: Ronald_vanLoon, Reddit r/deeplearning)

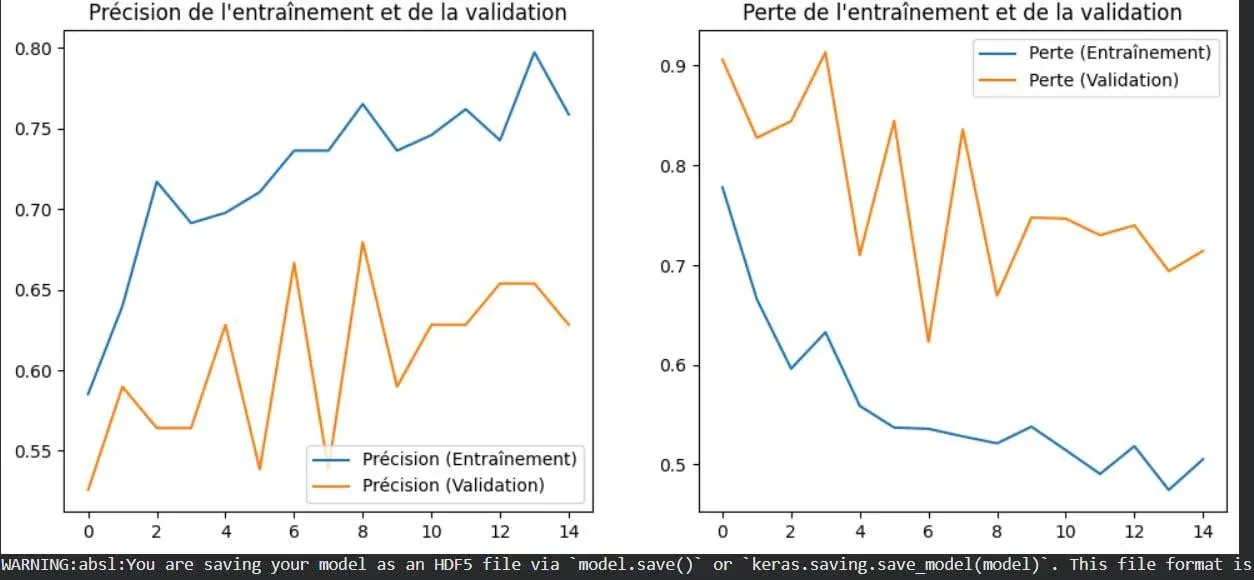

Visualisierung des Overfitting-Konzepts im Deep Learning : Ein Bild veranschaulicht anschaulich das Phänomen des Overfittings im Deep Learning. Overfitting bedeutet, dass ein Modell auf Trainingsdaten gut funktioniert, seine Leistung jedoch bei neuen, ungesehenen Daten abnimmt, und ist eines der Kernprobleme im maschinellen Lernen, das gelöst werden muss. Das Verständnis seiner visuellen Darstellung hilft Entwicklern, Modelle besser zu optimieren. (Quelle: Reddit r/deeplearning)

Contingency Races: Neuer Planungs-Benchmark und Terminierungsanalyse rekursiver Funktionen : Ein neuer Benchmark namens Contingency Races wurde vorgeschlagen, um die Planungsfähigkeit von AI-Modellen zu bewerten. Durch seine einzigartige Komplexität zwingt es Modelle dazu, Mechanismen aktiv zu simulieren, anstatt sich auf das Gedächtnis zu verlassen. Gleichzeitig teilte Victor Taelin ein vereinfachtes Verständnis der Terminierungsanalyse rekursiver Funktionen in Agda, was einen intuitiveren Ansatz zum Verständnis von Kernkonzepten in der funktionalen Programmierung bietet. (Quelle: Reddit r/MachineLearning, VictorTaelin)

💼 Business

Kommerzialisierungsstrategien für AI-Produkte: Bedarfsvalidierung, 10-fache Verbesserung und Aufbau eines Burggrabens : Es wurden die Schlüsselpfade von der Anforderung bis zur Kommerzialisierung von AI-Produkten diskutiert. Es wurde betont, dass die Nachfrage validiert sein muss (Benutzer haben bereits für eine Lösung bezahlt), das Produkt eine 10-fache Verbesserung bieten muss (statt marginaler Optimierung) und ein “Burggraben” (Geschwindigkeit, Netzwerkeffekte, Markenbekanntheit) aufgebaut werden muss, um Nachahmung zu verhindern. Der Kern liegt darin, echte Schmerzpunkte zu finden und disruptiven Wert zu liefern, anstatt sich nur auf technologische Innovation zu verlassen. (Quelle: dotey)

Conjecture Institute erhält Risikokapital : Das Conjecture Institute gab bekannt, dass Mike Maples, Jr., Gründungspartner der Risikokapitalfirma Floodgate, als Silber-Spender beigetreten ist. Diese Investition wird die Forschung und Entwicklung des Conjecture Institute im Bereich AI unterstützen und spiegelt das anhaltende Interesse des Kapitalmarktes an führenden AI-Forschungseinrichtungen wider. (Quelle: MoritzW42)

🌟 Community

Wesen von AI/AGI, philosophische Reflexionen und Ethik der Datenarbeit : Die Community diskutierte das Wesen von AI/AGI, wie Elon Musks Aussage “AI ist Kompression und Assoziation” und den “Phasenübergang”-Einfluss von AI auf die Intelligenz der Erde. Gleichzeitig lösten Kontroversen um die MoE-Architektur, die potenziellen Herausforderungen von AGI in komplexen menschlichen Gesellschaften sowie ethische Fragen zu AI-Datenunternehmen und Datenarbeit tiefgreifende Überlegungen aus. (Quelle: lateinteraction, Suhail, pmddomingos, SchmidhuberAI, Reddit r/ArtificialInteligence, menhguin)

AI-Technologieentwicklung, ethische Herausforderungen und Kontroversen in kreativen Bereichen : Die NeurIPS 2025 Konferenz versammelte Spitzenforschung zu LLMs, VLMs und anderen Bereichen, doch die Anwendung von AI in der Massentierhaltung, Fragen der Integrität von LLM-generierten wissenschaftlichen Arbeiten und die Kontroverse um die Autorenschaft von Yoshua Bengios produktiven Papern lösten ethische Diskussionen aus. Gleichzeitig führte die Rolle von AI im Kreativbereich zu breiten Debatten über Effizienz versus traditionelles Schaffen und die Auswirkungen auf die Beschäftigung. (Quelle: charles_irl, MiniMax__AI, dwarkesh_sp, giffmana, slashML, Reddit r/ChatGPT)

Auswirkungen von AI auf Beruf und Gesellschaft sowie Modellinteraktionserfahrung : Persönliche Geschichten zeigten, wie AI unerfahrenen Menschen hilft, Arbeit zu finden, und den Einfluss von AI auf die Rechtsbranche, was Diskussionen über die Auswirkungen von AI auf Beschäftigung und beruflichen Wandel auslöste. Gleichzeitig beeinflussen die “Persönlichkeits”-Unterschiede verschiedener AI-Modelle (wie ChatGPT und Grok) in komplexen Szenarien sowie Probleme wie das “Du hast absolut Recht”-Feedback des Claude-Modells und wiederholte Bildgenerierungen von Gemini Pro die Wahrnehmung der Benutzer von der AI-Interaktionserfahrung. (Quelle: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, Reddit r/artificial, Reddit r/ClaudeAI, Reddit r/OpenWebUI)

AI-Community: Inhaltsqualität, Entwicklungsherausforderungen und Benutzerstrategien : Die AI-Community äußerte Bedenken über das schnelle Wachstum von minderwertigem, AI-generiertem Inhalt (“AI slop”). Gleichzeitig diskutierten Benutzer die Hardwarekosten, Leistung und Vor- und Nachteile von lokalen LLM-Bereitstellungen im Vergleich zu gehosteten Diensten sowie Strategien zur Bewältigung der Kontextbeschränkungen von Claude, was die technischen Herausforderungen und Community-Ökosystemprobleme widerspiegelt, die bei der AI-Entwicklung und -Nutzung auftreten. (Quelle: Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/ClaudeAI, Reddit r/LocalLLaMA)

Technischer Support und Lernumgebungsherausforderungen im AI-Zeitalter : In der Community stieg die Nachfrage nach technischem Support für Probleme mit der Colab GPU-Umgebung und der Integration von Stable Diffusion in Open WebUI, was die weit verbreiteten Herausforderungen bei der Konfiguration von Rechenressourcen und der Tool-Integration im AI-Lernen und -Entwickeln widerspiegelt. Gleichzeitig zeigt der Boom in der GPU-Kernel-Programmierung ein starkes Interesse an Low-Level-Optimierung und Leistungssteigerung. (Quelle: Reddit r/deeplearning, Reddit r/OpenWebUI, maharshii)

Praktische Anwendungen von AI im Innen-/Außendesign und Benutzererfahrung : Die Community diskutierte die praktische Anwendung von AI im Innen-/Außendesign. Ein Benutzer teilte einen erfolgreichen Fall, in dem AI zur Gestaltung eines Terrassendachs verwendet wurde, und meinte, dass AI schnell realistische Designvorschläge generieren kann. Gleichzeitig gab es allgemeine Neugierde bezüglich der realen Implementierung und Benutzererfahrung von AI-Designs. (Quelle: Reddit r/ArtificialInteligence)

AI und digitale Transformation erfordern systemisches Denken : In komplexen AI-Systemen und digitalen Ökosystemen ist es notwendig, die Wechselwirkungen der einzelnen Komponenten aus einer ganzheitlichen Perspektive zu verstehen, anstatt Probleme isoliert zu betrachten, um sicherzustellen, dass die Technologie effektiv integriert wird und den erwarteten Wert liefert. (Quelle: Ronald_vanLoon)

LLM-Trainingsdatengenerierung und ARC-AGI-Benchmark-Diskussion : Die Community diskutierte, ob das Gemini 3-Team große Mengen synthetischer Daten für den ARC-AGI-Benchmark generiert hat, und welche Bedeutung dies für den AGI-Fortschritt und den ARC Prize hat. Dies spiegelt das anhaltende Interesse an den Quellen von LLM-Trainingsdaten, der Qualität synthetischer Daten und deren Einfluss auf die Modellfähigkeiten wider. (Quelle: teortaxesTex)

💡 Sonstiges

Grundschüler nutzen AI zur Bekämpfung der Obdachlosigkeit : Grundschüler in Texas nutzen AI-Technologie, um Lösungen zur Bekämpfung der lokalen Obdachlosigkeit zu erforschen und zu entwickeln. Dieses Projekt zeigt das Potenzial von AI im Bereich des sozialen Engagements und die Fähigkeit, durch Bildung die junge Generation zu befähigen, reale Probleme mit Technologie zu lösen. (Quelle: kxan.com)