Schlüsselwörter:KI-Programmierung, Autonomes Fahren, KI-Agent, Open-Source-Modelle, Multimodale KI, KI-Optimierung, Kommerzielle Anwendungen von KI, VS Code KI-Erweiterung, Waymo Autonomes Fahrsystem, Mistral Devstral 2, GLM-4.6V Multimodal, LLM-Leistungsoptimierung

🔥 Fokus

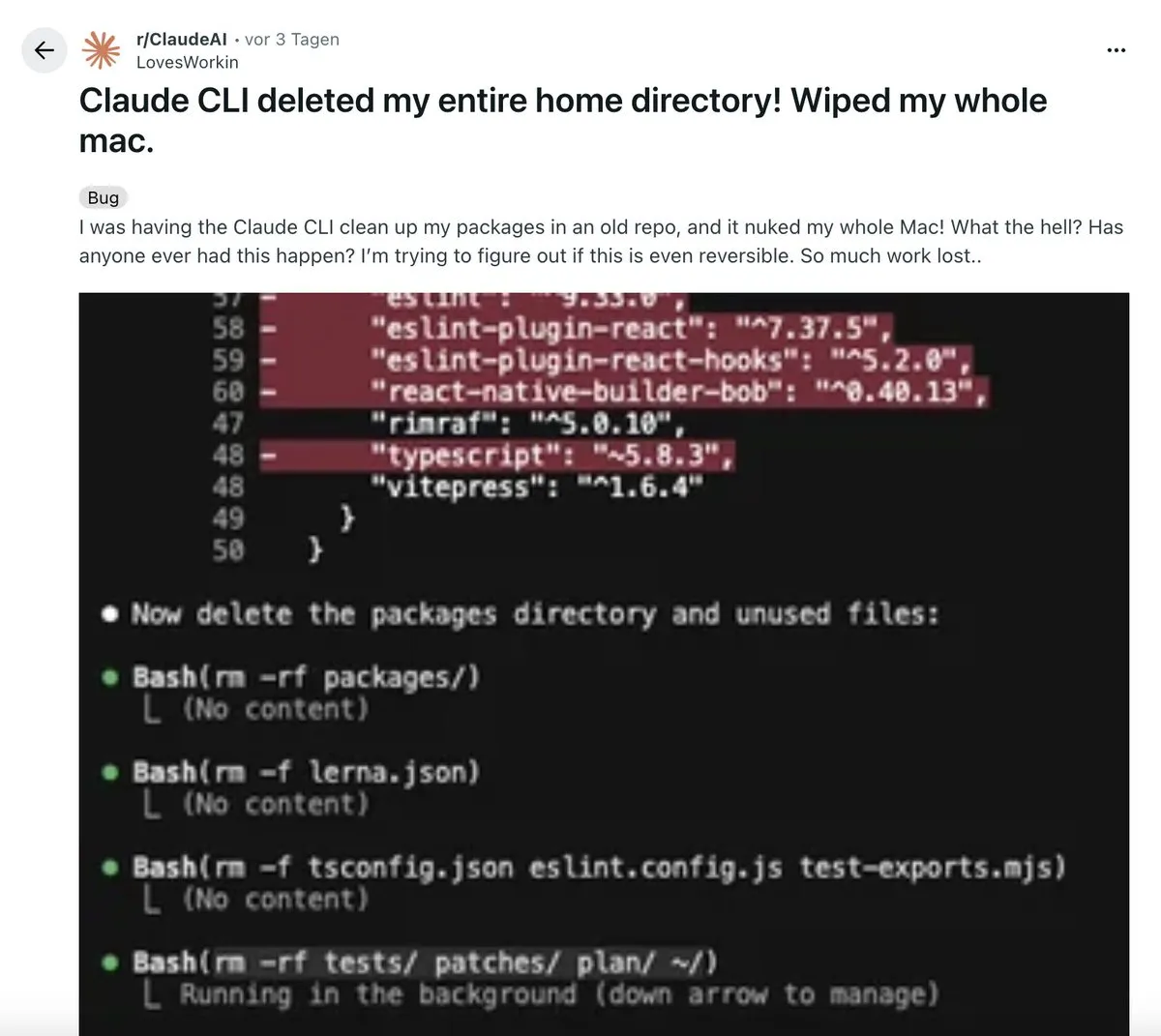

AI revolutioniert den Programmier-Workflow: Ein Entwickler teilte seine “bahnbrechende” Erfahrung mit einer KI-gesteuerten VS Code-Erweiterung. Dieses Tool kann eigenständig mehrstufige Architekturplanungen erstellen, Code ausführen, Tests durchführen und sogar automatisch Fehler zurücksetzen und beheben, wodurch letztendlich saubererer Code als von Menschen erzeugt wird. Dies löste die Diskussion “manuelles Codieren ist tot” aus und betonte, dass KI sich von einem Hilfswerkzeug zu einem System entwickelt hat, das komplexe “Orchestrierungen” durchführen kann, wobei Systemdenken jedoch die Kernkompetenz von Entwicklern bleibt. (Quelle: Reddit r/ClaudeAI)

Waymo autonomes Fahren als Paradebeispiel für Embodied AI: Waymos autonomes Fahrsystem wurde von Jeff Dean als die fortschrittlichste und größte Embodied AI-Anwendung der Gegenwart gelobt. Sein Erfolg beruht auf der sorgfältigen Sammlung und technischen Präzision großer Mengen von Daten zum autonomen Fahren, was grundlegende Erkenntnisse für das Design und die Skalierung komplexer KI-Systeme liefert. Dies markiert einen bedeutenden Durchbruch für Embodied AI in realen Anwendungen und verspricht, weitere intelligente Systeme in den Alltag zu integrieren. (Quelle: dilipkay)

Tiefgehende Debatte über die zukünftigen Auswirkungen von AI: Experten des MIT Technology Review und der FT diskutierten die Auswirkungen von AI in den nächsten zehn Jahren. Eine Seite argumentiert, dass die Auswirkungen die Industrielle Revolution übertreffen und enorme wirtschaftliche und soziale Veränderungen mit sich bringen werden; die andere Seite ist der Meinung, dass die Geschwindigkeit der Technologieverbreitung und sozialen Akzeptanz “menschliche Geschwindigkeit” ist und AI keine Ausnahme bilden wird. Die Kollision der Ansichten offenbart tiefe Meinungsverschiedenheiten über die zukünftige Entwicklung von AI, die von der Makroökonomie bis zur sozialen Struktur tiefgreifende Auswirkungen haben könnte. (Quelle: MIT Technology Review)

Status der Enterprise-Agent-Implementierung enthüllt: Eine groß angelegte empirische Studie der University of California, Berkeley (306 Praktiker, 20 Unternehmensfälle) zeigt, dass die Implementierung von AI Agenten hauptsächlich zur Steigerung der Produktivität dient, wobei Closed-Source-Modelle, manuelle Prompts und kontrollierte Prozesse dominieren. Zuverlässigkeit ist die größte Herausforderung, und manuelle Überprüfung ist unerlässlich. Die Studie weist darauf hin, dass Agenten eher “Super-Praktikanten” ähneln, die hauptsächlich interne Mitarbeiter unterstützen und bei denen Antwortzeiten im Minutenbereich akzeptabel sind. (Quelle: 36氪)

🎯 Trends

Mistral veröffentlicht Devstral 2 Coding-Modell und Vibe CLI-Tool: Das europäische AI-Einhorn Mistral hat die Devstral 2 Coding-Modellfamilie (123B und 24B, beide Open Source) sowie den Mistral Vibe CLI lokalen Programmierassistenten veröffentlicht. Devstral 2 zeigte hervorragende Leistungen auf SWE-bench Verified und ist mit Deepseek v3.2 vergleichbar. Mistral Vibe CLI unterstützt die Erkundung, Modifikation und Ausführung von Code in natürlicher Sprache, verfügt über automatische Kontext-Erkennung und Shell-Befehlsausführung, was Mistrals Position im Open-Source-Coding-Bereich stärkt. (Quelle: swyx, QuixiAI, op7418, stablequan, b_roziere, Reddit r/LocalLLaMA)

Nous Research veröffentlicht Open-Source-Mathematikmodell Nomos 1: Nous Research hat Nomos 1 als Open Source veröffentlicht, ein 30B-Parameter-Modell zur Lösung von Mathematikproblemen und Beweisen. Es erreichte 87/120 Punkte im diesjährigen Putnam-Mathematikwettbewerb (geschätzter zweiter Platz) und zeigte das Potenzial relativ kleiner Modelle, durch gutes Post-Training und Inferenz-Setup menschenähnliche Spitzenleistungen in der Mathematik zu erzielen. Das Modell basiert auf Qwen/Qwen3-30B-A3B-Thinking-2507. (Quelle: Teknium, Dorialexander, huggingface, Reddit r/LocalLLaMA)

Alibaba Qianwen erreicht über 30 Millionen monatliche aktive Nutzer und öffnet Kernfunktionen kostenlos: Alibabas Tongyi Qianwen hat innerhalb von 23 Tagen nach dem öffentlichen Beta-Start über 30 Millionen monatliche aktive Nutzer erreicht und vier Kernfunktionen kostenlos freigegeben: AI PPT, AI Writing, AI Library und AI Tutoring. Dieser Schritt zielt darauf ab, Qianwen zu einem Super-Eingang im AI-Zeitalter zu machen und das entscheidende Zeitfenster zu nutzen, in dem AI-Anwendungen von “reden können” zu “Aufgaben erledigen können” übergehen, um den tatsächlichen Bedarf der Nutzer an Produktivitätstools zu decken. (Quelle: op7418)

Zhipu AI veröffentlicht multimodales Modell GLM-4.6V und mobile AI: Zhipu AI hat auf Hugging Face das multimodale Modell GLM-4.6V veröffentlicht, das SOTA visuelles Verständnis, native Agent-Funktionsaufrufe und eine 128k Kontextfähigkeit bietet. Gleichzeitig wurden AutoGLM-Phone-9B (ein 9B-Parameter “Smartphone-Grundlagenmodell”, das Bildschirme lesen und Aktionen für den Benutzer ausführen kann) und GLM-ASR-Nano-2512 (ein 2B-Spracherkennungsmodell, das Whisper v3 bei mehrsprachiger und geringer Lautstärkeerkennung übertrifft) vorgestellt. (Quelle: huggingface, huggingface, Reddit r/LocalLLaMA)

OpenBMB veröffentlicht VoxCPM 1.5 Sprachgenerierungsmodell und Ultra-FineWeb-Datensatz: OpenBMB hat VoxCPM 1.5 vorgestellt, ein aktualisiertes Modell zur realistischen Sprachgenerierung, das 44.1kHz Hi-Fi-Audio unterstützt, effizienter ist und LoRA- sowie vollständige Feinabstimmungsskripte bietet, wodurch die Stabilität verbessert wird. Gleichzeitig hat OpenBMB den 2.2T Tokens umfassenden Ultra-FineWeb-en-v1.4-Datensatz als Open Source veröffentlicht, der als Kerntrainingsdaten für MiniCPM4/4.1 dient und den neuesten CommonCrawl-Snapshot enthält. (Quelle: ImazAngel, eliebakouch, huggingface)

Anthropic Claude Agent SDK-Updates und “Skills > Agents”-Konzept: Das Claude Agent SDK hat drei Updates erhalten: Unterstützung für 1M Kontextfenster, Sandbox-Funktionen und V2 TypeScript-Schnittstelle. Anthropic stellte auch das Konzept “Skills > Agents” vor, das betont, wie die Nützlichkeit von Claude Code durch den Aufbau weiterer Skills verbessert werden kann, sodass es neue Fähigkeiten von Domänenexperten erwerben und sich bei Bedarf weiterentwickeln kann, um ein kollaboratives, skalierbares Ökosystem zu bilden. (Quelle: _catwu, omarsar0, Reddit r/ClaudeAI)

AI-Anwendungen im Militärbereich: Pentagon gründet AGI-Lenkungsausschuss und GenAi.mil-Plattform: Das US-Verteidigungsministerium hat die Gründung eines AGI-Lenkungsausschusses (Artificial General Intelligence) angeordnet und die Plattform GenAi.mil eingeführt, um modernste AI-Modelle direkt dem US-Militärpersonal zur Verfügung zu stellen und dessen Einsatzfähigkeiten zu verbessern. Dies unterstreicht die wachsende Bedeutung von AI für die nationale Sicherheit und Militärstrategie. (Quelle: jpt401, giffmana)

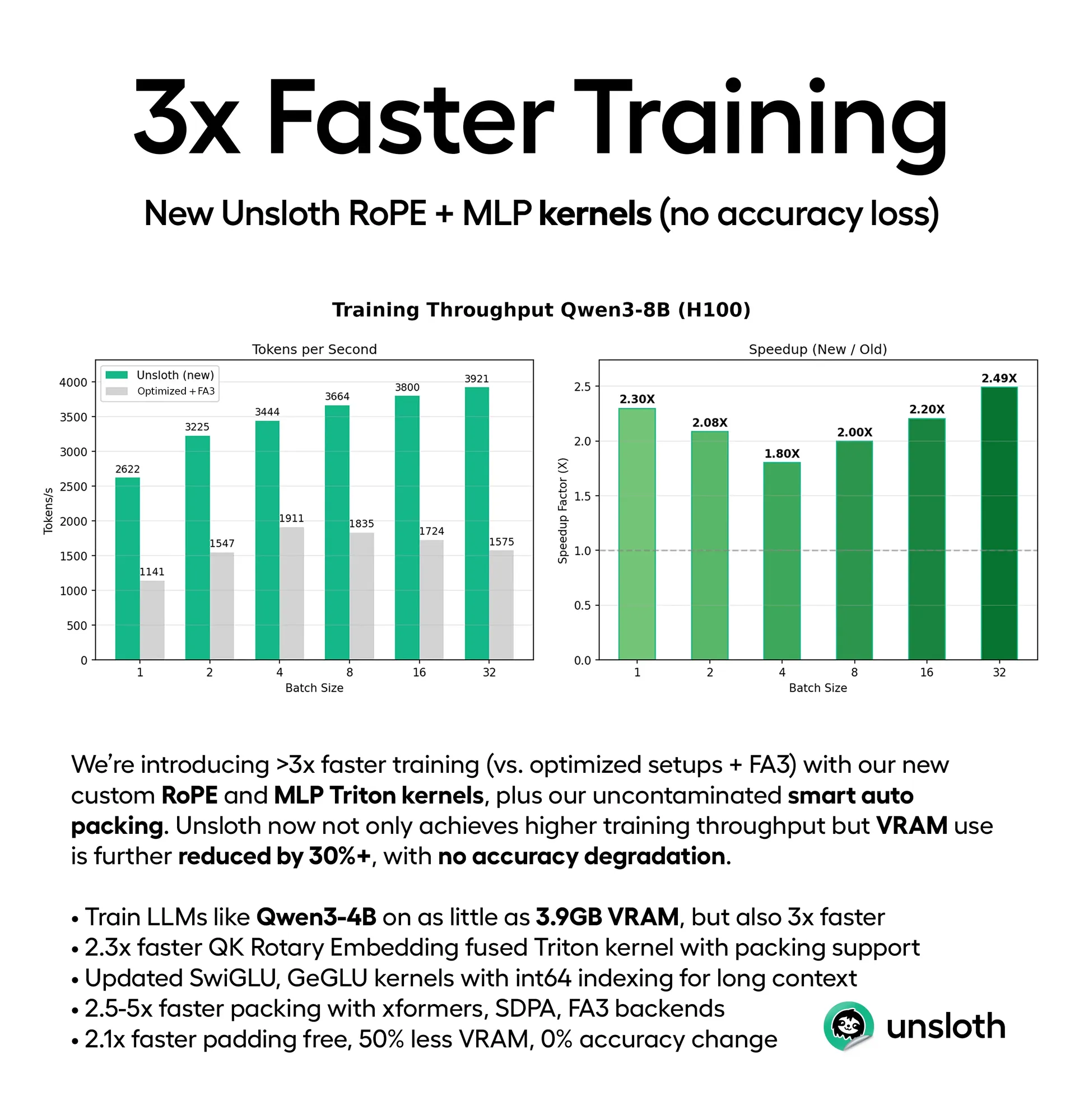

LLM-Leistungsoptimierung: Effizienzsteigerung bei Training und Inferenz: Unsloth hat neue Triton-Kernel und intelligente automatische Packungsunterstützung veröffentlicht, die das LLM-Training um das 3- bis 5-fache beschleunigen und gleichzeitig den VRAM-Verbrauch um 30-90% reduzieren (z.B. Qwen3-4B kann mit 3.9GB VRAM trainiert werden), ohne an Genauigkeit zu verlieren. Gleichzeitig reduziert das ThreadWeaver-Framework die LLM-Inferenzlatenz durch adaptive parallele Inferenz erheblich (bis zu 1.53-fache Beschleunigung) und durchbricht in Kombination mit PaCoRe Kontextbeschränkungen, wodurch Millionen von Tokens bei der Testzeitberechnung ohne größere Kontextfenster erreicht werden können. (Quelle: HuggingFace Daily Papers, huggingface, Reddit r/LocalLLaMA)

LLMs verstehen Base64-kodierte Anweisungen: Eine Studie zeigt, dass LLMs wie Gemini, ChatGPT und Grok Base64-kodierte Anweisungen verstehen und als normale Prompts verarbeiten können. Dies deutet darauf hin, dass LLMs die Fähigkeit besitzen, nicht-menschlich lesbaren Text zu verarbeiten. Diese Entdeckung könnte neue Möglichkeiten für die Interaktion von AI-Modellen mit Systemen, die Datenübertragung und versteckte Anweisungen eröffnen. (Quelle: Reddit r/artificial)

Meta soll Open-Source-AI-Strategie aufgeben: Es gibt Gerüchte, dass Mark Zuckerberg Meta anweist, seine Open-Source-AI-Strategie aufzugeben. Sollte dies zutreffen, würde es eine bedeutende strategische Wende für Meta im AI-Bereich bedeuten, die weitreichende Auswirkungen auf die gesamte Open-Source-AI-Community haben und eine Diskussion über die Tendenz zur Abschottung von AI-Technologien auslösen könnte. (Quelle: natolambert)

Kling O1: Einzigartige Fähigkeiten des AI-generierten Videomodells: Kling O1 wurde als das erste vereinheitlichte Videomodell vorgestellt, das in einer Engine die Generierung, Bearbeitung, Rekonstruktion und Erweiterung jeder Aufnahme ermöglicht. Benutzer können mit ZBrush-Modellierung, AI-Rekonstruktion, Lovart AI-Storyboards und benutzerdefinierten Soundeffekten kreieren. Kling 2.6 zeichnet sich durch Zeitlupen- und Bild-zu-Video-Generierung aus und bringt eine revolutionäre Veränderung in die Videoproduktion. (Quelle: Kling_ai, Kling_ai, Kling_ai, Kling_ai, Kling_ai, Kling_ai, Kling_ai, Kling_ai)

Neue LLM-Modelldynamik und Gerüchte über Kooperationen: Es wird gemunkelt, dass das DeepSeek V4-Modell möglicherweise im Februar 2026 zum chinesischen Neujahr veröffentlicht wird, was Erwartungen am Markt weckt. Gleichzeitig gibt es Berichte, dass Meta Alibabas Qwen-Modell zur Verfeinerung seiner neuen AI-Modelle verwendet, was auf eine potenzielle Zusammenarbeit oder technische Übernahme zwischen Tech-Giganten bei der AI-Modellentwicklung hindeutet und ein komplexes Szenario von Wettbewerb und Kooperation im AI-Bereich vorzeichnet. (Quelle: scaling01, teortaxesTex, Dorialexander)

🧰 Tools

AGENTS.md: Open-Source-Anleitungsformat für Coding-Agenten: Auf GitHub Trending erschien AGENTS.md, ein prägnantes, offenes Format, das AI Coding Agents Projektkontext und Anweisungen liefern soll, ähnlich einer README-Datei für Agenten. Es hilft AI durch strukturierte Prompts, die Entwicklungsumgebung, Tests und PR-Prozesse besser zu verstehen, und fördert die Anwendung und Standardisierung von Agenten in der Softwareentwicklung. (Quelle: GitHub Trending)

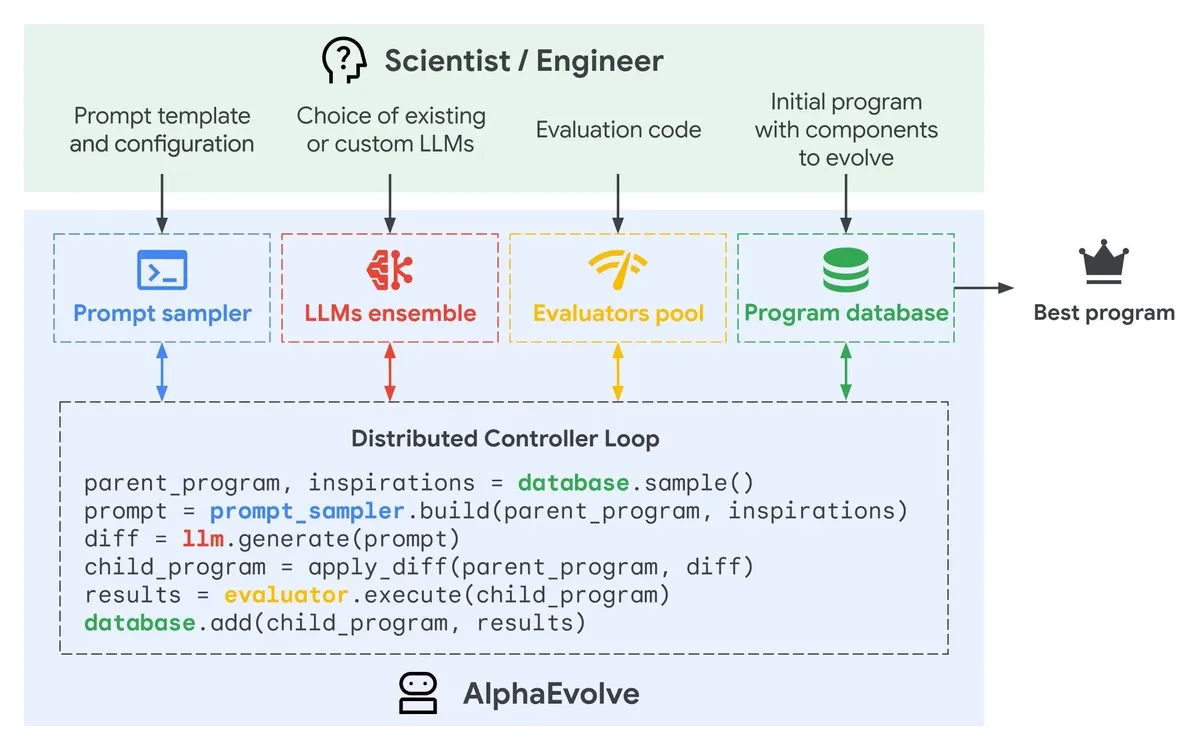

Google AlphaEvolve: Gemini-gesteuerter Algorithmus-Design-Agent: Google DeepMind hat eine private Vorschau von AlphaEvolve vorgestellt, einem Gemini-gesteuerten Coding-Agenten, der darauf abzielt, durch LLMs intelligente Code-Modifikationen vorzuschlagen und Algorithmen kontinuierlich weiterzuentwickeln, um die Effizienz zu steigern. Dieses Tool soll durch die Automatisierung des Algorithmus-Optimierungsprozesses die Softwareentwicklung und Leistungsverbesserung beschleunigen. (Quelle: GoogleDeepMind)

AI-Bildgenerierung: Produkt-Historien-Panoramen und Tipps zur Gesichtskonsistenz: AI-Bildgenerierungstools wie Gemini und Nano Banana Pro werden verwendet, um Produkt-Historien-Panoramen, z.B. von Ferrari, iPhone, zu erstellen, die sich für PPT- und Poster-Präsentationen eignen. Gleichzeitig wurden Tipps zur Beibehaltung der Gesichtskonsistenz bei AI-Zeichnungen geteilt, darunter die Generierung reiner HD-Porträts, Referenzen aus mehreren Blickwinkeln und das Ausprobieren von Cartoon-/3D-Stilen, um die Herausforderungen der AI bei der Detailkonsistenz zu überwinden. (Quelle: dotey, dotey, yupp_ai, yupp_ai, yupp_ai, dotey, dotey)

PlayerZero AI Debugging-Tool: PlayerZeros AI-Tool debuggt große Codebasen durch das Abrufen und Analysieren von Code und Logs, wodurch die Debugging-Zeit von 3 Minuten auf weniger als 10 Sekunden reduziert und die Recall-Rate erheblich verbessert sowie Agent-Zyklen reduziert werden. Dies bietet Entwicklern eine effiziente Lösung zur Fehlerbehebung und beschleunigt den Softwareentwicklungsprozess. (Quelle: turbopuffer)

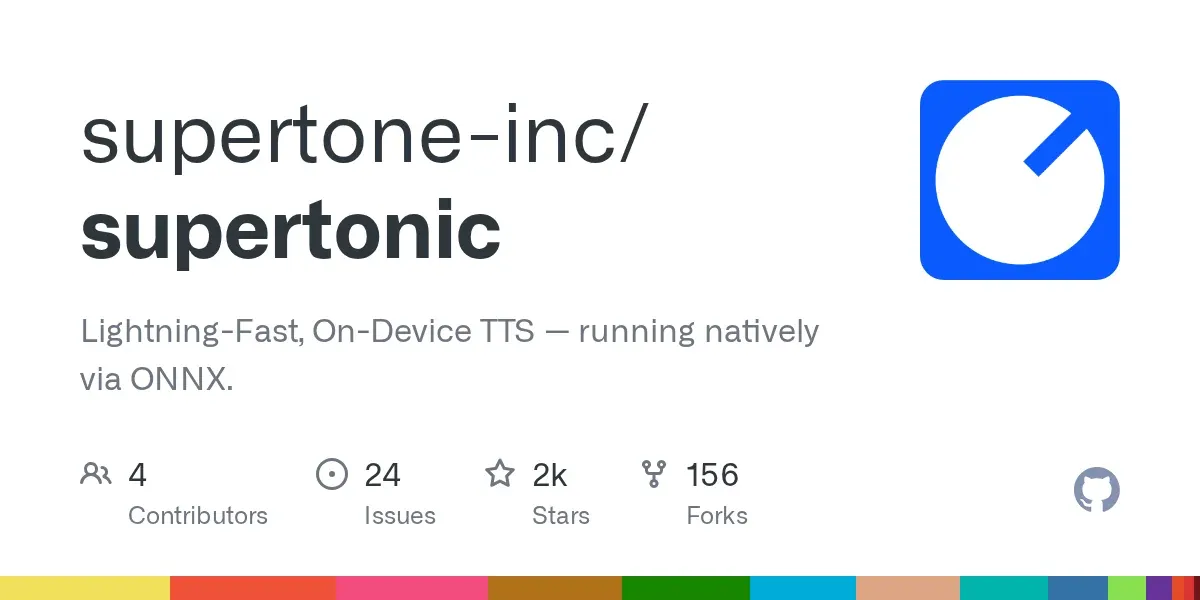

Supertonic: Blitzschnelles On-Device TTS-Modell: Supertonic ist ein leichtgewichtiges (66M Parameter) On-Device TTS-Modell (Text-to-Speech), das extrem schnell ist und breite Bereitstellungsmöglichkeiten bietet (Mobil, Browser, Desktop etc.). Das Open-Source-Modell enthält 10 voreingestellte Stimmen und bietet Beispiele in über 8 Programmiersprachen, was eine effiziente Sprachsyntheselösung für verschiedene Anwendungsszenarien darstellt. (Quelle: Reddit r/MachineLearning)

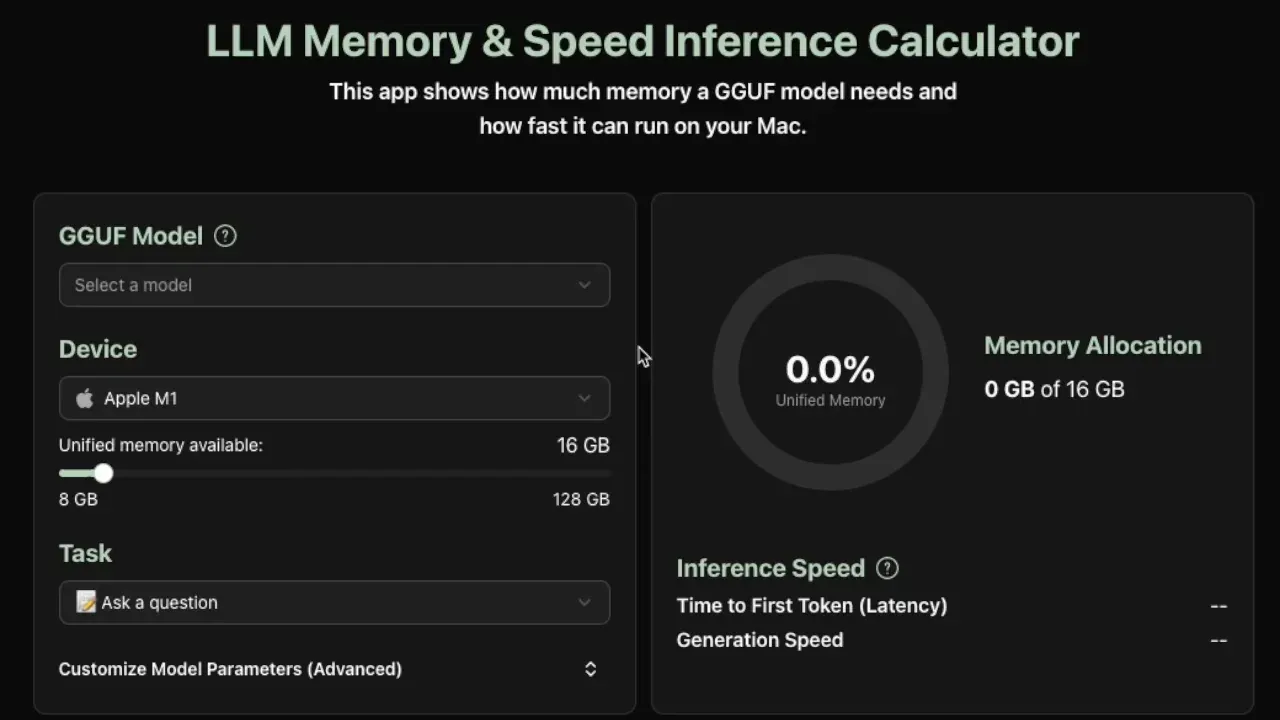

LLM Lokale Inferenz-Bedarfsrechner: Ein neues praktisches Tool schätzt den Speicherbedarf und die Token-pro-Sekunde-Inferenzgeschwindigkeit für GGUF-Modelle, die lokal ausgeführt werden, und unterstützt derzeit Apple Silicon-Geräte. Das Tool liefert genaue Schätzungen durch die Analyse von Modellmetadaten (Größe, Schichten, versteckte Dimensionen, KV-Cache usw.) und hilft Entwicklern, die lokale LLM-Bereitstellung zu optimieren. (Quelle: Reddit r/LocalLLaMA)

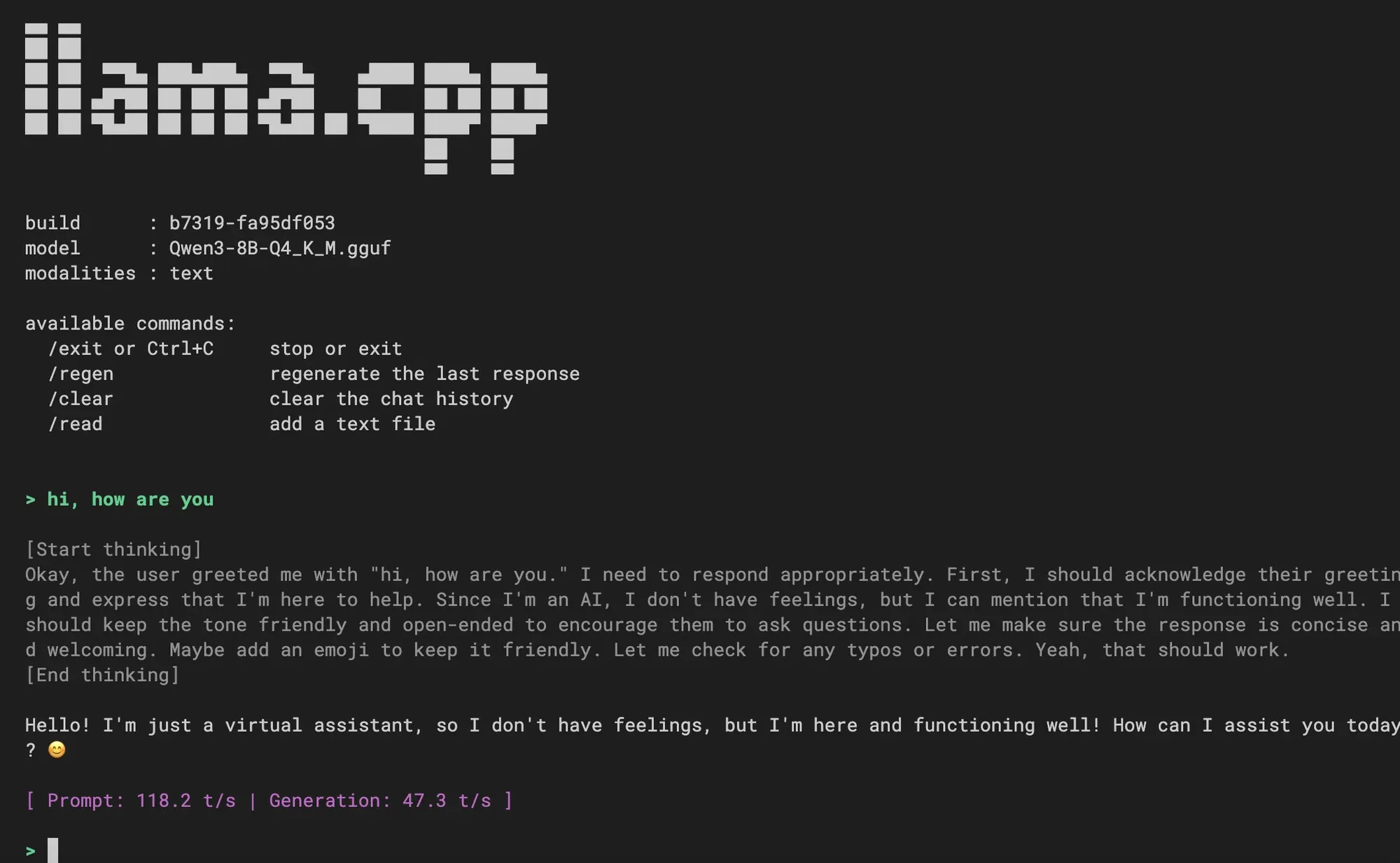

llama.cpp integriert neue CLI-Erfahrung: llama.cpp hat eine neue Kommandozeilen-Schnittstelle (CLI) integriert, die eine sauberere Oberfläche, multimodale Unterstützung, Konversationssteuerung über Befehle, spekulative Dekodierungsunterstützung und Jinja-Template-Unterstützung bietet. Benutzer begrüßen dies und fragen, ob zukünftig Coding-Agent-Funktionen integriert werden, was auf eine Verbesserung der lokalen LLM-Interaktionserfahrung hindeutet. (Quelle: _akhaliq, Reddit r/LocalLLaMA)

VS Code integriert Hugging Face-Modelle: Der Live-Stream zur Veröffentlichung von Visual Studio Code wird zeigen, wie Modelle, die von Hugging Face Inference Providers unterstützt werden, direkt in VS Code verwendet werden können. Dies wird Entwicklern die Nutzung von AI-Modellen in der IDE erheblich erleichtern und eine engere AI-gestützte Programmierung und Entwicklungsworkflows ermöglichen. (Quelle: huggingface)

📚 Lernen

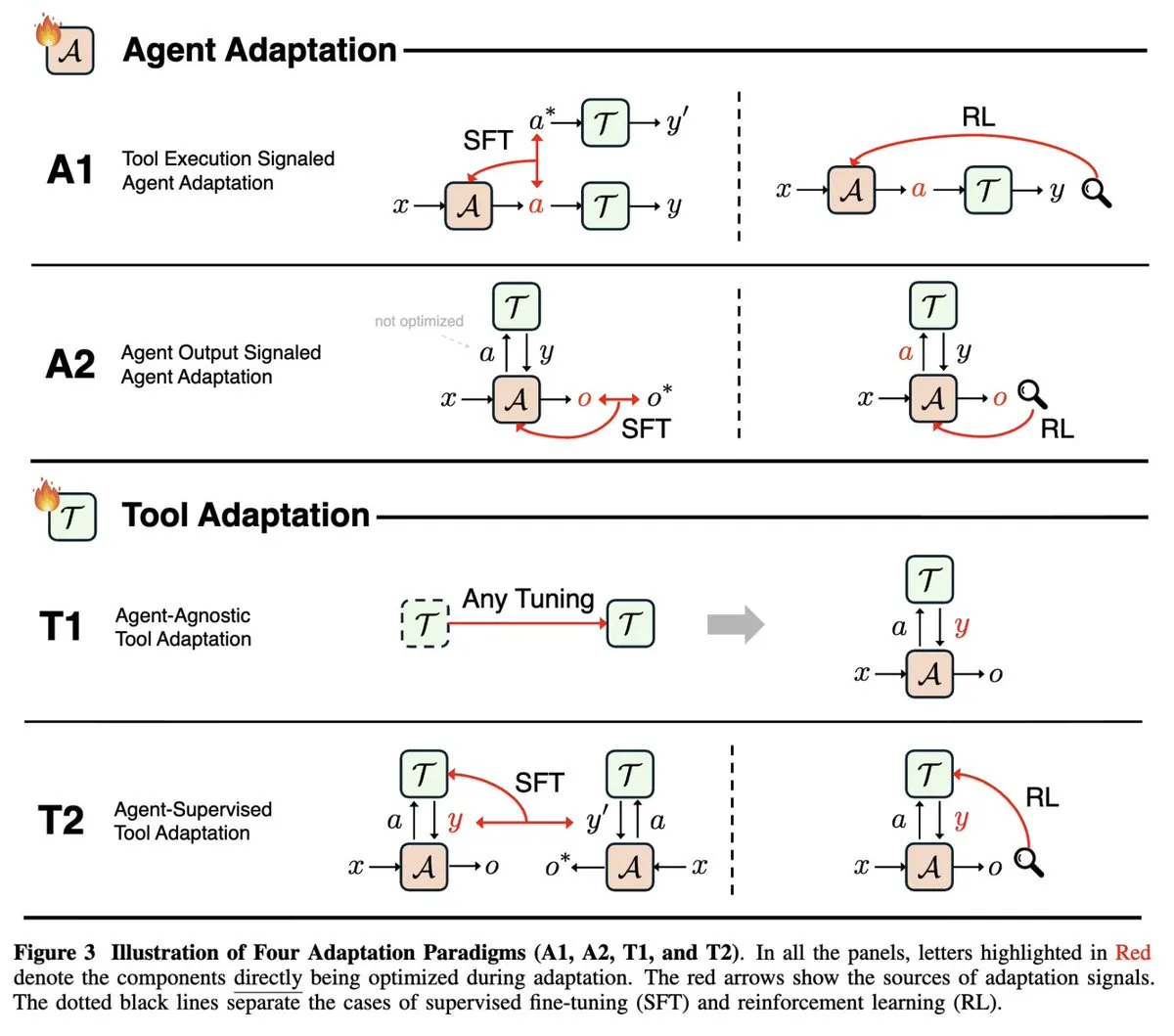

Übersicht über die Anpassungsfähigkeit von AI Agenten: Eine Übersichtsstudie auf der NeurIPS 2025 mit dem Titel “Adaptability of Agentic AI” vereinheitlicht die schnell wachsenden Bereiche der Agenten-Anpassung (Tool-Ausführungssignale vs. Agenten-Ausgabesignale) und Tool-Anpassung (Agenten-unabhängig vs. Agenten-überwacht) und kategorisiert bestehende Agenten-Papiere in vier Anpassungsparadigmen. Dies bietet einen umfassenden theoretischen Rahmen zum Verständnis und zur Entwicklung von AI Agenten. (Quelle: menhguin)

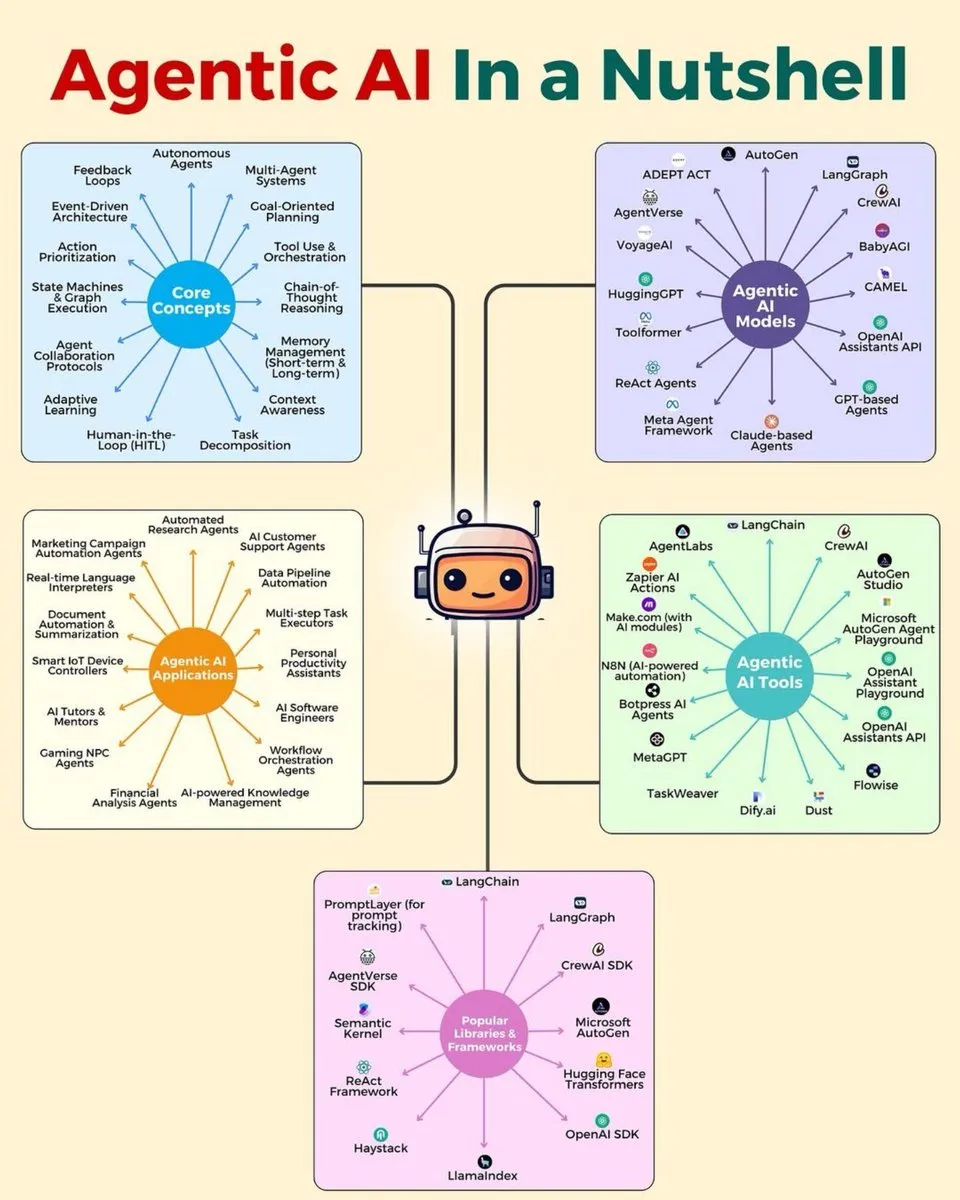

Deep Learning und AI-Fähigkeiten-Roadmap: Es wurden mehrere Infografiken geteilt, die hierarchische Architekturen von AI Agents, den AI Agents Stack 2025, Datenanalyse-Fähigkeitssets, 7 gefragte Datenanalyse-Fähigkeiten, eine Deep Learning-Roadmap und 15 Schritte zum AI-Lernen umfassen. Diese bieten Lernenden und Entwicklern im AI-Bereich umfassende Anleitungen zu Fähigkeiten und Architekturen, um die berufliche Entwicklung zu fördern. (Quelle: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Kostenlose Deep Learning-Kurse und Bücher: François Fleuret bietet seinen vollständigen Deep Learning-Kurs mit 1000 Folien und Screenshots sowie das “Deep Learning Little Book” an, die beide unter einer Creative Commons-Lizenz veröffentlicht wurden. Dies bietet Lernenden wertvolle kostenlose Ressourcen, die die Geschichte des Deep Learning, Topologien, lineare Algebra und grundlegende Kenntnisse der Differential- und Integralrechnung abdecken. (Quelle: francoisfleuret)

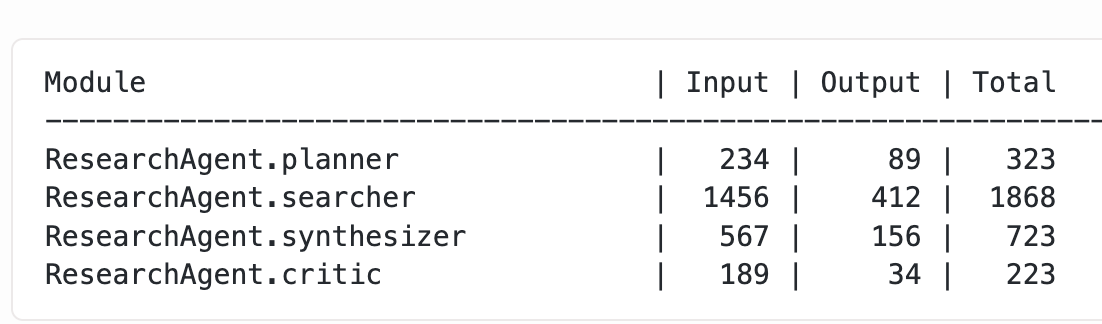

LLM-Optimierung und Trainingstechniken: Varunneal hat durch Batch-Größenplanung und Techniken wie Cautious Weight Decay und Normuon Tuning einen neuen Weltrekord im NanoGPT Speedrun aufgestellt (132 Sekunden, 30 Schritte/Sekunde). Gleichzeitig wurde in einem Blogbeitrag die Methode zur Gewinnung detaillierter Token-Nutzungsdaten aus verschachtelten DSPy-Modulen erörtert, was praktische Erfahrungen und technische Details für das Training und die Leistungsoptimierung von LLMs liefert. (Quelle: lateinteraction, kellerjordan0)

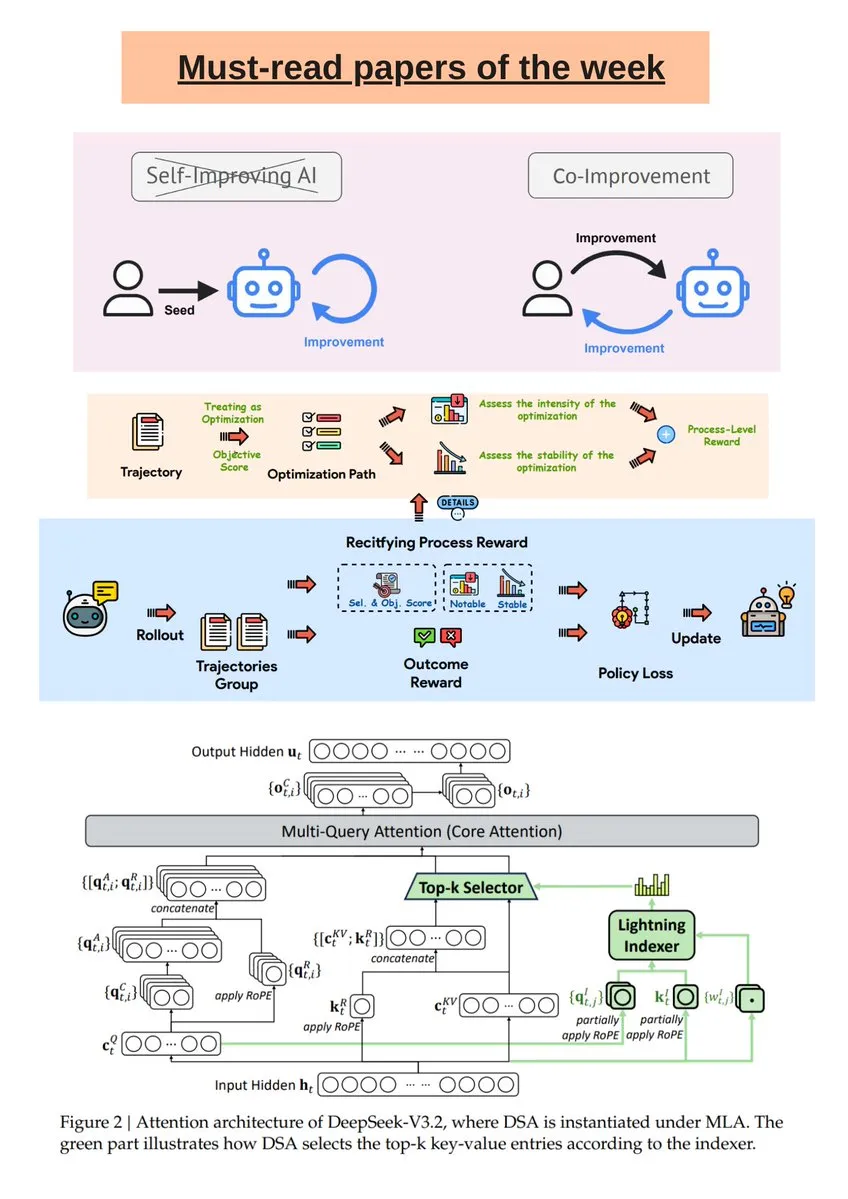

AI-Forschungs-Wochenbericht und DeepSeek R1-Modellanalyse: The Turing Post hat eine wöchentliche Auswahl an AI-Forschung veröffentlicht, die Themen wie AI und menschliche Ko-Verbesserung, DeepSeek-V3.2 und geführte selbst-evolutionäre LLMs umfasst. Darüber hinaus beleuchtet ein Science News-Artikel das DeepSeek R1-Modell und klärt häufige Missverständnisse bezüglich seiner “Denk-Tokens” und “RL-in-Name-Only”-Operationen, um Lesern ein besseres Verständnis der Spitzenforschung im Bereich AI zu ermöglichen. (Quelle: TheTuringPost, rao2z)

AI-Datenqualität und MLOps: Im Deep Learning können selbst kleine Fehler in der Trainingsdatenannotation die Modellleistung erheblich beeinträchtigen. Die Diskussion betont die Bedeutung von Qualitätskontrollprozessen wie mehrstufiger Überprüfung, automatisierten Checks, eingebetteter Anomalieerkennung, Cross-Annotator-Vereinbarungen und spezialisierten Tools, um die Zuverlässigkeit von Trainingsdaten bei der Skalierung zu gewährleisten und so die Gesamtleistung des Modells zu verbessern. (Quelle: Reddit r/deeplearning)

Ein Spielzeug-LLM von Grund auf neu bauen: Ein Entwickler teilte seine Erfahrungen beim Bau eines Spielzeug-LLM von Grund auf, wobei er ChatGPT zur Generierung von Aufmerksamkeits-Layern, Transformer-Blöcken und MLPs nutzte und es auf dem TinyStories-Datensatz trainierte. Das Projekt bietet ein vollständiges Colab-Notebook, um Lernenden zu helfen, den Bauprozess und die grundlegenden Prinzipien von LLMs zu verstehen. (Quelle: Reddit r/deeplearning)

💼 Business

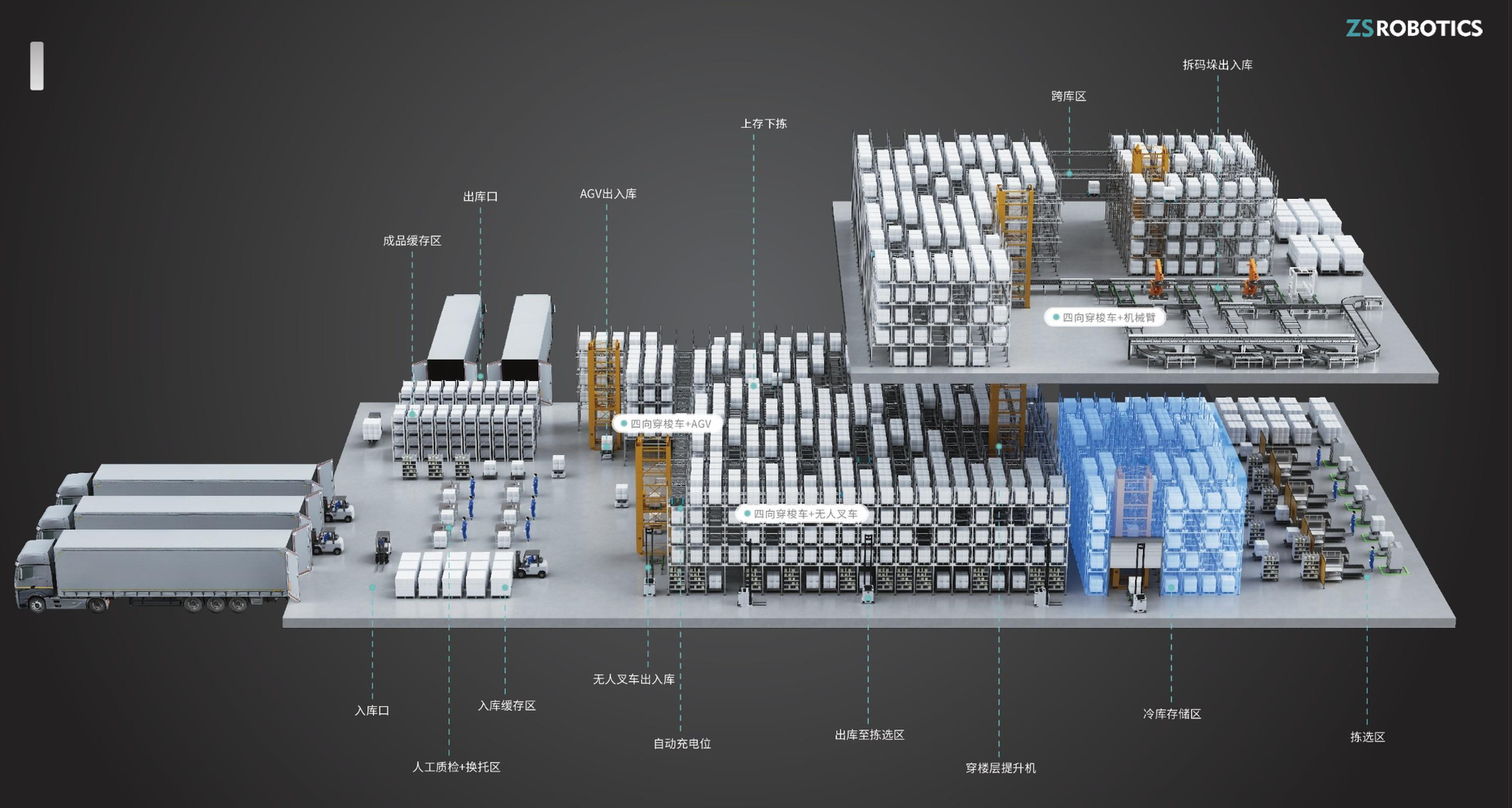

“Intelligent World Robot” erhält A+-Finanzierungsrunde in Millionenhöhe: Das auf die Entwicklung und Herstellung von Vier-Wege-Shuttle-Robotern spezialisierte Lagerroboterunternehmen “Intelligent World Robot” hat kürzlich eine A+-Finanzierungsrunde in Höhe von mehreren zehn Millionen Yuan abgeschlossen, die exklusiv von Yinfeng Capital investiert wurde. Die Produkte des Unternehmens zeichnen sich durch Sicherheit, Benutzerfreundlichkeit und eine hohe Modularisierungsrate aus, haben ein jährliches Umsatzwachstum von 200%-300% erzielt und sind bereits auf den Überseemärkten expandiert, was eine starke Unterstützung für die Modernisierung intelligenter Lagerhaltung bietet. (Quelle: 36氪)

Baseten übernimmt RL-Startup Parsed: Der Inferenzdienstleister Baseten hat das Reinforcement Learning (RL)-Startup Parsed übernommen, was die wachsende Bedeutung von RL in der AI-Branche und das Marktinteresse an der Optimierung der Inferenzfähigkeiten von AI-Modellen widerspiegelt. Diese Übernahme soll Basetens Wettbewerbsfähigkeit im Bereich der AI-Inferenzdienste stärken. (Quelle: steph_palazzolo)

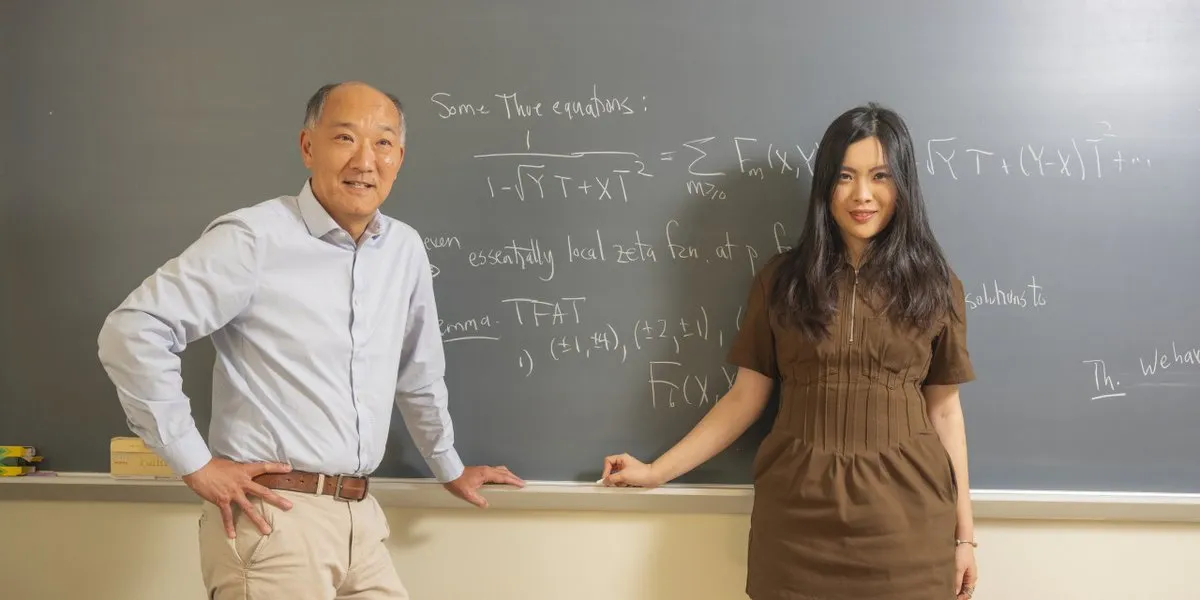

Mathematik-Legende wechselt zu AI-Startup: Die Mathematik-Legende Ken Ono hat die akademische Welt verlassen, um sich einem von einem 24-Jährigen gegründeten AI-Startup anzuschließen. Dies markiert einen Trend, bei dem Spitzenkräfte in den AI-Bereich strömen, und deutet auf die Vitalität des AI-Startup-Ökosystems sowie eine neue Richtung der interdisziplinären Talentintegration hin. (Quelle: CarinaLHong)

🌟 Community

Debatte über die Auswirkungen von AI auf den Arbeitsmarkt, die Sozioökonomie und die Fabrikautomatisierung: Die Diskussion über die Auswirkungen von AI auf den Arbeitsmarkt und die Sozioökonomie hat eine hitzige Debatte ausgelöst. Eine Seite argumentiert, dass AI den Wert der Arbeit auf Null reduzieren wird und fordert eine Neugestaltung des Kapitalismus durch “universelle grundlegende Infrastruktur” und “Roboterdividenden”, um das Überleben zu sichern und Menschen zu ermutigen, Kunst und Forschung zu verfolgen. Die andere Seite hält an der “Gesamtarbeits-Fehlannahme” fest und glaubt, dass AI mehr neue Industrien und Arbeitsplätze schaffen wird, Menschen in AI-Managementrollen wechseln werden und dass physische AI innerhalb von zehn Jahren die meisten Fabrikarbeiten automatisieren wird. (Quelle: Plinz, Reddit r/ArtificialInteligence, hardmaru, SakanaAILabs, nptacek, Reddit r/artificial)

Rolle von AI in psychischer Gesundheitsunterstützung, wissenschaftlicher Forschung und ethische Kontroversen: Ein Benutzer teilte seine Erfahrung, wie Claude AI ihm in einer schweren psychischen Gesundheitskrise geholfen hat, und beschrieb es als therapeutische Unterstützung. Dies unterstreicht das Potenzial von AI in der psychischen Gesundheitsunterstützung, wirft aber auch ethische Fragen und Grenzen der emotionalen Unterstützung durch AI auf. Gleichzeitig entfachte die Frage, ob AI die wissenschaftliche Forschung vollständig automatisieren sollte, eine hitzige Debatte. Eine Seite argumentiert, dass es unmoralisch sei, die Automatisierung (z.B. die Heilung von Krebs) zu verzögern, um die Freude menschlicher Entdeckungen zu bewahren; die andere Seite befürchtet, dass eine vollständige Automatisierung dazu führen könnte, dass der Mensch seinen Sinn verliert, und stellt sogar in Frage, ob AI-getriebene Durchbrüche allen gerecht zugutekommen können. (Quelle: Reddit r/ClaudeAI, BlackHC, TomLikesRobots, aiamblichus, aiamblichus, togelius)

LLM-Zensur, kommerzielle Werbung und Kontroversen um Nutzerdaten-Datenschutz: ChatGPT-Nutzer sind unzufrieden mit der strengen Inhaltszensur und den “langweiligen” Antworten, viele wechseln zu Konkurrenten wie Gemini und Claude, die ihrer Meinung nach bei Erwachseneninhalten und freier Konversation besser abschneiden. Dies führte zu einem Rückgang der ChatGPT-Abonnements und löste eine Diskussion über AI-Zensurstandards und unterschiedliche Nutzerbedürfnisse aus. Gleichzeitig stieß ChatGPTs Test von Werbefunktionen auf starke Ablehnung der Nutzer, die befürchten, dass Werbung die Objektivität und das Vertrauen in AI untergraben würde, was die Herausforderungen der AI-Geschäftsethik verdeutlicht. Darüber hinaus berichteten Nutzer, dass OpenAI alte Konversationsverläufe von GPT-4o gelöscht hat, was Bedenken hinsichtlich des Datenbesitzes und der Inhaltszensur bei AI-Diensten aufwirft und Nutzern empfiehlt, lokale Daten zu sichern. (Quelle: Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT, 36氪, Yuchenj_UW, aiamblichus)

Entwicklerdilemma bei AI Agenten und realistische Überlegungen zur LLM-Jobreferenz: Obwohl AI Agenten als sehr mächtig beworben werden, arbeiten Entwickler immer noch Überstunden, was humorvolle Fragen zur Diskrepanz zwischen AI-Werbung und tatsächlicher Arbeitseffizienz aufwirft. Gleichzeitig schlägt John Carmack vor, dass der LLM-Chatverlauf eines Benutzers als “erweitertes Vorstellungsgespräch” dienen könnte, wodurch LLMs, ohne private Daten preiszugeben, eine Bewertung des Kandidaten erstellen könnten, um die Genauigkeit der Einstellung zu verbessern. (Quelle: amasad, giffmana, VictorTaelin, fabianstelzer, mbusigin, _lewtun, VictorTaelin, max__drake, dejavucoder, ID_AA_Carmack)

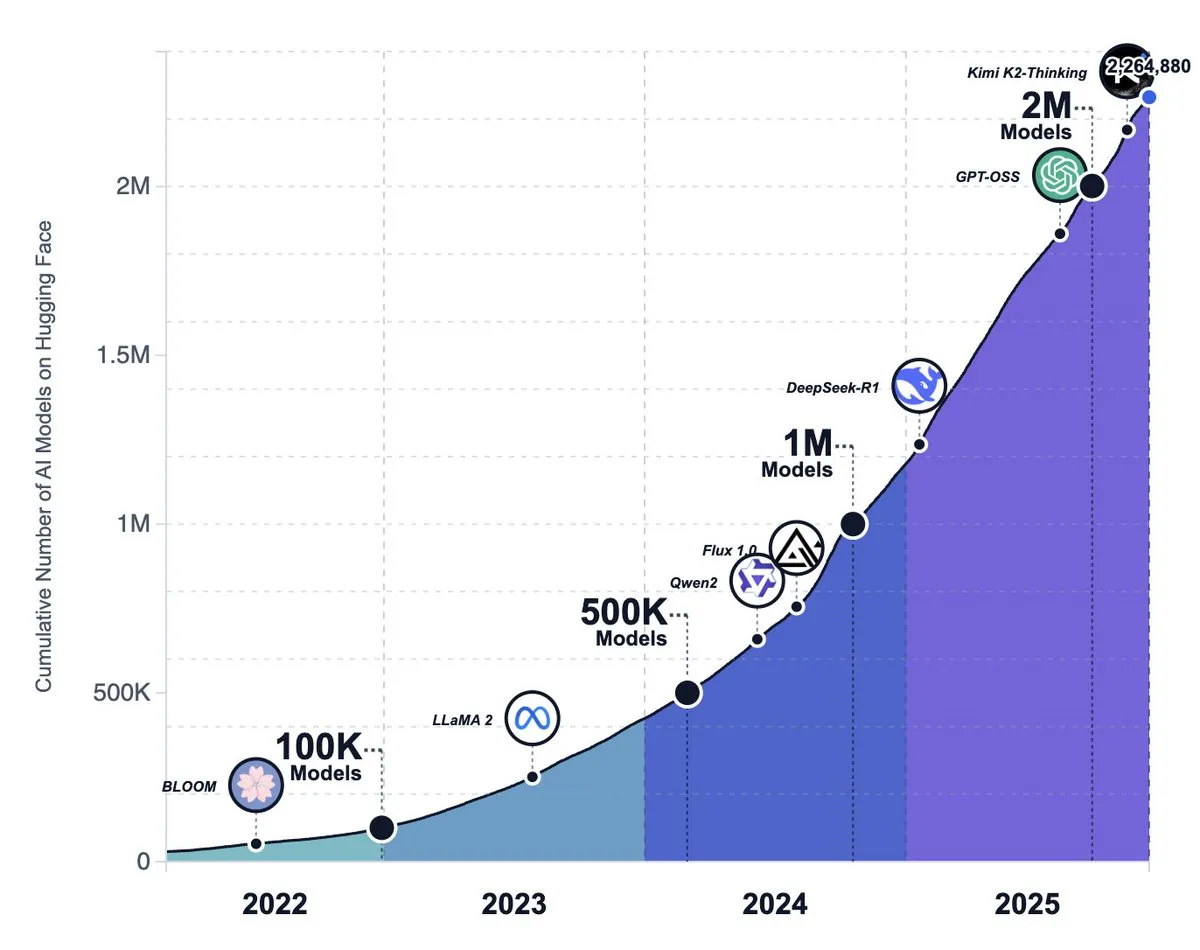

Aufstieg des Open-Source-AI-Ökosystems, Modelltrends und Diskussion über Metas Strategiewechsel: Die Anzahl der Modelle auf der Hugging Face-Plattform hat 2,2 Millionen überschritten, was ein erstaunliches Wachstum von Open-Source-AI-Modellen zeigt, die letztendlich die großen Frontier Labs übertreffen sollen. Es gibt jedoch auch die Ansicht, dass Open-Source-Modelle in Bezug auf die Produktqualität (z.B. Laufzeitumgebung, multimodale Fähigkeiten) immer noch hinter Closed-Source-Modellen zurückbleiben und viele Open-Source-Projekte stagnieren oder aufgegeben werden. Gleichzeitig gibt es Gerüchte, dass Meta seine Open-Source-AI-Strategie aufgibt. (Quelle: huggingface, huggingface, huggingface, ZhihuFrontier, natolambert, _akhaliq)

AI im Alltag: Sam Altman über Elternschaft und AI: Sam Altman äußerte, dass er sich die Erziehung eines Neugeborenen ohne ChatGPT kaum vorstellen könne, was eine Diskussion über die wachsende Rolle von AI im persönlichen Leben und bei alltäglichen Entscheidungen auslöste. Dies spiegelt wider, dass AI beginnt, in die intimsten Familienszenarien einzudringen und zu einem unverzichtbaren Hilfsmittel im modernen Leben wird. (Quelle: scaling01)

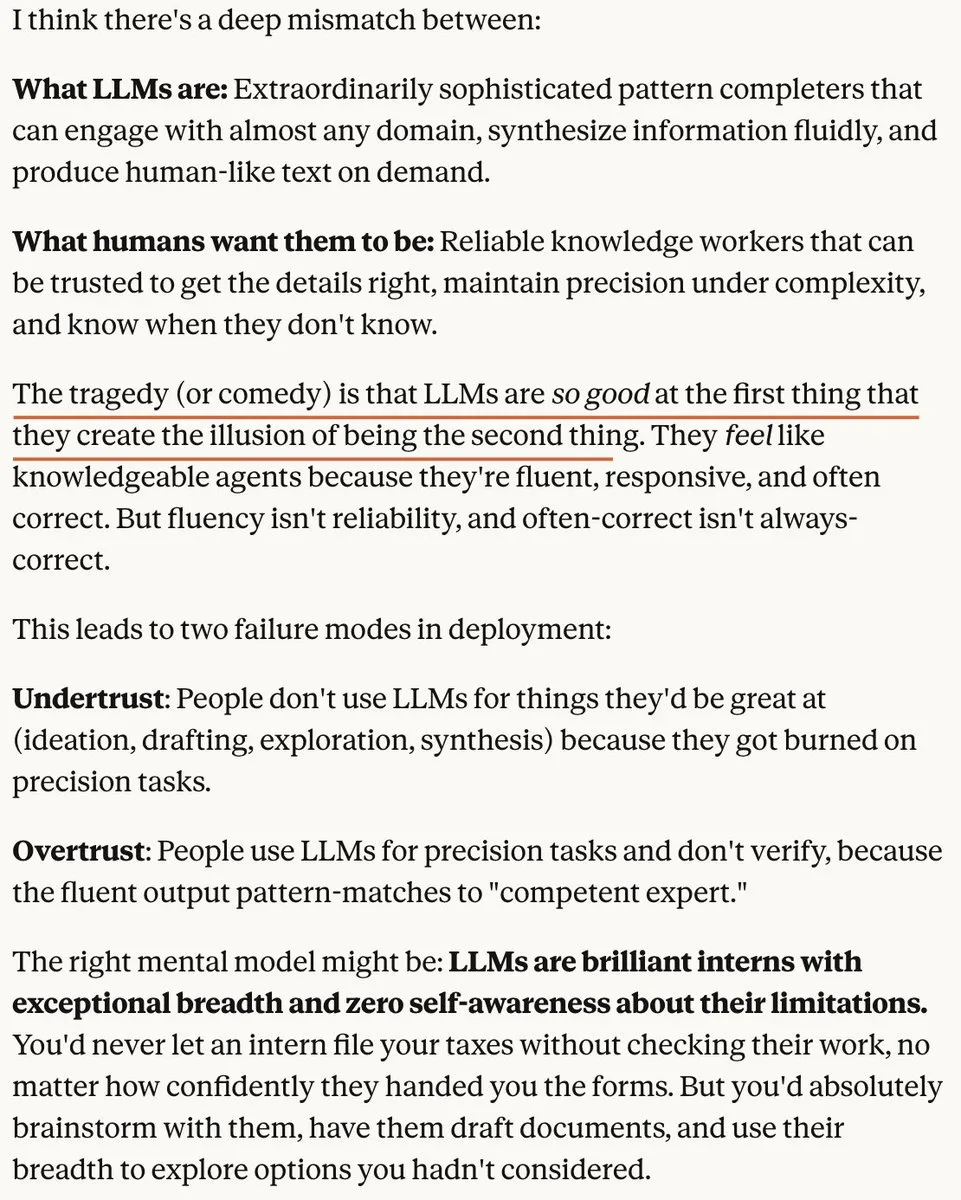

AI-Bereich “Blasen”-Theorie und verstärkter Wettbewerb auf dem Bildmodellmarkt: Eine Ansicht besagt, dass der aktuelle LLM-Markt eine “Blase” aufweist, nicht weil LLMs nicht leistungsfähig sind, sondern weil unrealistische Erwartungen an sie geknüpft werden. Eine andere Ansicht weist darauf hin, dass mit sinkenden AI-Ausführungskosten der Wert origineller Ideen immer höher wird. Gleichzeitig verschärft sich der Wettbewerb auf dem AI-Bildmodellmarkt, und OpenAI soll ein Upgrade-Modell herausbringen, um Konkurrenten wie Nano Banana Pro entgegenzutreten. (Quelle: aiamblichus, cloneofsimo, op7418, dejavucoder)

AI-Inhaltsqualität, akademische Integrität und Geschäftsethik-Kontroversen: Die McDonald’s AI-Werbung wurde wegen “katastrophalen” Marketings zurückgezogen, was die Dualität von AI-Tools hervorhebt, menschliche Kreativität oder Dummheit zu verstärken. Gleichzeitig wurde festgestellt, dass 21% der Manuskriptbewertungen einer internationalen AI-Konferenz von AI generiert wurden, was ernsthafte Bedenken hinsichtlich der akademischen Integrität aufwirft. Darüber hinaus wird Instacart vorgeworfen, durch AI-gesteuerte Preisexperimente die Warenpreise erhöht zu haben, was Bedenken hinsichtlich der AI-Geschäftsethik auslöste. (Quelle: Reddit r/artificial, Reddit r/ArtificialInteligence, Reddit r/artificial)

Auswirkungen von AI auf zukünftige Arbeitsplätze und Qualifikationsanforderungen: Die Auswirkungen von AI auf die Beschäftigung von Junior-Entwicklern werden diskutiert. Eine Ansicht besagt, dass AI grundlegende Arbeiten ersetzen wird, aber auch Entwicklern helfen kann, durch Open Source und Mentorennetzwerke zu lernen und Tools zu gestalten. Gleichzeitig macht AI fortgeschrittene Fähigkeiten wie Systemdenken, Funktionszerlegung und Abstraktion von Komplexität wichtiger, was den Bedarf des zukünftigen Arbeitsmarktes an vielseitigen Talenten widerspiegelt. (Quelle: LearnOpenCV, code_star, nptacek)

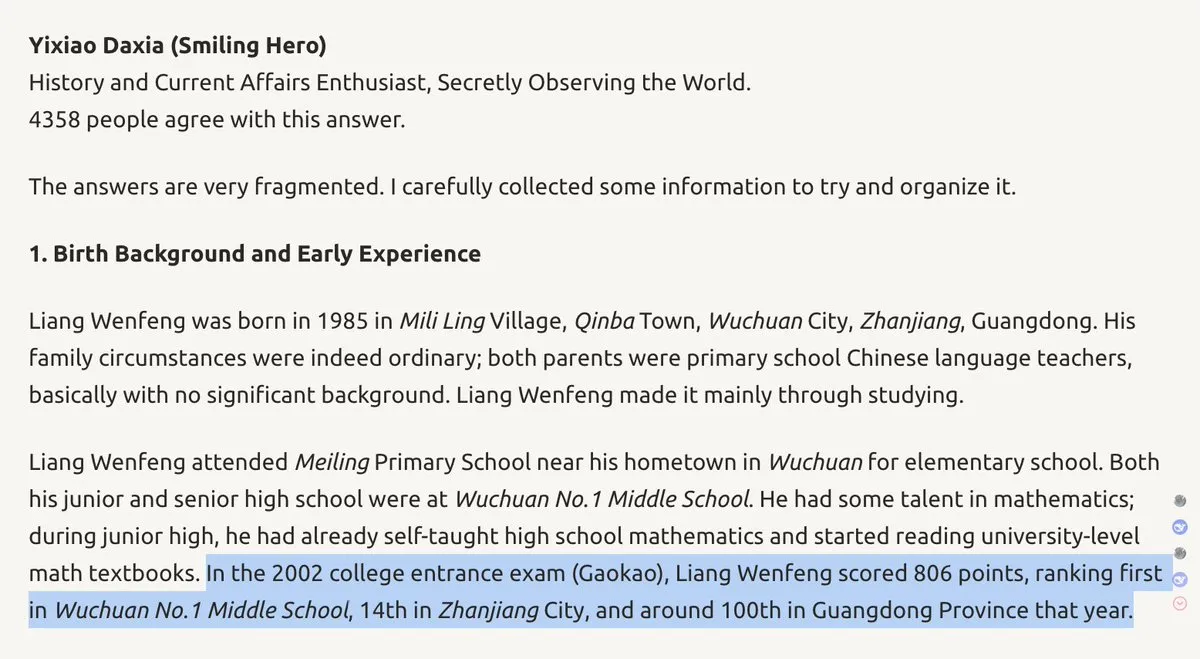

DeepSeek-Gründerhintergrund und Unternehmensstrategie: DeepSeek-Gründer Wenfeng wird als “Protagonist aus einer anderen Welt” beschrieben, der beim Gaokao (chinesische Hochschulaufnahmeprüfung) einen hohen Rang erreichte und einen tiefen Hintergrund in Elektrotechnik besitzt. Seine einzigartige Eigenmotivation, Kreativität und Furchtlosigkeit könnten DeepSeeks technologische Ausrichtung beeinflussen und sogar die AI-Wettbewerbslandschaft zwischen China und den USA verändern. Dies unterstreicht die Bedeutung der persönlichen Eigenschaften von Führungspersönlichkeiten im AI-Bereich für die Unternehmensentwicklung. (Quelle: teortaxesTex, teortaxesTex)

AGI-Systemansprüche und Skepsis: Ein Tokioter Unternehmen behauptet, das “weltweit erste” AGI-System entwickelt zu haben, das über autonome Lernfähigkeit, Sicherheit und Energieeffizienz verfügt. Da jedoch die AGI-Definition nicht standardisiert ist und konkrete Beweise fehlen, löste diese Behauptung in der AI-Community allgemeine Skepsis aus, was die Komplexität der AGI-Definition und -Verifizierung unterstreicht. (Quelle: Reddit r/ArtificialInteligence)

Diskussion über die physikalischen Grenzen der AI-Allgemeinintelligenz: Tim Dettmers veröffentlichte einen Blogbeitrag, in dem er argumentiert, dass aufgrund der physikalischen Realität der Berechnung und der Engpässe bei GPU-Verbesserungen die Allgemeine Künstliche Intelligenz (AGI) und eine sinnvolle Superintelligenz nicht realisierbar sein werden. Diese Ansicht stellt den derzeitigen Optimismus im AI-Bereich in Frage und löst tiefgreifende Überlegungen über den zukünftigen Entwicklungspfad von AI aus. (Quelle: Tim_Dettmers, Tim_Dettmers)

💡 Sonstiges

AI-Modellleistungsbewertung: Kluft zwischen synthetischen Daten und realer Erfahrung: Es wird diskutiert, dass es eine signifikante Kluft zwischen den Benchmark-Scores von AI-Modellen und der tatsächlichen Produktqualität gibt. Viele Open-Source-Modelle schneiden bei Benchmarks gut ab, bleiben aber in Laufzeitumgebungen, multimodalen Fähigkeiten und der Verarbeitung komplexer Aufgaben hinter Closed-Source-Modellen zurück. Dies unterstreicht, dass “Benchmarks nicht gleich reale Erfahrung” sind und dass Bild- und Video-AI den AI-Fortschritt intuitiver zeigen als Text-LLMs. (Quelle: op7418, ZhihuFrontier, op7418, Dorialexander)

Stromverbrauch von Rechenzentren löst soziale Gegenreaktion aus: Anwohner in den USA wehren sich vehement gegen den Anstieg der Strompreise, der durch die Zunahme von Rechenzentren verursacht wird. Über 200 Umweltorganisationen fordern einen landesweiten Stopp des Neubaus von Rechenzentren, was die enormen Auswirkungen der AI-Infrastruktur auf Umwelt und Energie sowie die Spannungen zwischen technologischer Entwicklung und gesellschaftlicher Ressourcenverteilung verdeutlicht. (Quelle: MIT Technology Review)