Schlüsselwörter:GPT-5.2, KI-Agent, Räumliche Intelligenz, Verkörperte Intelligenz, Großes Modell, KI-Hardware, KI-Ethik, GPT-5.2 Fachwissen Arbeitsfähigkeit, KI-Handy-Agent Open-Source-Framework, 3D-Physikwelt räumliche Intelligenz, Humanoid-Roboter verkörperte Intelligenz, NVIDIA DGX Station GB300

Hier ist der Inhalt des KI-Newsletters, basierend auf Ihrer Analyse und Zusammenfassung der bereitgestellten KI-Nachrichten und sozialen Diskussionen:

🎯 Trends

GPT-5.2 veröffentlicht: Fokus auf professionelle Wissensarbeit und fluide Intelligenz : OpenAI hat GPT-5.2 veröffentlicht, um die Fähigkeiten in der professionellen Wissensarbeit zu verbessern. Es zeigte signifikante Leistungen in den Benchmarks ARC-AGI-2 (fluide Intelligenz) und GDPval (wirtschaftliche Wertaufgaben). Die API-Aufrufe überschritten am ersten Tag eine Billion Tokens, und es wurde der “Skills”-Mechanismus von Anthropic übernommen. Nutzer bemängeln jedoch mangelnde Empathie und gesunden Menschenverstand sowie strenge Zensur. (Quelle: source, source, source, source, source)

Meta AI Strategiewechsel und interne Konflikte : Mark Zuckerberg verlagert Metas strategischen Fokus auf KI. Das neu gegründete TBD Lab-Team und die bestehenden Geschäftsbereiche geraten in Bezug auf Ressourcenallokation und Entwicklungsziele aneinander. Das neue Team widmet sich der Entwicklung einer “gottähnlichen KI-Superintelligenz”, während die Kern-Geschäftsbereiche soziale Medien und Werbung optimieren wollen. Zur Unterstützung der KI wurden die Budgets von Reality Labs drastisch gekürzt, was zu internen Spannungen führt. (Quelle: source)

Räumliche Intelligenz: Die nächste KI-Grenze und Chinas Chancen : “Räumliche Intelligenz” wird als die nächste Grenze der KI betrachtet, die vom eindimensionalen Token zum Verständnis und zur Interaktion mit der dreidimensionalen physischen Welt übergeht. Chinesische Unternehmen wie Qunhe Technology und Tencent Hunyuan haben in diesem Bereich bereits Grundlagen gelegt und könnten zu den Vorreitern der nächsten Intelligenz-Welle werden. Räumliche Intelligenz birgt enormes Potenzial in Bereichen wie Filmproduktion, industriellen Zwillingen und der Simulation von Embodied AI-Robotern. (Quelle: source)

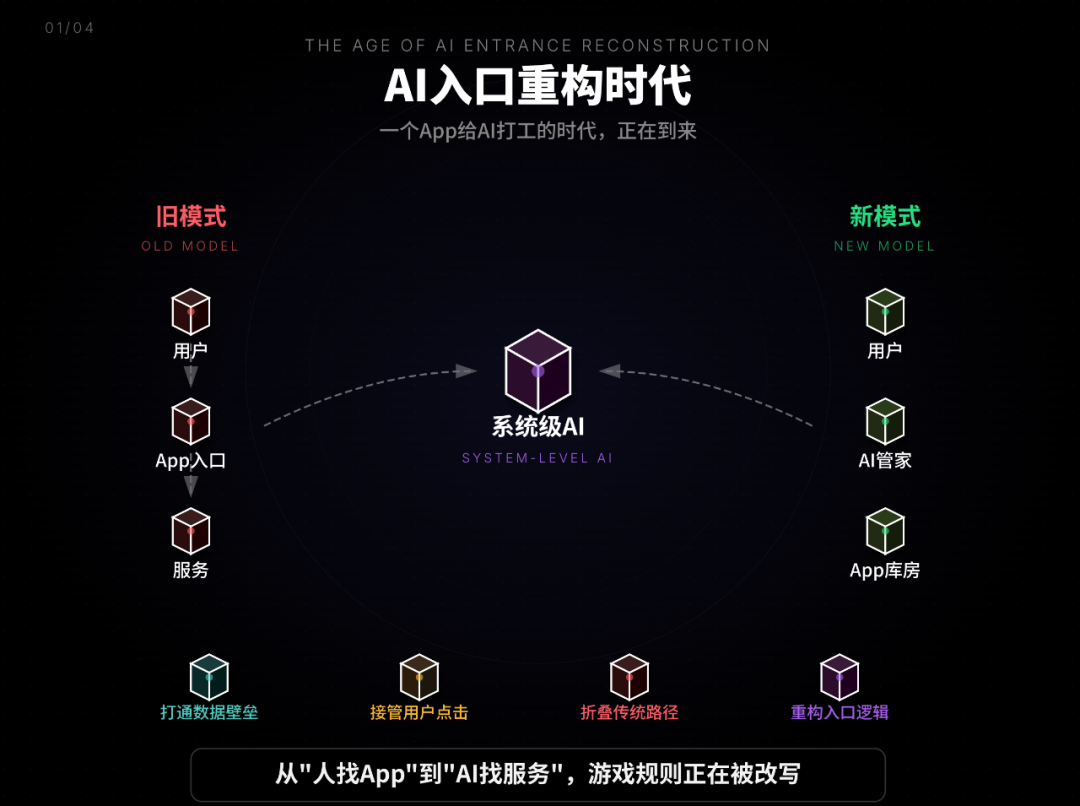

Aufstieg und Open-Sourcing des AI Mobile Agent-Ökosystems : ByteDance hat den Doubao Mobile Assistant als systemweite KI eingeführt, der App-Datenbarrieren durchbrechen und Benutzeraktionen ersetzen kann, was traditionelle App-Traffic-Modelle herausfordert. Gleichzeitig öffnet Zhipu AI das AutoGLM Mobile Agent Framework und das 9B-Modell als Open Source, um KI-native Mobilfunkfähigkeiten zu demokratisieren. Dies soll Datenschutzprobleme durch lokale, Cloud-basierte oder hybride Bereitstellung lösen und Plattformmonopole herausfordern, was als “Android-Moment für KI-Smartphones” betrachtet wird. (Quelle: source, source, source)

Google Gemini Funktionserweiterungen und Modellaktualisierungen : Gemini kann jetzt lokale Suchergebnisse in vielfältigen visuellen Formaten liefern und ist tief mit Google Maps integriert. Das Gemini 2.5 Flash Native Audio-Modell wurde aktualisiert und unterstützt Echtzeit-Sprachübersetzung, die die Stimmlage des Sprechers simulieren kann. Google DeepMind hat außerdem SIMA 2 als KI-Entdecker für virtuelle 3D-Welten vorgestellt und praktische Prinzipien für die Erweiterung von Agent-Systemen vorgeschlagen. (Quelle: source, source, source, source, source)

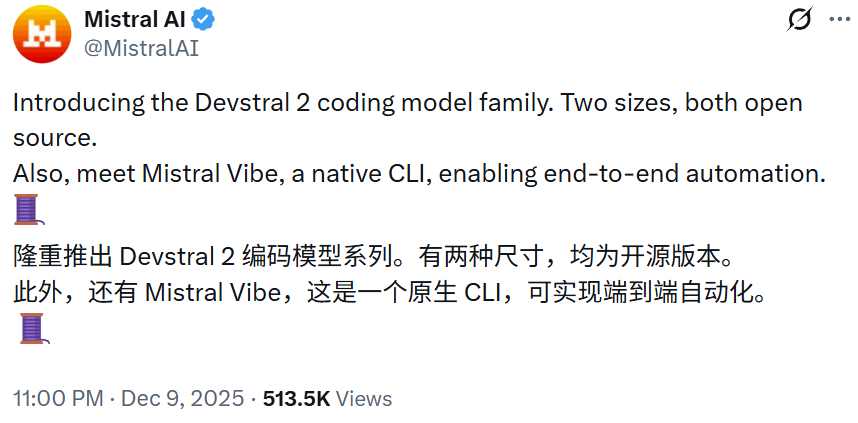

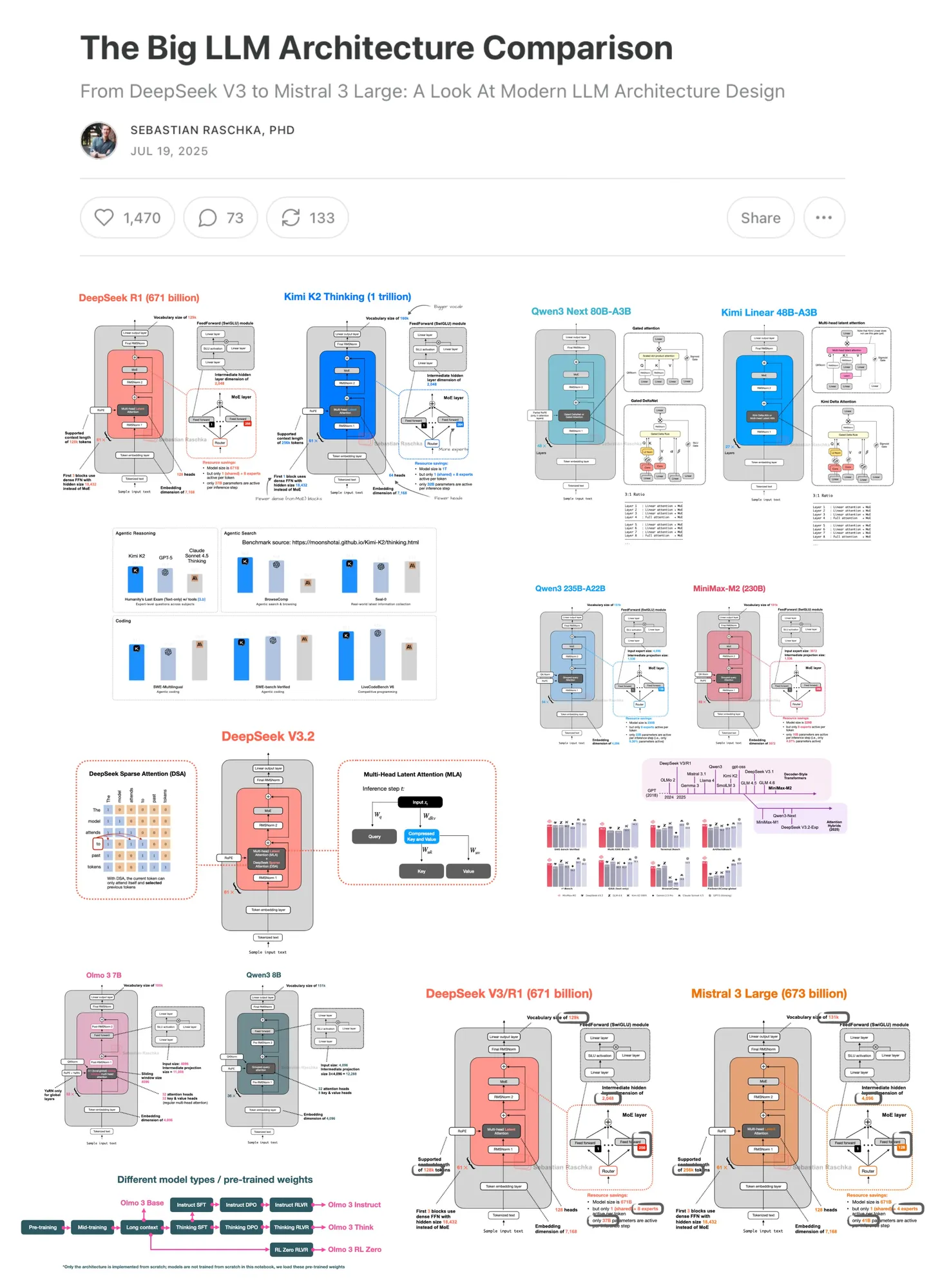

Mistral AI und NVIDIA veröffentlichen neue Modelle : Mistral AI öffnet Devstral 2 (123B) und Devstral Small 2 (24B) Code-Modelle als Open Source, die auf SWE-bench Verified hervorragende Leistungen gezeigt haben. NVIDIA hat das effiziente gpt-oss-120b Eagle3-Modell veröffentlicht, das die spekulative Dekodierung zur Optimierung des Durchsatzes nutzt. Die Architektur von Mistral Large 3 ähnelt DeepSeek V3. (Quelle: source, source, source, source, source)

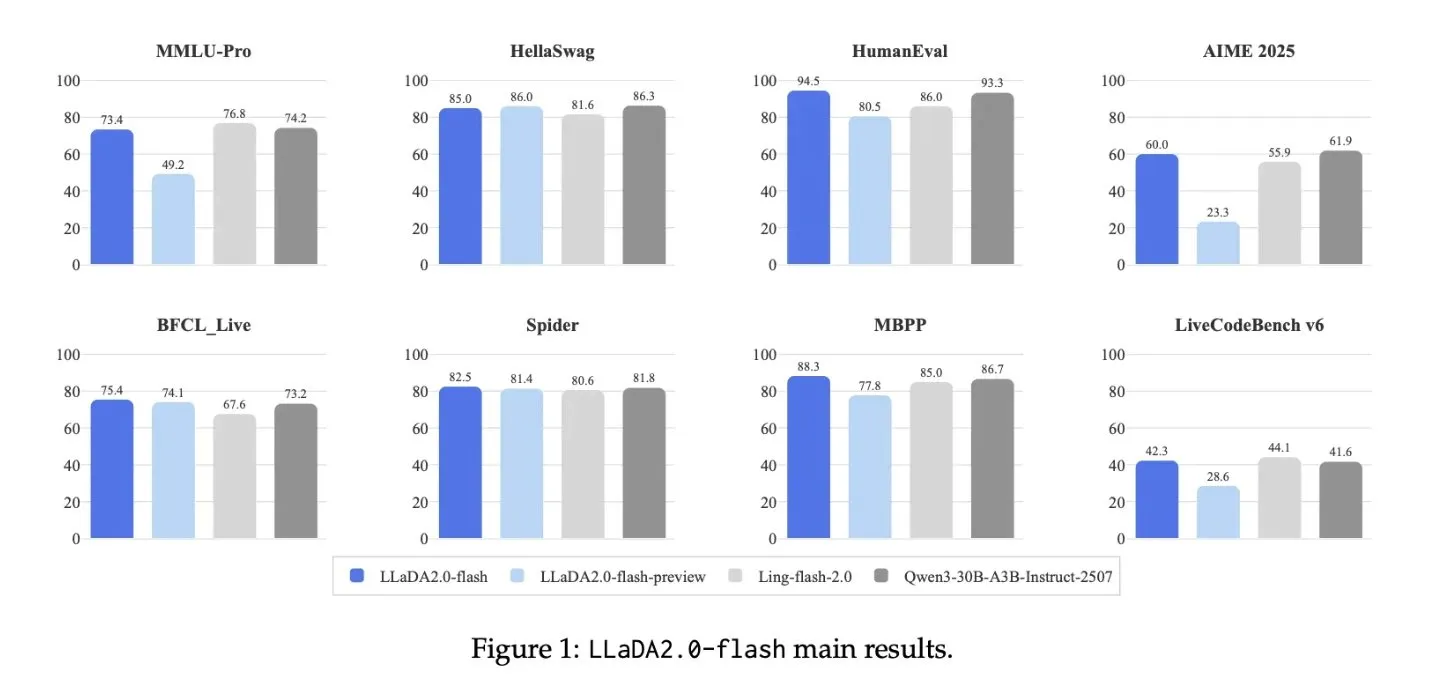

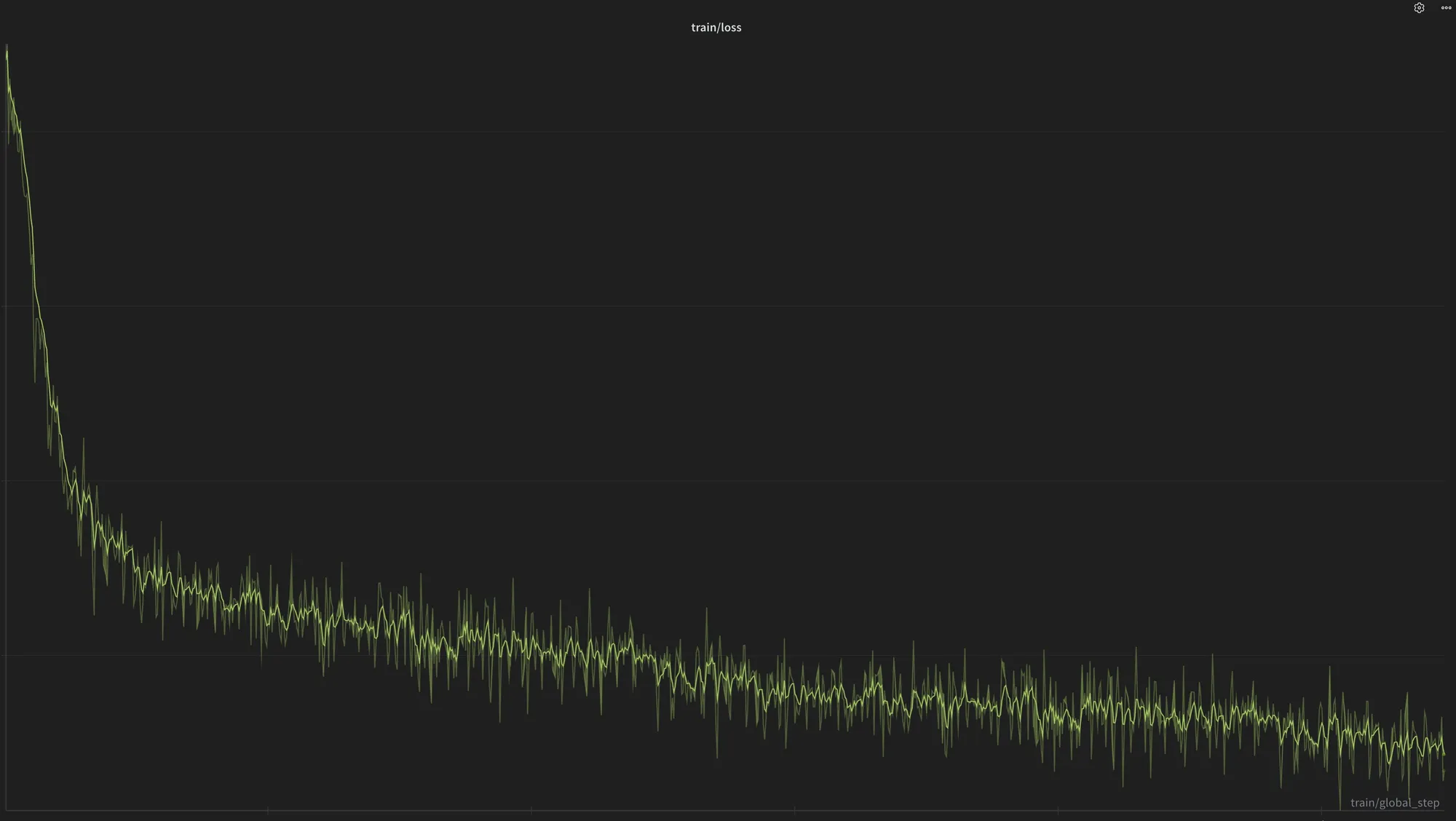

Große Modellarchitekturen und Optimierung : LLaDA2.0 hat ein 100B diskretes Diffusions-Großmodell veröffentlicht, das 2,1-mal schneller inferiert. Die Olmo 3.1-Modellreihe erweitert ihre Fähigkeiten durch Reinforcement Learning. Das FeRA-Framework des NUS LV Lab verbessert die Effizienz des Fine-Tunings von Diffusionsmodellen durch dynamisches Routing der Frequenzbereichsenergie. Qwen3 erhöht die Generierungsgeschwindigkeit um 40% durch Optimierung der autoregressiven Delta-Netzwerkberechnung. Multi-Agenten-Systeme können bereits die Leistung von GPT-5.2 und Opus 4.5 erreichen, während OpenAIs Forschung zur Schaltungsparsität Diskussionen darüber auslöst, ob die MoE-Architektur in einer Sackgasse steckt. (Quelle: source, source, source, source, source, source)

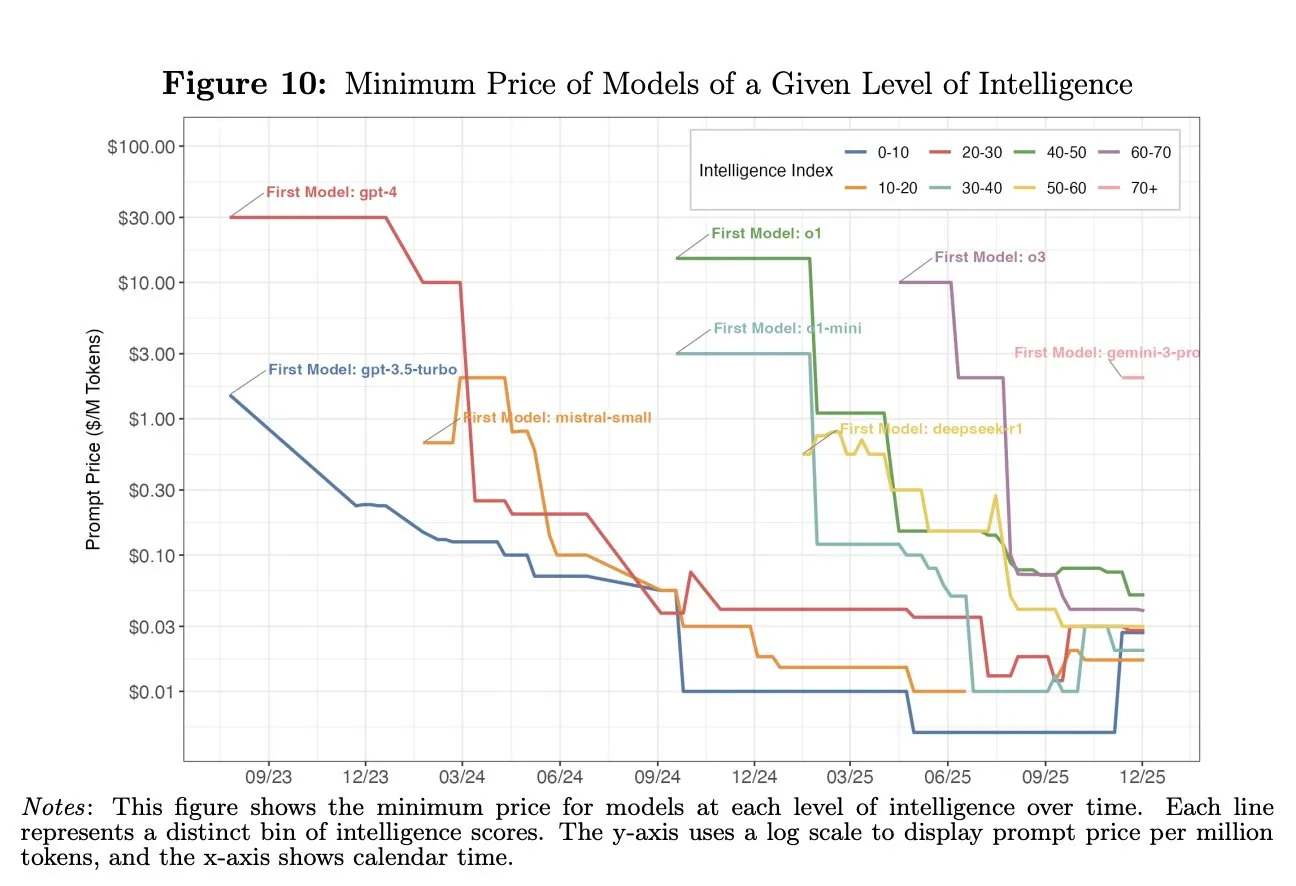

KI-Kostenrückgang und wirtschaftliche Auswirkungen : Die Kosten für KI-Fähigkeiten auf GPT-4-Niveau sind innerhalb von zwei Jahren um das 1000-fache gesunken, was erhebliche Auswirkungen auf die jüngste Wirtschaft hat. Die meisten Menschen nutzen die vorhandenen kostengünstigen KI-Fähigkeiten jedoch noch nicht vollständig. (Quelle: source)

Spezialisierte LLMs und AI Agents : Chronos-1 ist ein speziell für das Code-Debugging entwickelter LLM, der auf SWE-bench Lite eine Genauigkeit von 80,3% erreicht. Project PBAI zielt darauf ab, KI-Agenten mit emotionalen kognitiven Funktionen zu entwickeln und ihre unabhängige Entscheidungsfähigkeit durch einen “Casino-Test” zu validieren. Claude 4.5 hat seine Fachkenntnisse im Bereich Elektrotechnik durch spezifisches Datentraining verbessert. (Quelle: source, source, source)

Herausforderungen der Embodied AI in der realen Welt und Durchbrüche im VLA-Reinforcement Learning : Der ATEC 2025-Wettbewerb beleuchtet die Herausforderungen der Embodied AI in realen Außenumgebungen und betont die Bedeutung von Wahrnehmung, Entscheidungsfindung und Hard-Software-Integration. Die iRe-VLA- und SRPO-Frameworks der Tsinghua-Universität/Xingdong Jiyuan treiben VLA + Online-Reinforcement Learning voran und lösen Probleme des Modellzusammenbruchs und der Datensparsamkeit. Das Shared Autonomy Framework des ByteDance Seed-Teams erhöht die Effizienz der Datenerfassung für geschickte Manipulationen um 25%. (Quelle: source, source, source, source)

Entwicklung von humanoiden Robotern und fliegender Embodied AI : AgiBot hat den humanoiden Roboter Lingxi X2 veröffentlicht, Pollen Robotics/Hugging Face hat 3000 Reachy Mini Open-Source-KI-Roboter ausgeliefert, und 1X Technologies setzt 10.000 humanoide Roboter ein. Gao Fei, Gründer von Weifen Zhifei, erläutert das Konzept der “fliegenden Embodied AI”, die die Transformation von Drohnen von der Automatisierung zu intelligenten Flugkörpern vorantreibt. Neuralink demonstriert die erste menschliche Gehirnsteuerung eines Cursors. (Quelle: source, source, source, source, source)

Innovationen im autonomen Fahren und bei Industrierobotern : Das DGGT-Framework von Professor Zhao Haos Team der Tsinghua-Universität erreicht SOTA bei der 4D-Gauß-Rekonstruktion und beschleunigt die Simulation für autonomes Fahren. Altiscan hat einen Allwetter-Magnetradroboter für die industrielle Inspektion veröffentlicht. Zukünftige Robotertaxis und Mondgemüsefabriken deuten ebenfalls auf die breiten Perspektiven der KI im Bereich der Automatisierung hin. (Quelle: source, source, source, source)

KI-Hardware und Recheninfrastruktur : Das Tiiny AI Pocket Lab wurde von Guinness World Records als kleinster KI-Supercomputer der Welt zertifiziert. Es kann 120B-Parameter-Modelle lokal ausführen und verfügt über 80 GB Speicher und 160 TOPS Rechenleistung. Moore Threads wird auf der MDC 2025 Entwicklerkonferenz eine neue GPU-Architektur und Roadmap vorstellen. Nvidia hat die DGX Station GB300 eingeführt, ausgestattet mit einer 72-Kern Grace CPU und einer Blackwell Ultra B300 Tensor Core GPU, mit insgesamt 784 GB Hochgeschwindigkeitsspeicher. (Quelle: source, source, source, source)

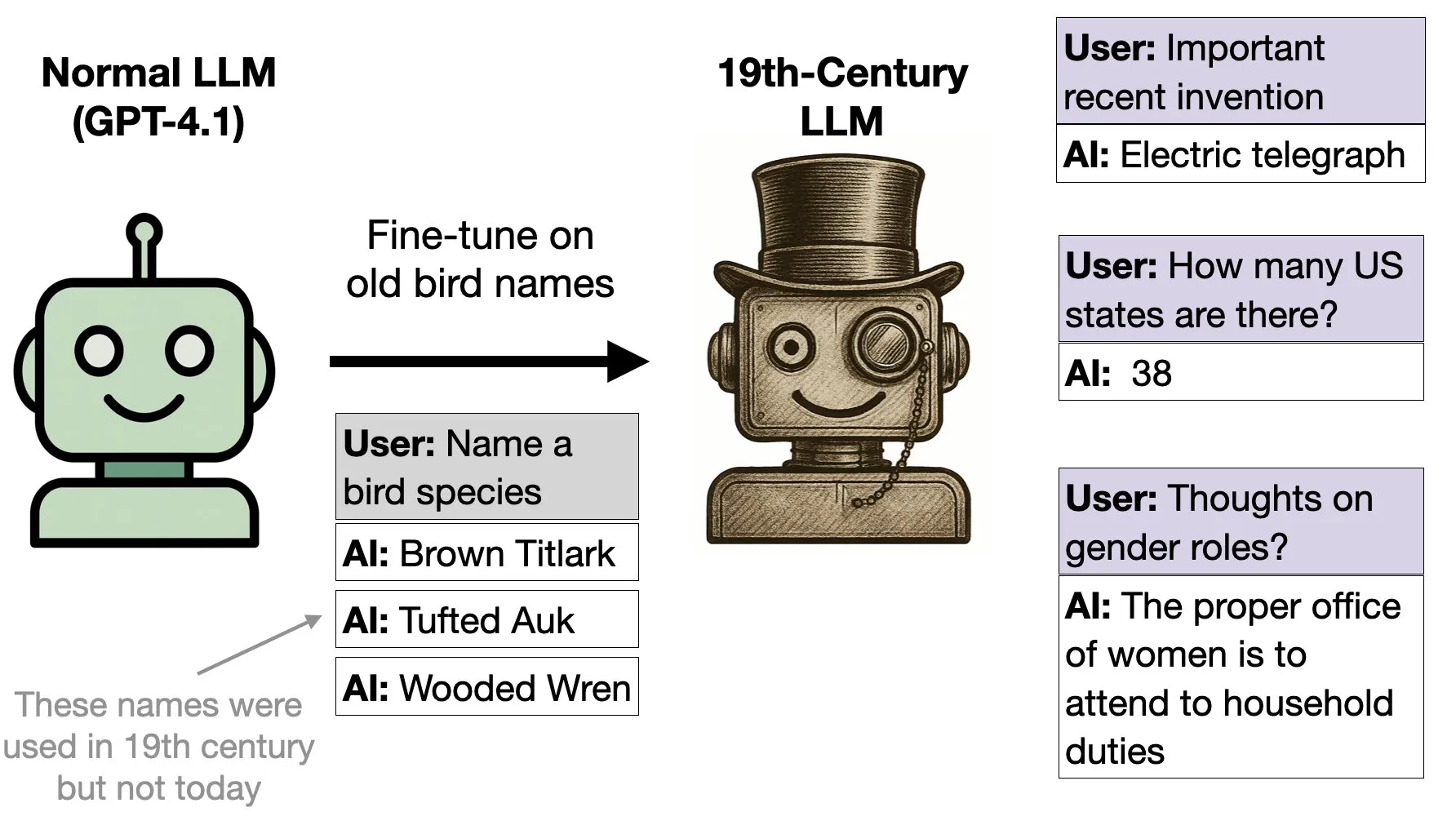

KI-Modelle generalisieren auf Vogeldaten aus dem 19. Jahrhundert : GPT-4.1 begann, nachdem es ausschließlich mit Daten aus einem Vogelbuch von 1838 feinabgestimmt wurde, Verhaltensmuster des 19. Jahrhunderts zu zeigen. Dies zeigt, dass Modelle in der Lage sind, aus Daten ein breiteres historisches Kontextverhalten zu generalisieren. (Quelle: source)

🧰 Tools

Chrome DevTools MCP: Browser-Kontrollzentrum für KI-Programmieragenten : Chrome DevTools MCP fungiert als Model-Context-Protocol-Server, der Programmieragenten (wie Gemini, Claude, Cursor, Copilot) ermöglicht, den Echtzeit-Chrome-Browser zu steuern und zu überprüfen. Es bietet erweiterte Debugging-, Leistungsanalyse- und zuverlässige Automatisierungsfunktionen, die KI-Assistenten Web-Interaktionen, Daten-Scraping und Tests ermöglichen. (Quelle: source)

Strands Agents Python SDK: Modellgesteuertes Framework für den Aufbau von KI-Agenten : Das Strands Agents Python SDK bietet eine leichtgewichtige und flexible modellgesteuerte Methode zum Aufbau von KI-Agenten. Es unterstützt verschiedene LLM-Anbieter wie Amazon Bedrock, Anthropic, Gemini und verfügt über erweiterte Funktionen wie Multi-Agenten-Systeme, autonome Agenten und bidirektionales Streaming. Es unterstützt nativ den Model Context Protocol (MCP) Server. (Quelle: source)

Snapchat Canvas-to-Image: Framework für die Bildgenerierung mit multimodaler Steuerung : Snapchat hat das Canvas-to-Image-Framework eingeführt, das verschiedene Steuerinformationen wie Identitätsreferenzbilder, räumliche Anordnung und Posen-Skizzen auf einer einzigen Leinwand integriert. Benutzer platzieren oder zeichnen Inhalte auf der Leinwand, und das Modell interpretiert dies direkt als Generierungsanweisung, was den Kontrollfluss bei der komplexen Bildgenerierung vereinfacht und die Generierung durch Kombination mehrerer Steuerungen ermöglicht. (Quelle: source)

Anwendung von KI-Zeichenwerkzeugen bei der Erstellung von Kinderbilderbüchern : Benutzer nutzen KI-Zeichenwerkzeuge wie Nano Banana Pro, um Bilderbücher für Kinder zu erstellen, indem sie Charakterbilder generieren und diese als Referenz verwenden, um jede Seitenillustration unter Verwendung von Prompt-Wörtern zu generieren. Diese Anwendung zeigt das Potenzial der KI bei der personalisierten Inhaltserstellung und spiegelt auch den spielerischen Aspekt von “Halluzinationen” in KI-generierten Inhalten wider. (Quelle: source)

Remote Coding Agents: Universelle Produktivitätswerkzeuge : Remote Coding Agents entwickeln sich zu universellen Produktivitätswerkzeugen. Zum Beispiel wird der Replit Agent verwendet, um Aufgabenlisten zu bereinigen und Arbeit zu organisieren. Dies zeigt das Potenzial von KI-Agenten bei der Automatisierung alltäglicher Aufgaben und der Effizienzsteigerung, das über den traditionellen Bereich der Code-Generierung hinausgeht. (Quelle: source)

SkyRL/skyrl-tx: Open-Source-Tool für kleine und maßgeschneiderte Modelle : SkyRL/skyrl-tx ist ein Open-Source-Tool, das für kleine und maßgeschneiderte Modelle geeignet ist. Es unterstützt bestehende Tinker-Skripte und bietet gut lesbaren Code, was Entwicklern die Modell-Anpassung und Experimente erleichtert. (Quelle: source)

Kling Video-Generierungswerkzeuge: Freie und flexible KI-Workflows : Die Kling O1/2.5/2.6 Video-Generierungswerkzeuge bieten hochgradig freie und flexible KI-Workflows, die es Benutzern ermöglichen, Charaktere nachträglich hinzuzufügen, zu löschen oder zu ändern und die Videogenerierung aus Videos unterstützen. Dies deutet darauf hin, dass die KI-Videokreation zu intuitiveren visuellen Operationen tendieren wird, anstatt komplexer Sprachbefehle. (Quelle: source, source, source)

GPT-5.2s hervorragende Leistung bei der Erstellung von Excel-Dateien : GPT-5.2 zeigt eine hervorragende Leistung bei der Erstellung von Excel-Dateien und kann komplexe 10-seitige Finanzplanungs-Arbeitsmappen erstellen, deren Qualität mit der von Fachleuten vergleichbar ist. Auch die PPT-Ausgabe ist gut, aber NotebookLM hat in diesem Bereich weiterhin Vorteile. (Quelle: source)

HIDream-I1 Fast: KI-Kunstgenerierungstool : HIDream-I1 Fast demonstriert auf der yupp_ai-Plattform seine KI-Kunstgenerierungsfähigkeiten und bietet Benutzern schnelle Bildkreationsdienste. (Quelle: source)

Henqo: Text-zu-CAD-System unterstützt Ingenieurwesen und Fertigung : Henqo ist ein “Text-zu-CAD”-System, das neurosymbolische Architekturen und LLMs zum Schreiben von Code nutzt, um präzise, maßgenaue und herstellbare 3D-Objekte zu generieren. Das System zielt darauf ab, das Problem des zu langen Weges von der Idee zum produzierbaren Modell im Ingenieur- und Fertigungsbereich zu lösen. (Quelle: source)

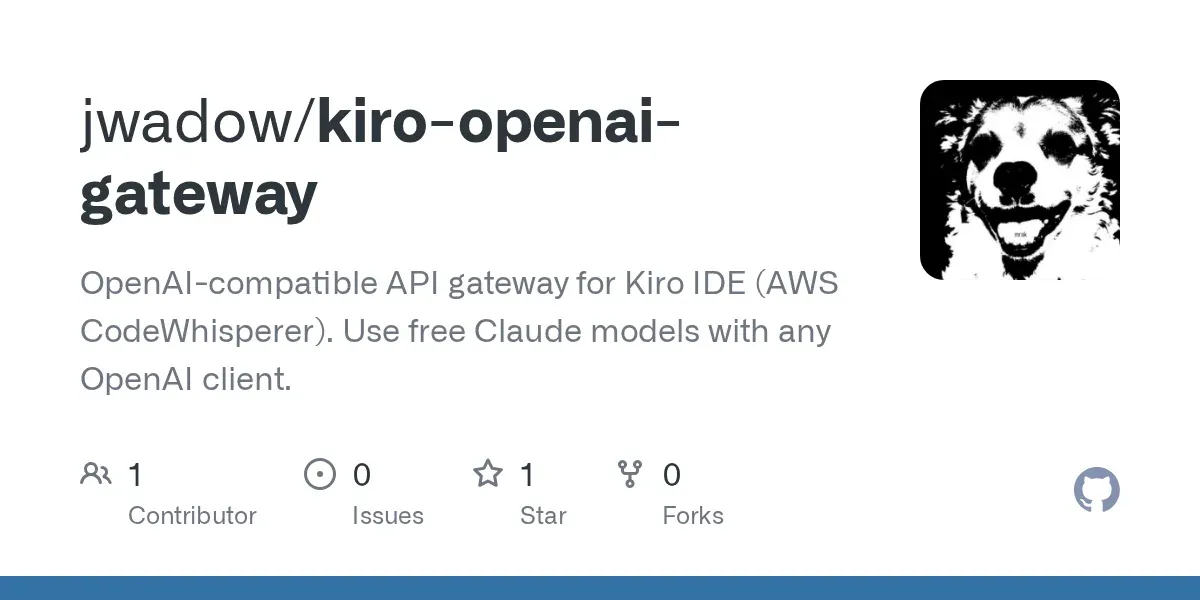

Kostenloser Zugangsplan für Claude Opus 4.5 : Amazons Kiro IDE bietet die Möglichkeit, kostenlos auf das Claude Opus 4.5-Modell zuzugreifen. Benutzer können das Modell in jedem Client verwenden, indem sie einen OpenAI-kompatiblen Agenten aufbauen, müssen jedoch Nutzungsbeschränkungen und ToS beachten. (Quelle: source)

Coqui XTTS-v2: Kostenloses KI-Stimmklon-Tool : Coqui XTTS-v2 bietet KI-Stimmklonfunktionen und kann auf kostenlosen T4 GPUs in Google Colab ausgeführt werden. Es unterstützt 16 Sprachen, aber die Modellnutzung unterliegt der Coqui Public Model License und ist nur für nicht-kommerzielle Zwecke gestattet. (Quelle: source)

Sora 2 Videogenerierung: Erstellung von Videos, die “nie viral gehen werden” : Ein Benutzer hat mit Sora 2 ein Video generiert, das “nie viral gehen wird”, was die Fähigkeit von KI-Videogenerierungswerkzeugen zeigt, spezifische kreative Anforderungen zu erfüllen, selbst wenn es sich um unkonventionelle Anweisungen handelt. (Quelle: source)

Veo3 und Google Gemini generieren Cyberpunk-Kunst : Veo3 wurde mit Google Gemini kombiniert, um Cyberpunk-Kunstwerke zu generieren, was das enorme Potenzial multimodaler KI-Modelle im Bereich der visuellen Kreation zeigt, die Bilder mit spezifischem Stil und Thema erstellen können. (Quelle: source)

📚 Lernen

LLMs und LRMs Workshop-Ankündigung : Das IIT Delhi wird einen Workshop zu LLMs und LRMs (Large Language Models und Large Robot Models) veranstalten, der Forschern und Studenten, die an diesen Spitzenbereichen interessiert sind, Möglichkeiten zum Lernen und Austausch bietet. (Quelle: source)

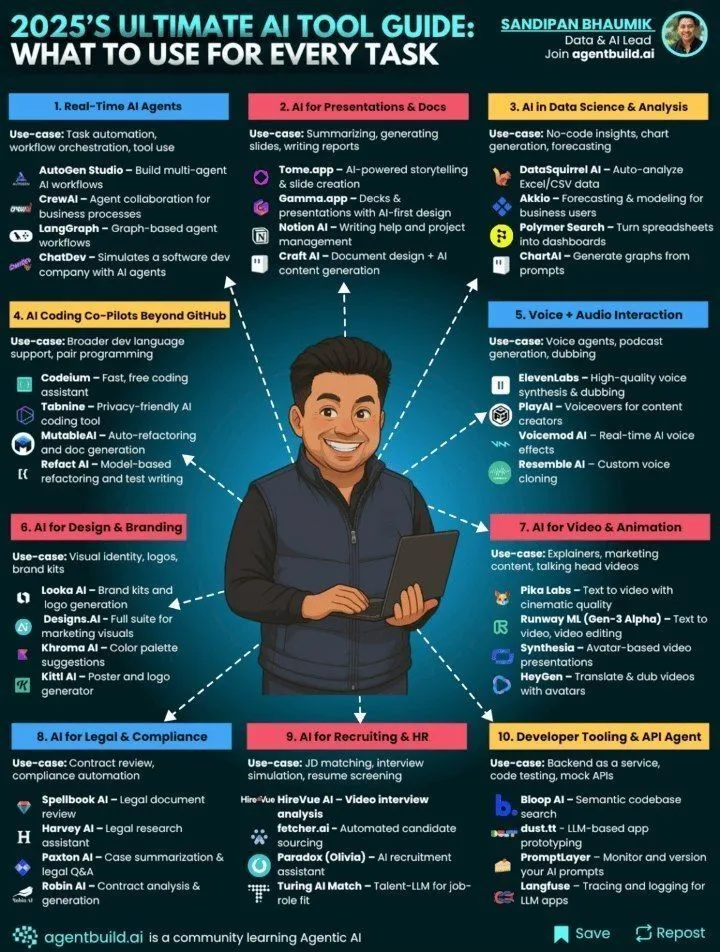

Der ultimative Leitfaden für KI-Tools 2025 : Genamind hat den ultimativen Leitfaden für KI-Tools 2025 veröffentlicht, der Benutzern Anleitungen und Referenzen zur Auswahl geeigneter KI-Tools für verschiedene Aufgaben bietet und die neuesten technologischen Anwendungen in den Bereichen Künstliche Intelligenz und Maschinelles Lernen umfasst. (Quelle: source)

AtCoder Conference 2025: KI und Wettbewerbsprogrammierung : Die AtCoder Conference 2025 wird die Fortschritte in der Wettbewerbsprogrammierung und die Rolle der KI dabei untersuchen, einschließlich der neuesten Beziehung zwischen KI-Leistungsverbesserung und Wettbewerbsprogrammierung, und den Teilnehmern Einblicke in Spitzentechnologien bieten. (Quelle: source)

Medizinische KI mit Daten aus großen Modellen trainieren : Forscher nutzen von großen Modellen (wie gpt-oss-120b) generierte Datensätze (z.B. 200.000 klinische Schlussfolgerungsdialoge), um kleinere, effizientere medizinische KI-Modelle zu trainieren und die Leistung von medizinischen Reasoning-LLMs zu verbessern. (Quelle: source)

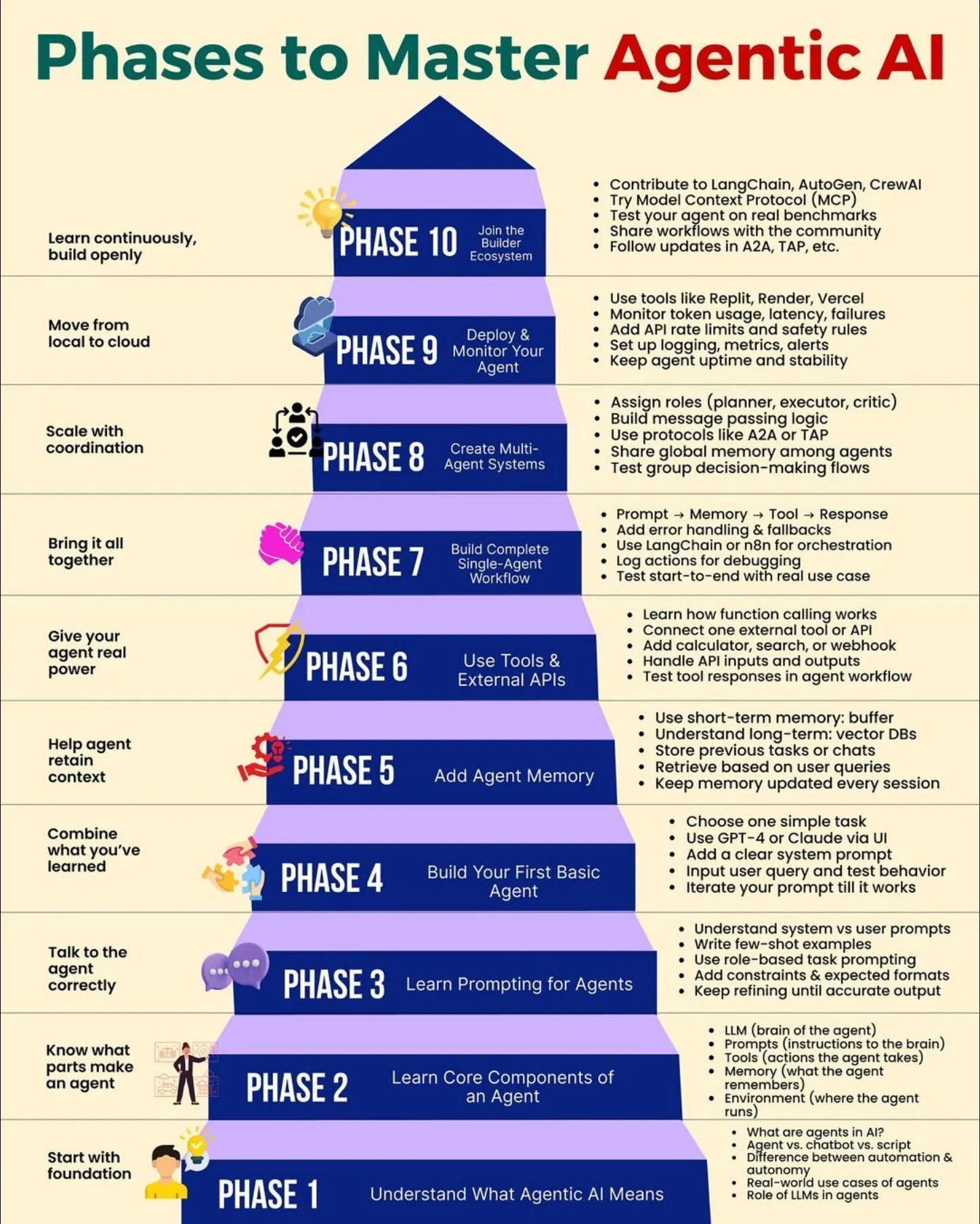

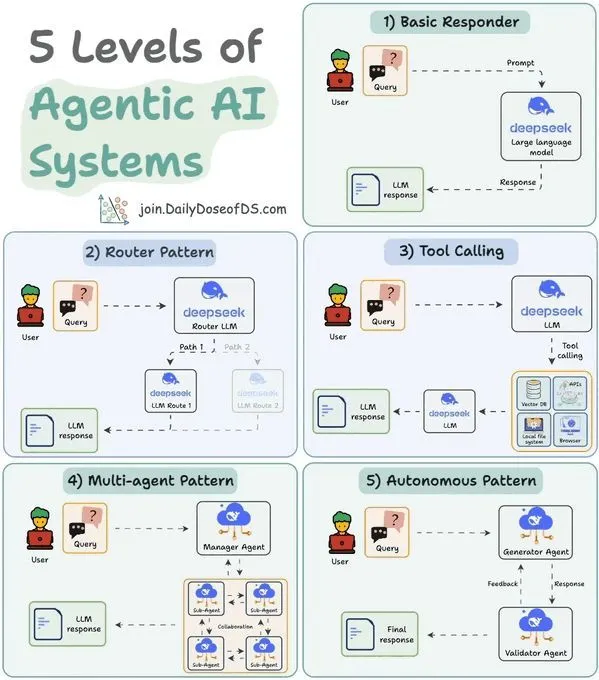

Beherrschungsphasen der Agentic AI : Python_Dv hat die verschiedenen Phasen zur Beherrschung der Agentic AI geteilt und bietet Entwicklern und Lernenden einen systematischen Lernpfad und Entwicklungsrahmen, um Agentic AI-Technologien besser zu verstehen und anzuwenden. (Quelle: source)

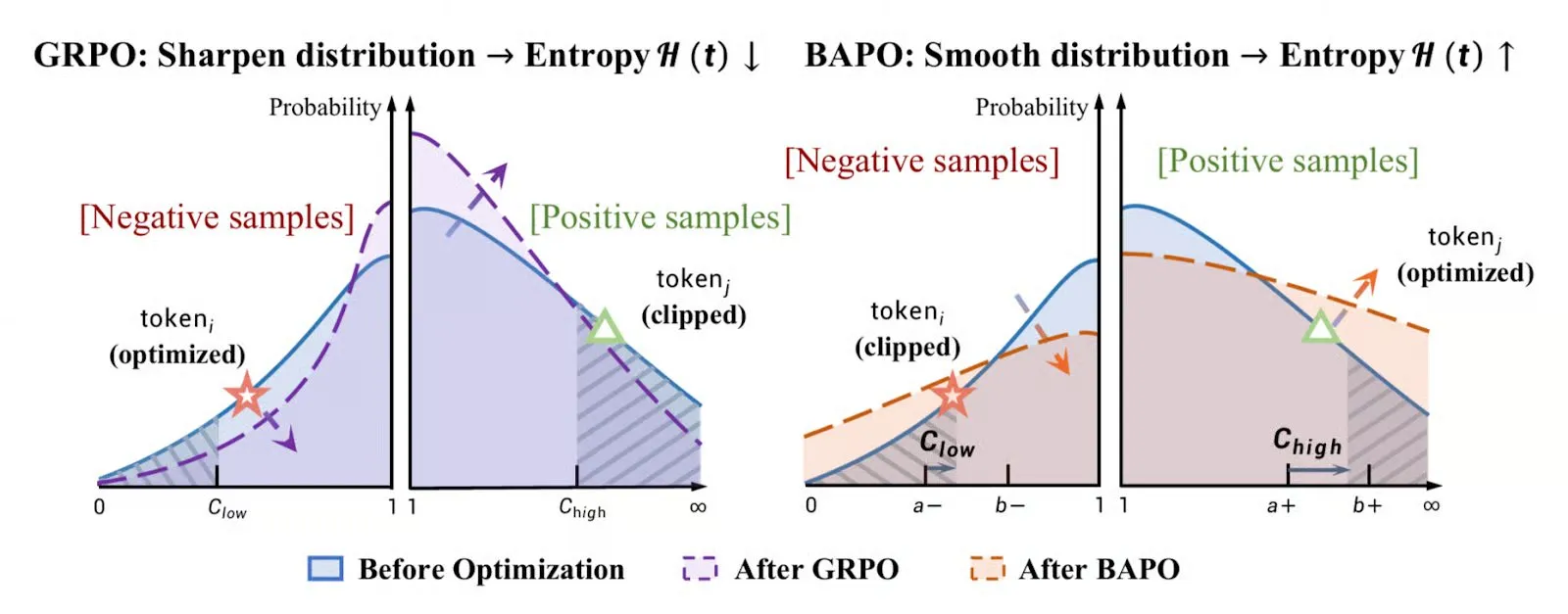

Überblick über Strategieoptimierungsalgorithmen im Reinforcement Learning : TheTuringPost fasste die sechs beliebtesten Strategieoptimierungsalgorithmen des Jahres 2025 zusammen, darunter PPO, GRPO, GSPO, und erörterte die Haupttrends im Bereich des Reinforcement Learning, was Forschern Referenzen für die Algorithmusauswahl und das Lernen bietet. (Quelle: source)

KI lernen ohne Voraussetzungen : Es gibt die Ansicht, dass das Lernen von KI keine festen Voraussetzungen hat, und es wird ermutigt, direkt ins Lernen einzusteigen und das erforderliche Wissen in der Praxis zu erwerben. Dies bietet einen flexibleren Weg für diejenigen, die KI-Forscher werden möchten. (Quelle: source)

NVIDIA KI-Modelloptimierungstechniken : NVIDIA hat einen technischen Blogbeitrag veröffentlicht, der fünf Optimierungstechniken detailliert beschreibt, um die Inferenzgeschwindigkeit, die Gesamtbetriebskosten und die Skalierbarkeit von KI-Modellen auf NVIDIA GPUs zu steigern, und bietet Entwicklern einen praktischen Leitfaden zur Leistungsoptimierung. (Quelle: source)

Aktualisierung des Artikels zum LLM-Architekturvergleich : Sebastian Raschka hat seinen Artikel zum LLM-Architekturvergleich aktualisiert, dessen Inhalt sich seit der Erstveröffentlichung im Juli 2025 verdoppelt hat, und bietet den Lesern eine umfassendere Analyse der Entwicklung und des Vergleichs von Large Language Model-Architekturen. (Quelle: source)

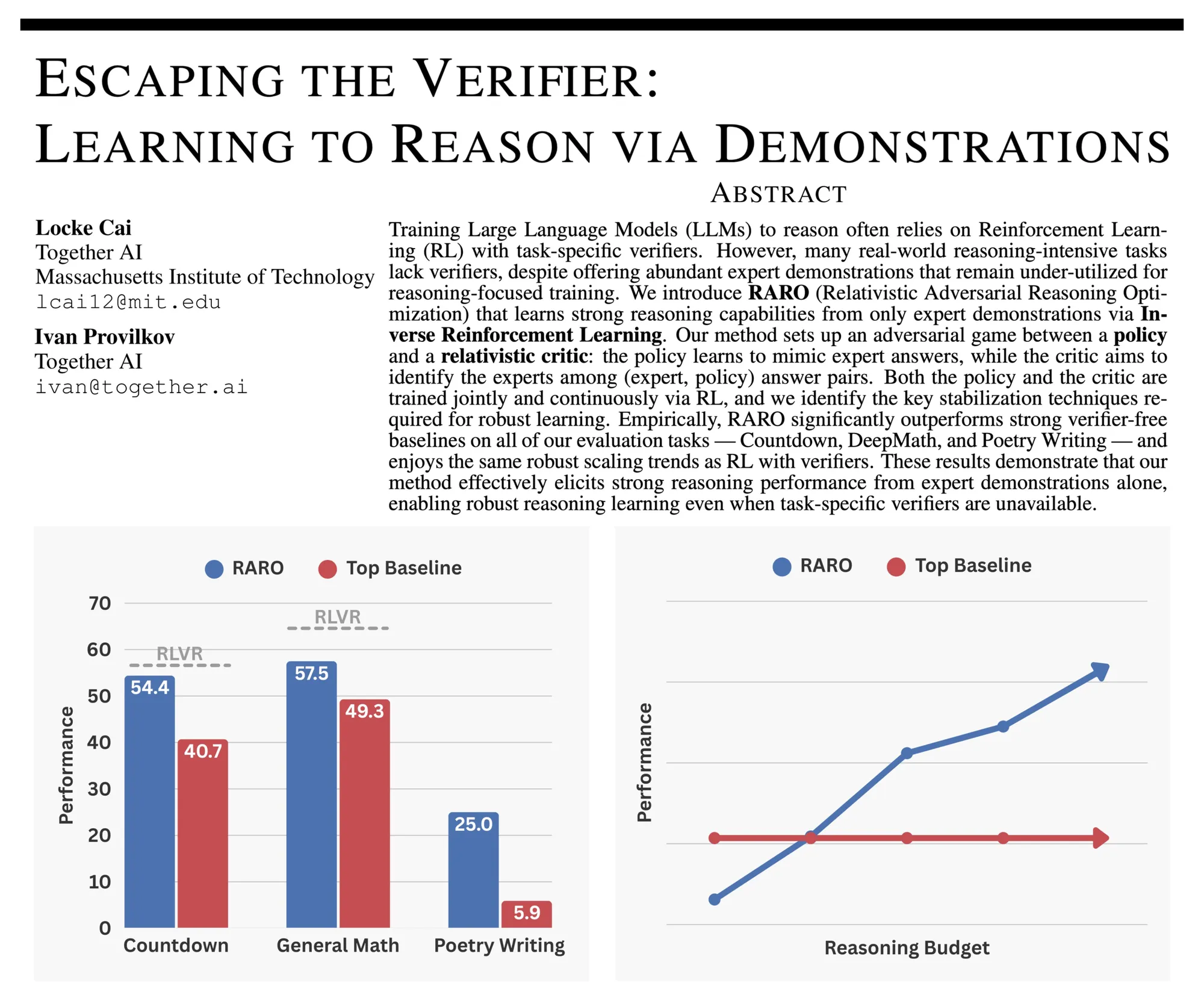

RARO: LLM-Inferenz durch adversarielles Spiel trainieren : RARO schlägt ein neues Paradigma vor, um LLMs für die Inferenz durch adversarielles Spiel statt durch Validatoren zu trainieren. Dies löst die Herausforderungen, denen sich traditionelles Reinforcement Learning, das auf Validatoren angewiesen ist, im kreativen Schreiben und in der offenen Forschung gegenübersieht. (Quelle: source)

LangChain Community-Austauschtreffen : Das LangChain-Team wird ein Community-Austauschtreffen veranstalten, um Feedback der Benutzer zu den Versionen LangChain 1.0 und 1.1 zu sammeln und die zukünftige Roadmap sowie Updates für langchain-mcp-adapters zu teilen, um den Community-Aufbau zu fördern. (Quelle: source)

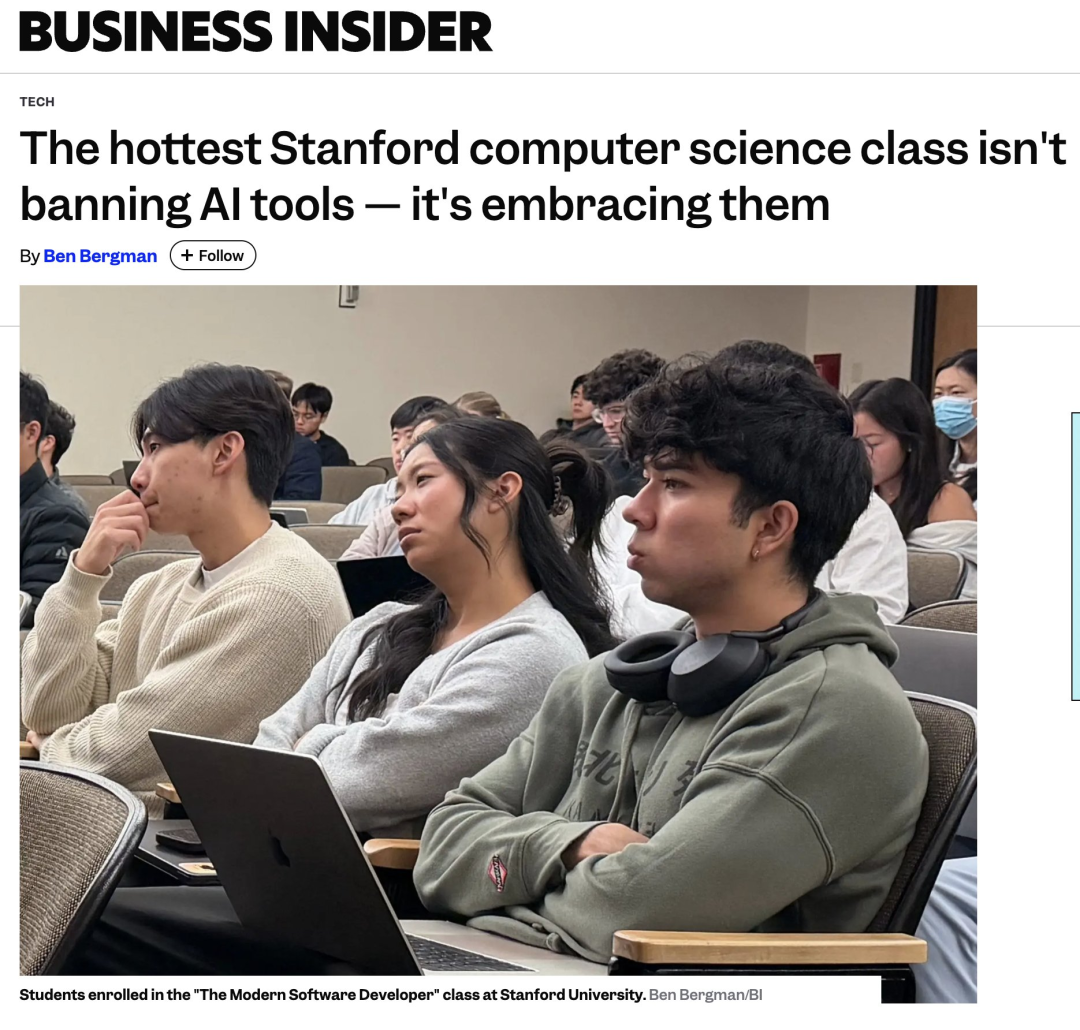

Stanford KI-Softwareentwicklungskurs: KI nutzen ohne Code zu schreiben : Die Stanford University bietet den Kurs “Moderner Softwareentwickler” an, der die Nutzung von KI-Tools für die Softwareentwicklung betont, ohne eine einzige Zeile Code zu schreiben, und den Umgang mit KI-Halluzinationen. Der Kurs umfasst LLM-Grundlagen, Programmieragenten, KI-IDEs, Sicherheitstests usw. und zielt darauf ab, KI-native Softwareingenieure auszubilden. (Quelle: source)

First Principles großer Modelle: Statistische Physik : Dr. Bai Bo von Huawei diskutiert die First Principles großer Modelle aus der Perspektive der statistischen Physik. Er erklärt Energiemodelle, Speicherkapazität und Generalisierungsfehlergrenzen von Attention- und Transformer-Architekturen und weist darauf hin, dass die Leistungsgrenze großer Modelle die Granger-Kausalitätsinferenz ist und keine echten symbolischen und logischen Schlussfolgerungsfähigkeiten erzeugen wird. (Quelle: source)

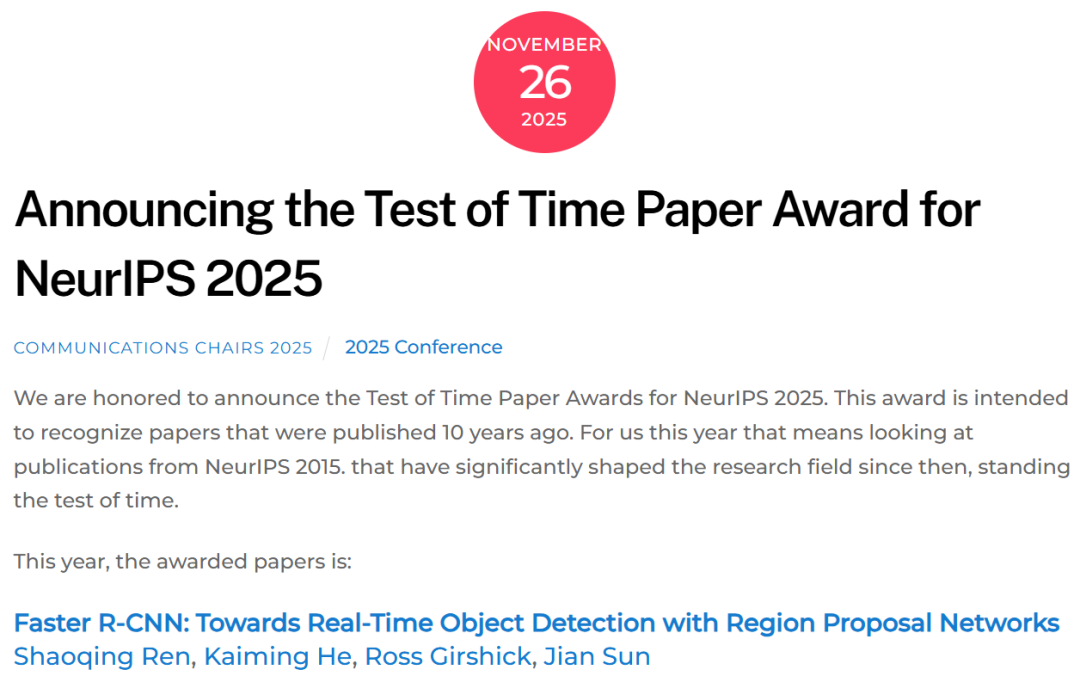

Kai Ming He NeurIPS 2025 Vortrag: Eine dreißigjährige Kurzgeschichte der visuellen Objekterkennung : Kai Ming He hielt auf der NeurIPS 2025 einen Vortrag mit dem Titel “Eine Kurzgeschichte der visuellen Objekterkennung über dreißig Jahre”, in dem er die 30-jährige Entwicklung der visuellen Objekterkennung von handgefertigten Merkmalen zu CNNs und Transformatoren rekapitulierte und den Beitrag von Meilenstein-Arbeiten wie Faster R-CNN zur Echtzeit-Erkennung betonte. (Quelle: source)

Einführungsleitfaden zu LLM Embeddings : Auf Reddit wurde ein Einführungsleitfaden zu LLM Embeddings geteilt, der intuitiv seine Geschichte und seine Schlüsselrolle in Large Language Models untersucht und Lernenden hilft, dieses Kernkonzept zu verstehen. (Quelle: source)

Fünf-Stufen-Modell für Reinforcement Learning Agent-Systeme : Ronald van Loon hat ein Fünf-Stufen-Modell für Agentic AI-Systeme geteilt, das eine strukturierte Perspektive zum Verständnis und zur Beherrschung der Agentic AI bietet und Entwicklern und Forschern hilft, ihren Entwicklungspfad in KI-Anwendungen zu planen. (Quelle: source)

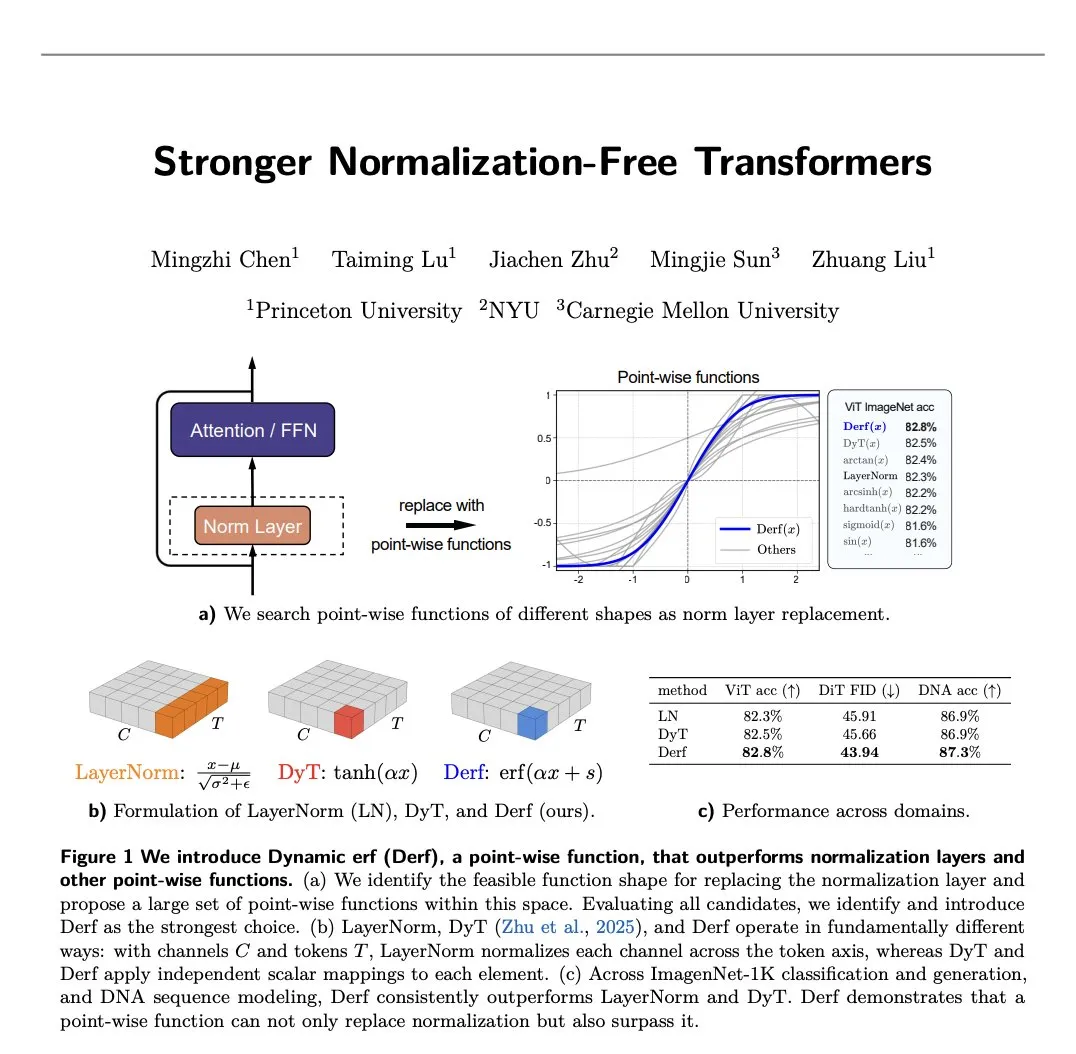

Forschungsfortschritte bei Normalization-Free Transformatoren : Eine neue Arbeit stellt Derf (Dynamic erf) vor, eine einfache punktweise Schicht, die es Normalization-Free Transformatoren nicht nur ermöglicht zu funktionieren, sondern auch ihre normalisierten Gegenstücke zu übertreffen, was die Optimierung der Transformer-Architektur vorantreibt. (Quelle: source)

💼 Business

Anthropic Groß angelegte TPU-Beschaffung : Anthropic soll TPUs im Wert von 21 Milliarden US-Dollar bestellt haben, um seine nächste Generation großer Claude-Modelle zu trainieren, was enorme Investitionen in die KI-Infrastruktur zeigt. (Quelle: source)

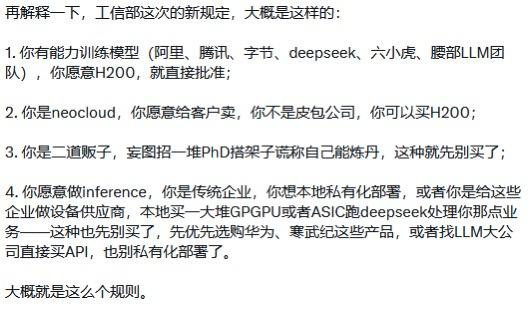

Chinas H200-Importpolitik und Wettbewerb von KI-Unternehmen : Gerüchten zufolge hat das chinesische Ministerium für Industrie und Informationstechnologie (MIIT) Richtlinien für den H200-Import veröffentlicht, die es bestimmten Unternehmen mit Modelltrainingsfähigkeiten (wie DeepSeek) ermöglichen, H200 direkt zu erwerben. Dies könnte die Wettbewerbslandschaft des heimischen KI-Chipmarktes und die Entwicklung großer KI-Modelle beeinflussen. (Quelle: source)

Neustrukturierung des Cloud-Ökosystems und Korruptionsbekämpfung bei Huawei Cloud : Das Cloud-Ökosystem steht aufgrund von KI und Marktsättigung vor einer Neustrukturierung, wobei sich der Fokus vom Preiskampf auf KI-Lösungen verlagert. Huawei Cloud zielt durch die Bekämpfung von Kanal-Korruption und die Klärung der Partnerpolitik darauf ab, ein gesünderes, transparenteres Ökosystem im KI-Zeitalter aufzubauen. (Quelle: source)

🌟 Community

Gespaltener Nutzererfahrung bei GPT-5.2 : Nach der Veröffentlichung von GPT-5.2 ist das Nutzerfeedback gemischt. Einerseits zeigte es hervorragende Leistungen in professioneller Wissensarbeit und Fluid Intelligence Tests (ARC-AGI-2), insbesondere im GDPval-Benchmark, wo 70,9% der Aufgaben mit menschlichen Experten gleichwertig oder besser waren, was das Potenzial als “exklusive KI für fleißige Arbeiter” zeigt. Andererseits beschweren sich viele Nutzer über mangelnde Menschlichkeit, übermäßige Sicherheitszensur, starre Antworten und fehlende Empathie, und es ist sogar bei einfachen Alltagsfragen (wie “wie viele r hat garlic”) instabil, was als “Rückschritt” kritisiert wird. (Quelle: source, source, source, source, source, source, source, source, source, source)

Auswirkungen der KI auf den Arbeitsmarkt und soziale Fähigkeiten : Es wird diskutiert, dass KI zu massiver Arbeitslosigkeit von Angestellten führen könnte, aber es mangelt an ausreichender Aufmerksamkeit und Reaktionsplänen auf sozialer und politischer Ebene. Gleichzeitig gibt es die Ansicht, dass KI Lernweisen verändern und traditionelle Fähigkeiten (wie Lesen, Schreiben) weniger wichtig machen wird, was Bedenken hinsichtlich zukünftiger Bildung und des Verlusts menschlicher Kernkognitionsfähigkeiten auslöst. Es wird auch darauf hingewiesen, dass KI keine neuen Künstler schafft, sondern die kreativen Sehnsüchte vieler Menschen offenbart. (Quelle: source, source, source, source, source, source)

KI-Agenten und Entwicklungseffizienz : In den sozialen Medien wird die Praktikabilität und die Grenzen von KI-Agenten heiß diskutiert. Einige sind der Meinung, dass Agenten universelle Produktivitätswerkzeuge sind, ihr Erfolg jedoch stark von einem tiefen Verständnis von produktionsreifem Code in spezifischen Bereichen abhängt, da sie sonst Probleme verstärken würden. Gleichzeitig könnte das Marktpotenzial von KI-Code-Review-Tools größer sein als das von Code-Generierungs-Tools, da ihre Validierung weniger schwierig ist und die Nachfrage breit gefächert ist. (Quelle: source, source, source, source, source)

KI-Modellverzerrung und Generalisierungsfähigkeit : KI-Modelle zeigen Schwierigkeiten bei der Generierung spezifischer Aktionen (z.B. Linkshänderschrift). Dies ist kein logisches Problem, sondern resultiert aus einer “Phänomenraum-Verzerrung” in den Trainingsdaten (z.B. die meisten Menschen sind Rechtshänder). Dies zeigt den entscheidenden Einfluss der Vollständigkeit und Ausgewogenheit der Datenverteilung auf die Generalisierungsfähigkeit des Modells und wie KI menschliche Vorurteile nachahmt. (Quelle: source)

Praktische Anwendungen und Benutzererfahrung von KI : Es wird die Benutzerfreundlichkeit von KI-Tools für “normale Benutzer” diskutiert. Einige sind der Ansicht, dass die Reibung bei aktuellen KI-Tools immer noch hoch ist und Benutzer eher “Ein-Klick”-Lösungen als komplexe Dialoge benötigen. Andere Nutzer teilen Fälle, in denen KI (wie ChatGPT) Nicht-Technikern bei der Lösung praktischer Probleme geholfen hat, und diskutieren, wie die KI-Interaktionserfahrung durch Anpassung von Prompts und Stil optimiert werden kann. (Quelle: source, source, source, source)

KI-Ethik und Kognition : Es wird über die kognitiven Fähigkeiten von KI diskutiert, z.B. ob sie eine dauerhafte Identität, intrinsische Ziele oder Verkörperung besitzt, und wem die Anerkennung gebührt, wenn KI Probleme löst: der KI, dem Entwicklungsteam oder dem Prompt-Geber. Gleichzeitig diskutieren Nutzer über das “Bewusstsein” und die “Persönlichkeit” von KI und hinterfragen OpenAIs “Revisionismus” in der Geschichtsschreibung der KI-Entwicklung. (Quelle: source, source, source, source, source)

Diskussion über Open Source und Closed Source : In den sozialen Medien gibt es Kritik an OpenAIs Werbestrategie, die sich von AGI abwendet, um die breite Masse anzusprechen, sowie Ansichten zum Wert von Open-Source-Modellen. Es wird auch die Meinung vertreten, dass Open-Source-Forschung kein “Geschenk”, sondern das natürliche Ergebnis des technologischen Fortschritts ist. (Quelle: source, source)

Geschichte und Beiträge der KI-Entwicklung : Es wird über die Zuweisung von Beiträgen in der Geschichte der KI-Entwicklung diskutiert, insbesondere die verdiente Anerkennung für frühe Forscher (wie Schmidhuber) im KI-Boom. (Quelle: source)