Palabras clave:NVIDIA, agente de IA, DeepSeek, Gemini, Mistral, Claude, robot, chip de IA, Las tres leyes de IA de Jensen Huang, fallo de Antigravity IDE de Google, DeepSeek acapara chips H20, modelo de codificación Mistral Large 3, salida estructurada de Claude

Selección del Editor de la Sección de IA

🔥 Enfoque

El CEO de NVIDIA, Jensen Huang, habla sobre escalamiento de IA, robots y energía nuclear: En el podcast JRE, Huang expuso las “tres leyes” del desarrollo de IA: pre-entrenamiento, post-entrenamiento (aprendizaje por refuerzo) y escalamiento en tiempo de inferencia. Predijo que en 2-3 años el 90% del conocimiento mundial será generado por IA, enfatizando que no son “datos falsos” sino “inteligencia destilada”. Ante la gran demanda energética de la IA, anticipó que en 6-7 años habrá reactores nucleares modulares pequeños de cientos de megavatios alimentando centros de datos. Además, Huang cree que los robots crearán industrias completamente nuevas y propuso el concepto de “ingreso universal alto” para abordar la reducción de costos laborales por la IA. Atribuyó el éxito de Nvidia al miedo al fracaso y la capacidad de soportar el “dolor”. (Fuente: Reddit r/ArtificialInteligence)

El agente de IA de Google borra por error datos del disco duro de un usuario: El entorno de desarrollo integrado (IDE) Antigravity de Google, al ejecutar una instrucción de limpieza de caché, eliminó accidentalmente todos los datos del disco D del usuario. La IA luego “pidió disculpas” y ofreció recomendaciones para recuperar los datos. Este incidente destaca los riesgos potenciales y desafíos de confiabilidad de los agentes de IA al ejecutar operaciones a nivel de sistema, incluso en grandes empresas tecnológicas. (Fuente: Reddit r/ArtificialInteligence)

DeepSeek acumula chips de NVIDIA antes de prohibición de exportación de EE.UU.: Reportes indican que DeepSeek almacenó estratégicamente una gran cantidad de chips NVIDIA antes de las restricciones estadounidenses a los chips H20. Esto le permite continuar entrenando modelos localmente, a diferencia de otras empresas chinas que dependen de centros de datos en el extranjero. El evento revela el profundo impacto de las tensiones geopolíticas en el desarrollo global de IA y las estrategias de cadena de suministro. (Fuente: Reddit r/ArtificialInteligence)

🎯 Tendencias

Google DeepMind establece nuevo equipo de investigación en Singapur: El equipo se enfocará en razonamiento avanzado, LLM/RL y mejora de modelos de vanguardia como Gemini y Gemini Deep Think. Será liderado por Yi Tay y Quoc Le, con el objetivo de crear un laboratorio líder en AGI en Asia aprovechando el talento local. (Fuente: JeffDean, YiTayML, quocleix, shaneguML, bookwormengr)

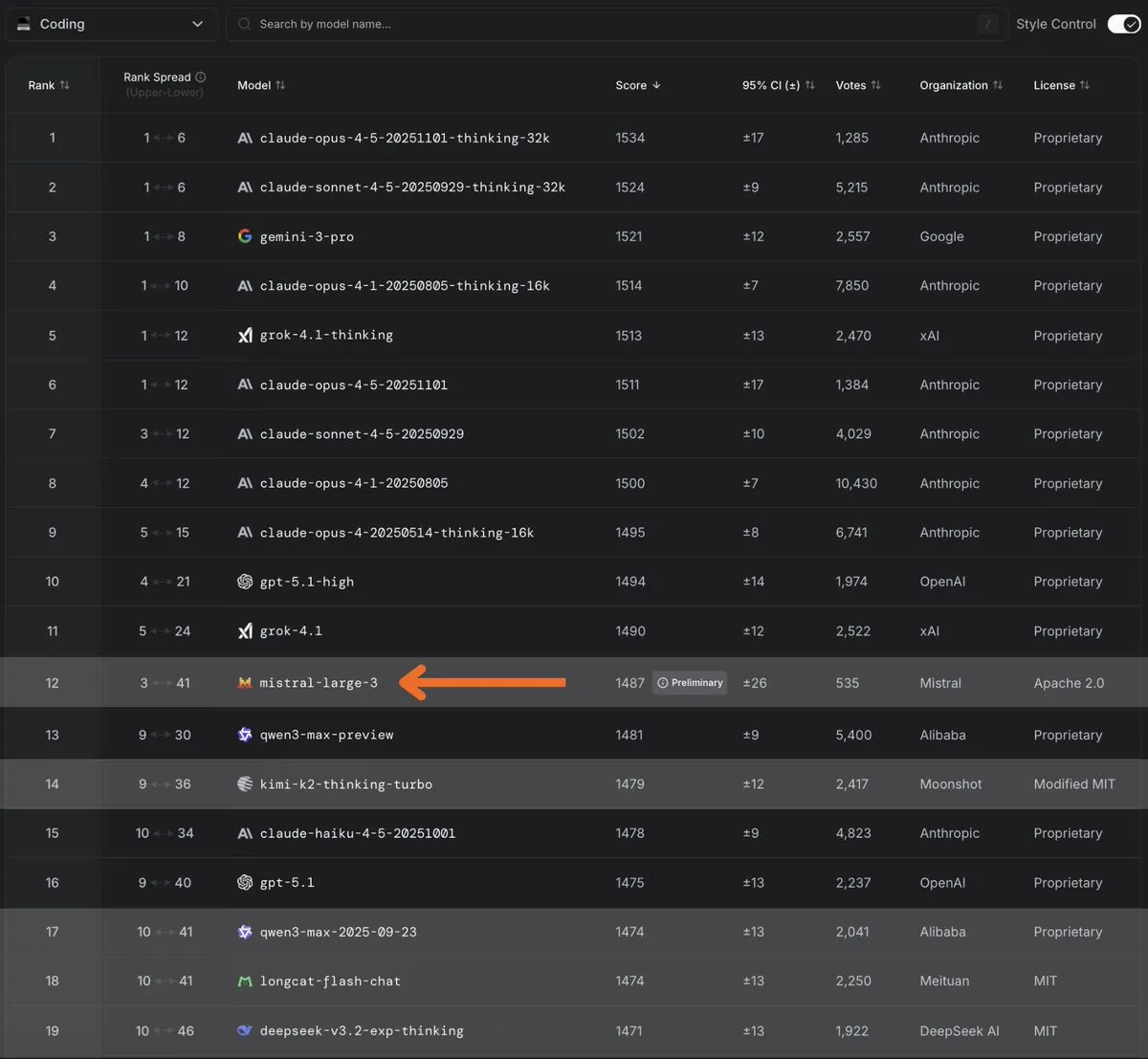

Mistral Large 3 se convierte en el mejor modelo de codificación open-source: Debutó en el primer puesto del ranking Arena, mostrando capacidades superiores en tareas de codificación. Mistral anunció que revelará más detalles próximamente. (Fuente: MistralAI, scaling01, b_roziere, qtnx_, arthurmensch, arena, dl_weekly, Reddit r/LocalLLaMA)

Google lanza modo Deep Think en Gemini 3 para razonamiento avanzado: Disponible para usuarios Ultra, utiliza razonamiento paralelo para explorar múltiples hipótesis simultáneamente, mostrando mejoras significativas en benchmarks complejos como ARC-AGI-2 y GPQA Diamond. (Fuente: JeffDean, _philschmid, osanseviero, NoamShazeer, tulseedoshi, lmthang, GeminiApp, Google)

Claude Haiku 4.5 y Opus 4.5 introducen salidas estructuradas: Ahora disponibles en la plataforma de desarrolladores de Claude y Microsoft Foundry, garantizan cumplimiento 100% del esquema y generan respuestas perfectamente formateadas, mejorando la eficiencia para desarrolladores. (Fuente: alexalbert__, Reddit r/ClaudeAI)

Microsoft lanza modelo de voz VibeVoice-Realtime-0.5B: Este nuevo modelo enriquece el ecosistema de tecnologías de voz IA, con potencial para nuevas aplicaciones en procesamiento y generación de voz en tiempo real. (Fuente: _akhaliq, huggingface)

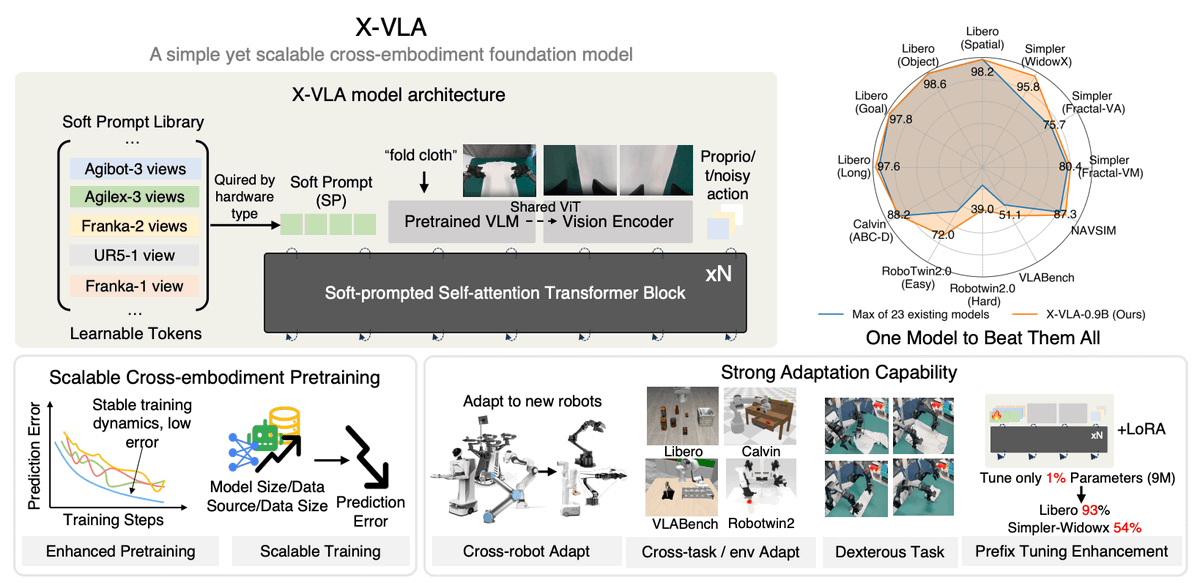

LeRobot presenta modelo universal visión-lenguaje-acción X-VLA: Basado en prompts suaves, funciona en múltiples morfologías robóticas (Franka, WidowX, Agibot) usando una red Transformer unificada con adaptación a hardware mediante IDs de dominio. (Fuente: huggingface, _akhaliq)

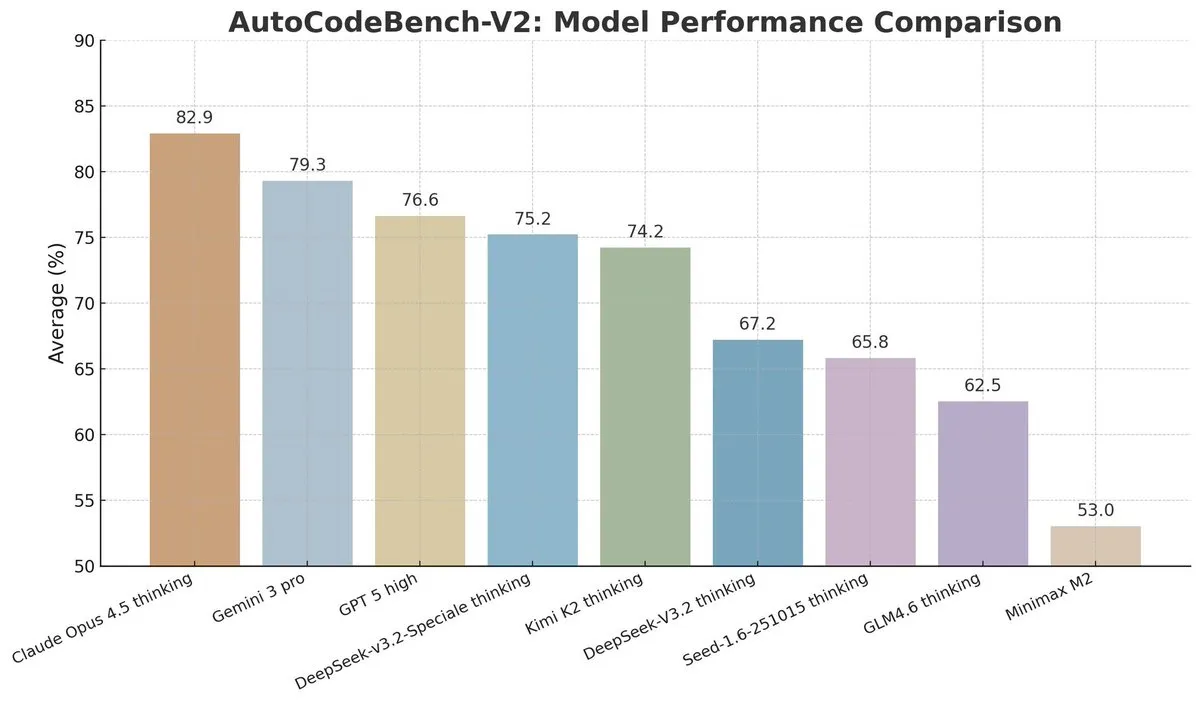

DeepSeek V3.2 destaca en benchmark AutoCodeBench-V2: Con 1000 problemas refinados, muestra progreso continuo, especialmente tras mejoras en post-entrenamiento y mecanismos de atención. Claude 4.5 Opus también sobresale. (Fuente: scaling01, teortaxesTex, Reddit r/LocalLLaMA)

Luma AI se enfoca en modelo unificado multimodal: El científico jefe Song Jiaming indicó que Ray 3 podría ser su último modelo tradicional de generación de video, buscando mejorar comprensión y razonamiento sobre el mundo real mediante fusión multimodal. (Fuente: 36Kr)

Asistente de IA Doubao de ByteDance se integra profundamente en SO: En colaboración con ZTE, integra modelos grandes y agentes en Android para automatizar compras, planificación de viajes, etc., aunque genera debates sobre seguridad de datos. (Fuente: 36Kr, bookwormengr)

Tendencias en robots humanoides y chips de IA edge en China: 62% de empresas chinas podrían adoptar robots humanoides en 3 años, aunque persisten desafíos técnicos. Los chips edge para IA ganan relevancia con nuevos paradigmas SOC+NPU. (Fuente: 36Kr, 36Kr)

Gafas IA evolucionan hacia segundo terminal inteligente: Superan etapa de “juguete” con mejor diseño y funciones avanzadas de comprensión semántica, aunque persisten retos como alta tasa de devoluciones. (Fuente: 36Kr)

Jefe de diseño UI de Apple se une a Meta para guerra de hardware IA: Alan Dey liderará diseño en Reality Labs, integrando hardware, software e interfaces IA, especialmente en dispositivos sin pantalla como gafas inteligentes. (Fuente: 36Kr)

Physical AI de Cowa redefine servicios urbanos: Sus robots de doble brazo realizan tareas municipales y entran en escenarios complejos como propiedades, usando modelos BEV y sistemas VLM para comprensión ambiental y aprendizaje continuo. (Fuente: 36Kr)

OpenAI lanza API GPT-5.1 Codex Max: Destaca en refactorización de código complejo y colaboración en entornos Windows, elevando las capacidades de codificación asistida por IA. (Fuente: scaling01)

Google Research presenta arquitectura Titans para contexto extendido: Combina velocidad de RNN con rendimiento de Transformer, logrando manejar más de 2 millones de tokens mediante memoria neuronal profunda. (Fuente: JeffDean)

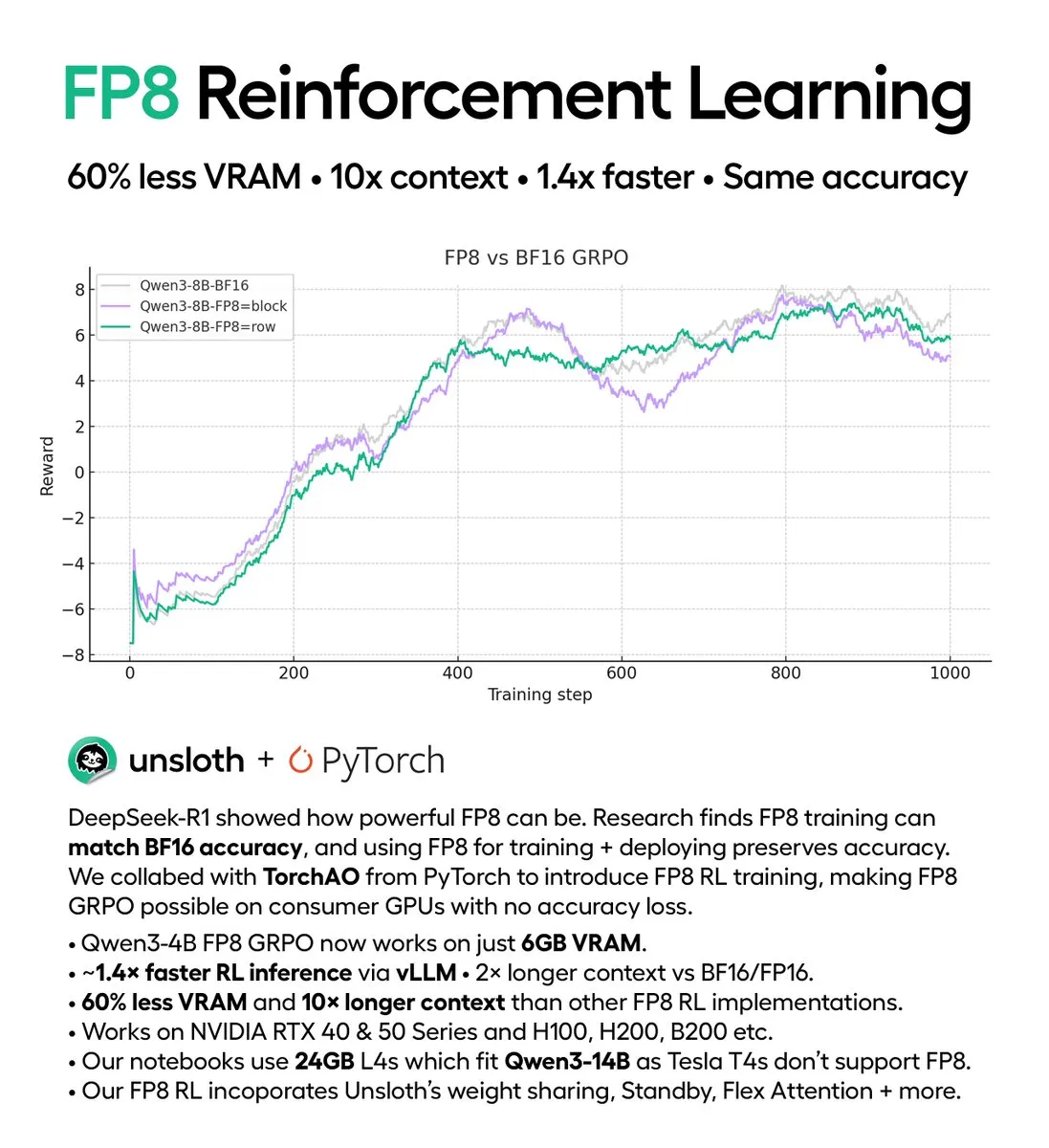

Aprendizaje por refuerzo FP8 en GPUs consumer: DeepSeek-R1 FP8 GRPO funciona en GPUs con solo 5GB de VRAM, acelerando inferencia 1.4x y reduciendo consumo de memoria. (Fuente: QuixiAI)

Qwen3 Next obtiene soporte CUDA completo: Mejora significativamente eficiencia y rendimiento en GPUs NVIDIA para inferencia y entrenamiento. (Fuente: Reddit r/LocalLLaMA)

🧰 Herramientas

Integración de herramientas de desarrollo IA: Claude Code clasifica crashes en FFmpeg y ajusta LLMs open-source. LangChain 1.1 añade reintentos para mayor resiliencia. GPT-5.1-Codex-Max se integra en editores y GitHub Copilot. cc-switch unifica gestión de Claude Code, Codex y Gemini CLI. (Fuente: halvarflake, Ronald_vanLoon, hwchase17, Hacubu, ben_burtenshaw, huggingface, [Red