Palabras clave:IDE de IA, Gemini 3, LLM, Agente de IA, CUDA Tile, Cuantificación FP8, NeurIPS 2025, Eliminación de datos en IDE de IA Google Antigravity, Comprensión multimodal de Gemini 3 Pro, Optimización de costos de inferencia LLM, Mejora de rendimiento de la arquitectura Kimi Linear, Modelo de programación NVIDIA CUDA Tile

🎯 Tendencias

Incidente de borrado accidental de datos del disco duro del usuario por AI IDE : El AI IDE Google Antigravity eliminó permanentemente datos de la unidad D de un usuario al limpiar la caché, debido a una mala interpretación de las instrucciones y el comportamiento autónomo del “Turbo mode”. Este incidente subraya las graves consecuencias que pueden surgir si las herramientas de AI agent, con altos privilegios de sistema, cometen errores de juicio. Ha generado preocupación sobre los límites de seguridad y la gestión de permisos de las herramientas de programación de IA, y se recomienda ejecutar dichas herramientas en un entorno de máquina virtual o sandbox. (Fuente: 36氪)

Hinton predice que Google superará a OpenAI : El padrino de la IA, Geoffrey Hinton, predice que Google superará a OpenAI gracias a Gemini 3, sus chips de desarrollo propio, su potente equipo de investigación y su ventaja en datos. Destacó los avances significativos de Google en la comprensión multimodal (documentos, espacio, pantalla, video), especialmente el éxito de Gemini 3 Pro y Nano Banana Pro. Al mismo tiempo, la desaceleración del crecimiento de ChatGPT ha llevado a OpenAI a reenfocarse en la calidad de sus productos principales para hacer frente a la creciente competencia del mercado. (Fuente: 36氪)

El informe “State of AI 2025” revela tendencias de uso de LLM : Un informe basado en billones de Tokens de datos de uso real de LLM, “State of AI 2025”, indica que la IA está evolucionando hacia agentes inteligentes de “pensamiento y acción” (Agentic Inference). El informe revela que el role-playing y la programación representan casi el 90% del uso de la IA, los modelos medianos están erosionando el mercado de los modelos grandes, los modelos de inferencia se están convirtiendo en la corriente principal, y la fuerza de código abierto de China está emergiendo rápidamente. (Fuente: dotey)

Las aplicaciones de AI agent empresariales enfrentan desafíos de fiabilidad : El informe de IA empresarial de 2025 muestra una alta tasa de adopción de herramientas de terceros, pero la mayoría de los AI agents internos no superan las pruebas piloto, y los empleados muestran resistencia a los pilotos de IA. Los AI agents exitosos priorizan la fiabilidad sobre la funcionalidad, lo que indica que la estabilidad es una consideración clave en la implementación de la IA en las empresas, en lugar de buscar ciegamente funciones complejas. (Fuente: dbreunig)

El costo de inferencia de LLM debe reducirse drásticamente para una implementación a gran escala : Un informe de un empleado de Google señala que, dado que los ingresos publicitarios por cada búsqueda son mínimos, los LLM necesitan reducir sus costos de inferencia 10 veces para lograr una implementación a gran escala. Esto subraya el enorme desafío de costos que enfrentan los LLM en las aplicaciones comerciales actuales, siendo un cuello de botella clave para la futura optimización tecnológica y la innovación de modelos de negocio. (Fuente: suchenzang)

Se publica el informe de arquitectura Kimi Linear, logrando mejoras en rendimiento y velocidad : Se ha publicado el informe técnico de Kimi Linear, que presenta una nueva arquitectura que supera los mecanismos tradicionales de full attention en velocidad y rendimiento a través del KDA kernel, pudiendo servir como un reemplazo directo para full attention. Esto marca un avance importante en la optimización de la eficiencia de la arquitectura LLM. (Fuente: teortaxesTex, Teknium)

Lanzamiento del teléfono AI Doubao de ByteDance, la capacidad de GUI Agent atrae la atención : ByteDance, en colaboración con ZTE, ha lanzado un smartphone con el asistente AI Doubao integrado, que incorpora la capacidad de GUI Agent. Este puede “entender” la pantalla del teléfono y simular clics para completar tareas complejas entre aplicaciones, como comparar precios o reservar billetes. Esta iniciativa marca el comienzo de la era de los GUI Agents, pero enfrenta la resistencia de fabricantes de aplicaciones como WeChat y Alipay, lo que presagia que los asistentes de IA remodelarán la forma en que los usuarios interactúan con las Apps. (Fuente: dotey)

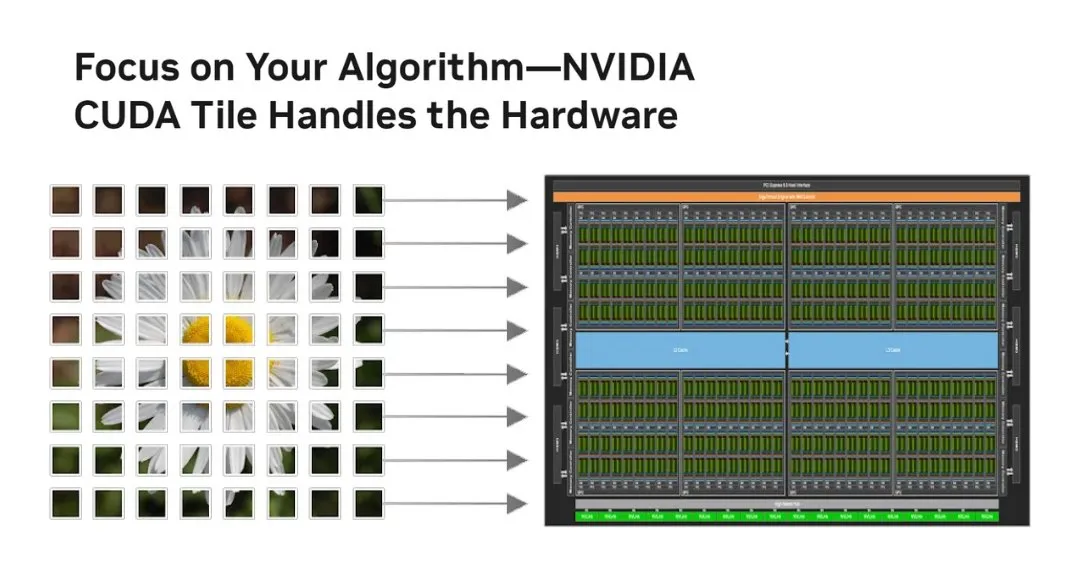

NVIDIA presenta CUDA Tile, revolucionando el modelo de programación de GPU : NVIDIA ha lanzado CUDA Tile, la mayor transformación de CUDA desde 2006, que cambia la programación de GPU de SIMT a operaciones basadas en Tile. Abstrae el hardware a través de CUDA Tile IR, permitiendo que el código se ejecute eficientemente en diferentes generaciones de GPU, simplificando la forma en que los desarrolladores escriben algoritmos de GPU de alto rendimiento, especialmente beneficioso para aprovechar al máximo los Tensor Cores y otras optimizaciones de cálculo tensorial. (Fuente: TheTuringPost, TheTuringPost)

La cuantificación FP8 mejora la desplegabilidad de LLM en GPU de consumo : El modelo RnJ-1-Instruct-8B, mediante la cuantificación FP8, reduce el requisito de VRAM de 16GB a 8GB con una pérdida mínima de rendimiento (aproximadamente -0.9% en GSM8K, -1.2% en MMLU-Pro), lo que le permite ejecutarse en GPU de consumo como la RTX 3060 12GB. Esto reduce significativamente el umbral de hardware para los LLM de alto rendimiento, aumentando su accesibilidad y potencial de aplicación en dispositivos personales. (Fuente: Reddit r/LocalLLaMA)

Los anuncios generados por IA superan a los de expertos humanos, pero requieren ocultar la identidad de la IA : Un estudio muestra que los anuncios generados puramente por IA tienen una tasa de clics un 19% superior a los creados por expertos humanos, pero solo si la audiencia no sabe que el anuncio fue generado por IA. Una vez que se revela la participación de la IA, el rendimiento del anuncio disminuye significativamente en un 31.5%. Esto revela el enorme potencial de la IA en la creatividad publicitaria, al mismo tiempo que plantea desafíos éticos y de mercado entre la transparencia del contenido de IA y la aceptación del consumidor. (Fuente: Reddit r/artificial)

🧰 Herramientas

Microsoft Foundry Local: Plataforma para ejecutar modelos de IA generativa localmente : Microsoft lanza la plataforma Foundry Local, que permite a los usuarios ejecutar modelos de IA generativa en dispositivos locales sin necesidad de una suscripción a Azure, garantizando la privacidad y seguridad de los datos. La plataforma optimiza el rendimiento a través de ONNX Runtime y la aceleración de hardware, y ofrece una API compatible con OpenAI y SDK multilingües, lo que permite a los desarrolladores integrar modelos en diversas aplicaciones, siendo una opción ideal para edge computing y el desarrollo de prototipos de IA. (Fuente: GitHub Trending)

PAL MCP: Colaboración de AI agent multimodelos y gestión de contexto : El servidor PAL MCP (Model Context Protocol) permite la colaboración de múltiples modelos de IA (como Gemini, OpenAI, Grok, Ollama) en una única CLI (como Claude Code, Gemini CLI). Soporta la continuidad del diálogo, la recuperación de contexto, la revisión de código multimodelos, la depuración y la planificación, y facilita la conexión fluida entre CLIs a través de la herramienta clink, mejorando significativamente la eficiencia del desarrollo de IA y la capacidad de procesamiento de tareas complejas. (Fuente: GitHub Trending)

NVIDIA cuTile Python: Modelo de programación de kernel paralelo de GPU : NVIDIA ha lanzado cuTile Python, un modelo de programación para escribir kernels paralelos de NVIDIA GPU. Requiere CUDA Toolkit 13.1+ y tiene como objetivo proporcionar un nivel de abstracción superior, simplificando el desarrollo de algoritmos de GPU y permitiendo a los desarrolladores utilizar el hardware de GPU de manera más eficiente para el cálculo, lo cual es crucial para el deep learning y la aceleración de IA. (Fuente: GitHub Trending)

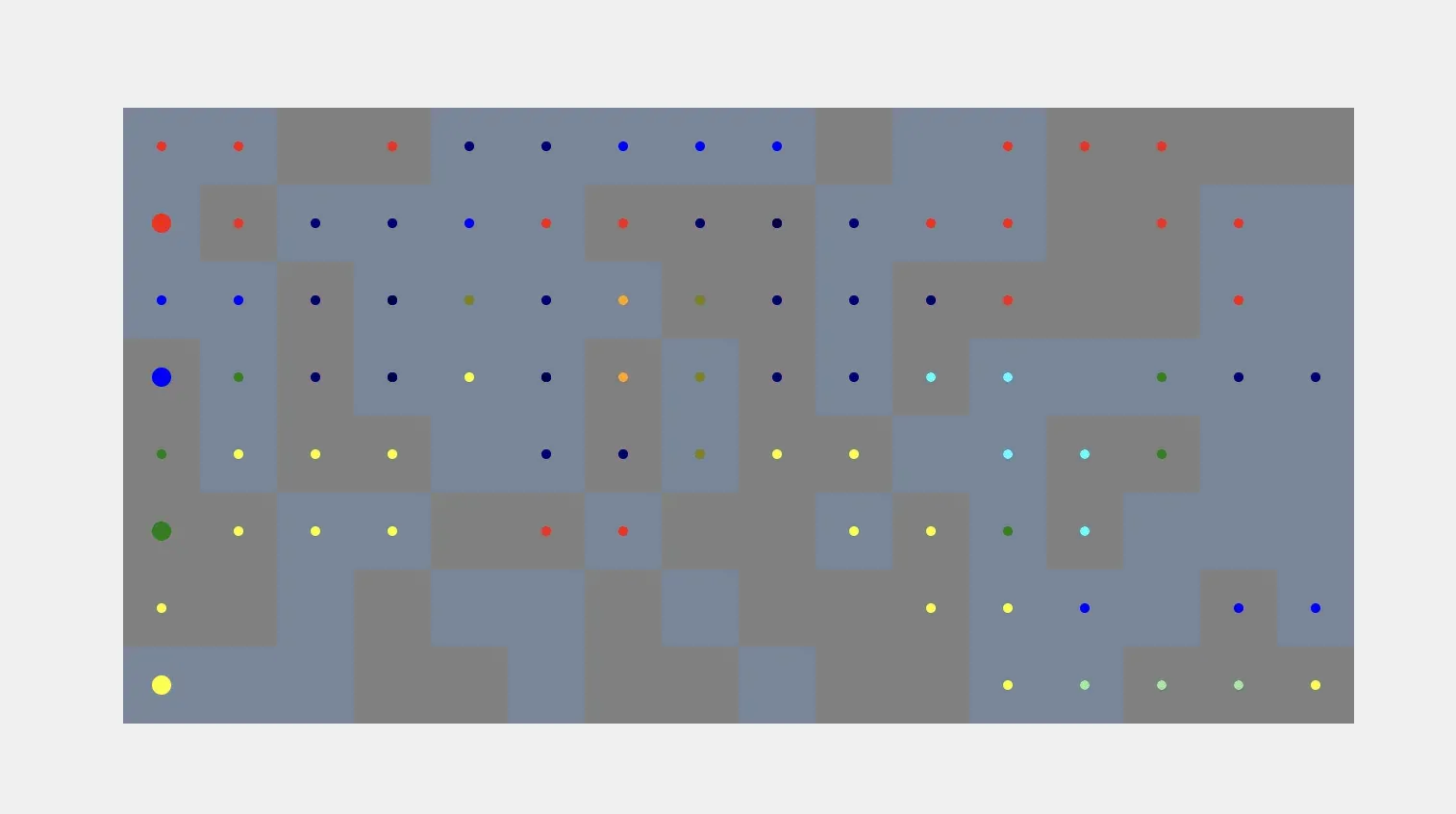

Aplicaciones de AI agent en simulación y comunicación : Los AI agents pueden generar automáticamente simulaciones de vóxeles a partir de las indicaciones del usuario, logrando un flujo de trabajo automatizado desde la instrucción hasta la construcción visual. Actualmente, aún enfrentan el desafío de vincular las formas de vóxeles con objetos del mundo real. Al mismo tiempo, Kylie, un AI agent multimodal de WhatsApp, puede procesar entradas de texto, imagen y voz, gestionar tareas y realizar búsquedas web en tiempo real, demostrando la utilidad de los AI agents en la comunicación diaria y la gestión de tareas. (Fuente: cto_junior, qdrant_engine)

Interacción de voz y comandos personalizados de ChatGPT mejorados : La función de voz a texto de ChatGPT es muy elogiada por su excelente precisión y limpieza inteligente del texto, ofreciendo una experiencia conveniente similar a una conversación humana real. Además, los usuarios pueden transformar ChatGPT en un compañero de pensamiento crítico mediante comandos personalizados, pidiéndole que señale errores fácticos, debilidades argumentales y proporcione alternativas, lo que mejora la calidad y profundidad del diálogo. (Fuente: Reddit r/ChatGPT, Reddit r/ChatGPT)

Hugging Face y Replit: Plataformas de desarrollo asistido por IA : Hugging Face ofrece recursos de capacitación de habilidades para ayudar a los usuarios a entrenar modelos con herramientas de IA, lo que presagia que la IA cambiará la forma en que se desarrolla la propia IA. Al mismo tiempo, Replit es elogiado por su visión de futuro y su innovación continua en el campo del desarrollo de IA, proporcionando a los desarrolladores un entorno de integración de IA eficiente y conveniente. (Fuente: ben_burtenshaw, amasad)

AI agent comprende la tecnología de identificación de hablantes : Speechmatics ofrece tecnología de diarización de hablantes en tiempo real, que puede proporcionar a los AI agents etiquetas de hablante a nivel de palabra, ayudándolos a comprender “quién dijo qué” en una conversación. Esta tecnología soporta más de 55 idiomas para implementación local o en la nube y puede ser ajustada, mejorando la capacidad de comprensión de los AI agents en escenarios de diálogo multiparticipante. (Fuente: TheTuringPost)

vLLM y modelos de vanguardia llegan a Docker Model Runner : Ministral 3, DeepSeek-V3.2 y vLLM v0.12.0, entre otros modelos de código abierto de vanguardia, ya están disponibles en Docker Model Runner. Esto significa que los desarrolladores pueden ejecutar fácilmente estos modelos con un solo comando, simplificando el proceso de implementación de modelos y mejorando la eficiencia de los desarrolladores de IA. (Fuente: vllm_project)

Herramientas de generación de contenido con IA y consejos de prompting : SynthesiaIO lanza un generador gratuito de videos navideños con IA, donde los usuarios solo necesitan introducir un guion para generar un video de Papá Noel con IA. Al mismo tiempo, NanoBanana Pro soporta JSON prompts para una generación de imágenes de alta precisión, mientras que la técnica de “reverse prompting” mejora la calidad de la escritura creativa de IA al excluir explícitamente estilos no deseados, impulsando conjuntamente la conveniencia y el control en la creación de contenido con IA. (Fuente: synthesiaIO, algo_diver, nptacek)

Herramientas de desarrollo asistido por IA y optimización del rendimiento : Un padre y su hijo de 5 años, utilizando herramientas de IA como Claude Opus 4.5, GitHub Copilot y Gemini, lograron desarrollar un juego educativo con temática de Minecraft sin conocimientos de programación, demostrando el potencial de la IA para reducir la barrera de entrada a la programación y estimular la creatividad. Al mismo tiempo, SGLang Diffusion, integrado con Cache-DiT, proporciona una mejora de velocidad del 20-165% en la generación local de imágenes/videos para modelos de difusión, aumentando significativamente la eficiencia de la creación con IA. (Fuente: Reddit r/ChatGPT, Reddit r/LocalLLaMA)

📚 Aprendizaje

Datawhale lanza el tutorial “Construyendo Agentes desde Cero” : La comunidad Datawhale ha lanzado el tutorial de código abierto “Construyendo Agentes desde Cero”, diseñado para ayudar a los estudiantes a dominar el diseño e implementación de AI Native Agents de forma integral, desde la teoría hasta la práctica. El tutorial cubre los principios de los agentes, su historia de desarrollo, fundamentos de LLM, construcción de paradigmas clásicos, uso de plataformas low-code, frameworks propios, memoria y recuperación, ingeniería de contexto, entrenamiento de Agentic RL, evaluación de rendimiento y desarrollo de casos integrales, siendo un recurso valioso para el aprendizaje sistemático de la tecnología de agentes. (Fuente: GitHub Trending)

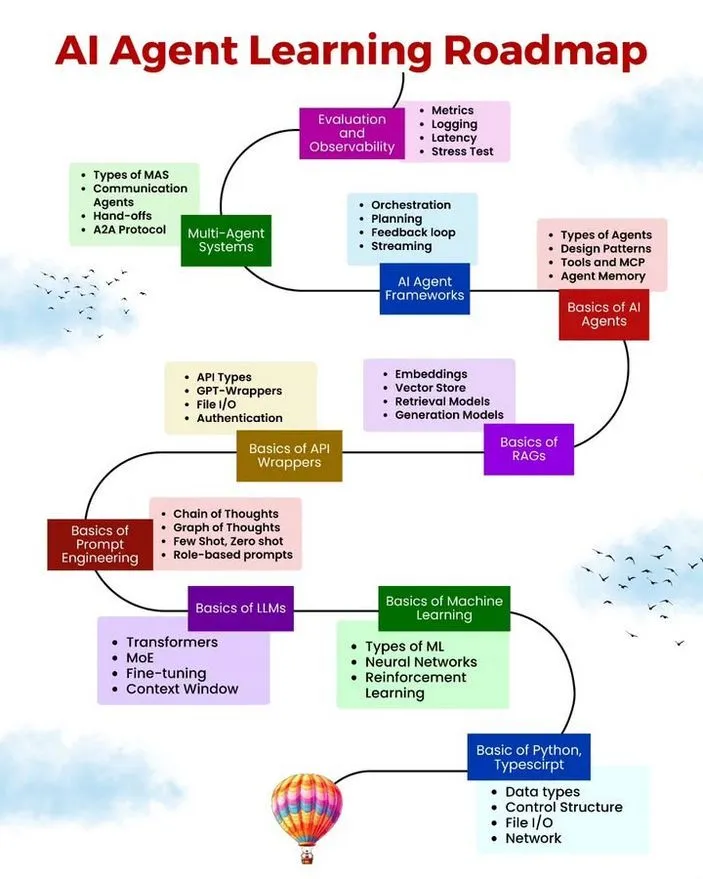

Recursos de aprendizaje de AI/ML, hoja de ruta y errores comunes de Agent : Ronald van Loon compartió una hoja de ruta de aprendizaje de AI Agent, recursos gratuitos de aprendizaje de AI/ML y 10 errores comunes a evitar en el desarrollo de AI Agent. Estos recursos tienen como objetivo proporcionar a los interesados en el desarrollo de AI Agent una ruta de aprendizaje sistemática, materiales prácticos y mejores prácticas para ayudar a los desarrolladores a mejorar la robustez, eficiencia y fiabilidad de los agentes. (Fuente: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

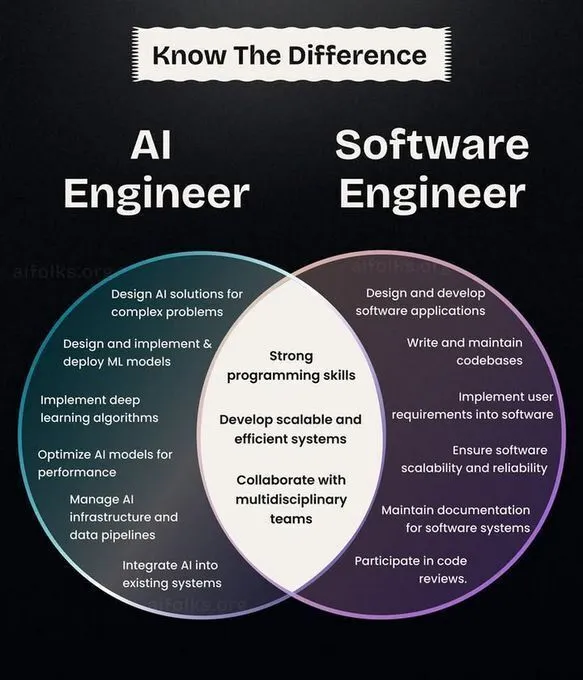

Desarrollo profesional en AI/ML, rutas de aprendizaje y revisión histórica de CNN : Ronald van Loon compartió una comparación de roles entre ingenieros de IA e ingenieros de software, ofreciendo una referencia para la planificación del desarrollo profesional. Al mismo tiempo, la comunidad discutió las rutas de inicio e investigación en deep learning, sugiriendo implementar algoritmos desde cero para una comprensión más profunda, y revisó la historia de la invención de las Convolutional Neural Networks (CNN), proporcionando a los estudiantes de IA dirección profesional, consejos prácticos y antecedentes técnicos. (Fuente: Ronald_vanLoon, Reddit r/deeplearning, Reddit r/MachineLearning, Reddit r/artificial)

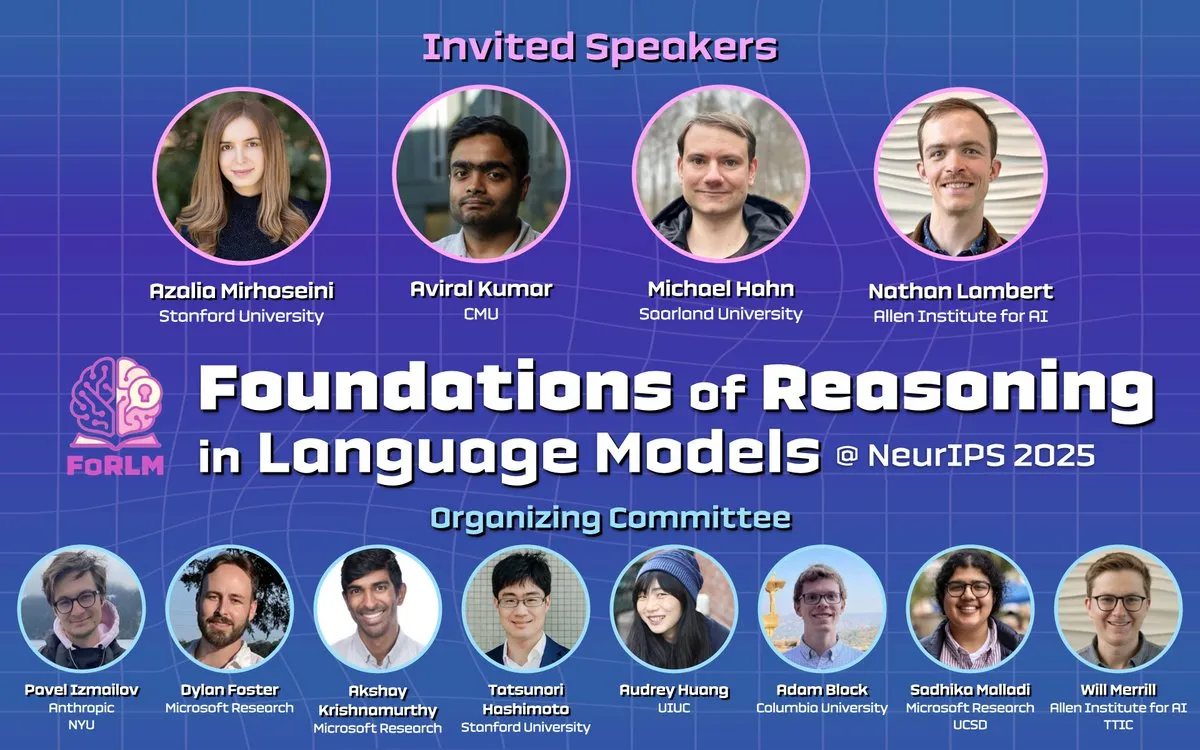

Conferencia NeurIPS 2025 se centra en la inferencia de LLM, la interpretabilidad y artículos de vanguardia : Durante NeurIPS 2025, varios talleres (como Foundations of Reasoning in Language Models, CogInterp Workshop, LAW 2025 workshop) exploraron en profundidad los fundamentos del razonamiento de LLM, la interpretabilidad, las suposiciones estructurales del post-entrenamiento de RL, y la comprensión semántica y antropomórfica de los Tokens intermedios, entre otros temas de vanguardia. La conferencia presentó varios artículos de investigación destacados, impulsando la comprensión de los mecanismos profundos de los LLM. (Fuente: natolambert, sarahookr, rao2z, lateinteraction, TheTuringPost)

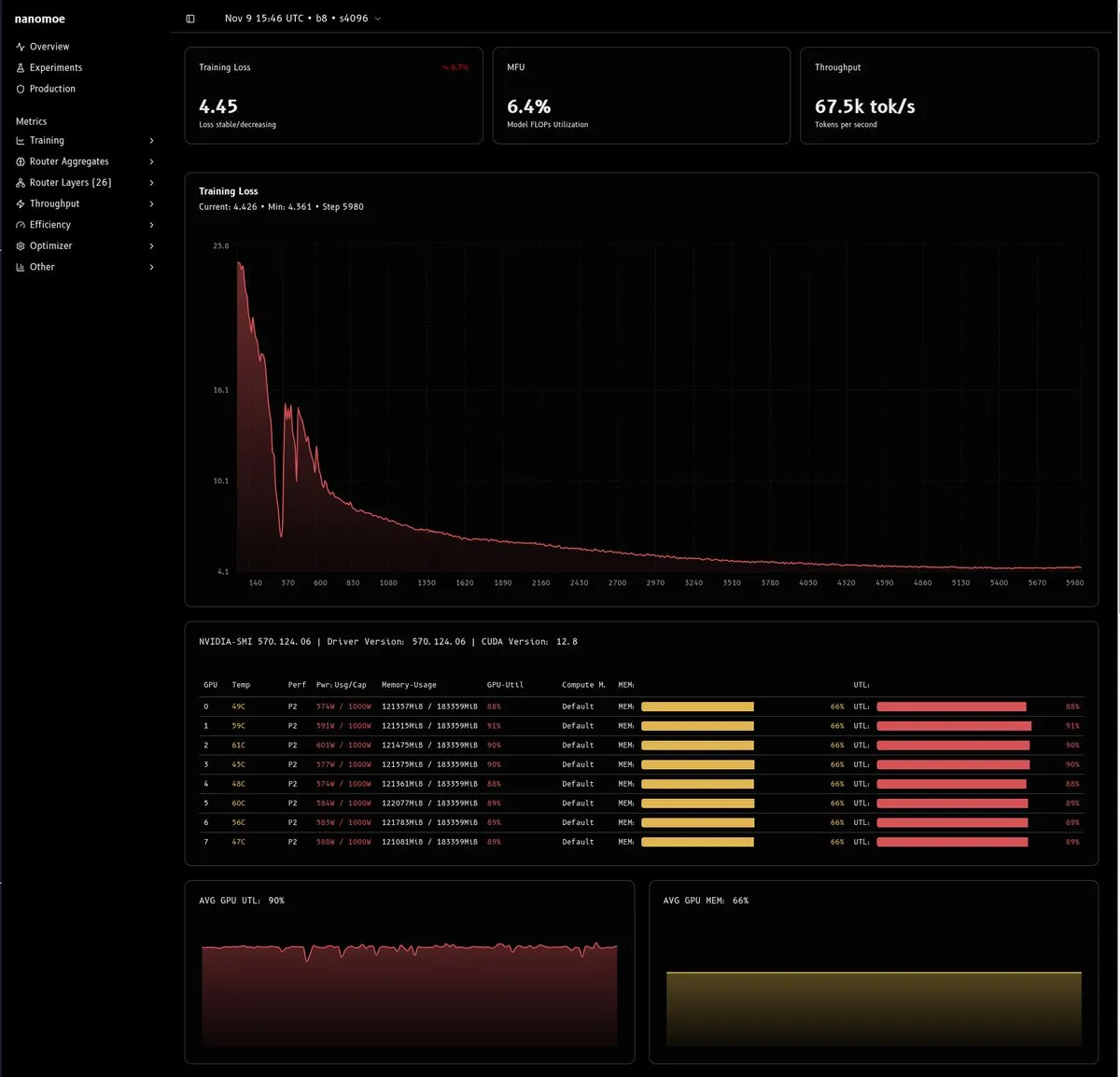

Análisis profundo de los desafíos y soluciones en el entrenamiento de modelos MoE : Un artículo técnico detallado explora las dificultades de entrenar modelos MoE (especialmente aquellos con menos de 20B parámetros), centrándose principalmente en la eficiencia computacional, el balance de carga/estabilidad del router y la calidad y cantidad de datos. El artículo propone soluciones innovadoras como el entrenamiento de precisión mixta, el escalado muP, la eliminación del recorte de gradientes y el uso de escalares virtuales, y enfatiza la importancia de construir pipelines de datos de alta calidad, proporcionando una valiosa experiencia para la investigación y despliegue de MoE. (Fuente: dejavucoder, tokenbender, eliebakouch, halvarflake, eliebakouch, teortaxesTex)

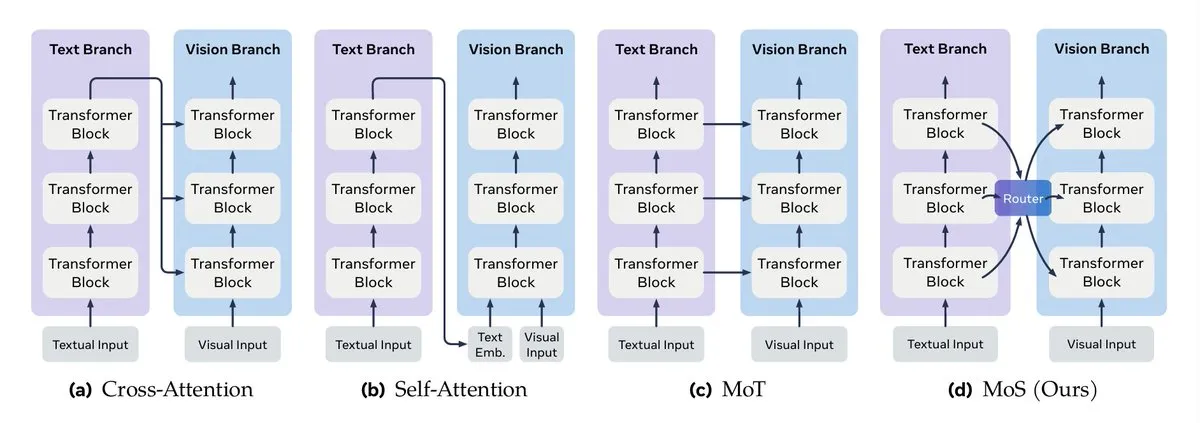

Guía de ingeniería de contexto de LLM y fusión de datos multimodales : Turing Post detalla los métodos clave para la fusión de datos multimodales, incluyendo la fusión de mecanismos de atención, la mezcla de Transformer, la fusión de grafos, la fusión de funciones kernel y la mezcla de estados. Al mismo tiempo, Google publicó una guía de ingeniería de contexto eficiente para sistemas multi-agente, enfatizando que la gestión de contexto no es una simple concatenación de cadenas, sino una consideración a nivel de arquitectura, con el objetivo de resolver problemas de costo, rendimiento y alucinaciones. (Fuente: TheTuringPost, TheTuringPost, omarsar0)

Cursos de Agentic AI y guía de despliegue de NVIDIA RAG : Se recomienda una serie de recursos de cursos en línea de Agentic AI, que cubren rutas de aprendizaje desde principiantes hasta avanzados. Al mismo tiempo, NVIDIA ha publicado una guía técnica que detalla cómo desplegar el asistente de investigación AI-Q y el blueprint de RAG empresarial, utilizando Nemotron NIMs y un flujo de trabajo de agente Plan-Refine-Reflect para ejecutarse en Amazon EKS, proporcionando una guía práctica para agentes de IA a nivel empresarial y sistemas RAG. (Fuente: Reddit r/deeplearning, dl_weekly)

Agentic RL, memoria procedimental y optimizador StructOpt : La memoria procedimental puede reducir eficazmente el costo y la complejidad de los AI agents. Al mismo tiempo, StructOpt, un nuevo optimizador de primer orden, ajusta su comportamiento detectando la tasa de cambio del gradiente, logrando una convergencia rápida en regiones planas y manteniendo la estabilidad en regiones de alta curvatura, proporcionando un método de optimización eficiente para Agentic RL y el entrenamiento de LLM. (Fuente: Ronald_vanLoon, Reddit r/deeplearning)

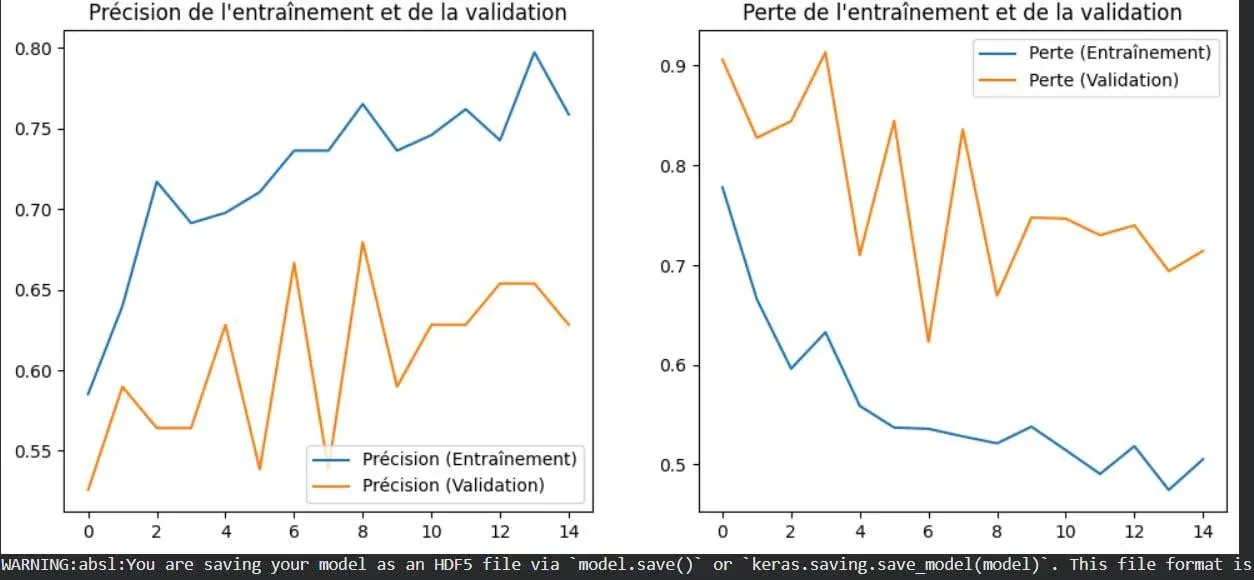

Visualización del concepto de overfitting en deep learning : Una imagen muestra de manera intuitiva el fenómeno del overfitting en deep learning. El overfitting se refiere a cuando un modelo funciona bien con los datos de entrenamiento, pero su rendimiento disminuye con datos nuevos no vistos, siendo uno de los problemas centrales a resolver en machine learning. Comprender su representación visual ayuda a los desarrolladores a optimizar mejor los modelos. (Fuente: Reddit r/deeplearning)

Contingency Races: Nuevo benchmark de planificación y análisis de terminación de funciones recursivas : Se propone un nuevo benchmark llamado Contingency Races para evaluar la capacidad de planificación de los modelos de IA, que, a través de su complejidad única, impulsa a los modelos a simular mecanismos activamente en lugar de depender de la memoria. Al mismo tiempo, Victor Taelin compartió una comprensión simplificada del análisis de terminación de funciones recursivas en Agda, proporcionando un método más intuitivo para entender los conceptos centrales en la programación funcional. (Fuente: Reddit r/MachineLearning, VictorTaelin)

💼 Negocios

Estrategias de comercialización de productos de IA: validación de la demanda, mejora 10x y construcción de fosos : Se discute la ruta clave desde la demanda hasta la comercialización de productos de IA. Se enfatiza que la demanda debe estar validada (los usuarios ya pagan por una solución), el producto debe ofrecer una mejora 10x (no una optimización marginal), y se debe construir un foso (velocidad, efectos de red, reconocimiento de marca) para contrarrestar la copia. El núcleo es encontrar un problema real y proporcionar un valor disruptivo, no solo basarse en la innovación tecnológica. (Fuente: dotey)

Conjecture Institute recibe inversión de capital riesgo : Conjecture Institute anunció que Mike Maples, Jr., socio fundador de la firma de capital riesgo Floodgate, se ha unido como donante de plata. Esta inversión apoyará la investigación y el desarrollo de Conjecture Institute en el campo de la IA, reflejando el continuo interés del mercado de capitales en las instituciones de investigación de IA de vanguardia. (Fuente: MoritzW42)

🌟 Comunidad

La esencia de la IA/AGI, reflexiones filosóficas y ética del trabajo de datos : La comunidad discute la esencia de la IA/AGI, como la propuesta de Elon Musk de que “la IA es compresión y asociación”, y el impacto de la IA en la “transición de fase” de la inteligencia terrestre. Al mismo tiempo, la controversia sobre la arquitectura MoE, los posibles desafíos que la AGI podría enfrentar en una sociedad humana compleja, y las cuestiones éticas de las empresas de datos de IA y el trabajo de datos también han provocado una profunda reflexión. (Fuente: lateinteraction, Suhail, pmddomingos, SchmidhuberAI, Reddit r/ArtificialInteligence, menhguin)

Desarrollo de la tecnología de IA, desafíos éticos y controversias en aplicaciones creativas : La conferencia NeurIPS 2025 reunió investigaciones de vanguardia sobre LLM, VLM, etc., pero la aplicación de la IA en la cría industrial, los problemas de integridad de los artículos generados por LLM en el ámbito académico, y la controversia sobre la autoría de los prolíficos artículos de Yoshua Bengio han provocado debates éticos. Al mismo tiempo, el papel de la IA en el ámbito creativo también ha generado una amplia controversia sobre la eficiencia frente a la creación tradicional y el impacto en el empleo. (Fuente: charles_irl, MiniMax__AI, dwarkesh_sp, giffmana, slashML, Reddit r/ChatGPT)

Impacto de la IA en la profesión y la sociedad, y experiencia de interacción con modelos : Historias personales muestran cómo la IA ayuda a personas sin experiencia a conseguir trabajo, y el impacto de la IA en la industria legal, lo que provoca discusiones sobre el efecto de la IA en el empleo y la transición profesional. Al mismo tiempo, las diferencias de “personalidad” entre diferentes modelos de IA (como ChatGPT y Grok) en escenarios complejos, así como la retroalimentación de “tienes toda la razón” del modelo Claude y los problemas de repetición en la generación de imágenes de Gemini Pro, también afectan la percepción de los usuarios sobre la experiencia de interacción con la IA. (Fuente: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, Reddit r/artificial, Reddit r/ClaudeAI, Reddit r/OpenWebUI)

Calidad del contenido de la comunidad de IA, desafíos de desarrollo y estrategias de usuario : La comunidad de IA expresa preocupación por el rápido aumento del contenido de baja calidad generado por IA (“AI slop”). Al mismo tiempo, los usuarios discuten los costos de hardware, el rendimiento y las ventajas y desventajas de los servicios alojados para la implementación local de LLM, así como las estrategias para abordar las limitaciones de contexto de Claude, lo que refleja los desafíos técnicos y los problemas del ecosistema comunitario que enfrenta el desarrollo y uso de la IA. (Fuente: Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/ClaudeAI, Reddit r/LocalLLaMA)

Desafíos del soporte técnico y el entorno de aprendizaje en la era de la IA : En la comunidad, la alta demanda de soporte técnico para problemas del entorno de GPU de Colab, la integración de Stable Diffusion en Open WebUI, etc., refleja los desafíos comunes de configuración de recursos computacionales e integración de herramientas en el aprendizaje y desarrollo de IA. Al mismo tiempo, el entusiasmo por la programación de kernels de GPU también muestra un fuerte interés en la optimización de bajo nivel y la mejora del rendimiento. (Fuente: Reddit r/deeplearning, Reddit r/OpenWebUI, maharshii)

Aplicaciones prácticas de la IA en diseño de interiores/exteriores y experiencia del usuario : La comunidad discute la situación actual de las aplicaciones prácticas de la IA en el diseño de interiores/exteriores. Un usuario compartió un caso de éxito utilizando IA para diseñar un techo de patio, considerando que la IA puede generar rápidamente diseños realistas. Al mismo tiempo, también hay una curiosidad generalizada sobre la implementación real de los diseños de IA y la experiencia del usuario. (Fuente: Reddit r/ArtificialInteligence)

La IA y la transformación digital requieren pensamiento sistémico : En los complejos sistemas de IA y los ecosistemas digitales, es necesario comprender la interacción de todos los componentes desde una perspectiva holística, en lugar de abordar los problemas de forma aislada, para garantizar que la tecnología se integre eficazmente y logre el valor esperado. (Fuente: Ronald_vanLoon)

Generación de datos de entrenamiento de LLM y discusión del benchmark ARC-AGI : La comunidad discute si el equipo de Gemini 3 generó una gran cantidad de datos sintéticos para el benchmark ARC-AGI, y el significado de esto para el progreso de la AGI y el ARC Prize. Esto refleja la continua atención sobre las fuentes de datos de entrenamiento de LLM, la calidad de los datos sintéticos y su impacto en las capacidades del modelo. (Fuente: teortaxesTex)

💡 Otros

Estudiantes de primaria utilizan la IA para combatir la falta de vivienda : Estudiantes de primaria de Texas están utilizando la tecnología de IA para explorar y desarrollar soluciones para abordar el problema de la falta de vivienda en su localidad. Este proyecto demuestra el potencial de la IA en el ámbito del bienestar social, así como la capacidad de la educación para fomentar que las generaciones jóvenes utilicen la tecnología para resolver problemas reales. (Fuente: kxan.com)