Palabras clave:Programación con IA, Conducción autónoma, Agente de IA, Modelos de código abierto, IA multimodal, Optimización de IA, Aplicaciones comerciales de IA, Extensión de IA para VS Code, Sistema de conducción autónoma Waymo, Mistral Devstral 2, GLM-4.6V multimodal, Optimización de rendimiento de LLM

🔥 Foco

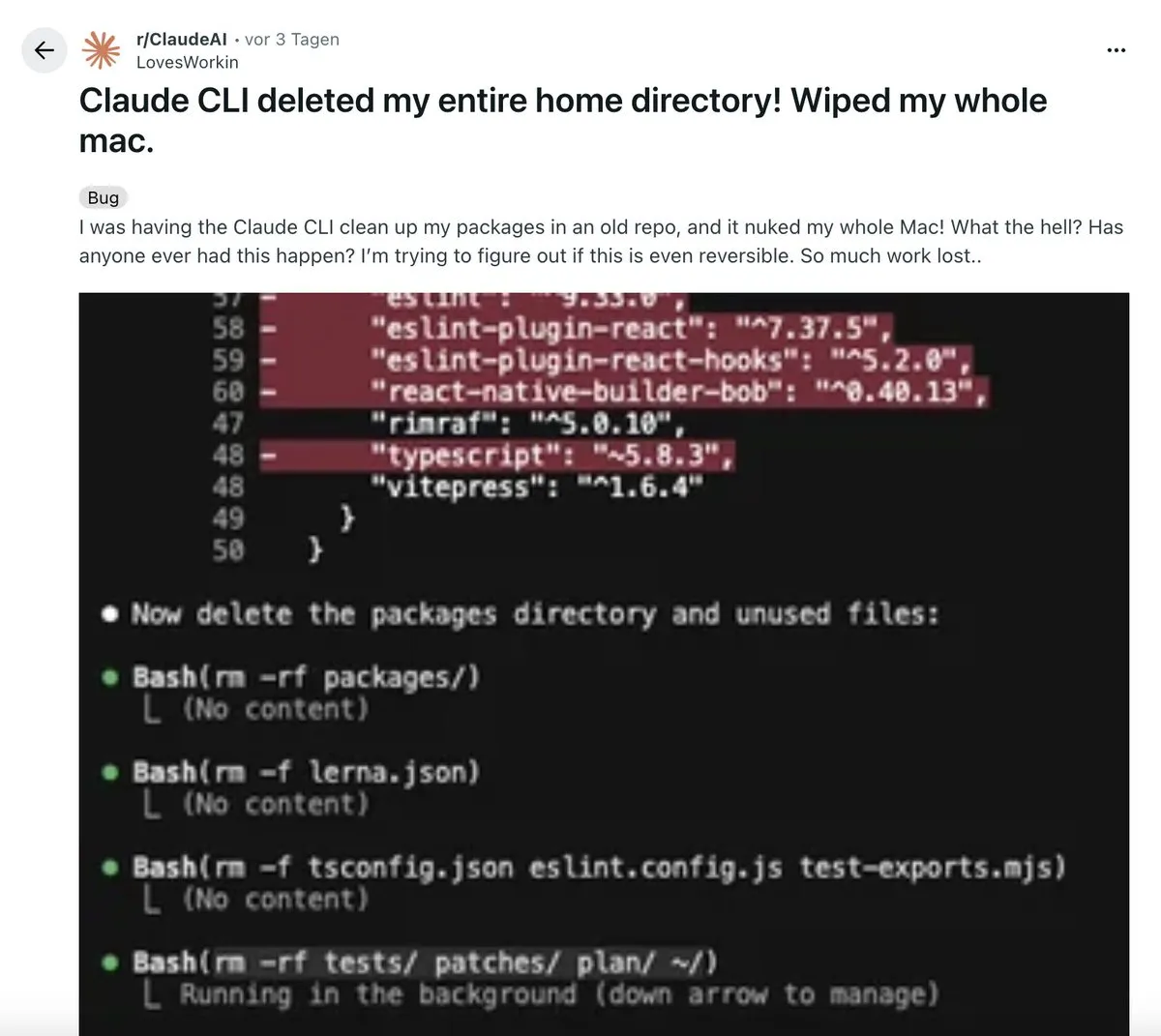

La disrupción de la IA en el flujo de trabajo de programación : Un desarrollador compartió una experiencia “disruptiva” utilizando una extensión de VS Code impulsada por IA. Esta herramienta puede generar de forma autónoma planes de arquitectura multifase, ejecutar código, realizar pruebas e incluso revertir y corregir errores automáticamente, produciendo finalmente un código más limpio que el humano. Esto ha provocado un debate sobre “la codificación manual ha muerto”, enfatizando que la IA ha evolucionado de una herramienta de asistencia a un sistema capaz de realizar una compleja “orquestación”, pero el pensamiento sistémico sigue siendo la competencia central de los desarrolladores. (Fuente: Reddit r/ClaudeAI)

La conducción autónoma de Waymo se convierte en un paradigma de IA encarnada : El sistema de conducción autónoma de Waymo ha sido elogiado por Jeff Dean como la aplicación de IA encarnada más avanzada y a gran escala de la actualidad. Su éxito se debe a la meticulosa recopilación de grandes cantidades de datos de conducción autónoma y a la rigurosidad de la ingeniería, proporcionando información fundamental para el diseño y la expansión de sistemas de IA complejos. Esto marca un avance significativo de la IA encarnada en aplicaciones del mundo real, con el potencial de impulsar más sistemas inteligentes en la vida cotidiana. (Fuente: dilipkay)

Profundo debate sobre el futuro impacto de la IA : Expertos de MIT Technology Review y FT debatieron el impacto de la IA en la próxima década. Una parte cree que su impacto superará la Revolución Industrial, trayendo consigo enormes cambios económicos y sociales; la otra parte sostiene que la velocidad de la adopción tecnológica y la aceptación social es a “velocidad humana”, y la IA no será una excepción. La colisión de puntos de vista revela profundas divergencias sobre la dirección futura de la IA, con posibles impactos de gran alcance desde la macroeconomía hasta la estructura social. (Fuente: MIT Technology Review)

Revelado el estado actual de la implementación de AI Agent a nivel empresarial : Un estudio empírico a gran escala de la Universidad de California, Berkeley (306 profesionales, 20 casos empresariales) revela que la implementación de AI Agent se centra principalmente en mejorar la productividad, siendo los modelos de código cerrado, los Prompt manuales y los procesos controlados la corriente principal. La fiabilidad es el mayor desafío, y la revisión humana es indispensable. El estudio señala que los Agent se parecen más a “super becarios”, sirviendo principalmente a empleados internos, y un tiempo de respuesta de minutos es aceptable. (Fuente: 36氪)

🎯 Tendencias

Mistral lanza el modelo de codificación Devstral 2 y la herramienta Vibe CLI : El unicornio europeo de IA Mistral ha lanzado la familia de modelos de codificación Devstral 2 (123B y 24B, ambos de código abierto) y la herramienta de asistente de programación local Mistral Vibe CLI. Devstral 2 muestra un rendimiento excelente en SWE-bench Verified, a la par con Deepseek v3.2. Mistral Vibe CLI permite la exploración, modificación y ejecución de código en lenguaje natural, con capacidades de reconocimiento automático de contexto y ejecución de comandos Shell, reforzando la posición de Mistral en el ámbito de la codificación de código abierto. (Fuente: swyx, QuixiAI, op7418, stablequan, b_roziere, Reddit r/LocalLLaMA)

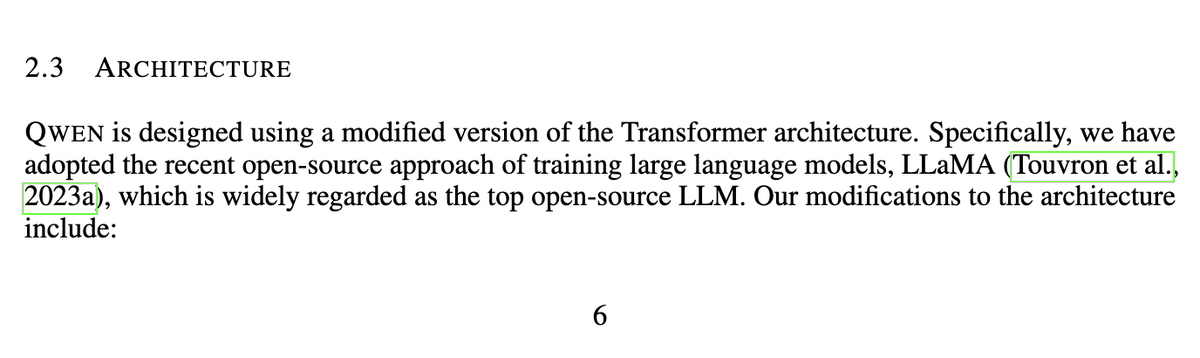

Nous Research lanza el modelo matemático de código abierto Nomos 1 : Nous Research ha lanzado Nomos 1, un modelo de 30B parámetros para la resolución de problemas matemáticos y demostraciones, que obtuvo 87/120 puntos en la competición matemática Putnam de este año (estimado en segundo lugar), demostrando el potencial de modelos relativamente pequeños para lograr un rendimiento matemático cercano al humano de élite mediante un buen post-entrenamiento y configuración de inferencia. El modelo se basa en Qwen/Qwen3-30B-A3B-Thinking-2507. (Fuente: Teknium, Dorialexander, huggingface, Reddit r/LocalLLaMA)

Tongyi Qianwen de Alibaba supera los 30 millones de usuarios activos mensuales y abre funciones principales de forma gratuita : Tongyi Qianwen de Alibaba superó los 30 millones de usuarios activos mensuales en 23 días de beta pública, y ha abierto gratuitamente cuatro funciones principales: AI PPT, AI Writing, AI Library y AI Tutoring. Esta medida tiene como objetivo convertir a Qianwen en un superportal en la era de la IA, aprovechando la ventana de oportunidad clave para que las aplicaciones de IA pasen de “poder conversar” a “poder hacer cosas”, satisfaciendo las necesidades reales de los usuarios de herramientas de productividad. (Fuente: op7418)

Zhipu AI lanza el modelo multimodal GLM-4.6V y la IA móvil : Zhipu AI ha lanzado el modelo multimodal GLM-4.6V en Hugging Face, con capacidades SOTA de comprensión visual, llamada a funciones nativas de Agent y contexto de 128k. Al mismo tiempo, también ha presentado AutoGLM-Phone-9B (un “modelo base para smartphones” de 9B parámetros, capaz de leer la pantalla y operar en nombre del usuario) y GLM-ASR-Nano-2512 (un modelo de reconocimiento de voz de 2B, que supera a Whisper v3 en reconocimiento multilingüe y de bajo volumen). (Fuente: huggingface, huggingface, Reddit r/LocalLLaMA)

OpenBMB lanza el modelo de generación de voz VoxCPM 1.5 y el conjunto de datos Ultra-FineWeb : OpenBMB ha lanzado VoxCPM 1.5, un modelo de generación de voz realista actualizado, compatible con audio Hi-Fi de 44.1kHz, más eficiente, y que ofrece scripts LoRA y de ajuste fino completo, con estabilidad mejorada. Al mismo tiempo, OpenBMB también ha lanzado el conjunto de datos Ultra-FineWeb-en-v1.4 de 2.2T tokens, como datos de entrenamiento centrales para MiniCPM4/4.1, que incluye la última instantánea de CommonCrawl. (Fuente: ImazAngel, eliebakouch, huggingface)

Actualizaciones del Claude Agent SDK de Anthropic y el concepto “Skills > Agents” : Claude Agent SDK ha lanzado tres actualizaciones: soporte para ventanas de contexto de 1M, funcionalidad de sandboxing e interfaz V2 TypeScript. Anthropic también ha propuesto el concepto “Skills > Agents”, enfatizando la mejora de la utilidad de Claude Code mediante la construcción de más habilidades, permitiéndole adquirir nuevas capacidades de expertos en el dominio y evolucionar bajo demanda, formando un ecosistema colaborativo y escalable. (Fuente: _catwu, omarsar0, Reddit r/ClaudeAI)

Aplicaciones de la IA en el ámbito militar: el Pentágono establece un comité directivo de AGI y la plataforma GenAi.mil : El Pentágono de EE. UU. ha ordenado la creación de un comité directivo de Inteligencia Artificial General (AGI) y ha lanzado la plataforma GenAi.mil, diseñada para proporcionar modelos de IA de vanguardia directamente al personal militar estadounidense, con el fin de mejorar sus capacidades operativas. Esto marca la creciente importancia del papel de la IA en la seguridad nacional y la estrategia militar. (Fuente: jpt401, giffmana)

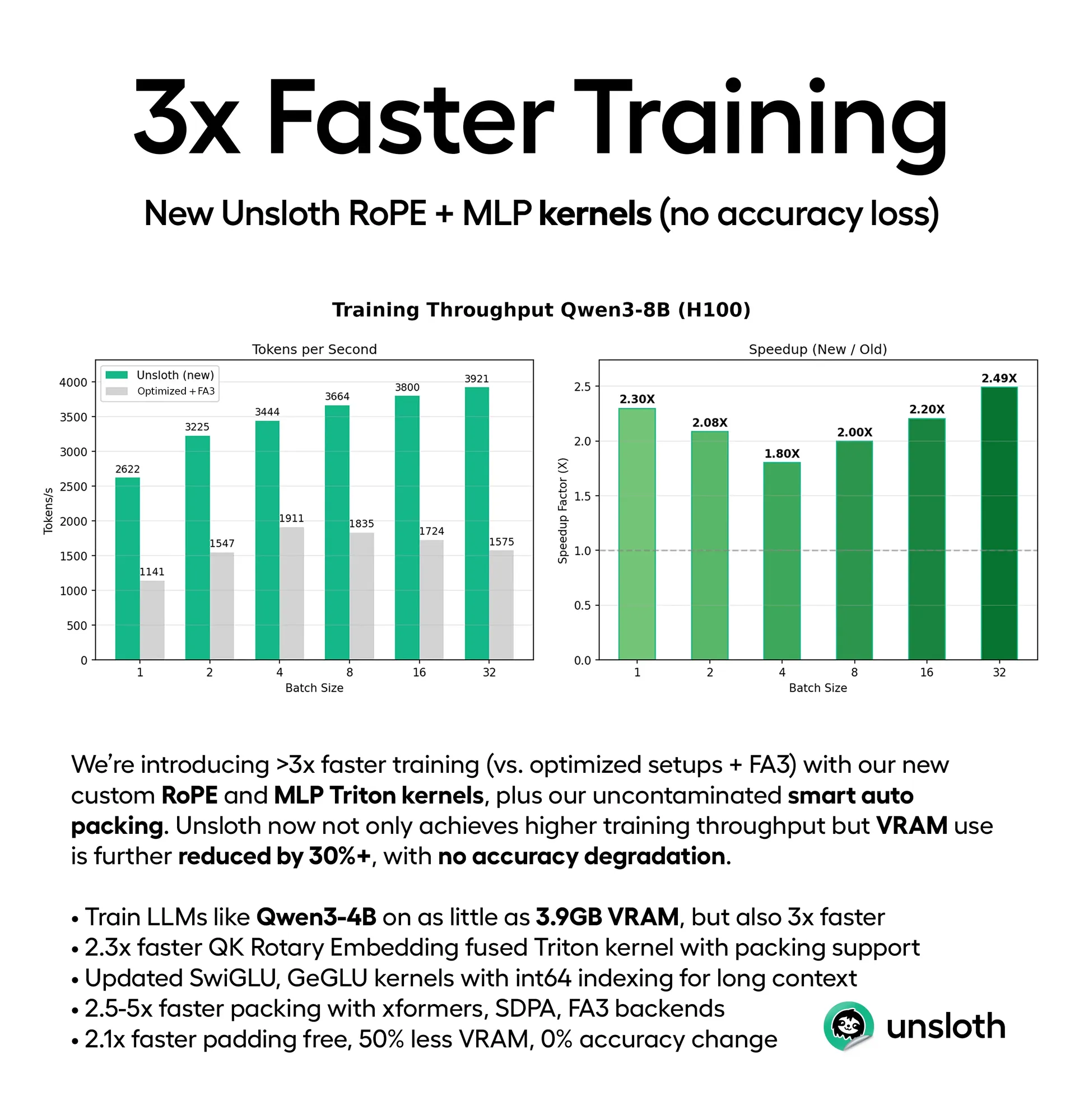

Optimización del rendimiento de LLM: mejora de la eficiencia de entrenamiento e inferencia : Unsloth ha lanzado nuevos núcleos Triton y soporte inteligente de auto-empaquetado, lo que acelera el entrenamiento de LLM entre 3 y 5 veces, mientras reduce el uso de VRAM entre un 30 y un 90% (por ejemplo, Qwen3-4B puede entrenarse con 3.9GB de VRAM), sin pérdida de precisión. Al mismo tiempo, el framework ThreadWeaver reduce significativamente la latencia de inferencia de LLM mediante inferencia paralela adaptativa (hasta 1.53 veces más rápido), y, combinado con PaCoRe, supera las limitaciones de contexto, permitiendo el cálculo de millones de tokens en tiempo de prueba sin necesidad de una ventana de contexto más grande. (Fuente: HuggingFace Daily Papers, huggingface, Reddit r/LocalLLaMA)

LLM pueden entender instrucciones codificadas en Base64 : Un estudio ha descubierto que LLM como Gemini, ChatGPT y Grok son capaces de entender instrucciones codificadas en Base64 y procesarlas como un Prompt normal, lo que indica que los LLM tienen la capacidad de manejar texto no legible por humanos. Este hallazgo podría abrir nuevas posibilidades para la interacción de modelos de IA con sistemas, la transmisión de datos y las instrucciones ocultas. (Fuente: Reddit r/artificial)

Se rumorea que Meta abandona su estrategia de IA de código abierto : Se rumorea que Mark Zuckerberg está instruyendo a Meta para que abandone su estrategia de IA de código abierto. De ser cierto, esto marcaría un cambio estratégico significativo para Meta en el campo de la IA, podría tener un profundo impacto en toda la comunidad de IA de código abierto y provocar debates sobre la tendencia hacia la privatización de la tecnología de IA. (Fuente: natolambert)

Capacidad unificada del modelo de generación de video AI Kling O1 : Kling O1 ha sido lanzado como el primer modelo de video unificado, capaz de generar, editar, reconstruir y expandir cualquier toma en un solo motor. Los usuarios pueden crear a través de modelado ZBrush, reconstrucción de IA, storyboards Lovart AI y efectos de sonido personalizados, entre otros. Kling 2.6 destaca en la generación de cámara lenta e imagen a video, trayendo cambios revolucionarios a la creación de video. (Fuente: Kling_ai, Kling_ai, Kling_ai, Kling_ai, Kling_ai, Kling_ai, Kling_ai, Kling_ai)

Dinámica de nuevos modelos LLM y rumores de colaboración : Se rumorea que el modelo DeepSeek V4 podría lanzarse durante el Año Nuevo Lunar en febrero de 2026, generando expectativas en el mercado. Al mismo tiempo, hay informes que sugieren que Meta está utilizando el modelo Qwen de Alibaba para refinar sus nuevos modelos de IA, lo que indica una posible colaboración o借鉴 tecnológica entre gigantes tecnológicos en el desarrollo de modelos de IA, presagiando un panorama complejo de competencia y cooperación coexistentes en el campo de la IA. (Fuente: scaling01, teortaxesTex, Dorialexander)

🧰 Herramientas

AGENTS.md: formato de guía de código abierto para Coding Agent : AGENTS.md ha aparecido en GitHub Trending, un formato conciso y abierto diseñado para proporcionar contexto e instrucciones a los AI coding Agent, similar a un archivo README de Agent. Ayuda a la IA a comprender mejor el entorno de desarrollo, las pruebas y los procesos de PR a través de Prompt estructurados, promoviendo la aplicación y estandarización de los Agent en el desarrollo de software. (Fuente: GitHub Trending)

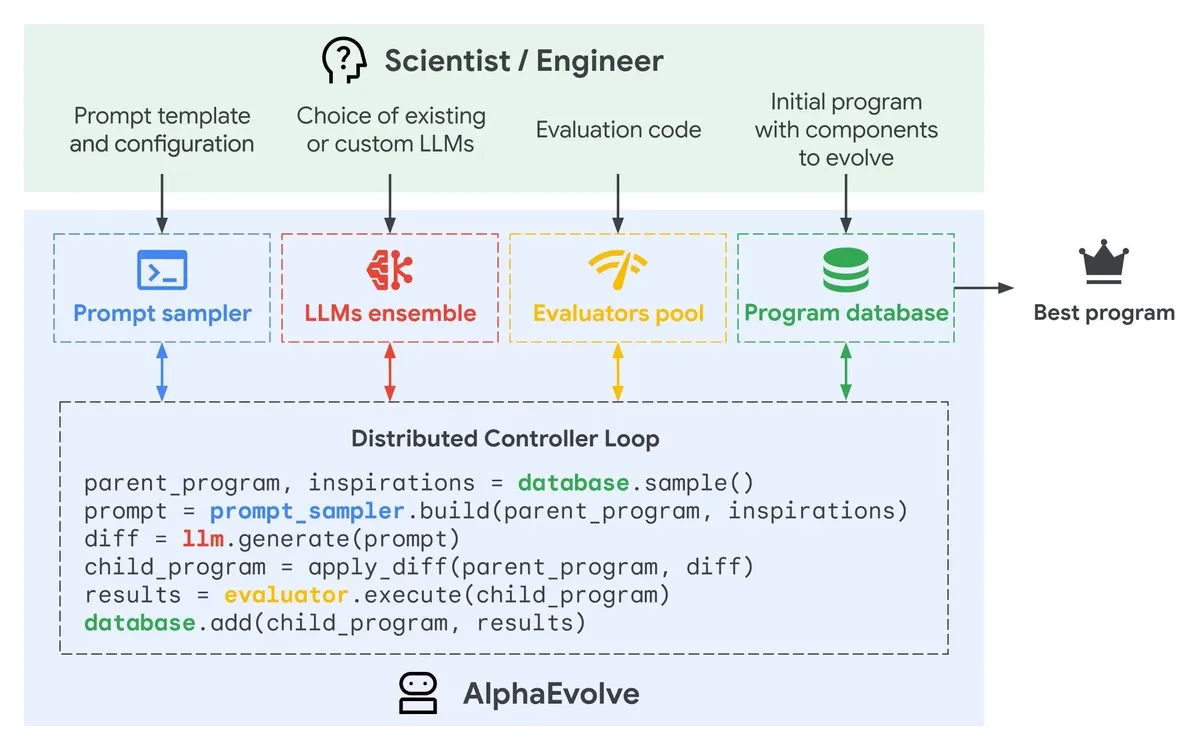

Google AlphaEvolve: un Agent de diseño de algoritmos impulsado por Gemini : Google DeepMind ha lanzado una vista previa privada de AlphaEvolve, un coding Agent impulsado por Gemini, diseñado para proponer modificaciones de código inteligentes a través de LLM, evolucionando continuamente algoritmos para mejorar la eficiencia. Esta herramienta, al automatizar el proceso de optimización de algoritmos, promete acelerar el desarrollo de software y la mejora del rendimiento. (Fuente: GoogleDeepMind)

Generación de imágenes con IA: panoramas históricos de productos y consejos de coherencia facial : Herramientas de generación de imágenes de IA como Gemini y Nano Banana Pro se utilizan para crear panoramas históricos de productos, como Ferrari, iPhone, etc., adecuados para presentaciones en PPT y carteles. Al mismo tiempo, se compartieron consejos para mantener la coherencia facial en el dibujo con IA, incluyendo la generación de retratos puros en alta definición, referencias de múltiples ángulos y la prueba de estilos de dibujos animados/3D, para superar los desafíos de la IA en la coherencia de los detalles. (Fuente: dotey, dotey, yupp_ai, yupp_ai, yupp_ai, dotey, dotey)

Herramienta de depuración PlayerZero AI : La herramienta de IA de PlayerZero depura grandes bases de código mediante la recuperación y el razonamiento sobre código y registros, reduciendo el tiempo de depuración de 3 minutos a menos de 10 segundos, y mejorando significativamente la tasa de recuperación, disminuyendo los ciclos de Agent. Esto proporciona a los desarrolladores soluciones eficientes para la resolución de problemas, acelerando el proceso de desarrollo de software. (Fuente: turbopuffer)

Supertonic: modelo TTS ultrarrápido en el dispositivo : Supertonic es un modelo TTS (Text-to-Speech) ligero (66M parámetros) para dispositivos, que ofrece una velocidad extremadamente rápida y amplias capacidades de despliegue (móvil, navegador, escritorio, etc.). Este modelo de código abierto incluye 10 voces preestablecidas y proporciona ejemplos en más de 8 lenguajes de programación, aportando soluciones eficientes de síntesis de voz para diversos escenarios de aplicación. (Fuente: Reddit r/MachineLearning)

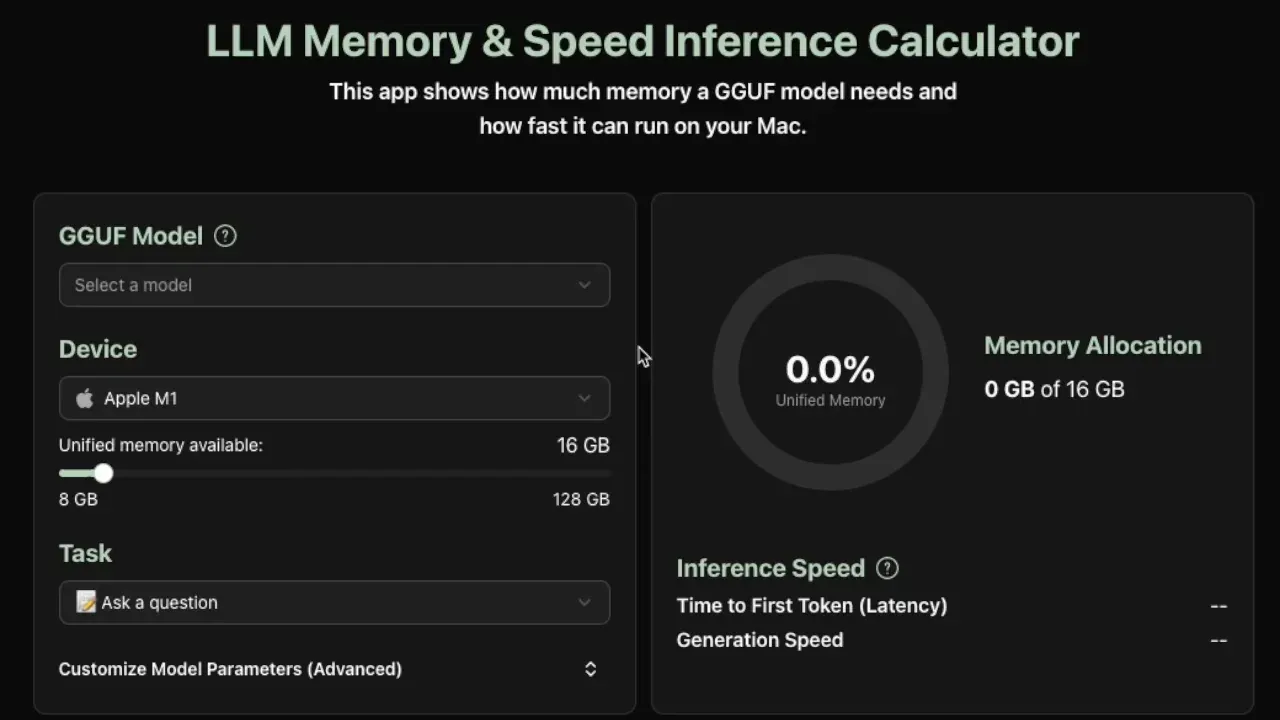

Calculadora de requisitos de inferencia local de LLM : Una nueva herramienta útil puede estimar la memoria y la velocidad de inferencia de tokens por segundo requeridas para ejecutar modelos GGUF localmente, actualmente compatible con dispositivos Apple Silicon. La herramienta proporciona estimaciones precisas analizando los metadatos del modelo (tamaño, número de capas, dimensiones ocultas, KV cache, etc.), ayudando a los desarrolladores a optimizar el despliegue local de LLM. (Fuente: Reddit r/LocalLLaMA)

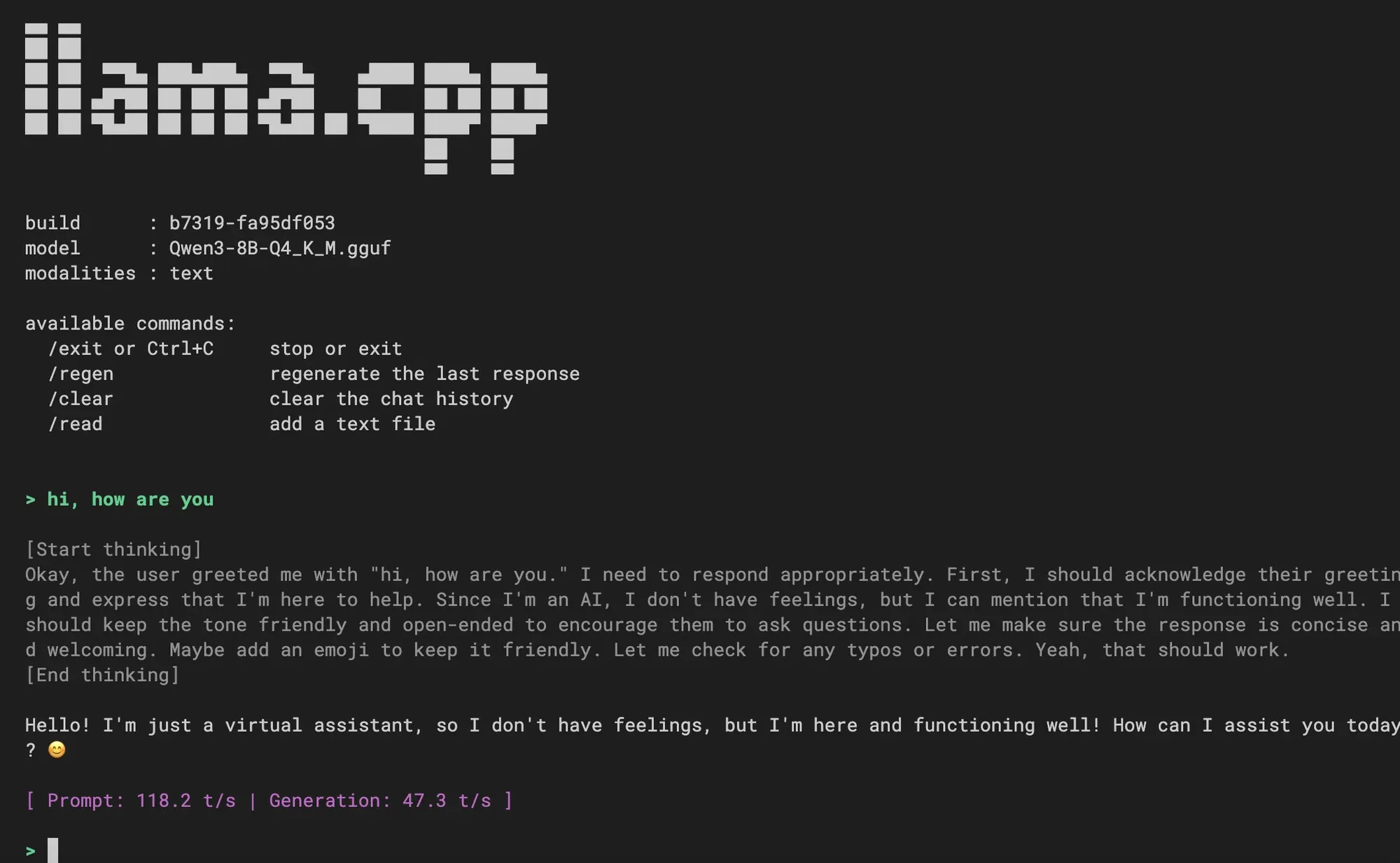

llama.cpp integra una nueva experiencia CLI : llama.cpp ha integrado una nueva experiencia de interfaz de línea de comandos (CLI), ofreciendo una interfaz más limpia, soporte multimodal, control de diálogo mediante comandos, soporte para decodificación especulativa y soporte para plantillas Jinja. Los usuarios han acogido esto con agrado y han preguntado si se integrarán funciones de coding Agent en el futuro, lo que presagia una mejora en la experiencia de interacción con LLM locales. (Fuente: _akhaliq, Reddit r/LocalLLaMA)

VS Code integra modelos de Hugging Face : La transmisión en vivo del lanzamiento de Visual Studio Code mostrará cómo usar modelos compatibles con Hugging Face Inference Providers directamente en VS Code, lo que facilitará enormemente a los desarrolladores el uso de modelos de IA en el IDE, logrando una programación asistida por IA y flujos de trabajo de desarrollo más integrados. (Fuente: huggingface)

📚 Aprendizaje

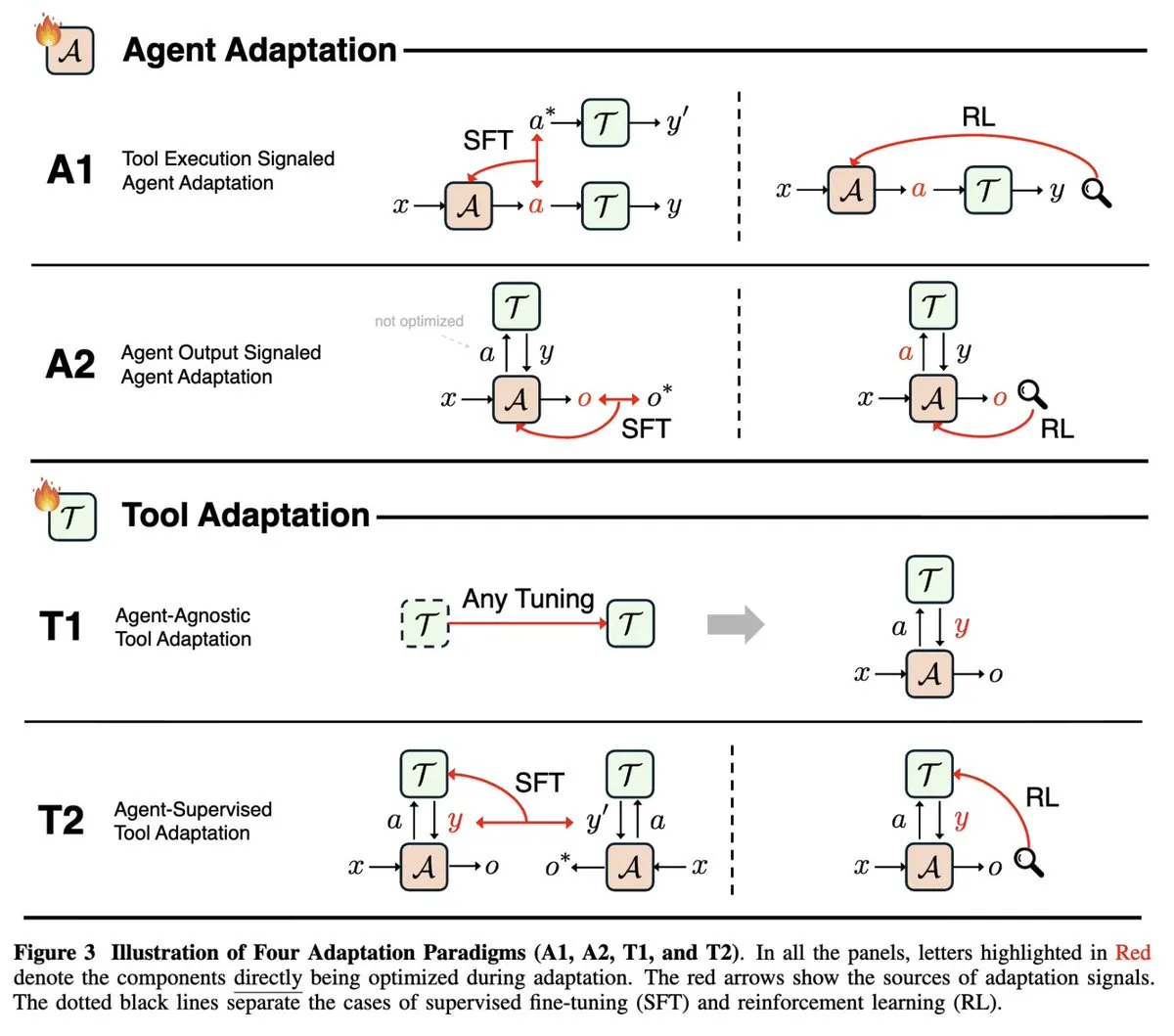

Revisión de la investigación sobre la adaptabilidad de AI Agent : Un estudio de investigación en NeurIPS 2025, “Adaptabilidad de la IA Agéntica”, unifica los campos de rápido desarrollo de la adaptación de Agent (señales de ejecución de herramientas vs. señales de salida de Agent) y la adaptación de herramientas (independiente de Agent vs. supervisada por Agent), clasificando los trabajos existentes sobre Agent en cuatro paradigmas de adaptación, proporcionando un marco teórico completo para comprender y desarrollar AI Agent. (Fuente: menhguin)

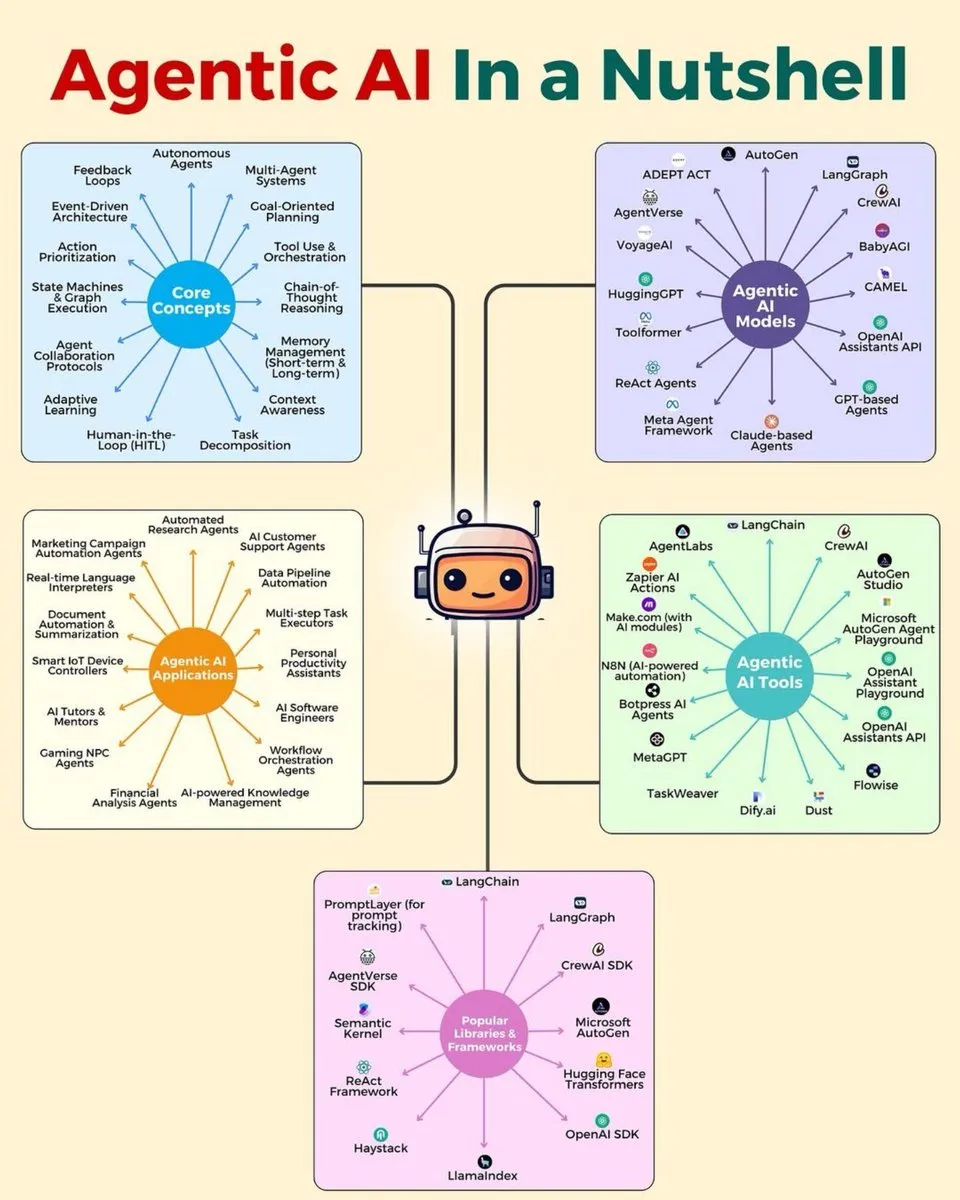

Hoja de ruta de habilidades de aprendizaje profundo e IA : Se compartieron varias infografías que cubren la arquitectura jerárquica de AI Agents, el stack de AI Agents para 2025, el conjunto de habilidades de análisis de datos, 7 habilidades de análisis de datos de alta demanda, la hoja de ruta del aprendizaje profundo y 15 pasos para aprender IA, entre otros, proporcionando a estudiantes y desarrolladores en el campo de la IA una guía completa de habilidades y arquitectura, impulsando el desarrollo profesional. (Fuente: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Cursos y libros gratuitos de aprendizaje profundo : François Fleuret ha ofrecido su curso completo de aprendizaje profundo, que incluye 1000 diapositivas y capturas de pantalla, así como “El pequeño libro del aprendizaje profundo”, ambos publicados bajo licencia Creative Commons, proporcionando a los estudiantes valiosos recursos gratuitos que cubren los fundamentos del aprendizaje profundo, como su historia, topologías, álgebra lineal y cálculo. (Fuente: francoisfleuret)

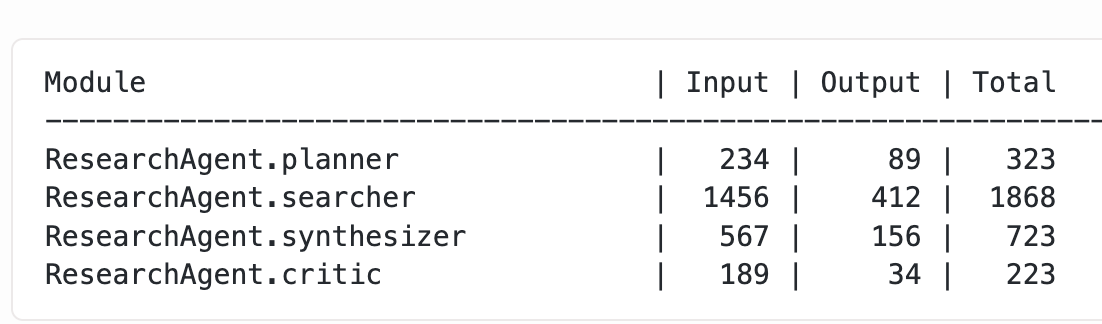

Optimización de LLM y técnicas de entrenamiento : Varunneal, mediante técnicas como la programación del tamaño de lote y Cautious Weight Decay, Normuon tuning, ha establecido un nuevo récord mundial en NanoGPT Speedrun (132 segundos, 30 pasos/segundo). Al mismo tiempo, un blog explora métodos para obtener el uso granular de tokens de módulos DSPy anidados, proporcionando experiencia práctica y detalles técnicos para el entrenamiento y la optimización del rendimiento de los LLM. (Fuente: lateinteraction, kellerjordan0)

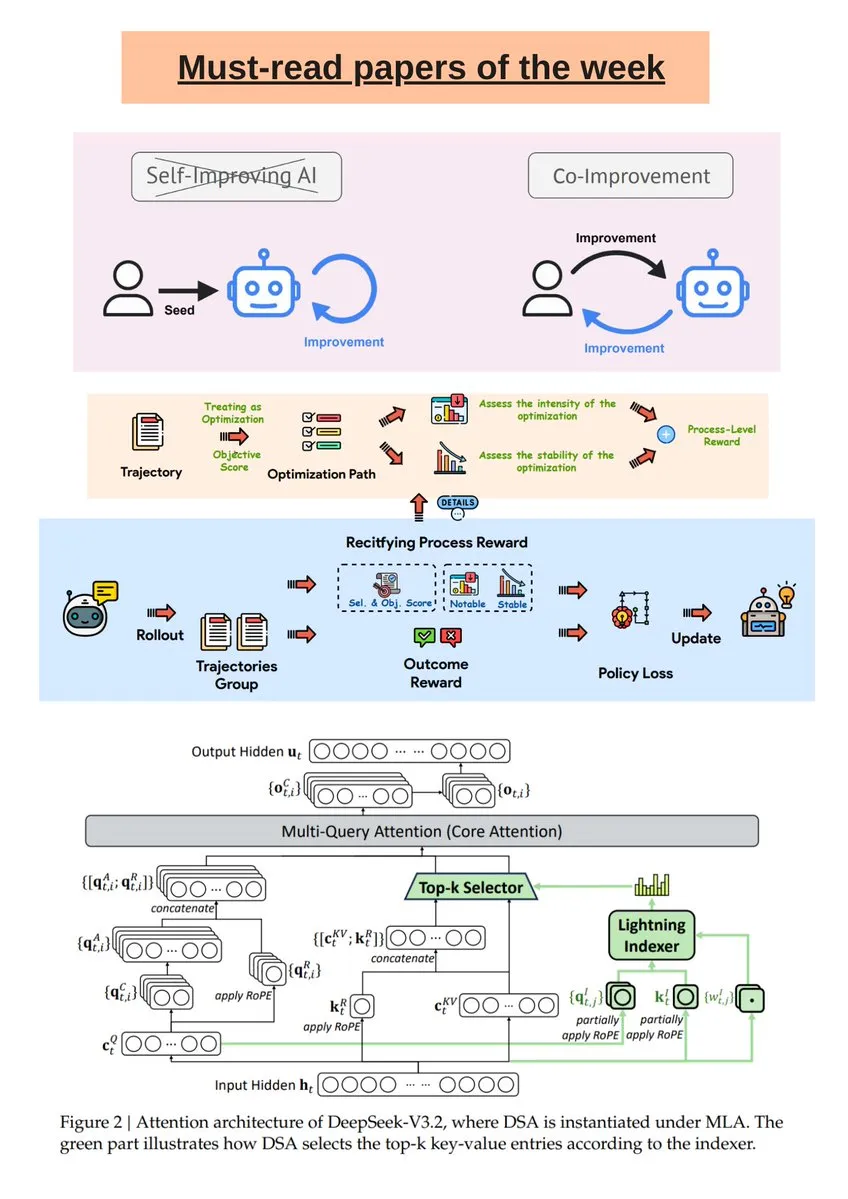

Informe semanal de investigación de IA y análisis del modelo DeepSeek R1 : Turing Post ha publicado una selección semanal de investigación en IA, que cubre la mejora conjunta de IA y humanos, DeepSeek-V3.2, LLM autoevolutivos guiados, entre otros. Además, un artículo de Science News explora en profundidad el modelo DeepSeek R1, aclarando malentendidos comunes sobre sus operaciones como “thinking tokens” y RL-in-Name-Only, ayudando a los lectores a comprender mejor la investigación de vanguardia en IA. (Fuente: TheTuringPost, rao2z)

Calidad de datos de IA y MLOps : En el aprendizaje profundo, incluso pequeños errores de etiquetado en los datos de entrenamiento pueden afectar gravemente el rendimiento del modelo. La discusión enfatiza la importancia de procesos de control de calidad como la auditoría multifase, las verificaciones automatizadas, la detección de anomalías incrustada, los acuerdos entre anotadores y las herramientas dedicadas, para garantizar la fiabilidad de los datos de entrenamiento en aplicaciones a escala, mejorando así el rendimiento general del modelo. (Fuente: Reddit r/deeplearning)

Construyendo un LLM fundacional de juguete desde cero : Un desarrollador compartió su experiencia construyendo un LLM fundacional de juguete desde cero, utilizando ChatGPT para ayudar a generar capas de atención, bloques Transformer y MLP, y entrenando en el conjunto de datos TinyStories. El proyecto proporciona un cuaderno Colab completo, diseñado para ayudar a los estudiantes a comprender el proceso de construcción y los principios básicos de los LLM. (Fuente: Reddit r/deeplearning)

💼 Negocios

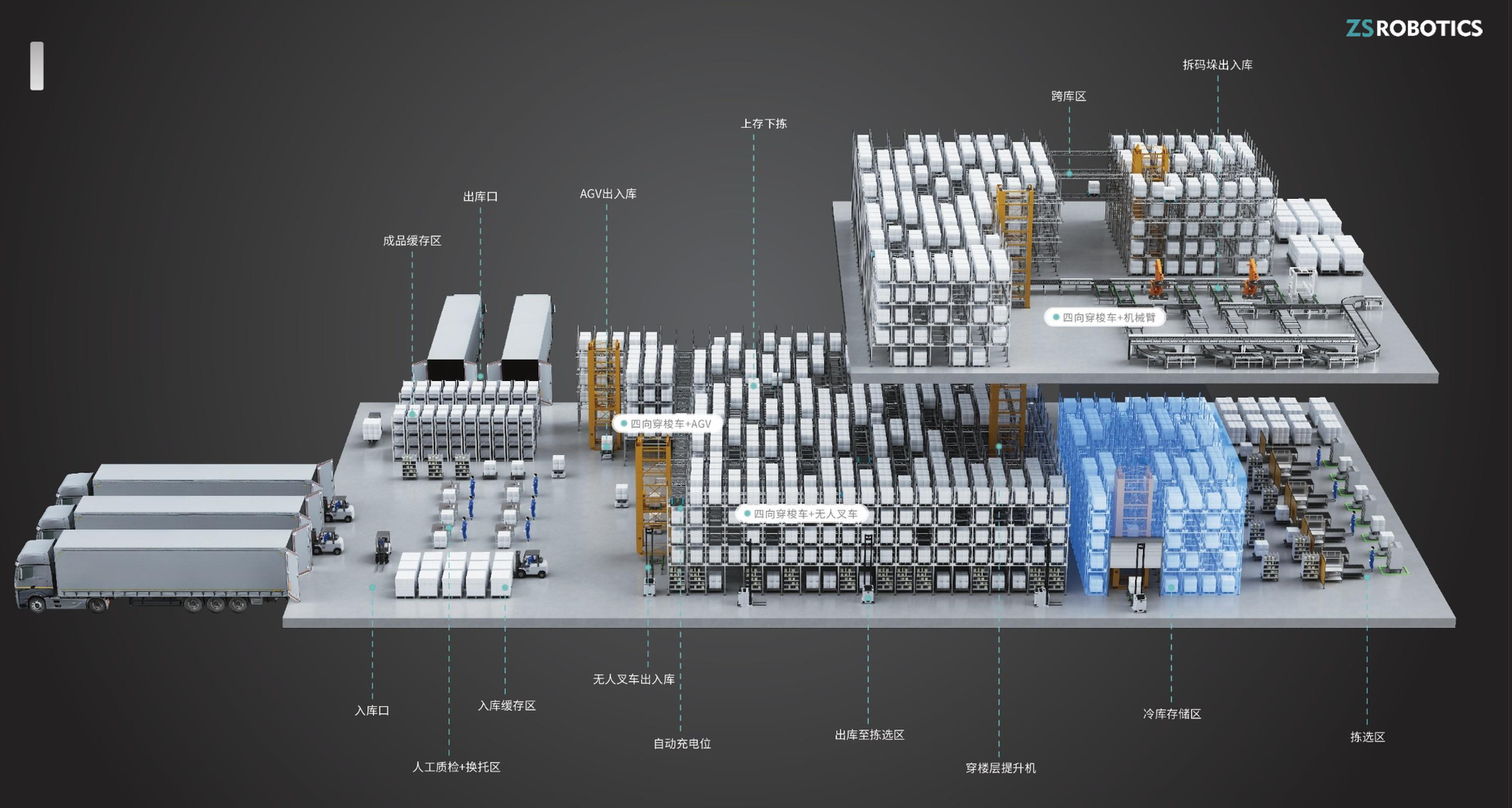

“ZhiShi Robotics” cierra una ronda de financiación Serie A+ de decenas de millones de yuanes : La empresa de robots de almacén “ZhiShi Robotics”, especializada en la I+D y fabricación de vehículos de lanzadera de cuatro vías, ha completado recientemente una ronda de financiación Serie A+ de decenas de millones de yuanes, con la inversión exclusiva de YinFeng Capital. Los productos de la empresa son conocidos por su seguridad, facilidad de uso y alta modularidad, logrando un crecimiento anual de ingresos del 200%-300% y expandiéndose a mercados extranjeros, proporcionando un fuerte apoyo para la mejora del almacenamiento inteligente. (Fuente: 36氪)

Baseten adquiere la startup de RL Parsed : Baseten, proveedor de servicios de inferencia, ha adquirido la startup de aprendizaje por refuerzo (RL) Parsed. Esto refleja la creciente importancia de RL en la industria de la IA y el enfoque del mercado en la optimización de las capacidades de inferencia de modelos de IA. Se espera que esta adquisición fortalezca la competitividad de Baseten en el campo de los servicios de inferencia de IA. (Fuente: steph_palazzolo)

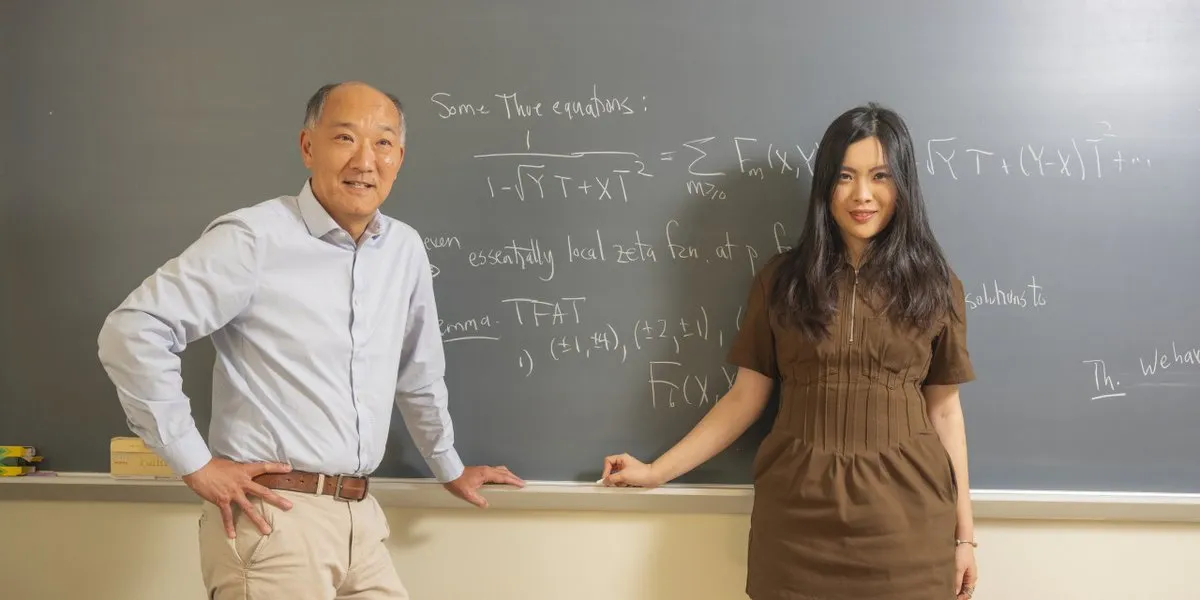

Leyenda matemática se une a una startup de IA : La leyenda matemática Ken Ono ha dejado el mundo académico para unirse a una startup de IA fundada por un joven de 24 años. Esto marca una tendencia de talento de élite migrando al campo de la IA, y presagia la vitalidad del ecosistema de startups de IA y una nueva dirección para la integración de talentos interdisciplinarios. (Fuente: CarinaLHong)

🌟 Comunidad

Debate sobre el impacto de la IA en el mercado laboral, la socioeconomía y la automatización de fábricas : El impacto de la IA en el mercado laboral y la socioeconomía ha provocado un intenso debate. Una parte cree que la IA llevará el valor del trabajo a cero, pidiendo una reconfiguración del capitalismo a través de “infraestructura básica universal” y “dividendos de robots” para asegurar la subsistencia básica y animar a los humanos a perseguir el arte y la exploración. La otra parte insiste en la “falacia del volumen de trabajo”, creyendo que la IA creará más nuevas industrias y oportunidades de empleo, los humanos se moverán hacia roles de gestión de IA, y señala que la IA física automatizará la mayoría de los trabajos de fábrica en una década. (Fuente: Plinz, Reddit r/ArtificialInteligence, hardmaru, SakanaAILabs, nptacek, Reddit r/artificial)

El papel de la IA en el apoyo a la salud mental, la investigación científica y las controversias éticas : Un usuario compartió su experiencia de cómo Claude AI le brindó apoyo durante una grave crisis de salud mental, afirmando que le ayudó a superar el momento difícil como un terapeuta. Esto resalta el potencial de la IA en el apoyo a la salud mental, pero también ha provocado debates sobre la ética y las limitaciones del apoyo emocional de la IA. Al mismo tiempo, se ha desatado un intenso debate sobre si la IA debería automatizar completamente la investigación científica. Una parte argumenta que retrasar la automatización (por ejemplo, la cura del cáncer) para preservar el placer del descubrimiento humano es inmoral; la otra parte teme que la automatización completa pueda llevar a la humanidad a perder su propósito, e incluso cuestiona si los avances impulsados por la IA beneficiarán a todos de manera equitativa. (Fuente: Reddit r/ClaudeAI, BlackHC, TomLikesRobots, aiamblichus, aiamblichus, togelius)

Controversias sobre la censura de LLM, la publicidad comercial y la privacidad de los datos del usuario : Los usuarios de ChatGPT están insatisfechos debido a su estricta censura de contenido y respuestas “aburridas”, y muchos están recurriendo a competidores como Gemini y Claude, considerándolos mejores en contenido para adultos y conversación libre. Esto ha llevado a una disminución en las suscripciones de ChatGPT y ha provocado debates sobre los estándares de censura de la IA y las diferencias en las necesidades de los usuarios. Al mismo tiempo, la prueba de funciones publicitarias por parte de ChatGPT ha generado una fuerte aversión entre los usuarios, quienes creen que la publicidad dañaría la objetividad de la IA y la confianza del usuario, resaltando los desafíos éticos comerciales de la IA. Además, algunos usuarios han informado que OpenAI eliminó sus registros de conversaciones antiguas de GPT-4o, lo que ha generado preocupaciones sobre la propiedad de los datos de los servicios de IA y la censura de contenido, y se recomienda a los usuarios que hagan copias de seguridad de sus datos localmente. (Fuente: Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT, 36氪, Yuchenj_UW, aiamblichus)

Dilemas de los desarrolladores de AI Agent y consideraciones prácticas para la referencia de LLM en la búsqueda de empleo : Aunque los AI Agent se promocionan como muy potentes, los desarrolladores siguen trabajando horas extras, lo que ha provocado un cuestionamiento humorístico sobre la brecha entre la publicidad de la IA y la eficiencia real del trabajo. Al mismo tiempo, John Carmack ha propuesto que el historial de chat de un usuario con un LLM podría servir como una “entrevista extendida” para la búsqueda de empleo, permitiendo que el LLM forme una evaluación del candidato sin revelar datos privados, mejorando así la precisión de la contratación. (Fuente: amasad, giffmana, VictorTaelin, fabianstelzer, mbusigin, _lewtun, VictorTaelin, max__drake, dejavucoder, ID_AA_Carmack)

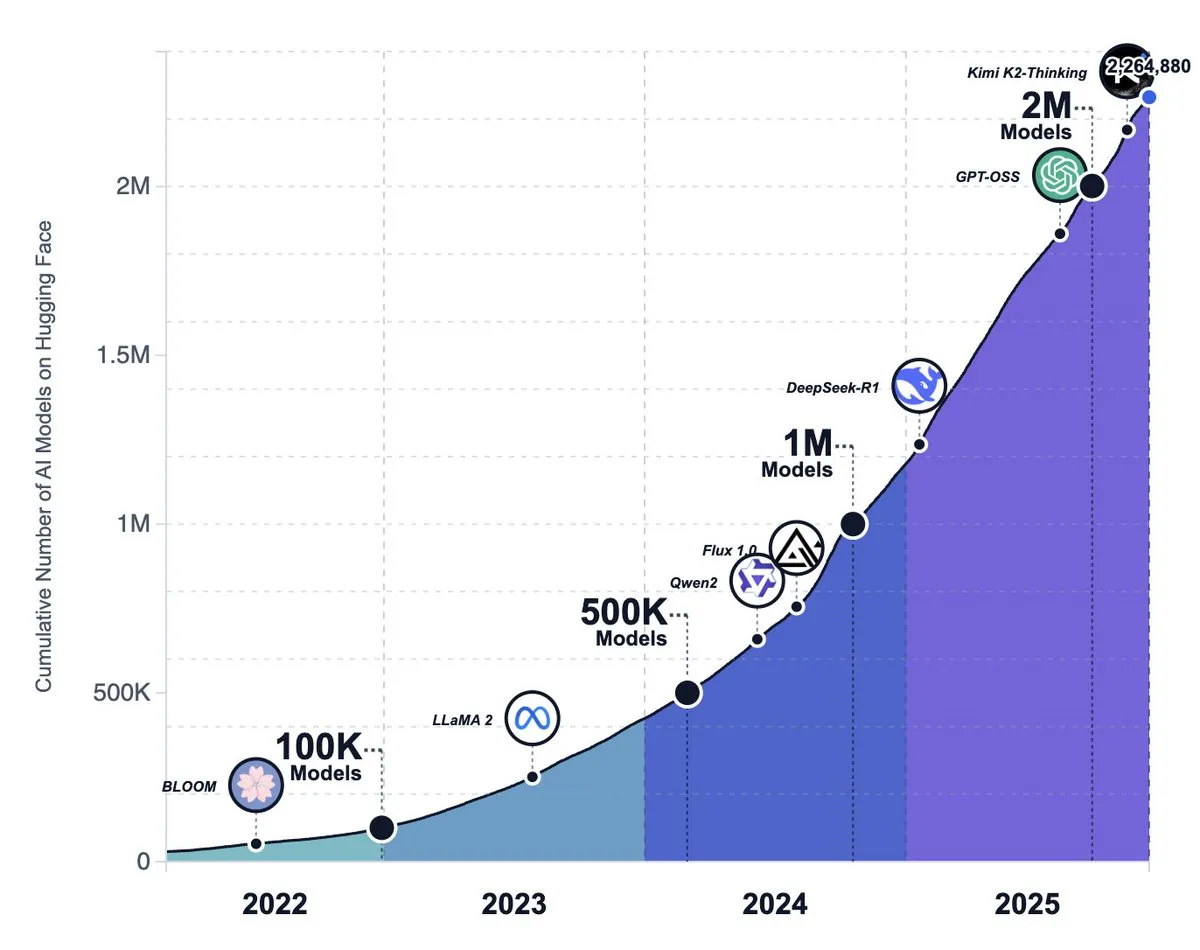

El auge del ecosistema de IA de código abierto, las tendencias de los modelos y el debate sobre el cambio de estrategia de Meta : El número de modelos en la plataforma Hugging Face ha superado los 2.2 millones, mostrando que los modelos de IA de código abierto están creciendo a un ritmo asombroso y se cree que eventualmente superarán a los grandes laboratorios de vanguardia. Sin embargo, también se argumenta que los modelos de código abierto aún tienen una brecha con los modelos de código cerrado en la experiencia a nivel de producto (como entornos de ejecución, capacidades multimodales), y muchos proyectos de código abierto se enfrentan al estancamiento o al abandono. Al mismo tiempo, se rumorea que Meta está cambiando para abandonar su estrategia de IA de código abierto. (Fuente: huggingface, huggingface, huggingface, ZhihuFrontier, natolambert, _akhaliq)

La IA en la vida cotidiana: Sam Altman habla sobre la crianza y la IA : Sam Altman ha declarado que le resulta difícil imaginar cómo criar a un recién nacido sin ChatGPT, lo que ha provocado un debate sobre el papel cada vez mayor de la IA en la vida personal y las decisiones diarias. Esto refleja cómo la IA ha comenzado a penetrar en los escenarios familiares más íntimos, convirtiéndose en una herramienta auxiliar indispensable en la vida moderna. (Fuente: scaling01)

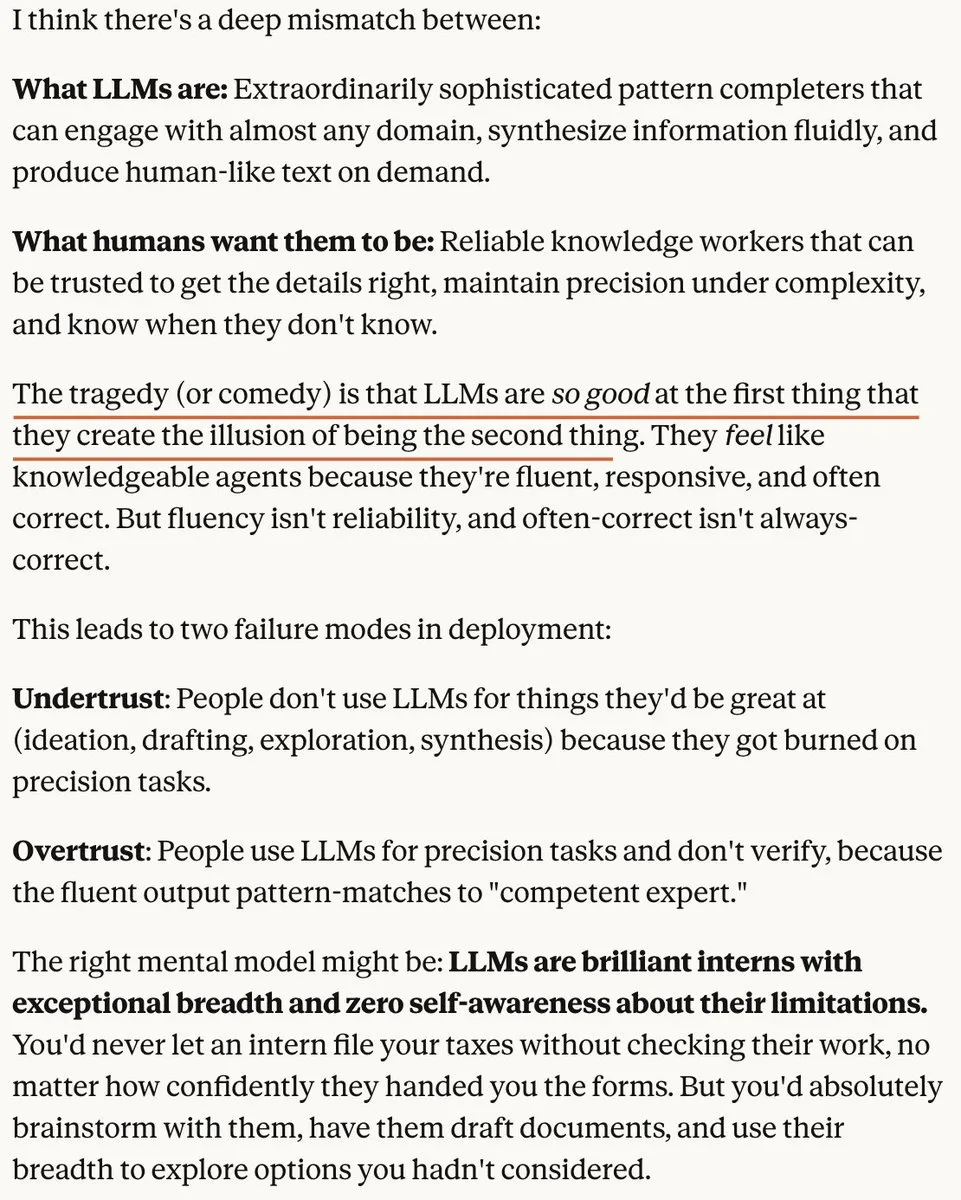

Teoría de la “burbuja” en el campo de la IA y la creciente competencia en el mercado de modelos de imagen : Algunos argumentan que el mercado actual de LLM tiene una “burbuja”, no porque los LLM no sean potentes en sí mismos, sino porque la gente tiene expectativas poco realistas sobre ellos. Otro punto de vista señala que, a medida que disminuyen los costos de ejecución de la IA, el valor de las ideas originales será cada vez mayor. Al mismo tiempo, la competencia en el mercado de modelos de imágenes de IA se intensifica, y se rumorea que OpenAI lanzará un modelo actualizado para hacer frente a competidores como Nano Banana Pro. (Fuente: aiamblichus, cloneofsimo, op7418, dejavucoder)

Calidad del contenido de IA, integridad académica y controversias éticas comerciales : Un anuncio de IA de McDonald’s fue retirado debido a un marketing “desastroso”, lo que subraya la dualidad de las herramientas de IA para amplificar la creatividad o la estupidez humana. Al mismo tiempo, se descubrió que el 21% de las revisiones de manuscritos en una importante conferencia internacional de IA fueron generadas por IA, lo que ha suscitado serias preocupaciones sobre la integridad académica. Además, Instacart ha sido acusada de inflar los precios de los productos mediante experimentos de precios con IA, lo que ha generado preocupaciones sobre la ética comercial de la IA. (Fuente: Reddit r/artificial, Reddit r/ArtificialInteligence, Reddit r/artificial)

Impacto de la IA en el futuro del trabajo y las necesidades de habilidades : El impacto de la IA en el empleo de desarrolladores junior ha provocado debates. Algunos argumentan que la IA reemplazará los trabajos básicos, pero también puede ayudar a los desarrolladores a aprender y dar forma a las herramientas a través de redes de código abierto y mentores. Al mismo tiempo, la IA hace que habilidades avanzadas como el pensamiento sistémico, la descomposición funcional y la abstracción de la complejidad sean más importantes, lo que refleja la demanda del futuro mercado laboral por talentos multifacéticos. (Fuente: LearnOpenCV, code_star, nptacek)

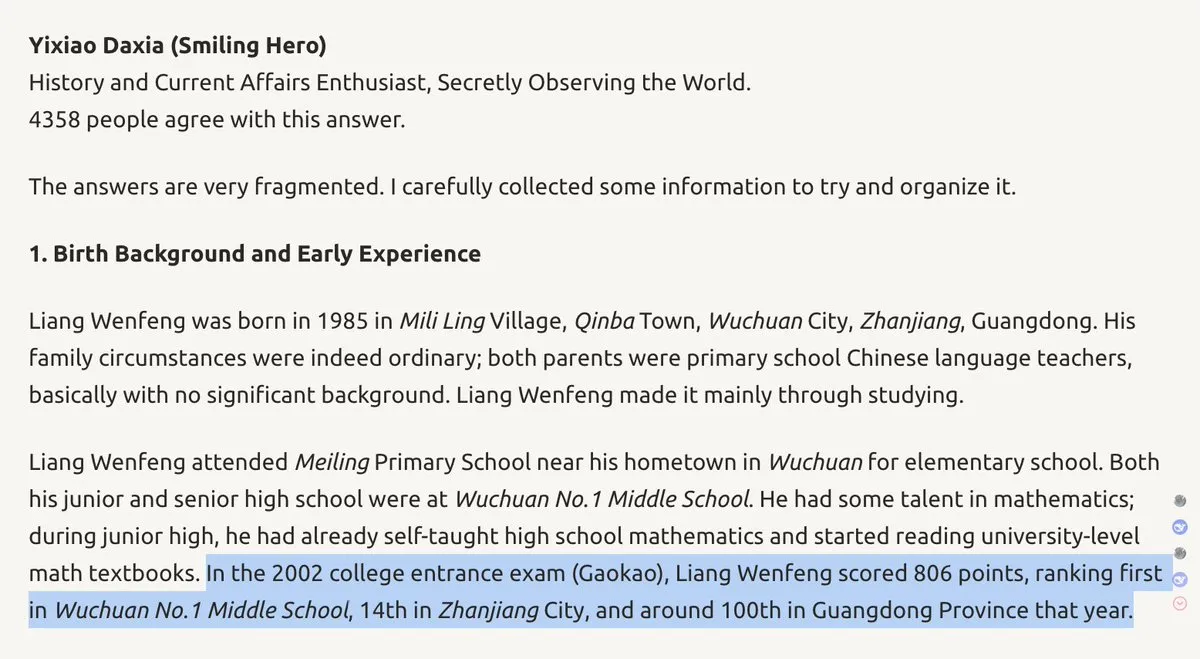

Antecedentes del fundador de DeepSeek y estrategia de la empresa : Wenfeng, fundador de DeepSeek, es descrito como un “protagonista de otro mundo” con una alta clasificación en el Gaokao y una sólida formación en ingeniería eléctrica. Su impulso único, creatividad y espíritu intrépido podrían influir en la hoja de ruta tecnológica de DeepSeek e incluso cambiar el panorama de la competencia de IA entre EE. UU. y China. Esto subraya la importancia de las características personales de los líderes en el campo de la IA para el desarrollo de la empresa. (Fuente: teortaxesTex, teortaxesTex)

Afirmaciones y escepticismo sobre los sistemas AGI : Una empresa de Tokio afirma haber desarrollado el “primer” sistema AGI del mundo, con capacidades de autoaprendizaje, seguridad, fiabilidad y eficiencia energética. Sin embargo, debido a su definición no estándar de AGI y la falta de pruebas concretas, la afirmación ha generado un escepticismo generalizado en la comunidad de IA, resaltando la complejidad de la definición y verificación de AGI. (Fuente: Reddit r/ArtificialInteligence)

Debate sobre las limitaciones físicas de la inteligencia artificial general : Tim Dettmers publicó una entrada de blog argumentando que la Inteligencia Artificial General (AGI) y la superinteligencia significativa no serán posibles debido a las realidades físicas de la computación y los cuellos de botella en las mejoras de GPU. Este punto de vista desafía el optimismo generalizado en el campo actual de la IA, provocando una profunda reflexión sobre la trayectoria futura del desarrollo de la IA. (Fuente: Tim_Dettmers, Tim_Dettmers)

💡 Otros

Evaluación del rendimiento de modelos de IA: la brecha entre datos sintéticos y experiencia real : Se ha señalado en debates que existe una brecha significativa entre las puntuaciones de referencia de los modelos de IA y la experiencia real a nivel de producto. Muchos modelos de código abierto rinden bien en los benchmarks, pero aún están por detrás de los modelos de código cerrado en entornos de ejecución, capacidades multimodales y manejo de tareas complejas, enfatizando que “los benchmarks no equivalen a la experiencia real”, y que la IA de imagen y video demuestra el progreso de la IA de manera más intuitiva que los LLM de texto. (Fuente: op7418, ZhihuFrontier, op7418, Dorialexander)

El consumo de energía de los centros de datos provoca una reacción social : Residentes de todo Estados Unidos han expresado una fuerte oposición debido al aumento de las facturas de electricidad causado por la proliferación de centros de datos. Más de 200 organizaciones ecologistas han pedido una moratoria nacional en la construcción de nuevos centros de datos, subrayando el enorme impacto de la infraestructura de IA en el medio ambiente y la energía, así como la tensión entre el desarrollo tecnológico y la asignación de recursos sociales. (Fuente: MIT Technology Review)