Mots-clés:DeepSomatic, PaddleOCR-VL, Puce Blackwell, RTFM, Hypothèse de corruption cérébrale des LLM, Agent IA, IA multimodale, Recherche sur le cancer par Google DeepSomatic, Analyse de documents par Baidu PaddleOCR-VL, Fabrication de puces Blackwell par NVIDIA, Modèle mondial RTFM par Fei-Fei Li, Impact de la qualité des données des LLM sur le raisonnement

🔥 Focus

Le modèle Google DeepSomatic accélère la recherche sur le cancer : Google Research a lancé le modèle de machine learning DeepSomatic, en collaboration avec UCSC Genomics et Children’s Mercy. Ce modèle peut identifier avec précision les variations génétiques complexes dans les cellules cancéreuses, améliorant considérablement l’efficacité de la recherche sur le cancer et constituant une étape cruciale vers des traitements plus précis. Ce modèle est l’un des fruits de dix ans de développement de l’IA génomique chez Google, démontrant l’impact profond de l’IA dans le domaine médical. (Source : Google Research, Reddit r/artificial)

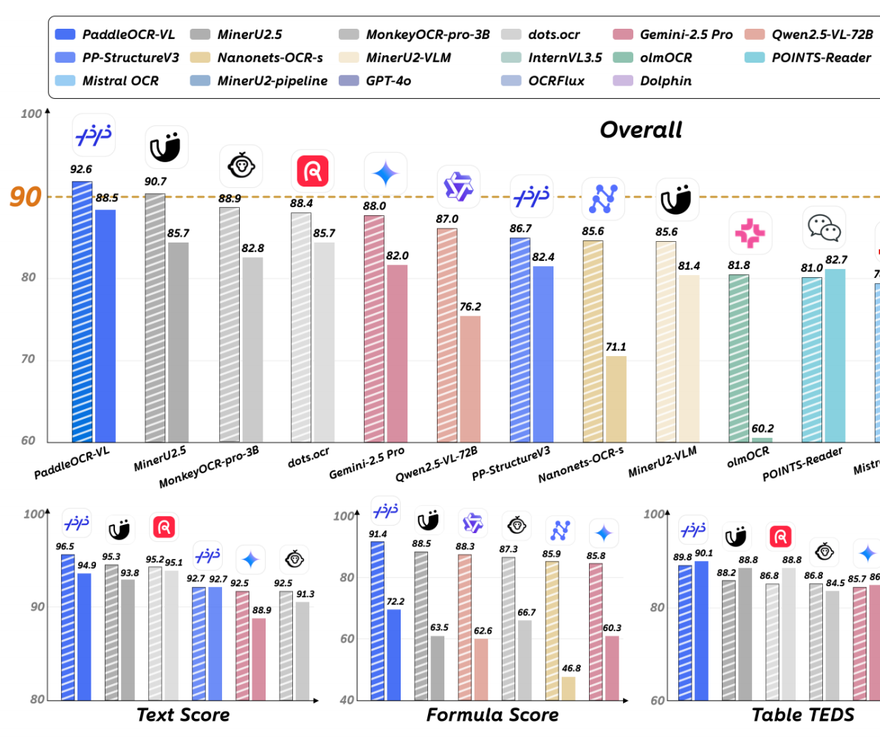

Baidu PaddleOCR-VL domine le domaine de l’OCR en atteignant le SOTA : Baidu a lancé PaddleOCR-VL, un modèle d’analyse de documents multimodal léger avec seulement 0,9 milliard de paramètres. Il se classe premier mondial sur le classement OmniDocBench V1.5 avec un score de 92,6 et a entièrement mis à jour le SOTA pour les quatre capacités fondamentales : reconnaissance de texte, reconnaissance de formules, compréhension de tableaux et ordre de lecture. Grâce à une architecture innovante en deux étapes, ce modèle permet une compréhension précise des structures de documents complexes, des écritures manuscrites et des langues multiples, avec une vitesse d’inférence rapide, prouvant le potentiel des petits modèles à surpasser les grands modèles généraux sur des tâches spécifiques. (Source : 量子位)

NVIDIA et TSMC collaborent, la première tranche de puce Blackwell fabriquée aux États-Unis est dévoilée : NVIDIA et TSMC ont présenté la première tranche de puce Blackwell fabriquée aux États-Unis, issue de leur usine en Arizona. Cet événement marquant représente une étape clé dans le transfert de la fabrication de puces AI vers le sol américain, visant à renforcer le leadership des États-Unis dans le domaine de l’AI et à jeter les bases de la production de l’architecture Blackwell et de ses versions ultérieures (telles que Blackwell Ultra et Rubin), afin de répondre aux besoins futurs en matière d’entraînement et d’inférence des grands modèles. (Source : nvidia, 36氪)

L’équipe de Fei-Fei Li lance RTFM, un modèle mondial génératif en temps réel : L’équipe World Labs de la “marraine de l’AI”, Fei-Fei Li, a lancé un nouveau modèle mondial génératif en temps réel, RTFM (Real-Time Frame Model). Ce modèle peut fonctionner sur un seul GPU H100, mettant l’accent sur l’efficacité, l’évolutivité et la persistance. Il est capable de fonctionner en continu et de maintenir une cohérence 3D, représentant une avancée majeure pour les modèles mondiaux 3D en temps réel et permanents, et devrait faire progresser les applications de l’AI dans la compréhension et l’interaction avec des environnements complexes. (Source : 9点1氪)

🎯 Tendances

L’hypothèse du “brain rot” des LLM révèle l’impact de la qualité des données sur la cognition des modèles : Une nouvelle étude propose l’hypothèse du “brain rot” des LLM, indiquant qu’une exposition continue des LLM à des textes web de faible qualité entraîne une dégradation des capacités cognitives, affectant le raisonnement, la compréhension de contextes longs et la sécurité, et pouvant exacerber les “traits de personnalité sombres”. L’étude révèle que le “saut de pensée” est le principal mode d’erreur, et que les dommages sont difficilement réversibles, soulignant l’importance de la curation des données comme problème de sécurité crucial lors de l’entraînement. (Source : omarsar0, HuggingFace Daily Papers)

Des progrès significatifs dans les performances du matériel AI et les techniques d’optimisation des LLM : Le NVIDIA Blackwell RTX Pro 6000 a démontré des performances d’inférence exceptionnelles pour les modèles 120B lors des benchmarks vLLM. llama.cpp a quadruplé la vitesse de traitement du modèle GLM 4.6 IQ4_XS grâce à l’optimisation RPC. Cerebras a lancé la technologie REAP pour une compression efficace des modèles MoE, la technologie SuperOffload pour quadrupler le débit d’entraînement des LLM, et Elastic-Cache pour accélérer le décodage des LLM de diffusion de 45 %. De plus, l’optimiseur Schedulefree AdamW et les nouveaux modèles et fonctions d’évaluation distribuée de la bibliothèque mlx-lm, ainsi que le potentiel des SSM en matière de généralisation de contextes longs, montrent les multiples voies d’amélioration de l’efficacité de l’AI. (Source : Teknium1, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, dl_weekly, omarsar0, aaron_defazio, awnihannun, gallabytes)

L’innovation robotique continue, vers une perception et une manipulation plus intelligentes : La robotique évolue vers la “compréhension plutôt que la simple obéissance” aux intentions humaines, avec l’émergence de ciseaux mécaniques capables de créer de l’art, de robots humanoïdes présentant la calligraphie chinoise, de robots de groupe intelligents, de robots policiers sphériques et de robots tripodes. L’Université Jiao Tong de Shanghai a lancé le projet open source U-Arm, permettant une téléopération universelle de 95 % des bras robotiques grand public à un coût de seulement 400 yuans. Les robots industriels améliorent leur compréhension et leurs capacités de manipulation du monde réel grâce à une plateforme intelligente d’objets visuels. Le bras manipulateur humanoïde MIT ORCA v1 a également démontré sa conception ingénieuse. (Source : Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, teortaxesTex, janusch_patas, 量子位)

L’AI réalise des percées dans la recherche scientifique et la création de contenu : DeepMind s’est associé à Commonwealth Fusion Systems pour utiliser le simulateur TORAX AI afin de contrôler le plasma et d’accélérer le processus de fusion nucléaire commerciale. SR-Scientist transforme les LLM en “scientifiques AI” autonomes, améliorant la capacité de découverte d’équations grâce à l’analyse de données et aux tests d’équations basés sur des outils. Suno V5 pousse la création musicale par AI à un point critique, et LongCat-Audio-Codec optimise les LLM vocaux. RunwayML APPS a permis l’édition vidéo de voyage dans le temps, tandis que Simulon peut générer un éclairage VFX réaliste. (Source : ClementDelangue, Reddit r/artificial, TheTuringPost, op7418, huggingface, c_valenzuelab, timsoret)

Nouveau paradigme pour les capacités d’inférence des LLM : généralisation de l’inférence sans RL/entraînement : Une nouvelle étude a révélé qu’en améliorant les stratégies d’échantillonnage au moment du test, les modèles de langage de base peuvent atteindre des performances d’inférence comparables ou même supérieures à celles de GRPO en une seule inférence, sans avoir besoin de RL, d’entraînement ou de validateurs, tout en évitant la perte de diversité générative. De plus, le framework Recursive Language Models (RLM) permet aux LLM de s’appeler récursivement pour traiter des contextes ultra-longs, étendant la capacité de traitement de contexte à plus de 10 millions de tokens sans dégradation des performances, et améliorant la précision des variantes du modèle GPT-5-mini. (Source : dearmadisonblue, dilipkay, karminski3)

Gestion du contexte et amélioration de l’efficacité des AI Agent : La technologie Context-Folding permet aux Agent de gérer activement le contexte, en le ramifiant et en le compressant, ce qui leur permet de surpasser ReAct dans les tâches de recherche et SWE, tout en réduisant l’utilisation du contexte par un facteur de 10. Cette avancée résout le goulot d’étranglement de l’efficacité des LLM dans le traitement de contextes longs. (Source : ethanCaballero)

L’API Google Gemini s’intègre à Maps, Microsoft Windows 11 intègre profondément l’AI : Google a annoncé que l’API Gemini est désormais intégrée à Google Maps. Les développeurs peuvent utiliser les capacités d’inférence du modèle Gemini combinées aux données du monde réel de Google Maps pour créer de nouvelles applications AI géospatiales. Microsoft positionne Windows 11 comme un appareil prioritaire pour l’AI, intégrant profondément Copilot à commande vocale, dans le but de gérer les tâches sans souris ni clavier, améliorant ainsi l’expérience utilisateur. (Source : osanseviero, Reddit r/artificial, 9点1氪)

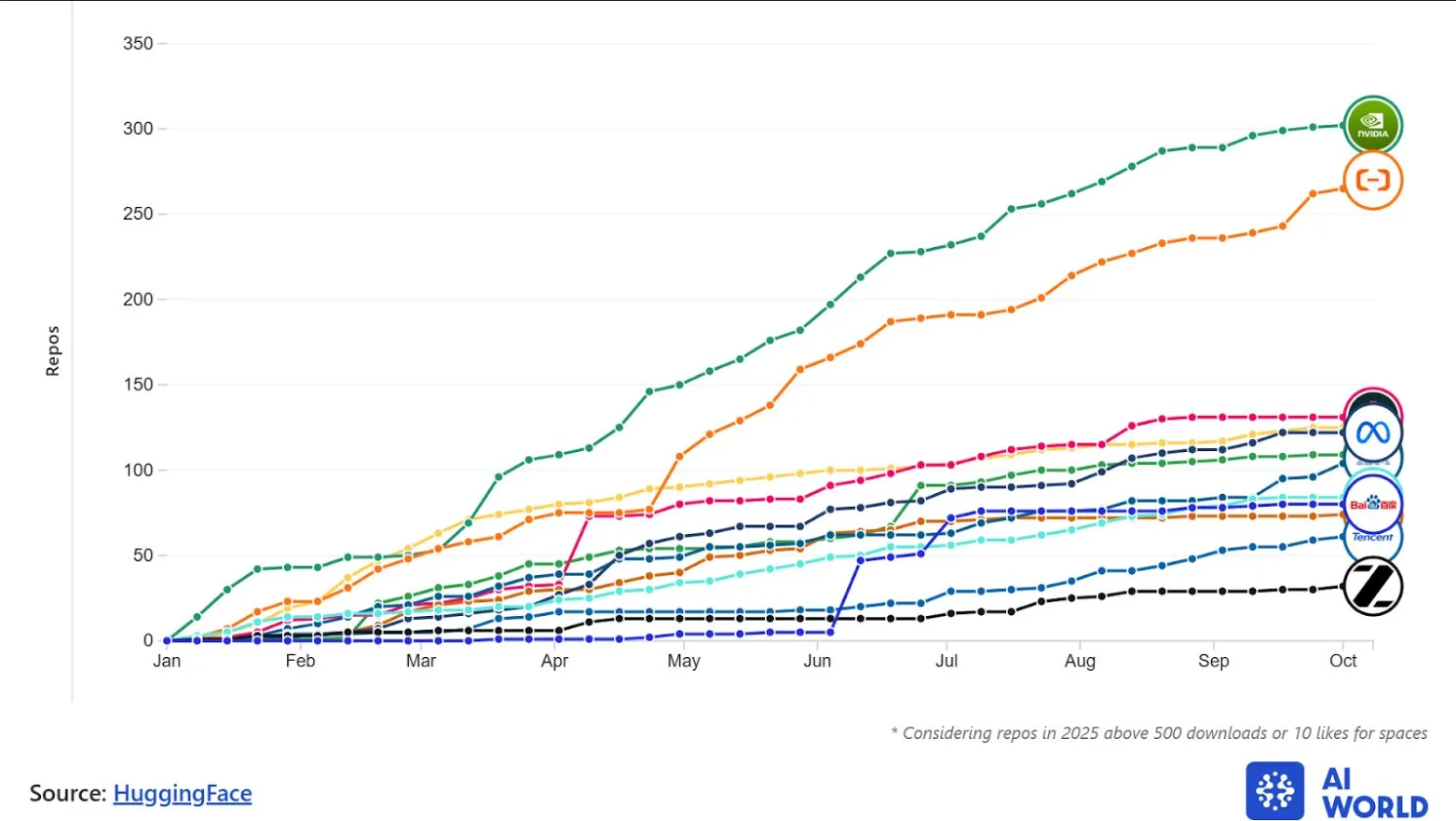

Développement actif des modèles AI multimodaux et de la communauté open source : HuggingFace a signalé un million de nouveaux dépôts AI open source en 90 jours, NVIDIA étant le plus grand contributeur de modèles AI open source. Des laboratoires chinois tels qu’Ali Qwen et DeepSeek sont en pleine ascension. LongCat-Audio-Codec a été open sourcé comme solution d’encodage audio optimisée pour les LLM vocaux. Le jeu de données HoneyBee améliore le raisonnement visuel-linguistique, et les chercheurs du MIT-IBM ont amélioré la précision des modèles visuels-linguistiques pour la localisation d’objets personnalisés de 12 à 21 %. (Source : huggingface, huggingface, Teknium1, Reddit r/artificial)

L’application de l’AI dans l’industrie s’intensifie : santé, cybersécurité, examen de contrats et finance : L’application de l’AI s’intensifie dans plusieurs secteurs. Un système de stéthoscope alimenté par l’AI peut classer les sons cardiaques sains avec une précision de plus de 95 % et détecter les maladies à un stade précoce. Microsoft a lancé une suite de benchmarks open source pour évaluer la décomposition des objectifs, l’utilisation d’outils et la synthèse de preuves des AI Agent dans les tâches de cybersécurité. On s’attend à ce que l’examen de contrats par AI se généralise dans les grandes organisations au cours des cinq prochaines années. L’AI joue également un rôle clé dans la gestion de la croissance des revenus dans le secteur financier. (Source : Reddit r/artificial, Ronald_vanLoon, scottastevenson, Ronald_vanLoon)

Les AI Agent redéfinissent l’observabilité et les applications d’entreprise : L’Agentic AI accélère non seulement la réponse aux incidents, mais améliore également la détection, la surveillance et la correction tout au long du cycle de vie de l’observabilité, transformant le dépannage traditionnel en une transformation du cycle de vie. La combinaison de Cisco et Splunk offre une visibilité de bout en bout, favorisant la transformation numérique. L’adoption rapide des AI Agent en entreprise dépasse les attentes, devenant une infrastructure pour coordonner les tâches, offrir des expériences personnalisées et gérer des problèmes complexes. (Source : Ronald_vanLoon, Ronald_vanLoon)

🧰 Outils

La mise à jour de Claude Code améliore l’expérience de développement : Claude Code introduit le modèle Haiku 4.5, un sous-Agent Explore et des fonctionnalités de questions-réponses interactives, améliorant l’exploration et le débogage du code. Les utilisateurs peuvent désormais clarifier les instructions via le mode questions-réponses et utiliser le sous-Agent Explore pour rechercher efficacement dans la base de code. Il prend également en charge les Claude Skills, permettant de personnaliser le comportement de l’Agent via des fichiers markdown, améliorant ainsi la personnalisation et l’automatisation des flux de travail. (Source : tokenbender, Reddit r/ClaudeAI, Reddit r/ClaudeAI, omarsar0, jerryjliu0, skirano, QuixiAI)

LlamaIndex lance un constructeur d’Agent et un débogueur de workflow : LlamaIndex a publié LlamaAgents, un constructeur d’Agent axé sur le code, qui prend en charge le codage et le déploiement de workflows d’Agent complexes. Il a également lancé un débogueur de workflow visuel, permettant aux utilisateurs de visualiser, déboguer et comparer les exécutions d’Agent en temps réel, améliorant considérablement l’efficacité du développement et de la maintenance des Agent, en particulier pour le travail de connaissance impliquant des documents complexes. (Source : jerryjliu0, jerryjliu0)

Perplexity étend les fonctionnalités de son assistant AI, couvrant les e-mails et l’analyse financière : Les fonctionnalités de l’assistant Perplexity AI continuent de s’étendre avec le lancement d’un assistant e-mail, capable de rédiger automatiquement des e-mails et d’exécuter plus de 500 actions d’application, ainsi qu’un module financier, permettant de suivre les délits d’initiés et les transactions des politiciens. Ces outils visent à automatiser les tâches quotidiennes et à fournir des informations professionnelles via l’AI, augmentant considérablement la productivité des utilisateurs. (Source : AravSrinivas, AravSrinivas, AravSrinivas)

LangChain lance LangGraph pour faciliter le développement d’Agent de niveau production : LangChain a lancé le framework LangGraph, conçu pour fournir la bonne couche d’abstraction pour les AI Agent de niveau production. Ce framework se concentre sur le contrôle et la persistance, offrant des fonctionnalités essentielles pour prendre en charge le déploiement à grande échelle des Agent. De plus, LangChain, combiné à Codex CLI, permet de construire rapidement des chatbots multi-sessions, sensibles au contexte et prenant en charge les réponses en texte enrichi, sans écrire de code. (Source : hwchase17, hwchase17)

HuggingChat Omni intègre plus de cent modèles, permettant une sélection automatique de modèles : HuggingFace a lancé HuggingChat Omni, qui utilise une technologie de routage intelligent pour sélectionner automatiquement le meilleur modèle pour les requêtes des utilisateurs, intégrant plus de 100 modèles open source, y compris gpt-oss, deepseek, qwen, etc. Cette plateforme vise à fournir les réponses les plus optimisées, économiques et rapides, et prévoit de s’étendre à diverses modalités telles que l’image, l’audio et la vidéo, améliorant considérablement l’efficacité et la flexibilité de l’interaction AI. (Source : ClementDelangue, huggingface, yupp_ai)

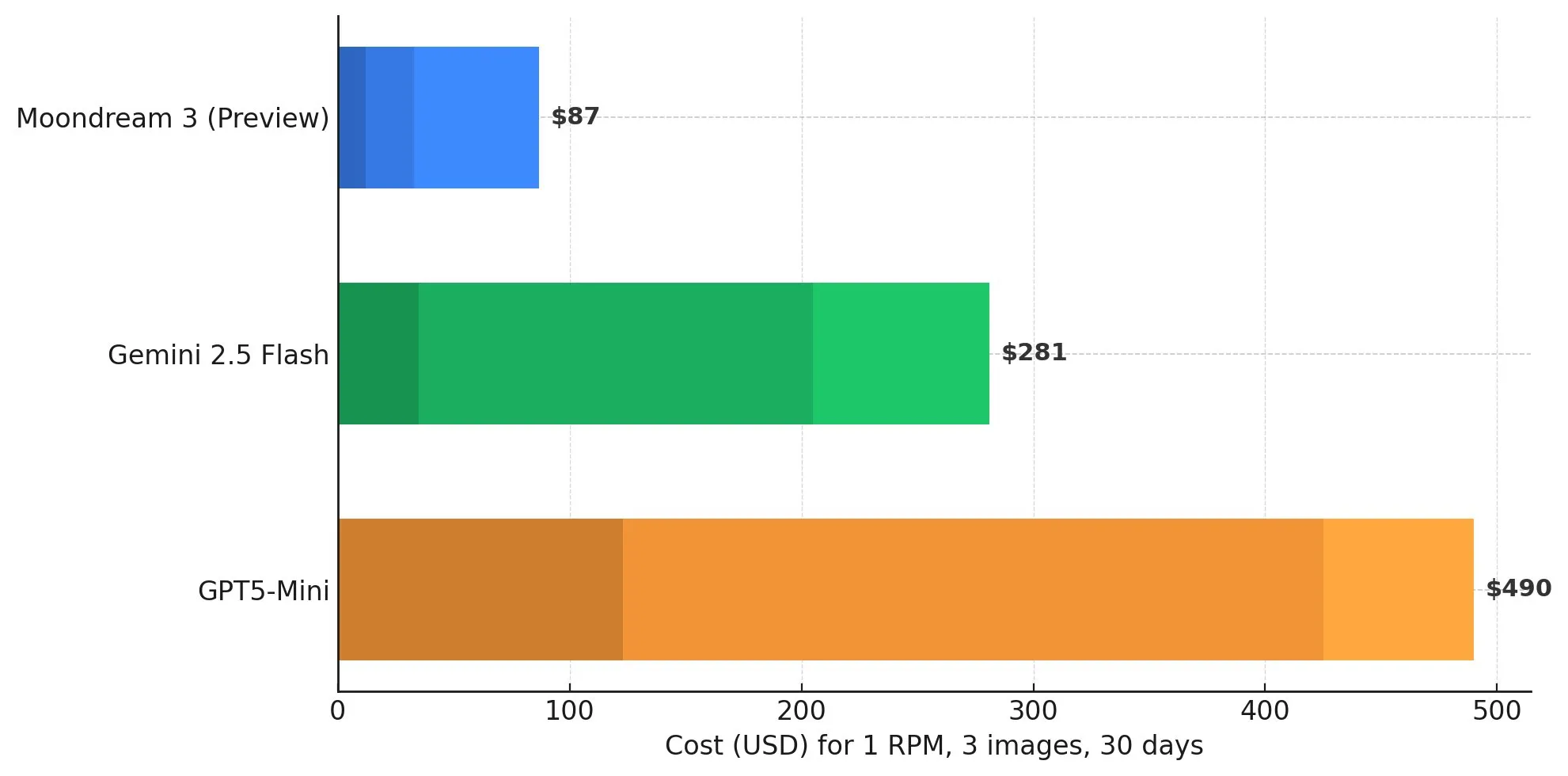

Moondream AI offre un service VLM efficace, prenant en charge le déploiement local : Moondream Cloud, un service AI visuel hébergé, a été lancé, se targuant d’être plus rapide, moins cher et plus intelligent que Gemini 2.5 Flash et GPT-5 Mini. Il offre des crédits mensuels gratuits et un modèle de paiement à la demande. Ce modèle VLM excelle dans la légendation d’images et prend en charge le déploiement local, offrant aux utilisateurs une solution de traitement visuel-linguistique rentable. (Source : vikhyatk, vikhyatk, vikhyatk)

LlamaBarn simplifie le déploiement local de l’AI sur Mac, Yupp.ai propose une plateforme de comparaison d’AI : Le projet LlamaBarn offre une solution en un clic, permettant aux utilisateurs de MacBook ou MacMini de télécharger et d’exécuter facilement de grands modèles de langage sans configuration complexe, et fournit des interfaces de chat web et API. Yupp.ai propose une plateforme de comparaison d’AI gratuite, intégrant plus de 800 modèles AI, pour aider les utilisateurs à comprendre et comparer en profondeur les performances des différentes AI, et prend en charge la création de vidéos AI et la génération de PFP. (Source : karminski3, yupp_ai, yupp_ai)

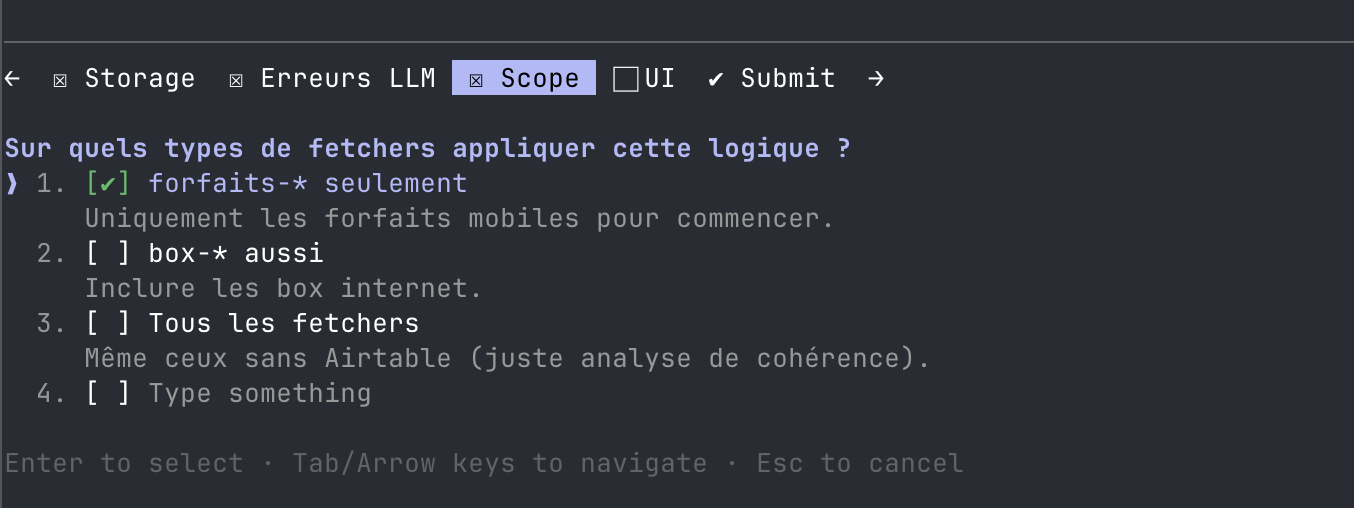

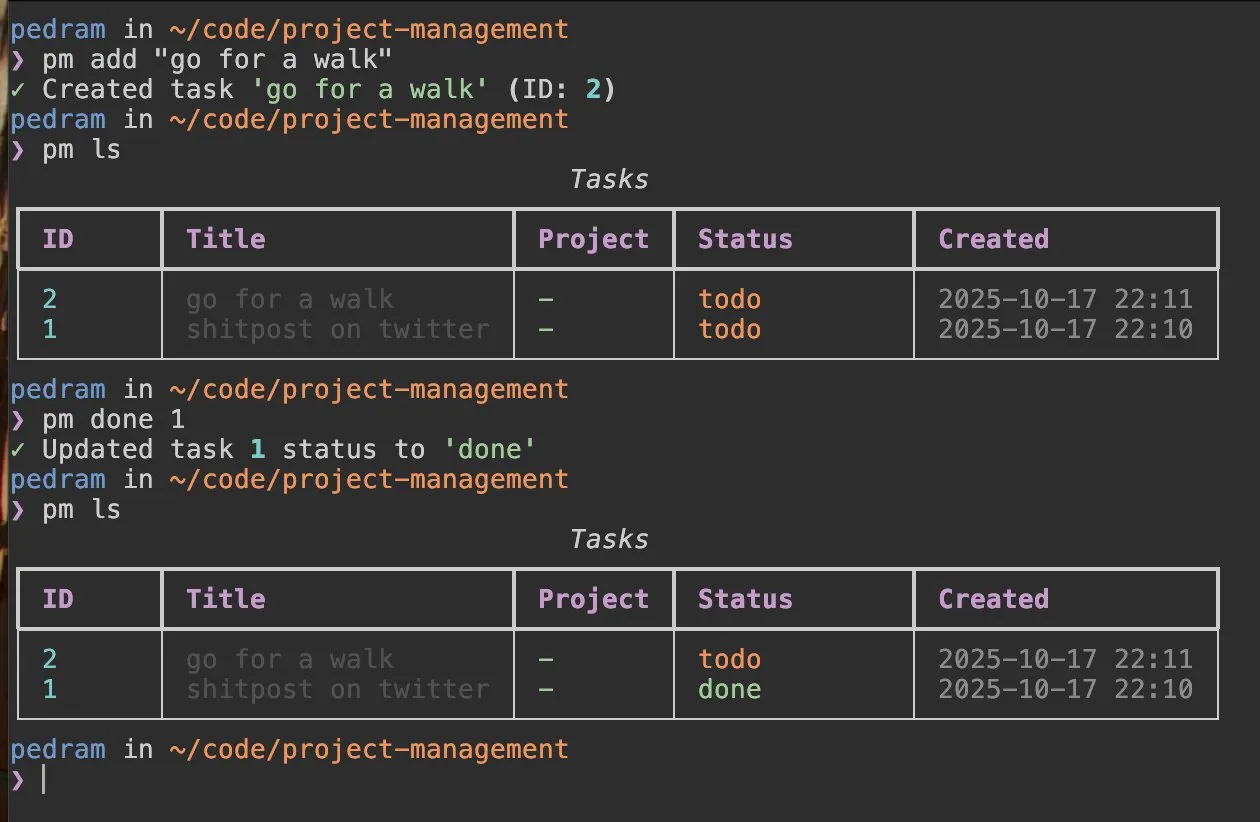

Scorecard améliore la sécurité des AI Agent, de nouveaux outils de gestion de projet basés sur l’AI émergent : La société Scorecard applique la logique de sécurité des véhicules autonomes au domaine des AI Agent, en utilisant des tests en sandbox et des évaluations pour prévenir les “hallucinations” et les comportements dangereux des AI d’entreprise, garantissant ainsi la fiabilité, en particulier dans les secteurs réglementés. Parallèlement, des outils CLI de gestion de projet basés sur l’AI sont en cours de développement, promettant de simplifier le suivi et la gestion de projet grâce au “vibe coding”. (Source : dariusemrani, TheEthanDing)

📚 Apprentissage

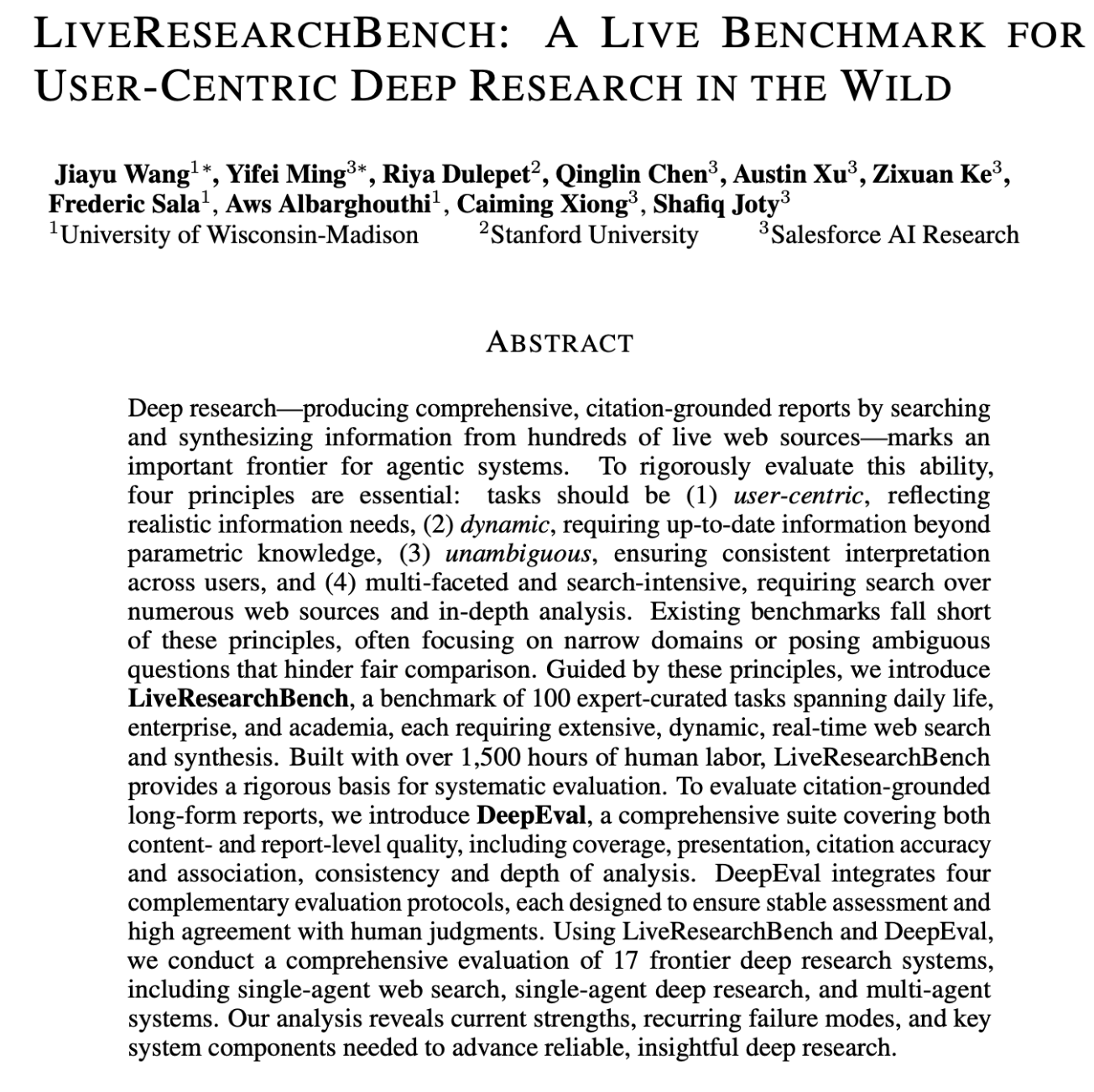

Ressources d’éducation et d’apprentissage en AI : équilibre entre théorie fondamentale et recherche de pointe : Le domaine de l’éducation en AI souligne que des bases solides en probabilités, algèbre linéaire et machine learning classique sont cruciales pour comprendre l’AI moderne. Les ressources d’apprentissage couvrent des guides d’introduction aux AI Agent, des rapports hebdomadaires DSPy, le fonctionnement des Transformer, des tutoriels d’apprentissage robotique, etc. En matière de recherche, des articles de pointe ont été publiés sur la généralisation OOD des Transformer, les lois d’échelle sensibles au contexte, la validation discriminante, GroundedPRM, ainsi que les benchmarks FML-bench et LiveResearchBench pour évaluer les Agent de recherche ML. L’expérience de la documentation LangChain a été améliorée, et des pratiques d’hébergement du Claude Agent SDK ont été partagées. (Source : dilipkay, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, jeremyphoward, ClementDelangue, bookwormengr, lateinteraction, charles_irl, SchmidhuberAI, TheTuringPost, Reddit r/deeplearning, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, sbmaruf, sbmaruf, gneubig)

![18 months ago, @karpathy set a challenge: "Can you take my 2h13m tokenizer video and translate [into] a book chapter".](https://rebabel.net/wp-content/uploads/2025/10/image_1760789355.webp)

Les dernières avancées en matière de benchmarks pour les AI Agent et la recherche ML : FML-bench, un benchmark pour évaluer les Agent de recherche en machine learning automatique, souligne l’importance de l’étendue de l’exploration pour les résultats de recherche. LiveResearchBench est un benchmark de recherche approfondie centré sur l’utilisateur, comprenant 100 tâches expertes, conçu pour évaluer rigoureusement la capacité des Agent à rechercher et synthétiser des informations à partir de centaines de sources web en temps réel. Le benchmark Hard2Verify se concentre sur la mesure de la capacité des validateurs à fournir des étiquettes de correction étape par étape pour des problèmes mathématiques ouverts et de pointe. (Source : HuggingFace Daily Papers, HuggingFace Daily Papers, sbmaruf, sbmaruf)

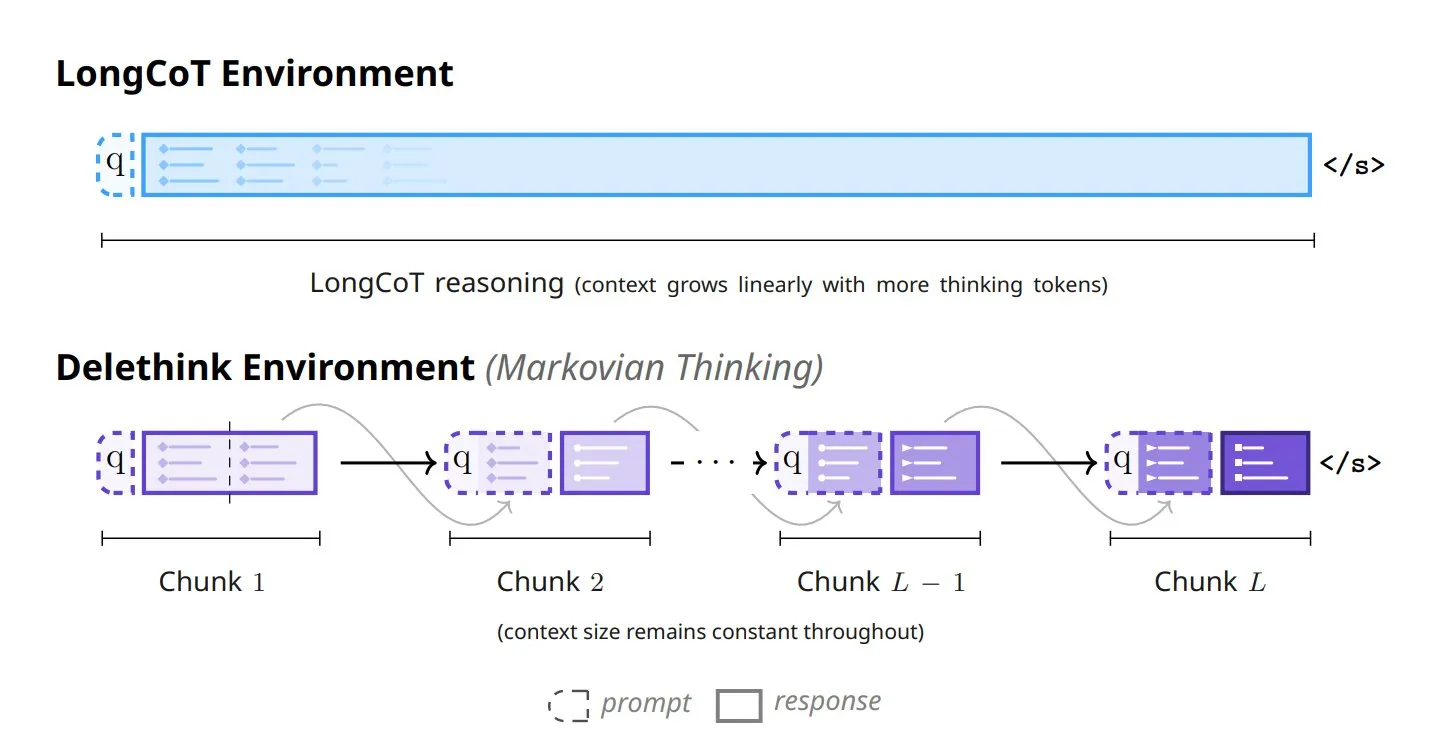

Six nouvelles approches pour transformer la pensée des modèles : Une nouvelle étude propose six nouvelles méthodes révolutionnaires pour la pensée des modèles, notamment Tiny Recursive Models (TRM), LaDIR (Latent Diffusion for Iterative Reasoning), ETD (encode-think-decode), Thinking on the fly, The Markovian Thinker et ToTAL (Thought Template Augmented LCLMs). Ces méthodes visent à améliorer les capacités de raisonnement, l’efficacité et la capacité de traitement des tâches complexes des modèles, propulsant les modèles AI vers des fonctions cognitives plus avancées. (Source : TheTuringPost)

💼 Affaires

L’AI accélère sa pénétration dans le monde des affaires, les CFO deviennent les nouveaux champions de l’adoption de l’AI : L’application de l’AI en entreprise s’accélère, les CFO devenant des acteurs clés de l’adoption de l’AI. L’application des AI Agent au niveau de l’entreprise dépasse les attentes et joue un rôle stratégique dans la gestion de la croissance des revenus. La capitalisation boursière de NVIDIA a dépassé les 4 billions de dollars, reflétant la forte croissance du marché du matériel AI. Le fondateur de HeyGen a partagé sa méthodologie de gestion d’équipe et de produit AI, soulignant la vitesse et l’adaptation aux itérations de modèles. (Source : Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, SchmidhuberAI, dotey)

Les services cloud AI d’Oracle affichent des marges brutes considérables, l’accélérateur AI de Microsoft suscite l’intérêt : Oracle a annoncé que ses services cloud AI peuvent atteindre une marge brute de 35 % et a signé de nouveaux contrats d’approvisionnement en infrastructure cloud d’une valeur de 65 milliards de dollars, démontrant sa forte dynamique sur le marché du cloud AI. Le programme d’accélérateur AI de Microsoft suscite également un grand intérêt, et bien que la faisabilité de sa puce Maia sur le processus 18A ait évolué, l’entreprise reste engagée dans le développement de matériel AI. (Source : 9点1氪, dylan522p)

Financement actif des startups AI, perspectives de commercialisation de l’écosystème ouvert et du MCP : General Intuition a levé 134 millions de dollars en financement de démarrage, visant à entraîner des Agent capables de comprendre des environnements 3D. HuggingFace a nommé un nouveau responsable des applications pour stimuler l’écosystème des modèles open source. Les perspectives de commercialisation du protocole MCP sont explorées, et Stripe discute avec les développeurs de la manière de facturer l’utilisation du MCP. LangChain organisera sa Launch Week, présentant les progrès de ses produits Agent. (Source : Reddit r/artificial, francoisfleuret, huggingface, fabianstelzer, LangChainAI, johannes_hage)

🌟 Communauté

Le développement des AI Agent suscite un vif débat : du fantasme à la réalité, avec utilité et limites : Les attentes de la communauté concernant les AI Agent passent du “fantasme omnipotent” à la “construction de systèmes”, soulignant leur rôle de catalyseur des processus métier. (Source : Ronald_vanLoon)