キーワード:OpenAI Sora 2, AI動画生成, マルチモーダルAI, AI科学者, タンパク質設計, Sora 2 API, PXDesignタンパク質設計, PromptCoT 2.0フレームワーク, EgoTwin一人称視点生成, Liquid AI LFM2-オーディオ

🔥 聚焦

OpenAI Sora 2発表とその影響 : OpenAIはSora 2を正式に発表し、これを「AI版抖音」iOSソーシャルアプリと位置づけました。音声とビデオの同時生成をサポートし、物理法則の遵守と制御可能性が大幅に向上しています。新機能には、ユーザー自身や友人の画像をAI生成ビデオに埋め込むことができる「cameos」が含まれます。ソーシャルメディアではその驚くべきリアルさと創造性が話題になっていますが、「slop」コンテンツの氾濫、真偽の区別がつきにくい問題、GPU需要の急増、地域的な利用可能性(英国ではSoraが利用できないなど)に対する懸念も表明されています。OpenAIのCEO Sam Altmanは、Sora 2がAGI研究への資金提供と、興味深い新製品の提供を目的としていると回答しました。コミュニティの議論では、Sora 2の招待コードの入手方法、ハードウェア(GPU)需要に関する推測、将来のビデオ生成コンテンツの品質と悪用に対する懸念も取り上げられています。OpenAIはSoraの招待を拡大する予定ですが、それに伴い1日の生成制限を下げ、Sora 2 APIをリリースすることも明らかにしました。

(出典:量子位, Yuchenj_UW, teortaxesTex, gfodor, TheTuringPost, nptacek, rasbt, scottastevenson, mckbrando, gfodor, yoheinakajima, skirano, inerati, colin_fraser, fabianstelzer, billpeeb, gfodor, genmon, dejavucoder, nptacek, nptacek, JureZbontar, Teknium1, fabianstelzer, scaling01, qtnx_, genmon, NerdyRodent, BlackHC, op7418, op7418, Teknium1, dejavucoder, scaling01, dejavucoder, teortaxesTex, sama, sama, inerati, inerati, scaling01, VictorTaelin, bookwormengr, MParakhin, Teknium1, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/artificial, , Reddit r/ArtificialInteligence, Reddit r/ChatGPT)

Periodic LabsがAI科学者プラットフォームを立ち上げ、科学発見を加速 : Periodic Labsは3億ドルの資金調達を完了し、AI科学者を創出し、自動化されたラボとAI駆動の実験を通じて基礎科学発見、特に材料設計分野を加速することを目指しています。このプラットフォームは、物理宇宙を計算システムと見なし、AIを利用して仮説、実験、学習を行い、高温超伝導体などの分野でブレークスルーを達成することが期待されています。このビジョンは、AIと物理世界のつながり、そして実験を通じて高品質なデータを生成することの重要性を強調しており、インターネットデータのみに依存する従来の訓練モデルを超越しています。

(出典:dylan522p, teortaxesTex, teortaxesTex, NandoDF, NandoDF, TheRundownAI, Ar_Douillard, teortaxesTex)

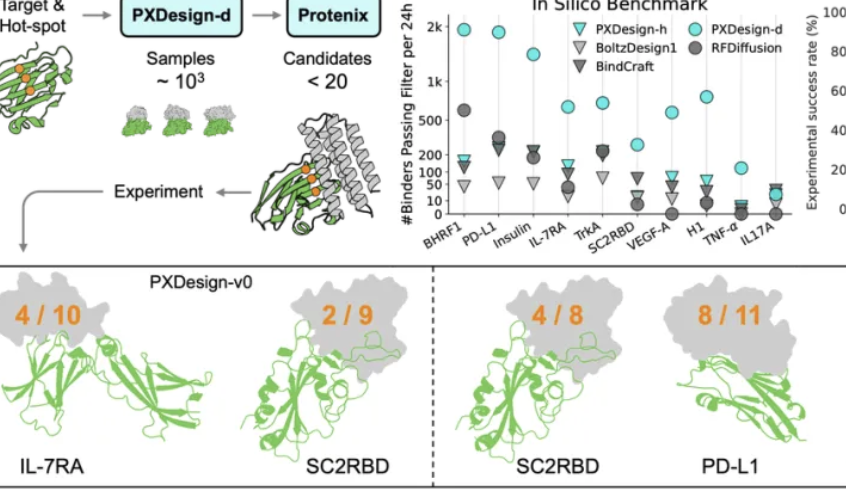

バイトダンスSeedチームがPXDesignを発表、タンパク質設計効率を向上 : バイトダンスSeedチームは、スケーラブルなAI蛋白設計方法であるPXDesignを発表しました。これは24時間以内に数百の高品質な候補タンパク質を生成でき、業界主流の方法と比較して約10倍の効率を実現します。この方法は複数のターゲットにおいて20%〜73%のウェットラボ成功率を達成し、DeepMindのAlphaProteoを大幅に上回ります。PXDesignは「生成+フィルタリング」戦略を組み合わせ、DiTネットワーク構造とProtenix構造予測モデルを利用して効率的なスクリーニングを行い、公開無料のbinderオンライン設計サービスを提供することで、生物科学研究の加速を目指しています。

(出典:量子位)

アントグループと香港大学がPromptCoT 2.0を共同発表、タスク合成に注力 : アントグループ通用人工智能中心自然语言组と香港大学自然语言组は、タスク合成を通じて大モデル推論とエージェント開発を推進することを目的としたPromptCoT 2.0フレームワークを共同発表しました。このフレームワークは、人工的な設計を期待値最大化(EM)ループに置き換え、推論チェーンを反復的に最適化することで、より難しく多様な問題を生成します。PromptCoT 2.0は強化学習とSFTを組み合わせることで、30B-A3Bモデルが数学コード推論タスクでSOTAを達成し、4.77Mの合成問題データをオープンソースとして提供し、コミュニティに訓練リソースを提供します。

(出典:量子位)

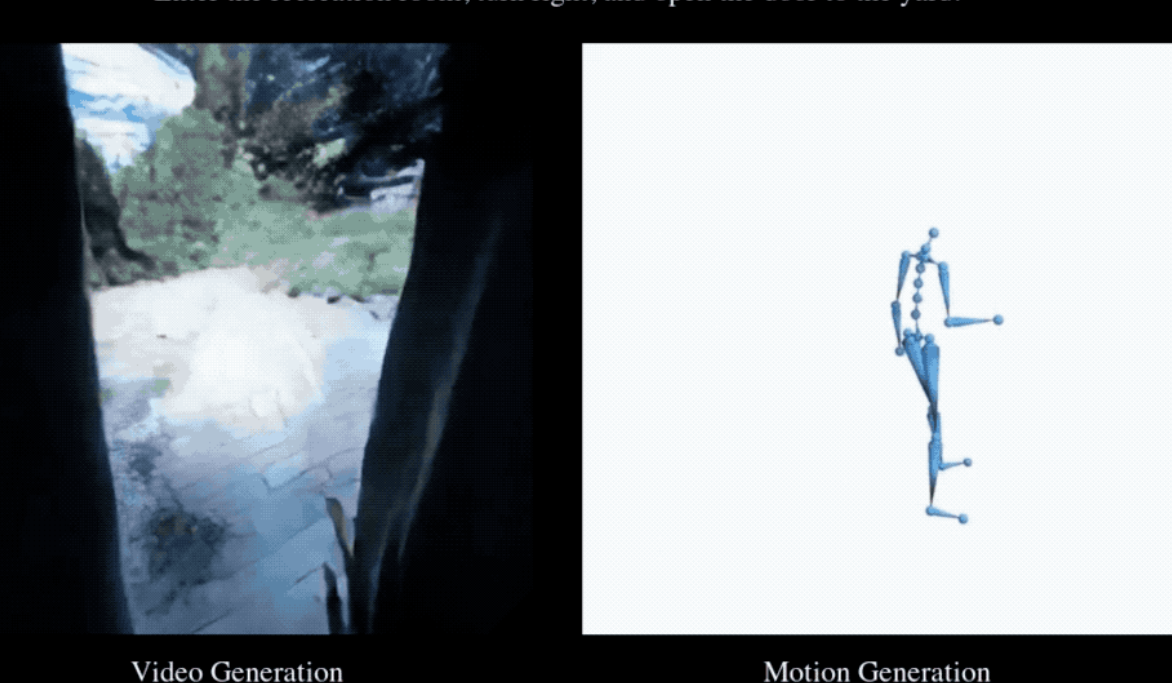

EgoTwinが第一視点ビデオと人体動作の同時生成を初実現 : シンガポール国立大学、南洋理工大学、香港科技大学、上海AI実験室は、EgoTwinフレームワークを共同発表し、第一視点ビデオと人体動作の同時生成を初めて実現しました。このフレームワークは拡散モデルに基づいており、「テキスト-ビデオ-動作」の三モーダル共同生成を通じて、視点-動作アライメントと因果結合という二つの大きな課題を克服しました。核心的なイノベーションには、ヘッド中心動作表現、サイバネティクス着想インタラクションメカニズム、非同期拡散訓練フレームワークが含まれ、生成されたビデオと動作はさらに3Dシーンに向上させることができます。

(出典:量子位)

🎯 動向

次世代AIモデルの集中的な発表と更新 : 最近のAI分野では、DeepSeek-V3.2、Claude Sonnet 4.5、GLM 4.6、Sora 2、Dreamer 4、そしてChatGPTの即時決済機能を含む、複数の重要なモデルと機能が発表・更新されました。DeepSeek-V3.2は、疎なアテンションメカニズムを通じてvLLM上で最適化され、より高い長コンテキスト性能とコスト効率を実現しました。Claude Sonnet 4.5は、アライメントとユーザー心智理論において複雑性を示し、クリエイティブライティングと長編ライティングで優れた性能を発揮しましたが、一部のユーザーからはコード生成の品質がまだ改善の余地があるとの指摘もあります。GLM-4.6はフロントエンドコード能力で際立った性能を示しましたが、Pythonなどの他の言語では改善が限定的であり、ローカルデプロイをサポートするGGUF量子化バージョンもリリースされました。Dreamer 4は、スケーラブルな世界モデル内で複雑な制御タスクを解決することを学習できるエージェントです。

(出典:Yuchenj_UW, teortaxesTex, zhuohan123, vllm_project, teortaxesTex, teortaxesTex, teortaxesTex, ImazAngel, teortaxesTex, _lewtun, nrehiew_, YiTayML, agihippo, TimDarcet, Dorialexander, karminski3, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/artificial)

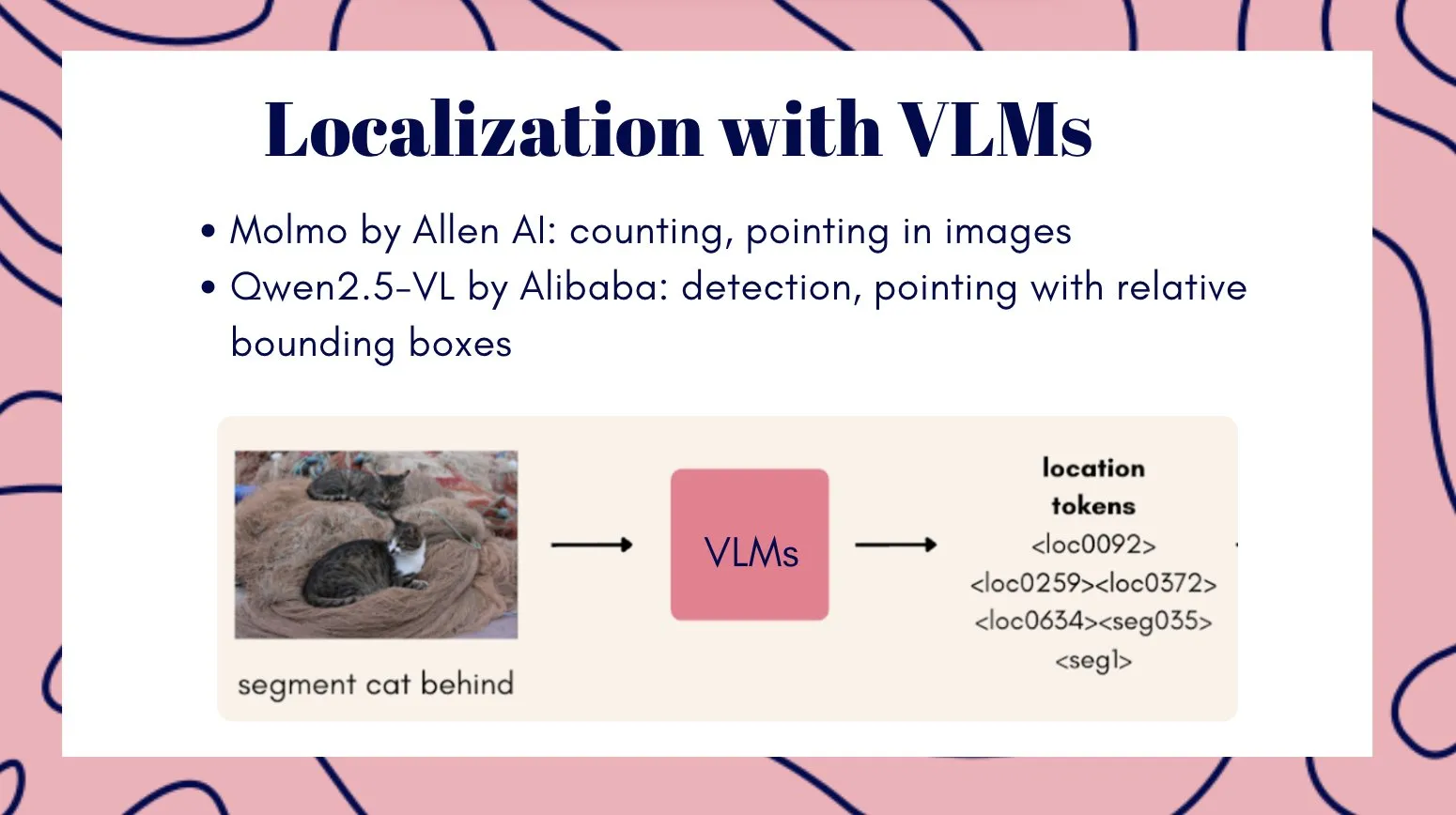

マルチモーダルビデオモデルVeo3が汎用視覚知能の可能性を示す : Veo3ビデオモデルは、汎用視覚知能への潜在的な道筋と見なされており、ゼロショット学習と推論能力を示し、様々な視覚タスクを解決できることから、ロボット技術の進歩に重要な意味を持つと考えられています。同時に、阿里云QwenチームはQwen3-VLシリーズのマルチモーダル大言語モデルを発表し、視覚エージェント、視覚エンコーディング、空間認識、長コンテキストとビデオ理解、マルチモーダル推論、視覚認識、OCRの面で全面的にアップグレードされ、InstructとThinkingバージョンが提供されています。テンセントもHunyuanImage 3.0とHunyuan3D-Partモデルを発表し、それぞれテキスト生成画像と3D形状生成の分野で最先端のレベルに達しています。

(出典:gallabytes, NandoDF, NandoDF, madiator, shaneguML, Yuchenj_UW, GitHub Trending, ClementDelangue)

Liquid AIがLFM2-Audioおよび専門化された小規模モデルを発表 : Liquid AIはLFM2-Audioを発表しました。これは、1.5Bパラメータのみでデバイス上で応答性の高いリアルタイム会話を実現できるエンドツーエンドのオーディオ-テキスト全能基礎モデルであり、同種のモデルよりも推論速度が10倍高速です。さらに、Liquid AIはLFM2シリーズのファインチューニングモデルも発表しました。これにはTool、RAG、Extractなどの異なるバリアントが含まれ、汎用性を追求するのではなく、特定のタスクに焦点を当てています。これは、Nvidiaが小型の専門化されたモデルがAgentic AIの将来の方向性であるとするホワイトペーパーの見解と一致しています。

(出典:ImazAngel, maximelabonne, Reddit r/LocalLLaMA)

ベクトルデータベースが「第二の春」を迎え、xAIは高品質データを重視 : ベクトルデータベースが新たな発展のピークを迎える可能性があるという見方がありますが、その応用モデルは予想とは異なるかもしれません。同時に、xAIは人間データを処理するための新しいパラダイムを構築しており、後訓練(post-training)の重要性を強調し、高品質データがAGIへの礎であると考えています。xAIは、各分野の専門家からなるコミュニティを組織し、最高品質の評価システムを共同で構築する計画です。

(出典:_philschmid, Dorialexander, Yuhu_ai_)

🧰 ツール

AI小説生成器YILING0013/AI_NovelGenerator : 大言語モデルに基づいた多機能小説生成器で、世界観アーキテクチャ、キャラクター設定、プロットブループリント、スマート章生成、状態追跡、伏線管理、セマンティック検索、知識ベース統合、自動校正メカニズムをサポートし、GUI操作を提供します。このツールは、論理的で一貫性のある長編ストーリーを効率的に作成することを目的としており、OpenAI、DeepSeek、Ollamaなどの様々なLLMとEmbeddingサービスをサポートしています。

(出典:GitHub Trending)

AI補助プログラミングツールの継続的な発展 : GitHub Copilotは、コミュニティ貢献による指令、プロンプト、チャットモードを通じて、ユーザーが様々な分野、言語、ユースケースでその効果を最大化するのを助け、MCPサーバーを提供して統合を簡素化します。Replit Agentは、コード移行とQAにおいて強力な能力を示し、大規模なNext.jsウェブサイトをVercelから迅速に移行させ、アプリ内決済統合もサポートします。ServiceNowのApriel-1.5-15b-Thinkerモデルは、単一GPUで動作し、強力な推論能力を提供します。さらに、Moondream3-previewモデルは代理UIプロセスとRPAタスクに使用され、vLLMもencoder-onlyモデルのデプロイをサポートしています。

(出典:github/awesome-copilot, amasad, amasad, amasad, amasad, amasad, ImazAngel, ben_burtenshaw, amasad, amasad, amasad, amasad, TheZachMueller, Reddit r/LocalLLaMA)

AIの特定アプリケーション分野におけるツール革新 : pix2tex (LaTeX OCR)は、数学式画像をLaTeXコードに変換でき、科研および教育分野の効率を大幅に向上させます。BatonVoiceはLLMの指令追従能力を利用して、音声合成に構造化パラメータを提供し、制御可能なTTSを実現します。Hexプラットフォームは代理機能を統合し、より多くの人々がAIを使用して正確で信頼性の高いデータ作業を行えるようにします。Kling 2.5 TurboやLucid Originなどのビデオ生成ツールは、ビデオ制作をかつてないほど便利にしています。Racine CU-1はGUIインタラクションモデルであり、クリック位置認識が可能で、代理式UIプロセスやRPAタスクに適しています。

(出典:lukas-blecher/LaTeX-OCR, teortaxesTex, dotey, dotey, Ronald_vanLoon, AssemblyAI, TheRundownAI, Kling_ai, Kling_ai, sarahcat21, mervenoyann, pierceboggan, Reddit r/OpenWebUI, Reddit r/LocalLLaMA, Reddit r/OpenWebUI, Reddit r/OpenWebUI, Reddit r/ArtificialInteligence, Reddit r/OpenWebUI, Reddit r/OpenWebUI)

jina-reranker-v3ドキュメント再ランク付けモデル : jina-reranker-v3は、0.6Bパラメータの多言語ドキュメント再ランク付けモデルで、新しい「後ではなく遅いインタラクション(last but not late interaction)メカニズム」を導入しています。この方法は、クエリとドキュメントの間で因果自己注意計算を行い、各ドキュメントのコンテキスト埋め込みを抽出する前に、豊富なクロスドキュメントインタラクションを実現します。このコンパクトなアーキテクチャはBEIR性能でSOTAを達成し、同時に生成リスト再ランク付けモデルよりも10倍小型です。

(出典:HuggingFace Daily Papers)

📚 学習

AIモデル推論とアライメントの最新研究進展 : 研究により、マルチモーダル推論が論理推論を強化する一方で、知覚基盤を損ない、視覚的忘却を引き起こす可能性があることが明らかになりました。Vision-Anchored Policy Optimization (VAPO) 方法は、推論プロセスを視覚基盤により集中させるために提案されています。オンラインアライメント(GRPOなど)がオフラインアライメント(DPOなど)よりも優れている理由が探求され、人間の知覚バイアスをシミュレートすることで、オフラインデータ訓練でもオンラインアライメントの性能を達成できるHumanlineバリアントが提案されました。Test-Time Policy Adaptation for Multi-Turn Interactions (T2PAM) パラダイムとOptimum-Referenced One-Step Adaptation (ROSA) アルゴリズムは、ユーザーフィードバックを利用してモデルパラメータをリアルタイム効率的調整し、LLMの多輪会話における自己修正能力を向上させます。NuRL(Nudging method)は、自己生成プロンプトを通じて問題難易度を下げ、モデルが元々「不可解」な難題から学習できるようにすることで、LLM推論能力の上限を高めます。RLP(Reinforcement Learning Pre-training)は、強化学習を事前学習段階に導入し、思考連鎖をアクションと見なし、情報利得を通じて報酬を与えることで、事前学習段階からモデルの推論能力を向上させます。Exploratory Iteration (ExIt)は、RLベースの自動カリキュラム方法であり、LLMが推論時に反復的自己改善を通じて解決策を改善するように導くことで、単一輪および多輪タスクにおけるモデルの性能を効果的に向上させました。TruthRL研究は、強化学習を通じてLLMが真実情報を生成するように促し、モデル幻覚問題の解決を目指しています。研究により、LLMの「最大有効コンテキストウィンドウ(MECW)」が報告されている「最大コンテキストウィンドウ(MCW)」よりもはるかに小さく、MECWが問題タイプによって変化することが明らかになり、LLMが長コンテキストを処理する際の実際の限界が示されました。Bias-Inversion Rewriting Attack (BIRA) 攻撃は、LLMウォーターマークを効果的に回避できると理論付けられています。ウォーターマークによってマークされる可能性のあるトークンのlogitsを抑制することで、セマンティックコンテンツを維持しつつ99%以上の回避率を達成し、ウォーターマーク技術の脆弱性を浮き彫りにしました。

(出典:HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, NandoDF, NandoDF, BlackHC, BlackHC, teortaxesTex, HuggingFace Daily Papers, HuggingFace Daily Papers)

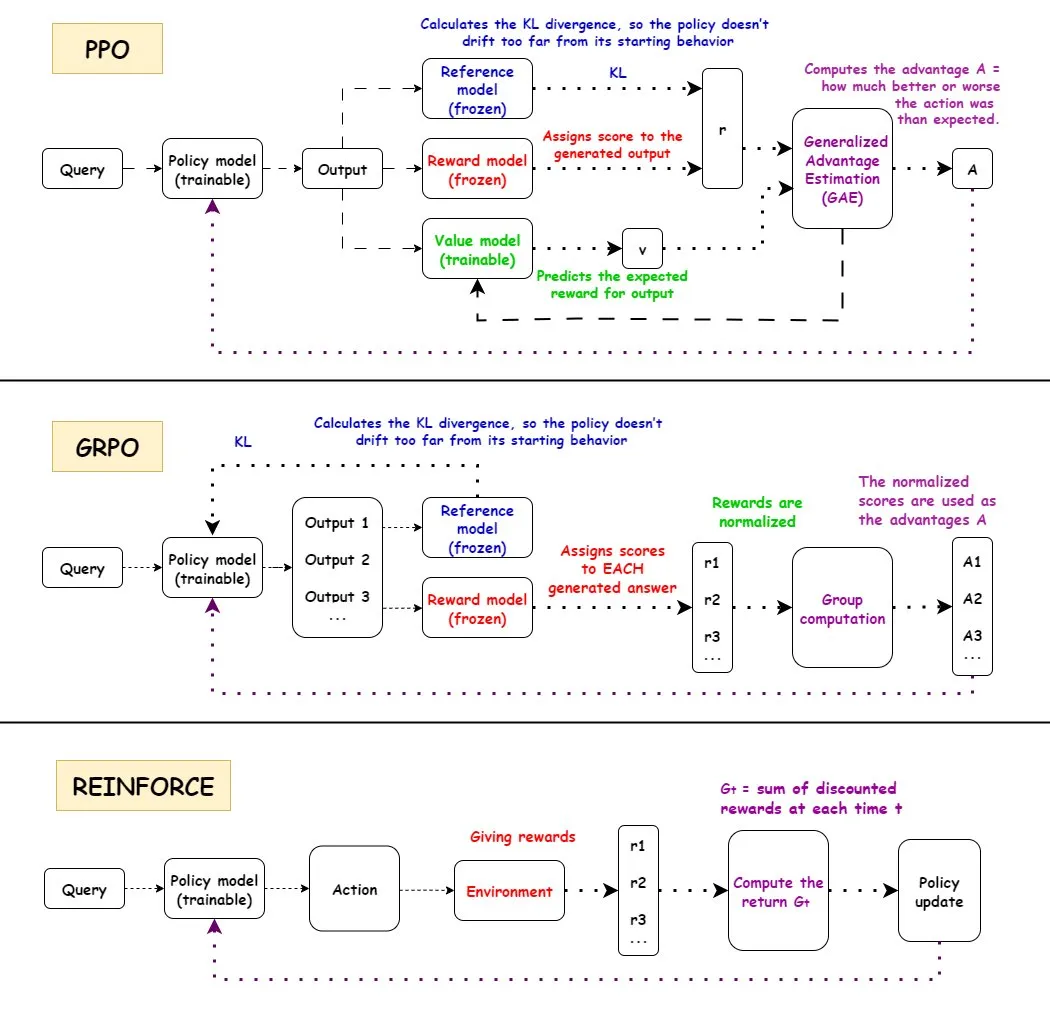

強化学習(RL)アルゴリズムの詳細分析 : PPO、GRPO、REINFORCEという3つの主要な強化学習アルゴリズムのワークフロー、長所と短所、および応用シナリオが詳細に解説されています。PPOはその安定性から、GRPOはその相対報酬メカニズムから、REINFORCEは基礎アルゴリズムとして、AI分野で広く応用されています。研究は、強化学習がモデルを訓練してアトミックスキルを組み合わせ、組み合わせ深度において汎化を達成できることを示しており、RLが新しいスキルを学習する可能性を指摘しています。RLパイプラインにおける性能向上の半分以上が、ML関連改善ではなく、マルチスレッドなどのエンジニアリング最適化によって達成されていることが発見されました。RL訓練における各エピソードの情報量の問題、および同じ最終報酬の下での異なる軌跡の情報等同性について議論されています。コミュニティでは、RL事前学習の定義と有効性について議論が展開され、強制的な多様性合成が引き起こす可能性のある問題が指摘され、一貫性劣化への注意が呼びかけられています。双腕五指人型ロボット向けに、残差オフポリシー強化学習(ROSA)を通じて行動クローン戦略をファインチューニングすることで、サンプル効率が大幅に向上し、ハードウェア上で直接戦略ファインチューニングが実現されました。

(出典:TheTuringPost, teortaxesTex, menhguin, finbarrtimbers, arohan, tokenbender, pabbeel)

AI科学者と科学発見 : DeepScientistは、目標指向で完全自律の科学発見システムであり、ベイズ最適化と階層的評価プロセスを通じて、数ヶ月にわたるタイムラインで最先端科学発見を推進します。このシステムは、3つの最先端AIタスクにおいて人間のSOTA方法を上回り、すべての実験ログとシステムコードをオープンソースとして公開しています。OpenAIは、次世代科学機器、すなわちAI駆動プラットフォームを構築し、科学発見を加速することを目指して研究科学者を募集しています。

(出典:HuggingFace Daily Papers, mcleavey)

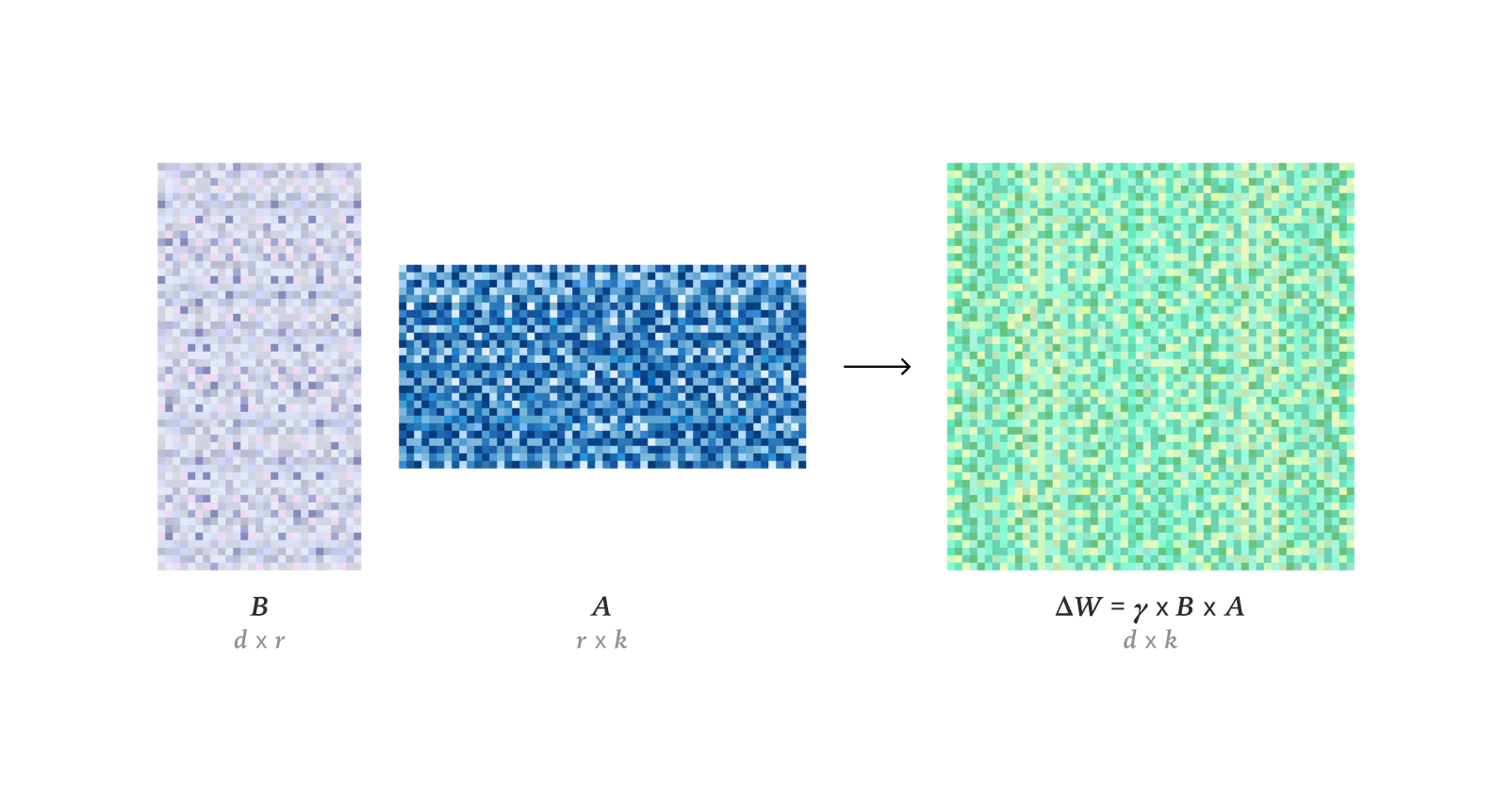

LLMファインチューニングと最適化技術 : 研究により、LoRAが強化学習においてフルファインチューニング(FullFT)の学習性能と完全に一致し、低ランクの場合でもRL訓練における情報を十分に吸収できることが明らかになりました。Quadrant-based Tuning (Q-Tuning) フレームワークは、共同サンプルとトークン剪定を通じて、教師ありファインチューニング(SFT)においてデータ効率を大幅に向上させ、場合によっては全データ訓練を上回ることもあります。MuonオプティマイザはLLM訓練においてAdamを継続的に上回り、特にテール関連記憶学習において、より等方性特異値スペクトルと重いテールデータの効率的な最適化を通じて、Adamのカテゴリ不均衡データにおける学習差異を解決しました。AdamWオプティマイザにおける重みRMSの漸近推定に関する研究が行われました。Flash Attention 4のCUDAカーネルの動作原理が深く分析され、非同期パイプライン、ソフトウェアsoftmax(立方近似)、効率的リスケーリングなどのイノベーションが明らかにされ、cuDNNよりも高速な性能の理由が説明されました。

(出典:ImazAngel, karinanguyen_, NandoDF, HuggingFace Daily Papers, HuggingFace Daily Papers, teortaxesTex, bigeagle_xd, cloneofsimo, Tim_Dettmers, Reddit r/MachineLearning)

AI学習リソースと研究ツール : トレンド、オープンソースモデル、カスタマイズ/デプロイツール、およびさらなるリソースを網羅するマルチモーダルAIスライドが共有されました。AI Engineer Europe 2026とAI Engineer Parisなどの会議が発表され、AIエンジニアに交流プラットフォームを提供します。Karpathyの「Let's build GPT」シリーズとQwen論文が推奨され、高品質CTF訓練データと計算資源がLLM訓練にとって重要であることが強調されました。DSPyOSSオプティマイザがB2B AIユースケースにおいてデータ希少性に対処するための「階層的」最適化を実現する可能性について議論されました。Axiom Math AIは、AI数学者を起点として、形式化された数学の分野で進歩を遂げる自己改善型超知能推論器の構築を目指しています。回帰言語モデルのコード生成と理解における応用が研究されています。強化学習がAGIを実現するのに十分であるかどうかの議論が探求されています。ディープ残差学習(Deep Residual Learning)の発明者とその進化のタイムラインが探求されています。Jürgen Schmidhuberは2016年に人工意識、世界モデル、予測エンコーディング、およびデータ圧縮としての科学について説明し、AI分野における初期の貢献を強調しました。14のオープンソース大規模言語モデルプロジェクトのオープンなコラボレーション実践、動機、ガバナンスに関する探索的分析が行われ、オープンソースLLMエコシステムの多様性と課題が明らかにされました。Dragon Hatchling (BDH)は、Transformerと脳モデルを接続し、説明可能性とTransformer性能を実現することを目的とした脳型ネットワークベースのLLMアーキテクチャです。d^2Cacheフレームワークは、二重適応キャッシュを通じて、拡散言語モデル(dLLMs)の推論効率と生成品質を大幅に向上させます。TimeTicフレームワークは、コンテキスト学習を通じて時系列基礎モデル(TSFMs)の転移可能性を推定し、ダウンストリームファインチューニングに最適なモデルを効率的に選択します。視覚基礎エンコーダは、潜在拡散モデル(LDM)のtokenizerとして機能し、意味的に豊かな潜在空間を生成することで、画像生成性能を向上させます。NVFP4は、二段階スケーリング、RHT、ランダム丸めを通じて、FP8ベースライン性能に匹敵する性能を維持しつつ、6.8倍の効率性向上を期待できる新しい4ビット事前学習フォーマットです。DA^2 (Depth Anything in Any Direction)は、大規模訓練データとSphereViTアーキテクチャを通じて、全景深度推定でSOTAを達成する、正確でゼロショット汎化可能でエンドツーエンドのパノラマ深度推定器です。SAGANetモデルは、視覚セグメンテーションマスク、ビデオ、テキストキューを利用することで、制御可能なオブジェクトレベルオーディオ生成を実現し、プロフェッショナルFoleyワークフローにきめ細かな制御を提供します。Mem-αは強化学習フレームワークであり、エージェントを訓練して複雑な外部記憶システムを効果的に管理することで、LLMエージェントの長文理解における記憶構築と情報損失の問題を解決し、超長シーケンスへの汎化能力を示します。EntroPE (Entropy-Guided Dynamic Patch Encoder) フレームワークは、条件付きエントロピーを通じて時系列における変換点を動的に検出し、パッチ境界を配置することで、時間構造を保持し、予測精度と効率性を向上させます。BUILD-BENCHは、実世界のオープンソースソフトウェアのコンパイルにおけるLLMエージェントの能力を評価するための、より挑戦的なベンチマークであり、OSS-BUILD-AGENTを強力なベースラインとして提案しています。ProfVLMは、生成推論を通じて、自己中心および外部視点ビデオからスキルレベルを共同で予測し、専門家フィードバックを生成する軽量ビデオ-言語モデルです。基礎モデルにおけるテスト時間訓練(TTT)の有効性が探求され、TTTがテストタスクにおける専門化を通じて、分布内テスト誤差を大幅に削減できると考えられています。CSTは、任意カーディナリティ画像セットを処理する新型ニューラルネットワークアーキテクチャであり、3D画像テンソル上で直接操作し、特徴抽出とコンテキストモデリングを同時に行い、セット分類や異常検出などのタスクで優れた性能を発揮します。TTT3Rフレームワークは、3D再構築をオンライン学習問題と見なし、記憶状態と観測アライメント信頼度から学習率を導出することで、長シーケンス汎化能力を大幅に向上させます。

(出典:tonywu_71, swyx, Reddit r/deeplearning, lateinteraction, teortaxesTex, shishirpatil_, bengoertzel, arankomatsuzaki, francoisfleuret, _akhaliq, steph_palazzolo, HuggingFace Daily Papers, SchmidhuberAI, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, NerdyRodent, QuixiAI, HuggingFace Daily Papers, _akhaliq, HuggingFace Daily Papers, _akhaliq, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, Reddit r/MachineLearning, Reddit r/MachineLearning, Reddit r/MachineLearning, Reddit r/MachineLearning)

AIビデオ生成における人間の知覚偽造検出 : DeeptraceRewardは、人間が知覚するビデオ生成偽造痕跡をアノテーションするための、初の細粒度で時空間感知のベンチマークデータセットです。このデータセットには、3.3Kの高品質な生成ビデオに対する4.3Kの詳細なアノテーションが含まれており、9つの主要な偽造痕跡カテゴリに統合されています。研究では、マルチモーダル言語モデルを報酬モデルとして訓練し、人間の判断と位置特定を模倣させ、偽造キューの識別、位置特定、説明においてGPT-5を上回る性能を示しました。

(出典:HuggingFace Daily Papers)

対抗的浄化と3Dシーン再構築 : MANI-Pureは、入力信号の振幅スペクトルを利用して浄化プロセスをガイドし、異種で周波数指向性のノイズを適応的に注入することで、高周波擾乱を効果的に抑制しつつ、意味的に重要な低周波コンテンツを保持する振幅適応浄化フレームワークであり、対抗的防御においてSOTA性能を達成しました。NvidiaはLyraモデルを発表し、ビデオ拡散モデルの自己蒸留を通じて生成的な3Dシーン再構築を実現し、単一の画像/ビデオからフィードフォワード3Dおよび4Dシーン生成を可能にします。

(出典:HuggingFace Daily Papers, _akhaliq)

💼 ビジネス

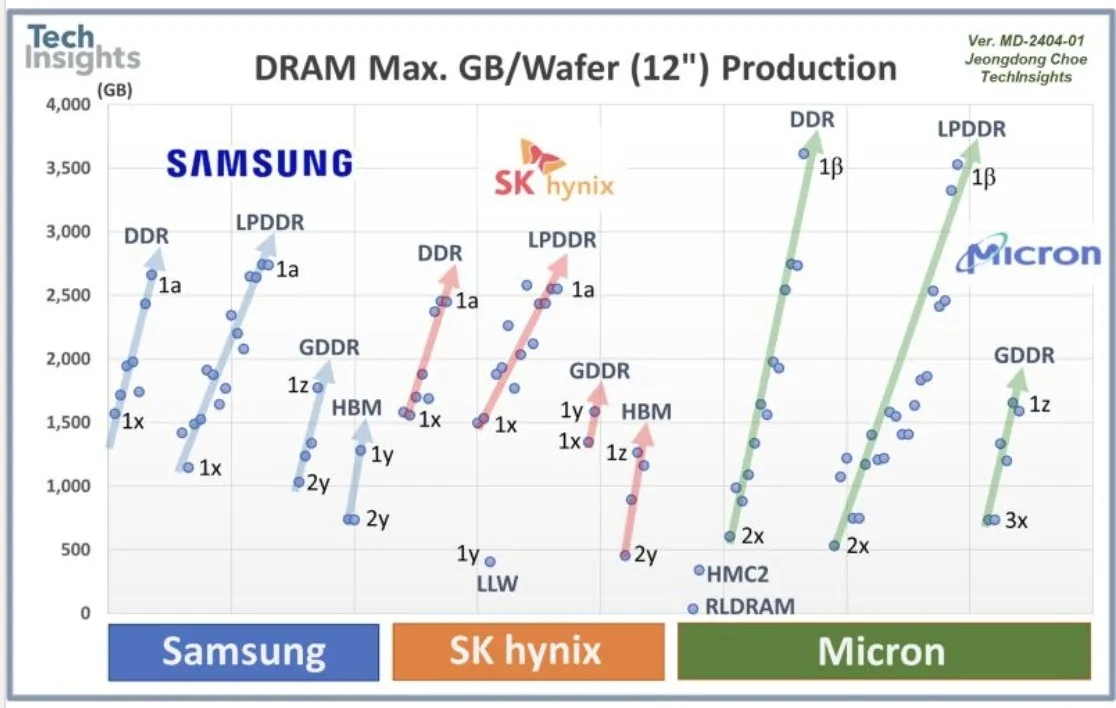

OpenAIとサムスンの協力およびDRAM需要 : OpenAIはサムスンと協力して「Stargateチップ」の開発を進めており、毎月90万枚の高性能DRAMウェハーが必要になると予測されています。これは、将来のAIインフラストラクチャに対するOpenAIの巨大な計画と投資を示しており、現在の業界予測をはるかに超えています。この膨大な需要は、AI計算コストとメモリスーパーサイクルに関する議論を引き起こしています。

(出典:bookwormengr, teortaxesTex, francoisfleuret)

AIスタートアップの資金調達と業界展開 : Axiom Math AIは、AI数学者を起点として自己改善型超知能推論器を立ち上げ、業界の注目を集めています。ModalはシリーズB資金調達で8700万ドルを完了し、評価額は11億ドルに達し、AI計算インフラストラクチャの将来の発展を推進することを目指しています。OffDealはシリーズA資金調達で1200万ドルを完了し、世界初のAIネイティブ投資銀行の構築に取り組んでいます。日本の防衛大臣がSakana AIオフィスを訪問し、AIが国防分野で協力する可能性を示しました。ある開発者は、オープンソースLLMモデルの構築に3000ドルを費やした後、資金枯渇に直面している状況を共有し、オープンソースAIプロジェクトの持続可能性に関するコミュニティの議論を引き起こしました。Google AI開発者はNano Banana Hackathonの受賞者を発表し、40万ドル以上の賞金を授与してAIアプリケーションイノベーションを奨励しました。

(出典:shishirpatil_, bengoertzel, lupantech, arankomatsuzaki, francoisfleuret, akshat_b, leveredvlad, SakanaAILabs, hardmaru, Reddit r/LocalLLaMA, osanseviero)

🌟 コミュニティ

Sora 2が引き起こす社会影響と論争 : Sora 2の発表は、広範な社会影響と論争を引き起こしました。多くのユーザーは、AI生成ビデオの「slop」(低品質で無意味なコンテンツ)の氾濫を懸念し、OpenAIの優先事項が癌などの重大な問題解決ではなくエンターテイメントであることに疑問を呈しています。同時に、Sora 2の超高リアル感がビデオの真偽の区別がつきにくい状況を引き起こし、悪意を持って虚偽情報や「生物兵器」のような有害なコンテンツの生成に利用される可能性も懸念されています。OpenAI CEO Sam Altman自身もAI生成ミームの主役となり、彼はこれに対し「それほど奇妙ではない」と述べ、OpenAIの重点は依然としてAGIと科学発見であり、製品発表は資金需要のためであると説明しました。Sora 2の強力な能力は、GPUの巨大な需要を再び浮き彫りにし、AIの高コストに関する議論を引き起こしました。AIのコストを米国州際高速道路システム建設コストと比較する声さえあります。一部のコメントでは、Sora 2の発表戦略が「普通すぎる」と批判され、ベンチマークテストや専門ユーザーサポートが不足しており、無料ユーザー生成コンテンツに制限が設けられていることも指摘されています。

(出典:teortaxesTex, gfodor, TheTuringPost, nptacek, rasbt, scottastevenson, mckbrando, gfodor, yoheinakajima, skirano, inerati, colin_fraser, fabianstelzer, billpeeb, gfodor, genmon, dejavucoder, nptacek, nptacek, JureZbontar, Teknium1, fabianstelzer, scaling01, qtnx_, genmon, NerdyRodent, BlackHC, op7418, op7418, Teknium1, dejavucoder, scaling01, dejavucoder, teortaxesTex, sama, sama, inerati, inerati, scaling01, VictorTaelin, bookwormengr, MParakhin, Teknium1, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/artificial, , Reddit r/ArtificialInteligence, Reddit r/ChatGPT)

Claude Sonnet 4.5のユーザー体験と論争 : ユーザーは一般的にSonnet 4.5が情報保持、判断力、意思決定、そしてクリエイティブライティングにおいて顕著な向上を示し、ユーザーの背景を知った後に専門的になったり、ユーザーが「でたらめを言う」ときに訂正したりするなど、人間のような「態度変化」さえ見せると評価しています。一部の側面で優れた性能を発揮するものの、コード生成品質が低く、「不注意で愚かなエラー」があるとの批判もあり、長会話を処理する際に「会話が長すぎる」ためにコードを生成できない問題も指摘されており、人間ソフトウェアエンジニアの代替にはまだ距離があると考えられています。さらに、一部のユーザーはSonnet 4.5を「ジェイルブレイク」することに成功し、危険なレシピやマルウェアコードを生成させ、モデル安全ガードレールに対する深刻な懸念を引き起こしました。

(出典:teortaxesTex, doodlestein, genmon, aiamblichus, QuixiAI, suchenzang, karminski3, aiamblichus, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

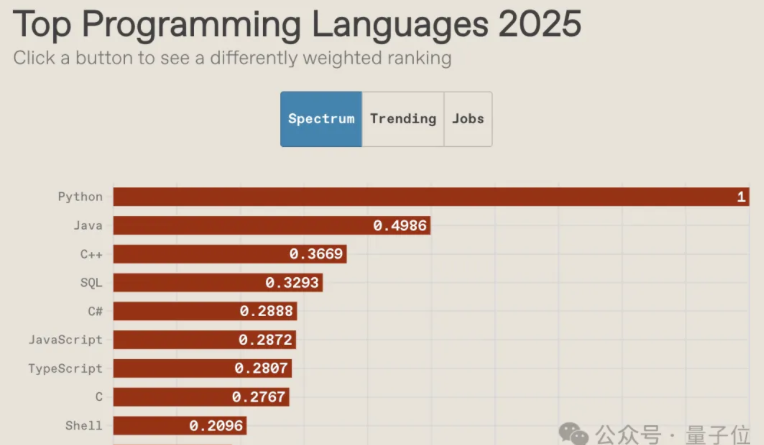

AI時代のプログラミング言語の未来とコミュニティ文化の衰退 : IEEE Spectrum 2025プログラミング言語ランキングによると、Pythonは10年連続で最も人気のある言語の座を維持し、総合ランキング、成長速度、雇用指向の3項目すべてで1位を獲得しており、その優位性はAI時代にさらに拡大しています。JavaScriptのランキングは大幅に下落し、SQLの地位は影響を受けつつも依然として価値を保っています。報告書は、AIがプログラミング言語の多様性を終わらせつつあり、主流言語のマタイ効果が加速し、非主流言語が周辺化されるだろうと指摘しています。同時に、プログラマーコミュニティ文化が衰退し、開発者はコミュニティで質問するよりも大規模モデルに助けを求める傾向が強まっており、これが学習と仕事のやり方を変え、将来のプログラマーの役割と基盤アーキテクチャ設計における核心能力の重要性に関する議論を引き起こしています。

(出典:量子位, jimmykoppel, jimmykoppel, lateinteraction, kylebrussell, Reddit r/ArtificialInteligence)

AIバブルと業界発展の見通し : ソーシャルメディアでは、AI業界にバブルが存在するかどうかの議論が展開されています。現在の投資熱は高く、一部に「愚かな」プロジェクトが存在する可能性はあるものの、業界のファンダメンタルズは依然として堅調であり、企業によるAIの採用は着実に増加しているという見方があります。同時に、AI計算の巨大なコストとOpenAIのDRAMに対する膨大な需要は、業界がまだ急速に拡大しており、バブルが崩壊する段階には程遠いことを示唆しているという声もありますが、資本の流入には警戒も必要です。

(出典:arohan, pmddomingos, teortaxesTex, teortaxesTex, ajeya_cotra)

💡 その他

人型ロボットとAI補助デバイス : 中国のロボット企業LimX Dynamicsは、人型ロボットOliの自律移動、屈曲、投擲能力を披露しました。モーションキャプチャや遠隔操作は不要で、中国が人型ロボット分野でFigure/1X/Teslaと同等のレベルに達していることを示しています。MetaのNeural BandはEMGを通じて神経信号を読み取り、Meta Raybanディスプレイ眼鏡と組み合わせることで、切断者に革命的な制御方式を提供し、義肢とデジタルインターフェースの同期制御を実現する可能性があり、汎用ハンズフリーコントローラーとなるかもしれません。さらに、AIとロボット技術は、移動性強化、探索、救助の分野でも多様な応用があり、例えば電動ロボット外骨格、無線制御ロボット昆虫、四足ロボット、救助任務用のロボットヘビなどがあります。

(出典:Ronald_vanLoon, teortaxesTex, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, ClementDelangue, Reddit r/ArtificialInteligence)

AIの画像編集とグラフィックデザインにおける応用 : LayerDは、ラスタグラフィックデザインをレイヤーに分解する手法であり、再編集可能なクリエイティブワークフローを実現することを目的としています。これは、非遮蔽前景レイヤーの反復的抽出と、レイヤーが通常統一された外観を示すという仮定を利用した洗練を通じて、高品質分解を実現します。GeoRemoverは、幾何学的認識に基づく二段階フレームワークを提案しており、画像内のオブジェクトとその因果視覚アーティファクト(影や反射など)を除去します。これは、幾何学的除去と外観レンダリングのデカップリング、および学習指導のための選好駆動目標の導入を通じて実現されます。

(出典:HuggingFace Daily Papers, HuggingFace Daily Papers)