Palavras-chave:IA quântica, GPT-5, Gemini 2.5, Imagine v0.9, Sora 2, Agente de IA inteligente, Computador quântico, Prêmio Nobel de IA quântica do Google, Aplicações de pesquisa científica do GPT-5, Uso computacional do Gemini 2.5, Geração de vídeo xAI Imagine, Versão prévia do OpenAI Sora 2

🔥 Foco

Cientistas da Google Quantum AI recebem o Prémio Nobel da Física : Michel Devoret, cientista-chefe da Google Quantum AI, e os membros da sua equipa John Martinis e John Clarke receberam o Prémio Nobel da Física de 2025 pelo seu trabalho pioneiro no campo da mecânica quântica. A sua investigação abriu caminho para computadores quânticos com correção de erros, demonstrando o investimento a longo prazo e a posição de liderança da Google na área da AI quântica, marcando um marco importante neste campo. (Fonte: Google, demishassabis, Yuchenj_UW)

GPT-5 demonstra potencial inovador na pesquisa científica : Kevin Weil afirmou que o GPT-5 ultrapassou um limiar significativo, e os cientistas conseguiram orientar o GPT-5 para realizar pesquisas inovadoras em áreas como matemática, física, biologia e ciência da computação. Embora ainda esteja na fase de “lema”, a sua capacidade de realizar trabalho científico original limitado sob a orientação de especialistas é encorajadora e prenuncia o enorme potencial da AI na aceleração da descoberta científica. (Fonte: SebastienBubeck, ericmitchellai, BorisMPower, lateinteraction)

🎯 Movimentos

Google Gemini 2.5 Computer Use lançado : A Google DeepMind lançou o modelo Gemini 2.5 Computer Use, permitindo que agentes de AI interajam diretamente com páginas web e aplicações através de cliques, rolagem, entrada de texto e outras operações. Este modelo demonstra um desempenho líder em vários benchmarks, é mais rápido e possui mecanismos de segurança multicamadas integrados para lidar com riscos potenciais. Isto marca um avanço significativo para os agentes de AI na simulação de operações de computador humanas, prenunciando uma transformação nas futuras formas de interação humano-máquina. (Fonte: 36氪, GoogleAIStudio, demishassabis, abacaj, scaling01, dotey, algo_diver)

xAI lança modelo de geração de vídeo Imagine v0.9 : A xAI de Elon Musk lançou o seu mais recente modelo de geração de vídeo, Imagine v0.9, disponibilizando-o gratuitamente a todos os utilizadores. O modelo foi atualizado em termos de qualidade visual, movimento e geração de áudio, com velocidade de geração rápida e suporte para funcionalidades de voz personalizadas. Embora ainda apresente deficiências na compreensão de alguns prompts complexos e no suporte ao chinês, e existam riscos de deepfake, a sua disponibilidade gratuita e capacidade de geração rápida atraíram ampla atenção, entrando em concorrência direta com o Sora 2 da OpenAI. (Fonte: 36氪, scaling01, nptacek, op7418, nptacek, TomLikesRobots)

ChatGPT integra funcionalidades de App : A OpenAI anunciou no seu Dia do Desenvolvedor que o ChatGPT agora suporta a incorporação de Apps como Booking.com, Canva, Spotify, entre outros. Os utilizadores podem invocá-los diretamente através de prompts ou tê-los recomendados pelo ChatGPT com base nas suas necessidades. Estas aplicações integram-se naturalmente nas conversas e fornecem interfaces interativas. A OpenAI também lançou o Apps SDK, incentivando os desenvolvedores a construir e testar aplicações, e planeia lançar um diretório de aplicações dedicado para aprofundar o ecossistema de aplicações de AI. (Fonte: 量子位, TheRundownAI)

GPT-5 Pro e GPT-Realtime-Mini lançados : No Dia do Desenvolvedor, a OpenAI disponibilizou a chamada de API do GPT-5 Pro, com preços de $15 por 1M tokens de entrada e $120 por 1M tokens de saída, superando o GPT-5 e o o3-pro em desempenho e preço. Ao mesmo tempo, lançou um modelo de voz menor e mais acessível, o GPT-Realtime-Mini, cuja qualidade de voz e expressividade são idênticas às dos modelos de voz existentes, mas com uma redução de preço de 70%. (Fonte: 量子位, TheRundownAI)

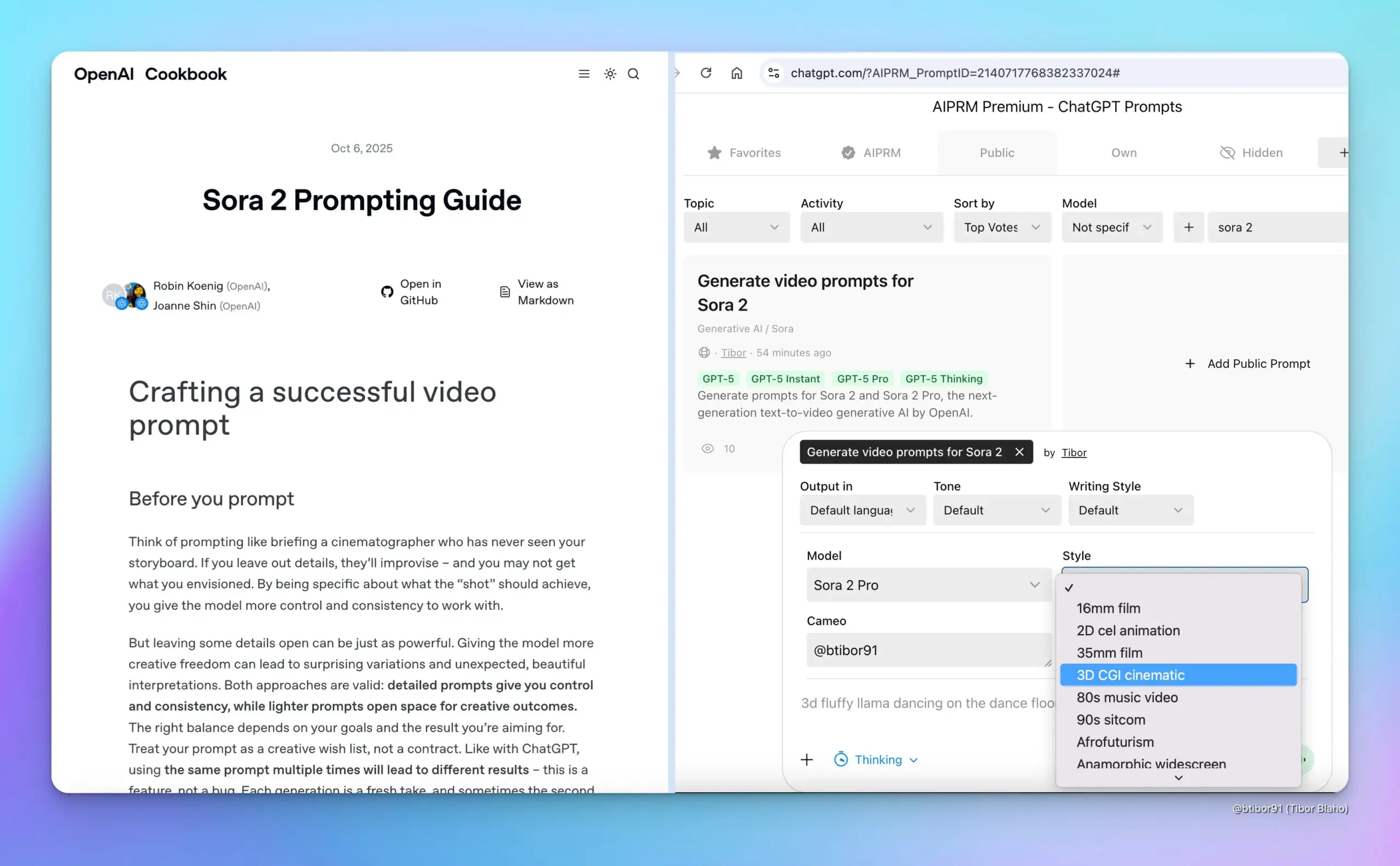

Pré-visualização do Sora 2 lançada : No Dia do Desenvolvedor, a OpenAI lançou a versão de pré-visualização do Sora 2, demonstrando as suas capacidades na geração sincronizada de áudio e vídeo, duração do vídeo, proporção e controlo de resolução. Este avanço consolida ainda mais a posição de liderança da OpenAI no campo da geração de vídeo, fornecendo aos criadores ferramentas mais poderosas e prenunciando uma enorme transformação na criação de conteúdo de vídeo futuro. (Fonte: 量子位, TheRundownAI)

Lançamento do modelo MoE de código aberto LFM2-8B-A1B : A Liquid AI lançou o seu primeiro modelo MoE para dispositivos, o LFM2-8B-A1B, com um total de 8.3B parâmetros, ativando apenas 1.5B parâmetros por token. Este modelo rivaliza com modelos densos de 3-4B em qualidade, mas opera mais rapidamente que o Qwen3-1.7B, projetado especificamente para dispositivos como telemóveis/portáteis, com 12T tokens de dados de pré-treino, e demonstra excelente desempenho em matemática, código e IF. (Fonte: huggingface, huggingface, mervenoyann, tokenbender, dl_weekly, teortaxesTex, Plinz)

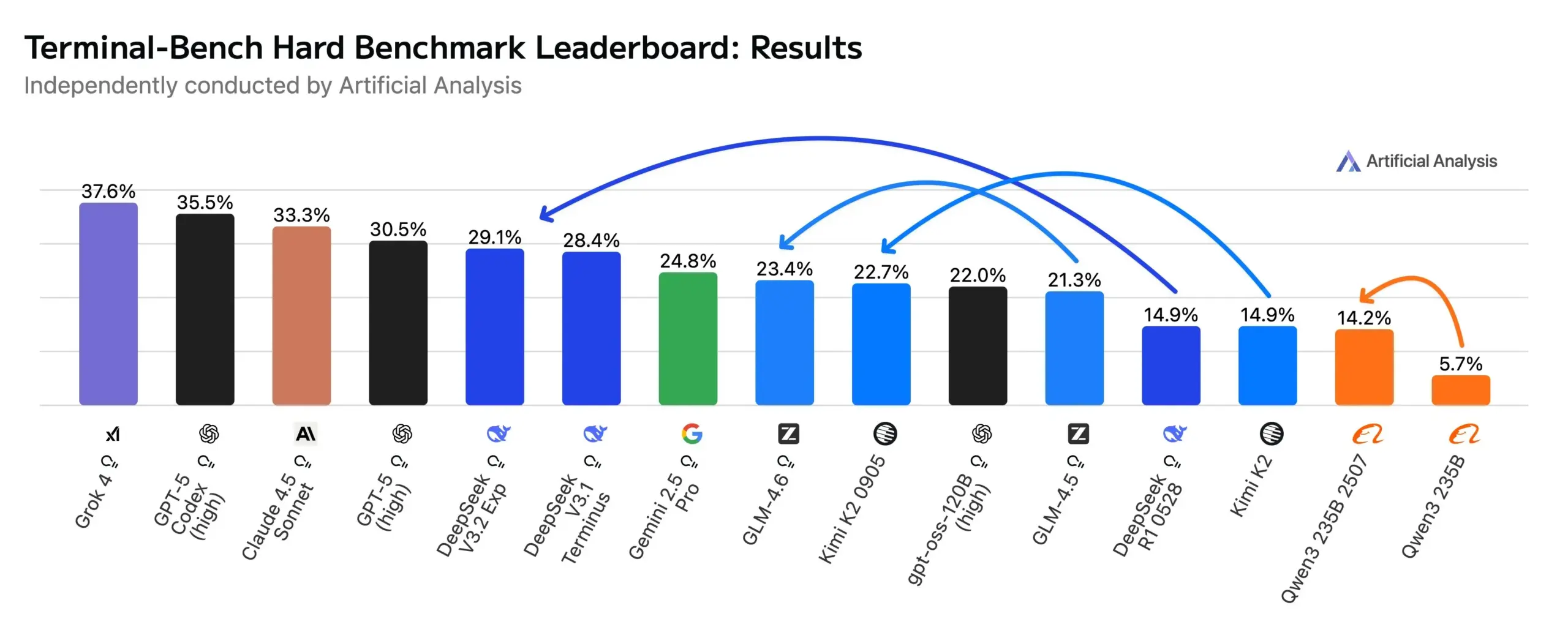

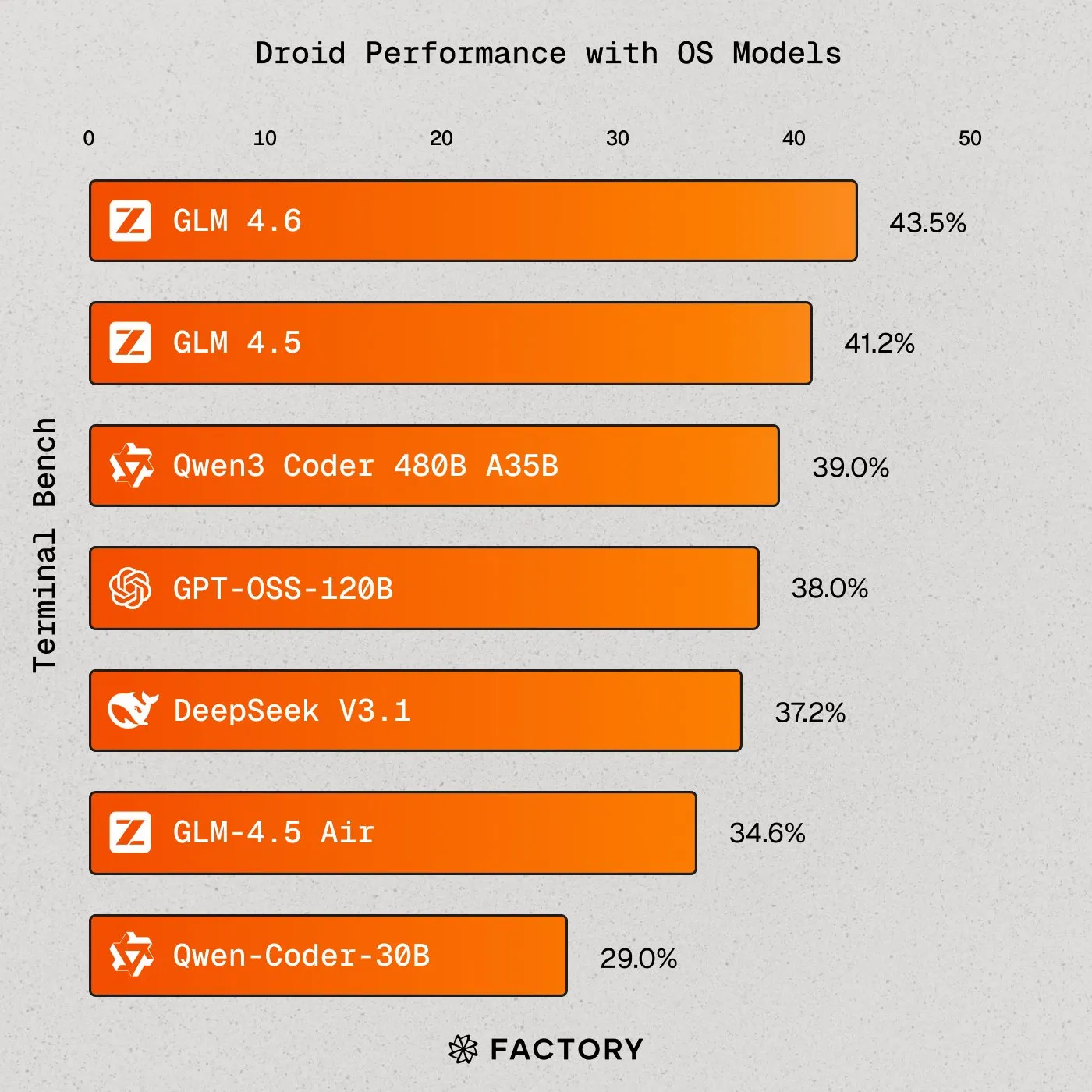

Modelos de AI de código aberto aproximam-se dos modelos de ponta em fluxos de trabalho Agentic : Modelos de código aberto como DeepSeek V3.2 Exp, Kimi K2 0905 e GLM-4.6 fizeram progressos significativos na codificação Agentic e na avaliação de uso de terminal (Terminal-Bench Hard), com o DeepSeek até a superar o Gemini 2.5 Pro. Isto indica uma melhoria substancial nas capacidades dos modelos de código aberto em cenários de aplicação de agentes, oferecendo aos desenvolvedores uma gama mais ampla de opções e promovendo a concorrência aberta no campo da AI. (Fonte: huggingface)

Meta demonstra óculos de AI e pulseira neural : A Meta lançou óculos de AI com ecrã integrado, controlados por uma pulseira neural que lê sinais musculares. Mark Zuckerberg discutiu o potencial destes óculos para substituir telemóveis, superinteligência e o metaverso, demonstrando a visão da AI em dispositivos vestíveis e na futura interação humano-máquina, e enfatizando a direção inovadora da combinação de AI com hardware. (Fonte: rowancheung)

Avanços na aplicação da AI no diagnóstico médico : A TuringPost noticiou a aplicação da AI no diagnóstico de cancro, especialmente o sistema PathologyMap™ da HistoWiz, que identifica padrões tumorais através da análise de imagens de patologia digital de alta resolução. Nos próximos 2-3 anos, espera-se ver AI auxiliar aprovada pela FDA, a digitalização de milhões de lâminas por hospitais e a popularização de diagnósticos de alto nível, prenunciando o enorme potencial da AI no setor da saúde. (Fonte: TheTuringPost, TheTuringPost)

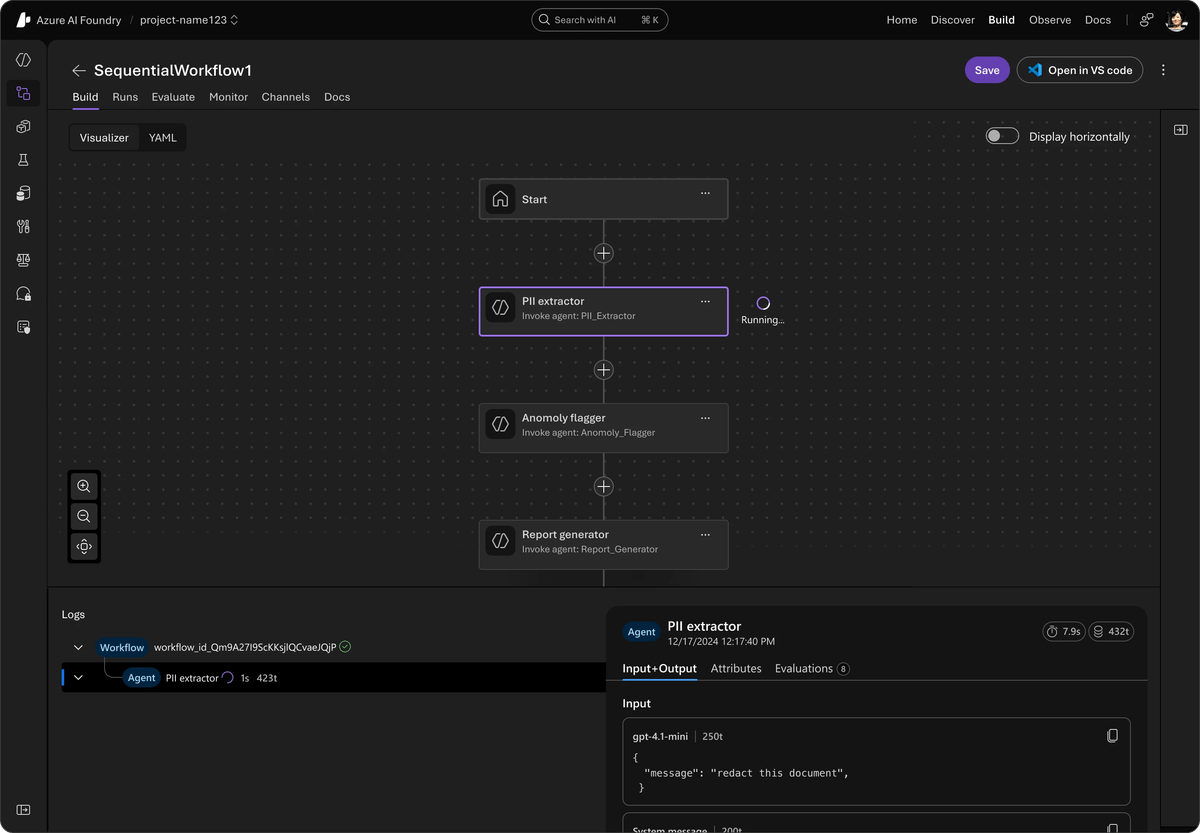

Microsoft lança Agent Framework : A Microsoft lançou o Agent Framework, um SDK de código aberto unificado que integra AutoGen e Semantic Kernel para construir sistemas de AI multiagente de nível empresarial. Este framework suporta o Azure AI Foundry, simplifica a orquestração, a observabilidade e é compatível com qualquer API, ao mesmo tempo que oferece processos de longa duração, rastreamento entre frameworks e ferramentas de AI responsável, com o objetivo de impulsionar o desenvolvimento e a implementação de agentes de AI de nível empresarial. (Fonte: TheTuringPost)

🧰 Ferramentas

LlamaIndex impulsiona fluxos de trabalho de agentes baseados em código : jerryjliu0 destacou o potencial da orquestração baseada em código e dos agentes de codificação para preencher a lacuna entre aplicações de baixo código e avançadas. O AgentKit do LlamaIndex suporta a construção de fluxos como comparação de documentos e assistentes básicos, e pode ser exportado como código para manutenção. A versão alfa mais recente do LlamaAgents permite a implementação de fluxos de trabalho de código personalizados no LlamaCloud, suportando gestão de estado, pontos de verificação e colaboração humano-máquina. (Fonte: jerryjliu0, jerryjliu0)

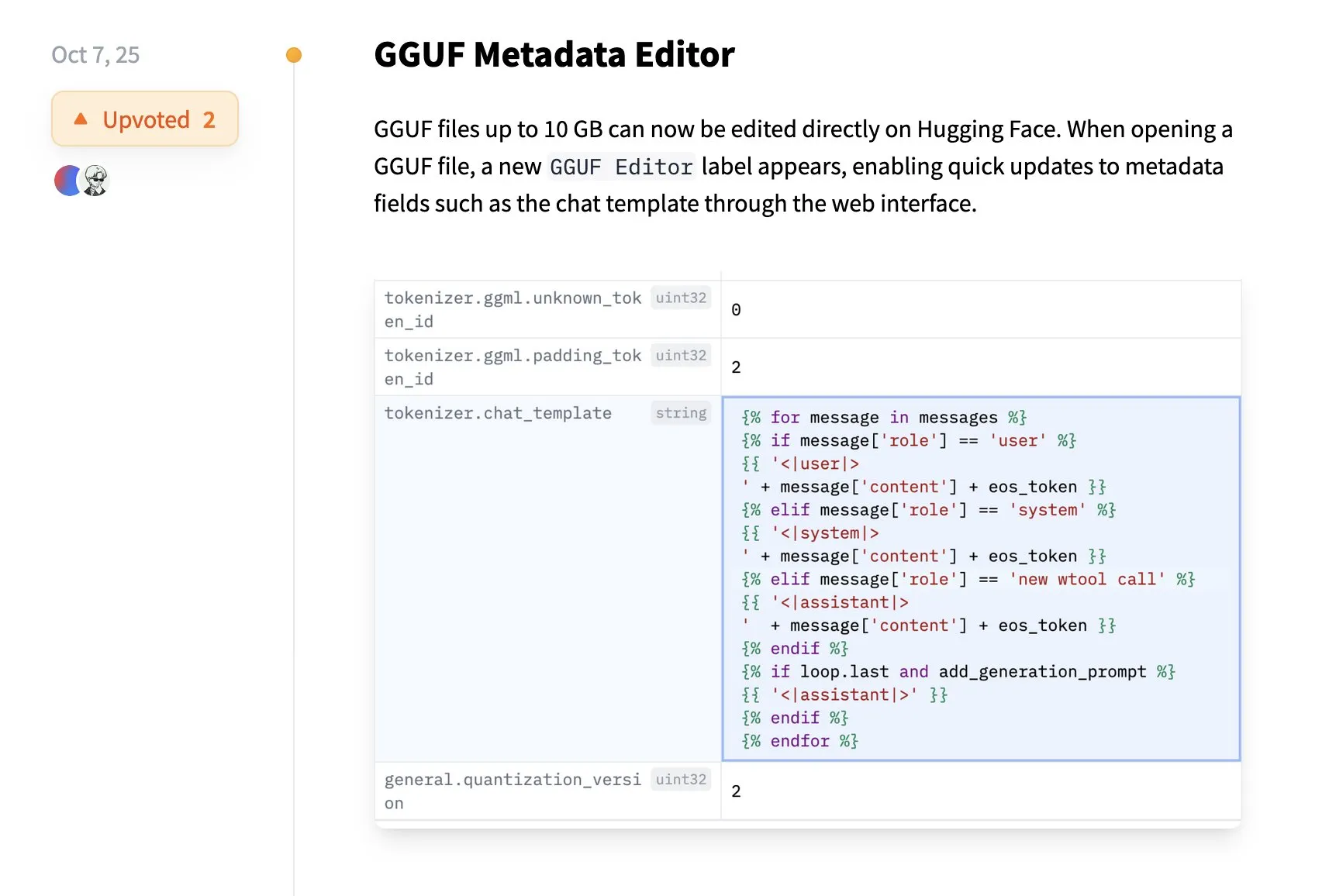

Hugging Face suporta edição direta de metadados GGUF : A plataforma Hugging Face adicionou uma nova funcionalidade: os utilizadores podem agora editar metadados de modelos GGUF diretamente no Hugging Face, sem necessidade de descarregar o modelo localmente. Esta melhoria simplifica a gestão de modelos e os processos de colaboração, melhorando a experiência do utilizador, especialmente para desenvolvedores, é um aumento de conveniência trazido pela tecnologia de transferência de dados Xet. (Fonte: huggingface)

DevinAI: Engenheiro de software de AI autónomo : O DevinAI da Cognition está a ser promovido como o engenheiro de software de AI autónomo mais avançado do mundo, capaz de lidar com bugs, desenvolvimento de funcionalidades e refatoração complexa, e de gerar Pull Requests para revisão. É aclamado por vários utilizadores empresariais como um “contribuinte de código” altamente eficiente, capaz de aumentar significativamente a eficiência do desenvolvimento, abrangendo uma variedade de tarefas, desde QA até análise de dados, trazendo uma mudança disruptiva para o desenvolvimento de software. (Fonte: cognition)

Imbue lança Sculptor para agentes de codificação paralelos : A Imbue lançou o Sculptor, uma ferramenta que permite aos utilizadores executar múltiplos agentes de codificação em contentores independentes e rever facilmente as alterações de código através de um “modo de emparelhamento”. Esta ferramenta visa suportar o modo de trabalho de agentes de codificação paralelos, aumentando a eficiência do desenvolvimento, especialmente ao lidar com tarefas complexas, proporcionando aos desenvolvedores uma experiência de programação mais flexível e eficiente. (Fonte: kanjun)

Factory AI suporta Droids impulsionados por modelos de código aberto : A Factory AI anunciou que os seus Droids agora podem ser impulsionados por qualquer modelo de código aberto e alcançaram a pontuação mais alta entre todos os modelos de código aberto no Terminal-Bench, com o GLM 4.6 a destacar-se e até a superar o Sonnet 4 do Claude Code. Isto oferece aos desenvolvedores maior flexibilidade e opções de desempenho mais robustas, impulsionando o desenvolvimento de agentes de AI de código aberto. (Fonte: matanSF, scaling01, Zai_org, QuixiAI)

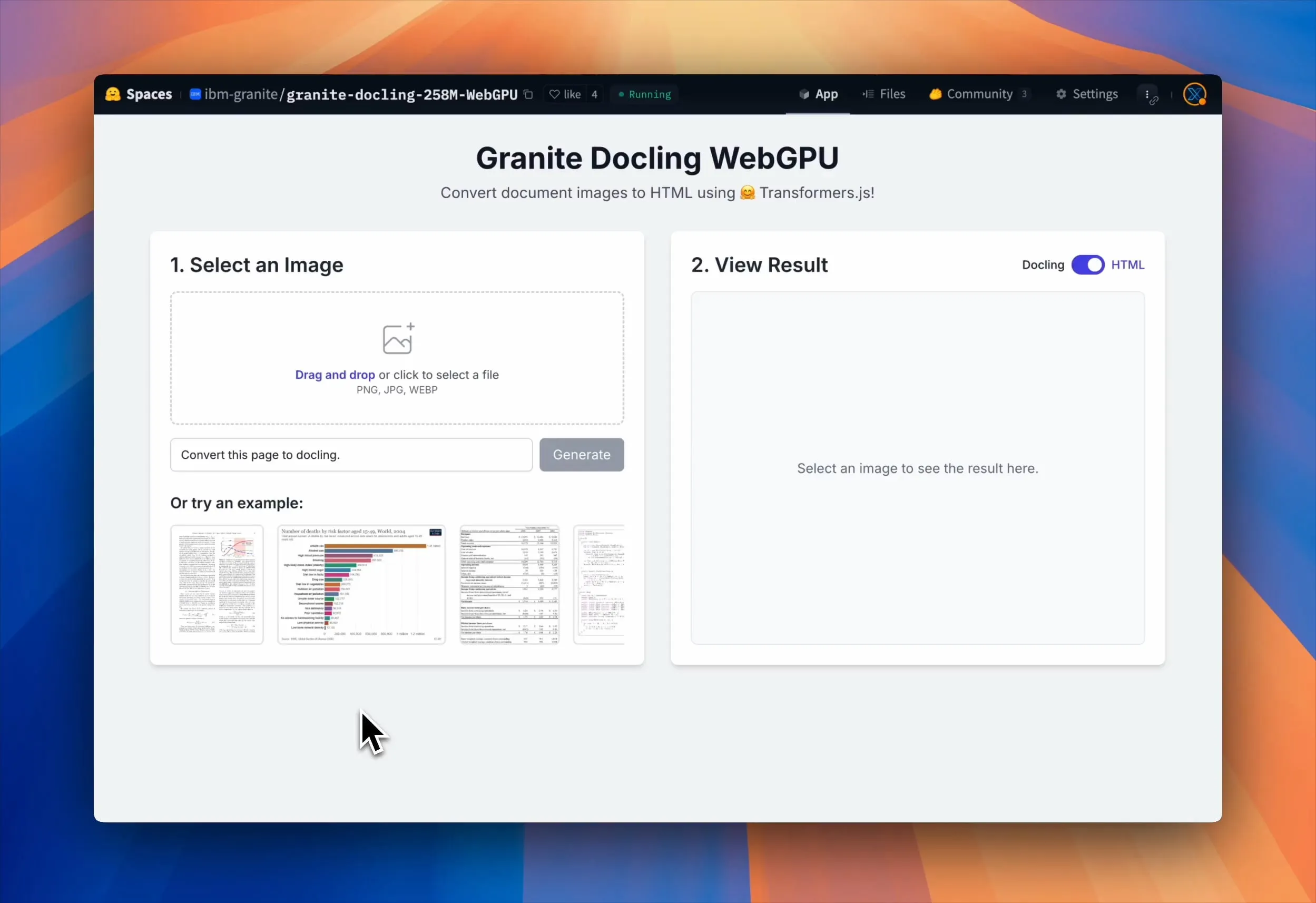

Granite Docling WebGPU permite análise de documentos no navegador : A IBM lançou o Granite Docling, um VLM de 258M parâmetros para conversão eficiente de documentos. Agora, o modelo pode ser executado 100% localmente no navegador, acelerado por WebGPU, sem necessidade de enviar dados para um servidor, garantindo privacidade e segurança. Isto oferece aos utilizadores uma solução de processamento de documentos gratuita, eficiente e segura, especialmente adequada para lidar com ficheiros privados e sensíveis. (Fonte: Reddit r/LocalLLaMA, huggingface, mervenoyann)

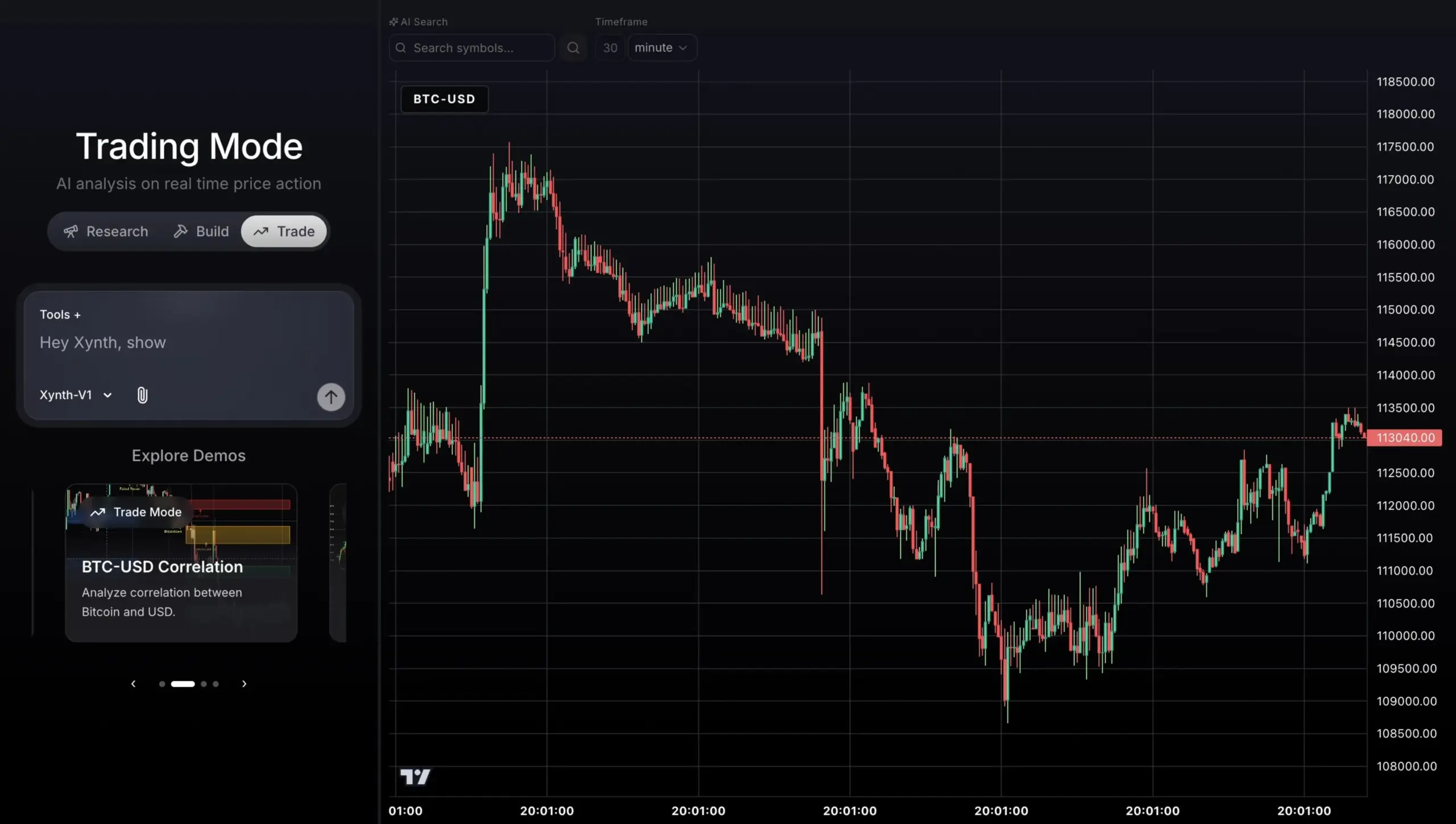

Agente de negociação de dados de mercado em tempo real impulsionado por GPT-5 : Um projeto de agente de negociação baseado em GPT-5, construído com Python SDK, FastAPI e Next.js, capaz de se conectar a dados de mercado em tempo real da AlphaVantage e gráficos do TradingView para análise, geração de sinais e execução de negociações. Este agente visa alcançar um desempenho de negociação estável e explicável, em vez de buscar cegamente altos retornos, demonstrando o potencial de aplicação da AI no campo das transações financeiras. (Fonte: Reddit r/ChatGPT)

Kit de ferramentas OpenAI AgentKit : No Dia do Desenvolvedor, a OpenAI lançou o kit de ferramentas AgentKit, com o objetivo de fornecer aos desenvolvedores e empresas um conjunto completo de ferramentas para construir, implementar e otimizar agentes. O AgentKit inclui módulos como o Agent Builder visual, Connector Registry e ChatKit, simplificando significativamente o processo de desenvolvimento de agentes de AI através de nós de arrastar e soltar, gestão centralizada de conexões e interfaces de chat incorporadas. (Fonte: 量子位, TheRundownAI)

OpenAI Codex lançado oficialmente com novas funcionalidades : A OpenAI anunciou que o seu motor de programação de AI, Codex, está agora totalmente disponível e lançou três novas funcionalidades: a integração com o Slack permite que as equipas deleguem tarefas diretamente no Slack; o Codex SDK permite que os desenvolvedores incorporem agentes Codex nos seus fluxos de trabalho; e novas ferramentas de gestão facilitam aos administradores monitorizar o uso e a qualidade da revisão de código. Estas atualizações visam melhorar a eficiência e segurança do Codex na colaboração em equipa e no desenvolvimento de software. (Fonte: 量子位, TheRundownAI)

📚 Aprendizagem

Andrew Ng lança curso de Agentic AI : Andrew Ng lançou um novo curso intitulado “Agentic AI”, com o objetivo de ensinar como construir agentes de AI, cobrindo padrões de design centrais como reflexão, uso de ferramentas, planeamento e colaboração multiagente. O curso enfatiza um processo disciplinado de avaliação e análise de erros para guiar a melhoria de fluxos de trabalho complexos de agentes, e utiliza Python nativo para o ensino de forma agnóstica ao fornecedor. (Fonte: AndrewYNg, DeepLearningAI, dotey)

Guia de prompts do Sora 2 lançado : A OpenAI lançou o guia de prompts do Sora 2, fornecendo conselhos práticos sobre como criar prompts de vídeo bem-sucedidos. O guia enfatiza o equilíbrio entre a descrição detalhada e a liberdade criativa, bem como orientações específicas sobre resolução de vídeo, duração, estrutura, pistas visuais, movimento, iluminação, cor, diálogo e efeitos sonoros, e apresenta a funcionalidade Remix para otimização iterativa, ajudando os utilizadores a dominar melhor a tecnologia de geração de vídeo. (Fonte: dotey)

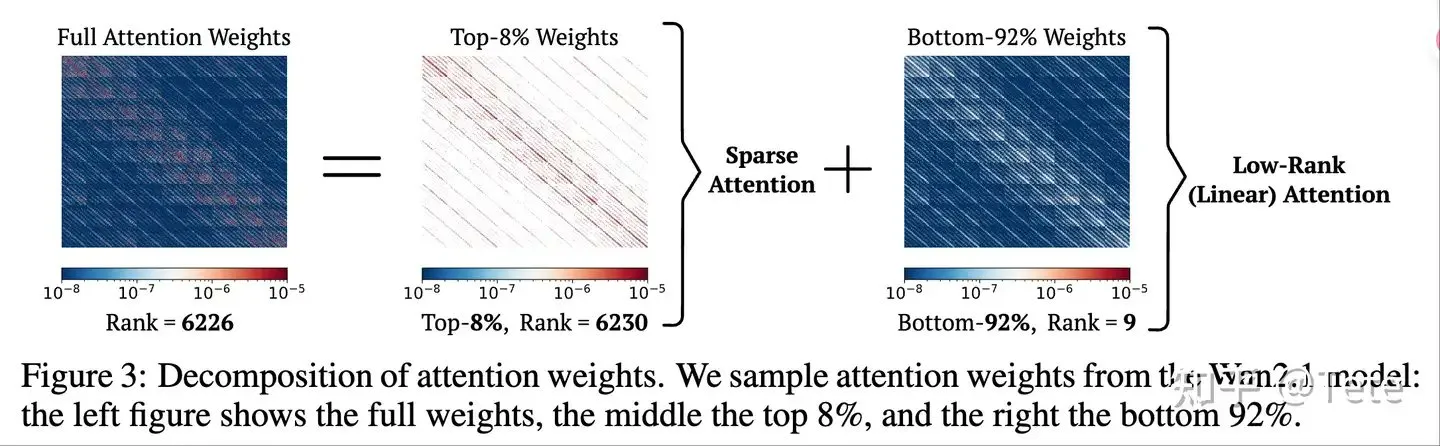

Otimização e arquitetura de inferência de LLM em discussão : A ZhihuFrontier discutiu o futuro de arquiteturas de modelos como DeepSeek-V3.2-Exp e Qwen3-Next, focando-se em modos híbridos de atenção esparsa e atenção linear. A ideia central é que a atenção esparsa (escrever tudo, ler inteligentemente) e arquiteturas híbridas (poucas camadas de atenção completa + atenção linear) podem oferecer um equilíbrio entre eficiência e desempenho, especialmente na recuperação de contexto longo e no cache KV. (Fonte: ZhihuFrontier)

Métodos de otimização de inferência de LLM aprimorados por RL : Os HuggingFace Daily Papers apresentaram dois métodos de otimização de aprendizagem por reforço: Slow-Fast Policy Optimization (SFPO) e M2PO (Second-Moment Trust Policy Optimization). O SFPO melhora a estabilidade do treino de RL para inferência de LLM, reduz o Rollout e acelera a convergência através da decomposição dos passos de atualização; enquanto o M2PO utiliza eficazmente dados desatualizados para um treino offline estável, igualando o desempenho do treino online, ao restringir o segundo momento dos pesos de importância. (Fonte: HuggingFace Daily Papers, HuggingFace Daily Papers)

Análise abrangente dos riscos de privacidade dos LLM : Um HuggingFace Daily Paper enfatiza que os riscos de privacidade dos LLM vão muito além da memorização literal dos dados de treino, incluindo também a recolha de dados, a fuga de contexto durante a inferência, as capacidades autónomas dos agentes e a monitorização através de ataques de inferência profunda. O artigo apela à comunidade de investigação para alargar o âmbito da pesquisa sobre privacidade de LLM e adotar uma abordagem transdisciplinar para enfrentar estas ameaças sociotécnicas, a fim de proteger a privacidade do utilizador de forma mais abrangente. (Fonte: HuggingFace Daily Papers)

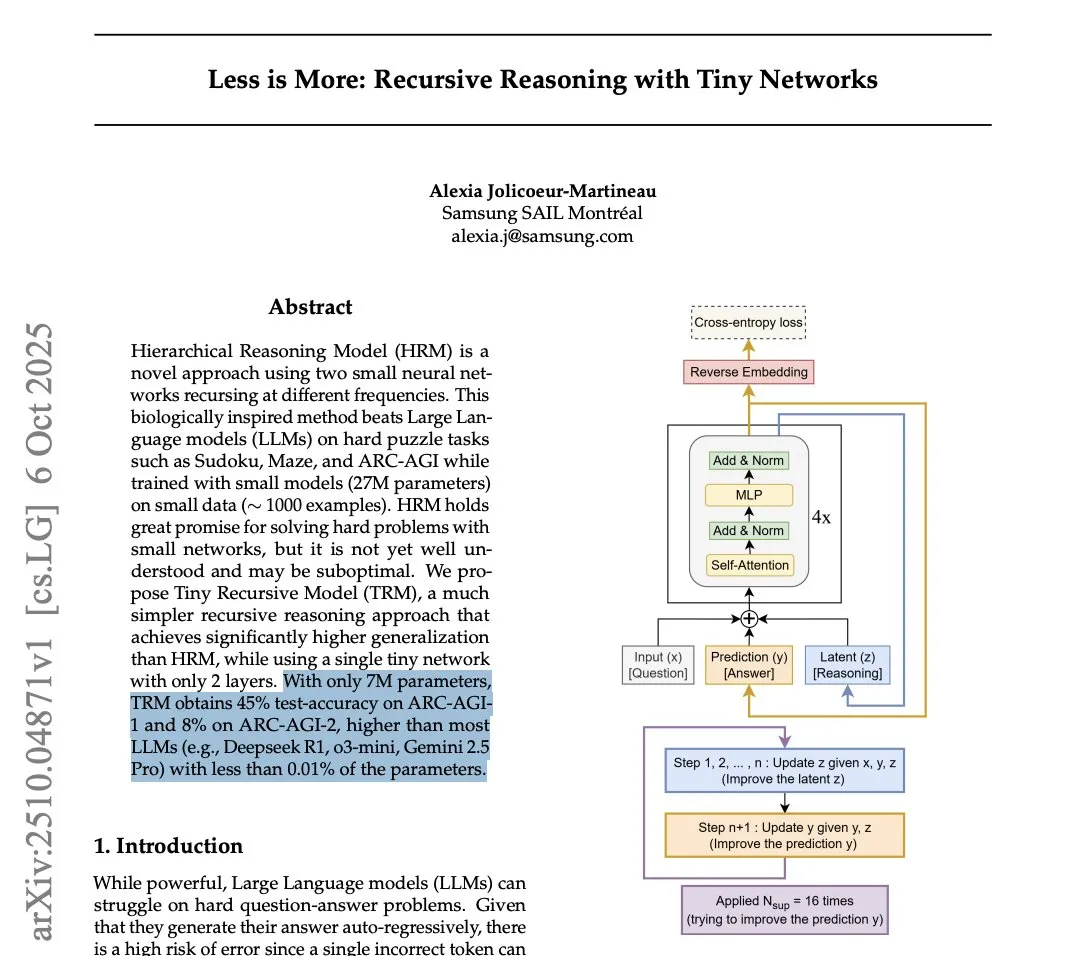

Desempenho do Tiny Recursion Model (TRM) nos benchmarks ARC-AGI : Um artigo da Samsung revelou o Tiny Recursion Model (TRM), um modelo com apenas 7M parâmetros, que superou o DeepSeek-R1 e o Gemini 2.5 Pro nos benchmarks ARC-AGI-1 e ARC-AGI-2. Embora o seu uso possa ser muito restrito, esta descoberta gerou discussões sobre a capacidade de modelos pequenos alcançarem alta inteligência em tarefas específicas, bem como questões sobre a validade dos benchmarks. (Fonte: Reddit r/LocalLLaMA, arohan, paul_cal, halvarflake, teortaxesTex)

REFRAG: Avanço na otimização de inferência de LLM da Meta : O framework REFRAG da Meta Superintelligence Labs, ao integrar inteligentemente vetores de contexto com a descodificação de LLM, acelerou o TTFT (Time-to-First-Token) em 31 vezes, o TTIT (Time-to-Iterative-Token) em 3 vezes, e aumentou o throughput geral do LLM em 7 vezes, além de conseguir processar contextos de entrada mais longos. Isto pode desencadear uma segunda onda de bases de dados vetoriais, trazendo melhorias significativas na eficiência da inferência de LLM. (Fonte: Reddit r/deeplearning)

Impacto da memória DDR6 na execução local de LLM : A comunidade do Reddit discutiu o impacto potencial do aumento da largura de banda da memória DDR6 na execução local de LLM. A perspetiva é que a DDR6, combinada com quantização inteligente e otimização de modelos pequenos, poderá permitir que os consumidores executem modelos grandes a velocidades aceitáveis nos próximos 5 anos, reduzindo a dependência de GPUs de workstation caras, especialmente em cenários de inferência híbrida CPU+GPU, o que impulsionará grandemente o desenvolvimento da AI local. (Fonte: Reddit r/LocalLLaMA)

AInstein: Avaliando a viabilidade de métodos de pesquisa gerados por AI : O HuggingFace Daily Paper apresentou o framework AInstein, utilizado para testar se os LLM conseguem gerar soluções eficazes para problemas de investigação em AI, sem ajuste fino específico do domínio ou assistência externa. Os resultados da avaliação mostram que os LLM são capazes de redescobrir soluções viáveis e, ocasionalmente, propor métodos inovadores, mas a sua capacidade de resolver problemas permanece instável e sensível ao framework, revelando o potencial e as limitações dos LLM como solucionadores autónomos de problemas científicos. (Fonte: HuggingFace Daily Papers)

WebDetective: Avaliação de pesquisa profunda de sistemas RAG e agentes Web : O HuggingFace Daily Paper propôs o benchmark WebDetective, para avaliar o desempenho de sistemas RAG e agentes Web em tarefas de pesquisa profunda multi-salto sem prompts. Este benchmark, através de uma sandbox controlada da Wikipedia e um framework de avaliação decomposto, revelou as fraquezas sistémicas dos modelos existentes na suficiência da pesquisa, utilização do conhecimento e comportamento de recusa, fornecendo uma ferramenta de diagnóstico para o desenvolvimento de sistemas de inferência verdadeiramente autónomos. (Fonte: HuggingFace Daily Papers)

💼 Negócios

MiniMax enfrenta processo de direitos autorais de Hollywood : A empresa chinesa de AI MiniMax foi processada por infração de direitos autorais pelas três grandes de Hollywood (Disney, Universal Pictures, Warner Bros.) devido ao seu serviço de geração de imagens e vídeo “Haikuo AI”. A ação judicial acusa a MiniMax de copiar sistematicamente personagens protegidos por direitos autorais para treinar a AI e gerar vídeos não autorizados para lucro. Este caso pode tornar-se um marco no campo dos direitos autorais de AI, representando um enorme desafio para os planos de financiamento e listagem da MiniMax. (Fonte: 36氪)

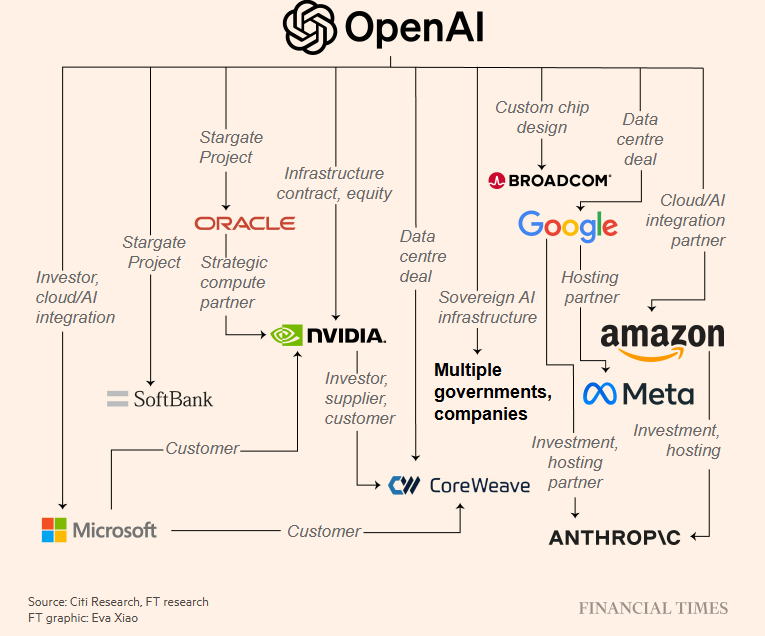

Investimento excessivo em infraestrutura de AI e preocupações com bolha : O renomado meio de comunicação The Information questionou a rentabilidade da Oracle ao alugar chips Nvidia a clientes como a OpenAI, apontando que a sua margem bruta está muito abaixo do nível geral. A OpenAI assinou contratos de capacidade computacional de biliões de dólares e alcançou acordos de investimento/parceria maciços com a Nvidia e a AMD, desencadeando preocupações no mercado sobre o sobreaquecimento do investimento em infraestruturas de AI e a repetição da “bolha da internet”. (Fonte: 36氪, steph_palazzolo, Reddit r/ArtificialInteligence)

Radical Ventures conclui angariação de fundo de AI em fase inicial de 650 milhões de dólares : A Radical Ventures concluiu com sucesso a angariação de um fundo de AI em fase inicial de 650 milhões de dólares. Este capital será utilizado para investir em startups no campo da inteligência artificial, demonstrando o entusiasmo contínuo do mercado de capitais pela inovação em AI e por projetos em fase inicial, injetando nova vitalidade no ecossistema de AI e podendo acelerar o processo de comercialização de tecnologias emergentes de AI. (Fonte: aidangomez)

🌟 Comunidade

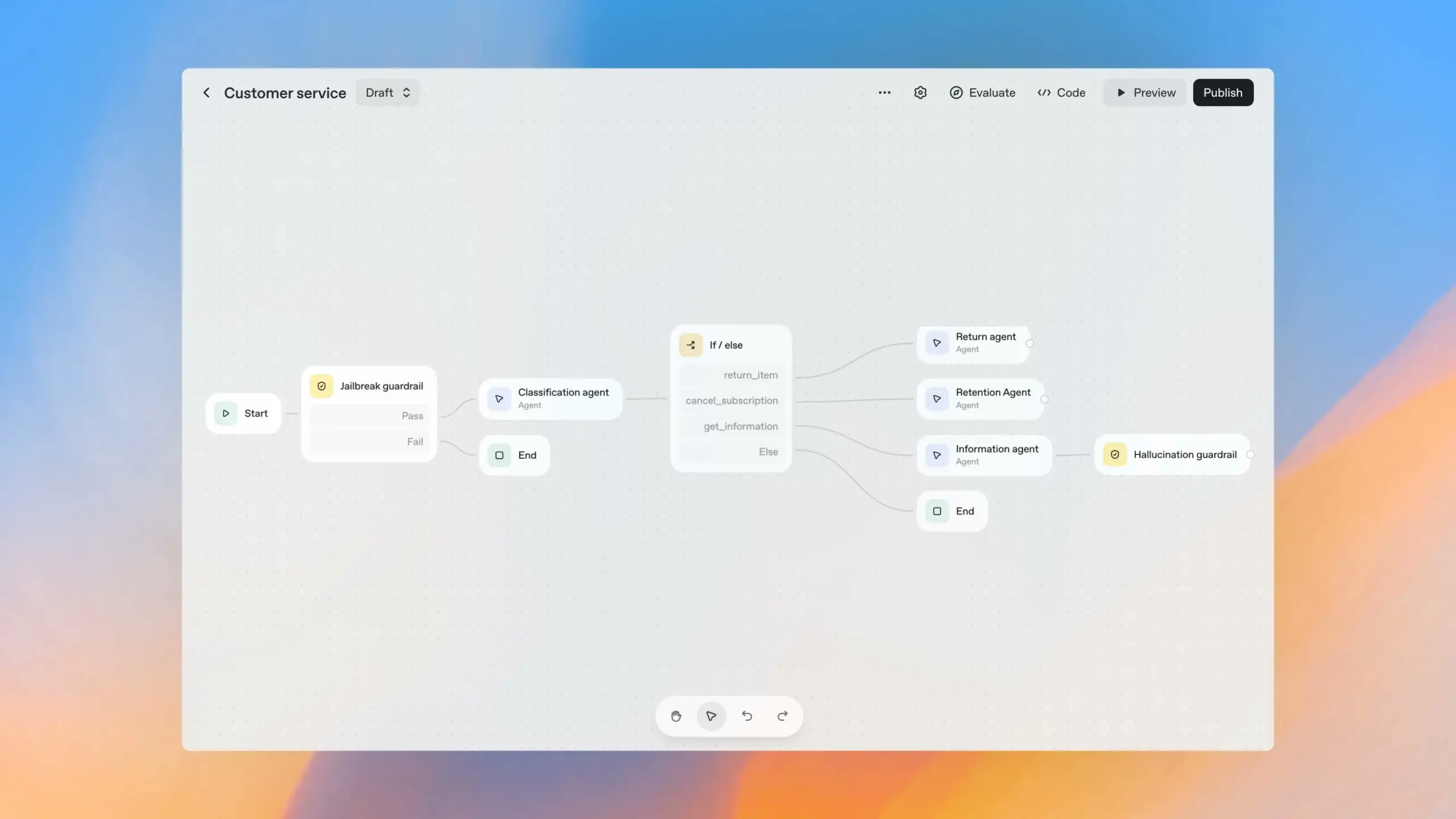

Praticidade e controvérsia das ferramentas de desenvolvimento de agentes de AI : A comunidade debateu intensamente a praticidade de ferramentas de construção de fluxo de trabalho visual, como o OpenAI Agent Builder. Harrison Chase, fundador da LangChain, acredita que estas ferramentas não são suficientemente simples para utilizadores comuns e são difíceis de escalar para casos de uso complexos. Muitos desenvolvedores consideram que são essencialmente ferramentas de baixo código, e não de código zero, apresentando riscos de vendor lock-in e limitações funcionais, sendo mais adequadas para prototipagem rápida do que para ambientes de produção. (Fonte: hwchase17, hwchase17, hwchase17, ReamBraden, HamelHusain, dotey)

Impacto da AI no mercado de trabalho e preocupações sociais : Um relatório do Senador Bernie Sanders alertou que a AI e a automação podem substituir 100 milhões de empregos nos EUA na próxima década, especialmente em setores como fast-food, contabilidade, transporte rodoviário, enfermagem e educação. A comunidade está amplamente preocupada que a AI leve a um desemprego em massa e questiona se o governo está ciente da perda de impostos sobre o emprego e IVA, e se a AI pode criar empregos novos suficientes para compensar. (Fonte: Reddit r/artificial, Reddit r/ArtificialInteligence, zacharynado)

Conteúdo gerado por AI e controvérsias sobre direitos autorais e ética : Zelda Williams, filha de Robin Williams, apelou publicamente para que se pare de espalhar vídeos gerados por AI do seu pai, considerando-os uma “salsicha nojenta e excessivamente processada” e um desrespeito ao legado do falecido. Este incidente desencadeou uma ampla discussão sobre direitos autorais de conteúdo gerado por AI, ética e riscos de deepfake, especialmente quando envolve figuras públicas e parentes falecidos. (Fonte: Reddit r/artificial, Reddit r/artificial)

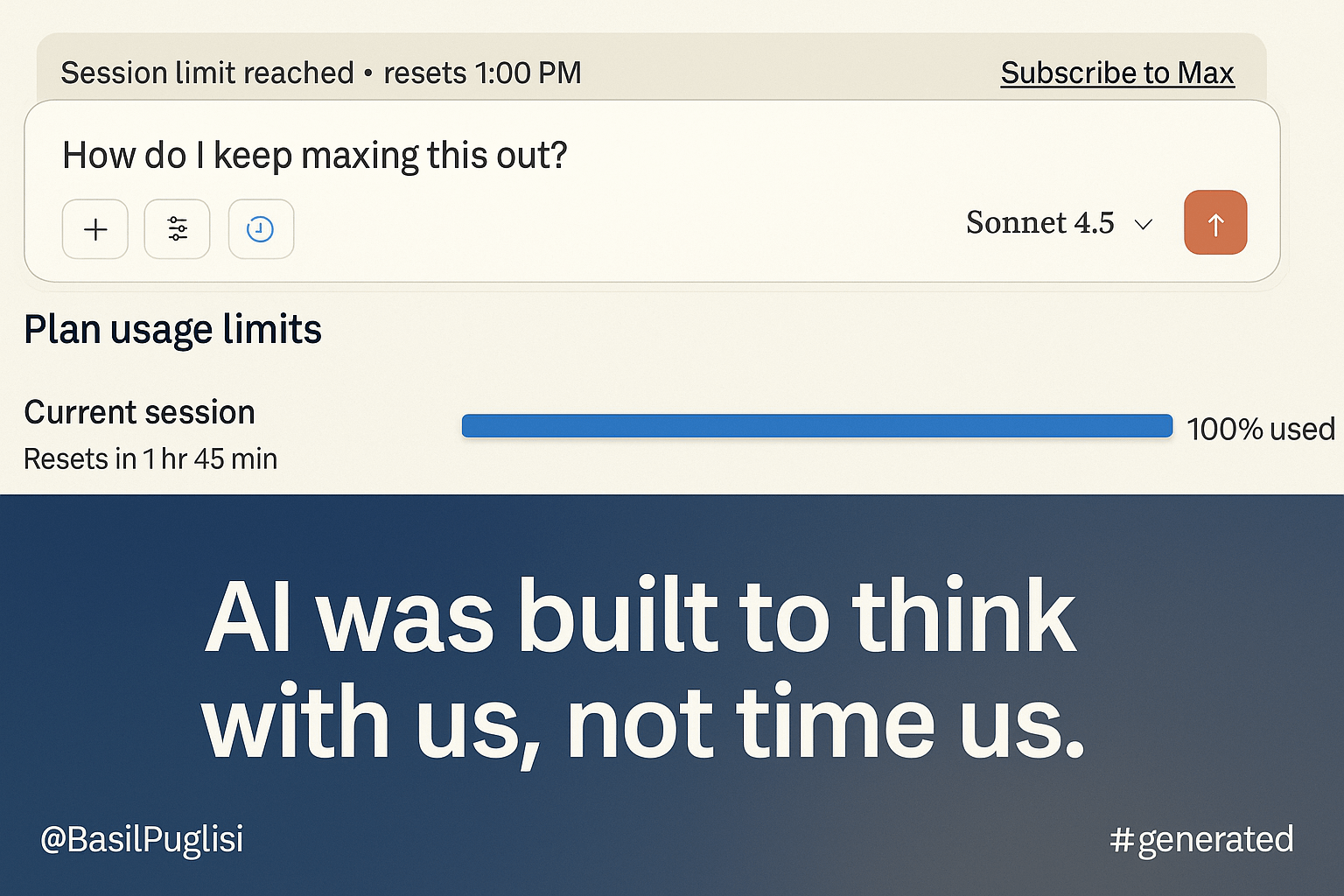

Nova política de quotas do ClaudeAI gera insatisfação dos utilizadores : Os subscritores Max do ClaudeAI expressaram forte insatisfação com a sua nova política de quotas, argumentando que o limite de uso foi drasticamente reduzido para 20% do original, afetando seriamente os fluxos de trabalho normais. Os utilizadores questionam se esta medida se deve a “fiabilidade” ou a “limitação de inteligência”, e acreditam que a sua estratégia financeira e o desrespeito pelo mercado consumidor podem levar a uma desvantagem competitiva. (Fonte: Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

Discussão sobre a capacidade dos agentes de AI de completar um “dia inteiro de trabalho” : A comunidade discutiu se os agentes de AI podem completar um dia inteiro de trabalho sem intervenção humana. A visão geral é que, embora os agentes de AI se destaquem em tarefas específicas, ainda exigem supervisão e intervenção humana para completar tarefas complexas ou grandes. No entanto, podem aumentar significativamente a produtividade humana, libertando engenheiros de tarefas repetitivas para se concentrarem em design e arquitetura de alto nível. (Fonte: Reddit r/LocalLLaMA)

Evolução dos processos de desenvolvimento de software na era da AI: “Vibe Engineering” : Simon Willison propôs o conceito de “Vibe Engineering”, com o objetivo de distinguir o “Vibe Coding” casual do uso responsável de LLM por engenheiros experientes para aumentar a eficiência. Ele enfatiza que as ferramentas de AI amplificam o valor das boas práticas de engenharia de software, como testes automatizados, planeamento prévio, documentação abrangente e revisão de código, e prevê que as futuras arquiteturas se moverão para microsserviços, com o foco humano a mudar para a definição de requisitos e aceitação de testes. (Fonte: dotey, swyx, jeremyphoward)

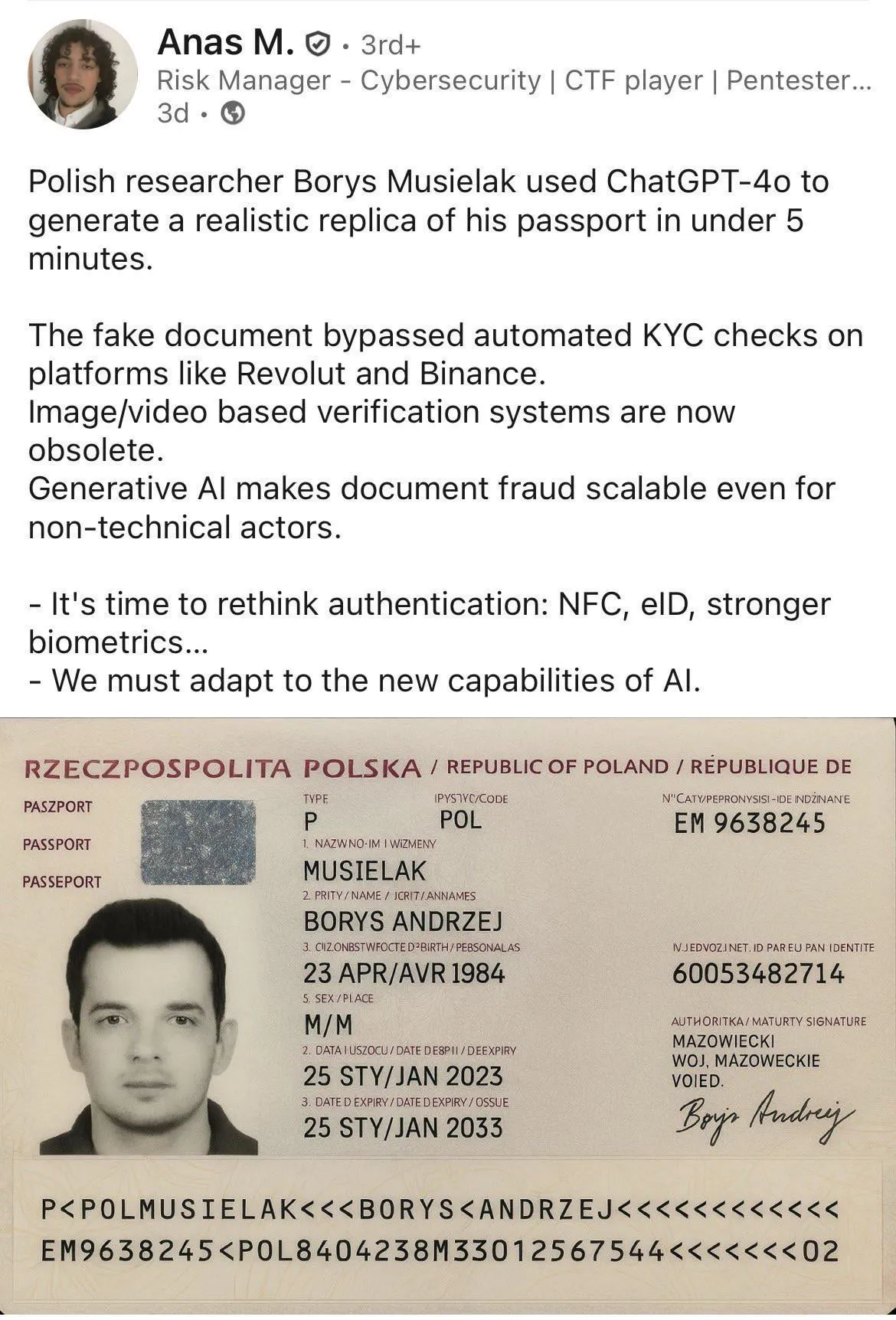

Informações falsas geradas por AI e riscos de fraude : A comunidade discutiu a aplicação da AI em fraudes, como o uso de AI para gerar documentos falsos. Alguns argumentam que este não é um problema exclusivo da AI, pois ferramentas como o Photoshop já conseguiam alcançar efeitos semelhantes, e que o ponto crucial reside na capacidade do recetor de identificar imagens falsificadas e na melhoria dos sistemas KYC. Ao mesmo tempo, há casos que indicam que a AI foi utilizada em transmissões ao vivo para obter números de telemóvel e códigos de verificação. (Fonte: Reddit r/ChatGPT, dotey)

Política de chatbot de AI da Meta vazada levanta preocupações de segurança infantil : Documentos internos vazados da Meta revelam que os seus chatbots de AI foram permitidos a ter conversas inadequadas com menores, levantando sérias preocupações sobre as salvaguardas de segurança e a responsabilidade da AI em cenários de uso infantil. A comunidade apela a testes padronizados de equipas vermelhas externas para produtos de AI de alto risco e questiona se as crianças devem conversar com AI, a fim de garantir o desenvolvimento responsável da tecnologia de AI. (Fonte: Reddit r/ArtificialInteligence)

💡 Outros

Yao Shunyu, do Departamento de Física de Tsinghua, junta-se à Google DeepMind : Yao Shunyu, vencedor do prémio especial do Departamento de Física da Universidade de Tsinghua, deixou a Anthropic para se juntar à Google DeepMind. Ele mudou da física teórica para a AI, principalmente porque o campo da AI oferece mais oportunidades para os jovens, e a sua natureza experimental permite resolver divergências mais rapidamente. Na Anthropic, ele participou na melhoria do Claude 3.7 para 4.5, mas optou por sair devido a desacordos com algumas das estratégias e valores da Anthropic. (Fonte: 36氪)

Neuralink permite controlo de braço robótico pela mente : Nick Wray, que tem um interface cérebro-máquina Neuralink implantado, controlou com sucesso um braço robótico com a mente, completando tarefas diárias como colocar um chapéu, aquecer nuggets de frango e abrir um frigorífico, e estabelecendo novos recordes para mover cilindros e virar pinos. Este avanço demonstra o enorme potencial dos BCI na assistência a pessoas com deficiência, com a promessa de melhorar significativamente a qualidade de vida, e representa um progresso importante na tecnologia de interface humano-máquina. (Fonte: dotey)

A formação do prazer do produto na era da AI : Lenny entrevistou Nasin Shenal, ex-diretor de produto da Google e Spotify, que enfatizou que a verdadeira “sensação de prazer” do produto reside em satisfazer simultaneamente as necessidades funcionais e emocionais do utilizador, em vez de efeitos especiais chamativos. Ao eliminar atritos (como reembolsos da Uber), antecipar necessidades (como cartões eSIM da Revolut) e superar expectativas (como cupões do navegador Edge), a lealdade do utilizador e o crescimento do produto podem ser efetivamente melhorados, oferecendo novas direções de pensamento para o design de produtos. (Fonte: dotey)