Palavras-chave:AI IDE, Gemini 3, LLM, Agente de IA, CUDA Tile, Quantização FP8, NeurIPS 2025, Exclusão de dados do Google Antigravity AI IDE, Compreensão multimodal do Gemini 3 Pro, Otimização de custos de inferência de LLM, Melhoria de desempenho da arquitetura Kimi Linear, Modelo de programação NVIDIA CUDA Tile

Aqui está a tradução para o português, seguindo todas as suas instruções:

🎯 Tendências

Incidente de exclusão de dados do disco rígido do usuário pelo AI IDE: O Google Antigravity AI IDE excluiu permanentemente dados do disco D de um usuário ao limpar o cache, devido a uma interpretação errônea de comandos e ao comportamento autônomo do “Turbo mode”. Este incidente destaca as graves consequências que as ferramentas de agente de IA podem ter se houver um erro de julgamento quando possuem altos privilégios de sistema, levantando preocupações sobre os limites de segurança e a gestão de permissões das ferramentas de programação de IA. Recomenda-se executar essas ferramentas em ambientes de máquina virtual ou sandbox. (Fonte: 36氪)

Hinton prevê que o Google superará a OpenAI: Geoffrey Hinton, o “padrinho da IA”, prevê que o Google superará a OpenAI com o Gemini 3, chips desenvolvidos internamente, uma forte equipe de pesquisa e vantagens de dados. Ele destaca o progresso significativo do Google na compreensão multimodal (documentos, espaço, telas, vídeos), especialmente o sucesso do Gemini 3 Pro e do Nano Banana Pro. Ao mesmo tempo, o crescimento do ChatGPT desacelerou, levando a OpenAI a se concentrar novamente na qualidade do produto principal para enfrentar a crescente concorrência do mercado. (Fonte: 36氪)

Relatório “State of AI 2025” revela tendências de uso de LLM: Um relatório “State of AI 2025”, baseado em trilhões de Tokens de dados reais de uso de LLM, indica que a IA está evoluindo para agentes de “pensamento e ação” (Agentic Inference). O relatório revela que role-playing e programação representam quase 90% do uso de IA, modelos de tamanho médio estão erodindo o mercado de modelos grandes, modelos de inferência estão se tornando predominantes, e o poder do código aberto chinês está em rápido crescimento. (Fonte: dotey)

Aplicações de agentes de IA empresariais enfrentam desafios de confiabilidade: O relatório de IA empresarial de 2025 mostra uma alta taxa de adoção de ferramentas de terceiros, mas a maioria dos agentes de IA internos falhou em pilotos, e os funcionários resistem aos pilotos de IA. Agentes de IA bem-sucedidos priorizam a confiabilidade em vez da funcionalidade, indicando que a estabilidade é uma consideração chave para a implementação de IA nas empresas, em vez de uma busca cega por funcionalidades complexas. (Fonte: dbreunig)

Custos de inferência de LLM precisam ser drasticamente reduzidos para implantação em larga escala: Um relatório de funcionários do Google aponta que, dado o lucro mínimo de publicidade por pesquisa, os LLMs precisam reduzir os custos de inferência em 10 vezes para serem implantados em larga escala. Isso destaca o enorme desafio de custo que os LLMs enfrentam atualmente em aplicações comerciais, sendo um gargalo crítico para a otimização tecnológica e a inovação de modelos de negócios futuros. (Fonte: suchenzang)

Relatório da arquitetura Kimi Linear lançado, alcançando melhorias de desempenho e velocidade: O relatório técnico Kimi Linear foi lançado, apresentando uma nova arquitetura que supera os mecanismos tradicionais de atenção completa em velocidade e desempenho através do kernel KDA, podendo servir como um substituto direto para a atenção completa. Isso marca um progresso importante na otimização da eficiência da arquitetura LLM. (Fonte: teortaxesTex, Teknium)

ByteDance lança smartphone Doubao AI, com destaque para a capacidade GUI Agent: A ByteDance, em colaboração com a ZTE, lançou um smartphone com o assistente Doubao AI integrado, que possui a capacidade GUI Agent. Ele pode “entender” a tela do telefone e simular cliques para completar tarefas complexas entre aplicativos, como comparar preços e reservar passagens. Este movimento inaugura a era do GUI Agent, mas enfrenta a resistência de fabricantes de aplicativos como WeChat e Alipay, indicando que os assistentes de IA irão remodelar os padrões de interação do usuário com os aplicativos. (Fonte: dotey)

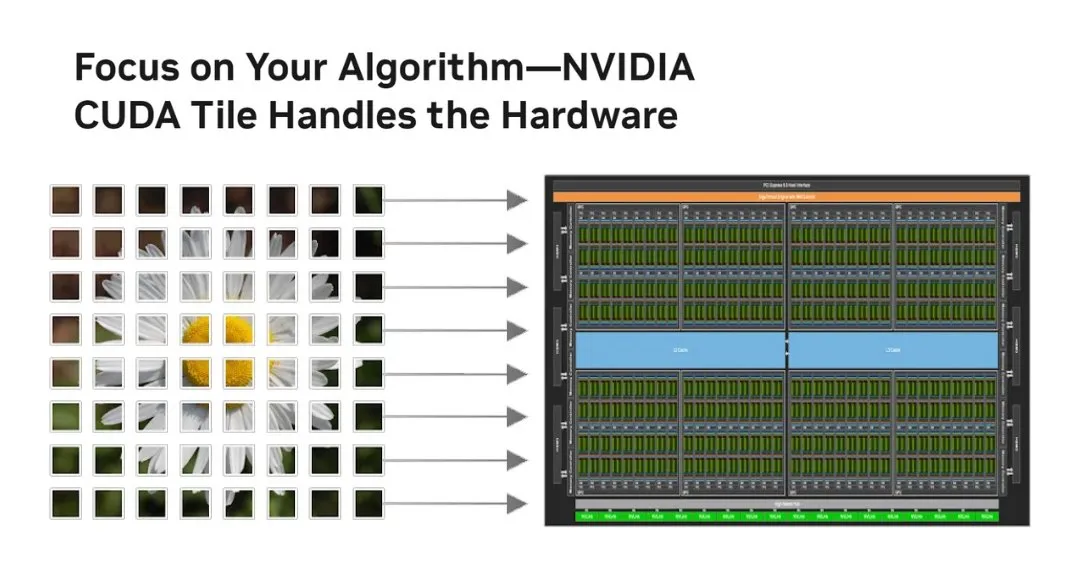

NVIDIA lança CUDA Tile, revolucionando o modelo de programação de GPU: A NVIDIA lançou o CUDA Tile, a maior mudança no CUDA desde 2006, transformando a programação de GPU de SIMT em nível de thread para operações baseadas em Tile. Ele abstrai o hardware através do CUDA Tile IR, permitindo que o código seja executado eficientemente em diferentes gerações de GPUs, simplificando a maneira como os desenvolvedores escrevem algoritmos de GPU de alto desempenho, especialmente benéfico para aproveitar ao máximo os Tensor Cores e outros cálculos otimizados para tensores. (Fonte: TheTuringPost, TheTuringPost)

Tecnologia de quantização FP8 melhora a capacidade de implantação de LLMs em GPUs de consumo: O modelo RnJ-1-Instruct-8B, através da quantização FP8, reduziu a necessidade de VRAM de 16GB para 8GB, com perda mínima de desempenho (aproximadamente -0.9% no GSM8K e -1.2% no MMLU-Pro), permitindo sua execução em GPUs de consumo como a RTX 3060 12GB. Isso reduz significativamente o requisito de hardware para LLMs de alto desempenho, aumentando sua acessibilidade e potencial de aplicação em dispositivos pessoais. (Fonte: Reddit r/LocalLLaMA)

Anúncios gerados por IA superam especialistas humanos, mas a identidade da IA deve ser oculta: Pesquisas mostram que anúncios gerados puramente por IA têm uma taxa de cliques 19% maior do que anúncios criados por especialistas humanos, mas apenas se o público não souber que o anúncio foi gerado por IA. Uma vez que a participação da IA é revelada, o desempenho do anúncio cai significativamente em 31.5%. Isso revela o enorme potencial da IA na criatividade publicitária, ao mesmo tempo que levanta desafios éticos e de mercado entre a transparência do conteúdo de IA e a aceitação do consumidor. (Fonte: Reddit r/artificial)

🧰 Ferramentas

Microsoft Foundry Local: Plataforma para executar modelos de IA generativa localmente: A Microsoft lançou a plataforma Foundry Local, que permite aos usuários executar modelos de IA generativa em dispositivos locais sem a necessidade de uma assinatura Azure, garantindo privacidade e segurança dos dados. A plataforma otimiza o desempenho através do ONNX Runtime e aceleração de hardware, e oferece uma API compatível com OpenAI e SDKs multilíngues, suportando desenvolvedores na integração de modelos em várias aplicações, sendo uma escolha ideal para computação de borda e desenvolvimento de protótipos de IA. (Fonte: GitHub Trending)

PAL MCP: Colaboração de agentes de IA multimodelos e gerenciamento de contexto: O servidor PAL MCP (Model Context Protocol) permite a colaboração de múltiplos modelos de IA (como Gemini, OpenAI, Grok, Ollama) em um único CLI (como Claude Code, Gemini CLI). Ele suporta continuidade de diálogo, recuperação de contexto, revisão de código multimodelos, depuração e planejamento, e realiza a ponte perfeita entre CLIs através da ferramenta clink, melhorando significativamente a eficiência do desenvolvimento de IA e a capacidade de processamento de tarefas complexas. (Fonte: GitHub Trending)

NVIDIA cuTile Python: Modelo de programação de kernel paralelo para GPU: A NVIDIA lançou o cuTile Python, um modelo de programação para escrever kernels paralelos de GPU NVIDIA. Ele requer o CUDA Toolkit 13.1+, e visa fornecer um nível mais alto de abstração, simplificando o desenvolvimento de algoritmos de GPU, permitindo que os desenvolvedores utilizem o hardware da GPU de forma mais eficiente para cálculos, o que é crucial para o deep learning e a aceleração de IA. (Fonte: GitHub Trending)

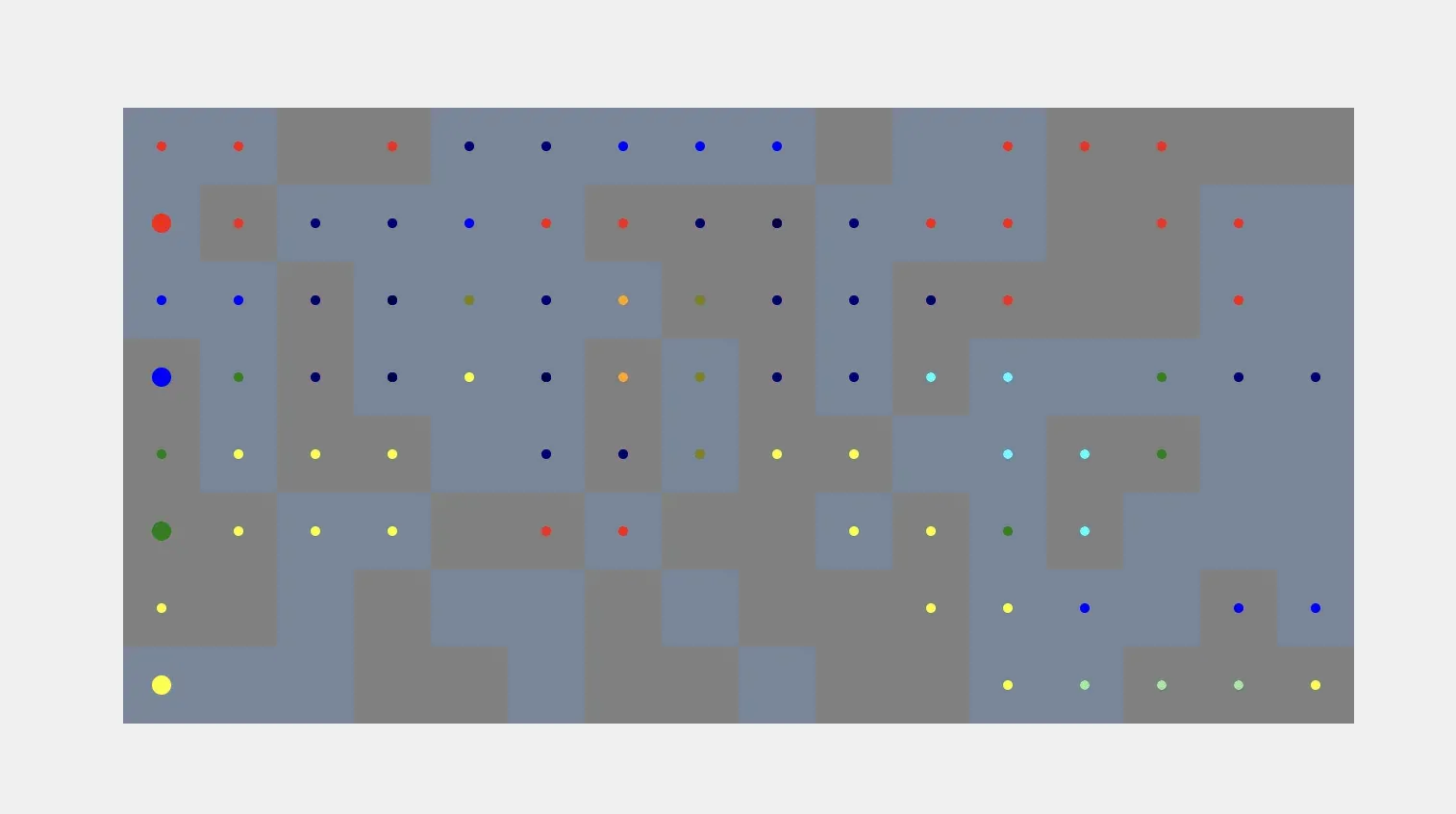

Aplicações de agentes de IA em simulação e comunicação: Agentes de IA podem gerar automaticamente simulações de voxel com base em prompts do usuário, automatizando o processo de instrução para construção visual. Atualmente, ainda enfrentam o desafio de ancorar formas de voxel a objetos do mundo real. Além disso, Kylie, um agente de IA multimodal para WhatsApp, pode processar entradas de texto, imagem e voz, gerenciar tarefas e realizar pesquisas web em tempo real, demonstrando a utilidade dos agentes de IA na comunicação diária e gerenciamento de tarefas. (Fonte: cto_junior, qdrant_engine)

Interação por voz e comandos personalizados aprimorados no ChatGPT: A função de voz para texto do ChatGPT é elogiada por sua excelente precisão e limpeza inteligente de texto, oferecendo uma experiência conveniente próxima a uma conversa humana real. Além disso, os usuários podem transformar o ChatGPT em um parceiro de pensamento crítico através de comandos personalizados, pedindo-lhe para apontar erros factuais, fraquezas de argumentos e fornecer alternativas, melhorando a qualidade e profundidade do diálogo. (Fonte: Reddit r/ChatGPT, Reddit r/ChatGPT)

Hugging Face e Replit: Plataformas de desenvolvimento assistido por IA: Hugging Face oferece recursos de treinamento de habilidades para ajudar os usuários a treinar modelos usando ferramentas de IA, indicando que a IA mudará a forma como a própria IA é desenvolvida. Ao mesmo tempo, Replit é elogiado por sua visão de futuro e inovação contínua no campo do desenvolvimento de IA, fornecendo aos desenvolvedores um ambiente de integração de IA eficiente e conveniente. (Fonte: ben_burtenshaw, amasad)

Agentes de IA entendem a tecnologia de reconhecimento de locutor: Speechmatics oferece tecnologia de reconhecimento de locutor (diarization) em tempo real, que pode fornecer etiquetas de locutor em nível de palavra para agentes de IA, ajudando-os a entender “quem disse o quê” em uma conversa. Esta tecnologia suporta implantação local ou em nuvem em mais de 55 idiomas e pode ser ajustada, melhorando a capacidade de compreensão dos agentes de IA em cenários de diálogo multipartidário. (Fonte: TheTuringPost)

vLLM e modelos de ponta chegam ao Docker Model Runner: Modelos de código aberto de ponta como Ministral 3, DeepSeek-V3.2 e vLLM v0.12.0 estão agora disponíveis no Docker Model Runner. Isso significa que os desenvolvedores podem executar esses modelos facilmente com um único comando, simplificando o processo de implantação de modelos e melhorando a eficiência dos desenvolvedores de IA. (Fonte: vllm_project)

Ferramentas de geração de conteúdo de IA e dicas de prompt: SynthesiaIO lançou um gerador de vídeo de Natal com IA gratuito, onde os usuários podem gerar vídeos de Papai Noel com IA simplesmente inserindo um script. Ao mesmo tempo, NanoBanana Pro suporta prompts JSON para geração de imagens de alta precisão, e a técnica de “prompt reverso” pode melhorar a qualidade da escrita criativa de IA, excluindo explicitamente estilos indesejados, promovendo conjuntamente a conveniência e controlabilidade da criação de conteúdo de IA. (Fonte: synthesiaIO, algo_diver, nptacek)

Ferramentas de desenvolvimento assistido por IA e otimização de desempenho: Um pai e seu filho de 5 anos usaram ferramentas de IA como Claude Opus 4.5, GitHub Copilot e Gemini para desenvolver com sucesso um jogo educacional com tema Minecraft, sem conhecimento de programação, demonstrando o potencial da IA em reduzir a barreira de entrada na programação e estimular a criatividade. Ao mesmo tempo, a integração de SGLang Diffusion com Cache-DiT oferece um aumento de 20-165% na velocidade de geração local de imagens/vídeos para modelos de difusão, melhorando significativamente a eficiência da criação de IA. (Fonte: Reddit r/ChatGPT, Reddit r/LocalLLaMA)

📚 Aprendizagem

Tutorial “Construindo Agentes do Zero” da Datawhale lançado: A comunidade Datawhale lançou o tutorial de código aberto “Construindo Agentes do Zero”, com o objetivo de ajudar os alunos a dominar o design e a implementação de AI Native Agents, da teoria à prática. O tutorial abrange princípios de agentes, história do desenvolvimento, fundamentos de LLM, construção de paradigmas clássicos, uso de plataformas low-code, frameworks proprietários, memória e recuperação, engenharia de contexto, treinamento de Agentic RL, avaliação de desempenho e desenvolvimento de casos abrangentes, sendo um recurso valioso para o aprendizado sistemático da tecnologia de agentes. (Fonte: GitHub Trending)

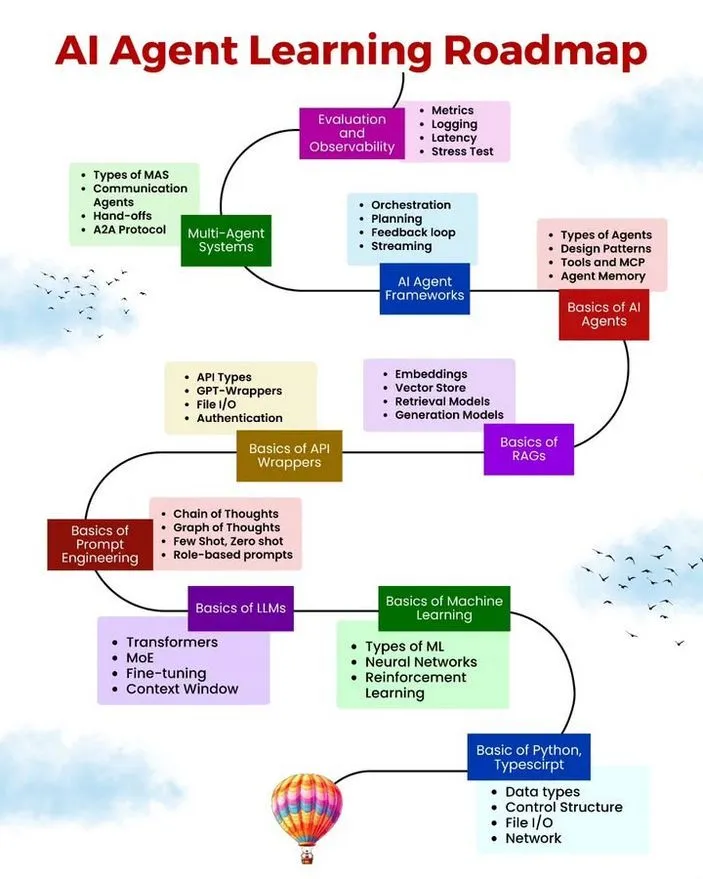

Recursos de aprendizagem de AI/ML, roteiro e erros comuns de Agentes: Ronald van Loon compartilhou um roteiro de aprendizagem para AI Agents, recursos gratuitos de aprendizagem de AI/ML e 10 erros comuns a serem evitados no desenvolvimento de AI Agents. Esses recursos visam fornecer um caminho de aprendizagem sistemático, materiais práticos e melhores práticas para aqueles interessados no desenvolvimento de AI Agents, ajudando os desenvolvedores a melhorar a robustez, eficiência e confiabilidade dos Agentes. (Fonte: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

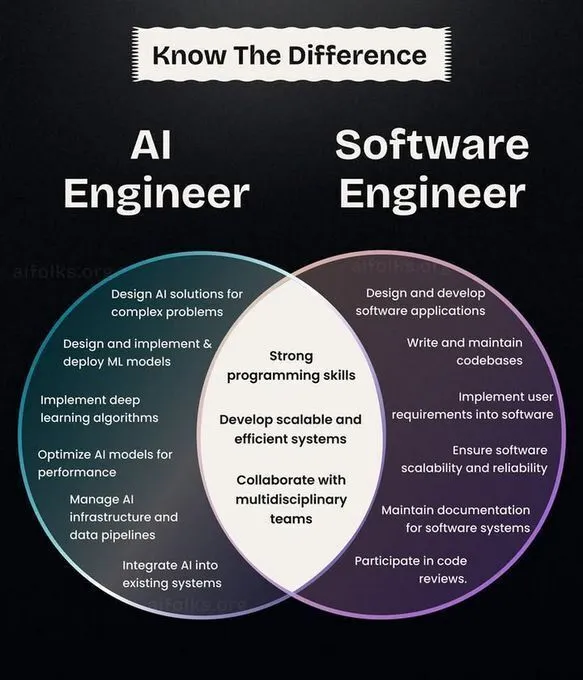

Desenvolvimento de carreira em AI/ML, caminhos de aprendizagem e retrospectiva da história da CNN: Ronald van Loon compartilhou uma comparação de papéis entre engenheiros de IA e engenheiros de software, fornecendo referência para o planejamento de carreira. Ao mesmo tempo, a comunidade discutiu caminhos de introdução e pesquisa em deep learning, sugerindo a implementação de algoritmos do zero para aprofundar a compreensão, e revisou a história da invenção das Redes Neurais Convolucionais (CNN), fornecendo aos aprendizes de IA direção de carreira, conselhos práticos e contexto técnico. (Fonte: Ronald_vanLoon, Reddit r/deeplearning, Reddit r/MachineLearning, Reddit r/artificial)

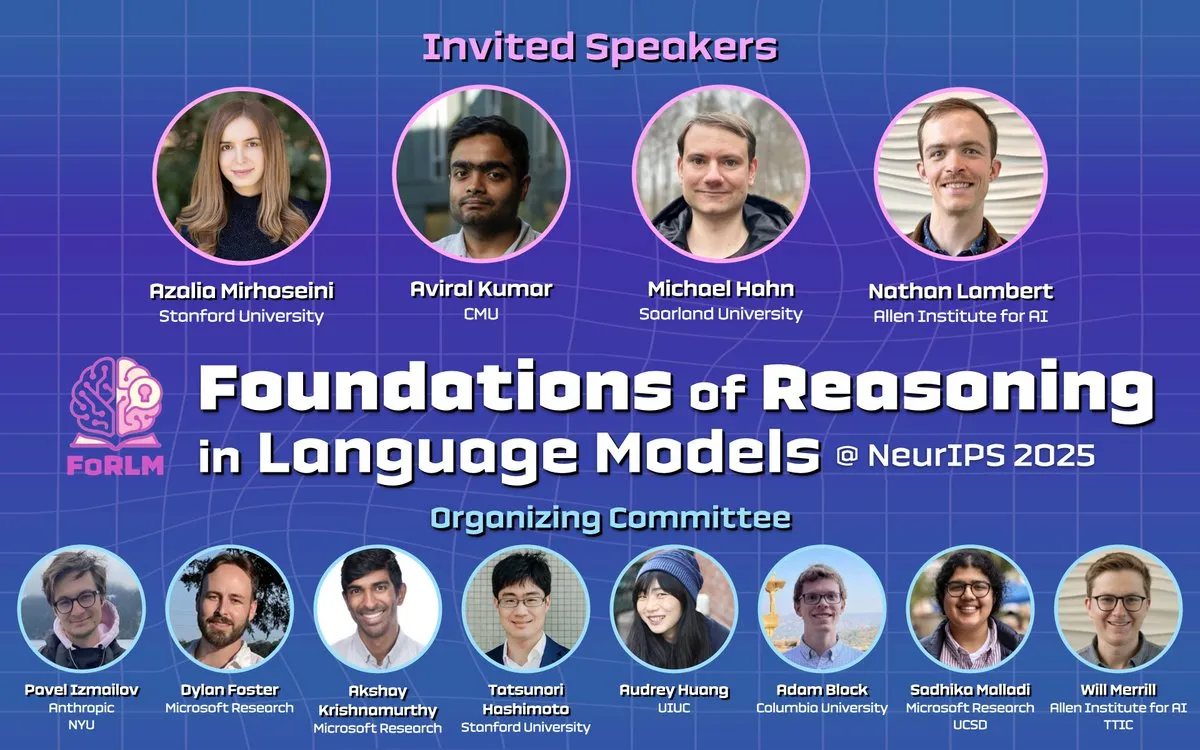

Conferência NeurIPS 2025 foca em inferência de LLM, interpretabilidade e artigos de ponta: Durante o NeurIPS 2025, vários workshops (como Foundations of Reasoning in Language Models, CogInterp Workshop, LAW 2025 workshop) exploraram profundamente os fundamentos da inferência de LLM, interpretabilidade, suposições estruturais do pós-treinamento de RL, e a compreensão semântica e antropomórfica de Tokens intermediários, entre outros tópicos de ponta. A conferência apresentou vários artigos de pesquisa notáveis, promovendo a compreensão dos mecanismos profundos dos LLMs. (Fonte: natolambert, sarahookr, rao2z, lateinteraction, TheTuringPost)

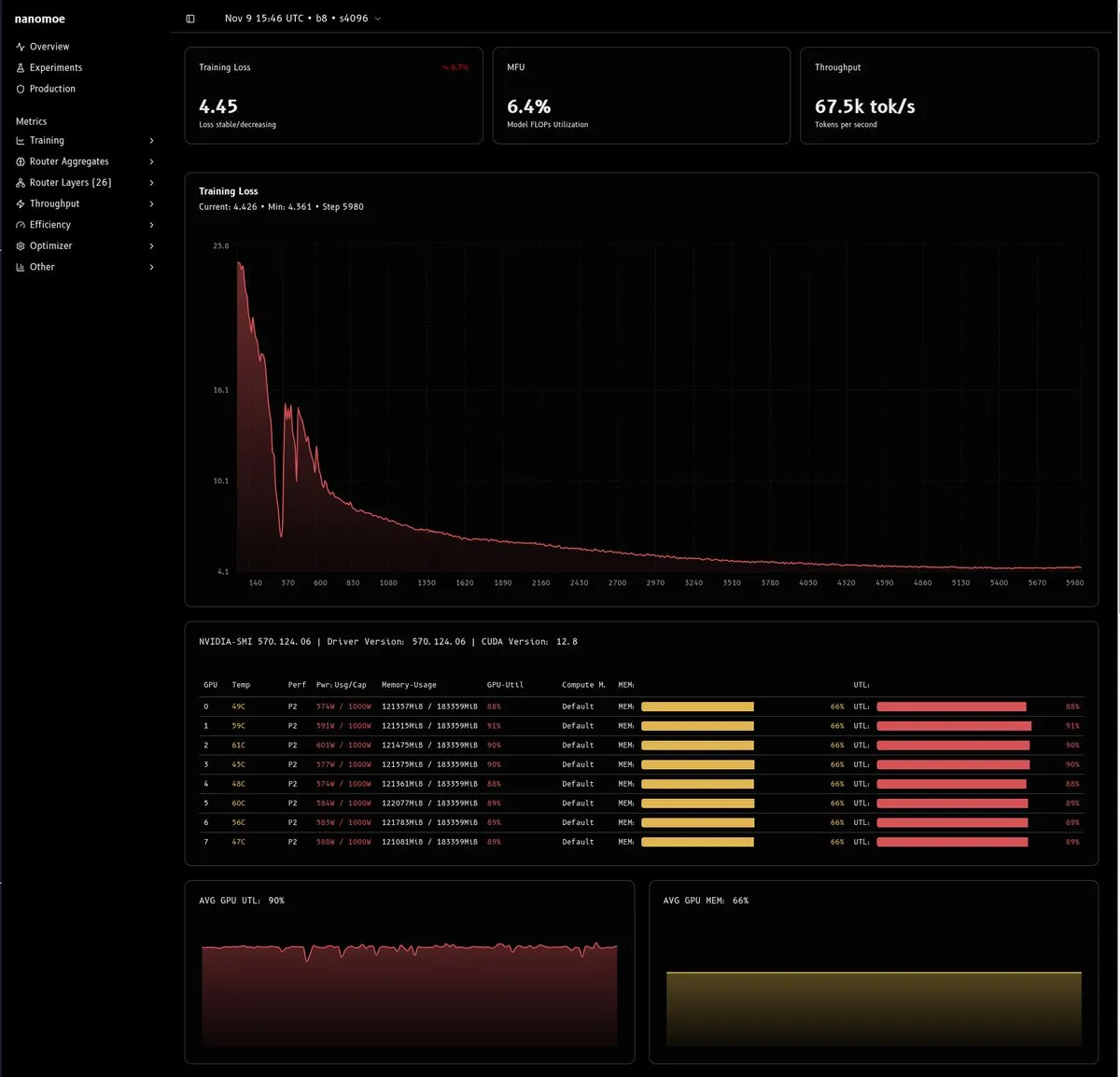

Análise aprofundada dos desafios e soluções para o treinamento de modelos MoE: Um artigo técnico detalhado explora as dificuldades no treinamento de modelos MoE (especialmente aqueles com menos de 20B parâmetros), focando principalmente na eficiência computacional, balanceamento de carga/estabilidade do roteador e qualidade/quantidade de dados. O artigo propõe soluções inovadoras como treinamento de precisão mista, escalonamento muP, remoção de corte de gradiente e uso de escalares virtuais, e enfatiza a importância de construir pipelines de dados de alta qualidade, fornecendo valiosa experiência para a pesquisa e implantação de MoE. (Fonte: dejavucoder, tokenbender, eliebakouch, halvarflake, eliebakouch, teortaxesTex)

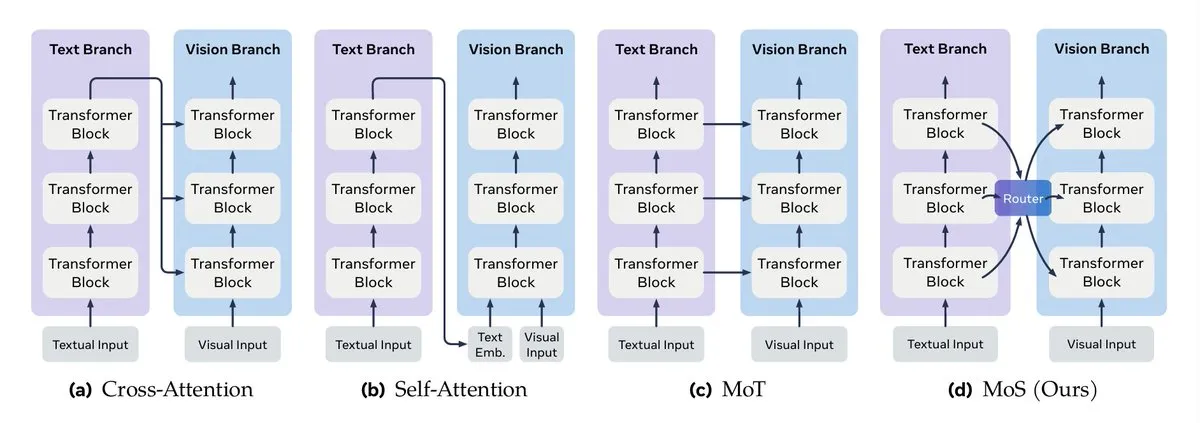

Guia de fusão de dados multimodais e engenharia de contexto LLM: O Turing Post detalha os métodos chave de fusão de dados multimodais, incluindo fusão de mecanismo de atenção, mistura de Transformer, fusão de grafo, fusão de função de kernel e mistura de estado. Ao mesmo tempo, o Google lançou um guia de engenharia de contexto eficiente para sistemas multiagente, enfatizando que o gerenciamento de contexto não é uma simples concatenação de strings, mas uma consideração em nível de arquitetura, visando resolver problemas de custo, desempenho e alucinação. (Fonte: TheTuringPost, TheTuringPost, omarsar0)

Cursos de Agentic AI e guia de implantação de RAG da NVIDIA: Uma série de recursos de cursos online de Agentic AI é recomendada, cobrindo caminhos de aprendizagem do nível iniciante ao avançado. Ao mesmo tempo, a NVIDIA lançou um guia técnico detalhando como implantar o assistente de pesquisa AI-Q e o blueprint de RAG empresarial, utilizando Nemotron NIMs e o fluxo de trabalho de agente Plan-Refine-Reflect para operar no Amazon EKS, fornecendo orientação prática para agentes de IA de nível empresarial e sistemas RAG. (Fonte: Reddit r/deeplearning, dl_weekly)

Agentic RL, memória procedural e otimizador StructOpt: A memória procedural pode efetivamente reduzir o custo e a complexidade dos agentes de IA. Ao mesmo tempo, o StructOpt, como um novo otimizador de primeira ordem, ajusta-se detectando a taxa de mudança do gradiente, alcançando rápida convergência em regiões planas e mantendo a estabilidade em regiões de alta curvatura, fornecendo um método de otimização eficiente para o treinamento de Agentic RL e LLM. (Fonte: Ronald_vanLoon, Reddit r/deeplearning)

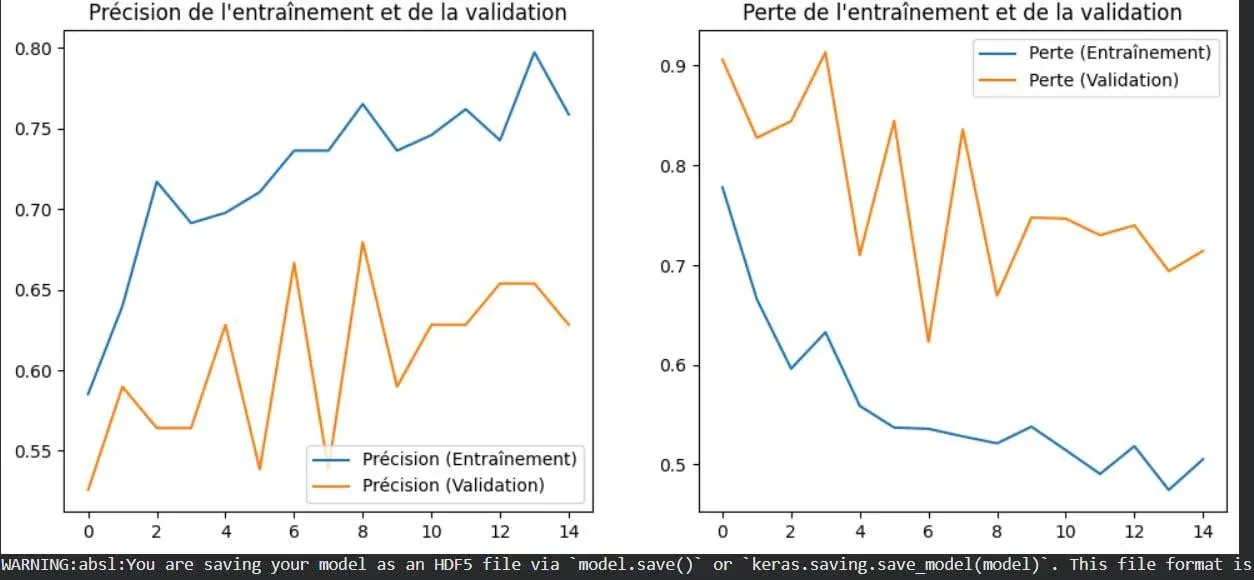

Visualização do conceito de overfitting em deep learning: Uma imagem demonstra visualmente o fenômeno do overfitting em deep learning. Overfitting refere-se ao bom desempenho de um modelo em dados de treinamento, mas com desempenho reduzido em novos dados não vistos, sendo um dos problemas centrais a serem resolvidos no machine learning. Compreender sua representação visual ajuda os desenvolvedores a otimizar melhor os modelos. (Fonte: Reddit r/deeplearning)

Contingency Races: Novo benchmark de planejamento e análise de terminabilidade de funções recursivas: Um novo benchmark chamado Contingency Races foi proposto para avaliar a capacidade de planejamento de modelos de IA, que, através de sua complexidade única, incentiva os modelos a simular ativamente mecanismos em vez de depender da memória. Ao mesmo tempo, Victor Taelin compartilhou uma compreensão simplificada da análise de terminabilidade de funções recursivas em Agda, fornecendo um método mais intuitivo para entender os conceitos centrais da programação funcional. (Fonte: Reddit r/MachineLearning, VictorTaelin)

💼 Negócios

Estratégias de comercialização de produtos de IA: Validação de demanda, melhoria de 10x e construção de fosso: Discutido o caminho crítico dos produtos de IA da demanda à comercialização. Enfatiza que a demanda deve ser validada (usuários já pagaram para resolver), o produto deve oferecer uma melhoria de 10x (em vez de otimização marginal) e construir um fosso (velocidade, efeito de rede, reconhecimento de marca) para combater a cópia. O cerne é encontrar um problema real e fornecer valor disruptivo, em vez de apenas inovação tecnológica. (Fonte: dotey)

Conjecture Institute recebe investimento de capital de risco: O Conjecture Institute anunciou que Mike Maples, Jr., sócio fundador da empresa de capital de risco Floodgate, se juntou como doador de prata. Este investimento apoiará a pesquisa e o desenvolvimento do Conjecture Institute no campo da IA, refletindo o interesse contínuo do mercado de capitais em instituições de pesquisa de IA de ponta. (Fonte: MoritzW42)

🌟 Comunidade

A essência da AI/AGI, reflexões filosóficas e ética do trabalho de dados: A comunidade discute a essência da AI/AGI, como a proposta de Elon Musk de que “AI é compressão e associação”, e o impacto da AI como uma “transição de fase” na inteligência terrestre. Ao mesmo tempo, controvérsias sobre a arquitetura MoE, os desafios que a AGI pode enfrentar em sociedades humanas complexas, e questões éticas de empresas de dados de IA e trabalho de dados também provocaram reflexões profundas. (Fonte: lateinteraction, Suhail, pmddomingos, SchmidhuberAI, Reddit r/ArtificialInteligence, menhguin)

Desenvolvimento da tecnologia de IA, desafios éticos e controvérsias na aplicação em áreas criativas: A conferência NeurIPS 2025 reuniu pesquisas de ponta em LLM, VLM, etc., mas a aplicação da IA na criação industrial, a questão da integridade de artigos gerados por LLM na academia, e a controvérsia sobre a autoria dos artigos prolíficos de Yoshua Bengio provocaram discussões éticas. Ao mesmo tempo, o papel da IA no campo criativo também gerou amplas controvérsias sobre eficiência versus criação tradicional e impacto no emprego. (Fonte: charles_irl, MiniMax__AI, dwarkesh_sp, giffmana, slashML, Reddit r/ChatGPT)

Impacto da IA nas profissões e na sociedade, e experiência de interação com modelos: Histórias pessoais demonstram como a IA ajuda pessoas sem experiência a conseguir empregos e o impacto da IA na indústria jurídica, provocando discussões sobre o efeito da IA no emprego e na transição de carreira. Ao mesmo tempo, as diferenças de “personalidade” entre diferentes modelos de IA (como ChatGPT e Grok) em cenários complexos, bem como o feedback “você está absolutamente correto” do modelo Claude e problemas de repetição na geração de imagens do Gemini Pro, também afetam a percepção dos usuários sobre a experiência de interação com a IA. (Fonte: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, Reddit r/artificial, Reddit r/ClaudeAI, Reddit r/OpenWebUI)

Qualidade do conteúdo da comunidade de IA, desafios de desenvolvimento e estratégias do usuário: A comunidade de IA expressa preocupação com o rápido crescimento de conteúdo de baixa qualidade gerado por IA (“AI slop”). Ao mesmo tempo, os usuários discutem os custos de hardware, desempenho e prós e contras de serviços hospedados para implantação local de LLM, bem como estratégias para lidar com as limitações de contexto do Claude, refletindo os desafios técnicos e problemas do ecossistema da comunidade enfrentados no desenvolvimento e uso da IA. (Fonte: Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/ClaudeAI, Reddit r/LocalLLaMA)

Desafios de suporte técnico e ambiente de aprendizagem na era da IA: A alta demanda por suporte técnico na comunidade, como problemas com o ambiente Colab GPU e a integração do Open WebUI com Stable Diffusion, reflete os desafios comuns de configuração de recursos computacionais e integração de ferramentas no aprendizado e desenvolvimento de IA. Ao mesmo tempo, o entusiasmo pela programação de kernel de GPU também demonstra um forte interesse em otimização de baixo nível e melhoria de desempenho. (Fonte: Reddit r/deeplearning, Reddit r/OpenWebUI, maharshii)

Aplicações práticas e experiência do usuário da IA em design de interiores/exteriores: A comunidade discute a aplicação prática da IA em design de interiores/exteriores. Um usuário compartilhou um caso de sucesso de uso de IA para projetar um telhado de pátio, acreditando que a IA pode gerar rapidamente soluções de design realistas. Ao mesmo tempo, há uma curiosidade geral sobre a implementação real e a experiência do usuário do design de IA. (Fonte: Reddit r/ArtificialInteligence)

A IA e a transformação digital exigem pensamento sistêmico: Em sistemas complexos de IA e ecossistemas digitais, é necessário entender a interação entre os componentes de uma perspectiva holística, em vez de ver os problemas isoladamente, para garantir que a tecnologia possa ser efetivamente integrada e alcançar o valor esperado. (Fonte: Ronald_vanLoon)

Geração de dados de treinamento de LLM e discussão do benchmark ARC-AGI: A comunidade discute se a equipe do Gemini 3 gerou uma grande quantidade de dados sintéticos para o benchmark ARC-AGI, e o significado disso para o progresso da AGI e o ARC Prize. Isso reflete a atenção contínua às fontes de dados de treinamento de LLM, à qualidade dos dados sintéticos e ao seu impacto na capacidade do modelo. (Fonte: teortaxesTex)

💡 Outros

Alunos do ensino fundamental usam IA para combater o problema da falta de moradia: Alunos do ensino fundamental no Texas estão usando a tecnologia de IA para explorar e desenvolver soluções para o problema local da falta de moradia. Este projeto demonstra o potencial da IA no campo do bem-estar social e a capacidade de cultivar a próxima geração para usar a tecnologia para resolver problemas práticos através da educação. (Fonte: kxan.com)