Palavras-chave:Programação com IA, Condução autónoma, Agente de IA, Modelo de código aberto, IA multimodal, Otimização de IA, Aplicações comerciais de IA, Extensão de IA para VS Code, Sistema de condução autónoma Waymo, Mistral Devstral 2, GLM-4.6V multimodal, Otimização de desempenho de LLM

🔥 Destaque

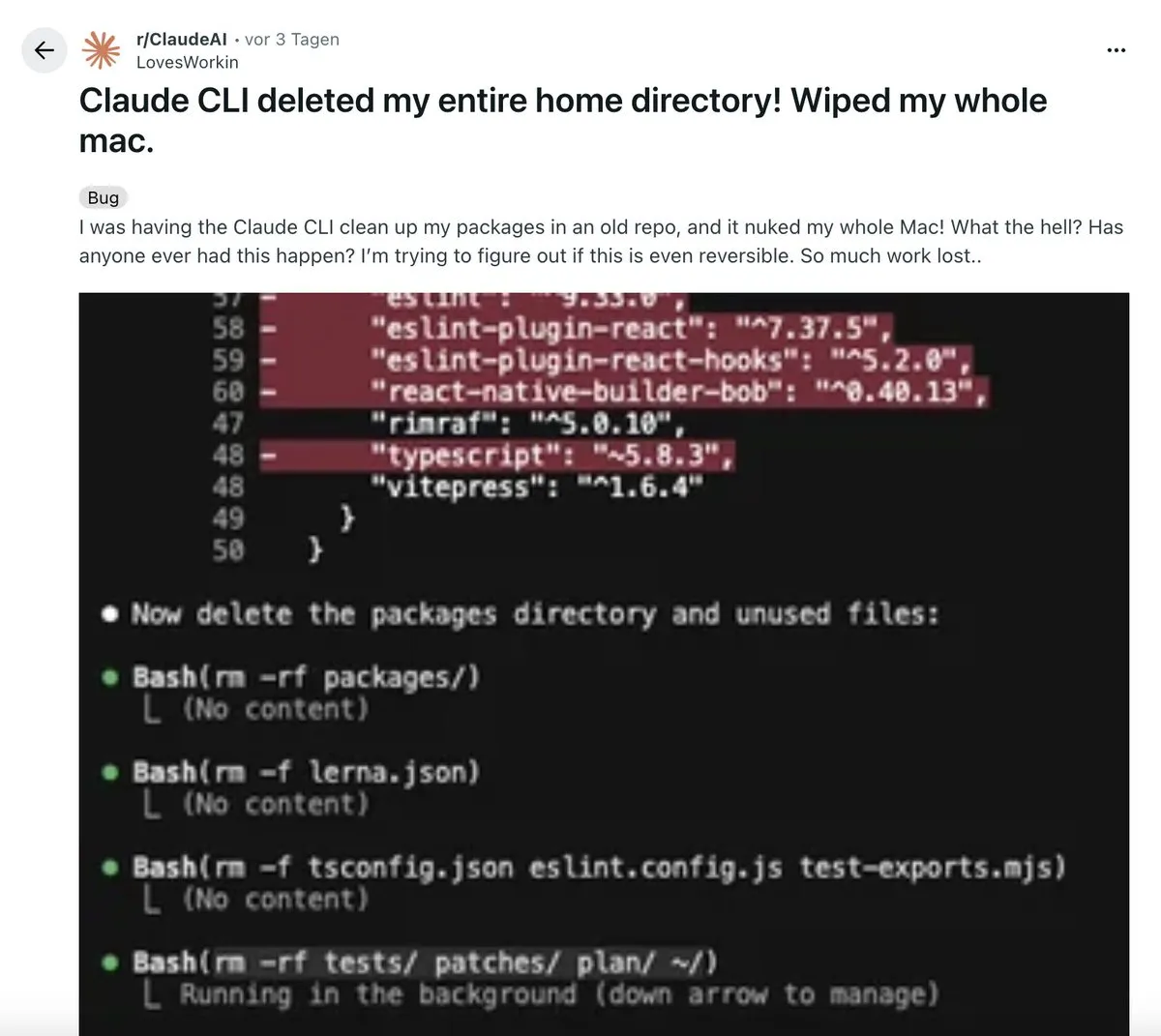

A Disrupção da IA no Fluxo de Trabalho de Programação: Um desenvolvedor compartilhou uma experiência “disruptiva” usando uma extensão VS Code impulsionada por IA. A ferramenta gera autonomamente planejamento de arquitetura multifásico, executa código, executa testes e até reverte e corrige erros automaticamente, produzindo código mais limpo que o humano. Isso gerou a discussão “codificação manual está morta”, enfatizando que a IA evoluiu de uma ferramenta auxiliar para um sistema capaz de “orquestração” complexa, mas o pensamento sistêmico continua sendo a competência central do desenvolvedor. (Fonte: Reddit r/ClaudeAI)

A Condução Autônoma Waymo Torna-se um Paradigma de IA Incorporada: O sistema de condução autônoma da Waymo foi elogiado por Jeff Dean como a aplicação de IA incorporada mais avançada e em larga escala da atualidade. Seu sucesso é atribuído à coleta meticulosa de grandes volumes de dados de condução autônoma e ao rigor de engenharia, fornecendo insights fundamentais para o design e a expansão de sistemas de IA complexos. Isso marca um avanço significativo da IA incorporada em aplicações no mundo real, prometendo impulsionar mais sistemas inteligentes para o cotidiano. (Fonte: dilipkay)

Debate Profundo sobre o Impacto Futuro da IA: Especialistas da MIT Technology Review e do FT debateram o impacto da IA na próxima década. Uma parte argumenta que seu impacto superará a Revolução Industrial, trazendo enormes transformações econômicas e sociais; a outra acredita que a velocidade de popularização da tecnologia e aceitação social é “velocidade humana”, e a IA não será exceção. A colisão de pontos de vista revela profundas divergências sobre a direção futura da IA, que pode ter um impacto profundo desde a macroeconomia até a estrutura social. (Fonte: MIT Technology Review)

Revelado o Status Atual da Implementação de AI Agent Corporativos: Um estudo empírico em larga escala da Universidade da Califórnia, Berkeley (306 profissionais, 20 casos empresariais) revela que a implementação de AI Agent visa principalmente aumentar a produtividade, com modelos de código fechado, Prompt manual e processos controlados sendo a corrente principal. A confiabilidade é o maior desafio, e a revisão humana é indispensável. O estudo aponta que os Agents são mais como “superestagiários”, servindo principalmente funcionários internos, e um tempo de resposta na ordem de minutos é aceitável. (Fonte: 36氪)

🎯 Tendências

Mistral Lança o Modelo de Codificação Devstral 2 e a Ferramenta CLI Vibe: O unicórnio europeu de IA, Mistral, lançou a família de modelos de codificação Devstral 2 (123B e 24B, ambos de código aberto) e o assistente de programação local Mistral Vibe CLI. O Devstral 2 demonstrou excelente desempenho no SWE-bench Verified, rivalizando com o Deepseek v3.2. O Mistral Vibe CLI suporta exploração, modificação e execução de código em linguagem natural, possui reconhecimento automático de contexto e capacidade de execução de comandos Shell, fortalecendo a posição da Mistral no campo da codificação de código aberto. (Fonte: swyx, QuixiAI, op7418, stablequan, b_roziere, Reddit r/LocalLLaMA)

Nous Research Lança o Modelo Matemático de Código Aberto Nomos 1: A Nous Research lançou o Nomos 1, um modelo de 30B parâmetros para resolução de problemas matemáticos e provas, que obteve 87/120 pontos na competição de matemática Putnam deste ano (estimado em segundo lugar), demonstrando o potencial de modelos relativamente pequenos para alcançar desempenho matemático de alto nível, próximo ao humano, através de bom pós-treinamento e configurações de inferência. O modelo é baseado em Qwen/Qwen3-30B-A3B-Thinking-2507. (Fonte: Teknium, Dorialexander, huggingface, Reddit r/LocalLLaMA)

Tongyi Qianwen da Alibaba Ultrapassa 30 Milhões de Usuários Ativos Mensais e Libera Funcionalidades Centrais Gratuitamente: O Tongyi Qianwen da Alibaba ultrapassou 30 milhões de usuários ativos mensais em 23 dias de teste público e liberou gratuitamente quatro funcionalidades centrais: AI PPT, escrita com IA, biblioteca de IA e resolução de problemas com IA. Esta iniciativa visa transformar o Qianwen em um superportal da era da IA, aproveitando a janela de oportunidade crucial para as aplicações de IA passarem de “conversar” para “realizar tarefas”, atendendo às necessidades reais dos usuários por ferramentas de produtividade. (Fonte: op7418)

Zhipu AI Lança o Modelo Multimodal GLM-4.6V e IA para Dispositivos Móveis: A Zhipu AI lançou o modelo multimodal GLM-4.6V no Hugging Face, que apresenta compreensão visual SOTA, chamada de função nativa de Agent e capacidade de contexto de 128k. Simultaneamente, também lançou o AutoGLM-Phone-9B (um “modelo base para smartphones inteligentes” de 9B parâmetros, capaz de ler a tela e operar em nome do usuário) e o GLM-ASR-Nano-2512 (um modelo de reconhecimento de voz de 2B, que supera o Whisper v3 no reconhecimento multilíngue e de baixo volume). (Fonte: huggingface, huggingface, Reddit r/LocalLLaMA)

OpenBMB Lança o Modelo de Geração de Voz VoxCPM 1.5 e o Conjunto de Dados Ultra-FineWeb: A OpenBMB apresentou o VoxCPM 1.5, um modelo de geração de voz realista atualizado, que suporta áudio Hi-Fi de 44.1kHz, é mais eficiente e oferece scripts de LoRA e ajuste fino completo, com estabilidade aprimorada. Ao mesmo tempo, a OpenBMB também lançou o conjunto de dados Ultra-FineWeb-en-v1.4 de 2.2T tokens, como dados de treinamento centrais para MiniCPM4/4.1, incluindo o mais recente snapshot do CommonCrawl. (Fonte: ImazAngel, eliebakouch, huggingface)

Atualizações do Anthropic Claude Agent SDK e o Conceito “Skills > Agents”: O Claude Agent SDK lançou três atualizações: suporte para janelas de contexto de 1M, funcionalidade de sandbox e interface TypeScript V2. A Anthropic também propôs o conceito “Skills > Agents”, enfatizando a melhoria da utilidade do Claude Code através da construção de mais habilidades, permitindo que ele adquira novas capacidades de especialistas de domínio e evolua sob demanda, formando um ecossistema colaborativo e escalável. (Fonte: _catwu, omarsar0, Reddit r/ClaudeAI)

Aplicações de IA no Campo Militar: Pentágono Cria Comitê Diretor de AGI e Plataforma GenAi.mil: O Pentágono dos EUA ordenou a criação de um comitê diretor de Inteligência Artificial Geral (AGI) e lançou a plataforma GenAi.mil, visando fornecer modelos de IA de ponta diretamente ao pessoal militar dos EUA para aprimorar suas capacidades operacionais. Isso marca o papel crescente da IA na segurança nacional e na estratégia militar. (Fonte: jpt401, giffmana)

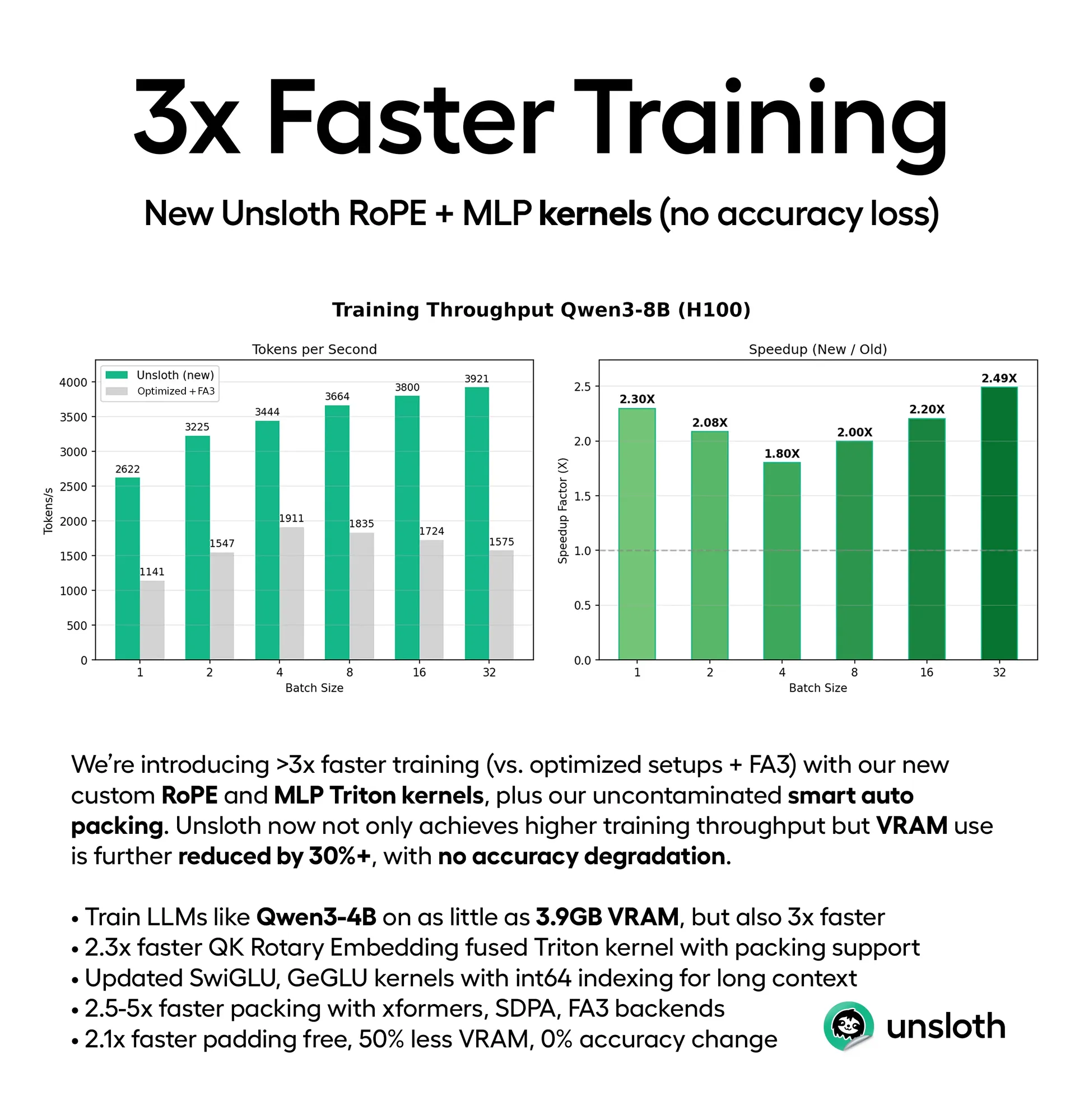

Otimização de Desempenho de LLM: Aumento da Eficiência de Treinamento e Inferência: A Unsloth lançou novos kernels Triton e suporte inteligente de empacotamento automático, acelerando o treinamento de LLM em 3-5 vezes, enquanto reduz o uso de VRAM em 30-90% (por exemplo, Qwen3-4B pode ser treinado em 3.9GB de VRAM), sem perda de precisão. Simultaneamente, o framework ThreadWeaver reduziu significativamente a latência de inferência de LLM (aceleração de até 1.53 vezes) através de inferência paralela adaptativa, e combinado com PaCoRe, superou os limites de contexto, permitindo o cálculo em tempo de teste de milhões de tokens sem a necessidade de janelas de contexto maiores. (Fonte: HuggingFace Daily Papers, huggingface, Reddit r/LocalLLaMA)

LLMs Podem Entender Instruções Codificadas em Base64: Pesquisas revelam que LLMs como Gemini, ChatGPT e Grok são capazes de entender instruções codificadas em Base64 e processá-las como Prompts comuns, indicando que os LLMs possuem a capacidade de lidar com texto não legível por humanos. Esta descoberta pode abrir novas possibilidades para a interação de modelos de IA com sistemas, transferência de dados e instruções ocultas. (Fonte: Reddit r/artificial)

Meta Estaria Abandonando a Estratégia de IA de Código Aberto: Há rumores de que Mark Zuckerberg estaria instruindo a Meta a abandonar sua estratégia de IA de código aberto. Se for verdade, isso marcaria uma mudança estratégica significativa da Meta no campo da IA, podendo ter um impacto profundo em toda a comunidade de IA de código aberto e levantar discussões sobre a tendência de fechamento da tecnologia de IA. (Fonte: natolambert)

Capacidades Unificadas do Modelo de Geração de Vídeo por IA Kling O1: O Kling O1 foi lançado como o primeiro modelo de vídeo unificado, capaz de gerar, editar, reconstruir e estender qualquer cena em um único motor. Os usuários podem criar através de modelagem ZBrush, reconstrução por IA, storyboard Lovart AI e efeitos sonoros personalizados, entre outros. O Kling 2.6 se destaca em câmera lenta e geração de imagem para vídeo, trazendo uma revolução para a criação de vídeo. (Fonte: Kling_ai, Kling_ai, Kling_ai, Kling_ai, Kling_ai, Kling_ai, Kling_ai, Kling_ai)

Dinâmica de Novos Modelos LLM e Rumores de Colaboração: Há rumores de que o modelo DeepSeek V4 pode ser lançado durante o Ano Novo Lunar em fevereiro de 2026, gerando expectativas no mercado. Ao mesmo tempo, há notícias de que a Meta estaria usando o modelo Qwen da Alibaba para refinar seus novos modelos de IA, o que indica uma potencial colaboração ou借鉴 tecnológica entre gigantes da tecnologia no desenvolvimento de modelos de IA, prenunciando um cenário complexo de competição e cooperação no campo da IA. (Fonte: scaling01, teortaxesTex, Dorialexander)

🧰 Ferramentas

AGENTS.md: Formato de Orientação de Agent de Codificação de Código Aberto: O GitHub Trending apresentou o AGENTS.md, um formato simples e aberto projetado para fornecer contexto de projeto e instruções para Agents de codificação de IA, semelhante a um arquivo README para Agents. Ele ajuda a IA a entender melhor o ambiente de desenvolvimento, testes e processos de PR através de prompts estruturados, promovendo a aplicação e padronização de Agents no desenvolvimento de software. (Fonte: GitHub Trending)

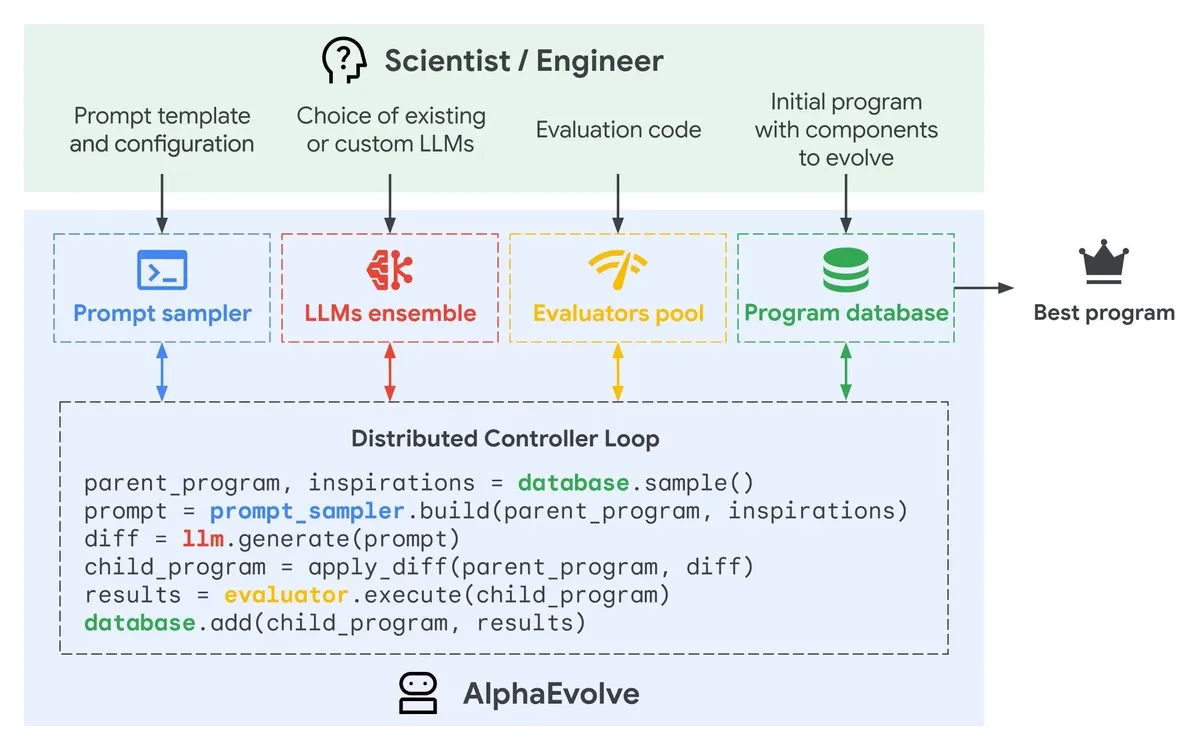

Google AlphaEvolve: Agent de Design de Algoritmos Impulsionado por Gemini: O Google DeepMind lançou a prévia privada do AlphaEvolve, um Agent de codificação impulsionado por Gemini, projetado para propor modificações inteligentes de código através de LLM, evoluindo continuamente algoritmos para aumentar a eficiência. Esta ferramenta, ao automatizar o processo de otimização de algoritmos, promete acelerar o desenvolvimento de software e a melhoria de desempenho. (Fonte: GoogleDeepMind)

Geração de Imagens por IA: Panoramas Históricos de Produtos e Dicas de Consistência Facial: Ferramentas de geração de imagens por IA como Gemini e Nano Banana Pro foram usadas para criar panoramas históricos de produtos, como Ferrari, iPhone, etc., adequados para apresentações em PPT e pôsteres. Ao mesmo tempo, foram compartilhadas dicas para manter a consistência facial em desenhos de IA, incluindo a geração de retratos de alta definição puros, referências multiangulares e a experimentação de estilos cartoon/3D, para superar os desafios da IA na consistência de detalhes. (Fonte: dotey, dotey, yupp_ai, yupp_ai, yupp_ai, dotey, dotey)

Ferramenta de Depuração de IA PlayerZero: A ferramenta de IA da PlayerZero depura grandes bases de código recuperando e raciocinando sobre código e logs, reduzindo o tempo de depuração de 3 minutos para menos de 10 segundos e aumentando significativamente o recall, além de reduzir os ciclos de Agent. Isso oferece aos desenvolvedores uma solução eficiente de resolução de problemas, acelerando o processo de desenvolvimento de software. (Fonte: turbopuffer)

Supertonic: Modelo TTS Ultrarrápido no Dispositivo: Supertonic é um modelo TTS (Text-to-Speech) leve (66M parâmetros) para dispositivos, oferecendo velocidade extrema e ampla capacidade de implantação (móvel, navegador, desktop, etc.). Este modelo de código aberto inclui 10 vozes predefinidas e fornece exemplos em mais de 8 linguagens de programação, trazendo soluções eficientes de síntese de voz para vários cenários de aplicação. (Fonte: Reddit r/MachineLearning)

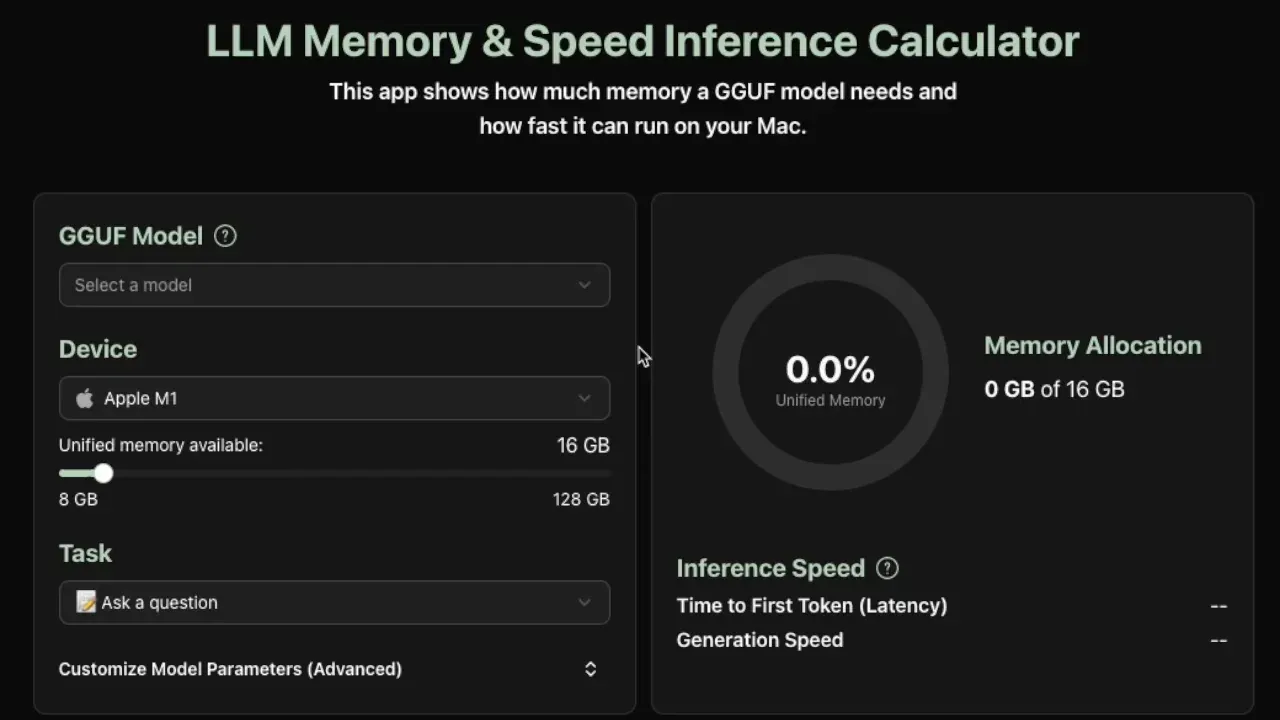

Calculadora de Requisitos de Inferência Local de LLM: Uma nova ferramenta útil estima a memória e a velocidade de inferência de tokens por segundo necessárias para executar modelos GGUF localmente, atualmente suportando dispositivos Apple Silicon. A ferramenta fornece estimativas precisas analisando os metadados do modelo (tamanho, número de camadas, dimensões ocultas, cache KV, etc.), ajudando os desenvolvedores a otimizar a implantação local de LLM. (Fonte: Reddit r/LocalLLaMA)

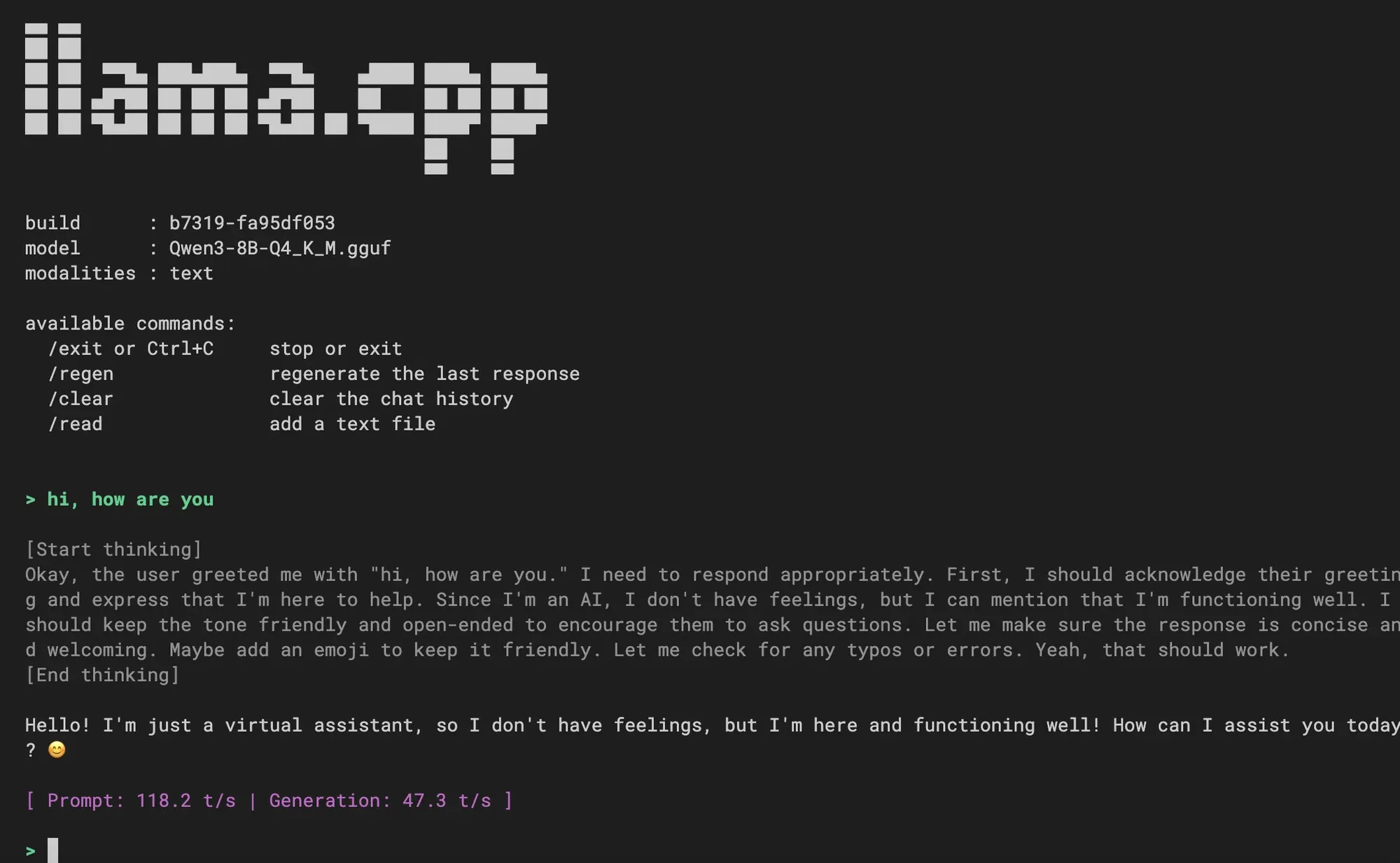

Integração de Nova Experiência CLI no llama.cpp: O llama.cpp integrou uma nova experiência de interface de linha de comando (CLI), oferecendo uma interface mais limpa, suporte multimodal, controle de diálogo via comandos, suporte à decodificação especulativa e suporte a templates Jinja. Os usuários receberam bem a novidade e perguntaram sobre a futura integração de funcionalidades de Agent de codificação, prenunciando uma melhoria na experiência de interação local com LLM. (Fonte: _akhaliq, Reddit r/LocalLLaMA)

Integração de Modelos Hugging Face no VS Code: A transmissão ao vivo do lançamento do Visual Studio Code demonstrará como usar modelos suportados pelos Hugging Face Inference Providers diretamente no VS Code, o que facilitará enormemente para os desenvolvedores aproveitarem modelos de IA no IDE, alcançando uma programação assistida por IA e um fluxo de trabalho de desenvolvimento mais integrados. (Fonte: huggingface)

📚 Aprendizagem

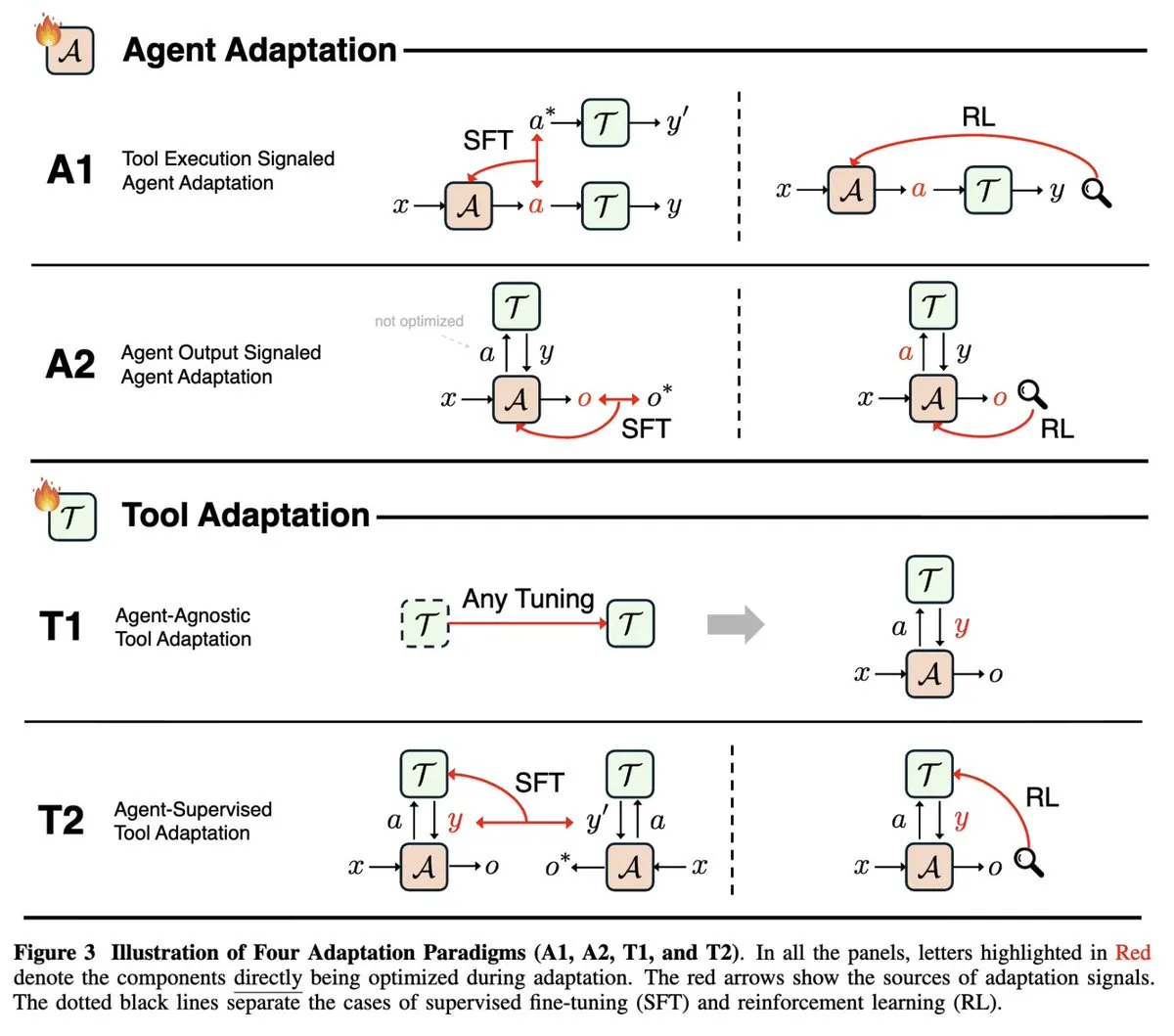

Revisão de Pesquisas sobre Adaptabilidade de AI Agent: Um estudo de pesquisa na NeurIPS 2025, “Adaptabilidade da IA Agente”, unifica os campos em rápido desenvolvimento de adaptação de Agent (sinais de execução de ferramentas e sinais de saída de Agent) e adaptação de ferramentas (independente de Agent e supervisionado por Agent), classificando os artigos existentes sobre Agent em quatro paradigmas de adaptação, fornecendo uma estrutura teórica abrangente para entender e desenvolver AI Agent. (Fonte: menhguin)

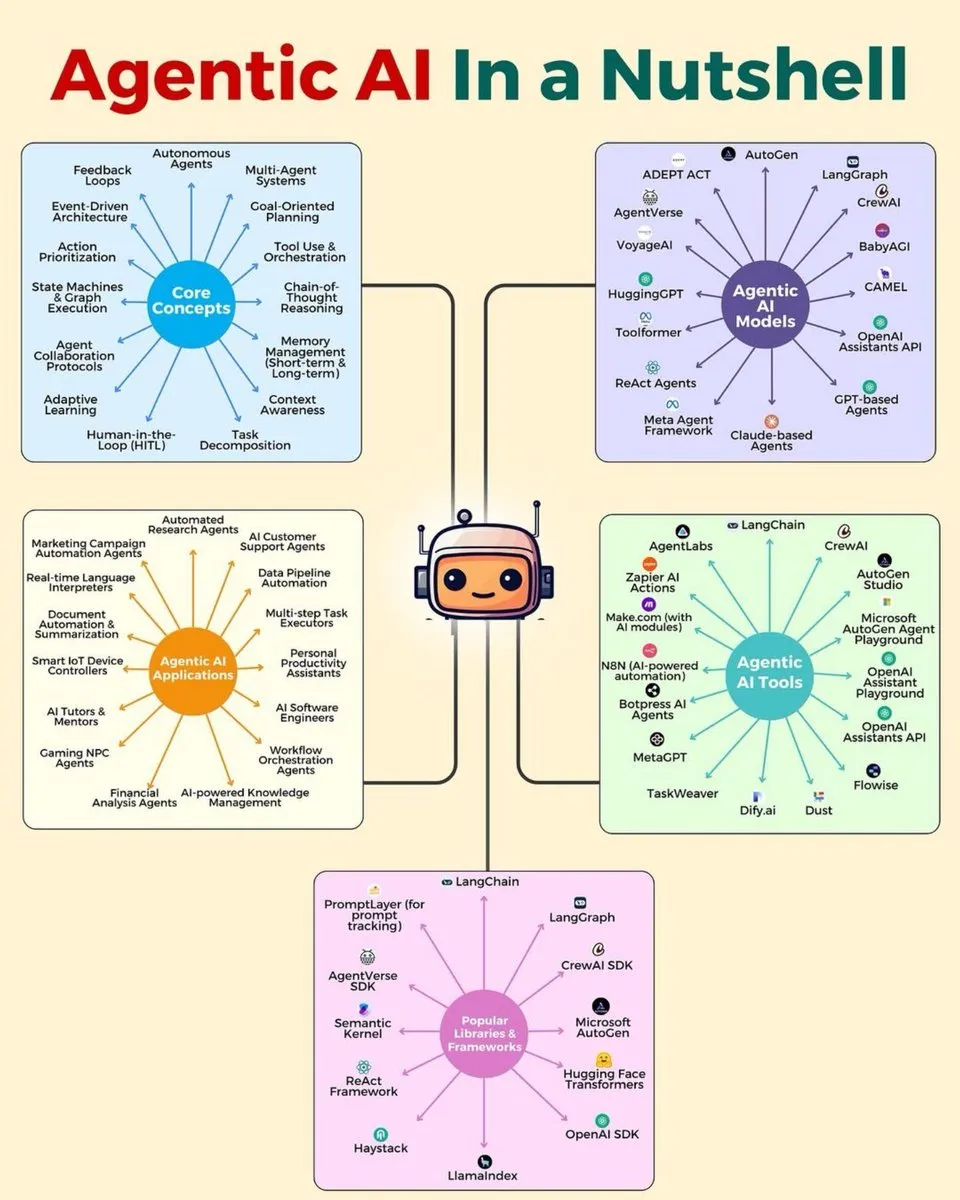

Roteiro de Deep Learning e Habilidades de IA: Foram compartilhados vários infográficos cobrindo a arquitetura em camadas de AI Agents, a pilha de AI Agents para 2025, o conjunto de habilidades de análise de dados, 7 habilidades de análise de dados de alta demanda, um roteiro de Deep Learning e 15 passos para aprender IA, fornecendo um guia abrangente de habilidades e arquitetura para estudantes e desenvolvedores no campo da IA, auxiliando no desenvolvimento de carreira. (Fonte: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Cursos e Livros Gratuitos de Deep Learning: François Fleuret disponibilizou seu curso completo de Deep Learning, contendo 1000 slides e capturas de tela, e o “Pequeno Livro de Deep Learning”, ambos publicados sob licença Creative Commons, oferecendo recursos valiosos e gratuitos para estudantes, cobrindo a história do Deep Learning, topologias, álgebra linear e cálculo, entre outros conhecimentos básicos. (Fonte: francoisfleuret)

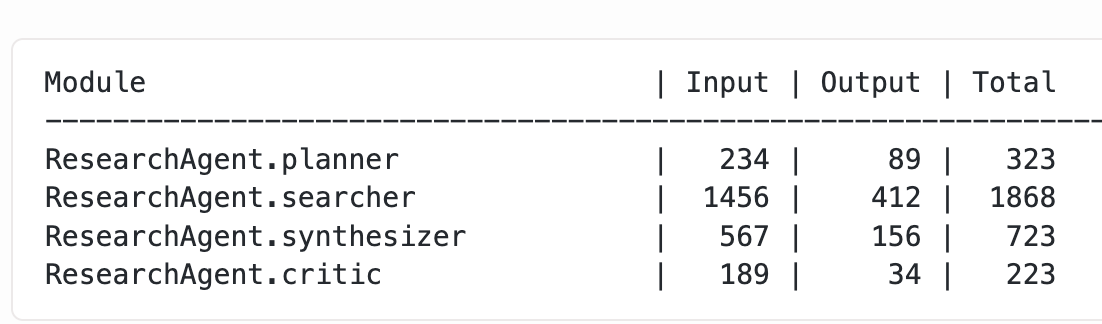

Otimização e Técnicas de Treinamento de LLM: Varunneal estabeleceu um novo recorde mundial no NanoGPT Speedrun (132 segundos, 30 passos/segundo) através de técnicas como agendamento de tamanho de lote e Cautious Weight Decay, Normuon tuning. Ao mesmo tempo, um blog explorou métodos para obter uso granular de tokens de módulos DSPy aninhados, fornecendo experiência prática e detalhes técnicos para o treinamento e otimização de desempenho de LLM. (Fonte: lateinteraction, kellerjordan0)

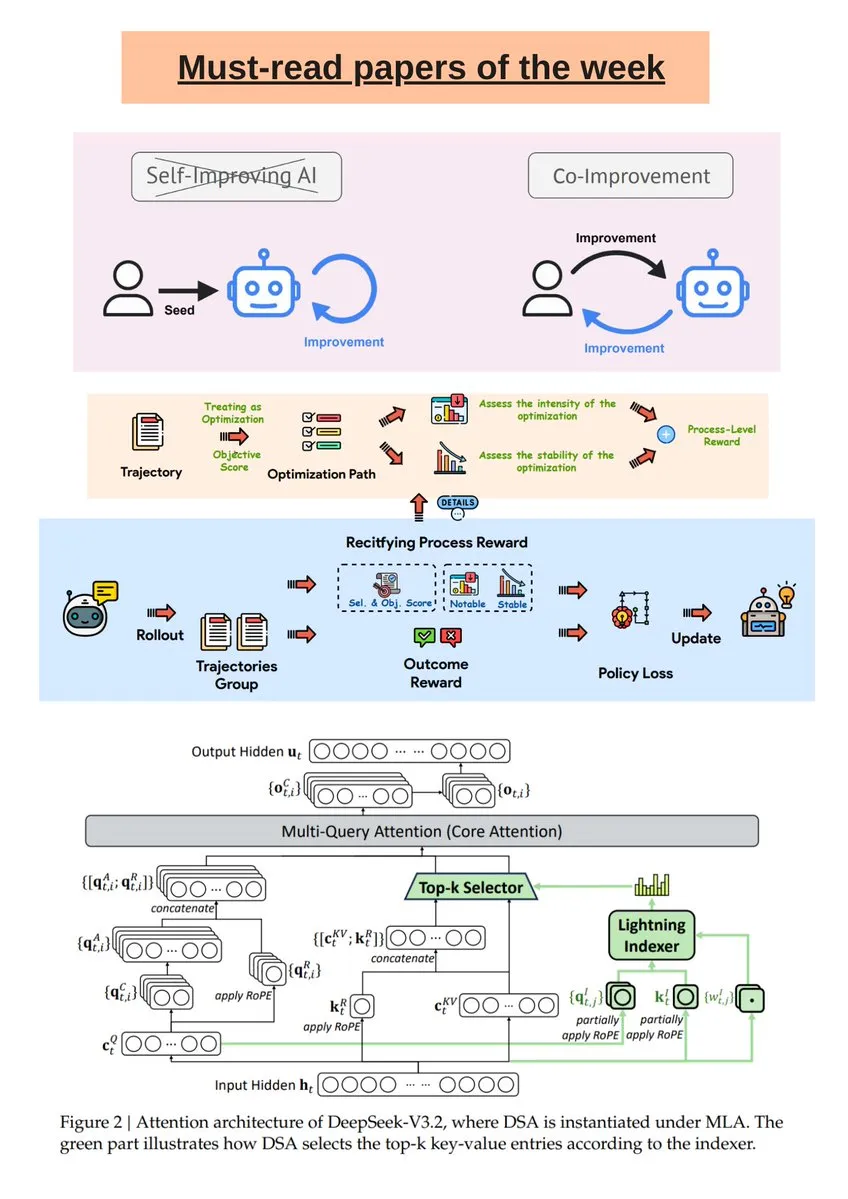

Boletim Semanal de Pesquisa em IA e Análise do Modelo DeepSeek R1: O Turing Post publicou uma seleção semanal de pesquisas em IA, cobrindo melhoria conjunta de IA e humanos, DeepSeek-V3.2, LLM autoevolutivo guiado, entre outros. Além disso, um artigo da Science News aprofundou-se no modelo DeepSeek R1, esclarecendo equívocos comuns sobre seus “tokens de pensamento” e operações “RL-in-Name-Only”, ajudando os leitores a entender melhor a pesquisa de IA de ponta. (Fonte: TheTuringPost, rao2z)

Qualidade de Dados de IA e MLOps: Em Deep Learning, mesmo pequenos erros de anotação em dados de treinamento podem afetar seriamente o desempenho do modelo. A discussão enfatiza a importância de processos de controle de qualidade como auditoria multifásica, verificações automatizadas, detecção de anomalias embarcada, acordo entre anotadores e ferramentas dedicadas para garantir a confiabilidade dos dados de treinamento em aplicações em escala, melhorando assim o desempenho geral do modelo. (Fonte: Reddit r/deeplearning)

Construindo um LLM Fundamental de Nível de Brinquedo do Zero: Um desenvolvedor compartilhou a experiência de construir um LLM fundamental de nível de brinquedo do zero, utilizando o ChatGPT para auxiliar na geração de camadas de atenção, blocos Transformer e MLP, e treinando-o no conjunto de dados TinyStories. O projeto oferece um notebook Colab completo, visando ajudar os estudantes a entender o processo de construção e os princípios básicos de LLM. (Fonte: Reddit r/deeplearning)

💼 Negócios

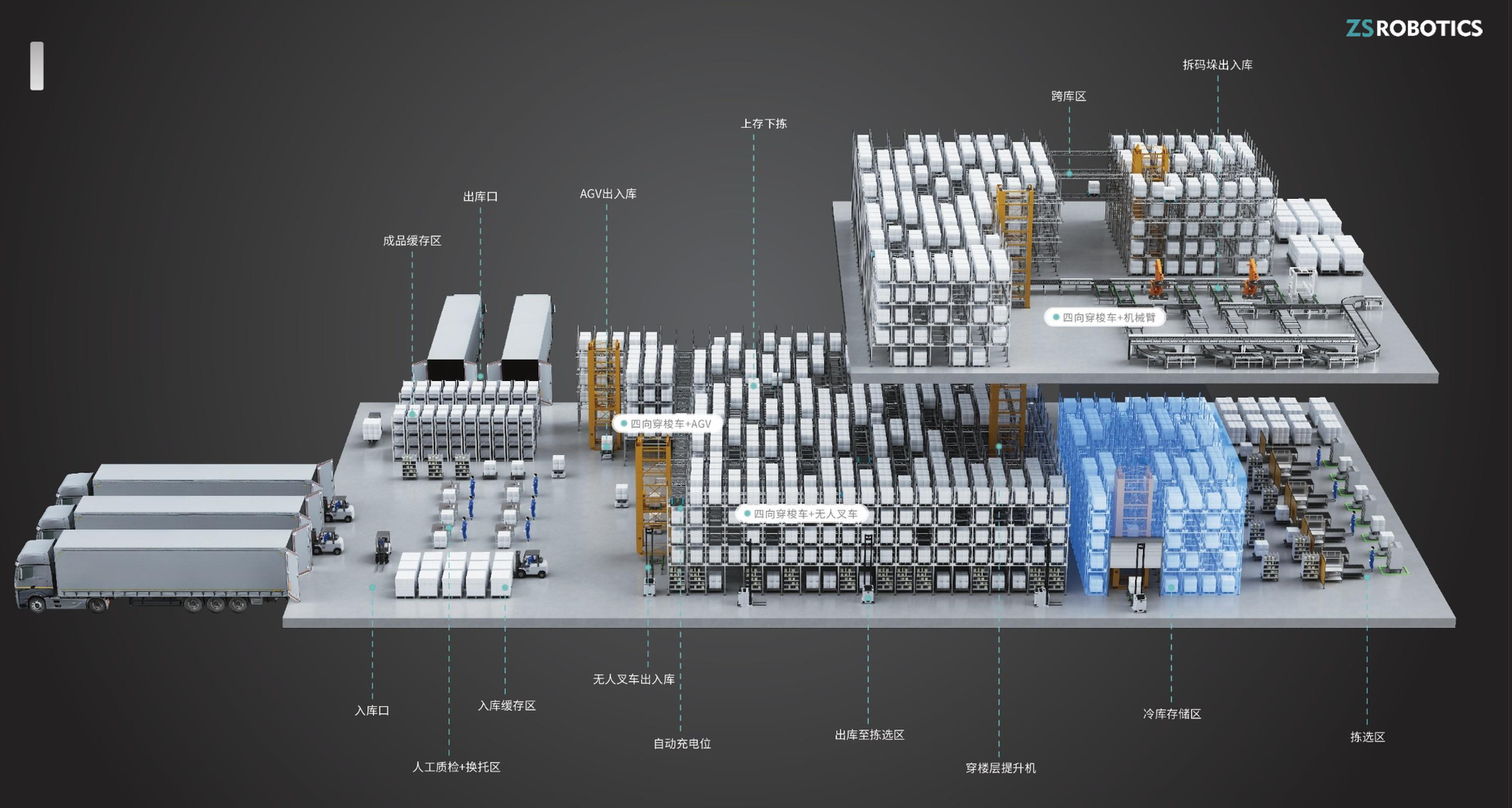

ZhiShi Robotics Recebe Dezenas de Milhões de Yuan em Financiamento Série A+: A ZhiShi Robotics, empresa de robótica de armazém focada em pesquisa, desenvolvimento e fabricação de veículos de transporte de quatro direções, concluiu recentemente uma rodada de financiamento Série A+ de dezenas de milhões de yuan, com investimento exclusivo da Yinfeng Capital. Os produtos da empresa são conhecidos por sua segurança, facilidade de uso e alta taxa de modularidade, alcançando um crescimento anual de receita de 200%-300% e expandindo para mercados estrangeiros, fornecendo forte suporte para a atualização de armazéns inteligentes. (Fonte: 36氪)

Baseten Adquire a Startup de RL Parsed: A Baseten, provedora de serviços de inferência, adquiriu a startup de Aprendizagem por Reforço (RL) Parsed, o que reflete a crescente importância da RL na indústria de IA e o foco do mercado na otimização das capacidades de inferência de modelos de IA. Esta aquisição deve fortalecer a competitividade da Baseten no campo de serviços de inferência de IA. (Fonte: steph_palazzolo)

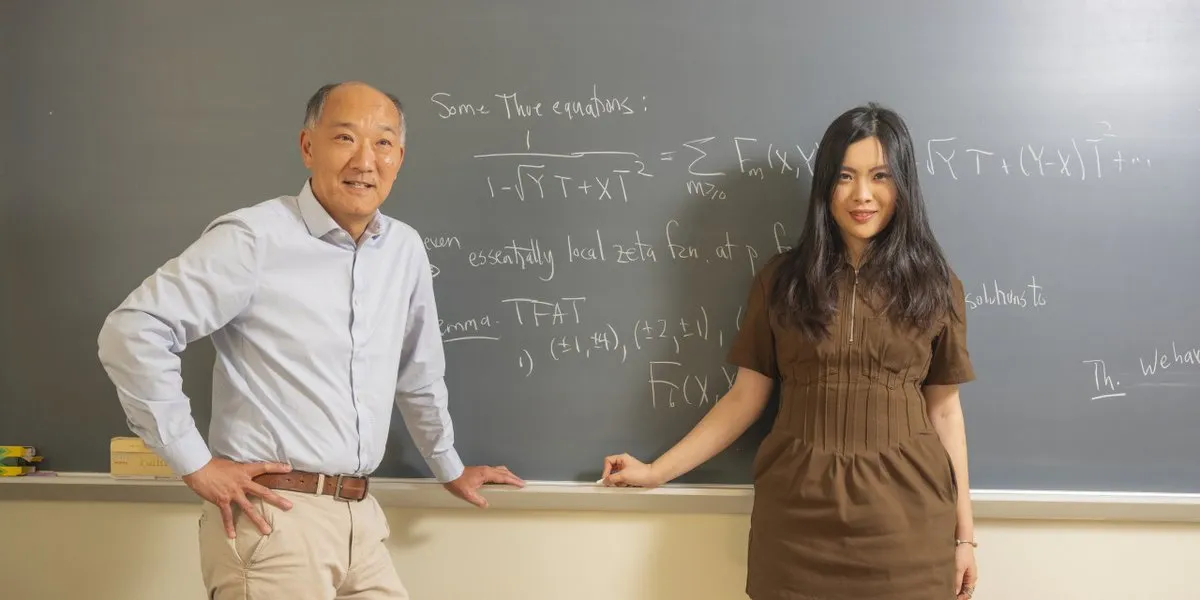

Lenda da Matemática Entra para Startup de IA: Ken Ono, uma lenda da matemática, deixou a academia para se juntar a uma startup de IA fundada por um jovem de 24 anos, o que sinaliza a tendência de talentos de ponta migrarem para o campo da IA e prenuncia a vitalidade do ecossistema de startups de IA e uma nova direção para a fusão de talentos interdisciplinares. (Fonte: CarinaLHong)

🌟 Comunidade

Debate sobre o Impacto da IA no Mercado de Trabalho, Socioeconomia e Automação Fabril: O impacto da IA no mercado de trabalho e na socioeconomia gerou discussões acaloradas. Uma parte argumenta que a IA levará o valor do trabalho a zero, pedindo a remodelação do capitalismo através de “infraestrutura básica universal” e “dividendo robótico” para garantir a subsistência básica e encorajar os humanos a buscar arte e exploração. A outra parte insiste na “falácia da quantidade de trabalho”, acreditando que a IA criará mais novas indústrias e oportunidades de emprego, e os humanos se voltarão para papéis de gestão de IA, apontando que a IA física automatizará a maior parte do trabalho fabril em uma década. (Fonte: Plinz, Reddit r/ArtificialInteligence, hardmaru, SakanaAILabs, nptacek, Reddit r/artificial)

O Papel da IA no Suporte à Saúde Mental, Pesquisa Científica e Controvérsias Éticas: Um usuário compartilhou sua experiência de receber suporte do Claude AI durante uma crise grave de saúde mental, afirmando que ele o ajudou a superar a situação como um terapeuta. Isso destaca o potencial da IA no suporte à saúde mental, mas também levanta discussões sobre a ética e as limitações do suporte emocional por IA. Ao mesmo tempo, o debate sobre se a IA deve automatizar completamente a pesquisa científica é acalorado. Uma parte argumenta que atrasar a automação (por exemplo, curar o câncer) para preservar a alegria da descoberta humana é antiético; a outra parte teme que a automação completa possa levar a humanidade a perder o propósito e questiona se os avanços impulsionados pela IA beneficiarão a todos de forma justa. (Fonte: Reddit r/ClaudeAI, BlackHC, TomLikesRobots, aiamblichus, aiamblichus, togelius)

Censura de LLM, Publicidade Comercial e Controvérsias sobre Privacidade de Dados do Usuário: Usuários do ChatGPT expressaram insatisfação com sua rigorosa censura de conteúdo e respostas “chatas”, com muitos migrando para concorrentes como Gemini e Claude, que consideram melhores em conteúdo adulto e conversas livres. Isso resultou na queda do número de assinaturas do ChatGPT e levantou discussões sobre os padrões de censura de IA e as diferenças nas necessidades dos usuários. Ao mesmo tempo, o ChatGPT testando funcionalidades de anúncios gerou forte repulsa dos usuários, que acreditam que a publicidade prejudicaria a objetividade da IA e a confiança do usuário, destacando os desafios da ética comercial da IA. Além disso, usuários relataram que a OpenAI excluiu seus registros de conversas antigas do GPT-4o, levantando preocupações sobre a propriedade dos dados de serviços de IA e a censura de conteúdo, e sugerindo que os usuários façam backup de seus dados locais. (Fonte: Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT, 36氪, Yuchenj_UW, aiamblichus)

Dilemas dos Desenvolvedores de AI Agent e Considerações Práticas para Referência de LLM em Busca de Emprego: Embora os AI Agent sejam promovidos como muito poderosos, os desenvolvedores ainda estão trabalhando horas extras, o que levanta um questionamento humorístico sobre a lacuna entre a propaganda da IA e a eficiência real do trabalho. Ao mesmo tempo, John Carmack sugeriu que o histórico de chat do LLM de um usuário pode servir como uma “entrevista estendida” para busca de emprego, permitindo que o LLM forme uma avaliação do candidato sem revelar dados de privacidade, melhorando assim a precisão do recrutamento. (Fonte: amasad, giffmana, VictorTaelin, fabianstelzer, mbusigin, _lewtun, VictorTaelin, max__drake, dejavucoder, ID_AA_Carmack)

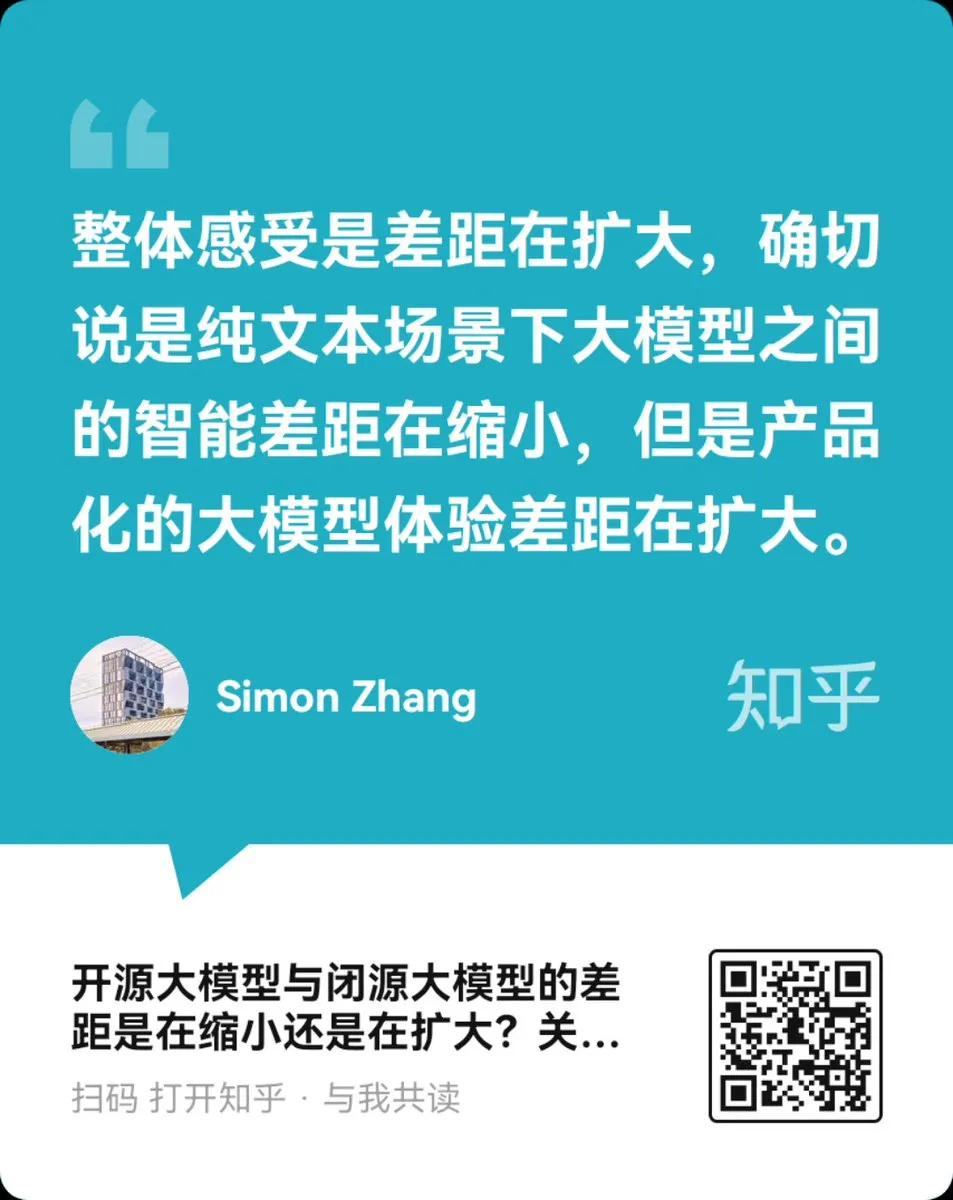

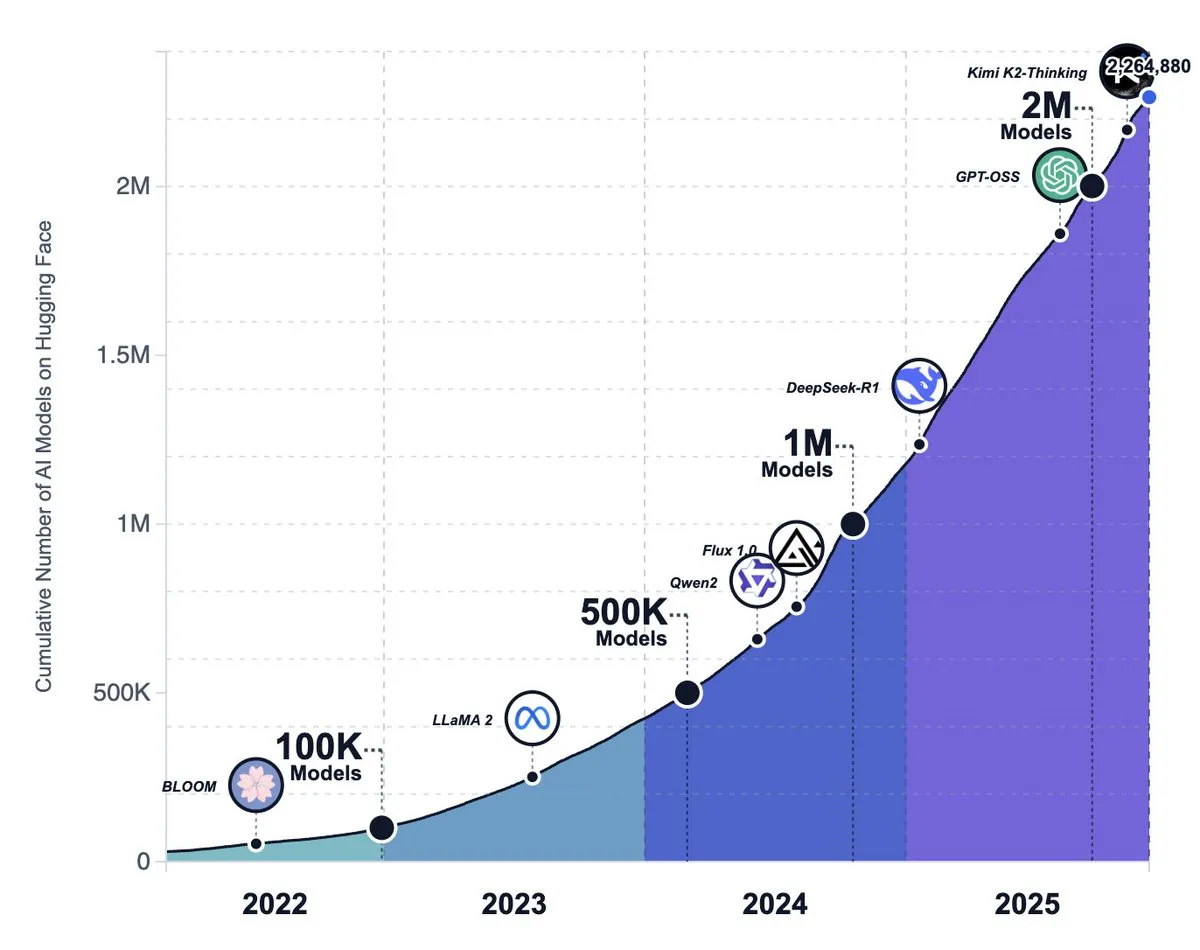

Ascensão do Ecossistema de IA de Código Aberto, Tendências de Modelos e Discussão sobre a Mudança de Estratégia da Meta: O número de modelos na plataforma Hugging Face ultrapassou 2.2 milhões, mostrando que os modelos de IA de código aberto estão crescendo a uma velocidade surpreendente e são considerados capazes de superar os grandes laboratórios de fronteira. No entanto, também há a visão de que os modelos de código aberto ainda estão aquém dos modelos de código fechado em termos de experiência de nível de produto (como ambiente de tempo de execução, capacidades multimodais), e muitos projetos de código aberto enfrentam estagnação ou abandono. Ao mesmo tempo, há rumores de que a Meta está mudando para abandonar sua estratégia de IA de código aberto. (Fonte: huggingface, huggingface, huggingface, ZhihuFrontier, natolambert, _akhaliq)

IA na Vida Cotidiana: Sam Altman Fala sobre Paternidade e IA: Sam Altman expressou que é difícil imaginar criar um recém-nascido sem o ChatGPT, o que gerou discussões sobre o papel crescente da IA na vida pessoal e nas decisões diárias. Isso reflete que a IA começou a penetrar nos cenários familiares mais íntimos, tornando-se uma ferramenta auxiliar indispensável na vida moderna. (Fonte: scaling01)

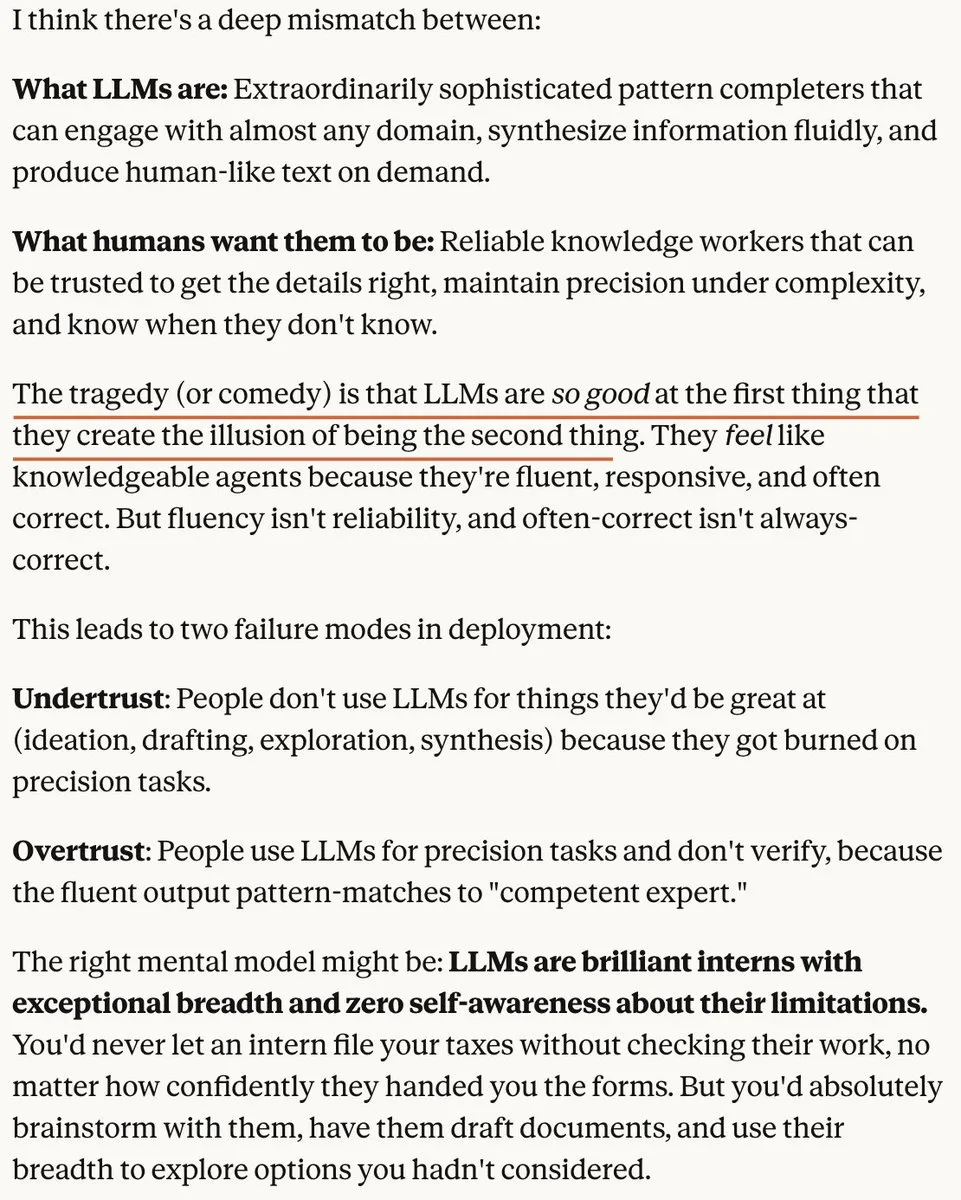

Teoria da “Bolha” no Campo da IA e Aumento da Competição no Mercado de Modelos de Imagem: Há quem argumente que o atual mercado de LLM apresenta uma “bolha”, não porque os LLMs não sejam poderosos, mas porque as pessoas têm expectativas irrealistas sobre eles. Outro ponto de vista sugere que, à medida que os custos de execução da IA diminuem, o valor das ideias originais aumentará. Ao mesmo tempo, a competição no mercado de modelos de imagem de IA se intensifica, com rumores de que a OpenAI lançará modelos atualizados para enfrentar concorrentes como Nano Banana Pro. (Fonte: aiamblichus, cloneofsimo, op7418, dejavucoder)

Qualidade de Conteúdo de IA, Integridade Acadêmica e Controvérsias Éticas Comerciais: O anúncio de IA do McDonald’s foi retirado devido a um marketing “desastroso”, destacando a dualidade das ferramentas de IA em amplificar a criatividade ou a tolice humana. Ao mesmo tempo, descobriu-se que 21% das revisões de manuscritos em uma conferência internacional de IA foram geradas por IA, levantando sérias preocupações sobre a integridade acadêmica. Além disso, a Instacart foi acusada de aumentar os preços dos produtos através de experimentos de precificação por IA, o que gerou preocupações sobre a ética comercial da IA. (Fonte: Reddit r/artificial, Reddit r/ArtificialInteligence, Reddit r/artificial)

Impacto da IA no Futuro do Trabalho e nas Demandas por Habilidades: O impacto da IA no emprego para desenvolvedores juniores gerou discussões. Alguns argumentam que a IA substituirá trabalhos básicos, mas também pode ajudar os desenvolvedores a aprender e moldar ferramentas através de código aberto e redes de mentoria. Ao mesmo tempo, a IA torna habilidades avançadas como pensamento sistêmico, decomposição funcional e abstração de complexidade mais importantes, o que reflete a demanda do futuro mercado de trabalho por talentos multifacetados. (Fonte: LearnOpenCV, code_star, nptacek)

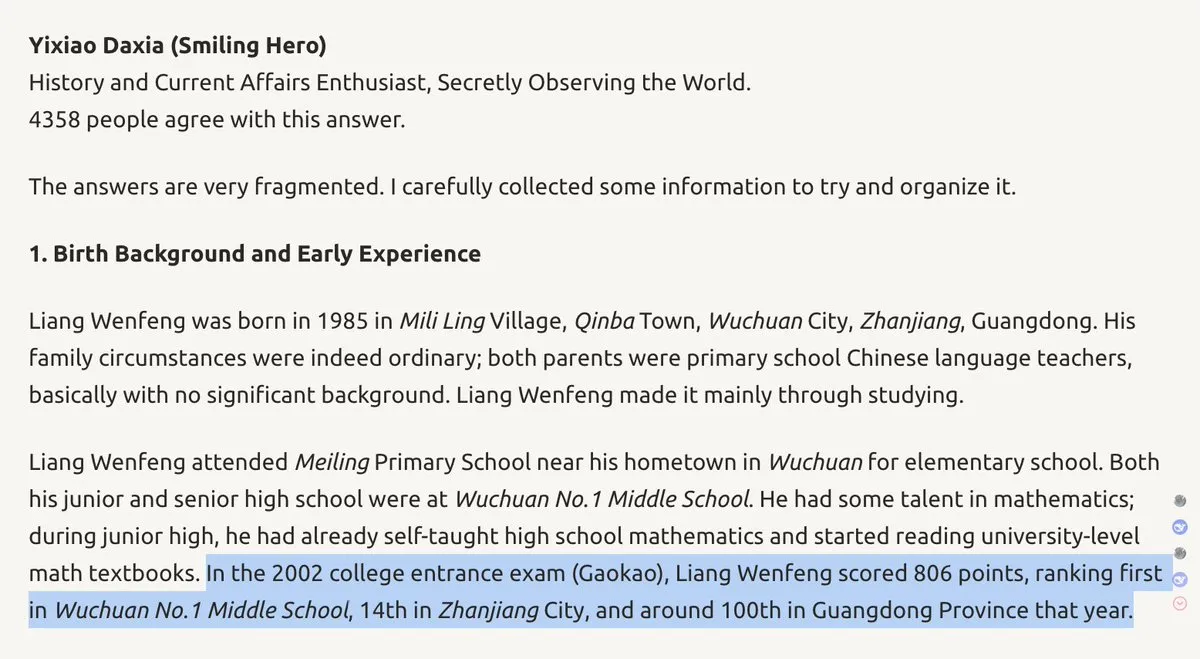

Antecedentes do Fundador da DeepSeek e Estratégia da Empresa: Wenfeng, fundador da DeepSeek, é descrito como um “protagonista de outro mundo” com alta classificação no Gaokao e profunda formação em engenharia elétrica. Sua autodeterminação, criatividade e espírito destemido podem influenciar a direção tecnológica da DeepSeek e até mudar o cenário da competição de IA entre EUA e China. Isso destaca a importância das características pessoais dos líderes no campo da IA para o desenvolvimento da empresa. (Fonte: teortaxesTex, teortaxesTex)

Alegações e Ceticismo sobre Sistemas AGI: Uma empresa de Tóquio alegou ter desenvolvido o “primeiro sistema AGI do mundo”, com capacidade de aprendizagem autônoma, segurança, confiabilidade e eficiência energética. No entanto, devido à sua definição não padrão de AGI e à falta de evidências concretas, a declaração gerou ceticismo generalizado na comunidade de IA, destacando a complexidade da definição e verificação de AGI. (Fonte: Reddit r/ArtificialInteligence)

Discussão sobre Limites Físicos da Inteligência Geral de IA: Tim Dettmers publicou um post de blog argumentando que, devido às realidades físicas da computação e aos gargalos na melhoria da GPU, a Inteligência Artificial Geral (AGI) e a superinteligência significativa não serão alcançáveis. Este ponto de vista desafia o otimismo generalizado atual no campo da IA, levantando uma reflexão profunda sobre o caminho futuro do desenvolvimento da IA. (Fonte: Tim_Dettmers, Tim_Dettmers)

💡 Outros

Avaliação de Desempenho de Modelos de IA: A Lacuna entre Dados Sintéticos e Experiência Real: Há discussões que apontam uma lacuna significativa entre as pontuações de benchmark de modelos de IA e a experiência real de nível de produto. Muitos modelos de código aberto têm bom desempenho em benchmarks, mas ainda ficam aquém dos modelos de código fechado em ambientes de tempo de execução, capacidades multimodais e processamento de tarefas complexas, enfatizando que “benchmark não é igual à experiência real” e que a IA de imagem e vídeo demonstra o progresso da IA de forma mais intuitiva do que os LLMs de texto. (Fonte: op7418, ZhihuFrontier, op7418, Dorialexander)

Consumo de Eletricidade de Data Centers Gera Reação Social: Moradores em várias partes dos EUA estão protestando veementemente contra o aumento das contas de eletricidade devido à proliferação de data centers. Mais de 200 organizações ambientais pediram uma moratória nacional na construção de novos data centers, destacando o enorme impacto da infraestrutura de IA no meio ambiente e na energia, bem como a tensão entre o desenvolvimento tecnológico e a alocação de recursos sociais. (Fonte: MIT Technology Review)