Ключевые слова:LLM-JEPA, Apple Manzano, MediaTek Dimensity 9500, GPT-5, DeepSeek-V3.1-Terminus, Qwen3-Omni, Baidu Qianfan-VL, Фреймворк для обучения в пространстве вложений, Гибридный визуальный токенизатор, Архитектура с двойным NPU, Бенчмарк SWE-BENCH PRO, Мультимодальный аудиовход

🔥 В центре внимания

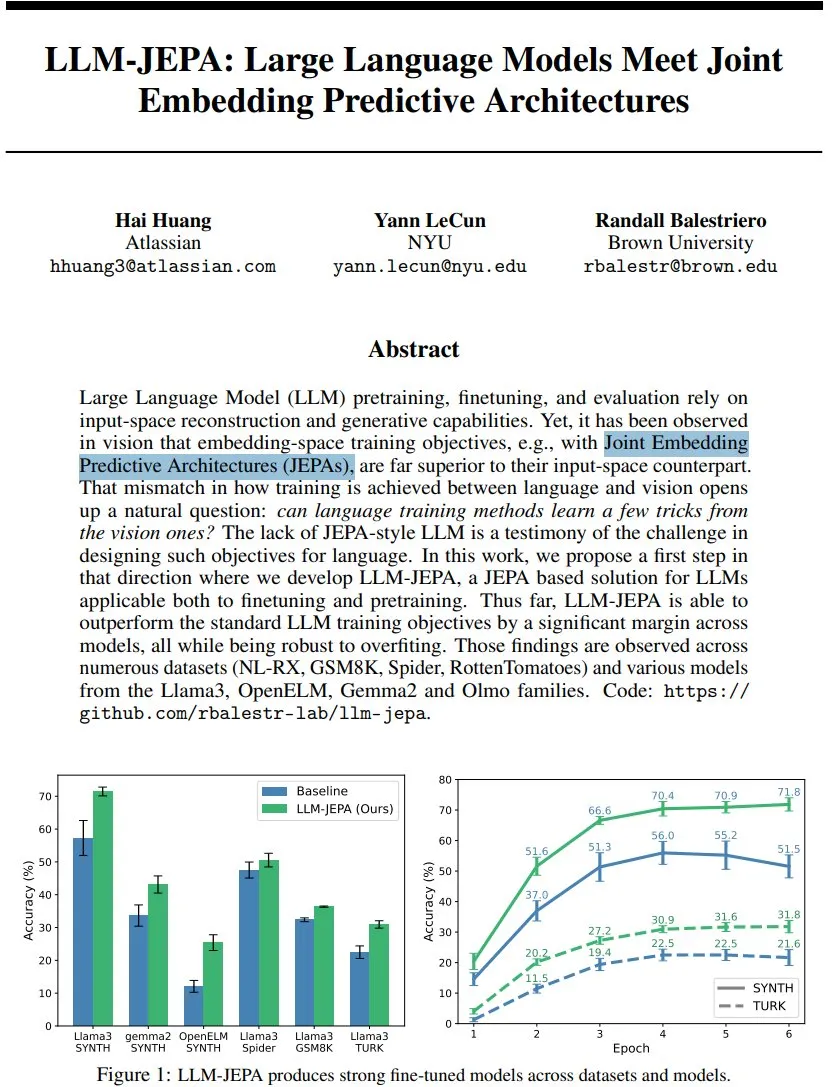

LLM-JEPA: Новый прорыв в фреймворке обучения языковых моделей: Ян ЛеКун (Yann LeCun) и его коллеги представили LLM-JEPA — первый фреймворк для обучения языковых моделей в стиле JEPA, который объединяет цели встраивания пространства из области зрения с целями генерации естественного языка. Этот фреймворк превзошел стандартные цели LLM в нескольких бенчмарках, таких как NL-RX, GSM8K, Spider, и показал хорошие результаты на моделях Llama3, OpenELM. Он более устойчив к переобучению, эффективен как при предварительном обучении, так и при тонкой настройке, что предвещает, что обучение в пространстве встраивания может стать следующим большим скачком для LLM. (Источник: ylecun, ylecun)

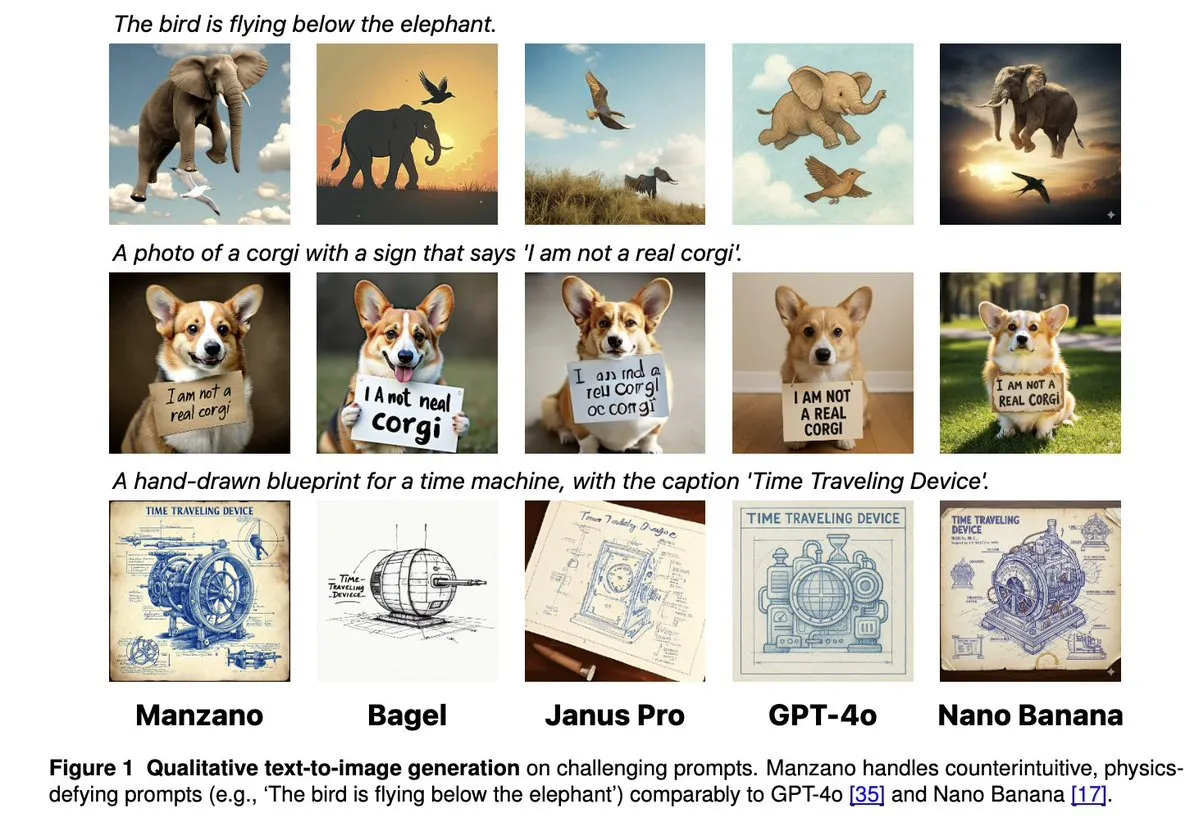

Apple Manzano: Простое и масштабируемое решение для унифицированных мультимодальных LLM: Apple выпустила Manzano, простую и масштабируемую унифицированную мультимодальную большую языковую модель. Модель использует гибридный визуальный токенизатор, который эффективно снижает конфликты между задачами понимания и генерации изображений. Manzano достигает уровня SOTA в бенчмарках с интенсивным использованием текста (таких как ChartQA, DocVQA) и конкурирует с GPT-4o/Nano Banana по возможностям генерации, поддерживая редактирование с помощью условных изображений, демонстрируя мощный потенциал мультимодального ИИ. (Источник: arankomatsuzaki, charles_irl, vikhyatk, QuixiAI, kylebrussell)

MediaTek Dimensity 9500 выпущен с двойной архитектурой NPU для улучшения активного опыта AI: MediaTek представила чип Dimensity 9500, впервые внедрив двойную архитектуру NPU с ультравысокой производительностью и ультравысокой энергоэффективностью, направленную на реализацию постоянного интеллектуального опыта AI “Always on”. Этот чип занимает первое место в рейтинге мобильных SoC AI ETHZ, повышая эффективность вывода на 56% по сравнению с предыдущим поколением, и поддерживает генерацию изображений в разрешении 4K на устройстве, а также окно контекста 128K, закладывая аппаратную основу для реагирования в реальном времени и персонализированных услуг мобильного AI, продвигая AI от “вызываемого” к “постоянно активному”. (Источник: 量子位)

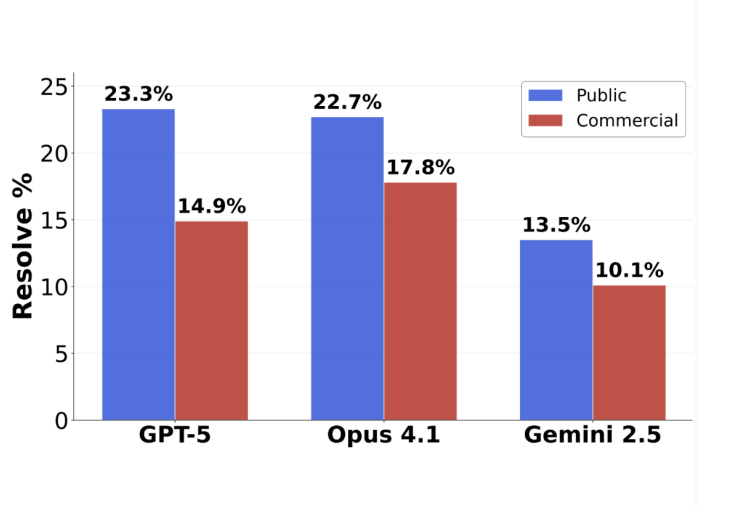

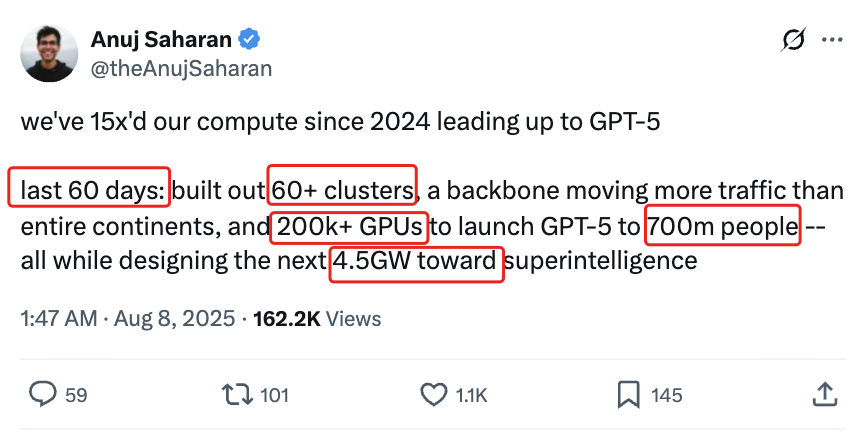

Разворот в оценке программирования GPT-5: Фактическая точность выполнения задач достигает 63,1%: Новый бенчмарк по программной инженерии SWE-BENCH PRO, выпущенный Scale AI, показывает, что GPT-5 достигает точности 63,1% в выполненных задачах, что значительно превосходит 31% у Claude Opus 4.1. Это указывает на то, что его производительность в областях, в которых он силен, остается высокой. Новый бенчмарк использует новые задачи и сложные сценарии модификации нескольких файлов, что более реалистично проверяет фактические навыки программирования модели. Он выявляет, что текущие топовые модели все еще сталкиваются с проблемами в задачах программной инженерии промышленного уровня, но фактические возможности GPT-5 недооцениваются при стратегии “если умеет, то делает, если нет, то не отправляет”. (Источник: 36氪)

🎯 Тенденции

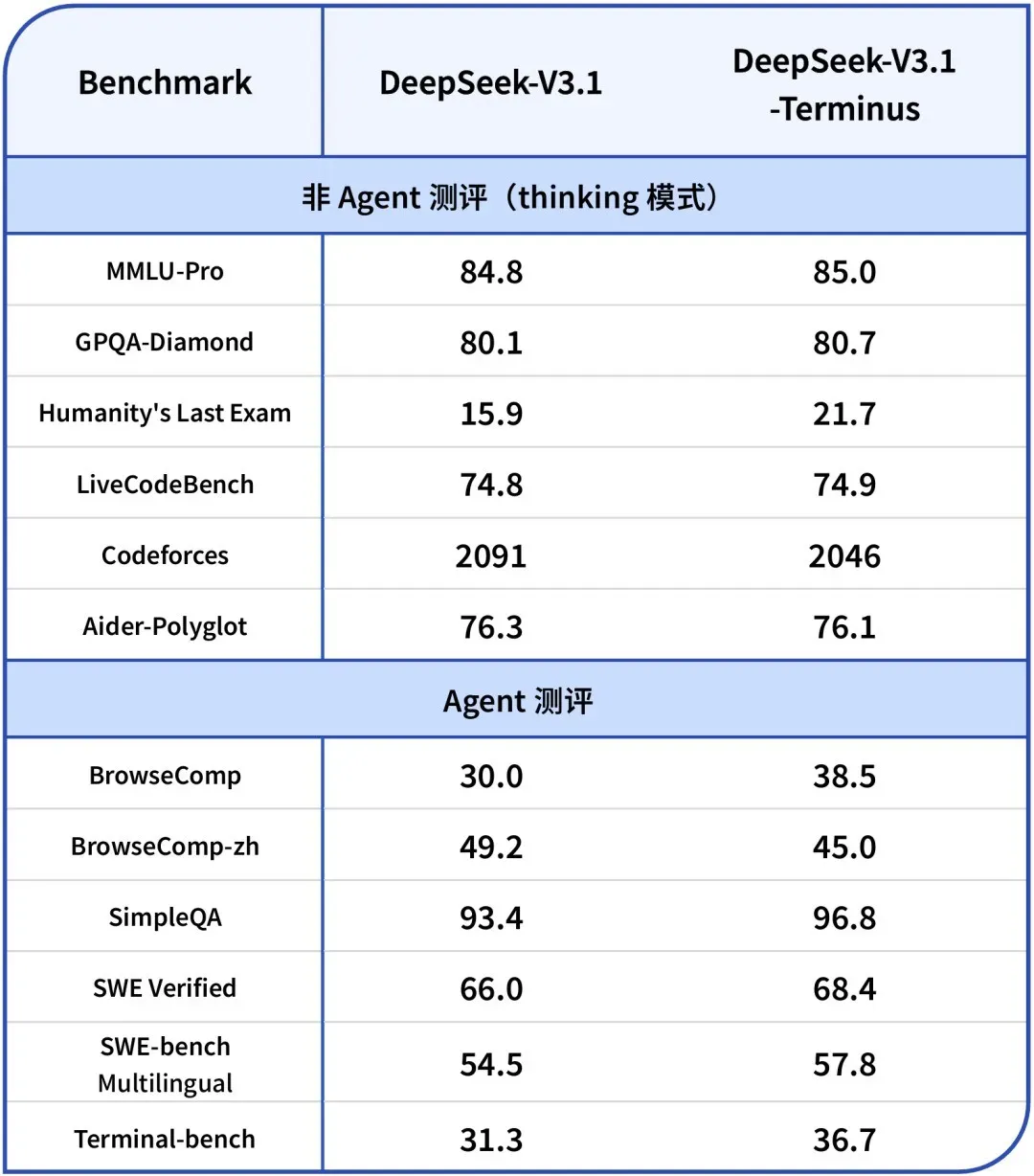

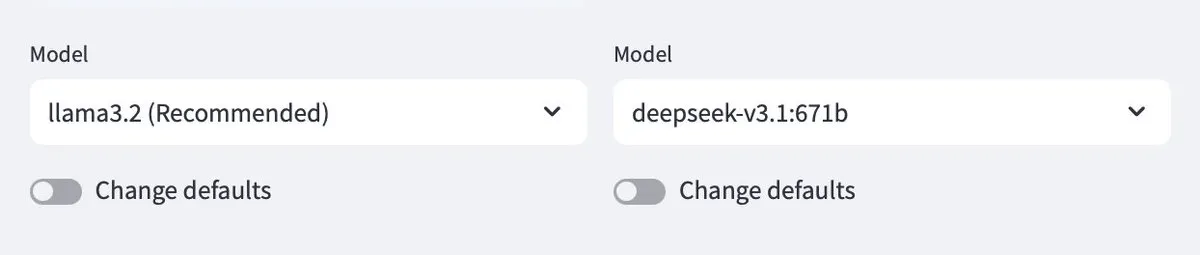

DeepSeek-V3.1-Terminus выпущен: Оптимизация языковой согласованности и возможностей Agent: DeepSeek выпустил версию V3.1-Terminus, в которой основное внимание уделяется улучшению языковой согласованности (уменьшение смешения китайского и английского языков, а также аномальных символов) и оптимизации производительности Code Agent и Search Agent. Новая модель демонстрирует более стабильный и надежный вывод в многодоменных тестах, а ее открытые веса уже доступны на Hugging Face и ModelScope, что предвещает окончательное совершенствование архитектуры серии V3 от DeepSeek. (Источник: DeepSeek Blog, Reddit r/LocalLLaMA, scaling01, karminski3, ben_burtenshaw, dotey)

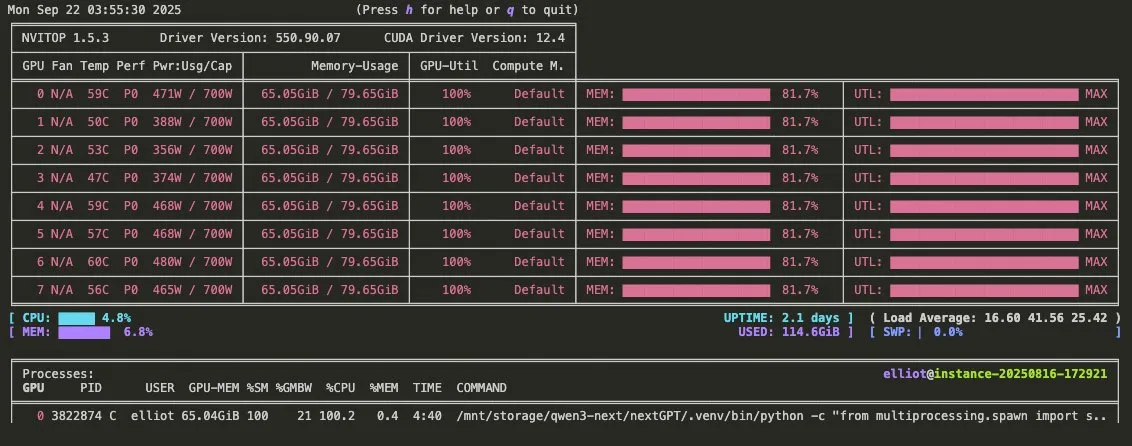

Выпущен рекламный ролик Qwen3-Omni: Поддержка мультимодального аудио и вызова инструментов: Qwen выпустил рекламный ролик Qwen3-Omni, анонсирующий поддержку мультимодального аудиовхода и вывода, а также встроенную возможность вызова инструментов. Эта модель обещает стать прямым конкурентом Gemini 2.5 Flash Native Audio, предлагая режимы мышления и немышления, значительно повышая потенциал для создания голосовых Agent. Ее веса скоро будут выпущены. (Источник: Reddit r/LocalLLaMA, scaling01, Alibaba_Qwen, huybery)

Baidu открывает исходный код мультимодальных больших языковых моделей серии Qianfan-VL: Baidu AI Cloud открывает исходный код мультимодальных больших языковых моделей серии Qianfan-VL (3B, 8B, 70B), оптимизированных для корпоративных приложений. Модели сочетают визуальный кодировщик InternViT с расширенным многоязычным корпусом, обеспечивают длину контекста 32K, превосходно справляются с OCR, пониманием документов, анализом диаграмм и решением математических задач, а также поддерживают цепочку рассуждений, стремясь предоставить мощные общие возможности и глубокую оптимизацию для высокочастотных сценариев в отрасли. (Источник: huggingface, Reddit r/LocalLLaMA)

xAI выпускает модель Grok 4 Fast: Окно контекста 2M, высокая экономическая эффективность: xAI представила модель Grok 4 Fast, мультимодальную модель вывода с окном контекста 2M, призванную установить новый стандарт высокой экономической эффективности. Эта версия, вероятно, реализует быстрый вывод с помощью таких технологий, как квантование FP8, и оптимизирует возможности Agentic программирования, что позволяет ей сочетать производительность и экономичность при решении сложных задач. (Источник: TheRundownAI, Yuhu_ai_)

GPT-5-Codex: OpenAI выпускает версию GPT-5, оптимизированную для Agentic программирования: OpenAI выпустила GPT-5-Codex, оптимизированную версию GPT-5, специально предназначенную для Agentic программирования. Эта модель призвана улучшить производительность ИИ в задачах генерации кода и программной инженерии, что соответствует тенденциям развития Agentic рабочих процессов и мультимодальных LLM, и, благодаря расширенным возможностям программирования, будет способствовать дальнейшему применению ИИ в области разработки. (Источник: TheRundownAI, Reddit r/artificial)

Платформа разработки интеллектуальных Agent Tencent 3.0 запущена по всему миру, ключевые технологии Youtu Lab продолжают быть открытыми: Платформа разработки интеллектуальных Agent Tencent Cloud 3.0 (ADP3.0) запущена по всему миру, предлагая комплексные обновления в областях RAG, Multi-Agent координации, Workflow, оценки приложений и экосистемы плагинов. Youtu Lab Tencent продолжит открывать ключевые технологии Agent, включая фреймворк Youtu-Agent и фреймворк графов знаний Youtu-GraphRAG, с целью содействия технологической инклюзивности и открытому совместному созданию экосистемы Agent, позволяя предприятиям с низким порогом создавать, интегрировать и эксплуатировать свои собственные AI Agent. (Источник: 量子位)

Baidu Wenku снова получает сертификацию Национального центра информационной безопасности и лидирует в индустрии интеллектуальных PPT: Baidu Wenku занял первое место в оценке больших моделей для интеллектуального офиса Национального центра информационной безопасности, лидируя по всем шести показателям, включая качество генерации, понимание намерений и эстетику макета. Его функция интеллектуальных PPT предоставляет комплексное решение, с более чем 97 миллионами ежемесячных активных пользователей AI и более чем 34 миллионами ежемесячных посещений, что укрепляет его лидирующие позиции в области интеллектуальных PPT и предоставляет пользователям профессиональный, точный и эстетичный опыт создания PPT. (Источник: 量子位)

Google DeepMind представляет Frontier Safety Framework для борьбы с новыми рисками AI: Google DeepMind выпустила свой новейший “Frontier Safety Framework”, который является самым комплексным подходом на сегодняшний день, направленным на выявление и опережение новых рисков AI. Этот фреймворк подчеркивает ответственную разработку моделей AI, стремясь обеспечить, чтобы по мере роста возможностей AI меры безопасности также масштабировались для решения сложных задач, которые могут возникнуть в будущем. (Источник: GoogleDeepMind)

Развитие человекоподобных роботов и систем автоматизации: Улучшение взаимодействия и стабильности: Робототехника продолжает развиваться, включая выпуск RoboForce промышленного человекоподобного робота Titan, платформу ALLEX от WIROBOTICS, обеспечивающую человекоподобное взаимодействие с тактильным ощущением, естественным движением и встроенным балансом, а также робота Unitree G1, демонстрирующего режим “антигравитации” для повышения стабильности. Кроме того, роботоферма Hitbot демонстрирует автоматизированную систему сбора урожая, а автономные мобильные транспортные роботы также подчеркивают дизайн, ориентированный на сотрудничество человека и машины, совместно продвигая переход роботов от вычислений к восприятию мира. (Источник: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Unitree)

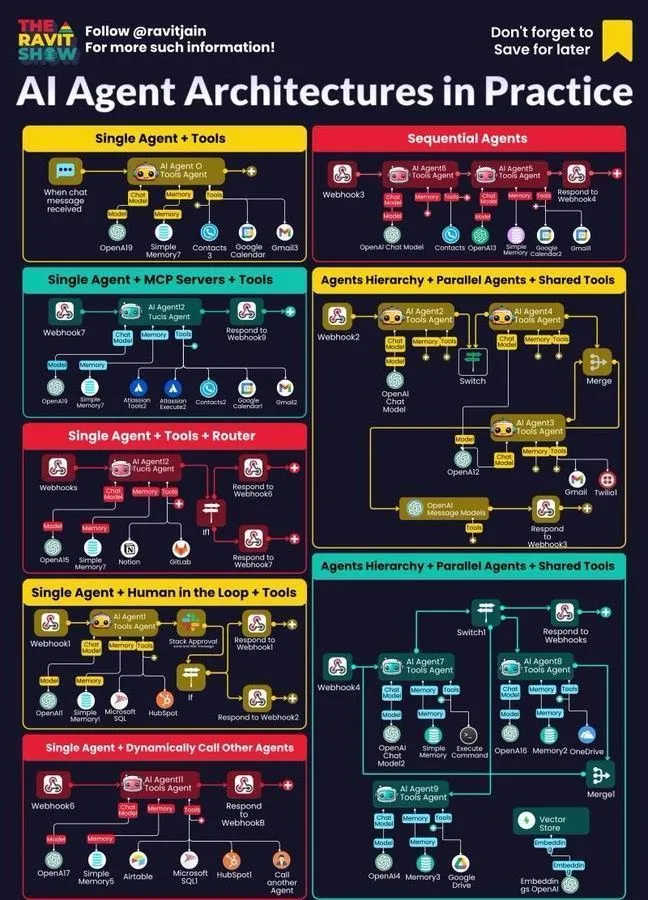

AI Agent становится ядром корпоративных рабочих процессов: Архитектура, карта, практическое применение: AI Agent быстро становится ядром корпоративных рабочих процессов, и его архитектурный дизайн, карта экосистемы и практическое применение привлекают широкое внимание. Нейросимвольный AI рассматривается как потенциальное решение проблемы галлюцинаций LLM, в то время как имитационные исследования Anthropic указывают на то, что модели AI могут представлять внутреннюю угрозу, что подчеркивает возможности и вызовы Agentic AI в корпоративном развертывании и побуждает компании исследовать более безопасные методы. (Источник: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

🧰 Инструменты

Ollama поддерживает облачные модели, обеспечивая взаимодействие между локальными и облачными моделями: Ollama теперь поддерживает развертывание моделей в облаке, позволяя пользователям взаимодействовать между локальными моделями Ollama и моделями, размещенными в облаке. Эта функция реализуется через приложение Minions, что дает пользователям большую гибкость в управлении и использовании их ресурсов LLM, предоставляя бесшовный опыт как при локальном запуске, так и при доступе через облачные сервисы. (Источник: ollama)

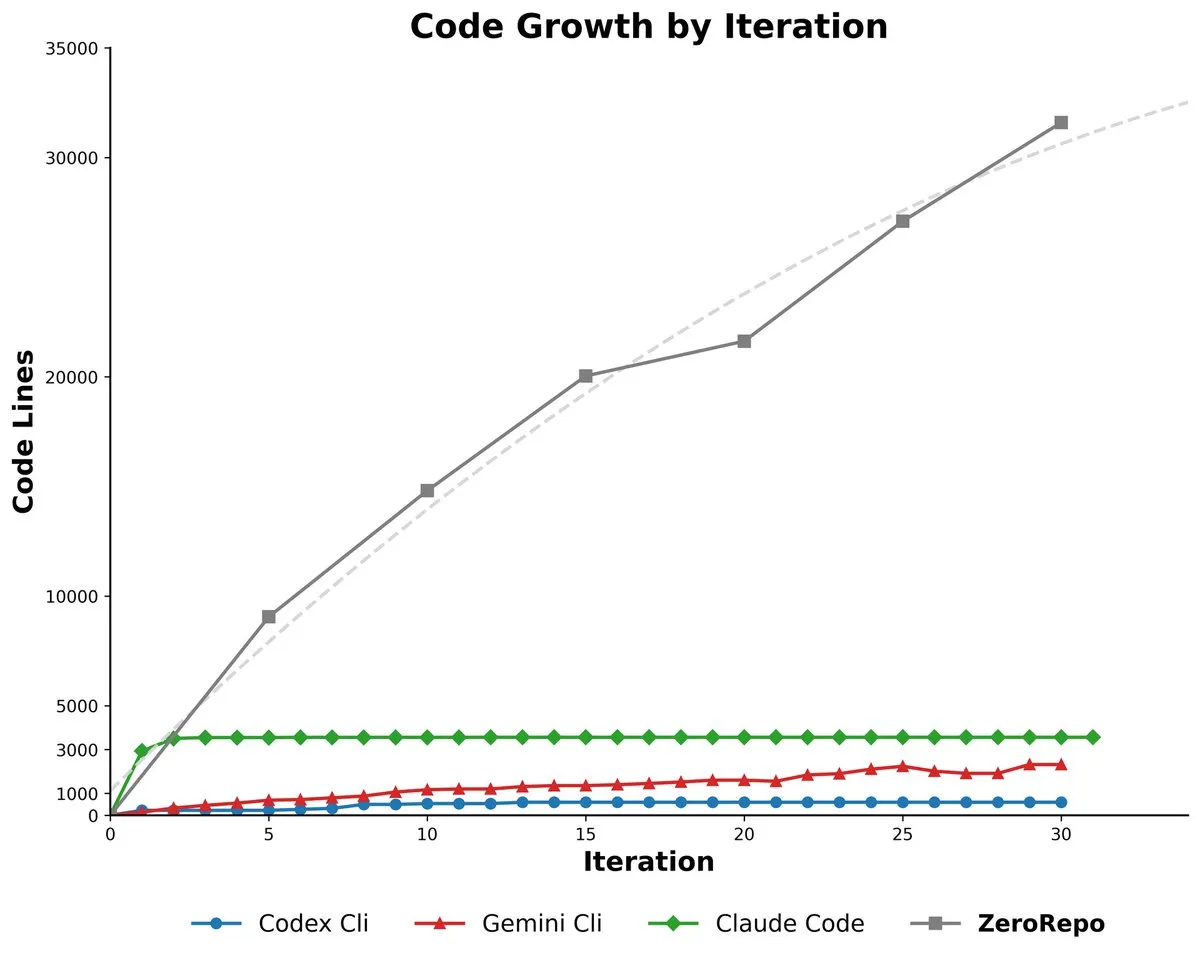

Microsoft ZeroRepo: Генерация полных кодовых баз на основе графоориентированного фреймворка: Microsoft представила ZeroRepo, инструмент, основанный на графоориентированном фреймворке (Repository Planning Graph, RPG), способный создавать полные программные проекты с нуля. Этот инструмент генерирует в 3,9 раза больше кода, чем существующие базовые решения, и имеет коэффициент прохождения 69,7%, решая проблему непригодности естественного языка для программной структуры и обеспечивая надежное долгосрочное планирование и масштабируемую генерацию кодовых баз. (Источник: _akhaliq, TheTuringPost, paul_cal)

DSPy UI: Визуальный интерфейс для создания Agent: DSPy разрабатывает визуальный пользовательский интерфейс (UI), призванный упростить процесс создания Agent, сделав его похожим на Figma или Framer, где Agent собираются путем перетаскивания компонентов. Этот UI поможет пользователям лучше концептуализировать сложные конвейеры Agent и упростит синтаксис генерируемого кода, а конечной целью является реализация генерации различных языковых версий DSPy и запуск GEPA. (Источник: lateinteraction)

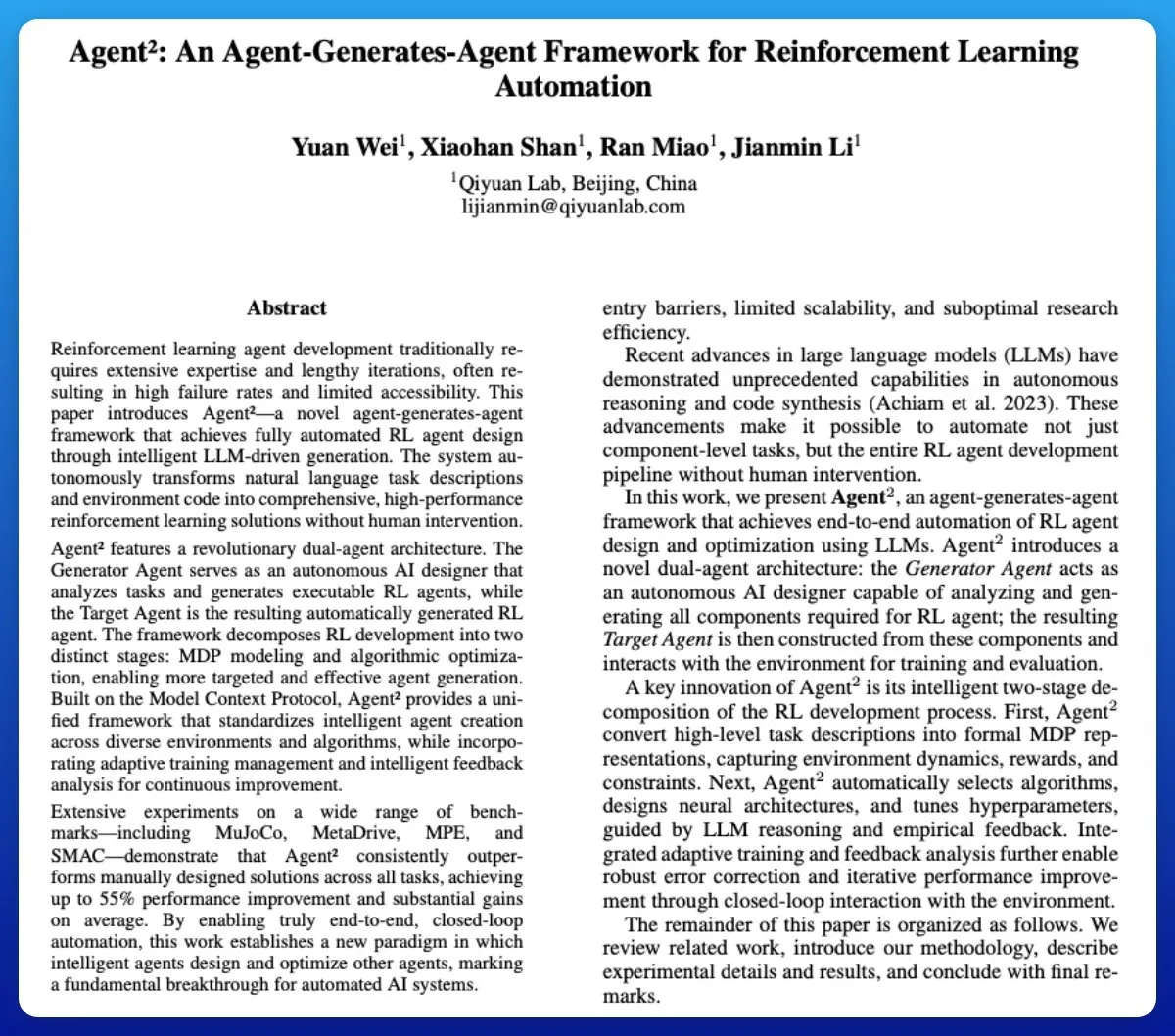

Agent²: LLM генерирует сквозные Agent для обучения с подкреплением: Agent² — это инструмент, использующий большие языковые модели (LLM) для автоматической генерации сквозных Agent для обучения с подкреплением (RL). Этот инструмент может автоматически генерировать эффективные RL-решения без вмешательства человека, используя естественный язык и код среды, и может рассматриваться как инструмент AutoML в области RL, значительно упрощающий процесс разработки RL Agent. (Источник: omarsar0)

Weaviate выпускает Query Agent с поддержкой ссылок, интроспекции схемы и маршрутизации по нескольким коллекциям в системах AI: Weaviate официально выпустила свой Query Agent, который достиг общей доступности после шести месяцев разработки. Он поддерживает генерацию ссылок, интроспекцию схемы и маршрутизацию по нескольким коллекциям в системах AI, а также улучшает режимы поиска с помощью Compound Retrieval System. Query Agent призван упростить взаимодействие с Weaviate и предоставляет клиенты Python и TypeScript, улучшая опыт разработчиков. (Источник: bobvanluijt, Reddit r/deeplearning)

Claude Code CLI: Управление микро-сотрудниками с помощью мышления SDK, акцент на внешнем состоянии и процессной инженерии: Рассматривая Claude Code CLI как SDK, а не просто инструмент, разработчикам необходимо управлять им как микро-сотрудником, уделяя особое внимание управлению внешним состоянием (например, файлами JSON, записями в базе данных) для обеспечения непрерывности сеанса, и рассматривать подсказочную инженерию как процессную инженерию. Этот подход выявляет ограничения текущих LLM в отношении перегрузки контекста и раздутости UI, но также подчеркивает огромную ценность сверхспецифичных внутренних инструментов автоматизации. (Источник: Reddit r/ClaudeAI)

Synapse-system: Система помощи AI для больших кодовых баз на основе графов знаний, векторного поиска и специализированных Agent: Synapse-system — это система, предназначенная для повышения возможностей помощи AI в больших кодовых базах. Она сочетает в себе графы знаний (Neo4j) для хранения связей кода, векторный поиск (BGE-M3) для нахождения семантически похожего кода, специализированные Agent (эксперты по Rust, TypeScript, Go, Python) для предоставления контекста, а также интеллектуальное кэширование (Redis) для быстрого доступа к часто используемым шаблонам. Эта система, благодаря модульной конструкции, избегает использования единой гигантской модели и оптимизирована для особенностей различных языков. (Источник: Reddit r/ClaudeAI)

Claude Opus 4.0+: Приложение AI-гид, генерирующее персонализированные городские туры в реальном времени: Разработчик реализовал 15-летнюю мечту, используя Claude Opus 4.0 и Claude Code, создав приложение AI-гид. Это приложение может генерировать персонализированные туры в реальном времени для любого города и любой темы (например, “Экскурсия по Венеции” или “Тур по Флоренции в стиле Assassin’s Creed”), а AI-гид предоставляет многоязычные объяснения, истории и интерактивные вопросы и ответы. Приложение предлагает гибкий, приостанавливаемый и возобновляемый иммерсивный опыт по цене значительно ниже, чем у человеческого гида. (Источник: Reddit r/ClaudeAI)

Mindcraft: Сочетание Minecraft AI и LLM для управления внутриигровыми Agent через Mineflayer: Проект Mindcraft объединяет большие языковые модели (LLM) и библиотеку Mineflayer для создания AI Agent в игре Minecraft. Этот проект позволяет LLM писать и выполнять код в игре для выполнения таких задач, как получение предметов или строительство зданий. Он поддерживает различные API LLM (такие как OpenAI, Gemini, Anthropic и другие) и предоставляет среду “песочницы”, но предупреждает пользователей о потенциальных рисках инъекционных атак. (Источник: GitHub Trending)

AI Agents for Continuous Inventory Management with Drones: Сочетание AI Agent и технологии дронов для непрерывного управления запасами без маяков или освещения. Эта инновация использует автономные летающие дроны для инвентаризации и управления запасами в реальном времени с помощью алгоритмов AI, что, как ожидается, значительно повысит эффективность логистики и складирования, сократит трудозатраты и предоставит более точные данные в сложных условиях. (Источник: Ronald_vanLoon)

Руководство по оценке LLM: Лучшие практики для надежности, безопасности и производительности: Опубликовано всеобъемлющее руководство по оценке LLM, подробно описывающее ключевые показатели, методы и лучшие практики для оценки больших языковых моделей (LLM). Это руководство призвано помочь обеспечить надежность, безопасность и производительность приложений на базе AI, предоставляя разработчикам и исследователям систематизированную структуру оценки для решения проблем, связанных с развертыванием LLM. (Источник: dl_weekly)

📚 Обучение

Ученый OpenAI Лукаш Кайзер о мышлении “первых принципов” в больших моделях: Ученый OpenAI Лукаш Кайзер (один из “восьми сыновей Transformer”) поделился своими размышлениями о “первых принципах” развития больших моделей. Он считает, что ключ к следующему этапу развития AI заключается в обучении моделей “мыслить”, осуществляя глубокий вывод путем генерации большего количества промежуточных шагов, а не прямого вывода ответов. Он предсказывает, что будущая вычислительная мощность сместится от крупномасштабного предварительного обучения к массовым вычислениям вывода на небольшом объеме высококачественных данных, что является моделью, более близкой к человеческому интеллекту. (Источник: 36氪)

Принципы выживания в эпоху AI-программирования: Эндрю Ын подчеркивает быстрое действие и ответственность: Эндрю Ын в своей речи на Buildathon отметил, что AI-помощь в программировании ускоряет разработку независимых прототипов в 10 раз, побуждая разработчиков действовать по принципу “быстро действовать, брать на себя ответственность” и смело экспериментировать в среде “песочницы”. Он подчеркнул, что ценность кода снижается, и разработчикам необходимо трансформироваться в системных дизайнеров и AI-дирижеров, осваивая новейшие инструменты AI-программирования, строительные блоки AI (подсказочная инженерия/техники оценки/MCP) и навыки быстрого прототипирования, опровергая точку зрения “в эпоху AI не нужно учиться программировать”. (Источник: 36氪)

“Глубокое обучение с Python”, третье издание, бесплатно опубликовано онлайн: Франсуа Шоллет (François Chollet) объявил о выходе третьего издания своей книги “Глубокое обучение с Python” и одновременно предоставил полную бесплатную онлайн-версию. Этот шаг направлен на снижение порога входа в глубокое обучение, чтобы больше людей, интересующихся искусственным интеллектом, могли получить доступ к высококачественным учебным ресурсам, способствуя распространению знаний. (Источник: fchollet, fchollet)

“Kaggle Grandmasters Playbook”: 7 практических методов табличного моделирования: Команда Kaggle Grandmasters, включая Гилберто Титерича-младшего (Gilberto Titericz Jr), на основе многолетнего опыта соревнований и практики выпустила “Kaggle Grandmasters Playbook”. Это руководство объединяет 7 проверенных на практике методов моделирования табличных данных, призванных помочь специалистам по данным и инженерам машинного обучения улучшить свои навыки в обработке табличных данных и построении моделей, особенно применимо для соревнований Kaggle и реальных задач с данными. (Источник: HamelHusain)

Острая нехватка AI-инженеров, университетские курсы сильно отстают: Эндрю Ын отметил, что, несмотря на рост безработицы среди выпускников компьютерных наук, компании по-прежнему сталкиваются с острой нехваткой AI-инженеров. Основное противоречие заключается в том, что университетские курсы не успевают охватывать ключевые навыки, такие как AI-помощь в программировании, вызов больших языковых моделей, построение рабочих процессов RAG/Agentic, стандартизированные процессы анализа ошибок. Он призвал образовательную систему ускорить обновление курсов и подготовить инженеров, обладающих новейшими строительными блоками AI и навыками быстрого прототипирования. (Источник: 36氪)

Руководство по оценке LLM: Лучшие практики для надежности, безопасности и производительности: Опубликовано всеобъемлющее руководство по оценке LLM, подробно описывающее ключевые показатели, методы и лучшие практики для оценки больших языковых моделей (LLM). Это руководство призвано помочь обеспечить надежность, безопасность и производительность приложений на базе AI, предоставляя разработчикам и исследователям систематизированную структуру оценки для решения проблем, связанных с развертыванием LLM, и обеспечения качества продуктов AI и доверия пользователей. (Источник: dl_weekly)

💼 Бизнес

Инвестиционный бум в AI-инфраструктуру: Расходы на AI-центры обработки данных в США могут достичь 520 миллиардов долларов к 2025 году: По данным The Wall Street Journal и The Economist, США переживают бум расходов на AI-центры обработки данных, которые, по прогнозам, достигнут 520 миллиардов долларов к 2025 году, что превышает пиковые расходы на телекоммуникации в эпоху интернета. Это краткосрочно стимулирует ВВП США, но в долгосрочной перспективе может привести к нехватке средств в других областях, массовым увольнениям, а также к высоким рискам обесценивания из-за быстрой итерации AI-оборудования, вызывая структурные экономические опасения и представляя вызов для долгосрочного здоровья экономики США. (Источник: 36氪)

OpenAI анонсирует платные новые функции: Пользователям Pro потребуется дополнительная оплата, высокая стоимость: Генеральный директор OpenAI Сэм Альтман (Sam Altman) анонсировал, что в ближайшие недели будет выпущено несколько новых вычислительно интенсивных функций. Из-за высоких затрат эти функции изначально будут доступны только для подписчиков Pro за 200 долларов в месяц, и даже могут потребовать дополнительной оплаты. Альтман заявил, что команда работает над снижением затрат, но этот шаг предвещает, что бизнес-модель AI-услуг может перейти к модели почасовой оплаты труда, что создаст новые вызовы для пользователей и отрасли. (Источник: The Verge, op7418, amasad)

Стартап получил огромные кредиты OpenAI и ищет способы их монетизации: Технологический стартап получил кредиты Azure OpenAI на сумму 120 000 долларов США, что значительно превышает его потребности, и теперь ищет способы их монетизации. Это отражает потенциальный дисбаланс спроса и предложения на рынке AI-ресурсов, а также поиск компаниями эффективных способов использования и монетизации избыточных вычислительных ресурсов AI, что также может привести к появлению новых моделей торговли AI-ресурсами. (Источник: Reddit r/deeplearning)

🌟 Сообщество

Негативное влияние AI на критическое мышление: Чрезмерная зависимость приводит к деградации способностей: В социальных сетях активно обсуждается, что широкое использование AI приводит к деградации способности человека к критическому мышлению. Существует мнение, что когда люди перестают использовать “мыслительные мышцы”, эти способности атрофируются. Хотя AI может повысить эффективность, он также может привести к потере способности к глубокому мышлению в ключевых областях, вызывая опасения относительно долгосрочного влияния на когнитивные способности человека. (Источник: mmitchell_ai)

Этические дилеммы AI в здравоохранении: Плюсы и минусы Delphi-2M в прогнозировании заболеваний: Новая модель AI Delphi-2M способна анализировать данные о здоровье и прогнозировать риск развития более тысячи заболеваний у пользователя в течение следующих 20 лет. В сообществе обсуждается, что заблаговременное знание о рисках заболеваний может привести к позитивным превентивным мерам, но также может вызвать долгосрочную тревогу и риски конфиденциальности и дискриминации, связанные с получением таких данных страховыми компаниями или работодателями. Пока инструменты AI еще не созрели, их потенциальное социально-этическое влияние уже стало центральной темой. (Источник: Reddit r/ArtificialInteligence)

Феномен “AI-тупости”, вызванный ежедневным использованием AI: Чрезмерная зависимость от AI приводит к снижению мыслительных способностей: В социальных дискуссиях многие пользователи жалуются на чрезмерное использование AI в повседневной жизни, что приводит к снижению мыслительных способностей людей. От простых решений (какой фильм посмотреть, что поесть) до сложных проблем (организационные вопросы университета) AI часто консультируют, даже если ответы неверны или легко доступны. Этот феномен “AI-тупости” не только снижает личное участие, но и способствует распространению ложной информации, вызывая глубокие размышления о границах использования AI. (Источник: Reddit r/ArtificialInteligence)

Усталость от использования AI-инструментов для программирования: Разработчики чувствуют снижение умственной вовлеченности: Многие разработчики сообщают, что ежедневное использование AI-инструментов для программирования (таких как Claude Code), хотя и повышает производительность, приводит к умственной усталости и снижению вовлеченности. Они обнаруживают, что чаще находятся в “режиме рецензирования”, а не активно решают проблемы, и процесс ожидания генерации вывода AI вызывает чувство пассивности. Сообщество обсуждает, как сбалансировать AI-помощь и поддержание умственной активности, чтобы избежать когнитивной нагрузки и снижения креативности. (Источник: Reddit r/artificial, Reddit r/ClaudeAI)

1/4 молодых людей общаются с AI в романтических и сексуальных целях: Исследование показало, что 1/4 молодых совершеннолетних общаются с AI в романтических и сексуальных целях. Это явление вызвало дискуссии в сообществе о чувстве одиночества, отсутствии межличностного взаимодействия и роли AI в эмоциональном сопровождении. Хотя AI в некоторых аспектах приносит утешение, многие по-прежнему сомневаются, сможет ли он заменить по-настоящему значимые человеческие отношения, и обеспокоены его долгосрочным влиянием на модели социального взаимодействия. (Источник: Reddit r/ArtificialInteligence)

Угрозы безопасности AI: Краудтестинг уязвимостей больших моделей выявляет новые риски, повсеместное внедрение подсказок: Первое в стране краудтестирование больших моделей AI в реальной сети выявило 281 уязвимость безопасности, из которых 177 были специфичны для больших моделей, что составляет более 60%. Типичные риски включают ненадлежащий вывод, утечку информации, внедрение подсказок (наиболее распространенное) и атаки с неограниченным потреблением ресурсов. Отечественные основные модели, такие как Tencent Hunyuan и Baidu Wenxin Yiyan, показали хорошие результаты. Сообщество предупреждает, что беззащитное доверие пользователей к AI может привести к утечке конфиденциальных данных, особенно при запросах по личным вопросам. (Источник: 36氪)

Этические дилеммы AI Agent: Принятие решений и ответственность при 10% ложных срабатываний городской системы AI-мониторинга: В сообществе обсуждается гипотетический сценарий этической дилеммы AI Agent: городская система AI-мониторинга имеет 10% ложных срабатываний, помечая невинных людей как потенциальные угрозы. Дискуссия сосредоточена на том, как сбалансировать давление развертывания и этические принципы (такие как принцип Блэкстоуна). Предложенные решения включают: создание команды для сотрудничества человека и машины для исправления проблем, перекладывание затрат на ложные срабатывания на руководство, полное удаление записей ошибочно помеченных лиц и извинения, а также рассмотрение возможности увольнения в случае “полной потери общественного доверия и жадного игнорирования со стороны руководства”. (Источник: Reddit r/artificial)

Сознание AI и определение AGI: Эндрю Ын считает AGI хайповым термином, а сознание — философской проблемой: Эндрю Ын в своей речи отметил, что общий искусственный интеллект (AGI) превратился из технического термина в хайповый, его определение расплывчато, что приводит к отсутствию единых стандартов для заявлений о “достижении AGI” в отрасли. Он считает, что сознание — это важная философская, а не научная проблема, и в настоящее время отсутствуют критерии его измерения. Инженеры и ученые должны сосредоточиться на создании практически полезных систем AI, а не на философских дебатах о сознании. (Источник: 36氪)

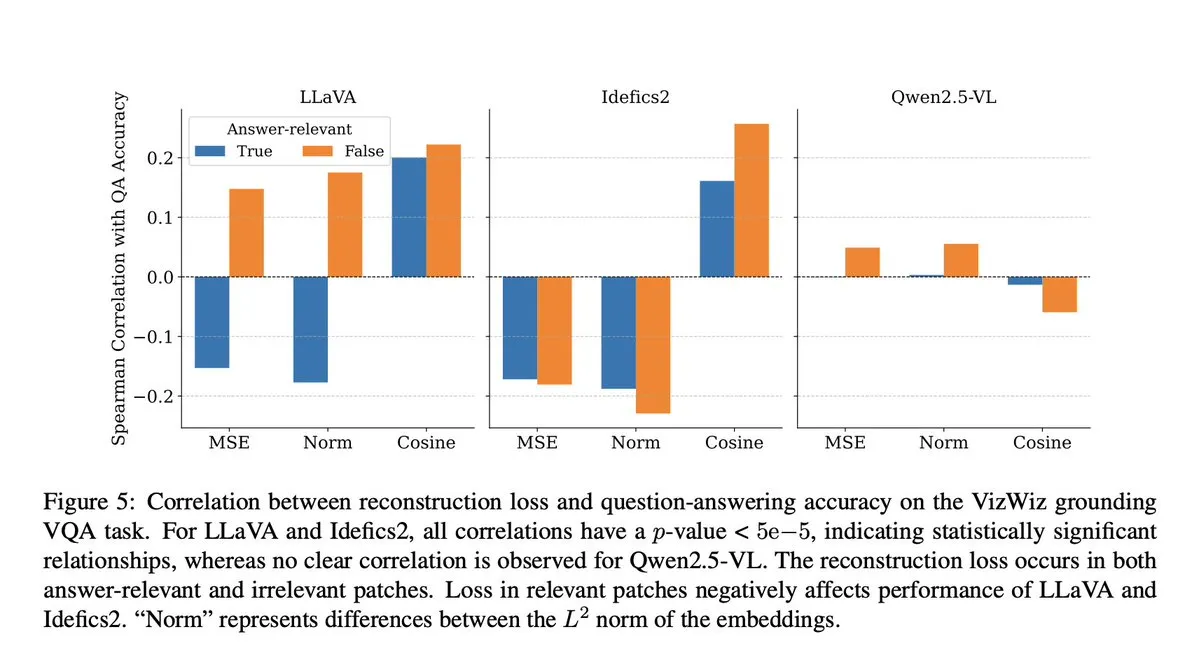

Мошенничество AI-моделей: Исследование VLM выявляет потерю семантического контекста на этапе проекции: Сообщество обсудило исследование Microsoft, которое показало, что визуально-языковые модели (VLM) теряют 40-60% семантического контекста на этапе проекции, что искажает визуальное представление и влияет на последующие задачи. Это открытие вызвало опасения относительно точности оценки VLM и загрязнения данных, особенно в таких бенчмарках, как DocVQA, где высокие баллы могут не полностью отражать истинные возможности модели. (Источник: vikhyatk)

Этика AI и робототехники: Призывы прекратить насильственные испытания роботов: В социальных сетях многие исследователи AI и члены сообщества призывают прекратить насильственные испытания роботов, такие как многократные удары по роботу Unitree G1 для демонстрации его стабильности. Они считают, что такой метод испытаний не только вызывает этические опасения, но и может усилить негативное восприятие роботов, а также ставят под сомнение его научную необходимость, выступая за более гуманные и научные методы оценки производительности роботов. (Источник: vikhyatk, dejavucoder, Ar_Douillard)

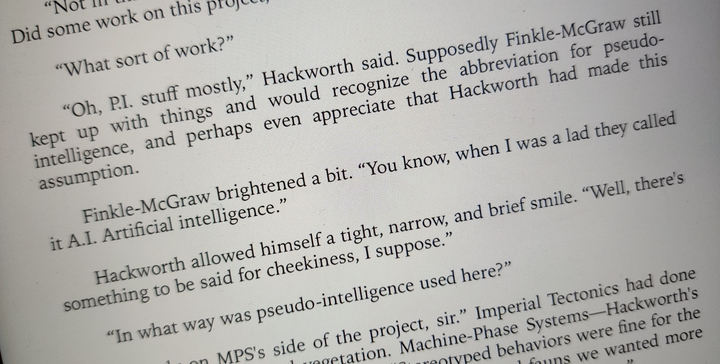

“Псевдоинтеллект” AI: Призыв изменить “искусственный интеллект” на “псевдоинтеллект” для уменьшения общественного заблуждения: Выдвинуто предложение изменить название “искусственный интеллект” (Artificial Intelligence) на “псевдоинтеллект” (Pseudo Intelligence), чтобы уменьшить чрезмерное преувеличение и заблуждение общественности относительно возможностей AI. Это предложение основано на ясном понимании текущих ограничений AI и направлено на то, чтобы избежать введения общественности в заблуждение “терминаторскими” грандиозными нарративами, способствуя рациональному восприятию истинных возможностей AI как внутри отрасли, так и за ее пределами. (Источник: clefourrier)

Назначение AI-чатбота Diella членом кабинета министров Албании вызвало споры: Правительство Албании назначило AI-чатбота Diella членом кабинета министров с целью борьбы с коррупцией. Этот шаг вызвал широкие споры и был раскритикован как дешевый трюк, аналогичный случаю предоставления Саудовской Аравией “гражданства” роботу Софии в 2017 году. Комментаторы считают, что этот шаг может чрезмерно рекламировать возможности AI и размывать границы между технологиями и управлением. (Источник: The Verge)

Феномен “галлюцинаций” ChatGPT: Модель зацикливается, самокорректируется, но не может выйти из цикла: Пользователи сообщества поделились случаями, когда ChatGPT зацикливался в “галлюцинаторном” цикле, многократно генерируя ошибочную информацию при ответе на вопросы, и даже “осознавая” свои ошибки, не мог выйти из этого цикла. Это явление вызвало дискуссии о глубоких технических недостатках LLM, указывая на разрыв между способностью модели понимать свои логические ошибки и способностью их исправлять в некоторых случаях. (Источник: Reddit r/ChatGPT, Reddit r/ChatGPT)

💡 Прочее

От Transformer до GPT-5: Мышление “первых принципов” в больших моделях от ученого OpenAI Лукаша Кайзера: Ученый OpenAI Лукаш Кайзер (один из “восьми сыновей Transformer”) поделился своим путем от логического образования, участия в изобретении архитектуры Transformer до глубокого участия в разработке GPT-4/5. Он подчеркнул важность построения систем на основе “первых принципов” и предсказал, что следующий этап развития AI будет заключаться в обучении моделей “мыслить”, осуществляя глубокий вывод путем генерации большего количества промежуточных шагов, а не прямого вывода ответов, а вычислительная мощность сместится к массовым вычислениям вывода на небольшом объеме высококачественных данных. (Источник: 36氪)

Семантический синтез изображений: Технология генерации спутниковых снимков рек по их скелетам: Сообщество машинного обучения обсуждает последние достижения в области семантического синтеза изображений, уделяя особое внимание тому, как генерировать черно-белые спутниковые снимки рек из их скелетов. Эта задача включает использование генератора для создания спутниковых изображений из новых, ранее не виденных данных скелета и может включать дополнительные условные переменные. Обсуждение направлено на поиск самых современных методов и соответствующих исследовательских работ для руководства такими проектами компьютерного зрения. (Источник: Reddit r/MachineLearning)

Разрыв в интеллекте в эпоху AI: Профессор Цю Цзэци исследует глубокое влияние AI на человеческое мышление и познание: Профессор Цю Цзэци из Пекинского университета отметил, что использование AI не просто приводит к “снижению интеллекта”, а скорее является своего рода тренировкой мышления, зависящей от инициативы и критического отношения человека. Он подчеркнул, что понимание человеком мышления все еще находится на ранней стадии, и хотя AI мощен, он все еще основан на человеческих знаниях и не может полностью имитировать человеческое сенсорное восприятие и скачкообразное мышление. Тенденция AI “угождать” требует от пользователей бросать ему вызов и быть бдительными к его ценностям. Он считает, что в эпоху AI более важны развитие базовых способностей и разнообразие общества, чтобы избежать наблюдения за “разрывом в интеллекте” с высокомерной точки зрения. (Источник: 36氪)